Q,S\2

T H E S E

PRESENTEE

A L'ECOLE DES GRADUES

DE L'UNIVERSITE LAVAL

POUR L * OBTENTION

DE LA MAITRISE EN SCIENCES DE L«EDUCATION

PAR

RICHARD GIRARD

L'EFFET DU DEGRE DE SPECIFICITE

DES OBJECTIFS PEDAGOGIQUES SUR LA CONSTRUCTION

DE TESTS DE RENDEMENT SCOLAIRE

Cette thèse a été préparée sous la direction de Mon-sieur Gérard Scallon, professeur à la Faculté des Sciences de l'Education de l'Université Laval. Nous lui sommes re-devable d ' une reconnaissance toute spéciale d ' avoir bien voulu assumer la direction de cette recherche, de nous avoir fait bénéficier de sa compétence professionnelle et de son grand dévouement.

s

Nous remercions aussi le Docteur Gilles Dusseault, professeur agrégé à la Faculté des Sciences de 1 ' Education de 1 ' Université Laval, d ' avoir bien consenti à superviser ce projet et nous avoir assisté de ses conseils.

Enfin, au personnel enseignant des classes où nous avons fait notre expérimentation ainsi qu ' à leurs élèves qui nous ont apporté leur si généreux concours, notre plus sincère merci!

Tf-Chapitres: pages INTRODUCTION 1 I - POSITION DU PROBLEME ET REVUE DE LA

LITTERA-TURE 3 1 - P o s i t i o n du problème • • • • • • • • • 3 2 - Revue de la littérature . « • • • . . 8 II - RATIONNEL ET HYPOTHESES 18 1 - Rationnel et hypothèses». . . . 18 2 - Limites de la recherche. . . . 20 III - PRESENTATION ET ANALYSE DES RESULTATS. . . . 23

1 - Echantillon . # « , 23

2 - Préparation des listes d'objectifs et

du test critère 24 3 - Stratégie expérimentale • • • • • • • 20

4 - Vérification des hypothèses 32

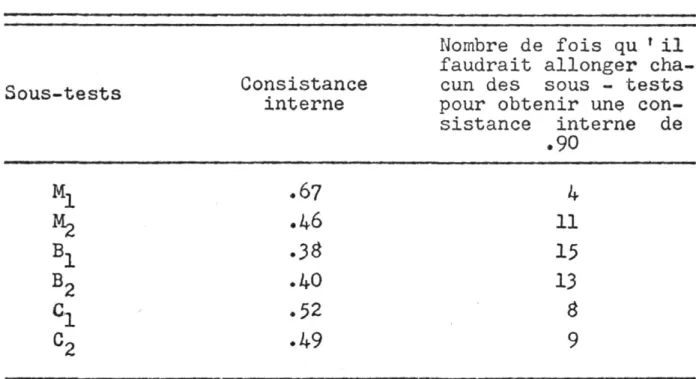

IV - ASPECTS EXPLORATOIRES 38 1 - Le degré de consistance interne des

divers sous-tests • • • • 39 2 - Le degré de difficulté des item . . . 41 3 - Le degré d'attraction des leurres • . 44 4 - Le degré d!équivalence entre les deux

sous-échantillons • • • 48 5 - La qualité sémantique de 1 * énoncé

principal et des alternatives

propo-sées 49 6 - l'homogénéité du contenu pour chaque

objectif 50 7 - Discussion • . . : • . . . • • • • . • 51

Tableaux: pages I Moyennes pour chacun des soustests à l'in

térieur de chaque échantillon et rapports critiques aui ont servi à l'épreuve de la

première hypothèse 32

II Ecarts types pour chacun des sous tests à l'intérieur de chaque échantillon et tests statistiques qui ont servi à l'épreuve de

la deuxième hypothèse 34

III Corrélations entre chacun des sous tests â l'intérieur de chaque échantillon qui ont

servi à l'épreuve de la troisième hypothèse 36 IV Consistances internes pour chacun des sous

tests et nombre de fois qu ' il faudrait al longer chacun de ces sous tests pour obte

nir une consistance interne idéale de .90 • 40 V Pourcentages de réussites pour chaque ques

tion de chacun des soustests à l'intérieur

de chaque échantillon 42

VI Nombre de leurres qui ont un degré d'attrac tion inférieur au tiers du nombre d'échecs

à chaque question ■■ 46

VII Moyennes au test critère pour chacun des

échantillons et rapport critique 48

VIII Distribution de fréquences des résultats pour chacun des soustests â l'intérieur de

chaque échantillon . 91

IX Moyenne, variance, écart type, consistance

interne pour chacun des soustests . . . . 93 J Matrice de corrélations entre les soustests

B^, Bg» C, • • 9M

XI Matrice de corrélations entre les soustests

Appendices: pages "A" Directives fournies aux professeurs

pour l'élaboration des questions . . . 56 "B" Listes d'objectifs de forme "OB" et de

forme "OM" 59 " C Tests de rendement en chimie: forme "B"

et forme "M" • 64 "D" Distribution de fréquences des

résul-tats pour chacun des sous-tests . . . . 91 "E" Moyenne, variance, écart - type,

consis-tance interne pour chacun des sous-tests et corrélations entre les divers

sous-tests 92 "F" Enoncés des objectifs, répartition des

choix de réponses et identification du

contenu pour chacune des réponses . . . 95

BIBLIOGRAPHIE 122

Au cours des vingt dernières années, les objectifs pédagogiques ont été 1 » objet d'une préoccupation accrue tant du côté de leur formulation que du côté de leur inter-prétation. L'expression "comportement observable" est deve-nue une sorte de cliché lorsqu ' on parle de formulation d'objectifs. La publication de la Taxonomie des Objectifs pédagogiques de Benjamin Bloom en 1956 est considérée comme un événement important. Cependant, il faut concéder à Ralph Tyler (1950) le crédit d'avoir été le premier à insister sur 1'importance des objectifs définis en termes opération-nels. Aux noms de Bloom et de Tyler, ajoutons ceux de Ma-ger (1962), Krathwohl (1964), Gagné (1965), Baker (1967) et Sullivan (1969) qui ont tenté de clarifier et de spécifier de quelle manière les objectifs devaient être formulés. Cette importance accordée â la formulation des objectifs est explicable par les décisions multiples qui peuvent être prises concernant par exemple la planification de 1'ensei-gnement et l'évaluation. Cette importance est également ex-plicable par la possibilité qu*il y ait plusieurs personnes engagées dans une prise de décision quelconque depuis leur formulation jusqu'à leur interprétation. Une question

fon-sonnes différentes? Dans le cadre de la présente recherche, cette question a été soulevée en considérant certaines dé-cisions qui peuvent être prises dans le domaine de l'évalu-ation du rendement scolaire et plus précisément au niveau de 1' élaboration d' instruments de mesure»

POSITION DU PROBLEME ET REVUE DE LA LITTERATURE POSITION DU PROBLEME

D'après Mager, un énoncé d'objectif peut, à des de-grés divers, suggérer des interprétations multiples dont le nombre peut varier selon le degré de spécificité du verbe d'action utilisé.

La définition convenable d'un objectif est donc celle qui réussit â communiquer votre intention; la meilleure est celle qui exclut le nlus grand nombre possible de variantes par rapport a votre objectif final (Mager, p.ll).

Mais le plus souvent les objectifs contiennent des expres-sions comme "sensibiliser", "développer le goût", etc. qui ouvrent la porte à un grand nombre d'interprétations diver-ses dont certaines risquent d'être erronées quant au com-portement terminal attendu.

D'après deux listes de verbes d'action que Mager u-tilise pour illustrer sa pensée, des verbes comme "savoir", "comprendre" ou "apprécier" conduiraient, toujours selon Mager, a des interprétations multiples chez les utilisa-teurs; par contre, des verbes d'action comme "écrire",

"i-L'argument fondamental qui est soutenu dans 1 ' ou-vrage de Mager est que certains verbes d' action conduisent a un nombre plus ou moins grand d' interprétations. D» après les illustrations variées d'objectifs contenus dans cet ou-vrage on peut en déduire que beaucoup de verbes d' action empruntés aux catégories de la Taxonomie de Bloom sont par-mi ceux que Mager considère comme conduisant à des inter-prétations variées. D' autre part, des verbes d'action plus spécifiques comme ceux que 1 ' on rencontre au niveau des consignes de certaines tâches ou situations d' examen (v.g. identifier, comparer, ordonner, etc.) sont parmi ceux que Mager considère comme conduisant â moins d'interprétations.

Il s'agit là d'une hypothèse implicitement formulée par Ma-ger quant à la relation inverse qui peut exister entre le degré de spécificité d'un verbe d ' action impliqué dans un objectif et le nombre d' interprétations suscitées par cet objectif.

Pour Mager, le degré de spécificité du verbe d'ac-tion utilisé dans 1' objectif ne serait pas le seul facteur â considérer dans la formulation adéquate d'un objectif. Le contenu sur lequel doit s » exercer 1' activité impliquée dans le verbe d ' action peut être lui aussi plus ou moins

jectif. Par exemple, un objectif comme "décrire le phénomè-ne de la pollution" n'a pas, à priori du moins, le même de-gré de spécificité qu' un objectif comme "décrire un trian-gle rectantrian-gle". Le verbe d'action utilisé dans les deux ob-jectifs est le même: "décrire". Cependant, le contenu du premier objectif "le phénomène de la pollution" peut sus-citer beaucoup d ' interprétations de la part d'un utilisa-teur éventuel: s'agit-il d'énumérer les causes de la pollu-tion et/ou s'agit-il d'énumérer ses effets? s * agit-il de traiter historiquement le phénomène et/ou de faire des pro-jections pour les dix prochaines années? Autant d'interpré-tations variées, toutes aussi valables les unes que les au-tres, mais dont certaines peuvent être très éloignées de 1 ' intention initiale de celui qui a communiqué un tel ob-jectif. Le contenu du second objectif: "un triangle rectan-gle", parce que relativement moins complexe que celui relié au phénomène de la pollution, apparaît plus limité du côté des interprétations diverses qu' il peut susciter. En plus du degré de spécificité du verbe d'action, le degré de spé-cificité du contenu peut être un facteur susceptible d' in-fluencer la qualité de la communication d'un objectif. Afin de mieux situer les limites de cette étude précisons tout

vre au sujet de l'hypothèse principale contenue dans 1 'ou-vrage de Mager. En d ' autres termes, il s'agit d' examiner les implications de 1' hypothèse de Mager sur 1' évaluation du degré d' atteinte d' un ou de plusieurs objectifs et sur 1' évaluation du rendement en considérant le degré de spé-cificité du verbe d'action comme une variable et en consi-dérant le contenu sur lequel doit s' exercer le comportement

exprimé par le verbe d'action comme étant déterminé à 1' a-vance.

Rappelons que l'hypothèse principale avancée par Mager implique une relation inverse entre le degré de

spé-cificité impliqué dans un objectif et le nombre d'interpré-tations diverses de la part de ceux à qui 1 ' objectif est

communiqué. Mager ne propose pas, du moins de façon expli-cite, de moyens concrets qui permettraient d' observer les effets du degré de spécificité du verbe d'action employé. Il laisse entrevoir tout au plus que le nombre de situa-tions d' examen perçues comme étant conformes a un objectif donné peut être inversement associé au degré de spécificité du verbe d'action utilisé dans cet objectif. Une telle

luimême. Lorsque l'objectif est défini de manière à inclure tous les types de questions possibles por tant sur le sujet, il est énoncé de manière trop va gue pour communiquer vraiment votre intention au lecteur. Au contraire, il expose bien votre dessein s'il est défini de façon â inclure les questions et les situations qui vous apparaissent appropriées tout en excluant en même temps celles qui ne vous

semblent pas conformes à l'objectif; alors seulement votre objectif est assez clair pour communiquer vé ritablement vos intentions (Mager, p,42).

Cette citation de Mager implique que 1 ' utilisation de termes vagues dans les objectifs peut conduire â une multitude de situations d' examen qui peuvent être imaginées en vue d'évaluer le degré d'atteinte de cet objectif. Le nom bre de situations d' examen présumément perçues comme confor mes â 1 * intention initiale exprimée dans un objectif appa

raît donc comme une définition opérationnelle possible de 1'effet du degré de spécificité du verbe d ' action sur la qualité de la communication. Cette façon de concevoir opéra tionnellement 1 ' effet du degré de spécificité du verbe d' action permet de soulever un problème important concernant la mesure du rendement scolaire et .1 ' évaluation du degré d ♦ atteinte d ' un objectif tout en permettant d'éprouver à 1 ' intérieur de certaines limites, 1» hypothèse avancée par Mager.

d' enseignement, poursuivis dans des conditions déterminées,

dont on confie 1' évaluation à des examinateurs d i f f é r e n t s .

Deux questions peuvent a l o r s ê t r e soulevées i c i . Jusqu' â

quel point l e rang d ♦ un étudiant (dans un groupe donné)

e s t i l indépendant des instruments de mesure préparés par

ces examinateurs? Parallèlement, jusqu ' à quel point l e de

gré d ' a t t e i n t e d'un objectif dans un échantillon donné de

sujets {% de r é u s s i t e s par exemple) e s t i l indépendant des

s i t u a t i o n s d ' examen imaginées par ces examinateurs d i f f é

rents à l a s u i t e de 1' énoncé de cet objectif? Qu'il s ' a g i s

se du r é s u l t a t d ' un étudiant ou du degré d ' a t t e i n t e d'un

objectif, l e problème soulevé par ces deux questions en est

un d ' équivalence entre divers instruments de mesure conçus

â p a r t i r d'un univers d ' o b j e c t i f s qui l e u r est commun.

REVUE DE LA LITTERATURE

Le problème soulevé dans cette recherche concerne principalement la relation étroite qui devrait exister entre un énoncé d ' objectif d' enseignement et les moyens utilisés par des examinateurs différents pour évaluer le degré d' at teinte de cet objectif ou pour évaluer le rendement scolaire de l'étudiant. Ce problème particulier s'insère dans un pro blème plus général qui est celui de 1' interprétation des ob jectifs. Il existe déjà une accumulation importante d' écrits

surtout s' être préoccupé de relier le problème de 1'inter prétation des objectifs à la planification de séquences particulières d'enseignement ou à la classification d'item par des juges. Les recherches qui ont été entreprises du côté de la classification d ' item par les juges sont les plus rapprochées du problème que nous avons soulevé bien qu ♦ aucune d' elles n' implique directement la rédaction de questions d ' examen par des examinateurs différents. Quant aux écrits théoriques, un échantillon seulement a été rete nu afin d' appuyer l'hypothèse avancée par Mager et afin de mieux délimiter 1' importance du problème qui a été soulevé.

En 194Ô, un groupe d'examinateurs, ayant à leur tê te Benjamin Bloom, décidèrent d ' élaborer un système de classification d' objectifs pédagogiques d ' ordre cognitif qui devait servir de guide à la préparation de programmes et à la rédaction d' examens. Cette taxonomie classifie les objectifs pédagogiques du domaine cognitif en six catégo ries: connaissance, compréhension, application, analyse, synthèse et évaluation.Les catégories correspondent à des habiletés intellectuelles présumément apprises et pouvant être observées dans des situations d'examen.

giques devait répondre à un problème de communication entre les utilisateurs éventuels tel que le soulignent Bloom et

ses collaborateurs:

The major purpose in constructing a taxonomy of educational objectives is to facilitate communica-tion (1956, p.lO)0

Les auteurs de la taxonomie ont admis que le consensus est difficile chez tous ceux qui doivent utiliser les objectifs particulièrement au niveau de 1' évaluation même de ces ob-jectifs» Des recherches suggèrent qu ' une des façons d' é-prouver la qualité de la communication du message ou de l'intention véhiculée par des objectifs pédagogiques est de vérifier si plusieurs juges seraient d' accord dans leur classification de questions d' examen rédigées par d'autres personnes à partir de ces objectifs. Parmi ces recherches, soulignons celles de Stanley et Bolton (1957). Dans une des recherches de Stanley et Bolton, on demanda à 8 juges, fa-miliers avec le contenu de 1 ' ouvrage de Bloom, de classi-fier 227 questions d ' examen selon les 7 niveaux et les 27 sous-niveaux de la taxonomie. Si les pourcentages d' accord entre les juges sont apparus assez élevés pour les ques-tions à classifier par niveaux, les pourcentages d ' accord ont été beaucoup plus faibles en ce qui concernait la clas-sification par sous-niveaux. Mcguire (1963) a réalisé une

série d ' études semblables â celles de Stanley et Bolton. Entre autres, on a demandé à trois spécialistes en médeci-ne, familiers avec la taxonomie, de classifier 683 ques-tions selon 8 catégories dont 6 appartenaient â la taxono-mie de Bloom. Le pourcentage d'accord obtenu entre les ju-ges fut de 63$. La littérature rapporte d'autres recherches analogues à celles citées antérieurement. Les résultats ob-tenus sont semblables à ceux de Stanley et Bolton et à ceux de Mcguire. Il est possible de tirer une première conclu-sion de l'ensemble de ces recherches: si les pourcentages d'accord obtenus semblent au premier abord assez élevés, on constate que ces pourcentages d ' accord entre les juges, pour classifier des questions selon les catégories de la taxonomie de Bloom, ne sont pas aussi forts que prévu. De plus, ces auteurs avancent peu d'hypothèses qui viendraient

expliquer ce manque d' accord entre les juges. Un groupe de chercheurs travaillant pour le "Graduate Council of the Florida State University for Exploratory Studies in the Va-lidation of Measures of Cognitive Processes" (1962), après

plusieurs recherches sur le sujet, en sont arrivés aux con-clusions suivantes:

First, the raters did not use the same frame of reference. Second, apparently some of the items can be solved by several processes each of which ap-pears at a different level of the taxonomy (1962, p.21).

Les juges utilisent des cadres de référence diffé-rents. Ainsi, la question: "Donnez un synonyme de paresseux" pourrait être considérée comme du simple rappel par des ju-ges qui prétendraient que 1 ' étudiant doit savoir une foule de synonymes de ce mot. Pour d ' autres juges, la même ques-tion pourrait appartenir au niveau de la compréhension s'ils estiment que l'étudiant doit utiliser le texte présenté pour répondre à la question. Les juges ne s ' entendent pas sur 1 ' expérience antérieure des examinés placés en situation d'examen. On observe que même après discussion les juges n' arrivent pas â se mettre d ' accord sur les connaissances que doit posséder un'étudiant avant même que celui-ci aborde une question d'examen.

Outre l'expérience antérieure des examinés, le pro-cédé de solution utilisé par les sujets au moment même où ils répondent â une question d' examen constitue un deuxième point de désaccord entre les juges. Par exemple, face à une situation d ' examen qui demande à 1 ' étudiant de choisir, parmi plusieurs titres suggérés, celui qui est le plus ap-proprié à un texte donné, certains juges diront qu'il s'a-git tout simplement de saisir 1'idée maîtresse d' où "inter-prétation" (compréhension). D1 autres, par contre,

préten-dront que 1 'étudiant doit analyser le texte ligne par ligne afin de déterminer les relations entre le texte et les

ti-très suggérés d'où "analyse". Les juges n'arrivent pas à se mettre d ' accord à priori sur la stratégie qu'une question d ' examen va exiger de la part du répondant. Pour résoudre le dilemne, il faudrait demander à l'étudiant de verbaliser son raisonnement.

En tant que système de classification de questions d ' examen, il ne semble pas que la taxonomie des objectifs pédagogiques de Bloom ait entièrement résolu le problème d ' une communication difficile entre divers utilisateurs d'objectifs pédagogiques. Chester Harris (1962) affirme que la taxonomie des objectifs pédagogiques nous laisse dans le noir ('in the doldrum1). Son rôle serait réduit à celui de

guide dans la formulation d ' objectifs généraux et dans le choix d ' objectifs que nous devrons par la suite convertir en termes de comportements observables de 1' étudiant. Sul-livan (1969), dans une courte critique de la taxonomie, af-firme ce qui suit:

At best, the taxonomy serves as a guide for describing very general desired outcomes of educa-tional programs and for suggesting objectives which then must be stated in terms of observable learner behavior to be useful for evaluation and

instructional purposes (Sullivan, p.72).

Tel que l'avait suggéré Mager (1962) auparavant, Sullivan propose une liste de verbes d ' action comme "identifier",

"nommer", "ordonner", etc. qui devraient faciliter le con-sensus chez ceux qui utiliseront des objectifs énoncés à l'aide de ces verbes d'action. Cette hypothèse, qui est ex-périmentalement analogue à celle de Mager, ne semble pas a-voir été éprouvée expérimentalement en terme de classifica-tion d' item par des juges ou en terme de rédacclassifica-tion de questions d' examen par des examinateurs différents.

Philip Vernon (1957) est un des auteurs qui a le mieux synthétisé le problème des objectifs que nous voulons soulever dans cette recherche. Voici comment il explique le manque de consensus chez les utilisateurs:

In the Writer' s view, the claim that objectives can be defined in terms of behavior is highly mis-leading. In practice, the definitions employ such terms as: 'ability to recognize assumptions', 'abi-lity to formulate relevant hypotheses', etc.

These would seem to be very much on a par with the faculties as memory, reasohning, observation and imagination, which educational psychology star-ted to outgrow oO years ago. And there is a tremen-dous jump from the faculty or ability as named to the items that are supposed to sample it. Almost

certainly there would be marked inconsistency bet-ween different test constructors who tried to clas-sify a set of miscellaneous items under these abi-lity-names (1958, p.7).

Précisons que dans cet extrait Vernon fait allusion 1 la taxonomie de Bloom.

Face a ce problème d' interpretation des objectifs, Mager (1962) propose une solution différente de celle qui

est impliquée dans la taxonomie. Alors que Bloom et ses collègues ont voulu accroître la qualité de la communication des objectifs en élaborant un système de classifica -tion de ces objectifs, Mager a préconisé plutôt des prin-cipes devant régir la formulation même de ces objectifs. Ces principes se résument principalement à trois critères de formulation d'un objectif pédagogique:

First, identify the terminal behavior by name; you can specify the kind of behavior that will be accepted as evidence that the learner has achieved the objective.

Second, try to define the desired behavior further by describing the important conditions un-der which the behavior will be expected to occur. Third, specify the criteria of acceptable per-formance by describing how well the learner must perform to be considered acceptable (Mager, p.12).

Dans l'objectif, il existe toujours un terme qui indique le comportement à faire acquérir. Des termes comme "écrire", "énumérer", "mettre en rangs" en sont des exem-ples. On précise aussi dans quelles conditions le sujet examiné va démontrer sa maîtrise de 1 ' habileté impliquée dans un objectif. Enfin, tout énoncé d' objectif doit con-tenir explicitement un critère de performance de sorte que 1' on sache quand le comportement a été acquis et que l'on puisse porter un jugement de valeur sur le degré

d'attein-te de l'objectif par un étudiant. Ce critère sera habituel-lement quantitatif.

L • étude de la qualité de la communication des ob-jectifs a été réalisée dans les recherches antérieures par certaines méthodes devenues classiques. L' approche la plus courante a été de demander â des juges de classifier des questions d' examen à partir d'un système de classification établi à priori comme celui de la taxonomie de Bloom. Plu-sieurs recherches utilisant la taxonomie de Bloom comme système de classification suggèrent que le pourcentage d' accord, entre des juges ayant â classifier des questions d' examen, n' est pas aussi élevé que prévu. Quant à 1*éva-luation de suggestions autres que la taxonomie par le pro-cédé de classification de questions d' examen par des juges, la littérature est peu éloquente. D ' ailleurs, certaines difficultés méthodologiques seraient susceptibles d ' être rencontrées si 1'on demandait à des juges de classifier des questions d ' examen d'après une liste d'objectifs formulés selon les principes de Mager par exemple. La similitude at-tendue entre les verbes d'action impliqués dans les énoncés de tels objectifs et les consignes données aux sujets dans chacune des questions pourraient être des facteurs impor-tants de contamination dans de telles recherches. Une autre approche qui aurait évité ce danger de contamination aurait

été de demander à plusieurs examinateurs de construire des questions d'examen soit à partir d'un système de classifi-cation comme la taxonomie de Bloom, soit à partir d'objec-tifs formulés selon des principes déterminés comme ceux de Mager. Il ne semble pas que les chercheurs se soient

préoc-cupés de cette façon d'étudier le problème de la communica-tion des objectifs. En ce qui concerne la rédaccommunica-tion de questions d'examen par des examinateurs différents, on peut donc se demander si des examens construits selon les prin-cipes de Mager seraient plus équivalents entre eux que des examens rédigés d' après la taxonomie de Bloom. L' équivalen-ce entre plusieurs examens pourrait être considérée comme étant le résultat d'une interprétation univoque des objec-tifs chez des examinateurs différents. La réponse â une telle question est une hypothèse qui ne semble pas avoir é-té éprouvée dans les recherches ané-térieures.

RATIONNEL ET HYPOTHESES

En vue d'éprouver l'hypothèse de Mager qui implique une relation inverse entre le degré de spécificité impliqué dans un objectif et le nombre d' interprétations diverses de la part de ceux à qui 1' objectif est communiqué, nous avons choisi deux types d'objectifs: des objectifs dont le verbe d'action a été emprunté aux catégories de la taxonomie de Bloom et des objectifs parallèles en contenu qui ont été formulés selon les deux premiers critères de Mager . De plus, il a été postulé théoriquement qu'un objectif d'in-terprétation univoque devrait amener des examinateurs dif-férents â rédiger des questions d'examen équivalentes. Par

extension, un échantillon d'objectifs d'interprétation uni-voque devrait se refléter dans l'équivalence entre des exa-mens de rendement préparés par des-» examinateurs différents.

L' équivalence entre plusieurs instruments de mesure signifie qu'un étudiant peut indifféremment se voir admi-nistrer un instrument ou 1 ' autre sans préjudice pour la qualité de son rendement. Statistiquement, deux ou plu-sieurs instruments de mesure sont équivalents lorsque leurs moyennes sont égales, leurs degrés de dispersion sont égaux

et leurs intercorrélations sont très élevées. (Gulliksen, p.173).

A partir de ce qui précède, nous croyons que: les examens préparés à partir d ' objectifs conformes aux deux premiers critères de Ma-ger seront plus équivalents entre eux que les examens préparés à partir d'objectifs empruntés aux catégories de la taxonomie de Bloom.

Puisque 1' équivalence entre deux ou plusieurs ins-truments de mesure s'évalue en comparant leurs moyennes, leurs degrés de dispersion et en observant le degré d'asso-ciation positive qu'ils manifestent entre eux, trois hypo-thèses spécifiques peuvent être formulées:

1 - Les différences de moyennes entre les exa-mens préparés à partir d' objectifs confor-mes aux deux premiers critères de Mager se-ront moins grandes que les différences de moyennes entre les examens préparés à par-tir de catégories de la taxonomie de Bloom. 2 - Les différences en degré de dispersion

en-tre les examens préparés à partir d 'objec-tifs conformes aux deux premiers critères de Mager seront moins grandes que les

férences en degré de dispersion entre les examens préparés à partir de catégories de la taxonomie de Bloom.

3 - Le degré d ' association entre les examens préparés à partir d'objectifs conformes aux deux premiers critères de Mager sera plus élevé que le degré d'association entre les examens préparés â partir de catégories de la taxonomie de Bloom.

LIMITES DE LA RECHERCHE

Dans le domaine des objectifs pédagogiques, le pro-blème de la communication semble se poser au niveau même de leur formulation. De nombreux auteurs ont reconnu que des objectifs formulés adéquatement facilitent le consensus chez les personnes devant les utiliser tout en favorisant la planification de 1 ' enseignement et en facilitant le processus d ' évaluation. Dans cette recherche, nous avons fait le postulat que le consensus est le phénomène le plus manifestement relié à ce problème de communication duquel dépendent une foule de décisions impliquant 1 ' interpré -tation des objectifs. Il faut admettre que le consensus tel qu'envisagé ici peut revêtir plusieurs manifestations. Ain-si, avec des énoncés d'objectifs utilisés comme stimuli, on pourrait être intéressé à observer:

1 - Le degré d'accord avec lequel des juges classi-fient des énoncés d ' objectifs selon un sche-me quelconque de classification.

2 - Le degré d'accord avec lequel des juges asso-cient des situations concrètes d'examen à ces objectifs.

3 - Le degré d'accord avec lequel des juges asso-cient des éléments de contenu à ces objectifs. 4 - Le degré d'équivalence d'instruments de mesure

construits par des professeurs différentsâ par-tir de ces mêmes énoncés d'objectifs.

5 - Le degré d'accord avec lequel des juges asso-cient des mots clefs(comportements observables) à ces objectifs.

6 - Le degré de concordance dans le choix d'activi-tés d'apprentissage, etc.

Sur le plan expérimental, certaines limitations ont été im-posées pour des raisons d'ordre pratique. Nous avons demandé la collaboration d ' un petit nombre d'enseignants (4) pour jouer le rôle d'examinateurs.Chacun devait rédiger un nombre limité de questions. La rédaction des objectifs utilisés dans cette recherche a été laissée à l'initiative de l'expé-rimentateur.

Le scheme expérimental qui a été utilisé pour cette étude souffre d ' autres limitations importantes qu ' il faut souligner. Rigoureusement, il eût fallu que tous les étu-diants répondent à tous les sous-tests afin d ' obtenir une matrice complète d ' intercorrélatîons. La période de

l'an-née académique pendant laquelle s'est déroulée l'expérience ne permettait pas une intrusion de plus d'une heure et de-mie dans les écoles. De plus, la passation des quatre sous-tests et du test critère par les mêmes sujets nous aurait permis d'appréhender des effets d'apprentissage ou de fati-gue incontrôlables.

PRESENTATION ET ANALYSE DES RESULTATS

Dans ce chapitre, nous allons décrire brièvement l'échantillon, préciser la nature des instruments de mesure, décrire la stratégie expérimentale utilisée et enfin éprou-ver succinctement nos trois hypothèses.

ECHANTILLON

Notre échantillon fut choisi dans deux écoles poly-valentes de la régionale de Tilly, en banlieue de Québec. Il fut assez limité étant donné que nous avions besoin, à la fois et des maîtres et de leurs étudiants impliqués dans le programme de chimie 42, en secondaire IV (llième année). Nous avons pu retenir les services de quatre professeurs et de leurs groupes d'étudiants. Nous avions au total 110 étu-diants, mais au moment de 1 ' expérimentation, 94 seulement furent présents. Voici une brève description de 1 ' échan-tillon quant au sexe :

Répartition des Etudiants selon le sexe

Groupes Garçons Filles Total

A B C D

6

16

15

16

53

9

6

15

11

41

15

2230

27

94

PREPARATION DES LISTES D'OBJECTIFS ET DU TEST CRITERE Rappelons que le but de la présente recherche était de vérifier si des examens construits à partir d ' objectifs conformes aux deux premiers critères de Mager, sont plus équivalents entre eux que des examens préparés à partir d ' objectifs empruntés aux catégories de la taxonomie de Bloom.

Au point de départ, deux listes d'objectifs s'impo-saient : une première contenant des objectifs énoncés selon les principes de Mager (forme OM) et une seconde, composée des mêmes objectifs mais énoncés à partir des termes emprun-tés â la taxonomie de Bloom (forme OB). Pour la construc-tion de la liste de forme OB, nous nous sommes servis d'un test utilisé par Kropp, Stocker et Bashaw dans leur essai

de validation de la taxonomie des objectifs pédagogiques de Bloom (1966). Ce test portait sur la structure atomique de l'atome. En collaboration avec le coordinateur de chimie de la régionale de Tilly, nous avons analysé le contenu du test en question. Nous avons constaté que le contenu était

conforme au programme de chimie 42, en secondaire IV.

Chacune des questions de ce test avait été construi-te par des spécialisconstrui-tes en chimie et avait été catégorisée selon la taxonomie de Bloom. Partant, nous avons tenté de verbaliser, sous forme d ' objectifs, les intentions initia-les visées par ces situations d'examen. La catégorie de la taxonomie étant identifiée, nous avons construit l'objectif avec un des verbes suggérés par Bloom et nous avons utilisé le contenu sur lequel portait la question. Nous avons ain-si élaboré treize objectifs à partir de treize questions. Ces treize questions ont été traduites et retenues pour ser-vir ultérieurement de test critère (test C) dans notre re-cherche. Les objectifs ainsi élaborés se situent dans les quatre premiers niveaux de la taxonomie. Le tableau sui-vant nous donne la répartition du nombre d ' objectifs et du nombre de questions:

Répartition du nombre d'objectifs et du nombre de questions selon les principales catégories de la taxonomie

exploitées dans 1« recherche (1)

Catégories de la Nombre d'objec-taxonomie tifs par

ca-tégorie Nombre tions je de ques-par ob-ctif 1.11 - Connaissance de la terminologie 1 1 1.12 - Connaissance des faits particuliers 2 2 1.21 - Connaissance des conventions 1 1 1.23 - Connaissance des classifications 1 1 1.31 - Connaissance des principes et des lois 1 1 2.10 - Transposition 1 1 2.20 - Interprétation 1 1 3.00 - Application 2 2 4.20 - Recherche des relations 1 1 4.30 - Recherche des principes d'or-ganisation 2 2 TOTAL: 13 13 i-i

(1) Une liste complète des énoncés d ' objectifs et de questions a été reproduite en appendice.

Nous avons aussi élaboré une liste parallèle de treize objectifs rédigés, cette fois, conformément aux

prin-cipes de Mager. Tel que l'avait fait Eva Baker (1967), nous avons déduit de chaque objectif de Bloom, un objectif plus spécifique. La spécificité de 1 ' objectif a été manipulée au niveau du verbe d ' action utilisé dans l'objectif. Pour ce faire des verbes tels que: "indiquer" - "écrire" - "nom-mer" , etc., selon les suggestions mêmes de Mager, ont été utilisés. Cependant, nous avons essayé de conserver le même contenu pour les deux formes d ' objectifs. Nous avons donc élaboré deux listes parallèles d ' objectifs qui diffé-raient par leur degré de spécificité. Nous appellerons la forme OB, celle qui a inspiré la rédaction des objectifs selon les catégories de Bloom, et la forme QM, celle qui a inspiré la rédaction des mêmes objectifs selon les deux pre-miers critères suggérés par Mager. Les treize questions retenues pour 1 ' identification des objectifs à exploiter dans ces deux listes, ont été traduites le plus fidèlement possible afin de servir de test critère.

Rappelons que le rôle de l'expérimentateur était de communiquer des objectifs à des personnes différentes selon deux formulations (forme OB et forme OM) dans le but de fai-re rédiger par ces personnes des situations d ' examens en relation avec ces objectifs. Les treize questions utili-sées comme test critère représentent, dans 1 ' intention de

1 ' expérimentateur, des situations d ' examens perçues comme conformes à ces objectifs.

STRATEGIE EXPERIMENTALE

Nous avons fourni, à chacune des personnes, une lis-te de treize objectifs. Après quoi, nous leur avons deman-dé de construire, à partir de cette liste, une question par objectif (cf. Directives en appendice). Deux professeurs ont reçu une liste d ' objectifs de forme OM et les deux au-tres une liste d ' objectifs de forme OB. Nous avons voulu tenir compte de deux facteurs en fournissant l'une ou l'au-tre des deux listes d ' objectifs : la scolarité et 1 ' expé-rience dans l'enseignement. Le tableau suivant résume les deux liste d'objectifs.

Répartition des professeurs selon le lieu d'enseignement, l'expérience dans l'enseignement, la scolarité

et la liste d ' objectifs reçue

Profes- Ecoles Années d'ex- Années de Listes seurs périence ds scolarité d'objectifs

l'enseigne- reçues ment

A

X

10

15

OM

B

X

12

15

OB

CY

14

14

OM

ûY

25

15

OB

En ce qui concerne la scolarité, nous constatons une répartition très homogène entre les individus concernés. Pour l'expérience dans l'enseignement, nous constatons à peu près la même chose, â 1 ' exception du professeur D qui a 25 ans d ' expérience. Nous avons présumé que le décalage ob-servé entre l'expérience du Professeur D et celle de chacun des autres était moins sérieux que s'il s'était produit avec des professeurs débutant dans l'enseignement. Ces critères n'ont donc pas été considérés pour déterminer la liste

d'ob-jectifs que chacun des professeurs devaient recevoir. Nous avons plutôt tenu compte du fait que les maîtres ne devaient pas communiquer entre eux pendant 1 ' expérience. Les deux professeurs de l'école TJX" ont donc reçu une liste d'objec-tifs de formes différentes (forme OM et forme OB). Il en fut

ainsi pour les deux professeurs de l'école "Y" (forme OM et forme OB). Chaque maître nous a donc produit un ensemble de treize questions objectives en relation avec la liste des 13 objectifs que nous lui avons fournie. Cette partie de l'expérience s ' est déroulée dans les dernières semaines de mai 1971.

A partir des questions fournies parles professeurs, nous avons élaboré quatre sous-tests: deux de forme M grou-pant les questions rédigées par chacun des professeurs ayant reçu des objectifs de forme OM et deux autres de forme B groupant les questions rédigées par chacun des professeurs

ayant reçu des objectifs de forme OB. Deux tests ont été élaborés en réunissant, pour chacun des tests, trois sous-tests de 13 questions. Ces deux sous-tests pourraient être dé-crits ainsi:

Le test M a été formé des sous-tests suivants:

1) le sous-test M, (13 questions du professeur A ) . 2) le sous-test M^ (13 questions au professeur C).

3) le sous-test G-, (13 questions critères de 1' expéri-mentateur) Le test B a été formé des sous-tests suivants:

1) le sous-test B-, (13 questions du professeur B). 2) le sous-test Bg (13 questions du professeur D ) .

3) le sous-test C^ (13 questions critères de 1 ' expéri-mentateur) N.B. - Le test critère a été indicé (C, ou Cg) pour diffé-rencier les résultats obtenus avec les échantillons de su-jets auxquels il a été administré. Il s'agit toutefois de la même collection de treize questions adaptées par l'expé-rimentateur.

Les 39 questions de chacun des tests (test M et test B) ont été distribuées au hasard à partir d ' une table de nombres distribués au hasard.

Le test M a été administré à deux classes d ' étu-diants et le test B à deux autres classes d'étuétu-diants. Les élèves des professeurs qui ont fait des questions à partir d'une liste d ' objectifs de forme OM ont reçu le test B et

les élèves des professeurs qui ont construit des questions à partir d ' une liste d ' objectifs de forme OB ont reçu le test M. Des directives précises accompagnaient le test (cf. Appendice). Aucune formule pour pallier le hasard n'a été utilisée dans la correction. Une heure et trente minutes ont été accordées pour répondre au test. Tous les étudiants ont eu le temps de terminer. Cette partie de l'expérimen-tation s'est déroulée dans la première semaine de juin 1971»

VERIFICATION DES HYPOTHESES Première hypothèse

La première hypothèse impliquait une double prédic-tion, à savoir 1 ' équivalence entre les moyennes des sous-tests M, et Mp d ' une part et une différence significative entre les moyennes des sous - tests B, et B2 d ' autre part.

Les résultats sont rapportés dans le Tableau I. TABLEAU I

Moyennes pour chacun des sous-tests à l'intérieur de chaque échantillon et rapports critiques qui ont servi

à l'épreuve de la première hypothèse

Premier échantillon Deuxième échantillon

"i

Hj B. B. Moyennes 7.04 5.33 7.15 8.81 9.04 8.83 Rapports critiques des diffé-rences de moyennes. (1) Ml " Ml * «2 » *2 " C = C «= 4.43** 0.21 5.31** Bl -Bl " B2 -B2 = 0.93 C ~ 0.0001 C = 0.79 Rapport critique de la différence entre les différences demoyennes:

(Mj^ - Mg) - (Bx - B2) est de

3.56**

D'après le Tableau I, 1 ' hypothèse de l'équivalence entre les moyennes aux deux sous -tests de type M est reje-tée à un niveau de probabilité inférieur à .01. De plus, le rapport critique de 0.93i correspondant à la différence B-, - B2, ne permet pas d'accepter l'hypothèse que les

sous-tests Bn - B2 ont des moyennes significativement

différen-tes.

Le rapport critique de 3*56, correspondant à la dif-férence entre les difdif-férences de moyennes, dépasse le seuil requis pour être significatif de .01. Cette différence si-gnificative peut être due à deux facteurs importants : soit â une différence de performance entre les deux échantillons,

soit à une différence réelle en niveau de difficulté entre les deux groupes de sous-tests.

En résumé, les données de cette étude, exprimées en termes de moyennes observées aux divers sous-tests, ne nous permettent pas d'accepter notre première hypothèse de

re-cherche .

Deuxième hypothèse

La deuxième hypothèse prédisait une équivalence en-tre les sous-tests M-, et M2 plus grande que 1 ' équivalence entre les sous-tests B-, et B2 et ce, en termes de degrés de

dispersion des résultats aux deux sous-tests. Les résultats relatifs à cette hypothèse sont rapportés dans le Tableau II.

TABLEAU II

Ecarts - types pour chacun des sous - tests à l'intérieur de chaque échantillon et tests statistiques qui ont servi

à l'épreuve de la deuxième hypothèse

Premier échantillon M, »2 Deuxième échantillon B, B, Ecarts-types 2.71 2.16 2.18 1.84 1.89 1.99 Rapports critiques des diffé-rences de variances (Mx - R>) - 1.68 (Mx - C ) » 1.53 (Mg - C ) -- 0.07 (B-L - B2) « 0.21 (B1 - C ) - 0.63 (B2 - C ) - 0.38 Ecarts-types des différen-ces de ré-sultats entre les sous-tests M1I42 MjC 2.60 2.84 2.30 B1B2 B ^ B2C 1.94 1.86 2.16

Le rapport "F" de la différence des résultats entre MnM^ et

.80*1 x

entre B-,B2 est égal à: l.i

I.T.. Niveau de signification: * p ^ .05

Les rapports critiques consignés dans le Tableau II ne permettent pas de rejeter 1 'hypothèse de

l'équivalen-ce de dispersion entre chacun des sous-tests comparés deux â deux. En effet, puisqu'à l'intérieur de chaque échantillon

il s'agit de comparer les écarts-types à partir de données pairées, un test statistique suggéré par J. P. Guilford

(1965» p. 193 et p. 581) exige un rapport critique aussi élevé que 2.01 pour être significatif à .05. Or, les va-leurs de 1.68 (pour la différence d'écarts-types entre M-, et Mg) et 0.21 (pour la différence d'écarts - types entre B, et B2) étant inférieures à la valeur requise, on conserve donc

l'hypothèse de 1 ' équivalence entre chacun des sous - tests mis en comparaison.

Quant à la différence entre des différences de de-grés de dispersion, l'a stratégie utilisée a été de comparer les écarts - types de la différence des résultats observés entre M-, et flL e t entre B, et B2. Comme il s ' agit ici de

comparer deux écarts - types provenant de deux échantillons indépendants, un rapport F de différence entre des varian-ces a été estimé. (Guilford, pp. 191-192 et p. 583). Un rapport F de 1.80 significatif à .05» nous permet à ce ni -veau de constater la non-équivalence en degré de dispersion entre les deux échantillons soumis à l'expérience. Cepen-dant, à un niveau de signification de .01, le rapport F de 1.80 ne nous permet pas de rejeter l'hypothèse de non équi-valence entre les résultats obtenus.

En résumé, les données de cette étude, exprimées en terme d'équivalence en degrés de dispersion, ne nous

permet-tent pas d'accepter d'emblée la deuxième hypothèse de notre recherche.

Troisième hypothèse

La troisième hypothèse prédisait un degré d'asso ciation entre les soustests M, et M2 plus grand que le de gré d ' association entre les sous tests B, et B2, ce degré

d ' association se traduisant par un coefficient de corréla tion. Les résultats obtenus sont rapportés dans le Tableau suivant.

TABLEAU III

Corrélations entre chacun des soustests à l'intérieur de chaque échantillon qui ont servi à l'épreuve

de la troisième hypothèse

Premier échantillon Deuxième échantillon Corrélations entre les sous tests et les rap ports cri tiques.

Le rapport critique de la différence entre les corrélations MnM> B,B0 est égal à 0.09 MjMg 0 . 4 5 * * B1B2 * °«-+6** MjC •= 0 . 3 4 * B ^ « 0 . 5 3 * * MrpC 0 . 4 4 * * B2C «■ 0 . 3 8 * * Niveaux de signification: * p é .05 ** p ù .01

Nous constatons que les corrélations entre les sous-tests M-, et Mg et entre les «ous-sous-tests B., et B2 sont

signi-ficatives à .01. Cependant, le degré d ' association entre les sous-tests M, et Mg est à peine inférieur au degré d'as-sociation entre les sous - tests B-, et B2. De plus, cette

différence du degré d'association en faveur des sous - tests B, et B2 ne dépasse pas le seuil requis pour être

signifi-cative à ^05»

En résumé, les données de cette étude, exprimées en termes de degré d ' association entre les divers tests,ne nous permettent pas d'accepter notre troisième hypothèse de recherche.

CONCLUSION)

Dans 1 ' ensemble, les résultats ne nous permettent pas d'accepter nos trois hypothèses de recherche. Les exa-mens préparés à partir d ' objectifs conformes aux deux pre-miers critères de Mager, ne seraient pas plus équivalents entre eux que les examens préparés à partir d'objectifs em-pruntés aux catégories de la taxonomie de Bloom. Cependant, une analyse des facteurs qui ont pu influencer les résul-tats observés et un examen des questions préparées par les maîtres, nous permettront peut-être d ' apporter une amorce d'explication des résultats obtenus.

ASPECTS EXPLORATOIRES

La méthodologie utilisée dans cette étude a proba-blement eu une forte influence sur les résultats obtenus. Il apparaît que 1 ' équivalence entre des instruments de me-sure construits isolément par des personnes différentes constitue un critère fort exigeant pour évaluer le degré auquel ces personnes interprètent des objectifs d'une maniè-re univoque. En effet, beaucoup de facteurs difficilement contrôlables peuvent intervenir même si l'on demande à des examinateurs différents de se conformer à la rédaction de questions d'un même type (comme celles comportant quatre alternatives dont une bonne réponse et trois leurres). Par-mi les facteurs qui ont pu influencer le degré d'équivalen-ce entre les différents instruments de mesure, citons prin-cipalement :

1 - le degré de consistance interne de chaque instru-ment de mesure;

2 - le degré de difficulté des questions ; 3 - le degré d'attraction des leurres ;

4 - le degré d ' équivalence entre les deux sous - échan-tillons ;

5 - la qualité sémantique de 1 ' énoncé principal dans une question à choix multiples et des alternatives proposées ;

Ces divers facteurs, lorsqu'il s'agit d'équivalence entre des tests préparés par des examinateurs différents, pourraient être associés à ce qu'on appelle l'erreur de me-sure et auraient pour effet d'amener des fluctuations impor-tantes au niveau des moyennes, des écarts - types et des in-tercorrélations. Le choix d ' une variable dépendante qui serait relativement exempte de telles fluctuations est un problème de scheme expérimental qui ne semble pas avoir été abordé dans les études antérieures. Une analyse qualitati-ve du contenu des questions rédigées par différents exami-nateurs dans une telle situation pourrait bien s'avérer plus efficace pour évaluer le degré d'univocité dans l'in-terprétation d'objectifs que l'analyse statistique des don-nées empiriques. Le but du présent chapitre sera d'exami-ner les résultats obtenus en regard des considérations qui précèdent et ce, en vue de suggérer quelques éléments de méthodologie de la recherche dans le domaine de la

communi-cation des objectifs.

LE DEGRE DE CONSISTANCE INTERNE DES DIVERS SOUS-TESTS Dans l'ensemble, les consistances internes des sous-tests, telles que calculées parla formule de Kuder-Richard-son (KR-20), Kuder-Richard-sont relativement faibles. Ces valeurs Kuder-Richard-sont rapportées dans le Tableau IV.

TABLEAU IV

Consistances internes pour chacun des sous-tests et nombre

de fois qu'il faudrait allonger chacun de ces sous-tests

pour obtenir une consistance interne idéale de 0.90^

Nombre de fois qu ' il

faudrait allonger

cha-Sous-tests Consistance cun des sous - tests

interne pour obtenir une

con-sistance interne de

.90

M

x.67 4

Mg .46 11

B

±.38 15

B

2.40 13

C

1.52 8

C

0.49 9

Nous constatons que ces valeurs de consistance

in-terne varient entre .67 pour le sous-test M-, et .38 pour le

sous-test B-,. Plusieurs facteurs concourent à expliquer la

faiblesse relative de ces consistances internes. En ce qui

nous concerne, le nombre limité de questions, soit treize

questions par sous -test, peut constituer une explication

valable. En appliquant la formule de Spearman-Brown (Ebel,

p. 315) utilisée pour estimer la précision d ' un test dont

la longueur est multipliée par un facteur "k", nous remar-quons d'après les données du Tableau IV que le sous-test B, devrait être allongé de quinze fois sa longueur initiale c'est-à-dire contenir 195 questions équivalentes pour obte-nir une consistance interne acceptable de .90. Si l'on fait subir le même traitement au sous-test B2, il faudrait alors

l'allonger de 13 fois sa longueur initiale pour obtenir une consistance interne idéale de .90. Dans 1 ' éventualité de reprise de la même étude, il faudrait sans doute demander aux constructeurs de tests un plus grand nombre de questions afin d'en améliorer la consistance interne.

Un autre facteur susceptible d'influencer la valeur de la consistance interne réside dans le degré de difficul-té des questions d'un test. La consistance interne est in-fluencée par le degré de difficulté des questions dans le sens d'une diminution ou d'une sous- estimation lorsque les indices de difficulté de ces questions s ' écartent du point milieu .50 (Gulliksen, 1950, chap. 16).

LE DEGRE DE DIFFICULTE DES ITEM

Au niveau des pourcentages moyens de réussites, il ne semble pas y avoir de fluctuations considérables à l'in-térieur de chaque échantillon. Ces valeurs sont rapportées dans le Tableau V.

TABLEAU V

Pourcentages de réussites pour chaque question de chacun des sous -tests à l'intérieur de chaque échantillon

Pourcentages de réussites Numéros des objectifs stimuli Premier échantillon Mx ^ C Deuxième échantillon Bl B2 C 1 0.67 0,38 0.67 0.47 0.67 0.90 2 0.56 0.42 0.47 0.96 0.92 0.61 3 0.49 0.31 0.58 0.55 0.35 0.61 4 0.47 0.31 0.64 0.69 0.80 0.55 5 0.29 0.78 0.93 0.63 0.37 1.00 6 0.80 0.51 0.24 0.73 0.84 0.63 7 0.80 0.18 0.73 0.82 0.67 0.92 8 0.53 0.18 0.84 0.31 0.84 0.90 9 0.78 0.62 0.53 0.73 0.80 0.86 10 0.60 0.53 0.60 0.96 0.51 0.53 11 0.27 0.60 0.20 0.26 0.78 0.33 12 0.56 0.38 0.42 0.92 0.57 0.84 13 0.24 0.13 0.29 0.80 0.98 0.16 Pourcen-tages moyens de réus-sites 0.54 0.41 0.55 0.679 0.70 0.68

Pour les questions formulées à partir d ' objectifs conformes à la taxonomie de Bloom, on constate une grande homogénéité. Les pourcentages moyens de réussites varient de .679 à .700. Pour l'autre échantillon, 1' homogénéité demeure encore assez bonne, les pourcentages moyens de réus-sites variant de .41 a .55» Cependant, cette homogénéité ne se reflète pas au niveau des pourcentages de réussites pour chaque question. Nous remarquons, dans certains cas, des fluctuations considérables pour des questions élaborées à partir d ' un même objectif et ce, pour les deux échantil-lons. Ainsi, pour les questions construites à partir de "l'objectif stimulus 13"» les sous - tests B, et B2

conser-vent respectivement des pourcentages de réussites de .80 et .98, alors que le test critère a un pourcentage de réussites de .16. Dans le cas de "l'objectif stimulus 7"> nous re-trouvons une situation analogue. Le sous-test M, a un

pour-centage de réussites de .80, alors que cette valeur est de .18 dans le cas du test critère.

Ces écarts en termes de pourcentages de réussites contribuent à expliquer, en partie, les faiblesses relati-ves des consistances internes obtenues. En effet, les va-leurs de consistances internes obtenues par la méthode de Kuder-Richardson (Ebel, p. 362) sont affectées parle niveau moyen des indices de difficultés des questions. Deux

ensem-blés de questions qui présentent la même somme de covarian-ces d'item, ce qui, théoriquement implique une même consis-tance interne de contenu, ces deux ensembles de questions peuvent avoir un degré de consistance interne différent. Pour illustrer cet énoncé, considérons un ensemble de ques-tions ayant des pourcentages de réussites variant de .60 à

.90, et un second ensemble de questions ayant des pourcen-tages de réussites variant de .40 à .60; ce dernier obtien-dra une consistance interne supérieure au premier. La for-mule Kuder-Richardson fournit une valeur maximum dans le cas où le pourcentage de réussites est de l'ordre de .50. Ce qui précède, non seulement contribue à expliquer la faiblesse relative des consistances internes obtenues dans cette étu-de, mais aussi implique que 1 ' on peut difficilement compa-rer les consistances internes de deux échantillons diffé-rents comme c'est le cas ici.

LE DEGRE D'ATTRACTION DES LEURRES

Un autre facteur important à considérer dans 1 ' ex-plication des variations d'indices de difficulté est le de-gré d ' attraction des leurres qui ont été conçus par les examinateurs. Chaque leurre d'une question devrait être choisi par une même proportion du nombre de répondants qui n'ont pas réussi cette question. Puisque dans cette étude

chaque question devait comporter trois leurres, chaque leur-re aurait dû leur-recevoir un tiers du nombleur-re total de répondants qui ont échoué une question.

Le Tableau VI nous renseigne, pour chacune des ques-tions associée à un objectif stimulus et rédigée par un exa-minateur particulier (M-,, Mg, B,, B2, C), sur le nombre de

leurres qui s'écartent de ce degré d ' attraction théorique-ment attendu.

TABLEAU VI

Nombre de leurres qui ont un degré d'attraction inférieur au tiers du nombre d'échecs

à chaque question (1) Nombre de leurres Numéros des objectifs stimuli Premier Ml échantillon M, C Deuxième Bl échantillon B2 C 1 2 0 1 2 1 2 2 2 1 2 2 1 1 3 0 2 2 2 0 2 4 1 2 1 1 2 0 5 2 2 2 2 1 0 6 1 2 2 1 1 2 7 2 1 1 1 1 2 8 1 2 1 1 2 1 9 1 2 2 2 1 1 10 2 1 2 2 1 1 11 0 1 1 2 0 2 12 1 1 2 1 2 2 13 1 1 2 1 2 1

Une vue d'ensemble du Tableau VI premet, en premier lieu, de constater que le nombre de leurres qui fonctionnent varie d'un examinateur à l'autre. Par exemple, pour

"l'ob-jectif stimulus 3"» chacun des trois leurres reçoit la fa-veur d'environ un tiers des répondants qui ont échoué cette question du sous-test M,, par contre, deux leurres dans les question du sous-test M2 et du test critère ne réussissent pas à attirer au moins un tiers des répondants qui ont raté cette question. Cette dernière observation est applicable pour l'ensemble des questions de chaque échantillon. D'ail-leurs, ces fluctuations s'observent non seulement entre les questions répondues par un échantillon donné, mais aussi d'un échantillon à l'autre.

Ce petit nombre de leurres qui a reçu un pourcenta-ge acceptable d ' attraction fait, qu'en pratique, le nombre d'alternatives accompagnant la bonne réponse a varié d'une question à l'autre. Nous sommes ici, en face d'un des as-pects les plus criticables de la méthodologie utilisée pour évaluer la "communicabilité" des objectifs, au moyen de la construction d'examens objectifs de rendement par des minateurs différents. En effet, en supposant que deux exa-minateurs aient interprété d'une manière univoque un tif stimulus qui leur a été communiqué, les questions objec-tives qu'ils rédigeront, présenteront fort probablement des différences de qualité dans le degré d'attraction des

leur-res, différences qui sont inévitables et dont l'effet est imprévisible sur le degré de difficulté des questions.

LE DEGRE D'EQUIVALENCE ENTRE LES DEUX SOUS-ECHANTILLONS Y a - t - i l équivalence de rendement entre les deux sous-échantillons considérés dans cette étude. Cette équi-valence devrait se traduire par des moyennes semblables à une mesure commune. Rappelons que parmi les divers sous-tests utilisés, les treize questions constituant le test critère ont été répondues par les sujets provenant des deux échantillons. Les moyennes sont rapportées dans le Tableau suivant.

TABLEAU VII

Moyennes au test critère pour chacun des échantillons et rapport critique

Premier échantillon Deuxième échantillon

Moyennes 7.15 8.83 Rapport cri-tique de la différence des moyennes^-tique de la -3 «JC&A différence 3*8 5** "•"Niveau de signification: ** p « .01

Le Tableau VII rapporte, pour le premier et le se-cond ^hantillon, des moyennes respectives de 7.15 et 8.83. Le rapport critique de 3.85» significatif à .01, nous per-met de rejeter l'hypothèse que les deux échantillons pro-viennent d'une même population. Cette conjecture a proba-blement influencé certains résultats notamment les moyennes et les consistances internes des sous - tests et indique la faiblesse du scheme expérimental quia été utilisé, faibles-se déjà soulignée au niveau des limitations de cette étude.

LA QUALITE SEMANTIQUE DE L'ENONCE PRINCIPAL ET DES ALTERNATIVES PROPOSEES

La qualité sémantique constitue un facteur impor-tant dans l'élaboration d'une question d'examen. Une ques-tion d ' examen établit une communicaques-tion entre une personne qui joue le rôle de 1 ' examinateur et un sujet qui joue le rôle de 1 ' examiné. Ce dernier doit saisir parfaitement l'intention de 1 ' examinateur lorsqu ' il a formulé la ques-tion. On ne peut nier 1 ' importance que prend un tel fac-teur dû au fait que chacun des sous - tests a été construit par des personnes différentes. On pouvait difficilement espérer avoir des questions de bonne qualité chez les pro-fesseurs qui ont joué le rôle d' examinateurs dans cette é-tude.

L'HOMOGENEITE DU CONTENU POUR. CHAQUE OBJECTIF

A ce facteur de qualité sémantique est reliée l'ho-mogénéité du contenu pour chacun des objectifs. En effet, pour un même objectif, on pouvait s'attendre à ce que les examinateurs construisent des questions semblables du moins quant au contenu. Or, une analyse très sommaire du contenu manipulé dans chaque question , nous permet d ' observer qu' il n'y a pas unanimité chez les examinateurs à ce point de vue. Sur 26 questions construites par deux professeurs conformément aux deux premiers critères de Mager, 18 seu-lement entraînent un consensus quant au contenu. Par con-tre, cette unanimité est encore plus faible pour les ques-tions construites à partir d'objectifs fidèles à la taxono-mie de Bloom : 10 questions sur 26 portent sur un contenu

conforme à celui suggéré par 1' objectif. Ces observations nous permettent de noter que non seulement le comportement suggéré par l'objectif mais aussi le contenu peuvent être des facteurs qui influencent l'équivalence entre des instru-ments de mesure.

DISCUSSION

Il appert donc que la construction d'instruments de mesure par des personnes différentes, semble impliquer plu-sieurs facteurs susceptibles d ' influencer le degré d'équi-valence entre ces instruments de mesure.

Ainsi, au niveau des indices de difficultés, nous constatons un nombre imposant de fluctuations sur les ques-tions élaborées à partir d'un même objectif. D'ailleurs la faiblesse relative des consistances internes des sous-tests s'explique en partie par ces; fluctuations; le petit nombre de questions et le fait que les deux échantillons ne pro-viennent pas d'une même population jouent également dans le même sens. Il ne faudrait pas nier non plus que les

pour-centages d'attraction des leurres ont influencer les pourcen-tages de réussites. Cependant, ce phénomène est difficile-ment contrôlable dans le contexte où des personnes différen-tes ont à construire des questions isolément. D'ailleurs, on retrouve la même difficulté en ce qui concerne la quali-té sémantique des questions. Ajoutons à cela que les cons-tructeurs de tests n'ont pas toujours été fidèles au conte-nu suggéré par l'objectif.

Dans une recherche comme la nôtre, il serait utopi-que d'espérer exercer un contrôle parfait sur les facteurs

pouvant influencer les résultats escomptés de sorte que même si les objectifs étaient formulés adéquatement, il faudrait s'attendre encore à ce que les instruments de me-sure construits à partir de ces objectifs ne soient pas équi-valents entre eux.

Les données de cette étude ne nous ont pas permis de vérifier l'hypothèse fondamentale soutenant que des exa-mens préparés par des personnes différentes à partir d'ob-jectifs conformes aux deux premiers critères de Mager sont plus équivalents entre eux que ceux construits à partir d'objectifs empruntés aux catégories de la taxonomie de Bloom. Pour les tests construits selon les critères de Ma-ger, nous nous attendions à ce que les moyennes et les écarts-types soient plus semblables entre eux, à ce que la corré-lation soit plus élevée que pour les tests construits selon les catégories de la taxonomie de Bloom. A première vue, il semble que les limitations que nous avons dû nous imposer au niveau du scheme expérimental et parmi lesquelles

figu-rent le nombre restreint de sujets d'une part et 1'impossi-bilité d'administrer les sous-tests à tous les sujets d'au-tre part, ont largement influencé les résultats obtenus.

Même si nous n ' avons pas réussi à établir que le fait de formuler des objectifs en termes spécifiques a d'une manière consistante, une influence positive sur le rendement scolaire de l'étudiant, nous nous sommes permis une analyse sommaire des facteurs susceptibles d'influencer l'équivalen-ce d ' instruments de mesure construits par des personnes différentes. Ces facteurs pourraient être une explication

plausible à l'écart entre les résultats attendus et les ré-sultats obtenus. Cette analyse nous a permis les observa-tions suivantes:

1 - une consistance relativement faible pour chacun des sous-tests;

2 - une certaine disparité entre les indices de diffi-cultés des questions issues d'un même objectif, c'est à-dire pour des questions parallèles;

3 - un degré d ' attraction hétérogène des leurres pour des questions parallèles;

4 - des échantillons de sujets non équivalents quant à la compétence reflétée par le test critère;

5 - la qualité sémantique des questions pouvant varier d'une personne à l'autre;

6 - l'hétérogénéité des questions parallèles quant au contenu suggéré par les objectifs stimuli.

Ces différentes observations que nous avons tirées de nos résultats permettraient d'améliorer la méthodologie à suivre dans une recherche comme la nôtre. Si une telle étude était reprise, nous ferions les suggestions suivantes:

1 - utiliser un plus grand nombre de sujets;

2 - administrer tous les sous - tests à tous les sujets afin d'obtenir un scheme expérimental plus rigoureux 3 - augmenter le nombre de questions pour chacun des sous-tests afin d'assurer une plus grande stabilité des résultats;

4 - contrôler la qualité sémantique des questions en les faisant reviser par des juges;

5 - augmenter le nombre de leurres par question à faire rédiger pour pallier à l'influence du degré d'at-traction des leurres sur la difficulté des ques-tions.

6 - faire en sorte que chaque question issue d'un même objectif porte sur le contenu suggéré par l'objec-tif;

7 - augmenter le nombre de personnes jouant le rôle de rédacteurs de questions à partir d'objectifs;

Comme nous l'avons suggéré au moment où nous avons établi les limites de notre recherche au chapitre II, le consensus obtenu par des personnes qui utilisent des objec-tifs formulés adéquatement, peut revêtir différentes mani-festations. En ce qui nous concerne, nous avons opté pour l'équivalence entre des instruments de mesure issus d'ob-jectifs semblables. Il serait, sans doute, intéressant de comparer nos résultats avec ceux obtenus par d'autres pro-cédés, comme le degré d ' attraction avec lequel les juges classifient des énoncés d'objectifs selon un scheme quel-conque de classification, le degré d'accord avec lequel des juges associent des situations concrètes d'examen à ces ob-jectifs, etc. De telles recherches permettraient d'élimi-ner certaines limitations méthodologiques imposées par no-tre étude et ainsi d'évaluer, d'une manière plus rigoureuse, le degré d'accord entre des personnes exposées à certains types de formulation d'objectifs.

DETERMINEE D'OBJECTIFS

La tâche qui vous est demandée consiste à construi-re, pour chacun des objectifs, une question d*examer}. "IL EST TRES IMPORTANT QUE VOTRE QUESTION MESURE LE PLUS

ETROI-TEMENT POSSIBLE L'OBJECTIF POURSUIVI.» Vous aurez donc à construire "13" questions, soit une question par objectif.

Vous devez construire des questions à choix multi-ples (quatre alternatives). Parmi les quatre alternatives, trois sont des leurres et la quatrième est la bonne réponse. Assurez-vous que votre question soit de bonne qualité sur le plan technique. Que les énoncés soient clairs et que les leurres soient attrayants; QUE TOUTE AMBIGUÏTE SOIT AINSI EVITEE!

Peut-être, aurez - vous la tentation d'utiliser des questions déjà formulées. Il faudra alors vous assurer que la question soit pertinente et selon 1 ' objectif poursuivi; que sa qualité technique soit irréprochable. Pour plus d'ef-ficacité, il vaudrait mieux que vous construisiiez vous-même la question.

En somme, vous avez en main trois documents:

a) Le DOCUMENT "A" qui vous donne les directives à suivre.

b) Le DOCUMENT "B" qui vous sert de brouillon. c) Le DOCUMENT "C" qui est à remettre. Nous

appré-cierons beaucoup que vos questions soient dacty-lographiées, une question par page, tel que spé-cifié dans le DOCUMENT "C".

S'il se produit des problèmes majeurs, vous pourrez toujours me téléphoner aux numéros indiqués sur la page frontispice. Nous passerons à la date convenue pour revi-ser et ramasrevi-ser le travail. Nous procéderons delà même fa-çon pour l'administration d'un test de chimie à une trentai-ne de vos élèves.