République Algérienne Démocratique et Populaire

Ministère de l’Enseignement Supérieur et de la Recherche Scientifique

Université Akli Mohand Oulhadj–Bouira

Faculté des sciences et des sciences appliquées

Département de Génie Electrique

Mémoire de Master

Option : Télécommunications

Thème :

Compression des images numeriques par la

technique des ondelettes (JPEG2000).

Réalisé Par :

Encadreur :

-Ziani Leila -Prof.A.Ouahabi

Dédicace

Je dédie ce modeste travail à :

Mon cher Père (qui’Allah lui fasse miséricorde) ;

Ma chère Mère, Dieu me sauvera ;

A toute ma famille ;

A touts mes amis ;

Remerciements

Avant tout je tiens mes remerciements à mon dieu tout puissant

De mon avoir donner la force et le courage.

Je saisons cette occasion pour adresser mes remerciements les plus

profonds à :

Mon promoteur Prof.A.Ouahabi qui a fourni des efforts énormes, par

ses informations ses conseils et ses encouragements.

Je voudrais aussi exprimer mes remerciements aux membres du jury

en acceptant de jugerce travail.

Que tous les enseignants qui ont contribué à ma formation trouvent en

ce modeste travail, le témoignage de ma profonde gratitude.

Je tiens aussi à remercier tous qui de près ou de loin m’ont aidé et

encouragé dans ce travail

Résumé

L'objectif de ce travail est l'étude de la compression des images numériques par la technique des ondelettes, plus précisément la norme de compressiond’images JPEG 2000 (Joint Photographic Expert Group) basée sur les ondelettes. La norme de compressionJPEG à base de la TCD (Transformée en Cosinus Discrète) a beaucoup de succès et resteencore une méthode de compression d’images très performante dans le domaine de l’Internetet des appareils photos numériques. Pour les faibles valeurs du taux de bits, la qualité de l’image se dégrade rapidement. JPEG2000 avait comme objectifs principaux de répondre aux divers besoins, des nouvellesapplications et d’apporter une nette amélioration par rapport à JPEG. Les expérimentations proposées dans ce travail sont réalisées sous l’environnement MATLAB.

SOMMAIRE

Introduction générale……….01

Chapitre 1 : Généralités sur la compression d’images

I-1. Introduction à la compression d’images………..……02I-2. Principe général de la compression des images ……….03

I-3. Classification des méthodes de compression ……… 04

I-3-1. Méthodes de compression sans perte d’informations ……… I-3-2. Méthodes de compression avec perte d’informations ………... I-4. Evaluation de la compression ………... 05

I-5. Qualité de reconstruction des images ……….06

I-6. Conclusion ………..07

Chapitre 2 : JPEG vs JPEG 2000

II-1. Introduction………08II-2.Compression JPE……… II-3. Compression JPEG2000 ………..11

II-3-1. Etapes de la compression JPEG 2000……….. II-3-2. La transformée en ondelettes discrète (DWT)………. ….12

II-3-2-1. Concepts de base ………...13

II-3-2-2. DWT 2D – Transformée en ondelettes discrète d’une image numérique…...15

II. 4. Avantages de la compression JPEG 2000 ………....19

Chapitre 3 : partie pratique sous l’environnement Matlab

III-1.Introduction………22III-2.Ondelettes privilégiées en compression d’images………. III-2-1.Ondelettes de Daubechies……… III-2-2. Ondelettes biorthogonales……….23

III-3-1.L’environnement Matlab……….

III-3-1-1.Compression d’empreintes digitales utilisée dans le FBI………...25

III-3-1-2.Compression image mask………...27

III-3-1-3Manipulation des images vraies couleur ……….30

III-4.Conclusion……….31

Conclusion générale………32

Liste des figures

Figure I. 1 Schéma de principe de la compression d’images……….03

Figure II.1Principe de la compression JPEG ………....09

Figure II.2 Schéma bloc de la compression/décompression JPEG 2000………...12

Figure II.3 Ondelette de Haar………13

Figure II.4 Ondelette dite « chapeau mexicain » (en anglais mexicanhat).………...14

Figure II.5 Ondelette de Morlet.………... Figure II.6 Principe de l’analyse multirésolution d’une image en considérant 3 résolutions……....18

Figure II.7Analyse multirésolution de l’image Lena en considérant 3 résolutions ou 3 échelles….. Figure II.8Reconstitution de l’image originale à partir d’une analyse multirésolution...19

Figure III.1 Exemple d’ondelette de Daubechies (ici db2).……….23

Figure III.2Exemple d’ondelettes bio-orthogonales. Ondelettes bi-orthogonales 9/7……….24

Figure III.3 Image originale à compresser……….25

Figure III.4 Image (empreinte digitale) compressée………..26

Figure III.5Image originale (mask) à compresser………..27

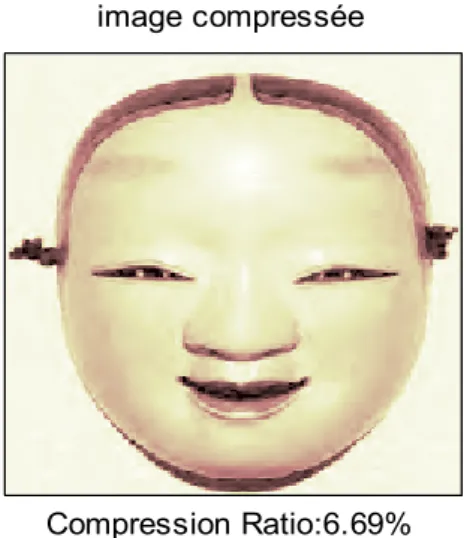

Figure III.6 représente une image originale et image compressée à taux de compression 6.69% et BPP 0.54………...28

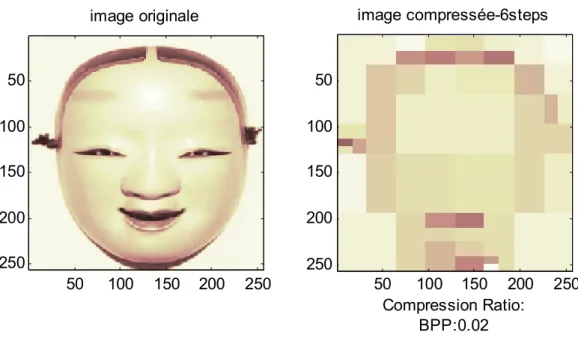

Figure III.7 Figure (III-7) : représente une image originale et image compressée-6 étapes à taux de compression 0.21% et BPP 0.02……….29

Figure III.8 Figure (III-8) : représente une image compressée-9 étapes à CR 1.93% et BPP 0.15 et une image compressée-12 étapes à CR 11.53% et BPP 0.92……….30

Figure III.9 Image originale à compresser...31 Figure III.10 Image copressée ……….

Liste d’abreviations

BPP Bit Par Pixel.

DCT Transformée en Cosinus Discrète. DWT Transformée en ondelettes. EQM Erreur Quadratique Moyenne. EZW Embedded Zero tree Wavelets. JPEG Joint Photographic Expert Group.

JPEG2000 Standard de compression d’images fixes récent, introduit par JPEG. MPEG-4 Moving Picture Exeperts Group 4.

PSNR Rapport Signal sur bruit crête. ROI Rigion Of Interest.

RC Rapport de Compression.

RLE Codage de Longueur de séquence. SNR Rapport Signal sur bruit.

1

Introduction générale

L’objectif de ce travail est d’étudier la nouvelle norme de compression d’images fondée sur les ondelettes et leurs propriétés.

Aujourd’hui, chacun est conscient de l’importance des images numériques et des messages qu’elles véhiculent. Le développement exponentiel de ce support d’information via Internet, la téléphonie mobile et de façon générale les multimédia pose le problème de stockage et de transmission des images. D’où la nécessité de compresser ces images afin de pouvoir stocker correctement ce volume important d’information, et le transmettre avec un débit de plus en plus élevé.

Après avoir rappelé la norme de compression JPEG, aujourd’hui largement utilisée, nous montrons ses avantages et limitations puis nous introduirons la nouvelle norme de compression JPEG2000 que nous comparerons à JPEG. Les expérimentations proposées dans ce travail sont réalisées sous l’environnement MATLAB.

Afin d’atteindre ces objectifs, ce rapport de master 2sera composé de trois chapitres :

Le premier chapitre rappelle les idées de base de la compression, du codage utilisée et des critères d’évaluation d’une compression d’images. Pour des raisons évidentes (afin d’éviter tout plagiat), nous renvoyons vers une bibliographie très fournie le lecteur désireux approfondir ces notions qui sortent du cadre de notre travail.

Le chapitre 2, est orienté vers la compression selon la norme JPEG puis vers la nouvelle norme JPEG2000 fondée sur les ondelettes Les ondelettes seront naturellement introduites où nous mettons l’accent sur les ondelettes orthogonales (par exemple les ondelettes de Daubechies) et les ondelettes bi-orthogonales qui ont la propriété de minimiser le nombre de coefficients d’ondelettes, ce qui est intéressant lorsque l’objectif poursuivi est une compression.

Dans le dernier chapitre, nous présenterons des applications de compression d’images qui montrent la puissance et les bonnes performances de la compression JPEG2000.

2

Chapitre 01 :Généralités sur la compression d’images

I-1. Introduction à la compression d’images

La révolution du numérique impose des échanges de volumes importants d’information ce qui pose des problèmes de stockage et de transfert et de gestionde cette masse de données exponentiellement croissante. D’où l’intérêt de développer des techniques de compression et de décompression de données. Leur but est de changer le format des informations de telle sorte qu’elles occupent moins de volume. Une fois compressées, ces données ne sont plus accessibles en tant que données cohérentes. Pour les récupérer, il suffit de reconstruire l’image par décompression.

Pour avoir une idée de l’importance de cette masse de données, concentrons nos investigations sur l’image en tant que donnée particulière. Soit une image numérique ( , ), donc constituée de pixels, si on suppose que chaque échantillon est quantifié sur bits, alors il nous faut × bits pour représenter cette image.

Si on considère le cas générique où = 512 et = 8 , on doit utiliser 8 × 512 × 512 bits ou 262144 octets(1 octet est un pixel représenté sur 8 bits) pour représenter une image de taille modeste. Il est bien évident que si la taille de l’image devient plus élevée, le nombre de bits nécessaire pour la décrire devient vite astronomique.

Cette représentation de l’image, appelée forme canonique d’une image ou image codée MIC(modulation par impulsion codée) ou PCM (pulse coded modulation), est très coûteuse, vu letrès grand nombre de bits utilisés lors d’une transmission ou d’une mémorisation. L’idée est doncde réduire le nombre de bits nécessaires à la représentation d’une image en tirant partie de ladépendance des échantillons adjacents. Cette opération s’appelle « Réduction de redondance » ou« compression d’image » [1].

Maintenant, prenons l’exemple d’une image numérique couleur1. Elle s’identifie à une matrice à colonnes et lignes. Pour une image en niveaux de gris, chaque pixel est codé sur 8 bitsl’intensité lumineuse décrite par des entiers compris entre 0 et 255, d’où2 =

1

3

256 valeurs possibles. Pour les images couleurs, chaque pixel est caractérisé par 3 intensités lumineuses RVB ou rouge, vert et bleu, définissant des images 3×8=24 bits.

Le stockage en mémoire d’une image couleur requiert donc × × 24 bits. Ceci représente rapidement une grande quantité : une image de 4 Mégapixels nécessite ainsi 4 × 2 × 24 bits soit 12 Mégaoctets, ne permettant le stockage, par exemple, que d’une dizaine de photos sur une carte 128 Mégaoctets.

L’objectif de la compression est de réduire la quantité de mémoire nécessaire pour le stockage d’une image ou de manière équivalente de réduire le temps de transmission de celle-ci. Cette compression peut soit conserver l’image intacte, il s’agit de la compression sans perte, soit autoriser une légère dégradation de l’image et il s’agit de compression avec perte. La première méthode est limitée à des facteurs de compressions (rapport entre la taille mémoire originale et la taille comprimée) de l’ordre de 3 tandis que la seconde permet des facteurs beaucoup plus grands au prix d’une légère dégradation de l’image, souvent non-détectable visuellement.

I-2. Principe général de la compression des images

D’une manière générale, un système de compression se décompose en troismodules que sont la décorrélation de l’image originale, la quantification des données del’image décorrélation et le codage des données quantifiées. La figure (I.1) illustrele principe général de la compression d’images.

Figure(I- 1) : Schéma de principe de la compression d’images Analysons chaque opération intervenant dans ce schéma.

1. Décorrélation

La dépendance existante entre chacun des pixels et ses voisins (la luminosité varie très peud’un pixel à un pixel voisin) traduit une corrélation très forte sur l’image. On essaie donc detirer partie de cette corrélation, pour réduire le volume d’information en effectuant uneopération de décorrélation des pixels. La décorrélation consiste à transformer les pixelsinitiaux en un ensemble de coefficients moins corrélés, c’est une opération réversible.

4 2. Quantification

La quantification des coefficients a pour but de réduire le nombre de bits nécessaires pourleurs représentations. Elle représente une étape clé de la compression. Elle approxime chaquevaleur d’un signal par un multiple entier d’une quantité , appelée quantum élémentaire oupas de quantification. Elle peut être scalaire ou vectorielle.

3. Codage

Une fois les coefficients quantifiés, ils sont codés. Un codeur doit satisfaire à priori les conditions suivantes :

Unicité : deux messages différents ne doivent pas être codés de la même façon.

Déchiffrabilité : deux mots de codes successifs doivent être distingués sans ambiguïté.

I-3. Classification des méthodes de compression

Les méthodes de compression d’images peuvent être classées en deux grandes classes. Les méthodes de compression sans perte d’informations (réversibles) et les méthodes de compression avec perte d’informations (irréversibles).

I-3-1. Méthodes de compression sans perte d’informations

Ce sont des méthodes qui permettent de trouver exactement l'image originale. Nous citerons la méthode RLE, la méthode HUFFMAN, la méthode entropique de Shannon...

Notre contribution n’étant pas sur le codage, nous invitons le lecteur intéressé de consulter les références suivantes : [1], [2], [3] et [4].

I-3-2. Méthodes de compression avec perte d’informations

Notre attention va se concentrer sur ces méthodes appelées également compression par transformées.

Bien entendu, ce sont des méthodes qui peuvent apporter unelégère distorsion aux images reconstruites mais non décelables visuellement. Ce type de compression est intéressant car il permet des taux de compression très élevés.

L’image originale est subdivisée en sous images ou blocs de taille réduite. Chaque bloc subit une transformation linéaire orthogonale (le nombre de coefficients va être donc restreint) réversible du domaine spatial vers le domaine fréquentiel. Les coefficients obtenus sont alors

5

quantifiés et codés en vue de leur transmission ou leur stockage. Pour retrouver l’intensité des pixels initiaux, on applique sur ces coefficients la transformation inverse[1].

Parmi les transformations candidates, nous citerons : - Transformation de Fourrier discrète.

- Transformation de Karhunen-Loeve. - Transformation de Hadamard.

- Transformation en cosinus discrète (DCT). - Transformation en ondelettes (DWT).

C’est sur ces deux dernières transformations que nous allons concentrer nos investigations.

I-4. Evaluation de la compression

L'évaluation de la compression peut être effectuée selon plusieurs critères [1], [2], [3], [4] et [5], nous citerons :

1. Le taux de compression (quotient) est défini comme le rapport entre le nombre de bits par pixels de l’image originale et l’image compressée (rapport des débits)et s’exprime par :

Quotient = Taille des données originales

Taille des données compresées (I. 1)

Plus une compression sera forte, plus le quotient de compression ou taux de compression sera élevé.

2. le gain de compression, égalementexprimé en pourcentage, est le complément à 1 du taux de compression égale à 1-(Taillecompressé/Taille normale)

Gain de compression = 1 − (1 Quotient) 100 % (I. 2) ⁄

6

3. le taux de bits (Tb) est aussi appelé le débit de compressionet s’exprime par :

Taux de bits(Tb)en bits pixel(bpp)⁄ = Nombre original de bits ∕ pixel

Quotient (I. 3) Remarque

Le taux de bits est aussi appelé débit de compression.

I-5. Qualité de reconstruction des images

Le problème de la qualité se pose pour les méthodes de compression avec perte d’informations. En effet, l'image reconstruite n'est pas exactement l'image originale, ainsi il nous faut une mesure de la qualité de l'image reconstruite. Parmi ces critères, nous citerons [5] :

1.EQM (Erreur quadratique moyenne) : Elle permet de mesurer la dégradation entre une image Xorigine et l’image Xreconstruite après compression de coordonnées (n, m) et de dimension (N, M)et s’exprime par :

= 1

M × N × ( ( , ) ( , )) ( . 4)

Où Xorigine (n, m) et Xreconstruite (n, m) : représentent les valeurs des pixels d’image d’origine et reconstruite.

2. SNR (Signal to Noise Ratio) : Il permet de mesurer la puissance de l’image originale par rapport au bruit dans l’imageet s’exprime par :

= 10 × log × × ∑ ∑ ( , )

EQM ( . 5)

3. PSNR (Peak Signal to Noise Ratio) :C’est le rapport signal sur bruit crête qui est très utiliséen traitement d’images pour témoigner de la qualité de restitution, notamment en

7

compressiondes images. Le PSNR est très facile à calculer, il est basé sur l’erreur quadratique moyenneentre l’image originale et l’image reconstruite et s’exprime dans le cas des images enniveaux de gris par :

= 10 × log ( ) dB (I. 6)

Avec :

Xmax : désigne la valeur du pixel maximale possible dans l’image qui prend une valeur 255pour une image où chaque pixel est codé sur 8 bits. Une valeur de PSNR infini correspond à uneimage non dégradée, et cette valeur décroît en fonction de la dégradation.

I-6. Conclusion

Dans ce chapitre, nous avons brièvement rappelé les objectifs de la compression et les différentes solutions apportés, comme la compression sans perte d’informations (réversible) et avec perte d’informations (irréversible). Ensuite nous avons rappelé les critères d'évaluation de la compression et de la qualité des images reconstruite.

8

Chapitre 02 : JPEG vs. JPEG 2000

II-1. Introduction

JPEG (sigle de Joint Photographic Experts Group) est le premier réflexe qui vient à l’esprit lorsque la notion de compression d’images est abordée. Créée en 1991, cette norme ISO (organisation internationale de normalisation) est en l’une des plus utilisées dans le domaine de la compression d’images photographiques. Elle s’avère d’ailleurs encore aujourd’hui très efficace lorsqu’elle est utilisée à des taux de compression faibles ou moyens.

Pour aller au-delà de ces performances modestes, en 2000 a été élaboré un nouveau format de compression d’images appelé JPEG 2000.

Dans ce chapitre, nous allons introduire la compression JPEG et la compression JPEG 2000 et les comparer

II-2. Compression JPEG

JPEG définit deux types de compression :

• Avec pertes ou compression irréversible. C’est le JPEG « classique ». Il permet des taux de compression de 3 à 100 [3], [6]

• Sans perte ou compression réversible. Dans ce cas, le taux de compression n’est que de l’ordre de 2 à 8 [3], [6]. Pour cette raison, ce type de compression est très peu utilisé.

9

Figure (II-1) : Principe de la compression JPEG.

• Rééchantillonnage (sous-échantillonnage) de la chrominance, car l'œil ne peut discerner de différences de chrominance au sein d'un carré de 2x2 points.

Une image couleur en mode RVB (rouge, vert et bleu, ou en anglais RGB) est constituée de trois composantes (matrices) : rouge, verte et bleue. L’inconvénient de cette représentation réside dans le fait que chaque plan ou matrice de couleur mélange à la fois la chrominance et la luminance.

Sachant que l’œil humain est très sensible à la luminance, soit à la variation de luminosité, et quasiment insensible à la chrominance, soit à la variation d’une même couleur, il existe donc un premier moyen d’optimiser la compression de l’image. Transformer une image initialement en mode RVB en une image en mode (YCbCr) ou (YUV). Le mode YCbCr décompose une image en un plan définissant la luminance (Y), et deux plans définissant la chrominance notée (Cb et Cr) comme suit :

Y luminance = 0,3 R+0,6V+0,1B L’œil est plus sensible à Y qu’à Cb et Cr. Cb (chrominance vers le bleu) = Y-B

10

• Découpage de l'image en blocs de 8x8 points, puis application de la DCT (Discrete CosineTransform, transformation en cosinus discrète) qui transforme l'image originale (dans le domaine spatial) en une image dans le domaine fréquentiel.

Cette transformation (DCT) est à la base de la norme JPEG.

La DCT est appliquée sur chacun des blocs de 8 × 8 pixels précédemment définis. Elle donne à nouveau un bloc de 8 × 8 pixels.

La DCT s’exprime mathématiquement par (où C(u) et C(v) sont des coefficients normalisateurs définis par (0) =

√ ( ≠ 0) = 1) [6] :

X(u,v)= 1

4 .C(u).C(V) X(i,j). cos (2.i+1).u. π 16 7 j=0 7 i=0 .cos (2.j+1).v. π 16 (II.1)

Et la transformée DCT inverse s’exprime par :

X(i,j)= 1

4 C(u).C(v).X(u,v). cos (2.i+1).u. π 16 7 v=0 7 u=0 . cos (2.j+1).v. π 16 (II.2) Avec : ( ) = ( ) = 1 √2 = = 0 ( ) = ( ) = 1 ≠ 0 , ≠ 0.

( , ): représente la valeur de la DCT au point de coordonnées fréquentielles ( , ) dans le bloc résultat de 8 × 8 pixels.

( , ): représente la valeur du pixel de coordonnées spatiales ( , )dans le bloc de l’image originale de 8× 8 pixels.

11

• Quantification de chaque bloc, ce qui annulera ou diminuera des valeurs de hautes fréquences, afin d'atténuer les détails en parcourant le bloc intelligemment avec un codage RLE (en zig-zag pour enlever un maximum de valeurs nulles).

Il est à noter que les coefficients de la DCT les plus « énergétiques » (c’est-à-dire de plus haute énergie et donc ceux qui sont porteurs d’informations) se trouvent autour de la fréquence zéro (composante continue) et donc il s’agit d’éliminer les coefficients en dessous d’un certain seuil (forcément éloignés de l’origine) car ils sont peu porteurs d’information. •Encodage de l'image par la méthode d’Huffman. Cette méthode permet de compression de typestatistique, basé sur l'entropie de Shannon.

Le codage de Huffman crée des codes à longueurs variables sur un nombre entier de bits. L’algorithme considère chaque message à coder comme étant une feuille d’un arbre qui reste à construire. L’idée est d’attribuer aux deux messages de plus faibles probabilités, les mots codés les plus longs. Ces deux mots codés ne se différencient que par leur dernier bit. Contrairement au codage de Shannon-Fano qui part de la racine des feuilles de l’arbre et, par fusions successives, remonte vers la racine[1-4] et [6].

II-3. Compression JPEG2000

Bien que la compression JPEG soit toujours très utilisée dans le domaine des images photographiques, elle propose une piètre qualité des images obtenues à des taux de compression élevés ainsi qu’un manque de flexibilité et de fonctionnalités. Ce qui témoigne de son incapacité à satisfaire toutes les exigences des applications, en particulier professionnelles, d’aujourd’hui telles que l’imagerie médicale, l’archivage iconographique, le multimédia, l’Internet et les terminaux mobiles. C’est à partir de ce constat qu’a été élaboré en 2000, le format de compression d’images JPEG 2000.

12

Figure (II-2) : Schéma bloc de la compression/décompression JPEG 2000.

Globalement, ce schéma synoptique (Figure II-2) est fondé sur le même principe que celui de la figure (II-1) (JPEG) à deux détails importants près :

1. La transformation linéaire utilisée est la transformée en ondelettes discrète ou DWT (discrete wavelet transform) au lieu de la DCT.

2. Cette transformation agit sur l’image complète et non pas sur des imagettes de 8 × 8 pixels, comme ce fut le cas en figure (II-1)(cas de la compression JPEG).

Pour cette raison, dans la suite, nous allons concentrer notre attention sur la transformée en ondelettes et l’analyse multirésolution [3], [5].

II-3-2. La transformée en ondelettes discrète (DWT) Pourquoi utiliser la DWT en compression d’images ?

En fait, la transformée en ondelettes d’une image donne peu de coefficients d’amplitude élevée où l’information utile est concentrée. Le reste des coefficients (d’amplitude faible) ne sont pas nécessaires pour retrouver l’information pertinente dans une image. D’où l’idée d’éliminer ces coefficients d’amplitude faible sans altérer significativement l’image. Cette idée d’alléger l’image par élimination des nombreux coefficients de faible amplitude est à la base de la compression JPEG 2000.

13 II-3-2-1. Concepts de base

Une ondelette ψ(t) est une fonction d’énergie finie et possédant la propriété suivante : L’aire sous sa courbe est nulle

( ) = 0 ( . 3)

Voici les premières ondelettes utilisées :

1. L’ondelette de Haar est la plus simple des ondelettes. C’est celle qui a le plus petit support. Leproblème avec cette ondelette, c’est que les approximations qui sont des fonctions constantes parmorceaux approchent mal les fonctions régulières et est représentée dans la figure (II-3).

Figure (II-3) : Ondelette de Haar

(Correspondant à l’ondelette de Daubechies d’ordre 1 ou db1 sous MATLAB)

0 0.2 0.4 0.6 0.8 1 1.2 1.4 -1.5 -1 -0.5 0 0.5 1 1.5 Wavelet

14

2. l’ondelette de chapeau mexicainc’est une autre ondelette très utilisée. Cette ondelette est admissible et représentée dans la figure (II-4).

Figure (II-4) : Ondelette dite « chapeau mexicain » (en anglais mexicanhat).

3. L’ondelette de Morlet(inventaire des ondelettes dans les années 1970-1980) c’est la première ondelette utilisée pour l'analyse tems-échelle et est représenté dans la figure (II-5).

15

La transformée en ondelettes permet une analyse temps-échelle, aussi appelée analyse multi-résolution car une telle analyse s’effectue selon diverses échelles ou multi-résolutions « ».

Cette analyse est traduite par la relation (II.4) où est la translation et l’échelle. La transformée en ondelettes ( , ) d’un signal ( ) est définie par :

( , ) = ( ) 1 √2

∗ − ( . 4)

Où

− qui représente l’échelle. Plus est petit, plus l’ondelette ( ) se contracte et permet donc d’analyser les évènements rapides contenus dans le signal ( ).

Inversement, plus est élevé, plus l’ondelette se dilate et permet donc de s’intéresser aux évènements lents contenus dans le signal.

− représente le décalage temporel de l’ondelette ( )le long de l’axe des . Cette transformée est inversible, et son inverse est défini par :

( ) =1 1

| | ( , ) , ( ) ( . 5) Avec :

= | ( )|

| | ù ( ) = ( ) ( . 6)

II-3-2-2. DWT 2D – Transformée en ondelettes discrète d’une image numérique

Dans le cas d’une image (signal bidimensionnel), la DWT correspond à une analyse multirésolution en utilisant des filtres passe-bas et passe-haut issus de l’ondelette choisie : c’est l’application du fameux algorithme de Mallat [5]. Plus précisément, l’analyse se déroule par balayage alternatif de lignes ou rangées et de colonnes selon l’algorithme suivant.

16 ■ Niveau 0

Le point de départ est une image échantillonnée sur × pixels, soit pixels dans les 2 dimensions, horizontale et verticale, de cette image échantillonnée, dite « LL0 » : premier L (Low) pour « basse fréquence » des rangées horizontales de nombres du niveau 0, second L pour « basse fréquence » des colonnes verticales de nombres du niveau 0.

■ Niveau 1

On calcule, lors d’une 1ère passe, 4 sous-images distinctes filtrées et sous-échantillonnées, ou « sous-bandes » :

– LL1 (Lowpass horizontal + Lowpass vertical) obtenue par application successive de deux opérateurs :

• L sur les rangées de LL0 (donne ∕ 2 colonnes).

• L sur les ∕ 2 colonnes ci-dessus (donne ⁄ coefficients pour LL1). 4

– LH1 (Lowpass horizontal + Highpass vertical) obtenue par application successive de deux opérateurs :

• L sur les rangées de LL0 (donne ⁄ colonnes). 2

• H sur les ∕ 2 colonnes ci-dessus (donne ⁄ coefficients pour LH1). 4

– HL1 (Highpass horizontal + Lowpass vertical) obtenue par application successive de deux opérateurs :

• H sur les rangées de LL0 (donne ∕ 2colonnes).

• L sur les ∕ 2colonnes ci-dessus (donne ∕ 4coefficients pour HL1).

– HH1 (Highpass horizontal + Highpass vertical) : obtenue par application successive de deux opérateurs :

• H sur les rangées de LL0 (donne ∕ 2 colonnes).

• H sur les ∕ 2colonnes ci-dessus (donne ∕ 4 coefficients pour HH1).

Le terme de « sous-bandes » se réfère au domaine des fréquences avec les effets du filtrage passe-bas ou passe-haut associé à un sous-échantillonnage de facteur 2.

17

À la fin de cette première passe, on dispose de 4 matrices × ⁄ =4 coefficients, sans compression donc à ce stade. Pas plus qu’il n’y aura compression au second passage (niveau 2), qui prendra comme point de départ les ⁄ coefficients de LL1. Pour la commodité de la 4 présentation, on dispose de la façon suivante les 4 fois ∕ 4 séries de coefficients de l’algorithme appliqué à un niveau donné.

Lorsque les ∕ 4coefficientsLL1 sont à leur tour traités pour obtenir les 4 × ( ∕ 16) = ∕ 4 coefficients duniveau 2, on les dispose sous forme de 4 matrices LL2, LH2, HL2, HH2 qui se substituent à la matrice LL1. Et ainsi de suite, jusqu’au niveau 3 (Figure II-6).

La Figure (II-7)illustre bien ces itérations successives, avec : – l’image initiale de « Lena » (Figure II-7 a).

– au niveau 1 de décomposition (Figure II-7b), quatre sous-images (sous-bandes) conventionnelles (LL1, LH1, HL1 et HH1) représentant les coefficients obtenus dans chaque matrice (avec la valeur des coefficients traduite faute de mieux par un niveau de gris, avec noir

= maximale négative et blanc = valeur maximale positive – il faudrait en fait une sorte de carte 3D avec des cotes de profondeur).

– puis au niveau 2 de décomposition (figure II-7 c), quatre autres sous-images issues de la décomposition itérative de LL1.

La figure (II-8)illustre la multirésolution ainsi générée par la décomposition en ondelettes, qui permet, dans le processus inverse de décodage, de reconstituer l’image originale.

D’une manière qualitative, les images LH représentent les détails horizontaux, les images HL les détails verticaux (le filtre H s’applique aux rangées) et les images HH les détails diagonaux.

Les images LL donnent en quelque sorte les « à-plats », c’est-à-dire les plages assez uniformes (à l’échelle observée).

18

Figure (II-6) : Principe de l’analyse multirésolution d’une image en considérant 3 résolutions ou 3 échelles.

Figure (II-7) : Analyse multirésolution de l’image Lena en considérant 3 résolutions ou 3 échelles.

19

Figure (II-8) : Reconstitution de l’image originale à partir d’une analysemultirésolution

II. 4. Avantages de la compression JPEG 2000 [3]

La compression JPEG 2000 permet une plus grande efficacité de compression, en particulier à bas débit, pour des applications telles que la transmission d’image sur réseau et la télédétection (remotesensing). Par exemple, moins de 0,25 bpp (bit per pixel) pour des images à niveaux de gris avec beaucoup de détails.

■ Une compression mathématiquement sans perte (lossless) et avec pertes (lossy). Une compression mathématiquement sans perte, avec un faible taux de compression, permet de reconstituer au décodage toutes les valeurs numériques originelles des matrices de nombres de l’image-source. Les applications pouvant utiliser la compression mathématiquement sans perte incluent les images médicales où aucune perte n’est tolérée, les archives iconographiques où la plus haute qualité est requise pour la conservation mais pas pour l’affichage, les applications sur réseaux fournissant des équipements avec des capacités et des ressources diverses, et les images de prépresse.

■ La transmission progressive, soit en fonction de la précision de codage du pixel, soit de la résolution spatiale (densité surfacique de pixels) de l’image. Cela permet une reconstruction différenciée de l’image selon les équipements de réception et d’affichage, par exemple dans le domaine du Web, des applications d’archivage iconographique, des imprimantes, etc.

20

■ Un débit fixe (fixed-rate, ou fixed local rate) signifie que le nombre de bits pour un nombre de pixels consécutifs est égal (ou inférieur) à une certaine valeur. Cela permet ainsi au décodeur de traiter en temps réel les données transitant via des canaux de capacité limitée, par exemple pour la télédétection, le codage de mouvements, etc. Une taille fixe (fixed-size, ou fixed global rate) signifie que la taille totale du train de données codées, le codestream (généré à la sortie du codeur), est égale à une certaine valeur, pour une image complète. Cela permet à un équipement avec un espace mémoire limité de contenir un train de données complet quelle que soit l’image.

■ L’accès et le traitement direct du train de données, pour permettre que des zones de l’image plus intéressantes que d’autres, appelées ROI (Region-Of-Interest), soient directement accessibles et décompressées avec moins de distorsion que le reste de l’image. Le traitement avec accès direct dans le codestream, pourrait permettre d’effectuer des opérations telles que rotation, translation, filtrage, extraction de caractéristiques, mise à l’échelle (scaling), etc. ■ Le codage temps réel ou capacité à compresser et décompresser les images en une seule passe séquentielle. La norme devrait aussi permettre de traiter une composante d’image dans un ordre entrelacé ou non. Durant la compression, le format devrait utiliser un contexte de pixels limité à un nombre raisonnable de lignes.

■ La robustesse vis-à-vis des erreurs binaires, importante en particulier pour la transmission via les réseaux sans fil. Le train de données comprenant des parties plus importantes que d’autres dans la détermination de la qualité de l’image décodée, sa conception doit permettre une détection-correction des erreurs au décodage.

■ La protection des images, avec des méthodes telles que : le watermarking ou marquage invisible inséré dans le contenu de l’image (parfois appelé tatouage), l’étiquetage (labeling) par ajout de données spécifiques dans le train de données ou le fichier, l’empreinte numérique (finger printing) par calcul d’un code ou signature unique mais externe à l’image, le chiffrement ( encryption) ou l’embrouillage (scrambling) de tout ou partie de l’image, et enfin le logo (stamping) sur l’image affichée.

■ La rétro-compatibilité, ou un transcodage facile, avec JPEG, la compatibilité avec les recommandations de l’ITU (International Telecommunication Union) pour l’échange d’images (celles concernant, par exemple, le fax), et l’interfaçage avec MPEG-4 (vidéo utilisant la compression JPEG 2000), en particulier avec la conservation des informations

21

concernant la propriété intellectuelle lors de l’insertion ou de l’extraction d’images fixes vers des ou à partir d’images animées.

D’autres caractéristiques requises concernaient :

– la description basée sur le contenu, pour retrouver une image dans de grandes banques de données ;

– de meilleures performances lors de multiples cycles de compression-décompression ; – un format de fichier plus flexible.

22

Chapitre 03 : Partie pratique sous l’environnement Matlab

III-1.Introduction

Il existe deux types d’ondelettes, les ondelettes dites orthogonales et biorthogonales. Les ondelettesorthogonales définissent une base dans L2. Le sous-espace des détails de niveau j est le complémentaire orthogonal du sous-espace des approximations de niveau j. En conséquence, deux ondelettes de même échelle sont orthogonales. Ces ondelettes présentent un grand intérêt car elles bâtissent une base orthonormée de l’espace des signaux, ce qui facilite l’inversion de la transformation. La famille des ondelettes orthogonales à support compact, est la plus intéressante, les filtres étant à réponse impulsionnelle finie ce qui facilite leur implémentation.

L’orthogonalité permet d’obtenir une bonne qualité d’image lors de la reconstruction du signal.

Pour la compression, la base doit être orthogonale pour être optimale, car elle élimine la redondance, donc, les coefficients sont fortement décorrélés. Cependant, les ondelettes orthogonales ne sont pas symétriques et induisent des distorsions lors du changement de base. Pour pallier à ce problème, les ondelettes biorthogonales ont été proposées. Sans être orthogonales, elles possèdent les caractéristiques des ondelettes orthogonales. En plus, elles sont symétriques. Ce sont des filtres en quadrature, ne formant pas une paire orthogonale. Lors de la reconstruction, une autre paire de filtres orthogonaux doit être utilisée.

III-2.Ondelettes privilégiées en compression d’images [5]

III-2-1.Ondelettes de Daubechies

Les ondelettes de Daubechies sont des ondelettes orthogonales dont le support est compact c’est-à-dire que les filtres correspondants sont constitués de peu de valeur.

23

Les ondelettes de Daubechies ne sont pas exprimables d’une façon analytique. Cette famille est notée dbp, par exemple db2, db4, etc. Il est à remarquer que db1 correspond à l’ondelette de Haar.

Figure (III-1) : Exemple d’ondelette de Daubechies (ici db2).

III-2-2. Ondelettes biorthogonales

En traitement d’images en vue de la compression, il est préférable d’utiliser pour l’analyse une ondelette ayant un grand nombre de moments nuls et un support compact (support le plus petit possible) de sorte que la représentation de l’image soit la plus creuse possible afin d’obtenir un fort taux de compression.

Une telle ondelette sera plutôt asymétrique et irrégulière, et donc inadaptée à la reconstruction ou synthèse de l’image où il est souhaitable d’utiliser une ondelette régulière et symétrique afin de réduire les artefacts visuels.

La cadre des ondelettes bi-orthogonales permet de satisfaire ces deux exigences simultanément. L’idée étant d’utiliser une ondelette ψ pour l’analyse et une autre ψ ̃ pour la synthèse de manière à relâcher la contrainte d’orthogonalité qui empêche d’avoir une ondelette symétrique à support compact. Dans un tel cas, des ondelettes différentes sont utilisées à l’analyse et à la synthèse (ou reconstruction) et sont appelées ondelettes bi-orthogonales.

24

Figure (III-2) : Exemple d’ondelettes bio-orthogonales. Ondelettes bi-orthogonales 9/7.

III-3. Compression JPEG2000

L’algorithme de compression que j’ai développé sous MATLAB, est basé sur un codage contour-texture réversible, c’est à dire que l’image reconstruite après compression est un duplicata exact de l’image initiale. Cependant le système mis en œuvre peut être modifié afin de réaliser une compression irréversible, plus performante en termes de taux de compression. III-3-1. L’environnement Matlab

Le logiciel Matlab constitue un système interactif et convivial de calcul numerique et de visualisation graphique. Destiné aux ingénieurs, aux techniciens et aux scientifiques, c’est un outil trèsutilisé, dans les universitéscomme dans le monde industriel, qui intègre des centaines de fonctions mathématiques et d’analyse numerique (traitement de signal, traitement d’images, visualisations graphiques, etc.).

25

III-3-1-1.Compression d’empreintes digitales utilisée par le FBI

Dans cet exemple, nous utilisons des paquets d'ondelettes pour analyser et compresser une image d'une empreinte digitale. C'est un problème du monde réel : le Federal Bureau of Investigation (FBI) maintient une grande base de données des empreintes digitales.

Le FBI utilise huit bits par pixel pour définir la nuance de gris et stocke 500 pixels par pouce, ce qui correspond à environ 700 000 pixels et 0,7 mégaoctets par doigt pour stocker les empreintes digitales sous forme électronique. En se tournant vers les ondelettes, le FBI a atteint un taux de compression de 15, 1.

La compression par ondelettes est meilleure, car elle évite les petits artefacts carrés et est particulièrement bien adaptée pour détecter des discontinuités (lignes) dans l'empreinte digitale et le résultat est suivant :

26

Figure (III-4) : Image (empreinte digitale) compressée.

Une mesure de la compression obtenue est donnée par l‘énergie retenue et le nombre de zéros que représentent des informations équivalentes.

L’énergie retenue signifie que l'image compressée est stockée en utilisant 98.65% de la taille de stockage initiale.

Le nombre de zéros étant donné la couleur du pixel utilisés pour stocker l'image.

La couleur du pixelpeut prendre des valeurs allant du noir au blanc en passant par un nombre fini de niveauxintermédiaires. Donc pour représenter les images à niveaux de gris, on peut attribuer à chaquepixel de l’image une valeur correspondant à la quantité de lumière renvoyée. Cette valeur peutêtre comprise entre 0 et 255. Par convention, la valeur zéro représente le noir (intensitélumineuse nulle) et la valeur 255 le blanc (intensité lumineuse maximale). Le nombre deniveaux de gris dépend du nombre de bits utilisés pour décrire la "couleur" de chaque pixel del’image. Plus ce nombre est important, plus les niveaux possibles sont nombreux

27 III-3-1-2.Compression image mask

C’est un exemple de compression d’image. L’image mask peut être remplacée par toute autre image.

Tout d'abord, nous chargeons et affichons l'image en niveaux de gris du mask.

Figure (III-5) : Image originale à compresser.

Une mesure de la compression obtenue est donnée par le taux de compression (CR) et le ratio Bit-Per-Pixel (BPP). CR et BPP représentent des informations équivalentes.

Le taux de compression CR signifie que l'image compressée est stockée en utilisant seulement CR% de la taille de stockage initiale.

Le rapport bit par pixel BPP étant donné le nombre de bits utilisés pour stocker un pixel de l'image.

Pour une image en niveaux de gris, le BPP initial est de 8 bits.

Le défi des méthodes de compression est de trouver le meilleur compromis entre un faible taux de compression et un bon résultat perceptif.

Image originale 50 100 150 200 250 50 100 150 200 250

28

Nous commençons par une méthode simple de mise en cascade des coefficients globaux de seuillage et du codage de Huffman. Nous utilisons l'ondelette par défaut bior4.4 et le niveau par défaut qui est le niveau maximal possible divisé par 2.

Le rapport de bit par pixel désiré BPP est fixé à 0.5 et l'image compressée sera stockée dans le fichier mask.wtc.

Le rapport bits par pixels obtenu est en réalité d'environ 0,53 (fermé à celui de 0,5 souhaité) pour un taux de compression de 6,7%.

Décompression

Maintenant, nous décompressons l'image extraite du fichier ‘mask.wtc’ et la comparons à l'image originale.

Figure (III-6) : représente une image originale et image compressée à taux de compression 6.69% et BPP 0.54

Le résultat est satisfaisant, mais un meilleur compromis entre le taux de compression et la qualité visuelle peut être obtenu en utilisant des méthodes de compression plus sophistiquées, qui impliquent des étapes de seuillage et de quantification plus strictes.

image originale image compressée

Compression Ratio:6.69% BPP:0.54

29 Compression par méthodes progressives

Nous illustrons maintenant l'utilisation de méthodes progressives de compression, en commençant par l'algorithme EZW utilisant l'ondelette de Haar. Le paramètre clé est le nombre de boucles ; l'augmenter conduit à une meilleure récupération, mais un meilleur taux de compression.

Figure (III-7) : représente une image originale et image compressée-6 étapes à taux de compression 0.21% et BPP 0.02

Ici, en utilisant seulement 6 étapes produites une image décomprimée très grossière. Maintenant, nous examinons un résultat légèrement meilleur en utilisant 9 étapes et enfin un résultat satisfaisant en utilisant 12 étapes.

image originale 50 100 150 200 250 50 100 150 200 250 image compressée-6steps Compression Ratio: BPP:0.02 50 100 150 200 250 50 100 150 200 250

30

Figure (III-8) : représente une image compressée-9 étapes à CR 1.93% et BPP 0.15 et une image compressée-12 étapes à CR 11.53% et BPP 0.92

Le ratio final de BPP est d'environ 0,92 en utilisant 12 étapes.

III-3-1-3. Manipulation des images en vrai couleurs

Enfin, nous illustrons comment compresser l'image wpeppers.jpg vrai couleur. Les images vraies couleur peuvent être compressées en utilisant le même schéma que les images en niveaux de gris en appliquant les mêmes stratégies à chacun des trois composants de couleur. Pour une image en niveaux de gris, le BPP initial est de 8 tandis que pour une image en couleurs vraie, le BPP initial est de 24, car 8 bits sont utilisés pour coder chacune des trois couleurs (espace colorimétrique RVB).

Image compressée -9 steps

Compression Ratio : 1.93 % BPP: 0.15 50 100 150 200 250 50 100 150 200 250

image compressée -12 steps

Compression Ration: 11.53 % BPP: 0.92 50 100 150 200 250 50 100 150 200 250

31

Figure (III-9) : Image originale à compresser.

Figure (III-10) : Image compressée.

Le taux de compression (1,65%) et le rapport bit / pixel (0,4) sont très satisfaisants tout en conservant une bonne perception visuelle.

III-4.Conclusion

Ces exemples simples de compression d’images montrent la puissance et les bonnes performances de la compression JPEG2000.

32

Conclusion générale

L’objet de ce travail a été la compression d’images en exploitant la notion d’ondelettes. Il s’agit de l’utilisation de la norme JPEG 2000 mise au point en 2000 mais actuellement n’est pas encore libre de droit.

Dans ce travail, nous avons brièvement rappelé les notions à retenir lorsqu’il s’agit de compression d’images. Une comparaison JPEG à base de DCT et JPEG 2000 à base de DWT a été réalisée.

Dans le dernier chapitre, nous avons appliqué sous MATLAB des exemples simples de compression d’images qui montrent les bonnes performances de la compression JPEG2000 en termes de taux de compression, de BPP et de PSNR.

33

Bibliographie

[1] M. SAHIR, « Compression des images numériques par la technique des ondelettes », Mémoire de Magister, soutenu le 19 juin 2011 à l’Université de Sétif.

[2] E. LE PENNEC, «Compression d’image» — Images des Mathématiques, CNRS, 2006. [3] J.-N. GOUYET, C. NELSON et M. LEGER, « JPEG 2000, format de compression d'image numérique par ondelettes – Principes », Techniques de l’Ingénieur, 2016.

[4] M. CAGNAZZO, « Ondelettes et compression d’images », PPT TELECOM-Paris Tech, Paris, 2012.

[5] A. OUAHABI, « Analyse multirésolution pour le signal et l’image », Hermes-Lavoisier, Paris, 2012.

[6] R. C. GONZALEZ et R. E. WOODS, « Digital image processing », Prentice-Hall, N. J., 2008.