THÈSE

Pour l'obtention du grade de

DOCTEUR DE L'UNIVERSITÉ DE POITIERS UFR des sciences fondamentales et appliquées

XLIM-SIC

(Diplôme National - Arrêté du 7 août 2006)

École doctorale : Sciences et ingénierie pour l'information, mathématiques - S2IM (Poitiers) Secteur de recherche : Traitement du signal et des images

Présentée par :

Naty Sidaty

Exploitation de la multimodalité pour l'analyse de la saillance et l'évaluation de la qualité audiovisuelle

Directeur(s) de Thèse :

Abdelhakim Saadane, Mohamed-Chaker Larabi Soutenue le 11 décembre 2015 devant le jury Jury :

Président Christine Fernandez-Maloigne Professeur, Université de Poitiers

Rapporteur Christophe Charrier Maître de conférences, GREyC, Université de Caen Rapporteur Frédéric Morain-Nicolier Professeur, CReSTIC, Université de Reims

Membre Abdelhakim Saadane Maître de conférences, Université de Nantes

Membre Mohamed-Chaker Larabi Maître de conférences, XLIM, Université de Poitiers

Membre Ahmed Bouridane Professor, Newcastle-upon-tyne, Northumbria University, UK

Pour citer cette thèse :

Naty Sidaty. Exploitation de la multimodalité pour l'analyse de la saillance et l'évaluation de la qualité audiovisuelle [En ligne]. Thèse Traitement du signal et des images. Poitiers : Université de Poitiers, 2015. Disponible sur Internet <http://theses.univ-poitiers.fr>

DOCTEUR DE L’UNIVERSIT´E DE POITIERS Facult´e des Sciences Fondamentales et Appliqu´ees

Diplˆome National - Arrˆet´e du 7 aoˆut 2006

Ecole Doctorale : Sciences et Ing´enierie pour l’Information, Math´ematiques - S2IM Secteur de Recherche : Traitement du Signal et des Images

Pr´esent´ee par :

Naty SIDATY

Exploitation de la multimodalit´

e pour l’analyse de la saillance et

l’´

evaluation de la qualit´

e audiovisuelle

Directeurs de Th`ese : Mohamed-Chaker Larabi

Abdelhakim Saadane Soutenue le 11 D´ecembre 2015 Devant la Commission d’Examen

JURY

Fr´ed´eric Morain-Nicolier, Professeur, Universit´e de Reims Champagne-Ardenne . . Rapporteur Christophe Charrier, Maˆıtre de Conf´erences HDR, Universit´e de Caen Normandie .Rapporteur Ahmed Bouridane, Professeur, Northumbria University at New Castle, UK . . . Examinateur Christine Fernandez-Maloigne, Professeure, Universit´e de Poitiers . . . Examinateur Mohamed-Chaker Larabi, Maˆıtre de Conf´erences, Universit´e de Poitiers . . . Directeur de Th`ese Abdelhakim Saadane, Maˆıtre de Conf´erences HDR, Universit´e de Nantes . . Directeur de Th`ese

En r´edigeant cette derni`ere page du manuscrit, je suis oblig´e de reconnaˆıtre que ce tra-vail de th`ese n’aurait pas ´et´e aussi fructueux sans l’aide de plusieurs personnes. Je tiens `a remercier tous ceux qui ont contribu´e, de pr`es ou de loin, `a sa r´ealisation.

Je tiens tout d’abord `a remercier Fr´ed´eric Morain-Nicolier, Professeur `a l’Universit´e de Reims Champagne-Ardenne et Christophe Charrier, Maˆıtre de Conf´erences HDR `a l’Univer-sit´e de Caen Normandie, d’avoir accept´e d’ˆetre les rapporteurs de cette th`ese. Leurs com-mentaires m’ont ´et´e tr`es utiles pour la pr´eparation de la soutenance et de la version finale du manuscrit.

Je remercie ´egalement Ahmed Bouridane, Professeur `a Northumbria University at New-castle (UK) pour sa participation `a mon jury en tant qu’examinateur et Christine Fernandez-Maloigne, Professeure `a l’Universit´e de Poitiers, pour avoir assum´e le rˆole de pr´esidente du jury.

Un tr`es grand merci `a mon directeur de th`ese Abdelhakim Saadane, Maˆıtre de conf´erences HDR `a l’´Ecole Polytechnique de l’Universit´e de Nantes, d’avoir accept´e de diriger ma th`ese. Je le remercie pour sa rigueur scientifique, ses nombreux conseils et ses r´eunions de travail prolong´ees.

Je tiens `a exprimer, en particulier, toute ma gratitude `a Chaker Larabi, Maˆıtre de conf´erences `a l’Universit´e de Poitiers, qui m’a permis de travailler sur un sujet aussi int´eressant et qui m’a guid´e pendant ces ann´ees de th`ese par sa qualit´e remarquable d’encadrement mais aussi et surtout pour ses valeurs humaines, son ouverture d’esprit, sa bonne humeur, sa gen-tillesse et sa pr´esence dynamique qui ont su amener une ambiance particuli`ere au 4`eme´etage.

Je remercie toutes les personnes avec qui j’ai eu la chance de partager mon bureau, Rafik, pour ses remarques et conseils qui m’ont simplifi´e la th`ese, mon cher ami Riadh pour les heures pass´ees ensemble et nos d´elires autour du fameux (Cmake), et Micha¨el pour sa bonne humeur. Un grand merci aussi `a mes compagnons de th`ese, et en particulier `a Badereddine et Nadjib, pour nos nombreuses discussions passionnantes et tous les bons moments pass´es ensemble.

Enfin, un tr`es grand merci `a ma famille pour son soutien durant toutes ces ann´ees d’´etude, et particuli`erement `a mon p`ere Sidaty qui m’a toujours soutenu, dans tous les sens du terme, quels que soient les choix entrepris.

Table des mati`

eres

Table des mati`eres iii

Table des tableaux v

Table des figures viii

Introduction g´en´erale 1

1. Contexte et objectifs . . . 1

2. Principales contributions . . . 2

3. Organisation du manuscrit . . . 3

I

Saillance Audiovisuelle

5

1 L’attention visuelle et sa mod´elisation 7 1.1 Introduction . . . 71.2 Syst`emes visuel et auditif humains . . . 8

1.2.1 Syst`eme visuel humain . . . 8

1.2.2 Syst`eme auditif humain . . . 11

1.3 Attention/Saillance visuelle . . . 12

1.3.1 Attention ou saillance . . . 13

1.3.2 Attention et mouvements oculaires . . . 13

1.3.3 Applications . . . 13

1.4 Cat´egorisations d’attention visuelle . . . 14

1.4.1 Attention exog`ene ou endog`ene . . . 14

1.4.2 Attention ouverte ou couverte . . . 14

1.4.3 Attention spatiale ou spatio-temporelle . . . 14

1.5 Mod`eles de pr´ediction de la saillance visuelle . . . 16

1.5.1 Mod`eles cognitifs . . . 16

1.5.2 Mod`eles d’analyse spectrale . . . 20

1.5.3 Mod`eles graphiques . . . 22

1.6 Saillance auditive . . . 23

1.6.1 Mod`ele de Kayser et al. . . 24

1.6.2 Mod`ele de Tsuchida et al. . . 24

1.7 El l’audiovisuel ? . . . 26

1.8 Conclusion . . . 28

2 Influence de l’audio sur l’attention visuelle 30 2.1 Introduction . . . 30

2.2 Les visages parlants, objets audiovisuels attirants . . . 31

2.2.1 Appareillages . . . 33

2.2.2 Participants . . . 33

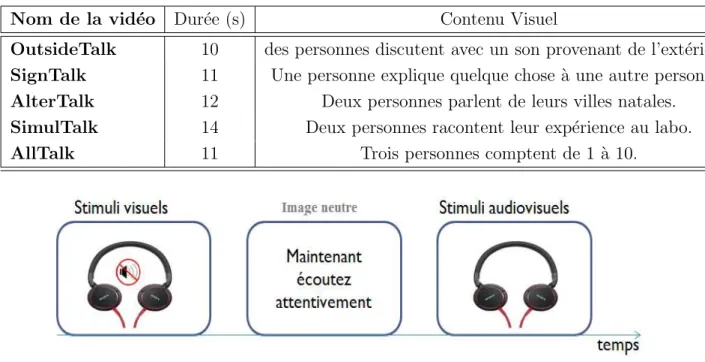

2.2.3 Stimuli . . . 34

2.2.4 Proc´edure . . . 35

2.2.5 Classification des donn´ees . . . 36

2.3 R´esultats et analyse. . . 37

2.3.1 Attention visuelle guid´ee par les visages parlants . . . 37

2.3.2 Variabilit´e des positions oculaires . . . 39

2.3.3 Analyse statistique . . . 44

2.4 Conclusion . . . 46

3 Vers une mod´elisation de l’attention audiovisuelle 47 3.1 Introduction . . . 47 3.2 Mod`ele propos´e . . . 48 3.2.1 Voie statique . . . 48 3.2.2 Voie dynamique . . . 52 3.2.3 Voie auditive . . . 53 3.2.4 Strat´egies de fusion . . . 59

3.3 Traitement des r´esultats d’eye-tracking . . . 60

3.3.1 Cr´eation d’une carte de fixation par image . . . 61

3.3.2 Cr´eation d’une densit´e de saillance . . . 61

3.4 M´etriques quantitatives de similarit´e . . . 63

3.4.1 Coefficient de Corr´elation : CC . . . 63

3.4.2 Aire sous la courbe ROC : AUC . . . 63

3.4.3 Divergence de Kullback-Leibler : KLD . . . 64

3.4.4 Normalized Scanpath Saliency : NSS . . . 65

3.5 Evaluation des performances des mod`eles statiques . . . 65

3.6 Performance globale du mod`ele audiovisuel . . . 67

Table des mati`eres

II

Qualit´

e Audiovisuelle

74

4 Evaluation de la qualit´e visuelle 76

4.1 Introduction . . . 76

4.2 De la production du signal `a la qualit´e d’exp´erience (QoE) . . . 77

4.3 Evaluation subjective de la qualit´e´ . . . 78

4.3.1 Perception des d´egradations et qualit´e visuelle . . . 79

4.3.2 Organisation des tests subjectifs . . . 80

4.3.3 M´ethodologie d’´evaluation subjective de la qualit´e . . . 81

4.3.4 Les recommandations de l’UIT . . . 86

4.3.5 Les bases des donn´ees . . . 86

4.4 Evaluation objective de la qualit´e . . . 87

4.4.1 Cat´egorisations des m´ethodes objectives . . . 87

4.4.2 M´etriques objectives de qualit´e . . . 89

4.4.3 Evaluation des performances des m´etriques de qualit´e´ . . . 92

4.5 Et la qualit´e audiovisuelle ? . . . 94

4.6 Conclusion . . . 95

5 Evaluation subjective multimodale et multi-supports de la qualit´e 97 5.1 Introduction . . . 97

5.2 Effet de l’audio sur la qualit´e visuelle per¸cue . . . 98

5.2.1 Environnement des tests . . . 98

5.2.2 M´ethodologie d’´evaluation . . . 99

5.2.3 Traitement des donn´ees subjectives . . . 100

5.2.4 Effet de l’audio sur la qualit´e globale . . . 102

5.2.5 Analyse statistique . . . 102

5.3 Effets des diff´erents param`etres sur la qualit´e audiovisuelle . . . 106

5.3.1 Environnement global de l’exp´erience . . . 108

5.3.2 Description de la base d’´etude . . . 109

5.3.3 Organisation et proc´edure d’´evaluation . . . 111

5.3.4 Influence de la r´esolution sur la qualit´e visuelle . . . 113

5.3.5 Influence du dispositif d’affichage sur la qualit´e globale . . . 113

5.3.6 Influence de la qualit´e de l’audio sur la qualit´e globale . . . 115

5.4 Conclusion . . . 115

Conclusion & perspectives 120

Bibliographie 124

2.1 Caract´eristiques techniques du cam´escope utilis´e. . . 35 2.2 Description de la base de vid´eos construite pour les besoins de l’exp´erience 1. 36 2.3 ANOVA `a un facteur sur les valeurs de la dispersion donn´ees en figure 2.8. . 45 3.1 Pr´ecision de la m´ethode sur notre base de vid´eos . . . 57 3.2 Comparaison entre deux ensembles de cartes de densit´e de saillance dans les

conditions visuelle et audiovisuelle. Pour une grande similarit´e : CC → ±1, N SS → +∞, KLD → 0. . . 66 3.3 Mesures de performances des mod`eles statiques en utilisant la v´erit´e de terrain

“Sans Audio”. . . 68 3.4 Mesures de performances des mod`eles statiques en utilisant la v´erit´e de terrain

“Avec Audio”. . . 68 3.5 Mesures de performance des mod`eles de saillance spatio-temporelle sur la v´erit´e

de terrain “sans audio” en utilisant la s´equence OutsideTalk. . . 69 3.6 Mesures de performance des mod`eles de saillance spatio-temporelle sur la v´erit´e

de terrain “sans audio” en utilisant la s´equence SinglTalk. . . 69 3.7 Mesures de performance des mod`eles de saillance spatio-temporelle sur la v´erit´e

de terrain “sans audio” en utilisant la s´equence AlterTalk.. . . 69 3.8 Mesures de performance des mod`eles de saillance spatio-temporelle sur la v´erit´e

de terrain “sans audio” en utilisant la s´equence SimulTalk. . . 70 3.9 Mesures de performance des mod`eles de saillance spatio-temporelle en utilisant

la v´erit´e de terrain “sans audio” pour la s´equence AllTalk. . . 70 3.10 Mesures de performance des mod`eles de saillance spatio-temporelle en utilisant

la v´erit´e de terrain “avec audio” en utilisant la s´equence OutsideTalk. . . 70 3.11 Mesures de performance des mod`eles de saillance spatio-temporelle en utilisant

la v´erit´e de terrain “avec audio” pour la s´equence SinglTalk. . . 71 3.12 Mesures de performance des mod`eles de saillance spatio-temporelle en utilisanr

la v´erit´e de terrain “avec audio” pour la s´equence AlterTalk. . . 71 3.13 Mesures de performance des mod`eles de saillance spatio-temporelle en utilisant

la v´erit´e de terrain “avec audio” pour la s´equence SimulTalk. . . 71 3.14 Mesures de performance des mod`eles de saillance spatio-temporelle en utilisant

la v´erit´e de terrain “avec audio” pour la s´equence AllTalk. . . 72 3.15 Mesures de performance du mod`ele audiovisuel propos´e, avec l’approche d’Itti

comme voie statique. . . 73 3.16 Mesures de performance du mod`ele audiovisuel propos´e, avec l’approche de

Liste des tableaux

3.17 Mesures de performance du mod`ele audiovisuel propos´e, avec l’approche de Tavakoli comme voie statique. . . 73 4.1 Distorsions spatiales et temporelles de la qualit´e vid´eo. . . 79 4.2 Conditions de visualisation recommand´ees par l’UIT (issues du rapport ITU-R

BT.710). . . 81 4.3 Principales recommandations de l’UIT relatives aux tests subjectifs d’´evaluation

de la qualit´e (ESQ : ´Evaluation subjective de la qualit´e). . . 86 5.1 Caract´eristiques techniques du dispositif d’affichage utilis´e dans l’exp´erience 2. 99 5.2 Param`etres de quantification (QP) utilis´es pour g´en´erer les s´equences vid´eo

utilis´ees dans cette exp´erience. . . 100 5.3 Exemple d’´echelle de notation utilis´ee dans notre exp´erience. . . 100 5.4 Analyse de variance ANOVA `a trois facteurs sur l’ensemble des donn´ees de

l’exp´erience. . . 106 5.5 Description de la base de vid´eos utilis´ee pour l’exp´erience 3. . . 110 5.6 Analyse de variance multivari´ee MANOVA sur l’ensemble des donn´ees de

1.1 Sch´ema global du syst`eme visuel humain [2]. . . 9

1.2 Diff´erentes couches du syst`eme visuel humain [3] . . . 10

1.3 Fonction de sensibilit´e au contraste normalis´ee pour les voies de chrominance et de luminance (Image extraite de [9]). . . 10

1.4 Sch´ema du syst`eme auditif humain [4]. . . 11

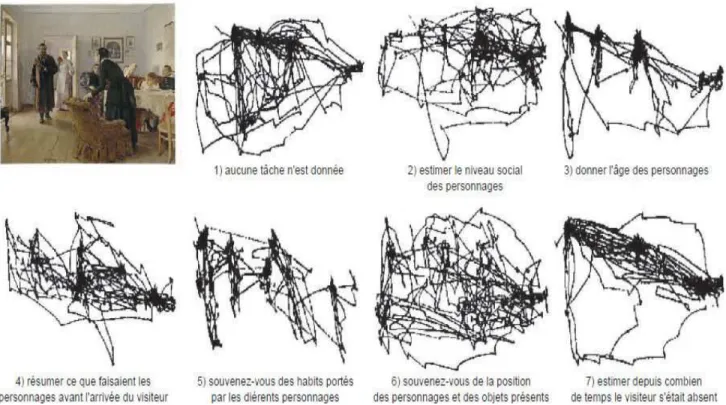

1.5 Mouvements des yeux lors d’une observation libre d’une sc`ene selon Yarbus “attention ouverte” (Image extraite de [28]). . . 15

1.6 Mouvements oculaires lors d’une observation d’une sc`ene avec diff´erentes tˆaches (questions) de 3 minutes chacune. Image extraite de [74] . . . 15

1.7 Architecture du mod`ele de Laurent Itti (Image extraite de [11]). . . 17

1.8 Mod`ele de saillance spatio-temporel de Le Meur et al.[18]. . . 19

1.9 Mod`ele de saillance spatio-temporel de Marat et al. [19]. . . 21

1.10 Architecture du mod`ele d’Achanta et al. [23] . . . 22

1.11 (A) Architecture globale du mod`ele de Kayser et al. [35], (B) Spectogramme des bulles d’eau dans un environnement bruit´e et sa carte de saillance corres-pondante. Image extraite de [35] . . . 25

1.12 Architecture du mod`ele de Tsuchida et al. [36] . . . 26

1.13 Architecture du mod`ele audiovisuel de Ruesch et al. [44]. . . 28

2.1 Les fixations des participants pour diff´erents sc´enarii mis en œuvre dans [57]. 32 2.2 Appareillage utilis´e dans l’exp´erience 1 : (a) connexion entre l’oculom`etre et l’´ecran de visualisation, (b) conditions de visualisation des stimuli. Images extraites du manuel d’utilisation de Tobii-TX120, Version 3.2. . . 34

2.3 Cam´escope utilis´e pour l’acquisition des vid´eos de tests. . . 35

2.4 Proc´edure de visualisation des stimuli dans l’exp´erience 1. . . 36

2.5 Dur´ee moyenne des fixations des participants sur les visages parlants ou non parlants exprim´ee en pourcentage, dans le cas o`u (a) le son provient de l’ext´erieur, (b) un seul visage parlant, (c) deux locuteurs parlent de mani`ere alternative, (d) deux locuteurs parlent simultan´ement et (e) tous les visages parlent. Dans le cas (e), seulement trois visages sont pr´esents. . . 38

2.6 Carte de chaleur (HeatMap) des fixations des participants pour (a) la trame 99 (SinglTalk ) et (b) la trame 167 ( AlterTalk ). . . 40

Table des figures

2.8 Valeurs moyennes de la dispersion (et les ´ecart-types) entre les positions ocu-laires des participants intra et inter conditions (visuelle et audiovisuelle) pour les s´equences vid´eo (a) OutsideTalk, (b) SinglTalk, (c) AlterTalk, (d) SimulTalk

et (e) AllTalk. . . 42

2.9 Evolution temporelle des dispersions des positions oculaires entre participants pour l’ensemble des s´equences vid´eo de l’exp´erience : (a) OutsideTalk, (b) SinglTalk, (c) AlterTalk, (d) SimulTalk et (e) AllTalk. . . 43

3.1 Architecture du mod`ele de saillance audiovisuelle. . . 49

3.2 Exemple de r´esultats des mod`eles statiques s´electionn´es sur deux s´equences AlterTalk (en haut) et SinglTalk (en bas), respectivement, de notre base de donn´ees. De haut en bas et de gauche `a droite : l’image originale, les cartes de saillance obtenues par les mod`eles d’Achanta et al.[23], Zhang et al.[24], Harel et al.[16], Itti et al.[11], Vikram et al.[75], Tavakoli et al.[76], Bruce et al.[20] et Nauge et al.[74]. . . 51

3.3 L’architecture globale de la voie dynamique du mod`ele. . . 52

3.4 Exemple d’une carte de saillance temporelle de la s´equence SinglTalk. Les r´egions claires correspondent aux r´egions en mouvement de la vid´eo (La deuxi`eme personne `a partir de la gauche est en train de parler tandis que la premi`ere personne `a partir de la droite est en train de jouer avec l’orange sur la table. 53 3.5 Exemple d’une image de la s´equence SimullTalk o`u les visages sont d´etect´es grˆace `a la m´ethode [83]. . . 55

3.6 Calcul des scores de synchronisation dans la m´ethode [85] . . . 56

3.7 Cartes de saillance auditive pour une trame de la s´equence SinglTalk (en haut) o`u la deuxi`eme personne `a partir de la gauche est en train de parler (la qua-tri`eme personne n’a pas ´et´e d´etect´ee) et une autre trame de la s´equence Si-mulTalk (en bas) o`u la premi`ere et la troisi`eme personne `a partir de la gauche parlent simultan´ement . . . 58

3.8 Exemple d’une image originale de la s´equence SinglTalk (a) avec ses deux cartes de densit´e de saillance dans les conditions visuelle (b) et audiovisuelle (c). 62 3.9 La mesure AUC `a partir de la courbe ROC. . . 64

4.1 Chaˆıne de transmission du signal audiovisuel de sa production `a la qualit´e d’exp´erience, (Image extraite de [99]). . . 78

4.2 Facteurs de d´egradation de la qualit´e vid´eo dans les services d’IPTV, (Image extraite de [102]). . . 80

4.3 Les deux ´echelles comparatives normalis´ees par l’UIT. . . 82

4.4 Pr´esentation des stimuli dans les m´ethodes comparatives. . . 83

4.5 Echelles de notation utilis´ees pour la m´ethode ACR (a) et la m´ethode SSCSQ (b). . . 83

4.6 Pr´esentation des stimuli dans les m´ethodes `a simple stimulus. . . 84

4.7 Pr´esentation des stimuli dans les m´ethodes `a double stimulus. . . 84

4.8 Echelle utilis´ee dans la m´ethode DSCQS. . . 85

4.10 Trois cat´egories de m´etriques de qualit´e vid´eo (Image extraite de [102]). . . . 88

4.11 Illustration de la corr´elation de Pearson (Image extraite de [74]) . . . 93

4.12 Exemple des mesure de CSpearman, RMSE et RO (Image extraite de [74]). . . 94

5.1 Proc´edure d’´evaluation de la qualit´e dans l’exp´erience 2. . . 101

5.2 Distribution des scores de qualit´e dans les deux conditions de l’exp´erience, visuelles (a) et audiovisuelles (b). . . 102

5.3 Valeurs MOS et les intervalles de confiance associ´es obtenus dans les deux conditions visuelles et audiovisuelles de l’exp´erience, pour toutes les s´equences vid´eo. . . 103

5.4 Influence de l’audio sur le jugement visuel de l’observateur pour les cinq gammes de qualit´e (a) M´ediocre, (b) Mauvaise, (c) Assez Bonne, (d) Bonne et (e) Excellente. . . 104

5.5 Scores subjectifs avec audio versus sans audio pour les vid´eos du test. . . 105

5.6 Images extraites de la base d’´etude. . . 110

5.7 Interfaces des applications utilis´ees, (a) Iphone et Ipad (b) ´ecran TV. . . 111

5.8 Scores de qualit´e pour les trois dispositifs d’affichage (a) iPad, (b) iPhone (en utilisant les cinq r´esolutions) et (c) TV (en utilisant trois r´esolutions) . . . . 114

5.9 Comparaison entre les scores subjectifs des diff´erents dispositifs accompagn´es des intervalles de confiance `a 95% et de la r´egression lin´eaire. . . 116

5.10 Influence de la qualit´e audio sur la qualit´e multimodale tous contenus confon-dus et r´egression logarithmique. . . 117

Introduction g´

en´

erale

Contexte et objectifs

Malgr´e les contraintes d’h´et´erog´en´eit´es des syst`emes, le trafic des donn´ees sur Internet ne cesse d’augmenter depuis le d´ebit du 21e si`ecle. Selon le Visual Networking Index (VNI) de CISCO, le trafic IP mondial annuel d´epassera le seuil d’un zettaoctet (1 milliard de te-raoctets) en 2016, et le seuil de deux zettaoctets en 2019. Le nombre d’appareils connect´es `a des r´eseaux IP sera, selon le VNI, trois fois plus sup´erieur que la population mondiale en 2019. Il y aura donc en moyenne trois appareils connect´es par habitant en 2019, contre pr`es de deux appareils par habitant en 2014. Ainsi, le trafic IP par habitant atteindra 22 Go en 2019, en hausse de 8 Go par habitant par rapport `a 2014. Le trafic vid´eo, en particu-lier, repr´esente `a peu pr`es les deux tiers du trafic Internet global. En France par exemple, ce trafic atteindra 80% du trafic total d’ici 2018, avec pr`es de 445 millions d’appareils connect´es.

Dans la vie de tous les jours, nous souhaitons acqu´erir, visualiser et partager de plus en plus de vid´eos, partout, `a tout moment et surtout avec tous types d’appareils (Smartphones, Tablettes, PC, etc.), avec la meilleure qualit´e audiovisuelle possible. L’ˆetre humain est donc confront´e `a une quantit´e d’informations gigantesque `a travers diverses applications et services.

Afin de traiter le flux exorbitant d’informations que re¸coit notre cerveau `a travers le syst`eme visuel et auditif, celui-ci poss`ede un m´ecanisme attentionnel permettant de s´electionner les informations les plus pertinentes, autrement dit, les r´egions les plus importantes de l’envi-ronnement. Ce m´ecanisme s´electif est influenc´e non seulement par les informations visuelles mais aussi par les informations auditives ainsi que les interactions audiovisuelles. Du cˆot´e de la recherche, la mod´elisation de l’attention visuelle a fait l’objet de nombreuses ´etudes et diff´erents mod`eles de saillance visuelle on ´et´e propos´es. Cependant, la mod´elisation de l’attention auditive et plus particuli`erement l’influence de l’audio sur l’attention visuelle a ´et´e tr`es peu ´etudi´ee, voire n´eglig´ee. Les travaux r´ealis´es dans cette th`ese sont divis´es en deux parties, `a savoir l’attention audiovisuelle et la qualit´e multimodale, deux parties diff´erentes mais intimement li´ees.

Ainsi, au cours des travaux r´ealis´es dans cette th`ese, nous cherchons tout d’abord `a ´etudier l’influence de l’audio sur les mouvements oculaires des observateurs humains, et donc sur leur attention visuelle, lors de l’exploration libre des vid´eos. La pr´ediction des zones ”saillantes” de la vid´eo, qui attirent davantage l’attention visuelle de ces observateurs, sera par la suite

´etudi´ee. Cette pr´ediction est bas´ee non seulement sur les indices visuels de la vid´eo mais aussi sur le contenu auditif de celle-ci.

La qualit´e audiovisuelle, telle qu’elle est per¸cue par l’utilisateur final, fait l’objet d’une grande partie de ce travail. En effet, le jugement humain de la qualit´e est influenc´e `a la fois par la nettet´e du contenu visuel et la clart´e du signal auditif associ´e. Ainsi, nous cherchons `a quantifier l’influence de la qualit´e du signal audio sur la qualit´e globale du contenu audiovi-suel, plus particuli`erement pour des applications de vid´eo-conf´erence et de streaming vid´eo o`u diff´erents appareils de visualisation peuvent ˆetre utilis´es.

Principales contributions

Afin d’´etudier l’influence de l’information auditive sur l’attention visuelle d’un cˆot´e et sur le jugement humain de l’autre, nous avons r´ealis´e une s´erie de tests psychovisuels dont l’objectif est de mieux comprendre notre perception bi-modale des signaux multim´edia (au-dio et vid´eo). ´Etant particuli`erement int´eress´e par les applications de vid´eo-conf´erence o`u diff´erents participants peuvent ´echanger et au vu du manque de bases de donn´ees audiovi-suelles, en g´en´eral, et en particulier pour ces applications, nous avons ´et´e amen´es `a cr´eer une base de donn´ees audiovisuelle o`u diff´erentes personnes ont reproduit des sc´enarios de vid´eo-conf´erence. Cette base de donn´ees, cr´e´ee au sein de notre laboratoire, a ´et´e nomm´ee SICMedia

Nous avons tout d’abord r´ealis´e une exp´erimentation oculom´etrique afin de quantifier l’influence du son sur les mouvements oculaires des observateurs. Les vid´eos de la base de donn´ees SICMedia ont ´et´e pr´esent´ees aux observateurs avec et sans leur bande-son originale. Cette premi`ere exp´erimentation nous a permis de quantifier, d’une part, l’importance des visages et en particulier des visages parlants dans une s´equence vid´eo et, d’autre part, l’in-fluence du signal sonore sur les parcours visuels des observateurs, et donc sur leur attention visuelle. Sur la base des r´esultats de cette exp´erience, nous avons propos´e un mod`ele de saillance audiovisuelle permettant de pr´edire les zones de la vid´eo les plus pertinentes pour un observateur humain. Les mouvements oculaires des participants dans cette exp´erience ont ´et´e enregistr´es grˆace `a un oculom`etre et servent de v´erit´e de terrain lors de la comparaison des r´egions pr´edites par le mod`ele propos´e et celles r´eellement visualis´ees ou fix´ees par les participants de cette exp´erience.

Dans la deuxi`eme partie de ce travail, nous avons r´ealis´e un ensemble de tests psychovi-suels pour ´evaluer la qualit´e multimodale (audio et vid´eo) et multisupports. Tout d’abord, nous avons ´etudi´e l’influence de la pr´esence de l’audio sur le jugement de la qualit´e. A cette fin, des vid´eos d´egrad´ees de la base SICMedia ont ´et´e pr´esent´ees aux observateurs en leur demandant de juger leur qualit´e. Dans un premier temps, nous avons ´etudi´e l’influence d’un audio inalt´er´e sur le jugement de la qualit´e visuelle dans un contexte de vid´eo-conf´erence. Les r´esultats ne montrent pas d’influence notable de la pr´esence de l’audio non alt´er´e sur le juge-ment humain. En effet, ´etant donn´e que la qualit´e de cette modalit´e (audio) est quasi parfaite,

Introduction g´en´erale

celle-ci n’a pas eu d’influence positive ou n´egative sur une qualit´e visuelle d´egrad´ee `a diff´erents niveaux. Dans un second temps, nous avons pouss´e nos recherches en r´ealisant une deuxi`eme exp´erimentation plus g´en´erale. Les signaux auditifs et visuels sont cette fois-ci alt´er´es et in-versement combin´es (Une meilleure qualit´e audio est combin´ee avec une mauvaise qualit´e vid´eo et inversement). Diff´erents dispositifs d’affichage (Smartphones, Tablettes, ´ecran TV) et plusieurs r´esolutions d’images ont ´et´e utilis´es. Les vid´eos “stimuli” dans cette troisi`eme exp´erience ont ´et´e acquises dans un contexte de streaming. Une base des donn´ees, nomm´ee StreamApp, compos´ee de diff´erentes vari´et´es de vid´eos a ´et´e cr´e´ee `a cette fin. Les r´esultats ont montr´e que la qualit´e de l’audio joue un rˆole primordial dans l’´evaluation globale de la qualit´e audiovisuelle. En effet, une mauvaise qualit´e audio peut d´egrader, d’une fa¸con significative, la qualit´e audiovisuelle mˆeme si le contenu visuel associ´ee est de tr`es bonne qualit´e.

Organisation du manuscrit

Ce pr´esent document est scind´e en deux parties. La premi`ere, intitul´ee “saillance audio-visuelle”, est d´edi´ee `a l’´etude, l’analyse et la mod´elisation de la saillance audiovisuelle. La seconde partie, intitul´ee “qualit´e audiovisuelle”, est consacr´ee `a l’´evaluation de la qualit´e multimodale et multisupports. Ainsi, le manuscrit est organis´e en cinq chapitres et tente de faire une analyse de la saillance et de la qualit´e audiovisuelle :

— Dans le premier chapitre, nous faisons un ´etat de l’art des caract´eristiques et des perfor-mances des principaux mod`eles d’attention visuelle pr´esents dans la litt´erature. Nous commen¸cons par une introduction des syst`emes visuel et auditif humain ainsi que l’at-tention visuelle et auditive qui leur est associ´ee. Ensuite, nous d´ecrivons les diff´erents facteurs de cat´egorisation ainsi que les principales classes des mod`eles de saillance vi-suelle. Enfin, nous mettons l’accent sur les besoins de mod`eles de saillance audiovisuelle permettant de prendre en compte `a la fois les informations visuelles et auditives.

— Le deuxi`eme chapitre traite de l’influence de l’audio sur les mouvements oculaires hu-mains. Il permet d’investiguer d’un cˆot´e l’influence de l’audio sur l’attention visuelle et de l’autre, l’importance des visages et en particulier des visages parlants dans la s´equence vid´eo. Cette influence a ´et´e ´etudi´ee `a travers une premi`ere exp´erimentation oculom´etrique lors de laquelle des observateurs ont ´et´e appel´es `a regarder librement des s´equences vid´eo dans deux conditions : visuelle (sans son) et audiovisuelle (avec son). L’analyse est effectu´ee en comparant les positions oculaires de ces observateurs dans les deux conditions de l’exp´erience.

— Le troisi`eme chapitre est d´edi´e quant `a lui `a la mod´elisation de l’attention audiovi-suelle. Il propose un mod`ele de saillance audiovisuelle, pour les sc`enes de conversation ou de vid´eo-conf´erence. Ce mod`ele prend en compte, outre l’aspect spatio-temporel, l’information sonore dans la s´equence vid´eo. Une voie auditive d´edi´ee aux positions des locuteurs et des auditeurs dans la vid´eo a ´et´e ajout´ee au mod`ele `a trois branches. Un ensemble de mod`eles de saillance visuelle de la litt´erature a ´et´e utilis´e pour mod´eliser

la voie statique de ce mod`ele afin de choisir les trois mod`eles plus performants. Un ensemble de m´ethodes de fusion ont ´et´e employ´ees pour cr´eer la carte de saillance au-diovisuelle finale, r´esultant de la fusion des trois voies : statique, dynamique et auditive. Enfin, diff´erentes mesures ont ´et´e utilis´ees pour quantifier les performances du mod`ele de saillance propos´e.

— Le quatri`eme chapitre s’int´eresse `a l’´evaluation de la qualit´e audiovisuelle. Il propose de faire le tour sur les diff´erentes m´ethodes, subjectives et objectives, d’´evaluation de la qualit´e visuelle. A ce titre, nous d´ecrivons en d´etail les conditions des tests psychovisuels ainsi que les normes de l’UIT (Union Internationale des T´el´ecommunications) qui y sont associ´ees. Ensuite, nous pr´esentons les diff´erentes classes des m´ethodes (m´etriques) ob-jectives d’´evaluation de la qualit´e en mettant l’accent sur celles int´egrant des propri´et´es du syst`eme visuel humain (SVH). Enfin, nous mettons en ´evidence les approches mul-timodales permettant de prendre en compte l’information sonore dans leur processus d’´evaluation de la qualit´e globale telle qu’elle est per¸cue par l’utilisateur final.

— Enfin, le cinqui`eme chapitre est d´edi´e `a l’´etude de l’influence de la qualit´e de l’audio sur la qualit´e de la vid´eo et vice versa. Il propose tout d’abord d’´evaluer la qualit´e visuelle en pr´esence d’un audio inalt´er´e. A cette fin, nous avons men´e une campagne de tests psychovisuels pour quantifier l’influence du signal sonore sur le jugement hu-main de la qualit´e. Le signal audio reste inalt´er´e dans toute cette exp´erience. Dans un second temps, nous avons r´ealis´e une deuxi`eme campagne de tests psychovisuels o`u les deux modalit´es (audio et vid´eo) sont alt´er´ees. Dans cette troisi`eme exp´erience, nous avons utilis´e trois types de dispositifs d’affichage pour visualiser les s´equences vid´eo ; un Smartphone, une tablette et un ´ecran TV (homme cin´ema). Diff´erentes r´esolutions d’images ont ´et´e aussi utilis´ees. Pour ´evaluer l’influence de l’audio sur la qualit´e globale, les s´equences vid´eos et leur bande-son associ´ees sont inversement combin´ees (meilleure qualit´e vid´eo est associ´ee `a une qualit´e audio m´ediocre et vice versa). L’influence `a la fois du dispositif d’affichage et de la r´esolution utilis´ee a ´et´e ´egalement ´etudi´ee.

Premi`

ere partie

Chapitre 1

L’attention visuelle et sa mod´

elisation

Sommaire

1.1 Introduction . . . 7

1.2 Syst`emes visuel et auditif humains . . . 8

1.2.1 Syst`eme visuel humain . . . 8

1.2.2 Syst`eme auditif humain. . . 11

1.3 Attention/Saillance visuelle . . . 12

1.3.1 Attention ou saillance. . . 13

1.3.2 Attention et mouvements oculaires . . . 13

1.3.3 Applications . . . 13

1.4 Cat´egorisations d’attention visuelle . . . 14

1.4.1 Attention exog`ene ou endog`ene . . . 14

1.4.2 Attention ouverte ou couverte . . . 14

1.4.3 Attention spatiale ou spatio-temporelle . . . 14

1.4.4 Attention bas´ee espace ou objet . . . 16

1.5 Mod`eles de pr´ediction de la saillance visuelle . . . 16

1.5.1 Mod`eles cognitifs . . . 16

1.5.2 Mod`eles d’analyse spectrale . . . 20

1.5.3 Mod`eles graphiques . . . 22

1.6 Saillance auditive . . . 23

1.6.1 Mod`ele de Kayser et al. . . 24

1.6.2 Mod`ele de Tsuchida et al. . . 24

1.7 El l’audiovisuel ? . . . 26

1.8 Conclusion . . . 28

1.1

Introduction

La mod´elisation de l’attention visuelle est un champ de recherche tr`es actif. Depuis l’appa-rition en 1980 de la th´eorie d’int´egration des attributs (Feature Integration theory) de Treis-man et al. [30], reconnue comme ´etant la base de l’´etude de l’attention visuelle, le nombre

de mod`eles ne cesse d’augmenter. Dans ce chapitre, nous proposons de dresser un panorama des caract´eristiques et des performances des principaux mod`eles d’attention ou de saillance visuelle pr´esents dans la litt´erature. Pour ce faire, nous commen¸cons par d´ecrire bri`evement le syst`eme visuel et le syst`eme auditif humains. Ensuite, l’attention visuelle est d´efinie et les diff´erents facteurs de cat´egorisation (classification) sont pr´esent´es. Les principales classes sont alors d´ecrites en mettant en ´evidence les m´ecanismes computationnels associ´es. Nous pr´esentons enfin les quelques mod`eles pr´eliminaires d’attention “audiovisuelle” int´egrant `a la fois les informations visuelles et auditives.

1.2

Syst`

emes visuel et auditif humains

Afin d’appr´ehender au mieux la saillance audiovisuelle, il est important de pr´esenter l’anatomie fonctionnelle des syst`emes visuel et auditif impliqu´es dans cette derni`ere. Ces deux syst`emes traitent une tr`es grande quantit´e d’informations fournies par l’environnement ext´erieur. Le traitement de ces informations est rapide et permet de r´eagir rapidement et correctement. Cette performance est li´ee `a la capacit´e qu’ont ces syst`emes de r´eduire l’in-formation visuelle afin de ne conserver que des attributs permettant de guider notre atten-tion vers des r´egions particuli`eres de l’environnement, appel´ees classiquement des r´egions saillantes. Ce biais attentionnel est non seulement guid´e par les informations visuelles et auditives s´epar´ement, mais aussi par leur interaction audiovisuelle.

1.2.1

Syst`

eme visuel humain

Le syst`eme visuel humain (SVH) est principalement constitu´e de deux organes : l’œil, qui est le capteur de la lumi`ere de l’environnement ext´erieur, et le cortex visuel qui permet ensuite de traiter ces informations visuelles. L’acheminement de ces informations de la r´etine (lieu de traduction du message lumineux venant de l’environnement ext´erieur) au cortex visuel est illustr´e en figure 1.1 (b).

La figure 1.1 (a) repr´esente une coupe transversale de l’œil humain avec ses principales composantes. La perception visuelle d’une sc`ene est d´etermin´ee par les rayons lumineux (´emis ou r´efl´echis) de cette sc`ene. Quand un rayon lumineux traverse l’œil, il passe `a travers la corn´ee, l’humeur aqueuse, l’iris, le cristallin, le corps vitr´e et enfin la r´etine.

La r´etine est le lieu de traduction du message lumineux venant de l’environnement ext´erieur. Elle est compos´ee d’un ensemble de couches de cellules (des photor´ecepteurs, d’une couche granuleuse interne et des cellules ganglionnaires) [3]. Les photor´ecepteurs se d´ecomposent en deux types : les bˆatonnets et les cˆones. Les bˆatonnets (environ 100 millions par œil) sont des cellules r´eparties sur toute la surface de l’œil permettant ainsi la vision scotopique (nocturne ou de faible ´eclairage). Ils sont ´egalement associ´es `a la d´etection de mouvement [2, 3]. Les cˆones (entre 6 et 7 millions par œil chez l’homme) sont des cellules localis´ees dans le centre de l’œil assurant la vision diurne. Elles sont responsables de l’acuit´e visuelle et de la vision des couleurs. Ainsi, lorsqu’il y a une quantit´e de lumi`ere suffisante, l’homme per¸coit une immense vari´et´e de couleurs diff´erentes grˆace notamment `a ses trois

1.2. Syst`emes visuel et auditif humains

(a) (b)

Figure 1.1 – Sch´ema global du syst`eme visuel humain [2].

types de cˆones ; L (sensibles `a la lumi`ere rouge, de longueur d’onde 560 nm), M (sensibles `a la lumi`ere verte, de longueur d’onde 530 nm) et S (sensibles `a la lumi`ere bleue, de longueur d’onde 524 nm) [9, 10, 74]. Les cˆones sont concentr´ees dans une r´egion centrale de la r´etine appel´ee fov´ea. Elle est la partie de la r´etine o`u notre vision des d´etails est la plus pr´ecise. C’est pourquoi nos points de fixation doivent ´evoluer pour analyser les d´etails. Finalement, le cortex visuel est la partie du SVH responsable du traitement de l’information visuelle. Il se trouve au pˆole dorsal du lobe occipital (figure 1.2).

L’information r´etinienne est achemin´ee, dans un premier temps, vers les corps genouill´es lat´eraux gauche et droit, `a travers le chiasma optique le long du tractus optique par les nerfs optiques, puis directement vers le cortex visuel primaire (aire V1) [1, 2]. Diff´erents traite-ments progressifs de cette information sont ainsi effectu´es. Les corps genouill´es lat´eraux sont compos´es de six couches : les couches 1 `a 4 sont impliqu´ees dans le traitement de la couleur et de la forme tandis que les couches 5 et 6 participent aux traitements de l’information relative au mouvement.

Filtrage visuels

Comme mentionn´e ci-dessus, la r´etine et le cortex visuel sont les deux principales parties du SVH. Ainsi, le traitement des informations r´etiniennes et corticales a ´et´e particuli`erement mod´elis´e [9, 74, 19]. Pour la r´etine, le fonctionnement des cellules essentielles qui la compose a ´et´e mod´elis´e dans [13] par des filtrages spatio-temporels : transform´ee de Fourier pour la dimension temporelle continue et la transform´ee en Z pour la dimension spatiale discr`ete. Cette mod´elisation, en particulier du filtrage spatiale r´ealis´e par la r´etine, a ´et´e adopt´ee par Ho-Phuoc dans [9]. Dans ces travaux, le filtrage “r´etinien” appliqu´e `a l’information de luminance est diff´erent de celui appliqu´e `a l’information de chrominance. Par cons´equent, les fonctions de sensibilit´e au contraste diff´erent pour ses deux informations, comme le montre la figure1.3. En r´esum´e, la mod´elisation de la r´etine consiste `a renforcer les contrastes (les hautes fr´equences spatiales) pour la luminance et un filtrage passe-bas spatial pour les informations

Figure 1.2 – Diff´erentes couches du syst`eme visuel humain [3]

chromatiques. Enfin, les informations de luminance et la chrominance sont envoy´ees au cortex visuel, o`u diff´erents traitements seront appliqu´es par la suite.

Figure 1.3 – Fonction de sensibilit´e au contraste normalis´ee pour les voies de chrominance et de luminance (Image extraite de [9]).

Pour le cortex visuel, les premi`eres r´eponses neuronales de l’aire V1 consistent en un ensemble de filtres spatio-temporels s´electifs. Dans le domaine fr´equentiel, le fonctionnement de l’aire V1 (filtres corticaux) peut ˆetre assimil´e `a une suite de transformations de Fourier complexes. Th´eoriquement, ces filtres peuvent conjointement effectuer le traitement neuronal de la fr´equence spatiale, de l’orientation, du mouvement, et de la vitesse (fr´equence tempo-relle) [1, 3].

1.2. Syst`emes visuel et auditif humains

1.2.2

Syst`

eme auditif humain

Dans le syst`eme auditif humain (SAH), les ondes sonores sont capt´ees par le pavillon puis achemin´ees vers la cochl´ee, l’organe principal de la perception auditive. Le SAH est compos´e de trois parties [4] : l’oreille externe, l’oreille moyenne et l’oreille interne comme le montre la figure 1.4.

Figure 1.4 – Sch´ema du syst`eme auditif humain [4].

— Oreille externe : Compos´ee d’un pavillon, qui sert `a la protection et l’amplification du signal sonore, et d’un conduit auditif externe, qui permet d’acheminer ces ondes vi-bratoires vers l’oreille moyenne. Le conduit auditif poss`ede une fr´equence de r´esonnance qui oscille entre 1 et 3 KHz. C’est pourquoi notre syst`eme auditif est tr`es sensible aux fr´equences de la parole humaine (environ 3KHz).

— Oreille moyenne : Compos´ee principalement du tympan et est situ´ee entre la fenˆetre ovale de l’oreille externe et la cochl´ee de l’oreille interne. Elle permet de convertir les ondes sonores en vibratoires m´ecaniques `a travers un ensemble de petits osselets (mar-teau, enclume et ´etrier).

— Oreille interne : C’est cette derni`ere qui contient l’organe principal de l’ou¨ıe, la co-chl´ee. Cette derni`ere, renfermant entre 15 et 20 milles cellules cili´ees, permet de trans-former l’´energie acoustique en flux nerveux. Ce dernier est par la suite v´ehicul´e vers le cortex auditif par les nerfs auditifs pour un traitement de ces informations sonores, comme dans le cas du cortex visuel. Une lecture plus approfondie de ce m´ecanisme est disponible en [5].

Notre syst`eme auditif est expos´e `a une source multiple de voix, de sons et de bruits superpos´es, dont les spectres sont bien diff´erents. N´eanmoins, ce syst`eme auditif est ca-pable de porter notre attention sur une source sonore bien particuli`ere, parole humaine par

exemple, mˆeme en pr´esence d’un environnement bruit´e. Cette proc´edure du SAH permettant de r´ecup´erer une source complexe de l’environnement ext´erieur et de la s´eparer en “packets” acoustiques (de fr´equence et nature diff´erente) peut ˆetre d´ecrite par l’Analyse des Sc`enes Auditives (Auditory Scene Analysis, ASA) [6]. Cette analyse se compose des processus de regroupement s´equentiel et simultan´e :

— Regroupement simultan´e : Ce type de regroupement sert `a rassembler les informations qui proviennent, au SAH, de la mˆeme source sonore et `a s´eparer les informations pro-venant de sources distinctes. Ce regroupement est bas´e essentiellement sur des indices comme l’harmonicit´e commune et la coh´erence de la modulation d’amplitude [7]. — Regroupement s´equentiel : Il sert `a affecter les ´ev´enements successifs qui pr´esentent une

certaine coh´erence entre eux `a des repr´esentations mentales du comportement temporel des sources sonores [6, 7]. Il est bas´e sur un ensemble d’indices : le contenu fr´equentiel, l’enveloppe spectrale, etc.

Bien que les syst`emes visuel et auditif humain pr´esentent une anatomie diff´erente, ceux-ci ont des comportements fonctionnels tr`es similaires. Nous trouvons ainsi, par analogie avec le syst`eme visuel, le cortex auditif qui est la partie principale du syst`eme auditif humain. Il est responsable de l’analyse en d´etail des informations auditives provenant du milieu ext´erieur. Ainsi, ce cortex auditif nous permet de distinguer et m´emoriser les diff´erentes fr´equences so-nores (son grave ou aigu), mais aussi de connaˆıtre l’intensit´e du son (fort ou faible), sa dur´ee et son timbre. Il poss`ede des voies eff´erentes inhibitrices permettant de r´eduire sp´ecifiquement la sensibilit´e `a certaines fr´equences sonores. Par cons´equent, ceci permet de prˆeter notre at-tention auditive `a des sons particuliers tout en att´enuant les autres sons. C’est en quelque sorte une fonctionnalit´e similaire `a la fonction de sensibilit´e au contraste dans le cas visuel.

Dans le reste de ce chapitre, nous d´ecrivons en d´etail l’attention visuelle et auditive, puis nous pr´esentons les principaux mod`eles de saillance visuelle et auditive associ´es et nous terminons par l’interaction de ces informations attentionnelles.

1.3

Attention/Saillance visuelle

L’attention visuelle est un m´ecanisme important du syst`eme visuel humain qui mod´elise notre perception visuelle du monde ext´erieur. Elle permet de s´electionner les r´egions de la sc`ene les plus distinctives de leur voisinage. Du cˆot´e de la recherche, des efforts ont ´et´e consacr´es `a l’´etude et la compr´ehension des principales caract´eristiques du syst`eme visuel humain, de la r´etine aux diff´erentes aires du cortex visuel. Diff´erentes th´eories fondatrices de l’attention visuelle ainsi que les mod`eles associ´es ont ´et´e propos´es [26, 64]. La premi`ere mise en œuvre computationnelle de ces mod`eles est propos´ee par Koch et Ullman [14] qui ont int´egr´e des caract´eristiques visuelles afin de construire une sorte de carte topographique qui repr´esente la sc`ene. La premi`ere impl´ementation et v´erification de ce mod`ele, appliqu´e aux sc`enes synth´etiques mais aussi naturelles, a ´et´e faite par Laurent Itti [11]. Diff´erentes approches bas´es sur ce dernier mod`ele, qui est en am´elioration continue jusqu’`a nos jours, ont ´et´e par la suite propos´ees.

1.3. Attention/Saillance visuelle

1.3.1

Attention ou saillance

De mani`ere interchangeable, les termes attention et saillance sont souvent utilis´es dans la litt´erature. Cependant, ces termes ont chacun une d´efinition bien particuli`ere : l’attention est un concept g´en´eral couvrant tous les facteurs qui influencent le m´ecanisme de s´election (exog`enes ou endog`enes). La saillance, quant `a elle, caract´erise certaines parties de la sc`ene, objets ou autres, qui apparaissent plus distinctifs par rapport `a leur voisinage. Le terme “saillant” est souvent utilis´e dans les processus attentionnels li´es aux facteurs de bas-niveau, par cons´equent les mod`eles ascendants (bottom-up) sont couramment appel´es mod`eles de saillance visuelle.

1.3.2

Attention et mouvements oculaires

Il est difficile d’appr´ehender l’attention visuelle sans au pr´ealable avoir rappel´e sa re-lation avec les mouvements oculaires. Les recherches neuronales et cognitives ont attribu´e une relation d’interd´ependance entre ces deux concepts. Il existe deux types de mouvements oculaires : des mouvements saccad´es (saccades et fixations) o`u les yeux se focalisent sur diff´erentes r´egions d’une sc`ene lors de son exploration et des mouvements de poursuites, o`u les yeux suivent des objets en d´eplacement. L’´etude des caract´eristiques (biais centr´e, distri-bution des saccades et fixations, etc.) et des facteurs influen¸cant les mouvements oculaires (bas-niveau, haut niveau, etc.) est d´etaill´ee dans [51, 10]. Pour mesurer les mouvements des yeux, les chercheurs font appel `a des syst`emes oculom´etriques. L’utilisation de ces syst`emes remonte `a 1935 avec Buswell [51]. Les r´esultats fournis par ces eye-trackers qui sont au-jourd’hui largement r´epandus, constituent la base de validation des mod`eles attentionnels (Chapitre 3).

1.3.3

Applications

Les applications qui exploitent l’attention visuelle et les mod`eles attentionnels associ´es sont aujourd’hui nombreuses : la vision par ordinateur (la reconnaissance et d´etection d’ob-jets, la poursuite de cibles, la compression, etc.), l’infographie (rendu d’images, ´eclairage dynamique, etc.) et la robotique (navigation et interaction). La vision par ordinateur, le do-maine qui nous int´eresse ici, est le champ qui utilise plus les mod`eles d’attention visuelle car les tˆaches r´ealis´ees par ceux-ci sont proches de celles de la vision humaine. On trouve ainsi des applications li´ees au traitement d’images au sens large du terme (segmentation, compression, etc.). Un mod`ele de saillance visuelle permet de hi´erarchiser l’importance des r´egions d’une image. Par exemple, cette hi´erarchie peut ˆetre utilis´ee pour s´electionner et adapter le taux de compression. Un autre exemple d’utilisation est le r´esum´e de vid´eos. L’attention visuelle dans ce cas, permet de s´electionner les trames ayant le plus de s´emantiques dans la vid´eo pour r´eduire la taille de celle-ci tout en respectant le sens du contenu afin de faciliter son stockage (cas de la vid´eosurveillance par exemple). R´ecemment, cette notion a ´et´e utilis´ee pour l’´evaluation de la qualit´e visuelle [66].

1.4

Cat´

egorisations d’attention visuelle

Les facteurs de cat´egorisation qui sont d´ecrits dans ce paragraphe servent `a l’analyse et la classification des mod`eles d’attention visuelle.

1.4.1

Attention exog`

ene ou endog`

ene

Posner [26] a d´efinit en 1980 deux types d’attention : l’attention exog`ene et l’attention endog`ene. L’attention exog`ene (ou ascendante) est un m´ecanisme automatique bas´e sur les caract´eristiques de la sc`ene. Il s’agit d’un processus externe d´eclench´e par les stimuli externes (stimulus-driven). L’objet qui attire notre attention doit ˆetre suffisamment distinctif de son entourage. Un exemple typique d’une attention exog`ene est une sc`ene contenant une barre horizontale entour´ee par des barres verticales. L’attention est imm´ediatement attir´ee par la barre horizontale. Contrairement `a l’attention exog`ene, l’attention endog`ene (ou descendante) est un m´ecanisme volontaire li´e `a nos objectifs (goal ou task-driven). Un exemple de ce dernier type d’attention est de chercher par exemple une personne qui parle parmi plusieurs dans une s´equence vid´eo. L’approche exog`ene ´etant rapide et simple `a mod´eliser, la majorit´e des mod`eles attentionnels l’exploite [11, 64,17].

1.4.2

Attention ouverte ou couverte

Les recherches portant sur l’attention visuelle ont distingu´e l’attention ouverte de l’atten-tion couverte (le “comment” focaliser son attenl’atten-tion). Ces deux types d’attenl’atten-tion se diff´erencient par les mouvements des yeux. L’attention ouverte consiste `a faire bouger les yeux et/ou la tˆete afin de placer l’objet de notre attention sur la fov´ea ; l`a o`u une analyse d´etaill´ee a lieu. Ce type d’attention est observable et mesurable `a l’aide d’un eye-tracker. Par contre, l’atten-tion couverte consiste `a focaliser le regard sur un stimulus lors de l’exploral’atten-tion d’une sc`ene sans changer l’orientation du regard. En 1967, Yarbus [28] a ´etudi´e la liaison entre l’atten-tion ouverte est les mouvements des yeux `a travers des s´eries d’exp´erimental’atten-tion. Il a montr´e que les mouvements des yeux d´ependaient de la tˆache demand´ee. La figure 1.5 montre les mouvements des yeux lors d’une observation libre (free watching) d’une sc`ene. Le regard est naturellement attir´e par le visage et, en particulier, les yeux, le nez et la bouche. La figure 1.6 montre, au contraire, les mouvements oculaires lors d’une observation d’une sc`ene avec des tˆaches bien particuli`eres (questions).

Un exemple simple de l’attention visuelle couverte consiste `a focaliser le regard sur une personne qui parle tout en ´etant conscient de l’espace visuel en dehors de la vision fov´eale centrale. Un autre exemple de ce type d’attention est la conduite, le conducteur focalise son regard sur la route tout en surveillant simultan´ement l’´etat des panneaux et des feux.

1.4.3

Attention spatiale ou spatio-temporelle

La s´election visuelle est, naturellement, d´ependante `a la fois de la saillance de la sc`ene courante ainsi que du cumul des connaissances acquises les instants pr´ec´edents. De nom-breux mod`eles d’attention visuelle sont consacr´es `a l’´etude de l’attention “statique” : mod`eles

1.4. Cat´egorisations d’attention visuelle

Figure 1.5 – Mouvements des yeux lors d’une observation libre d’une sc`ene selon Yarbus “attention ouverte” (Image extraite de [28]).

Figure1.6 – Mouvements oculaires lors d’une observation d’une sc`ene avec diff´erentes tˆaches (questions) de 3 minutes chacune. Image extraite de [74]

d’images fixes [11, 64, 23]. D’autres mod`eles utilisent l’information de mouvement pour mod´eliser leur approche “dynamique” : mod`eles de saillance de vid´eos [17, 19]. La majorit´e des mod`eles spatio-temporels de saillance calcule, pour estimer le mouvement, le flux op-tique (optical flow ). Diff´erentes m´ethodes sont alors utilis´ees : m´ethodes de correspondance de blocs, m´ethodes bas´ees sur l’´energie ou m´ethodes diff´erentielles.

1.4.4

Attention bas´

ee espace ou objet

Que ce soit exog`ene ou endog`ene, ouverte ou couverte, spatiale ou spatio-temporelle, la majorit´e des mod`eles attentionnels se base sur une repr´esentation spatiale (space-based ) [11,64]. Cela vient du fait qu’une repr´esentation spatiale, en plus de sa simplicit´e de mise en œuvre, est plus coh´erente avec le caract`ere bas-niveau de l’attention visuelle. Cependant, des mod`eles d’attention visuelle bas´es objets (object-based ) ont ´et´e propos´es dans la litt´erature. Un panorama des diff´erents mod`eles d’attention bas´es objets est d´ecrit dans [29].

1.5

Mod`

eles de pr´

ediction de la saillance visuelle

Depuis 1998, l’ann´ee de la publication du premier mod`ele computationnel d’attention visuelle, biologiquement plausible, par Itti et Koch [11], un int´erˆet croissant a ´et´e port´e `a ce sujet. Diff´erents mod`eles, inspir´es de la biologie ou simplement bas´es sur des outils math´ematiques, ont ´et´e propos´es. Ces mod`eles peuvent ˆetre class´es, en fonction de leurs m´ecanismes pour estimer l’attention visuelle, en plusieurs cat´egories. Nous nous sommes int´eress´es ici aux mod`eles permettant, `a partir d’une image fixe ou d’une vid´eo, de produire une carte de saillance visuelle.

1.5.1

Mod`

eles cognitifs

Presque tous les mod`eles attentionnels sont directement ou indirectement inspir´es des concepts cognitifs. Nous d´ecrivons dans cette section les mod`eles, qui ont trait aux notions psychologiques ou neurophysiologiques, les plus utilis´es dans la litt´erature pour g´en´erer des cartes de saillance.

• Itti et Koch 1998

D´etaill´e dans de nombreuses th`eses et rapports, le mod`ele bottom-up (cf. paragraphe 1.3.1) d’Itti et Koch utilise, dans sa version originale, trois caract´eristiques perceptuelles pour construire une carte de saillance : intensit´e, couleur et orientation (figure 1.7). L’image d’entr´ee est d´ecompos´ee en diff´erents canaux perceptuels `a partir desquels une repr´esentation multi-´echelles de l’image est construite. Ensuite, un filtrage centre-p´eriph´erie est effectu´e afin d’obtenir 42 cartes de caract´eristiques :

— 6 pour l’intensit´e.

1.5. Mod`eles de pr´ediction de la saillance visuelle

— 24 pour l’orientation (0°, 45°, 90° et 135°)

Ces cartes caract´eristiques sont normalis´ees par un op´erateur N (.) permettant de renforcer les cartes contenant un petit nombre de pics d’activit´e (correspondant aux zones saillantes). Ensuite, elles sont somm´ees pour obtenir trois cartes de visibilit´e (conspicuity map) corres-pondant `a l’intensit´e (CI), la couleur (CC) et l’orientation (CO). Enfin, ces trois cartes sont lin´eairement combin´ees pour obtenir une seule carte de saillance (CS) :

CS = 1 3

X k=I,C,O

Ck (1.1)

Figure 1.7 – Architecture du mod`ele de Laurent Itti (Image extraite de [11]).

Un r´eseau de neurones de type Winner Takes All (WTA) coupl´e `a un m´ecanisme d’inhi-bition de retour IOR (Inhid’inhi-bition Of Return) est utilis´e afin de pr´edire une sorte de parcours oculaire. Le r´eseau WTA g´en`ere les diff´erentes focalisations en s´electionnant la zone d’activit´e maximale de la carte de saillance tandis que le m´ecanisme d’inhibition d´esactive temporaire-ment la r´egion d´ej`a visit´ee. Ce mod`ele, poss´edant une architecture simple, est aujourd’hui la r´ef´erence pour la comparaison des mod`eles d’attention visuelle. Diff´erentes impl´ementations

de ce mod`ele sont disponibles librement : Saliency Toolbox de Walther [14], VOCUS de Frin-trop [15], etc. Ce mod`ele, initialement d´edi´e aux images fixes, a ´et´e am´elior´e par Itti lui-mˆeme en ajoutant des attributs de mouvement (flicker, motion) afin qu’il soit capable de pr´edire une carte de saillance vid´eo.

En r´esum´e, le mod`ele d’Itti pr´esente de nombreux avantages : il est simple `a œuvre et efficace en temps de calcul (il utilise les m´ecanismes de WTA et IOR pour choisir les fixations au cours du temps). Toutefois, l’aspect biologique mod´elis´e reste limit´e.

• Le Meur et al.

Le Meur [17] propose un mod`ele d´eriv´e du mod`ele d’Itti en mod´elisant quelques ca-ract´eristiques d’entr´ee du syst`eme visuel humain SVH : la sensibilit´e aux contrastes, la d´ecomposition perceptuelle et le masquage visuel. En plus, l’espace couleur RVB utilis´e par Itti a ´et´e remplac´e dans ce mod`ele par l’espace couleur perceptuel de Krauskopf ACr1Cr2 (A : luminance, Cr1 : chrominance, Cr2 : chrominance) afin de simuler le traitement r´etinien de l’information visuelle [74, 19].

Ce mod`ele a ´et´e ´etendu dans le domaine spatio-temporel [18] en combinant les infor-mations chromatiques, achromatiques et temporelles. Dans ce mod`ele, les caract´eristiques visuelles sont extraites s´epar´ement en plusieurs canaux parall`eles. Pour chaque canal, une carte de caract´eristique est obtenue puis une unique carte de saillance est construite `a partir de ces canaux. L’architecture de la derni`ere version de ce mod`ele est repr´esent´ee par la figure 1.8.

Contrairement `a la m´ethode de fusion adopt´ee par Itti (sommation des cartes), Le Meur et al. ont utilis´e une m´ethode de fusion en deux ´etapes. Tout d’abord, les cartes chromatiques et achromatique sont regroup´ees en une seule carte (spatiale). Cette carte sera par la suite fu-sionn´ee avec la carte temporelle. Avant cette ´etape de fusion, les deux cartes sont normalis´ees par des valeurs th´eoriques. Afin de prendre en compte la compl´ementarit´e des cartes ainsi que leur redondance, un terme additif et un terme multiplicatif ont ´et´e utilis´es dans la fusion.

Malgr´e la prise en compte de certaines propri´et´es du SVH, le gain en termes de perfor-mances de ce mod`ele sont tr`es faibles. La complexit´e calculatoire, dˆu `a la d´ecomposition perceptuelle, est aussi un point critique de ce mod`ele bio-inspir´e. Il n’est pas adapt´e aux applications n´ecessitant le temps r´eel ou presque.

• Marat et al.

Marat et al. [19] ont propos´e une approche bottom-up pour pr´edire une carte de saillance spatio-temporelle de vid´eos. Ce mod`ele permet d’extraire deux signaux de la vid´eo corres-pondants aux deux principales sorties de la r´etine : la voie parvocellulaire et la voie ma-gnocellulaire. Ces signaux permettent de traiter les informations statiques et dynamiques et de construire une carte de saillance pour chaque voie. Finalement, les deux cartes sont

1.5. Mod`eles de pr´ediction de la saillance visuelle

fusionn´ees pour g´en´erer une seule carte de saillance spatio-temporelle. Ce mod`ele a ´et´e va-lid´e via une exp´erimentation d’eye-traking sur une base de donn´ees de grande taille (17000 trames). le mod`ele de Marat a ´et´e impl´ement´e en C et est disponible `a cette adresse : http://www.gipsa-lab.fr/projet/perception/. On peut choisir de ne calculer que la sor-tie statique, dynamique, ou la fusion de toutes les voies. Cinq m´ethodes de fusions ont ´et´e utilis´ees pour construire la carte finale : 3 m´ethodes dites “classiques” et 2 m´ethodes dites “adapt´ees”. Pour les m´ethodes classiques, une fusion moyenn´ee (sommes de deux cartes), une fusion maximum (le maximum de deux cartes) et une fusion multiplicative (multiplication pixel par pixel des deux cartes) ont ´et´e test´ees. En ce qui concerne les m´ethodes adapt´ees, les deux cartes sont tout d’abord pond´er´ees par leurs caract´eristiques appropri´ees [19] : le maximum pour les cartes statiques et le skewness (cœfficient de dissym´etrie) pour les cartes dynamiques, comme suit :

Ms′= M ax(Ms)× Ms (1.2)

Md′ = Skewness(Mf)× Md (1.3)

Ms et Md sont les cartes statiques et dynamiques, respectivement.

Ensuite, une fusion dite “simple” des deux voies Msd et une fusion “renforc´ee MRsd ont ´et´e d´efinies, comme le montre les ´equations1.4et1.5. Les r´esultats de ces m´ethodes de fusion ont montr´e que la m´ethode MRsd, favorisant les pixels saillants dans les deux voies, est la plus performante, en utilisant la m´etrique NSS (cf. Chapitre 3).

Msd = Ms′+ Md′ (1.4)

MRsd = Ms′+ Md′+ Ms′× Md′ (1.5) Les mod`eles cognitifs ont l’avantage d’int´egrer des aspects biologiques de l’attention vi-suelle. Ils sont simples, faciles `a impl´ementer et extensibles. Cependant, la m´ethodologie de fusion des cartes, pour obtenir la carte de saillance finale, soul`eve de nombreuses questions (notamment des valeurs th´eoriques ont ´et´e choisies arbitrairement sans aucune justification, comme dans le cas de Le Meur et al.).

1.5.2

Mod`

eles d’analyse spectrale

Au lieu de traiter une image dans le domaine spatial, les mod`eles d’analyse spectrale calculent la saillance visuelle dans le domaine fr´equentiel. Dans ce paragraphe, nous ne pr´esentons pas les mod`eles attentionnels bio-inspir´es mˆeme si ces derniers effectuent une d´ecomposition spatio-fr´equentielle (comme celui de Le Meur [18], par exemple). Achanta et al. [23] ont propos´e un mod`ele de saillance bas´e sur les caract´eristiques bas-niveau de la lumi-nance et de la couleur (figure 1.10). L’image d’entr´ee subit une transformation dans l’espace de couleur CIELAB, ensuite la carte de saillance est calcul´ee comme suit :

1.5. Mod`eles de pr´ediction de la saillance visuelle

o`u Iµ est la moyenne arithm´etique sur chaque canal de l’image I, IW hc(x, y) est la version liss´ee de l’image par un filtrage gaussien de fenˆetre 5 × 5 et k.k est la distance Euclidienne.

Figure 1.10 – Architecture du mod`ele d’Achanta et al. [23]

Ce mod`ele a tr`es rapidement ´et´e utilis´e dans les comparaisons des performances des nouveaux mod`eles de saillance visuelle (cf. chapitre 3). Malgr´e sa simplicit´e math´ematique, ce mod`ele pr´esente des r´esultats comp´etitifs par rapport aux mod`eles bio-inspir´es.

Zhang et al. [24] ont propos´e une m´ethode simple et efficace pour pr´edire la saillance visuelle bas´ee sur le spectre r´esiduel. En effet, ils supposent que les singularit´es statistiques dans le spectre peuvent ˆetre responsables pour les r´egions anormales dans l’image, o`u les objets deviennent visibles. Cette m´ethode est ind´ependante des caract´eristiques, cat´egories, ou d’autres formes de connaissance pr´ealable de l’objet. Une analyse de l’image dans le domaine spectral permet d’extraire le spectre r´esiduel et par la suite construire une carte de saillance correspondante dans le domaine spatial. Guo et Zhang [25] ont propos´e ensuite une approche bas´ee sur le spectre de phase de la transform´ee de Fourier (PFT Phase spectrum of Fourier Transform). Ils ont montr´e que l’utilisation de ce dernier, au lieu du mod`ele bas´e sur le spectre r´esiduel, est plus rapide en temps de calcul et donne de meilleurs r´esultats. Cette approche a ´et´e utilis´ee pour calculer la saillance d’une s´equence vid´eo par l’ajout de l’information de mouvement.

Les mod`eles d’analyse spectrale sont simples et faciles `a impl´ementer. La plausibilit´e biologique de ces mod`eles reste malgr´e tout critiquable.

1.5.3

Mod`

eles graphiques

Un mod`ele de cette cat´egorie est consid´er´e comme un cadre probabiliste dans lequel un graphe repr´esente une structure conditionnelle ind´ependante entre des variables al´eatoires. L’attention visuelle, li´ee aux mouvements oculaires, est trait´ee comme une s´erie chronolo-gique. Harel et al. [16] proposent une approche nomm´ee GBVS (Graph-Based Visual Sa-liency) permettant d’extraire des cartes caract´eristiques `a plusieurs ´echelles spatiales. La m´ethode propos´ee pr´esente une coh´erence remarquable avec le d´eploiement de l’attention des

1.6. Saillance auditive

sujets humains lors d’une s´erie d’exp´erimentations psychovisuelles. Elle permet d’int´egrer la notion de biais centr´e (central bias) favorisant les r´egions centrales de la sc`ene. Ce mod`ele, biologiquement plausible, a ´et´e largement utilis´e dans la litt´erature dˆu `a sa simplicit´e est sa rapidit´e calculatoire.

Au-del`a des classes de mod`eles d´ecrites ci-dessus, diff´erentes approches ont ´et´e propos´ees dans la litt´erature. Nous trouvons ainsi des mod`eles bas´es sur les th´eories de l’information, comme celui de Bruce [20], o`u le calcul de la saillance locale sert `a maximiser l’information acquise `a partir de son environnement. Il traite les parties de la sc`ene les plus informatives et rejettent le reste. Dans [76], les auteurs ont pr´esent´e une approche bas´ee sur l’estimation de la saillance locale. Les caract´eristiques visuelles sont estim´ees en utilisant l’acquisition comprim´ee (Sparse Sampling) et l’estimation de la densit´e de noyau dans un cadre bay´esien. Cette m´ethode, rapide `a mettre en œuvre, permet d’obtenir un gain de 5% par rapport aux autres m´ethodes classiques (Itti, Achanta, etc). Ce mod`ele figure parmi les dix premiers mod`eles de saillance les plus performants sur la base des donn´ees MIT [72] (cf. chapitre 3).

1.6

Saillance auditive

Bien que les syst`emes visuel et auditif pr´esentent une diff´erence anatomique importante (section 1.2), des recherches neuronales ont montr´e que leur m´ecanisme sensoriel est tr`es similaire [68]. De ce fait, diff´erents mod`eles de saillance auditive ont ´et´e propos´es avec des r´esultats encourageants. Les premiers mod`eles ne datent que de 2005 avec notamment les travaux de Matei [22]. Ces mod`eles peuvent ˆetre class´es en deux cat´egories :

- Mod`eles bas´es sur la spatialisation du son : ces mod`eles tentent d’estimer la localisa-tion spatiale du son en se basant sur des indices physiques. La technique de spatialisalocalisa-tion sonore la plus proche de l’´ecoute naturelle est la synth`ese binaurale [32]. Grˆace `a deux filtres correspondants aux oreilles gauche et droite, commun´ement appel´es HRTF (Head Related Transfer Function) ou les fonctions de transfert binaurale et leurs ´equivalents temporels, nomm´es HRIR (Head Related Impulse Response), cette synth`ese permet un rendu spatia-lis´e d’une source sonore `a une position donn´ee. Le ITD (Interaural Time Difference) ou Diff´erence Interaurale de Temps et le IID (Interaural Intensity Difference) ou Diff´erence In-teraurale d’Intensit´e sont des indices fondamentaux pour la perception auditive. L’association de l’IID et l’ITD permet une localisation relativement pr´ecise de la source sonore [32, 34]. Ces mod`eles sont g´en´eralement con¸cus pour des applications li´ees aux robots humano¨ıdes, plus pr´ecis´ement l’orientation spatiale de ces robots [31, 33, 34]. Les signaux auditifs dans cette cat´egorie doivent ˆetre st´er´eophoniques (utilisation d’au moins deux microphones pour l’acquisition du signal audio)

- Mod`eles bas´es sur la similarit´e entre les syst`emes visuel et auditif : ces mod`eles pr´esentent une architecture proche de celle obtenue dans les mod`eles visuels d´ecrits pr´ec´edemment. Le signal sonore, dans cette cat´egorie, est converti en une carte d’intensit´e temps-fr´equence consid´er´ee comme une image sur laquelle sont appliqu´es les mˆemes traitements que dans le

cas visuel [35,36]. Ces mod`eles sont utilis´es pour diverses applications : D´etection de parole, analyse des sc`enes auditives, etc.

1.6.1

Mod`

ele de Kayser et al.

Le concept essentiel de la mod´elisation de la saillance auditive a ´et´e propos´e par Chris-toph Kayser [35]. La structure de ce mod`ele (figure 1.11) est tr`es similaire `a celle propos´ee par Itti dans le cas visuel [11]. La diff´erence repose essentiellement sur l’extraction des ca-ract´eristiques. Les cartes sont obtenues au moyen d’un spectrogramme (une repr´esentation visuelle de la mani`ere dont les fr´equences, du signal sonore, changent au cours du temps). La carte de saillance auditive extrait les caract´eristiques individuelles, telles que la modulation spectrale ou temporelle, de mani`ere parall`ele. Apr`es l’extraction des caract´eristiques, un en-semble de filtres est utilis´e pour quantifier : l’intensit´e du son, le contraste de fr´equence et le contraste temporel. A travers un m´ecanisme de centre-pourtour, une carte de singularit´e (conspicuity map) est cr´e´ee pour chaque caract´eristique extraite. Enfin, ces cartes sont fu-sionn´ees, d’une mani`ere similaire `a celle utilis´ee par Itti (sommation), pour obtenir la carte de saillance auditive finale.

Le mod`ele a ´et´e valid´e exp´erimentalement sur des sc´enarios acoustiques naturels montrant ainsi une bonne corr´elation avec le jugement humain et permettant de pr´edire la d´etectabilit´e des sons saillants incorpor´es dans un milieu bruit´e, avec un temps de calcul assez faible.

1.6.2

Mod`

ele de Tsuchida et al.

Au lieu de transformer le paradigme visuel propos´e par Itti dans le domaine auditif, comme le fait Kayser [35], Tsuchida et al. ont propos´e un mod`ele de saillance auditive nomm´e ASUN (Auditory Saliency Using Natural Statistics) [36], inspir´e du mod`ele de saillance visuelle SUN de Zhang [24]. Tout d’abord, le signal audio d’entr´ee (´echantillonn´e `a 16 kHz) est converti en un signal spectral dans le domaine des fr´equences (cochleagrams) en utilisant un banc de filtres de Gammatone (200-8000 Hz), liss´e par une convolution avec une fenˆetre de Han-ning de 1 msec et sous-´echantillonn´e `a 1 kHz afin d’obtenir une d´ecomposition fr´equentielle en 64 dimensions du signal d’entr´ee. Puis, cette repr´esentation est divis´ee en 20 bandes de fr´equence. Finalement, une analyse en composantes ind´ependantes est calcul´ee pour chacune de ces 20 bandes s´epar´ement, comme le montre la figure 1.12. La saillance `a tout point est bas´ee sur la raret´e des r´eponses auditives `a ce point (la nouveaut´e attire l’attention).

Sur les mˆemes bases d’´etudes, ce mod`ele pr´esente des performances meilleures (M = 0.3262, SD = 0.0635) que celles obtenues par le mod`ele de Kayser (M = 0.0362, SD = 0.0683). Toutefois, la complexit´e calculatoire est un point faible du mod`ele, surtout pour son usage dans des applications en temps r´eel.

D’autres mod`eles de saillance auditive ont ´et´e d´evelopp´es pour des applications parti-culi`eres : pour la d´etection des paroles [37] ou pour l’analyse des sc`enes bruit´ees [38]. Un mod`ele de saillance auditive bas´e sur un algorithme de s´eparation de l’´energie discr`ete (Dis-crete Energy Separation Algorithm, DESA) a ´et´e propos´e dans [39]. Il permet la s´eparation de la parole et de la musique `a partir d’un flux audio m´elang´e. R´ecemment, ce mod`ele a ´et´e

uti-1.6. Saillance auditive

Figure 1.11 – (A) Architecture globale du mod`ele de Kayser et al. [35], (B) Spectogramme des bulles d’eau dans un environnement bruit´e et sa carte de saillance correspondante. Image extraite de [35]

![Figure 1.3 – Fonction de sensibilit´e au contraste normalis´ee pour les voies de chrominance et de luminance (Image extraite de [9]).](https://thumb-eu.123doks.com/thumbv2/123doknet/7899498.264515/24.918.171.764.560.798/figure-fonction-sensibilit-contraste-normalis-chrominance-luminance-extraite.webp)

![Figure 1.8 – Mod`ele de saillance spatio-temporel de Le Meur et al.[18].](https://thumb-eu.123doks.com/thumbv2/123doknet/7899498.264515/33.918.165.767.265.894/figure-mod-ele-saillance-spatio-temporel-meur-al.webp)

![Figure 1.9 – Mod`ele de saillance spatio-temporel de Marat et al. [19].](https://thumb-eu.123doks.com/thumbv2/123doknet/7899498.264515/35.918.204.706.232.910/figure-mod-ele-saillance-spatio-temporel-marat-al.webp)

![Figure 1.13 – Architecture du mod`ele audiovisuel de Ruesch et al. [44].](https://thumb-eu.123doks.com/thumbv2/123doknet/7899498.264515/42.918.291.629.117.504/figure-architecture-mod-ele-audiovisuel-de-ruesch-et.webp)

![Figure 2.1 – Les fixations des participants pour diff´erents sc´enarii mis en œuvre dans [57].](https://thumb-eu.123doks.com/thumbv2/123doknet/7899498.264515/46.918.134.782.408.648/figure-fixations-participants-diff-erents-enarii-mis-œuvre.webp)