HAL Id: hal-03023940

https://hal.uca.fr/hal-03023940

Submitted on 25 Nov 2020

HAL is a multi-disciplinary open access

archive for the deposit and dissemination of

sci-entific research documents, whether they are

pub-lished or not. The documents may come from

teaching and research institutions in France or

abroad, or from public or private research centers.

L’archive ouverte pluridisciplinaire HAL, est

destinée au dépôt et à la diffusion de documents

scientifiques de niveau recherche, publiés ou non,

émanant des établissements d’enseignement et de

recherche français ou étrangers, des laboratoires

publics ou privés.

Distributed under a Creative Commons Attribution| 4.0 International License

Reconstruction Planaire de Zone Carrossable de Route

Laurent Delobel, Thierry Chateau, Eric Royer, Francois Marmoiton

To cite this version:

Laurent Delobel, Thierry Chateau, Eric Royer, Francois Marmoiton. Reconstruction Planaire de Zone

Carrossable de Route. RFIA, Jun 2020, Vannes, France. �hal-03023940�

Reconstruction Planaire

de Zone Carrossable de Route

Laurent DELOBEL

Institut PASCAL Universit´e Clermont-Auvergne Aubi`ere, France laurent.delobel@uca.frThierry CHATEAU

Institut PASCAL Universit´e Clermont-Auvergne Aubi`ere, France thierry.chateau@uca.frEric ROYER

Institut PASCAL Universit´e Clermont-Auvergne Aubi`ere, France eric.royer@uca.frFranc¸ois MARMOITON

Institut PASCAL Universit´e Clermont-Auvergne Aubi`ere, France francois.marmoiton@uca.frAbstract—Nous pr´esentons une m´ethode d’estimation d’un mod`ele 3D planaire de la route `a partir de capteurs de vision embarqu´es sur un v´ehicule. L’objectif est d’aller vers une automatisation de la d´etermination de l’espace navigable 3D dans les applications de v´ehicules autonomes. Nous proposons les contributions suivantes : 1) une combinaison de mod`eles g´eom´etriques et d’analyse vid´eo par r´eseaux de neurones pro-fonds pour extraire un ensemble de points ´epars et les filtrer pour conserver ceux dont le label s´emantique pr´esente une forte probabilit´e d’appartenir `a la route, et 2) une base de donn´ees de type position de route g´eo-r´ef´erenc´ee (OpenStreetMap) servant de r´ealit´e terrain pour une premi`ere validation de la m´ethode.

Index Terms—SLAM, Segmentation s´emantique, SPPNet, re-construction 3D

I. INTRODUCTION

La conduite autonome est un champ de recherche partic-uli`erement actif et qui n´ecessite, pour la plupart des applica-tions, l’utilisation d’une carte d´efinissant les voies navigables. Des approches comme [1] se d´ecomposent en deux phases : 1) un premier passage est r´ealis´e sur la trajectoire `a rejouer. Une phase d’apprentissage construit alors un mod`ele 3D bas´e capteur et 2) un asservissement du v´ehicule le long de cette trajectoire `a partir d’une localisation temps r´eelle dans la carte bas´e capteur. Cette strat´egie garantit, dans l’hypoth`ese o`u le guidage poss`ede une pr´ecision correcte, que la navigation s’op`ere sur une voie carrossable et autoris´ee (si la phase manuelle 1 respecte ces condition). L’ajout d’un module d’´evitement d’obstacle impose de g´en´erer des trajectoires s’´eloignant de celle apprise et n´ecessite donc de connaˆıtre les limites de la zone sur laquelle le v´ehicule peut naviguer.

Dans ce document, nous proposons une technique de re-construction 2D/3D de la structure de la chauss´ee carrossable des routes. Ce mod`ele servirait alors de zone sur laquelle le v´ehicule peut naviguer. L’objectif `a terme est ´egalement de d´evelopper un syst`eme, permettant `a partir d’images acquises `a partir de v´ehicules (autonomes ou non), de construire une carte g´eom´etrique et s´emantique de l’environnement.

Les principales contributions sont :

• La combinaison d’un mod`ele g´eom´etrique avec un r´eseau de segmentation s´emantique,

• La construction d’une base de donn´ees et une validation qualitative de la m´ethode propos´ee.

Donn´ees V´ehicule Reconstruction SLAM 3D Segmentation S´emantique Vote Points de la Route Extraction Plan de Route Projection Segmentation sur la Route

Fig. 1. Description de la m´ethode.

Le mod`ele g´eom´etrique est issu d’une technique de recon-struction de type SLAM visuel. Celle-ci permet de reconstruire un mod`ele 3D avec un facteur d’´echelle proche de 1.

Apr`es cette introduction, La deuxi`eme section dresse un ´etat de l’art de la probl´ematique abord´ee. La m´ethode propos´ee est pr´esent´ee dans une troisi`eme section. La quatri`eme section d´ecrit la base de donn´ees acquise et les exp´erimentations r´ealis´ees pour quantifier les performances de la m´ethode.

II. TRAVAUX ANTERIEURS´

Historiquement, les premiers travaux li´es `a la d´etection de bords de route utilisent des capteurs LIDAR. Certains travaux utilisent un capteur LIDAR mononappe plan 2D, que l’on positionne dans un plan vertical, ce dernier pivotant sur un axe vertical. Utilisant un tel montage, on parvient `a identifier les murs verticaux ainsi que le sol.

Plus r´ecemment, des techniques op´erant des LIDARs 3D multi-nappes ont ´et´e utilis´ees afin d’extraire ces informations ( [2], [3], [4]). Plusieurs nappes LIDAR orient´ees par ´el´evation croissante permettent d’identifier, soit par rayon d’impact croissant, soit par azimuth croissant (en valeur absolue par rapport au cap v´ehicule), la position des bords de chauss´ee. L’´el´evation z varie en effet de mani`ere discr`ete dans ce cas, entre la zone chauss´ee et la zone trottoir. Des couplages avec des donn´ees LIDAR g´eom´etriques, et vision (r´eflectance LIDAR, ou image cam´era) ont ´egalement ´et´e r´ealis´es ( [4], [5]).

Le couplage de segmentation s´emantique utilisant des im-ages couleur, avec des donn´ees g´eom´etriques permettrait de g´en´eraliser ce proc´ed´e. En effet, les m´ethodes param´etriques g´eom´etriques LIDAR peuvent ´echouer dans certains cas:

• en cas de ”bateau” (la hauteur trottoir rejoint celle de la

route `a la limite)

• dans le cas o`u le trottoir est mat´erialis´e par un trac´e au sol (marquage au sol)

• lorsque la route est sinueuse, ou que sa plan´eit´e est mise en d´efaut,

• en cas d’accotement.

Le cas des voies pi´etonnes est ´egalement `a traiter, dans des cas exceptionnels il s’entend.

Les m´ethodes g´eom´etriques peinent car ces environ-nements ne sont pas suffisamment structur´es. La segmentation s´emantique d’images par des techniques d’apprentissage per-met de mieux prendre en compte ces situations, dans le sens o`u des mod`eles complexes peuvent ˆetre entraˆın´es. Il s’agit alors d’avoir `a disposition une base de donn´ees annot´ee expliquant le plus de variabilit´e possible.

Il existent de nombreux travaux en segmentation s´emantique bas´ee apprentissage et utilisant des jeux des donn´ees issues du domaine automobile ( [6], [7], [8]). Ces m´ethodes sont prin-cipalement bas´ees sur des structures de r´eseaux de neurones profonds convolutifs (DCNN).

III. M ´ETHODEPROPOSEE´

Nous proposons d’utiliser conjointement des mod`eles g´eom´etriques de reconstruction d’environnement 3D et de navigation bas´e cam´era, et des mod`ele bas´es apprentissage de segmentation s´emantique d’images couleur, dans le but d’identifier les bords de voies de circulation pour des v´ehicules autonomes.

La chaˆıne de traitement se d´ecompose en quatre parties :

• reconstruction d’une carte ´eparse de points 3D `a l’´echelle

`a partir d’un SLAM visuel (multi-cam´eras) aid´e par l’utilisation d’odom`etres,

• segmentation s´emantique des images afin d’extraire

l’ensemble des pixels appartenant aux zones de route,

• identification robuste, pour chaque image, du plan 3D local de la route,

• reprojection sur le plan de la route des zones d’image labellis´ees ROUTE.

Le but est d’obtenir un mod`ele 3D de la route sous forme d’un ensemble de polygones en 3 dimensions. Ces polygones 3D pourront avoir des plans, des normales associ´ees diff´erentes et ne repr´esenteront qu’une autre mani`ere de reconstruire la route. Cette mani`ere de reconstrure est de plus haute s´emantique en ce sens que les primitives sont de plus haute dimensionalit´e.

A. Construction d’une carte ´eparse bas´ee SLAM

Nous utilisons la m´ethode de reconstruction visuelle 3D bas´ee sur cam´eras d´ecrite dans ( [9], [10]), et qui reconstruit, `a partir d’une ou plusieurs cam´eras calibr´ees une carte 3D de l’environnement. Les odom`etres du v´ehicule sont ´egalement pris en compte.

La carte ainsi g´en´er´ee contient:

• un raffinement des param`etres de calibration intrins`eque et extrins`eque des cam´eras utilis´ees,

Fig. 2. La zone segment´ee route (en vert), et les autres cat´egories (rouge). Noter entre les deux zones l’existence d’un glacis (identification ind´etermin´ee).

• la liste des points 3D identifi´es dans un rep`ere li´e `a la pose courante,

• pour chaque pose/image cl´e: – la pose de chaque cam´era,

– pour chaque cam´era et pose associ´ee, la liste des points 3D vus, ainsi que leurs coordonn´ees 2D dans l’image.

B. Segmentation S´emantique

Nous utilisons la segmentation s´emantique d´ecrite dans [6], avec un r´eseau de type SSPNet. Les param`etres utilis´es sont les param`etres officiels TensorFlow publi´es pour le dataset CityScape.

Comme nous utiliserons ce r´eseau sur une base diff´erente de celle sur lequel il a ´et´e entraˆın´e, les performances seront moindres `a cause du changement de domaine. Nous proposons d’introduire une notion d’incertitude li´ee aux mesures issues de la segmentation afin de d´efinir une notion de facteur de s´ecurit´e li´e `a la classe associ´ee `a un pixel. On d´efinit pour chaque pixel de l’image:

OutClass = arg max

class i

ResultVector[i] (1)

Nous avons pr´ef´er´e prendre une marge de s´ecurit´e sur le r´esultat de retour, en exigeant que pour la classe choisie (route), la diff´erence entre sa r´eponse et le maximum des autres classes soit sup´erieur `a une valeur positive, que nous nommons L.

OutClass = Road ssi arg max

class i6=Road

ResultVector[i] + L ≤ ResultVector[Road] (2) Dans ce cas, on prend une marge de s´ecurit´e en terme de r´eponse pour ´eviter toutes les zones dans lesquelles le maximum de r´eponses des classes est mal d´efini. Cela permet d’´eviter d’utiliser des portions de l’image dans lesquelles la cat´egorisation des pixels n’est pas certaine.

Un exemple d’une segmentation prenant en compte un facteur de s´ecurit´e est visible sur la figure 2.

C. Estimation du Plan M´edian de la Route

Les donn´ees contenues dans la carte g´en´er´ee sont une liste de points en 3 dimensions. Afin de d´efinir la projection de la zone segment´ee, il faut d´efinir une portion localement plane associ´ee `a la route. Certains a-prioris ont ´et´e pris:

• la route est, sur une ´echelle de quelques m`etres locale-ment plane,

• le v´ehicule circule toujours sur la route,

• les cam´eras sont toujours capables d’observer la route. Dans ce cas, nous proposons de fitter un plan sur un patch de quelques m`etres autour de la position de passage d’un v´ehicule. Ce plan est ensuite utilis´e pour filtrer des points du patch, et conserver uniquement ceux qui appartiennent `a la route. Il suffit alors d’estimer, par une m´ethode robuste, le plan qui passe au mieux par ces points. Nous proposons un fit par moindres carr´es m´edians, en utilisant une technique de tirage al´eatoire (du type RANSAC).

Afin de ne prendre pour la d´etermination du plan de la route que des points 3D ayant une probabilit´e raisonnable d’y appartenir, un filtrage par vote est effectu´e:

• pour chaque image 2D couleur (capture), on identifie la zone vue comme route,

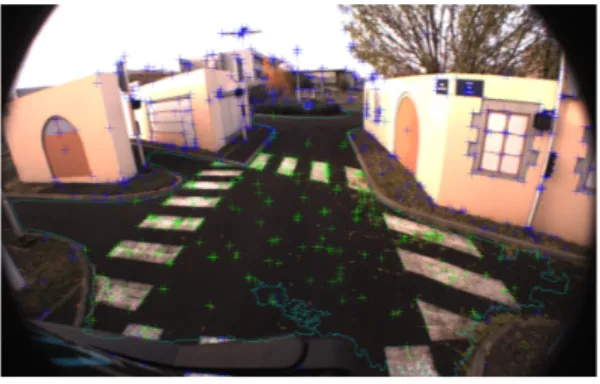

• pour chacun des points appartenant `a la capture (voir figure 3):

– si les coordonn´ees 2D du points captur´e sont incluses dans la zone segment´ee route de l’image cam´era, on incr´emente le vote route ainsi que le nombre de vues, – dans le cas contraire, on incr´emente le nombre de

vues du point, en laissant inchang´e son vote

• lorsque toutes les vues cam´era ont ´et´e analys´ees, chaque point est cat´egoris´e:

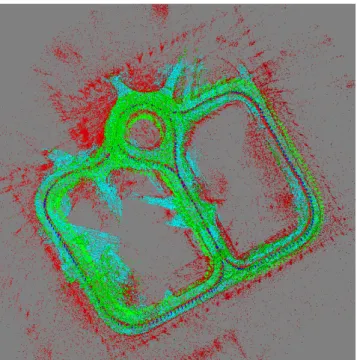

– lorsque le nombre de vote route d´epasse 50% du nombre de vues du point, celui-ci est cat´egoris´e ”ROUTE” (points verts sur la figure 4),

– dans le cas contraire, il est cat´egoris´e ”AUTRE” (points rouges sur la figure 4).

Chaque zone segment´ee comme zone de route `a partir de l’image cam´era couleur est par la suite g´er´ee comme un polygone dont les sommets sont extraits par la proc´edure de segmentation. Ces polygones sont bidimensionnels (dans le plan focal cam´era).

Ensuite, pour chaque pose v´ehicule, on interpole le plan de route locale ainsi:

• un patch de D × D m`etres autour de la position du v´ehicule est s´electionn´e,

• les points cat´egoris´es route et appartenant `a ce patch sont utilis´es,

• un fit moindres-carr´es-m´edians randomis´e sur l’´equation du plan de la route (un point du plan, barycentre par exemple, plus une normale unitaire) est r´ealis´e bas´es sur ces points; le nombre de tirages al´eatoires de s´equences de points utilis´e est donn´e comme N (voir [11]). D. Projection de la zone Route

`

A cette ´etape, nous disposons:

Fig. 3. Image des points identifi´es comme appartenant `a la route (croix vertes) `a partir de la vue cam´era. Les points bleu n’y appartiennent pas.

Fig. 4. Points 3D (en vert) `a vote majoritaire comme route. Les points rejet´es sont en rouge. Les polygones de route en 3D sont dessin´es en cyan. Le tri`edre route (axe z en couleur bleue) correspond au passage du v´ehicule et constitue la trajectoire au sol de ce dernier.

• des patchs locaux des plans de route,

• des zones reconnues comme segment´ees (dans les

im-ages)

Le but de cette ´etape consiste `a apparier une vue cam´era avec un plan de route suffisamment proche, observable di-rectement. L’id´ee est alors de choisir une correspondance entre chaque vue cam´era dont on a extrait la zone segment´ee comme route, et un plan de route correspondant. Puis, une fois cette correspondance trouv´ee, on projette le polygone route segment´e sur ce plan par un proc´ed´e de type cam´era projective.

´

Etant donn´e que nous avons ´equip´e notre v´ehicule avec une paire de cam´eras st´er´eo `a l’avant du v´ehicule (le v´ehicule se d´eplac¸ant vers l’avant), nous allons commencer `a partir d’une position ant´erieure et avancer au fur et `a mesure jusqu’`a trouver le centre du patch route le plus proche du centre optique des cam´eras.

Le polygone entourant la zone d´elimit´ee comme route dans l’image couleur est alors projet´e par un proc´ed´e de type projection centrale par rapport `a la position cam´era, sur le plan de route identifi´e. Afin de ne pas cr´eer de points projet´es vers l’arri`ere de la cam´era (ce qui est typique d’un mod`ele projectif au-del`a de la ligne d’horizon du plan route dans l’image), nous limitons en position Y (haut) l’extension du polygone de route reconstruit. On peut observer sur la figure 5 le r´esultat d’une telle reconstruction.

Fig. 5. Superposition des polygones segment´es comme route (en bleu), avec le bords des trottoirs (en rouge) en vue de dessus. Carte orient´ee NORD vers le haut.

E. Accumulation des Polygones en Vue 2D

Les polygones reconstruits permettent une visualisation 3D de la carte ainsi que de la route reconstruite. Une vue plus int´eressante consiste `a accumuler les polygones de bord de route en vue 2D.

Nous utilisons comme rep`ere de r´ef´erence le rep`ere de d´epart du v´ehicule `a l’initialisation. Nous amenons chaque polygone 3D dans le rep`ere en question, puis le projetons sur le plan XY. L’affichage des polygones est r´ealis´e en accumulation (plus le nombre de polygones est important, plus la couleur sera marqu´ee).

IV. EXPERIMENTATIONS´

Dans cette section, nous pr´esentons les r´esultats obtenus dans le cadre de la reconstruction s´emantique de bord de route. A. ´Equipements et Donn´ees Utilis´ees

Les exp´erimentations ont ´et´e r´ealis´ees `a partir de donn´ees acquises sur le site d’exp´erimentation PAVIN1, en utilisant

un enregistrement des donn´ees capteur `a bord d’un v´ehicule EZ10 (voir figure 6). Le v´ehicule EZ10 est ´equip´e entre autres capteurs:

• de deux cam´eras Noir et blanc de r´esolution 640 × 480

(une `a l’avant, l’autre `a l’arri`ere du v´ehicule) op´erant `a une fr´equence de 10 Hz,

• de deux cam´eras couleur (type Bayer) de r´esolution 1920 × 1200, op´erant ´equalement `a 10 Hz (mais non-synchronis´ees avec les pr´ec´edentes),

• de capteurs d’odom´etrie int´egr´es au v´ehicule (bus CAN),

• d’un capteur de type GPS (UBLOX6T).

Ce v´ehicule utilise l’intergiciel Robot Operating Sys-tem (ROS), commun en robotique. Une des nombreuses fonctionnalit´es de ce type d’environnement est de permettre l’enregistrement des donn´ees capteurs sous un format universel 1Plateforme d’Auvergne pour les V´ehicules INtelligents, simulant un

environnement urbain `a ´echelle 0.5.

Fig. 6. V´ehicule exp´erimental EZ10. Deux cam´eras global-shutter couleur de type GS3-U3-23S6C, d’une r´esolution 1920 par 1200 pixels sont mont´ees en paire st´er´eo sur le toit `a l’avant du v´ehicule.

permettant leur r´e-utilisation par toute application utilisant l’envirionnement ROS.

Les donn´ees acquises par les capteurs ont ´et´e stock´ees dans un fichier de type ROSbag permettant la r´eutilisation des donn´ees. Nous avons travaill´e `a partir d’un fichier ROSbag issu d’une trajectoire en S, comprenant des images de vues st´er´eo couleur 24 bits au format 1920 × 1200, synchronis´ees `a 10 ms et acquises `a une fr´equence de 10 Hz. La dur´ee de la trajectoire est de 3 minutes.

Des acquisitions LIDAR 3D partielles du site d’exp´erimentation ont ´et´e acquises, mais n’ont actuellement pas encore ´et´e exploit´ees (travaux futurs). Celles-ci contiennent des nuages de points 3D au format Lambert– RGF93 munis d’une altitude. Nos analyses n’ont exploit´e pour l’instant que l’information visuelle.

B. Mode Op´eratoire

Le mode op´eratoire appliqu´e est le suivant:

• calibration de la paire cam´era st´er´eo couleur par SLAM

sur une trajectoire ferm´ee et auto-´etalonnage apr`es une fermeture de boucle ( [12]),

• extraction des images couleurs (fichier ROSbag) et

seg-mentation s´emantique,

• ex´ecution de notre analyse de reconstruction de bords de voie (carte 3D) `a partir des donn´ees pr´ec´edemment g´en´er´ees,

• aplanissement 2D horizontal et extraction des bords de route du jeu de donn´ees.

La calibration de la paire st´er´eo avant du jeu de donn´ees a ´et´e r´ealis´ee it´erativement par optimisation globale r´ep´et´ee, et utilise le mˆeme jeu de donn´ees que la reconstruction. Les param`etres du SLAM sont r´egl´es pour avoir un grand nombre de points d’int´erˆet (5 fois plus que ce que nous utilisons habituellement pour la navigation autonome) de fac¸on `a avoir suffisament de points d´etect´es sur la route.

La trajectoire utilis´ee fait une longueur

d’approximativement 200 m`etres et g´en`ere un peu plus de 170 000 points dans la carte. Cette carte induit des d´erives au niveau du parcours. Nous tentons de limiter celles-ci en utilisant des trajectoires re-bouclant sur elles-mˆemes, et nous

Fig. 7. Vue de dessus d’une reconstruction 3D de la route sur note site d’exp´erimentation PAVIN, carte orient´ee NORD vers le haut.

op´erons une optimisation ult´erieure (´egalement hors-ligne) sur les poses compatibles (fermeture de boucle).

Les segmentations de zone de route ont ´et´e r´ealis´ees de mani`ere d´eport´ee sur un cluster GPU de notre m´eso-centre de calcul CRRI-UCA et rapatri´ees en local.

C. R´esultats Obtenus

On peut voir sur la figure 7 la reconstruction des routes principales de note site d’exp´erimentation PAVIN. Ceci est `a comparer `a la carte de reconstruction bidimentionnelle 5.

Les tri`edres au niveau de l’orientation de la route mat´erialisent le passage du v´ehicule au niveau de la route (vecteur Z normal vers le haut par rapport `a la route, vecteur X dans le sens de parcours).

Nous avons manuellement align´e les donn´ees de la carte g´eom´etrique SLAM avec la carte des bords de trottoirs avec une erreur sur le facteur d’´echelle de l’ordre de 1% .

Nous avons de mˆeme manuellement align´e nos donn´ees de polygones de zone route avec la mˆeme base de donn´ees, voir figure 5, et, hormis la reconstruction de la zone circulaire au-tour du rond-point, l’alignement (sans changement de facteur d’´echelle) s’av`ere satisfaisant moyennant une tol´erance de 1 % ´egalement.

On remarque sur les figures 5 et 7:

• sur la portion OUEST du site reconstruit la segmentation s´emantique d´eborde nettement sur la zone non-carossable,

• la statistique de polygones de segmentation est faible sur la route cˆot´e EST (taux ´echecs de segmentation important des images droite et gauche simultan´e).

Le premier point est assez ais´ement mis en ´evidence sur une image de segmentation op´er´ee dans cette zone, pr´esent´ee

Fig. 8. Exemple d’une segmentation d´ebordant au-del`a du trac´e de la route (sur le cˆot´e gauche de la route, remarquer les points narqu´es en vert sur le terre-plein).

Fig. 9. Vue par la tranche de la pente descendante allant du rond-point vers l’entr´ee pi´eton (gauche de l’image).

sur la figure 8. Il s’agit d’un cas o`u la segmentation ´echoue. Il est possible que les ´echecs de ce type soient attribuables aux conditions d’´eclairages de la sc`ene tout comme le rendu colorim´etrique sur les cam´eras. Un apprentissage sp´ecifique permettrait sans doute d’am´eliorer ces r´esultats, tout comme le choix d’un autre r´eseau de segmentation.

Le second item, quant `a lui, est reli´e `a des r´esultats de segmentation inutilisables (la totalit´e de l’image class´ee dans une seule classe).

On notera que la technique que nous proposons est capable de reconstruire la structure 3D (incluant la pente et l’altitude) le la portion de route g´en´er´ee. Sur la figure 9, on observe, vue depuis le NORD, la structure EST–OUEST v.s. altitude de notre site d’exp´erimentation.

Une branche apparaˆıt en pente descendante en allant vers la gauche de la vue (portion allant du rond-point vers l’EST, en pente descendante). Une autre (cˆot´e SUD du site, allant ´egalement vers l’EST), est quasiment horizontale. On est donc capable de reconstruire la d´eclivit´e d’une sc`ene `a partir de donn´ees visuelles acquises sur v´ehicule.

D. Test Manuel sur des donn´ees KITTI

Afin de pouvoir valider notre extraction de zones carross-ables, nous avons utilis´e le dataset num´erot´e 00 du dataset KITTY, sous-base de donn´ees ODOMETRY [13].

La comparaison a ´et´e r´ealis´ee `a partir de donn´ees g´eor´ef´erenc´ees de mani`ere absolue dans la base de donn´ees OpenStreetMap [14].

Grˆace aux images de ce jeu de donn´ees 00, nous avons identifi´e de mani`ere manuelle la zone dans laquelle les donn´ees ont ´et´e extraites (il s’agit de Weinerfeld, dans la banlieue de Karlsruhe). Une extraction de la base de donn´ees

Open-Fig. 10. Extraction des rues de Weinerfeld, dans la banlieue de Karlsruhe.

Fig. 11. Alignement des donn´ees entre la base de donn´ees absolue Open-StreetMap, et notre reconstruction de route (recouvrement en rose). Noter que les rues provenant de la base de donn´ees OSM sont fortement ´elargies afin de de prendre en compte les potentielles erreurs locales.

StreetMap nous a permis de reconstruire les zones de route utilises pour l’acquisition des donn´ees (voir la figure 10).

Une reconstruction de route a ´et´e men´ee sur un peu plus de la moiti´e du jeu de donn´ees. Sur une partie non-n´egligeable, la segmentation ´echoue, de ce fait, une partie d’une longue rue n’apparait pas dans les donn´ees. Apr`es avoir ´elargi les segments de rue obtenus d’OpenStreetMap, nous les avons align´es selon une transform´ee de Fourier-Mellin (voir [15]) avec la reconstruction r´ealis´ee. La superposition des deux zones est indiqu´ee en vert sur la figure 11. Le facteur d’´echelle est ´egalement correct `a 1 % pr`es.

CONCLUSION

Nous proposons une m´ethode multi-techniques permettant, `a partir de donn´ees v´ehicule, d’une reconstruction g´eom´etrique, ainsi que d’une op´eration de segmentation s´emantique bas´ee sur un r´eseau convolutionnel, de reconstruire une zone carross-able de route. Certains bords de route peuvent ˆetre identifi´es de mani`ere correcte, en partie en raison de r´esultats erron´es

de l’algorithme de segmentation choisi. Malgr´e les limites de l’algorithme de segmentation utilis´e, nous pensons qu’avec l’am´elioration de qualit´e et de temps de calcul de ces tech-niques, ces r´esultats sont `a mˆeme d’ˆetre am´elior´es `a l’avenir. Une validation par alignement sur des donn´ees 3D de type m´etrologie (acquisitions LIDAR mentionn´ees en IV-A) fait ´egalement partie des travaux futurs.

REMERCIEMENTS

Ces travaux ont ´et´e financ´es par le programme de recherche ”Investissements d’Avenir” et l’Agence Nationale de la Recherche, `a travers le laboratoire d’excellence IMobS3 (ANR-10-LABX-16-01). Les calculs ont ´et´e effectu´es sur les ressources du M´esocentre Clermont Auvergne.

REFERENCES

[1] E. Royer, M. Lhuillier, M. Dhome, and T. Chateau, “Localization in urban environments : monocular vision compared to a differential gps sensor,” in IEEE CVPR, Computer Vision and Pattern Recognition, (San Diego, USA), jun 2005.

[2] F. Ghallabi, F. Nashashibi, G. El-Haj-Shhade, and M.-A. Mittet, “Lidar-based lane marking detection for vehicle positioning in an hd map,” in 2018 21st International Conference on Intelligent Transportation Systems (ITSC), pp. 2209–2214, IEEE, 2018.

[3] A. Y. Hata, F. S. Osorio, and D. F. Wolf, “Robust curb detection and vehicle localization in urban environments,” in 2014 IEEE Intelligent Vehicles Symposium Proceedings, pp. 1257–1262, IEEE, 2014. [4] C. Fern´andez, D. F. Llorca, C. Stiller, and M. Sotelo, “Curvature-based

curb detection method in urban environments using stereo and laser,” in 2015 IEEE Intelligent Vehicles Symposium (IV), pp. 579–584, IEEE, 2015.

[5] A. Hata and D. Wolf, “Road marking detection using lidar reflective intensity data and its application to vehicle localization,” in 17th International IEEE Conference on Intelligent Transportation Systems (ITSC), pp. 584–589, IEEE, 2014.

[6] B. Hariharan, P. Arbel´aez, R. Girshick, and J. Malik, “Simultaneous detection and segmentation,” in European Conference on Computer Vision, pp. 297–312, Springer, 2014.

[7] H. Zhao, X. Qi, X. Shen, J. Shi, and J. Jia, “Icnet for real-time semantic segmentation on high-resolution images,” in Proceedings of the European Conference on Computer Vision (ECCV), pp. 405–420, 2018.

[8] R. P. Poudel, S. Liwicki, and R. Cipolla, “Fast-scnn: fast semantic segmentation network,” arXiv preprint arXiv:1902.04502, 2019. [9] E. Royer, J. Bom, M. Dhome, B. Thuilot, M. Lhuillier, and F.

Mar-moiton, “Outdoor autonomous navigation using monocular vision,” in 2005 IEEE/RSJ International Conference on Intelligent Robots and Systems, pp. 1253–1258, IEEE, 2005.

[10] E. Royer, Cartographie 3D et localisation par vision monoculaire pour la navigation autonome d’un robot mobile. PhD thesis, 2006. [11] H. Barreto and D. Maharry, “Least median of squares and regression

through the origin,” Computational statistics & data analysis, vol. 50, no. 6, pp. 1391–1397, 2006.

[12] P. L´ebraly, E. Royer, O. Ait-Aider, C. Deymier, and M. Dhome, “Fast calibration of embedded non-overlapping cameras,” 2011 IEEE International Conference on Robotics and Automation, pp. 221–227, 2011.

[13] A. Geiger, P. Lenz, and R. Urtasun, “Are we ready for autonomous driving? the kitti vision benchmark suite,” in Conference on Computer Vision and Pattern Recognition (CVPR), 2012.

[14] OpenStreetMap contributors, “Planet dump retrieved from https://planet.osm.org .” https://www.openstreetmap.org , 2017. [15] O. Fourt, R. Rouveure, and P. Faure, “Odometry with a panoramic

radar in outdoor environment: use of a radon-fourier transform for the estimation of the move without external sensors,” International Journal of Signal Processing, Image Processing and Pattern Recognition, vol. 7, no. 2, pp. 35–50, 2014.