Réorganisation cérébrale et perception de la parole chez

les aveugles congénitaux : études comportementales et

par IRM fonctionnelle

Laureline ArnaudDoctor of Philosophy

Integrated Program in Neuroscience McGill University

Montreal, QC

December 2017

A thesis submitted to McGill University in partial fulfillment of the requirements of the degree of Doctor of Philosophy

Table des matières

Table des matières... i

Résumé ... viii

Abstract ... x

Remerciements ... xiii

Préface et contribution des auteurs ... xvi

Liste des figures ... xviii

Liste des tables... xxiv

Liste des sigles et abréviations ... xxviii

Préambule ... 1

Chapitre 1 - Revue de la littérature... 3

1.1. Décodage spectro-temporel de la parole chez les aveugles congénitaux ... 3

1.1.1. Rôle de la vision dans l’acquisition et la perception de la parole ... 3

1.1.2. Capacités de discrimination spectro-temporelle des sons chez les aveugles ... 6

Discrimination de sons purs et de mélodies ... 6

Discrimination de sons de parole ... 8

1.1.3. Impact du domaine et de la familiarité des stimuli ... 9

1.1.4. Test adaptatif et évaluation des seuils différentiels fréquentiels ... 10

Evaluation des seuils différentiels fréquentiels... 11

Impact de l’expérience musicale sur les seuils différentiels fréquentiels ... 14

1.2. Corrélats neurofonctionnels de la perception de la parole chez les aveugles congénitaux ... 18

1.2.1. Rôle des aires « visuelles » chez les aveugles congénitaux ... 18

1.2.2. Réseaux de perception de la parole chez les aveugles congénitaux ... 22

1.2.3. Plasticité et supériorité à l'échelle comportementale ... 28

1.3. Effets de répétition en IRMf ... 29

1.3.1. Adaptation IRMf et facilitation comportementale ... 30

1.3.2. Modèles sous-jacents ... 31

Répétition-Suppression ... 31

1.3.3. Répétition-Suppression chez les Aveugles ... 34

Objectifs de recherche ... 37

Études 1 et 2 : Décodage acoustique de la parole ... 37

Étude 3 : Mécanismes neuronaux associés aux différences de perception de la parole ... 39

Chapitre 2 – Article 1: Frequency-change identification abilities for native speech, foreign speech and music sounds of amateur musicians and non-musicians ... 41

Préface ... 41

Frequency-change identification abilities for native speech, foreign speech and music sounds of amateur musicians and non-musicians ... 41

Corresponding author ... 42

Abstract ... 42

Keywords... 43

Abbreviations ... 43

2.1. Introduction ... 43

2.2. Experiment 1 - Vowel Identification and Rating... 49

2.2.1. Methods ... 49

Participants ... 49

Corpus creation ... 49

Procedure: Vowel Identification and Rating ... 52

2.2.2. Results ... 53

Vowel identification and rating ... 53

Selection of native and non-native stimuli... 55

2.3. Experiment 2 - F0 direction identification ... 55

2.3.1. Methods ... 55

Participants ... 56

Corpus creation ... 56

Adaptive procedure: estimation of FDL/F0DL for pitch direction identification ... 57

Note on the control of level ... 59

Analyses ... 60

2.3.2. Results ... 61

Correlation between the scores ... 64

Effect of level and F0 directions on F0 direction identification accuracy in musicians and non-musicians ... 65

Correlation with number of years of training ... 66

2.4. Discussion ... 67

2.4.1. Better pitch processing abilities in musicians ... 68

2.4.2. A generalized advantage ... 69

2.4.3. No effect of familiarity on vowel FDLs ... 70

2.4.4. Better thresholds for music over speech stimuli ... 71

2.4.5. Conclusion ... 73

2.5. Appendix ... 73

2.6. Declaration of Interest ... 75

2.7. Acknowledgements ... 75

Chapitre 3 – Article 2 : Enhanced Perception of Pitch Changes in Speech and Music in Early Blind Adults ... 76

Préface ... 76

Enhanced Perception of Pitch Changes in Speech and Music in Early Blind Adults ... 77

Corresponding author ... 77 Abstract ... 77 Highlights ... 78 Keywords... 78 Abbreviations ... 79 3.1. Introduction ... 79

3.2. Experiment 1 – Vowel identification and rating ... 82

3.2.1. Methods ... 82 Participants ... 82 Experimental design... 82 Corpus creation ... 83 Stimuli ... 83 Procedure ... 84 Analyses ... 85

3.2.2. Results ... 85

Vowel identification and quality rating ... 85

Selection of native and non-native stimuli... 87

3.3. Experiment 2 - Pitch-direction identification task ... 89

3.3.1. Methods ... 89

Stimuli ... 89

Adaptive procedure ... 90

Analyses ... 92

3.3.2. Results ... 92

Pitch-direction identification task ... 92

Correlation between the scores ... 96

Effect of intensity and pitch directions on pitch direction identification accuracy ... 98

3.4. Discussion ... 99

3.4.1. Enhanced Processing in the Congenitally Blind... 100

3.4.2. Pitch perception processes ... 102

3.5. Supplemental material ... 105

3.6. Acknowledgements ... 106

Chapitre 4 – Article 3 : Neural responses to repetition priming of spoken words and pseudowords in early blind individuals ... 107

Préface ... 107

Neural responses to repetition priming of spoken words and pseudowords in early blind individuals ... 107

Corresponding author ... 108

Keywords... 108

Abstract ... 108

4.1. Introduction ... 110

4.1.1. Behavioural differences in speech perception and production in the blind ... 110

4.1.2. Cross-modal plasticity ... 110

4.1.3. Repetition-Priming ... 112

4.1.4. Summary ... 113

4.2.1. Participants ... 114

4.2.2. Corpus ... 115

4.2.3. Experimental design: Lexical decision task ... 116

4.2.4. Experimental design: post-scan test ... 117

4.2.5. Behavioural task analysis: lexical decision task ... 117

4.2.6. Behavioural task analysis: post-scan test ... 118

4.2.7. Acquisition parameters ... 118

4.2.8. Neuroimaging data analyses ... 119

Word and pseudoword ... 120

Lexicality ... 121

Repetition effects ... 121

4.3. Results ... 122

4.3.1. Behavioural analyses: lexical decision task ... 122

Effect of group on scores and sensitivity ... 122

Effect of group and repetition on reaction time ... 122

4.3.2. Neuroimaging analyses ... 123

Word and Pseudoword ... 123

Word processing ... 123

Pseudoword processing ... 126

Lexicality effect ... 131

Sighted group—effects of lexicality ... 132

Blind group- Lexicality effects ... 134

Between group comparison ... 134

Repetition effects in Early Blind and Sighted Adults ... 134

Repetition-enhancement ... 137

Post-scan test ... 138

4.4. Discussion ... 139

4.4.1. Common activation and deactivation during lexical decision ... 139

4.4.2. Cross-modal Plasticity ... 140

4.4.3. Differences for pseudoword processing ... 143

4.5. Acknowledgements ... 146

Chapitre 5 - Discussion ... 148

5.1. Expérience musicale, privation visuelle, et capacités de perception de la hauteur des sons... 149

5.1.1. Effet de l’expérience musicale sur les seuils de perception de la hauteur des sons .. 149

De meilleurs seuils fréquentiels différentiels chez les musiciens ... 149

5.1.2. Un avantage général des musiciens sur les seuils fréquentiels différentiels ... 152

5.1.3. Effet de la cécité sur les seuils de perception de la hauteur ... 153

De meilleurs seuils différentiels chez les aveugles ... 153

Effet de l’expérience musicale chez les aveugles ... 155

5.1.4. Effet de la familiarité des sons sur les seuils différentiels et du type de stimulus chez les voyants ... 156

Pas d’effet de la familiarité des voyelles ... 156

Effet du type de stimulus : stimuli de parole, musicaux et sons purs ... 158

Des seuils identiques pour les voyelles et les sons purs, mais pas pour les instruments ... 158

Note sur les différences spécifiques observées chez les contrôles de l’étude 2 : un effet de l’âge ? ... 162

5.1.5. Conclusion : expérience musicale, privation visuelle et traitement de la hauteur des sons ... 163

5.2. Privation visuelle et réseaux associés aux traitements des mots et pseudo-mots ... 164

5.2.1. Plasticité Intermodale ... 164

Plasticité intermodale : généralités ... 164

Recrutement des aires extrastriées pour la perception auditive de la parole chez les aveugles ... 166

Rôle des aires visuelles primaires ... 167

5.2.2. Reconnaissance des mots ... 170

Répétition-suppression dans le Gyrus Frontal Inférieur ... 171

Répétition-suppression dans le Gyrus Fusiforme ... 172

5.2.3. Traitement et reconnaissance de nouveaux mots ... 176

Rôle de l’AMS ... 177

Répétition augmentation ... 178

5.3. Conclusion et futures pistes de recherche ... 180

Annexe ... 184

Effet de la formation musicale sur les seuils des aveugles et des voyants ... 184

Résumé

Ce travail de thèse s’est intéressé à mieux caractériser les phénomènes de compensation auditive et de réorganisation cérébrale chez les personnes non-voyantes. En examinant la perception et le traitement de stimuli de parole venant de contextes familiers et non familiers, et de stimuli musicaux, nous interrogeons l’impact de l’expérience vécue (privation sensorielle, expérience musicale) sur les mécanismes de traitement de la parole.

La première étude a permis de développer et de valider une tâche psychoacoustique sur un groupe de musiciens amateurs et un groupe de non-musiciens. A l’aide d’une procédure adaptative, nous évaluons les seuils fréquentiels différentiels de la fréquence fondamentale pour des voyelles françaises, des voyelles non-françaises, des sons d’instruments musicaux et des sons purs. La sélection des voyelles françaises et non-françaises a été réalisée pour chacun à partir des résultats individuels d’une tâche d’identification et de jugement de la qualité des voyelles. Nous avons démontré que les musiciens avaient de meilleurs seuils perceptifs que les non-musiciens, même en l’absence d’indices d’intensité, d’un son de référence, et en incluant des musiciens avec seulement deux ans de formation musicale. Cet avantage est présent quel que soit le type de stimuli, ce qui suggère un bénéfice perceptif général de l’expérience musicale.

Pour la deuxième étude, la même tâche psychoacoustique a été employée pour tester l’effet de la cécité précoce sur les seuils fréquentiels différentiels. Un groupe de participants aveugles présentant une cécité précoce et un nouveau groupe de participants voyants, d’âge, de sexe, d’éducation scolaire et d’éducation musicale appariés au groupe de participants aveugles ont pris part à cette expérience. Nous démontrons que les aveugles ont de meilleurs seuils fréquentiels différentiels que les voyants quel que soit le type de stimuli employé. Par ailleurs, contrairement

aux trois groupes de participants voyants étudiés dans cette thèse, il n’y a pas d’association forte entre leurs seuils pour les sons purs et leurs seuils pour les sons complexes dans le groupe de participants aveugles, suggérant que ces traitements reposent sur des mécanismes distincts dans cette population. Enfin, de possibles différences dans l’effet de l’âge sur le traitement auditif des personnes aveugles sont apparues.

Les groupes de participants aveugles et voyants de la deuxième étude ont pris part à une étude d’imagerie par résonance magnétique fonctionnelle (IRMf). Cette troisième étude consistait à explorer les mécanismes de réorganisation cérébrale des réseaux de perception de la parole chez les personnes non voyantes grâce à une technique d’adaptation IRMf, qui permet de mesurer l’effet de la répétition de stimuli sur la réponse des aires cérébrales. Nous avons pu mettre en évidence des différences dans les réseaux cérébraux associés à une tâche de décision lexicale. En plus de la plasticité intermodale généralement observée, nos résultats confirment l’importance du gyrus fusiforme gauche dans la perception et la reconnaissance du langage chez les aveugles, et mettent au jour le rôle important joué par un ensemble d’aires pariétales lors de la construction de la représentation de nouveaux mots chez les aveugles.

En conclusion, nos résultats montrent que l’expérience musicale et la privation visuelle améliorent les seuils perceptifs quel que soit le type de sons employés. L’étude de neuroimagerie confirme la présence de mécanismes de plasticité intermodale des aires visuelles et met au jour un ensemble de structures pariétales qui présentent aussi une réorganisation fonctionnelle. Grâce à ces trois études, nous avons mis en évidence des différences psychoacoustiques et fonctionnelles chez les aveugles à la fois pour traiter des stimuli connus et simples (sons purs, voyelles, mots) et pour apprendre et identifier des stimuli inconnus et complexes (voyelles non-natives, pseudo-mots).

Abstract

The present work seeks to provide a more complete understanding and characterization of the mechanisms involved in auditory compensation in individuals affected by blindness early in life, with a focus on behavioral and brain reorganisation. By characterizing the perception and processing of speech stimuli, from either known or unknown contexts, we aim to investigate experiential factors, such as sensory deprivation and musical experience, on speech processing mechanisms.

Our first study was focused on the development and validation of a psychoacoustic task on a group of amateur musicians and a group of non-musicians. Using an adaptive paradigm, fundamental frequency perceptual thresholds (frequency difference limen) were evaluated for French vowels, non-French vowels, musical instrument tones, and pure tones. Every participant took part in a task — before the actual test — to identify and rank the quality of French and non-French vowels. We found that musicians, including those with only two years of musical experience, have better perception capabilities over non-musicians, even without intensity cues and reference tones. This advantage is present independently of stimulus type used, suggesting a general enhanced perception due to musical experience.

For our second study, the same adaptive psychoacoustic task was used to assess the impact of early blindness on frequency difference limens. A group of blind individuals with early blindness, and a new group of sighted individuals matched on age, sex, education, and musical experience took part in the experiment. We found that early blind individuals have lower differential frequency limens for all stimuli, indicating general enhanced perception abilities. In addition, the blind group have shown some specificities regarding pitch processing: contrary to what was observed with the

three other groups of sighted participants in the psychoacoustic studies, blind participants did not exhibit strong correlation between pure tone thresholds and complex tone thresholds. This points towards different mechanisms for processing auditory stimuli between blind and sighted individuals. Finally, within the blind group, differences in sound processing were observed when considering participant age.

To have a better understanding of the functional brain reorganisation in the blind, the same groups from the second study were asked to participate in a functional Magnetic Resonance Imaging (fMRI) study. The goal of this third study was to explore the reorganisation of cortical networks involved with speech perception in the blind, using an adaptation fMRI paradigm. The fMRI protocol was used to measure the effects of stimulus repetition on brain activation. We demonstrated differences in brain networks associated with lexical decision on words and pseudowords. In addition to observing the cross-modal plasticity commonly reported in the literature, our results confirmed the major role of the left fusiform gyrus in speech perception and processing, as well as the role of a cluster of parietal areas in building representations of new words.

In conclusion, our results demonstrate that musical experience and visual deprivation improve perception thresholds for every type of sound. The neuroimaging study demonstrate differences in processing and learning new words and highlight the major role of intermodal plasticity mechanisms in visual areas as well as the role of a cluster of parietal structures. This thesis contributes directly to the improvement of the knowledge and understanding of the mechanisms recruited for auditory processing in the blind. Through three studies, we highlight critical differences between the blind and non-blind, both at a psychoacoustic level and at a functional

level, in the way each group processes known and simple stimuli (pure tones, native vowels, words), as well as unknown and complex stimuli (non-native vowels, and pseudowords).

Remerciements

Je tiens tout d’abord à exprimer ma gratitude à mon directeur Vincent Gracco et ma codirectrice Lucie Ménard. Merci Vince de m’avoir permis de réaliser ce doctorat et de m’avoir encouragée à interpréter les résultats avec plus de recul. Merci Lucie de m’avoir accueillie aussi chaleureusement dans ton laboratoire, d’avoir tout fait pour que je m’y sente bien, et de m’avoir intégrée à ton équipe. Et un grand merci pour ton soutien dans la dernière ligne droite de la rédaction. Merci à tous les deux de m’avoir laissée explorer des sujets variés, développer mes compétences de recherche et présenter mes résultats à des conférences internationales.

Je voudrais remercier les personnes qui ont accepté de faire partie du comité de thèse : Dr Franco Lepore, Dr Dave St-Amour, Dr Etienne De Villers-Sidani, Dre Alanna Watt, et surtout je voudrais remercier Dre Shari Baum pour sa patience, sa gentillesse, et ses conseils. Merci d’avoir fait partie de mon comité conseil tout au long du doctorat. Je tiens aussi à remercier Dre Lucile Rapin, Dr Mickael Deroche et Anastasia Sares pour la relecture de la thèse, merci pour tous vos conseils qui m’ont été très utiles et en particulier à Lucile pour tous tes encouragements au cours de la rédaction. Merci à Dre Josephine Nalbantoglu qui a été une directrice de programme hors pair.

Je tiens à remercier le Centre de Recherche sur le Cerveau, le Langage et la Musique pour m’avoir soutenu dans mes projets à l’aide de bourses de doctorat et de bourses de voyage.

Je tiens aussi à remercier certaines personnes que j’ai rencontrées et qui ont toutes contribué à mon parcours de recherche, chacune de ces personnes m’a inspirée à sa manière : Valérie Compan, Hélène Loevenbruck, Christophe Savariaux, Coriandre Vilain, Jean-Luc Schwartz, Philippe Kahane, Jean-Philippe Lachaux. Et en particulier merci à Marc Sato, mon directeur de Master,

grâce à qui j’ai rencontré Vince et Lucie, et qui m’a formée pour les analyses IRM. J’admire ton expertise et ta rigueur scientifique.

Je souhaite remercier Jill Vandermeerschen pour ses conseils pour les analyses statistiques des deux premières études, et le Dr. David Fleming pour ses conseils pour les analyses de neuroimagerie. Je tiens à remercier Louise Marcotte, David Costa, Ron Lopez, et Michael Ferreira. Toute personne qui a travaillé à l’IRM de recherche du BIC le confirmera, c’est un réel plaisir de travailler avec vous. Je n’ai jamais rencontré auparavant une équipe aussi soudée et montrant autant de professionnalisme et de dévouement. Merci pour votre soutien au cours de toutes les sessions IRM. Merci à tous les participants pour leur patience. En particulier aux personnes non-voyantes qui ont participé, grâce à vous la recherche sur la plasticité cérébrale avance, merci du fond du cœur pour votre contribution.

Du fond du cœur merci à Francine Gauvin, je t’ai rencontrée dans les moments difficiles et tu as su me donner les clés pour persévérer et en arriver là aujourd’hui. Je te dois non seulement l’aboutissement de mon projet de doctorat mais également une valise d’outils qui me serviront toute ma vie j’en suis sûre. Merci aux membres du groupe de soutien aux étudiants au doctorat de McGill et au groupe d’écriture de Graphos, incluant sa coordinatrice Yvonne Hung.

Je souhaite aussi chaleureusement remercier tous les membres du laboratoire du contrôle moteur de la parole de McGill et ceux à côté de qui j’ai travaillé à la maison Rabinovitch pendant toutes ces années : Francois-Xavier Brajot, Lisa Coady, Isabelle Deschamps, Thomas Gisiger, Inbal Itzhak, Fatemeh Mollaei, Anastasia Sares, Douglas Shiller, les conversations animées autour du lunch me manqueront. Merci en particulier à Benjamin Elgie mon partenaire de rédaction, merci pour tous tes encouragements tous les jours où nous nous sommes retrouvés à la bibliothèque pendant cette dernière année pour terminer nos doctorats, et à Don Nguyen, merci pour ton

assistance au cours du projet mais surtout merci du fond du cœur de m’avoir accueilli dans ta famille, pour ton soutien moral pendant les périodes difficiles le long du chemin. Tu es devenu un ami pour la vie.

Merci à tous les membres de mon laboratoire d’adoption, le laboratoire de phonétique de l’UQÀM : Lambert Beaudry, Marie Bellavance-Courtemanche, Caroline Émond, Thomas Granger, Mélinda Maysounave, Paméla Trudeau-Fisette, Christine Turgeon, Cristina Uribe, Camille Vidou et un remerciement tout particulier à Annie Brasseur et Lucile Rapin pour votre soutien et votre amitié au cours de ces dernières années. Cela a compté énormément pour moi. Merci à mes amis au Canada, Pariya, Nina, Soroush, Txomin, Anthony, Rola, Viviane, Manu, les Zotier, les Davy, Ayo, Emilie, Anh et Phúc Lương Nguyen, et à mes amis et ma famille Arnaud-Bigot en France. Je veux rendre hommage à mes parents Laurent et Aurore, et mes grands-parents, Pili, Mijo, André et Monique, qui m’ont permis d’en arriver là aujourd’hui. Merci à mes grand-mères, qui je l’espère auraient été fières de moi. Merci à mon grand-père André, pas peu fier d’avoir une petite-fille à qui transmettre sa curiosité scientifique. Merci Maman d’avoir relu toute la thèse, plusieurs fois, et merci pour tes encouragements pendant ces longues années. Merci Marjolaine d’être venue faire un bout du voyage et découvrir mon univers à l’Université McGill, ça a beaucoup compté, merci pour tout ton amour et tes encouragements !

Et enfin, à mon conjoint Alexandre, merci pour ton soutien inébranlable au cours de toutes ces années. Merci d’avoir été, littéralement, mes mains pendant plusieurs mois au milieu de ce doctorat, puis de m’avoir soutenue et supportée au cours des dernières semaines. Merci d’avoir cru en moi, bien plus que moi, merci pour tout.

Préface et contribution des auteurs

Article 1: Arnaud L., Ménard L., Gracco V.L. Frequency-Change Identification Abilities for

Native Speech, Foreign Speech and Music Sounds of Amateur Musicians and Non-Musicians (soumis à Hearing Research le 6 juin 2017)

J’étais responsable de la formulation des hypothèses, du développement des stimuli, du schéma expérimental, du recrutement des participants, de l’acquisition, analyse et interprétation des données, ainsi que de la rédaction de l’article. Mes directeurs, Vincent Gracco et Lucie Ménard m’ont conseillée, et guidée à toutes les étapes du projet et pour la correction de l’article.

Article 2: Arnaud L., Ménard L., Gracco V.L. Enhanced Perception of Pitch Changes in Speech

and Music in Early Blind Adults (soumis à Neuropsychologia le 15 juin 2017)

J’étais responsable de la formulation des hypothèses, du développement des stimuli, du schéma expérimental, du recrutement des participants, de l’acquisition, analyse et interprétation des données, ainsi que de la rédaction de l’article. Les références pour le recrutement des participants aveugles ont été fournies par Lucie Ménard. Mes directeurs, Vincent Gracco et Lucie Ménard m’ont conseillée, et guidée à toutes les étapes du projet et pour la correction de l’article.

Article 3: Arnaud L., Ménard L., Gracco V.L. FMRI Adaptation of Spoken Words and

Pseudowords in Early Blind Individuals

J’étais responsable de la formulation des hypothèses, du développement des stimuli, du schéma expérimental, du recrutement des participants, de l’acquisition, analyse et interprétation des données, ainsi que de la rédaction de l’article. Les références pour le recrutement des participants aveugles ont été fournies par Lucie Ménard. Jean-Michel Frenette m’a assistée pour

l’enregistrement du corpus. J’ai été aidée par les assistants de recherche Mélinda Maysounave and Don Nguyen pour la phase de neuroimagerie avec les participants aveugles, ainsi que par les technologues Louise Marcotte, David Costa, et Ron Lopez pour l’acquisition des données de neuroimagerie. Mes directeurs, Vincent Gracco et Lucie Ménard m’ont conseillée, et guidée à toutes les étapes du projet et pour la correction de l’article.

L’ensemble du contenu présenté dans la thèse représente une contribution originale et significative à l’avancement des connaissances en neurosciences. Les études ont été rédigées sous forme d’article pour publication dans des revues scientifiques. Une partie des résultats a été présentée aux conférences de Cognitive Neuroscience Society Meeting en 2015, à l’ACFAS en 2015 et 2016 et à l’International Society for Magnetic Resonance Meeting en 2017.

Liste des figures

Figure 1-1 - Exemple d'escalier adaptatif 3-descend 1-monte. Les cercles indiquent une réponse fausse, les signes + indiquent une réponse juste. La procédure 3-descend 1-monte commence après la première réponse fausse. Une réponse fausse est suivie d’une augmentation de la différence entre les stimuli (niveau plus facile), tandis qu’après trois réponses justes la différence entre les stimuli est réduite (le niveau de difficulté est augmenté). Le seuil calculé correspond à la moyenne géométrique des niveaux des stimuli aux points d’inversion de l’escalier. ... 13

Figure 1-2 – Illustration de la position des aires visuelles et des gyri frontaux inférieurs et fusiformes chez l’humain. Représentation basée sur l’atlas de Jülich pour les aires visuelles (Eickhoff et al., 2005), Harvard-Orford pour le cortex et les gyri fusiformes, et l’atlas de Tzourio-Mazoyer pour les gyri frontaux inférieurs (Tzourio-Tzourio-Mazoyer et al., 2002). GFI = Gyrus Frontal Inférieur... 20

Figure 1-3 - Vue de surface de l’activité cérébrale de l’effet de répétition suppression et valeurs estimées des contrastes associés. Extrait de Arnaud et al. (2013), traduit de l’anglais 3A-Vue de surface de l’activité cérébrale de l’effet de répétition suppression et valeurs estimées des contrastes associés reflétant la décroissance du pourcentage de signal BOLD pour les 7 répétitions des voyelles dans les régions auditives, visuelles et pariétales (Effet RS: corrigé à p<.01 au niveau du cluster, et non corrigé à p<.001 au niveau du voxel, nombre de voxel minimum de 30 par cluster) ; 3B-Vue de surface de l’effet de groupe et coupe horizontale montrant les aires d’activation pour 4 sections de z = 10 à z = 30 par incrément de 5mm. Abréviations : pSTG = gyrus temporal supérieur postérieur; IPS = sillon inférieur pariétal; SMG= gyrus supramarginal. ... 35

Figure 2-1 - Native and non-native vowels used in the identification and rating task. Nine prototypes of each of 6 native (i y u e ə a) and 6 non-native (ɨ ʉ ɯ ʊ ɤ ʌ) vowels were presented to participants. For each vowel category, eight variants were then synthesized around the reference prototype by modifying the values of the first two formants in 5% steps. F1 and F2 are the two first formants of each vowel. ... 52

Figure 2-2 - Identification of non-native stimuli. Percentage of identification and rating of non-native vowels across participant and vowel variant. ... 54

Figure 2-3 - Stimuli. Signal (top) and spectrogram (bottom) representations of examples of stimuli used in the FDL task. F0 and intensity contours are shown in blue and green, respectively. Note that the pure tone appears to be clipped but this is an artifact due to the limited time resolution of the display window. ... 57

Figure 2-4 - Experimental design. Signal (top) and spectrogram (bottom) representations of a trial example. The F0 and intensity contours of the stimuli are represented in blue and green respectively. F0 = mean fundamental frequency, I = mean intensity. ... 59

Figure 2-5 - On-line stimulus preparation. On each trial, after each participant answer, the fundamental frequency (F0) values (reference and shift) of the next trial, as well as the intensity values were calculated and sent out to MATLAB and then to Praat. The F0 and intensity shifts were applied through the standard Praat procedure using PSOLA reconstruction and the wave files for the following trial were synthesized. ... 60

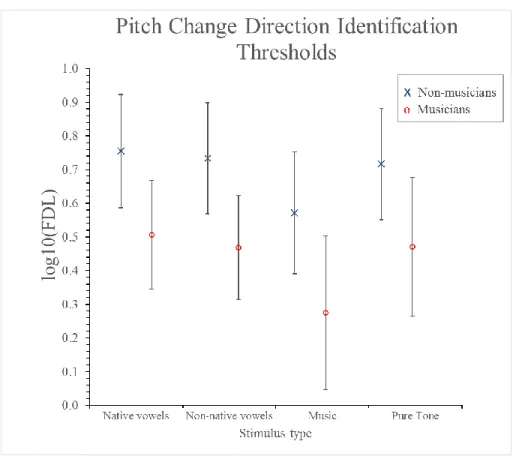

Figure 2-6 - Mean frequency- and F0-discrimination thresholds (FDLs and F0DLs, respectively) in the musicians and the non-musicians for pitch direction identification. Thresholds are shown for different types of auditory stimuli. All thresholds are expressed as the logarithm

base 10 of percentages of the standard frequency or F0. Error bars represent 95% confidence intervals. ... 63

Figure 2-7 - Correlation matrix between FDL/F0DL for different types of stimuli within non-musicians. The figure shows the correlation between the log10-transformed FDLs for French vowels (FV), native vowels (NV), musical instruments (MUS) and pure tone (PT) for non-musicians. All correlations are significant with Bonferroni adjustment... 64 Figure 2-8 - Correlation matrix between FDL/F0DL for different types of stimuli within musicians. The figure shows the correlation between the log10-transformed FDLs for French vowels (FV), native vowels (NV), musical instruments (MUS) and pure tone (PT) for non-musicians. All correlations are significant with Bonferroni adjustment... 65 Figure 2-9 - Correlation between F0DL/FDLs for French vowels (FV), non-native vowels (NV), musical instruments (MUS), and pure tone (PT) and the number of years of formal musical training (n=17). ... 67

Figure 3-1 - Native and non-native vowels used in identification and rating task. Nine tokens of each of 6 native (i y u e ə a) and 6 non-native (ɨ ʉ ɯ ʊ ɤ ʌ) vowels were presented to participants in an identification and rating task. For each vowel category, eight variants were then synthesized around the reference prototype by modifying the values of the first two formants in 5% steps. ... 84

Figure 3-2 - Identification of non-native stimuli. Non-native vowels were either identified as non-native vowels or identified as native vowels and were given low ratings, except for /ɨ/, which was also recognized as a good /y/. ... 87

Figure 3-3 - Signal (top) and spectrogram (bottom) representations of examples of stimuli used in the FDL task. Pitch and intensity contours are shown in blue and green respectively. Note that the pure tone appears to be clipped but this is an artifact due to the limited time resolution of the display window. ... 90

Figure 3-4 - FDL for pitch direction identification for different types of auditory stimuli for blind and sighted participants. Error bars represent 95% confidence intervals. ... 96

Figure 3-5 - Correlation matrix between FDL thresholds of sighted participants. The figure shows the correlation between the log-transformed FDLs for French vowels (FV), non-native vowels (NV), pure tones (PT) and music instruments (MUS) for sighted participants. Pearson’s linear correlation coefficients are shown for each pair; red color indicates significant correlation corrected with Bonferroni adjustment (p<0.0083). ... 97

Figure 3-6 - Correlation matrix between FDL thresholds of blind participants. The figure shows the correlation between the log-transformed FDLs for French vowels (FV), non-native vowels (NV), pure tones (PT) and music instruments (MUS) for blind participants. Pearson’s linear correlation coefficients are shown for each pair; red color indicates significant correlation corrected with Bonferroni adjustment (p<0.0083). ... 98

Figure 4-1 Behavioral results for the task. Average reaction time during the lexical decision task. Blind participants were as fast as control participants. Participants were significantly faster for words than pseudowords. A repetition priming effect was observed; answers were faster for the repeated stimuli. ... 123

Figure 4-2 – Lexical decision for words in early blind and sighted individuals. Axial views of activation (hot) and deactivation (cold) during processing of word vs. baseline in (a) sighted

individuals and (b) early blind individuals. Results are shown for a voxel p-value < 0.001 and a correction for multiple comparison at the cluster level (FDR, p<0.05). ... 124

Figure 4-3 - Lexical decision for pseudowords in early blind and sighted individuals. Axial views of activation (hot) and deactivation (cold) during processing of pseudoword vs. baseline in (a) sighted individuals and (b) early blind individuals. Results are shown for a voxel p-value < 0.001 and a correction for multiple comparison at the cluster level (FDR, p<0.05). ... 127

Figure 4-4 – Group differences for pseudowords. Axial and coronal views of areas that are differentially activated between groups during lexical decisions for pseudowords. Blind > Sighted (hot). Results are shown for a voxel p-value < 0.001 and a correction for multiple comparison at the cluster level (FDR, p<0.05). The other direction (Sighted > Blind) and the contrasts for word condition did not show any significant differences. ... 130

Figure 4-5- Effects of Lexicality status in early blind participants, sighted participants and between group differences. Main effect of Lexicality (words vs. pseudowords) in (a) sighted, (b) blind individuals, (c) between groups. Results are shown for a voxel p-value < 0.001 and a correction for multiple comparison at the cluster level (FDR, p<0.05). In the sighted, results were found for the word > pseudoword contrast only. In the blind, results were found for the pseudoword > word contrast only. ... 131

Figure 4-6 - Parameter estimates for the effect of lexicality. Parameters estimates are shown for peak voxels of the lexicality contrasts within (a) sighted and (b) blind. These are shown relative to the rest baseline. They are presented in the order of table 5. Error bars indicate standard error of the mean. ... 133

Figure 4-7 - Neural repetition effects in sighted and blind individuals. Views of areas that show repetition-suppression (a) in sighted individuals: Unique > Repeated (blue), and (b) repetition-enhancement in blind individuals: Unique < Repeated (hot). Results are shown for a p<0.001 at the voxel level and p<0.05 at the cluster level. (c) Parameter estimate for repetition-suppression and enhancement effects. Error bars indicate standard error of the mean. L IFG pT = Left Inferior Frontal Gyrus pars triangularis, L S1 BA2 = Left primary somatosensory cortex Brodmann Area 2, R SPL 7A = Right Superior Parietal Lobule anterior Brodmann Area 7, R IPL PFt = Right Inferior Parietal Lobule PFt, hIP1 = human intra-parietal area 1. ... 135

Figure 4-8 – Behavioral results after the task. Percentage of correct responses at the post-MRI memory test for blind and controls for words and pseudowords. Blind were better than controls to recall if stimuli were presented during the experiment in the MRI scanner or not, and words were easier to recall than pseudowords. The error bars represent the standard error of the mean. ... 138

Figure Annexe 1- Effet de la formation musicale sur les seuils. Résultats du modèle à effet mixtes sur l’impact de la formation musicale sur les participants aveugles (rouge) et voyants (bleus) pour les quatre types de stimuli. Les traits pleins indiquent les résultats significatifs. VF = voyelles françaises, NN = voyelles non-natives, SP = son pur, MU = instrument de musique. 185

Liste des tables

Tableau 1-1 - Comparaison des méthodes et résultats des études rapportant les seuils fréquentiels différentiels de la fréquence fondamentale chez des musiciens et non-musiciens ... 15

Table 2-1 - Formant Fi and bandwidth Bi values, in hertz, of reference stimuli /a/, /e/, /ə/, /ɤ/, /i/, /ɨ/, /ɯ/, /u/, /ʊ/, /ʉ/, /ʌ/, and /y/ synthesized for the perceptual experiment. All stimuli had an F0 of 112 Hz and a duration of 600ms.. Prototypical values are based on the monophthong oral vowels of the world’s languages, reported in UPSID (UCLA Phonological Segments Inventory Database, Maddieson, 1986). ... 51

Table 2-2 - Percentage of identification of native vowels and average rating for correctly identified vowels. Left: Averages are calculated across the 9 variants of each vowel category and across all participants. Bold indicates the response that was given most often, for each presented vowel. Right: Rating of the quality of pronunciation of correctly identified native vowels. The rating scale was between 1 (bad pronunciation) and 7 (good pronunciation). ... 53

Table 2-3 - Percentage of identification of non-native vowels. Averages are calculated across the 9 variants of each vowel category and across all participants. Bold indicates the response that was given most often, for each presented vowel. ... 54

Table 2-4 - Individual and group demographic information and results for the f0 direction identification task. Music background is defined as the number of years of formal musical training. FDL/F0DL = Frequency Difference Limen or Fundamental Frequency Difference Limen, Fr = French, NN = non-native. ... 62

Table 3-1 - Formant Fi and bandwidth Bi values, in hertz, of 'reference' stimuli /a/, /e/, /ə/, /ɤ/, /i/, /ɨ/, /ɯ/, /u/, /ʊ/, /ʉ/, /ʌ/, and /y/ synthesized for the perceptual experiment. F0=112Hz and

duration is 600ms for all stimuli. Prototypical values are based on the monophthong oral vowels of the world’s languages, reported in UPSID (UCLA Phonological Segments Inventory Database, Maddieson, 1986). ... 83

Table 3-2 Percentage of identification of native vowels and average rating for correctly identified vowels. Averages are calculated over the 9 variants of each vowel category for all participants. Note that /ø/, /ə/, and /œ/ answers were grouped together as well as /o/ and /ɔ/ Rating of the quality of pronunciation of correctly identified native vowels. The rating scale was between 1 (bad pronunciation) and 7 (good pronunciation). ... 86

Table 3-3 Percentage of identification of non-native vowels. Averages are calculated over the 9 variants of each vowel category for all participants. Note that /ø/, /ə/, and /œ/ answers were grouped together as well as /o/ and /ɔ/ ... 86

Table 3-4 - Individual and group demographic information and results for the pitch direction identification task. Music background is defined as the number of years of formal musical training. ... 94

Table 4-1 - Demographic information – Education corresponds to the number of post-secondary years, onset of blindness is given in month. M = male, F =female, E=English, Sp=Spanish, ROP=retinopathy of prematurity, Cong=congenital... 115

Table 4-2- Regions of activation and deactivation for word processing compared to baseline in the sighted and the blind (uncorrected p < .001 at the voxel level and FDR-corrected p< .05 at the cluster level). Coordinates in the MNI space. The first area of the cluster reflects the peak anatomical location, with the breakdown of up to two local peaks separated by more than 8 mm within the cluster also shown. ... 125

Table 4-3 -Regions of activation and deactivation for pseudoword processing compared to baseline in the sighted and the blind (uncorrected p < .001 at the voxel level and FDR-corrected p< .05 at the cluster level. Coordinates in the MNI space. The first area of the cluster reflects the peak anatomical location, with the breakdown of up to two local peaks separated by more than 8 mm within the cluster also shown. ... 129

Table 4-4 – Group differences for pseudowords. Regions of significant differences for pseudoword processing between sighted and blind (uncorrected p < .001 at the voxel level and FDR-corrected p< .05 at the cluster level. Coordinates in the MNI space. The first area of the cluster reflects the peak anatomical location, with the breakdown of up to two local peaks separated by more than 8 mm within the cluster also shown. No significant differences were found in the opposite direction (Sighted > Blind). ... 130

Table 4-5 - Effect of lexicality within the sighted group, the blind group, and significant between-group differences (uncorrected p < .001 at the voxel level and FDR-corrected p< .05 at the cluster level). Coordinates in the MNI space. The first area of the cluster reflects the peak anatomical location, with the breakdown of up to two local peaks separated by more than 8 mm within the cluster also shown. ... 132

Table 4-6 - Priming effects within the sighted group and within the blind group (uncorrected p < .001 at the voxel level and uncorrected p< .05 at the cluster level). Coordinates in MNI space. The first area of the cluster reflects the peak anatomical location, with local peaks separated by more than 8 mm within the cluster.Repetition-suppression ... 136

Table 4-7 – Presence of enhancement effects in other three conditions (words in sighted, pseudowords in sighted, words in blind) for the regions showing significant

repetition-enhancement effects for pseudoword in the blind group, tested at a more lenient statistical threshold (p<0.01, voxel level). ... 137

Liste des sigles et abréviations

AVFM : aire visuelle de la forme des mots

BOLD : de l'anglais blood-oxygen-level dependent dB : décibel

EB: early blind

EPI: Echo-Planar Imaging F0 : Fréquence fondamentale F1: first formant

F2: second formant

F3 ou GFI : Gyrus Frontal Inférieur FDL: frequency difference limen FWHM: Full-Width at Half Maximum G préC : gyrus précentral

GA : Gyrus angulaire HG: Heschl’s Gyrus

HRF: Hemodynamic Response Function Hz : Hertz

IFG: Inferior Frontal Gyrus IOG: Inferior Occipital Gyrus IPL: Inferior Parietal Locule IPS: Intraparietal Sulcus

IRMf : Imagerie par Résonance Magnétique fonctionnelle LO : cortex latéral occipital

MEG : Magnéto-encéphalographie MFG: Middle Frontal Gyrus ms : millisecondes

MTG: Middle Temporal Gyrus O6 : cuneus

pSTG: posterior Superior Temporal Gyrus

SDF/SDF0 : Seuils fréquentiels différentiels de la fréquence (son pur) ou fréquence fondamentale (son complexe)

SFG: Superior Frontal Gyrus SI: sighted individuals

SMA: Supplementary Motor Area SMG: Supramarginal Gyrus SOG: Superior Occipital Gyrus STG: Superior Temporal Gyrus STS : sillon temporal supérieur T1 : gyrus temporal supérieur T2 : gyrus temporal moyen T4 : gyrus fusiforme TA: Acquisition Time TE: Echo Time

TEP : Tomographie par émission de positons

TMS : stimulation magnétique transcrânienne, de l’anglais Transcranial Magnetic Stimulation TR: Repetition Time

UPSID: UCLA Phonological Segments Inventory Database V1 : cortex visuel primaire

VLAM: Variable Linear Articulatory Model VWFA: Visual Word Form Area

Préambule

Un des défis actuels de la recherche en neuroscience est de comprendre comment les circuits neuronaux se réorganisent pour s'adapter à des perturbations importantes du cerveau telles que des lésions cérébrales, une privation sensorielle ou le vieillissement. De plus en plus d'études s'intéressent au comportement du cerveau face à ces modifications, c'est-à-dire à sa plasticité. La neuroplasticité est un vaste champ d'étude, et comprendre les mécanismes qui la régissent aura des conséquences importantes notamment sur le développement de futures stratégies thérapeutiques pour aider les patients à récupérer d'accidents cérébraux.

La cécité congénitale est un modèle particulièrement intéressant pour étudier les mécanismes de neuroplasticité. Chez les voyants, les informations visuelles jouent un rôle prépondérant pour interagir avec l'extérieur et pour se construire des représentations de l'environnement. Bien que privées d'informations visuelles, les personnes aveugles de naissance démontrent des capacités remarquables pour vivre de manière autonome. Alors que chez les voyants, et chez les sourds, les informations visuelles jouent un rôle important dans la perception de la parole, chez les aveugles on n’observe pas de déficit langagier. Il a été montré que les personnes aveugles peuvent traiter efficacement les informations venant des autres sens et surpassent même les voyants pour certaines tâches impliquant des traitements tactiles ou auditifs. Nous proposons de mieux délimiter ce qui fait qu’un stimulus sonore est traité plus efficacement dans le contexte de la privation visuelle. Nous voulons notamment évaluer si l’avantage perceptif dépend de la familiarité du stimulus et du domaine du stimulus.

Ces vingt dernières années, un certain nombre d'études de neuroimagerie ont montré que les aires visuelles des aveugles congénitaux étaient fonctionnelles. On a notamment observé un recrutement

des aires occipitales lors de tâches sensorielles et de plus haut niveau, y compris lors du traitement de la parole ou du langage. Nous proposons d’explorer en détail les réseaux associés à la perception de la parole en distinguant les mécanismes sous-jacents du décodage de stimuli familiers ou non-familiers. A l'aide d’une combinaison d’expériences comportementales et de neuroimagerie, nous souhaitons mieux comprendre les conséquences de la privation visuelle, qu’elles soient observables au niveau des performances perceptuelles des aveugles ou au niveau du fonctionnement cérébral sous-jacent. L’identification des mécanismes neuronaux par lesquels le cerveau compense la privation visuelle constitue un modèle particulièrement intéressant pour comprendre les mécanismes de réorganisation cérébrale ainsi que leurs liens avec les différences comportementales observées.

Le premier chapitre de la thèse présente un état des connaissances sur les spécificités comportementales et les mécanismes neuronaux associés à la perception de la parole chez les aveugles congénitaux, et se termine par les objectifs et hypothèses de recherche de la présente thèse. Dans le deuxième chapitre, nous présentons une étude psychoacoustique sur les seuils de discrimination de la hauteur du son d’un groupe de personnes voyantes pour différents types de sons, incluant des sons de parole, et de l’impact de l’expérience musicale sur ces seuils. Dans le troisième chapitre, en s’appuyant sur la même méthodologie, nous évaluons l’impact de la privation visuelle sur les seuils de discrimination de la hauteur du son chez un groupe de participants aveugles. Dans le quatrième chapitre, nous explorons les mécanismes neuronaux associés à la compensation auditive observée lors de la perception de la parole, lors d’une tâche d’Imagerie par Résonance Magnétique fonctionnelle (IRMf) dans le même groupe de participants. Enfin, le cinquième chapitre est une discussion des présents résultats et de leur implication pour l’étude de la réorganisation cérébrale après une privation visuelle de naissance.

Chapitre 1 - Revue de la littérature

Dans ce premier chapitre, nous détaillerons les spécificités comportementales des aveugles congénitaux dans la perception des caractéristiques acoustiques de la parole. Puis, nous ferons état des connaissances actuelles sur les mécanismes neuronaux associés à ces traitements et comment ces mécanismes diffèrent chez les aveugles congénitaux comparativement aux personnes voyantes. Enfin, nous présenterons la méthode d’adaptation IRMf, les théories sur lesquelles elle s’appuie, et en quoi elle pourrait permettre de mieux comprendre l’impact de la cécité sur la perception de la parole. Nous terminerons par la présentation des objectifs de recherche de la présente thèse.

1.1. Décodage spectro-temporel de la parole chez les aveugles congénitaux

Chez les voyants, la vision joue un rôle majeur dans la perception du monde et dans la construction de ses représentations. Le quotidien des personnes privées de ce sens est rempli d’obstacles et de défis à relever pour, par exemple, retrouver ou utiliser un objet, pour se déplacer, ou pour accéder aux médias d’information (livres, ordinateur etc.). Pour mieux comprendre les défis que la cécité pourrait engendrer dans le contexte du développement du langage et de la communication en général, rappelons brièvement le rôle de la vision dans l’acquisition et l’utilisation du langage et de la communication parlée chez les personnes voyantes et les conséquences de la privation visuelle sur ces capacités.

1.1.1. Rôle de la vision dans l’acquisition et la perception de la parole

On sait que la vision joue un rôle considérable lors de la communication en face à face (Hubbard, Wilson, Callan, & Dapretto, 2009; McNeill, 1992; Sumby & Pollack, 1954) et lors de l'apprentissage de la parole (Kuhl & Meltzoff, 1982). La compréhension de la parole peut être facilitée par la présence d’indices visuels tels que les mouvements des mains, des lèvres ou des

expressions faciales. On peut distinguer plus efficacement deux phonèmes acoustiquement proches, /m/ et /n/ par exemple, grâce aux informations visuelles associées aux mouvements des lèvres du locuteur. Les aveugles congénitaux ne peuvent pas se servir de ces indices et ne peuvent donc se concentrer que sur la modalité auditive ou somato-sensorielle pour acquérir et percevoir la parole. Quand il s’agit d’étudier les conséquences d’une privation sensorielle sur les modalités intactes, deux modèles ou hypothèses sont généralement proposés (Rauschecker, 1995). Suivant l’hypothèse de perte généralisée, l’absence d’une modalité sensorielle pourrait impacter négativement les autres modalités. Dans le cas de la cécité, l’exploration de l’environnement est plus difficile et les stimulations extérieures réduites. Plusieurs études montrent qu’à l’âge adulte les informations venant de plusieurs sens sont intégrées pour optimiser la perception. L’effet McGurk -MacDonald (McGurk & MacDonald, 1976) et l’effet ventriloque (Alais & Burr, 2004) sont des exemples frappants d’intégration bimodale audio-visuelle. Il existe aussi des exemples d’intégration visuo-haptique caractérisée par de meilleurs seuils lorsque les deux modalités sont présentes plutôt qu’une (Ernst & Banks, 2002). Bien que la perception multimodale soit attestée chez les enfants âgés d'à peine quelques jours, le poids accordé à chacune de ces modalités dans le traitement perceptif n'est pas le même chez l'enfant et chez l'adulte. (Gori, Del Viva, Sandini, & Burr, 2008; Narinesingh, Goltz, Raashid, & Wong, 2015). L'intégration muldimodale telle qu'observée chez l'adulte semble donc être le résultat, entre autres, d’années d’expérience, et de réajustement de la calibration entre les sens au fur et à mesure du développement. En l’absence d’une modalité sensorielle, les modalités épargnées peuvent donc être affectées et en particulier lorsque le sens manquant joue habituellement un rôle de calibration des autres sens (Gori, Sandini, Martinoli, & Burr, 2013; Gori, Vercillo, Sandini, & Burr, 2014).

A l’inverse, les modèles de plasticité compensatoire prévoient que les personnes privées d’une modalité sensorielle compensent l’absence d’un sens en développant au maximum les autres sens (Merabet & Pascual-Leone, 2010). En effet, des études rapportent des capacités améliorées chez les aveugles, pour localiser des sons (voir Renier, De Volder, and Rauschecker (2013) pour une revue), pour utiliser l’écholocalisation (voir Kolarik, Cirstea, Pardhan, and Moore (2014) pour une revue), pour se déplacer dans l’espace (Fortin et al., 2008), ou pour certaines tâches haptiques (Alary et al., 2009; Alary et al., 2008). Suivant ce modèle, on s’attend à observer de meilleures capacités lors de la perception auditive de la parole chez les aveugles.

En fait, les revues de littérature sur les capacités sensorielles des aveugles aboutissent à un constat mitigé, par exemple : que « nous ne pouvons pas tirer de conclusions générales quant à la différence entre la perception auditive des aveugles par rapport à celle des voyants sur la base de la synthèse des travaux antérieurs. » (Dupont, 2006), ou que « bien que certaines études indiquent que les aveugles sont supérieurs aux voyants pour certaines tâches, d’autres ne reportent pas de différence significative » (Braun, 2016).

Concernant de possibles performances supérieures lors de la perception de la parole, il est rapporté que les aveugles sont meilleurs que les voyants pour reconnaître des syllabes, des mots ou des phrases dans des conditions d'écoute dichotique (présentation simultanée de sons différents dans chaque oreille) ou dans du bruit (Hugdahl et al., 2004; Muchnik, Efrati, Nemeth, Malin, & Hildesheimer, 1991; Niemeyer & Starlinger, 1981; Rokem & Ahissar, 2009). Il a également été montré que les aveugles congénitaux sont capables d'apprendre à comprendre la parole accélérée jusqu'à 22 syllabes par seconde contre 8 syllabes par seconde chez les voyants au maximum (Dietrich, Hertrich, & Ackermann, 2013; Hertrich, Dietrich, & Ackermann, 2013b; Hertrich, Dietrich, Moos, Trouvain, & Ackermann, 2009). Mais, la perception de la parole, telle que la

parole accélérée implique une multitude de traitements acoustico-linguistiques. Il est difficile d’identifier la contribution de chaque type de traitement à cette meilleure capacité globale des aveugles à percevoir la parole. Ces résultats sont-ils dus à un meilleur traitement acoustique des sons que constitue la parole, un meilleur traitement cognitif, ou une meilleure mémoire auditive à court terme ? Il existe plusieurs études montrant que les aveugles peuvent identifier de la parole plus efficacement dans différentes conditions ou qu’ils peuvent comprendre de la parole accélérée mais il existe peu d'études sur la perception des caractéristiques acoustiques de la parole, à un niveau plus fondamental de traitement, ce qui constitue un des thèmes explorés dans cette thèse.

1.1.2. Capacités de discrimination spectro-temporelle des sons chez les

aveugles

Discrimination de sons purs et de mélodies

Il existe pourtant des indices qui iraient dans le sens d’un meilleur traitement à un niveau plus fondamental également. Parallèlement aux études réalisées sur la parole, plusieurs travaux récents ont montré une certaine supériorité des aveugles congénitaux pour le traitement d’autres sons que ceux de la parole. Cette recherche est vaste et, comme mentionné auparavant, touche des traitements aussi variés que la localisation de sons dans l’espace, la reconnaissance de sons, ou l’écholocalisation. Ici, nous nous concentrerons sur les travaux les plus cohérents pour l’étude de la perception de la parole, c’est-à-dire sur les études portant sur les capacités de discrimination spectro-temporelle des aveugles congénitaux.

Les aveugles congénitaux auraient de meilleures habiletés à discriminer la hauteur de sons purs (Gougoux et al., 2004; Rokem & Ahissar, 2009; Voss & Zatorre, 2012; Wan, Wood, Reutens, & Wilson, 2010). Par exemple, ils présentent en moyenne des scores d’identification de la direction

du changement de hauteur de sons entre 80 et 100% selon la condition contre 50 à 80% chez les voyants (Gougoux et al., 2004), un seuil de discrimination de la hauteur de sons de 0.8% contre environ 3.5% chez les contrôles (Voss & Zatorre, 2012), des scores en moyenne 10 à 15% meilleurs que les contrôles pour des tâches de discrimination de la hauteur et du timbre de sons (Wan et al., 2010). Cette supériorité subsiste quand l'expérience musicale est prise en compte comme facteur de régression (Voss & Zatorre, 2012) ou dans le groupe contrôle (Rokem & Ahissar, 2009; Wan et al., 2010). Les tests impliquant un traitement de la hauteur sur des séquences plus longues donnent des résultats mitigés. Par exemple, un groupe d’aveugles avec une cécité précoce ne présentait pas de meilleurs scores qu’un groupe contrôle pour une tâche de discrimination simple de mélodies, mais montrait de meilleurs scores que le groupe contrôle pour des mélodies transposées, ce qui rend la tâche plus difficile (Voss & Zatorre, 2012). D’autre part, aucune différence entre aveugles et voyants n’a été observée pour une tâche qui consistait à comparer le premier et le dernier son d’une séquence de 6 ou 12 sons alors que les aveugles avaient de meilleurs scores de discrimination pour des sons présentés isolément (Wan et al., 2010). Concernant la dimension temporelle du traitement des sons, il semble que les aveugles congénitaux sont capables de traiter des signaux auditifs plus rapides que les personnes voyantes. Par exemple leur score de discrimination de la hauteur de deux tons, pour des stimuli très courts (20 ms), équivaut au score des contrôles pour des stimuli de 170 ms (Gougoux et al., 2004). Stevens & Weaver (2005) ont montré que lors d'une tâche de jugement d'ordre temporel, les aveugles n'étaient pas influencés par la présence d'un masque de bruit présenté après les stimuli même après un intervalle très court (10 ms), leur performance pour cet intervalle équivalait à la performance des contrôles pour un intervalle supérieur à 160ms. Ces résultats suggèrent que les mécanismes de perception auditive des aveugles congénitaux sont différents de ceux des voyants. Ces différences

semblent concerner plusieurs dimensions : traitement de la hauteur du son et intégration temporelle plus efficaces.

Le fait que les aveugles congénitaux démontrent une meilleure acuité auditive pour certains traitements acoustiques indique-t-il que les aveugles congénitaux pourraient percevoir la parole plus efficacement que les voyants dès l'étape de décodage acoustique ? Peuvent-ils par exemple traiter plus efficacement les indices acoustiques sur des sons plus complexes comme des unités de parole telles que les voyelles ?

Discrimination de sons de parole

Il existe peu d'études sur la perception de la parole des aveugles congénitaux au niveau du décodage acoustique. Ménard et collègues (2009) ont montré une meilleure catégorisation de voyelles chez des aveugles congénitaux adultes pour certains contrastes. En revanche, pour d’autres contrastes de voyelles, les deux groupes de participants ont atteint un score de 100% ce qui ne permet pas de faire apparaître de différence entre les deux groupes. Les aveugles seraient également meilleurs pour identifier des syllabes (i.e. /pa/, /ta/, /ka/, /ba/, /da/, /ga/) dans des conditions d’écoute dichotique que les voyants (Hugdahl et al., 2004), et plus rapides pour identifier la première voyelle de pseudomots dissyllabiques (baba, babu, dede, tete, gigo, gigi, lolo, wowo) (Klinge, 2011). Cependant, dans cette dernière étude, les aveugles étaient plus rapides que les voyants pour des tests impliquant d’autres types de traitement (par exemple l’identification d’émotions). Il se pourrait donc que les aveugles aient de meilleurs temps de réaction uniquement du fait qu’ils sont plus à l’aise pour utiliser les boutons de réponse que les contrôles qui avaient les yeux bandés pendant l’expérience et qui sont moins habitués à manipuler des objets sans les voir.

En conclusion, des études ont montré une certaine supériorité des aveugles congénitaux pour certaines tâches de perception de la parole mais peu d'entre elles ont évalué la perception de la parole à l’étape du décodage acoustique malgré des indications que les aveugles ont de meilleures capacités de discrimination acoustique pour d’autres types de sons comme les sons purs.

1.1.3. Impact du domaine et de la familiarité des stimuli

En se basant sur les résultats récents, qui montrent que les aveugles congénitaux sont meilleurs pour des tâches impliquant un décodage acoustique fin de sons purs ou de mélodies, et sur les travaux de Ménard et al. (2009) sur la perception de voyelles, nous proposons d'étudier la perception de la parole chez des aveugles congénitaux adultes dès l'étape de décodage acoustique, en mesurant des seuils perceptifs. De plus, nous voulons répondre à une autre question fondamentale qui n’a pas été abordée auparavant. On ignore si la facilitation de traitement auditif des aveugles s’applique de manière générale à tout type de son ou plus spécifiquement à certains types de sons. Comme décrit ci-dessus, ces différences sont particulièrement présentes pour des sons sinusoïdaux. Ces sons sont très particuliers puisqu’ils sont constitués d’une seule composante sinusoïdale et ne représentent pas les sons qui sont principalement présents et rencontrés dans notre environnement. Comparer des sons complexes et des sons sinusoïdaux permettrait de vérifier que la meilleure acuité auditive des aveugles pour les sons purs n’est pas un phénomène accessoire mais représente bien un mécanisme présent chez les aveugles pour des sons plus écologiques. D’autre part, mesurer des seuils pour des sons complexes venant de différents domaines permettrait de tester l’hypothèse d’un meilleur traitement global des aveugles pour la hauteur des sons, l’équivalent perceptif de la fréquence fondamentale, ce qui n’a jamais été testé à notre connaissance. La fréquence fondamentale est une dimension physique qui est saillante pour la perception de la musique et de la parole. C’est une dimension majeure de la perception musicale

puisqu’elle définit les intervalles. Ses variations ont un rôle varié en fonction des langues. Pour les langues tonales (comme le mandarin), la hauteur a une dimension phonologique. Pour le français québécois (qui est une langue non tonale), la langue maternelle des participants inclus dans nos études, les variations de la hauteur permettent de distinguer une phrase déclarative et une phrase interrogative, de reconnaître s’il s’agit d’une voix d’enfant ou d’adulte, d’homme ou de femme, ou encore permettent de séparer plusieurs sources de parole et ainsi améliorer la compréhension de ce qui est dit par une personne quand sa voix est masquée par d’autres voix (Brokx & Nooteboom, 1982; Nooteboom, 1997b). On peut donc dire que la hauteur, même si elle joue des rôles variés, a son importance à la fois dans la perception de la musique et de la parole. Toutefois, la perception auditive associée à la musique et celle associée à la parole pourraient différer à cause des caractéristiques propres à ces domaines et notamment en fonction de leurs importances relatives pour les aveugles. La parole constitue un moyen privilégié de communication et d’accès à l’information (au travers de la radio, de livres audios ou de la synthèse vocale de contenus numérique) et revêt donc un rôle très important qui pourrait résulter en un affinage plus poussé, spécifique à ce domaine.

1.1.4. Test adaptatif et évaluation des seuils différentiels fréquentiels

Parmi le grand nombre de tests existants et qui permettent d’évaluer les capacités de perception auditive, nous avons choisi d’utiliser un test pour évaluer les seuils différentiels fréquentiels. En effet, nous verrons que ces tests permettent de mesurer les limites de la perception de chaque individu et peuvent s’appliquer à plusieurs types de sons (parole, musique etc.). Nous allons présenter le principe et les avantages de ces tests et discuter d’un facteur important à prendre en compte lors de l’étude des seuils différentiels fréquentiels : l’impact de l’expérience musicale sur ces seuils.

Evaluation des seuils différentiels fréquentiels

En psychoacoustique, le seuil différentiel, ou seuil de discrimination, est la différence minimale entre deux stimuli à partir de laquelle un individu peut distinguer les deux stimuli. Par exemple le seuil différentiel de fréquence fondamentale (SDF0) est la différence minimale de fréquence fondamentale qui peut être détectée par un individu. La fréquence fondamentale (F0) est le paramètre physique d’un son qui correspond à la perception de la hauteur tonale des sons, et qui détermine donc si un son est perçu comme aigu ou grave. Comme ce seuil évolue avec la valeur de la fréquence fondamentale, il est d’usage de calculer le SDF0 relatif :

𝑆𝐷𝐹0

𝑟𝑒𝑙=

∆F0F0que nous noterons SDF0 pour éviter d’alourdir le texte.

Ces seuils peuvent être évalués à partir de diverses méthodes, il existe trois catégories de méthodes dites classiques :

- La méthode des limites, qui consiste à diminuer la différence entre les stimuli jusqu’à ce

que le sujet ne parvienne plus à détecter de différence (méthode descendante) ou à l’inverse à augmenter la différence jusqu’à ce que le sujet la détecte (méthode ascendante).

- La méthode des ajustements, qui permet au participant de faire varier lui-même la

différence entre les stimuli jusqu’à ce qu’il juge avoir atteint un niveau correspondant à la limite de son seuil de détection.

- La méthode des stimuli constants, pour laquelle la différence entre les stimuli varie et est

présentée de manière non prédictible par le sujet et qui permet d’estimer l’ensemble de la fonction psychométrique du sujet.

Mais ces méthodes sont considérées comme inefficaces car dans le cas de la méthode des stimuli constants il faut connaître à l’avance les points de la fonction psychométrique à tester, et dans le cas des méthodes des limites et ajustements, les résultats peuvent être sujets à des erreurs d’anticipation, ou d’habituation de la part des participants (voir Gescheider (1997)).

Pour contrer ces problèmes, des méthodes psychophysiques dites « adaptatives » ont été développées. Il existe par exemple, les procédures en escalier et les procédures bayésiennes et de maximum de vraisemblance. Les procédures en escalier sont plus faciles à mettre en place et ont été couramment utilisées depuis leur popularisation par Levitt (1971), c’est sur cette procédure que nous nous concentrerons.

Les procédures en escalier (voir Figure 1-1) consistent à ajuster le niveau de difficulté d’un essai en fonction du niveau des essais précédents et des réponses du participant. Une des méthodes les plus populaires consiste à diminuer la différence entre les stimuli après un certain nombre de réponses justes et à l’augmenter dès que le sujet fait une erreur. On parle de « 2 up 1 down » que l’on pourrait traduire par : « 2 descend - 1 monte ». Il existe d’autres procédures telles que « 1 up 1 down », « 3 up 1 down » etc. En fonction de la procédure choisie, et de la taille des incréments et décréments des niveaux de difficulté, la probabilité de converger vers un certain point de la courbe psychométrique varie. Les valeurs estimées par Levitt ont depuis été corrigées (Garcı́a-Pérez, 1998), et des recommandations concernant les paramètres optimaux de ces méthodes ont été décrites (Alcala-Quintana & Garcia-Perez, 2007; García-Pérez, 2000, 2001, 2002) malheureusement peu d’études ont suivi ces recommandations (García-Pérez, 2011) .

Figure 1-1 - Exemple d'escalier adaptatif 3-descend 1-monte. Les cercles indiquent une réponse fausse, les signes + indiquent une réponse juste. La procédure 3-descend 1-monte commence après la première réponse fausse. Une réponse fausse est suivie d’une augmentation de la différence entre les stimuli (niveau plus facile), tandis qu’après trois réponses justes la différence entre les stimuli est réduite (le niveau de difficulté est augmenté). Le seuil calculé correspond à la moyenne géométrique des niveaux des stimuli aux points d’inversion de l’escalier.

Les seuils différentiels fréquentiels des sons purs ont été le sujet d’un grand nombre d’études dans la population générale depuis la fin des années 1940, (voir par exemple Harris (1948) et Meurmann (1954), et les travaux par Moore et collègues (Moore & Glasberg, 1989; Moore, Glasberg, Low, Cope, & Cope, 2006; Sek & Moore, 1995). L’étude de ces seuils est communément utilisée en psychoacoustique puisqu’elle permet de déterminer les relations existant entre les dimensions physiques des stimuli sonores et la perception que l’on en a. Ils ont d’ailleurs été étudiés dans le contexte de la plasticité due à l’expérience musicale chez les musiciens.