FACULTE DES SCIENCES DE L ’EDUCATION

THESE PRESENTEE

A L'ECOLE DES GRADUES DE L'UNIVERSITE LAVAL

POUR L'OBTENTION

DU GRADE DE MAITRE ES ARTS (M.A.) PAR

JOANNE DUBE BACHELIERE ES ARTS DE L'UNIVERSITE LAVAL

ETUDE SUR L'UTILISATION D'ITEMS SPECIFIQUES DANS UN QUESTIONNAIRE D'EVALUATION DE COURS

Je désire principalement remercier mon directeur de recher che, monsieur Jean-Jacques Bernier, de même que mon deuxième conseiller monsieur Denis Rhéaume, pour leurs précieux conseils tout au long de

l'accomplissement de cette recherche.

Je désire également remercier monsieur Jean-Marc Dumas, docu mentaliste au centre de recherche INRS-Education, qui m'a permis de con

sulter les différents rapports rédigés dans le cadre du projet PERPE.

Il faut souligner aussi la collaboration d'une dizaine de pro fesseurs de la Commission Scolaire Régionale de T i l l y qui ont accepté de nous permettre de rencontrer les élèves dans le cadre de leurs cours pour les fins de l'expérimentation.

Enfin je dois mentionner la contribution financière du Fonds F.C.A.C. pour l'aide et le soutien à la recherche.

RESUME

Notre recherche porte sur un questionnaire d'évaluation de cours construit à partir de 40 items spécifiques. Il s'agit du questionnaire PERPE Secondaire développé au début des années 70 par des chercheurs de

1 'INRS-Education. Cet instrument de mesure comporte une caractéristique

que nous croyions intéressante c'est-à-dire une description opérationnel le de chacun des traits mesurés. Chaque item comporte un t i t r e , une des cription opérationnelle de ce t i t r e et une échelle de réponses.

L'étude origine de l' in té r ê t que nous portons â la description opérationnelle accompagnant chacun des titre s d'items du questionnaire. Nous nous demandions si le fait d'ajouter une description opérationnelle précisant chacun des aspects à évaluer pouvait amener 1 'élève à répondre différemment ou de façon plus analytique aux items du questionnaire. No tre objectif consistait donc à vé rifier expérimentalement si les descrip tions opérationnelles modifient la façon de répondre au questionnaire.

Pour procéder, nous avons d'abord u t ilis é la forme originale du

questionnaire PERPE Secondaire (forme 1). Nous avons produit également

une forme modifiée du questionnaire (forme 2) oû nous avons conservé exac tement tous les mêmes tit res et les mêmes échelles de réponses à l'excep

tion toutefois des descriptions opérationnelles. Lors de la passation

du questionnaire, les copies ont été distribuées au hasard de façon à ce qu'à l'in té rieur d'un même groupe, une moitié d'élèves reçoive la forme 1 et l'autre moitié la forme 2. Notre échantillon comprend dix groupes

des groupes de différentes matières lors de notre expérimentation.

La façon d'étudier l' e f f e t de la description opérationnelle sur la façon de répondre au questionnaire consiste à comparer la moyenne et 1'écart-type des items aux deux formes du questionnaire. Ces analyses nous ont amenés à remarquer que, dans l'ensemble, l'ajout de la descrip tion opérationnelle a tendance à augmenter la moyenne de l'item. Par a il le u r s, l'ajout de la description opérationnelle a tendance à diminuer 1'écart-type. Nous croyons que le fa it qu'un item soit spécifié par une description opérationnelle entraîne généralement une compréhension plus univoque du t r a it mesuré d'oû une plus petite dispersion des réponses.

Un premier examen de la littérature nous l a i s s a i t croire qu'une étude du type que nous proposions ne semblait pas avoir été réalisée au

paravant. L'idée d'inclure dans le questionnaire une description opéra

tionnelle de chacun des traits mesurés nous semblait une in it iati ve inté ressante méritant d'être évaluée. Cette étude concerne la validité des informations recueillies par un questionnaire d'évaluation de cours puisque l'on considère qu'un item est valide s ' i l mesure bien ce qu'il

prétend mesurer. Les conclusions que nous en tirons devraient intéres

ser ceux qui travaillent à l'élaboration d'instruments de mesure dans le domaine de l'évaluation des cours par les élèves.

page

REMERCIEMENTS ... i

RESUME ... ii

TABLE DES MATIERES ... iv

LISTE DES TABLEAUX ... v

CHAPITRE I: INTRODUCTION ... 1

a) Objectif de l'étude ... 1

b) Evaluation de cours à l'aide de questionnaires ... 10

c) Le questionnaire PERPE Secondaire ... 14

CHAPITRE I I : METHODOLOGIE ... 24

a) Expérimentation ... 24

b) Description de l'échantillon ... 28

CHAPITRE I I I : ANALYSE DES DONNEES ... 31

a) Introduction ... 31

b) Comparaison des moyennes aux 2 formes du questionnaire ... 37

c) Comparaison des écarts-types aux 2 formes du questionnaire .. 48

CHAPITRE IV: CONCLUSION ... 57 TABLE DES MATIERES

LISTE DES TABLEAUX

page

TABLEAU 2.1 Répartition des élèves selon la forme du question

naire et selon le groupe d'appartenance ... ... 30

TABLEAU 3.1 Effet des descriptions opérationnelles sur la

moyenne et l'écart-type des items ... 35

TABLEAU 3.2 Différences sensibles de moyennes ... 38

TABLEAU 3.3 Différences sensibles d'écarts-types... 49

TABLEAU 3.4 Différences sensibles de moyennes et différences

CHAPITRE I

INTRODUCTION

a) Objectif de 1 'étude

Notre recherche concerne l'évaluation des cours par les élèves à l'aide de questionnaires. Elle a comme point de départ la forme parti culière des items d'un instrument québécois. Il s'agit du questionnaire PERPE Secondaire^ un questionnaire u t ilisé dans le cadre de l'évaluation des cours qui s'applique, comme son nom l'indique, au niveau de l' e n se i gnement secondaire. Le PERPE Secondaire a été développé au début des an nées 70 par des chercheurs de 11INRS-Education. Ce questionnaire est com posé de 40 items comportant chacun un tit r e écrit en majuscules, une des cription opérationnelle du titre de l'item c'est-à-dire une définition de l'aspect évalué et un ensemble de réponses constituant une échelle de L i - kert en cinq points. De plus, chaque item est suivi de deux questions.

1PIERRE, P., MAILH0T,M. (1977). Le questionnaire PERPE Secondaire.

La première question mesure la perception qu'ont les élèves de la réalité c'est-à-dire la façon dont i l s perçoivent leur professeur (question A).

La seconde question mesure les attentes des élèves c'est-à-dire la maniè re dont devrait se comporter le professeur pour que les élèves soient sa t i s f a i t s (question B). Prenons quelques exemples pour i llu s t r e r la natu re des items de cet instrument qui a su retenir notre attention.

Premier exemple:

COMPREHENSION DANS LES CONTROLES

Il s'agit de mesurer l'importance que ce professeur accorde à la compré hension de la matière, dans les contrôles ou examens, en insistant sur un effort de réflexion, une reformulation personnelle, plutôt que sur une simple répétition du contenu du cours.

1. Accorde PEU d' importance à la compréhension

2. Accorde une PLUS OU MOINS grande importance à la compréhension

3. Accorde une GRANDE importance 3 la compréhension 4. Accorde une TRES GRANDE importance à la compréhension 5. Accorde une ENORME importance à la compréhension

Question A: Oü situez-vous ce professeur (ce cours) sur l'échelle d'éva-1uation?

3

Deuxième exemple:

VARIETE DES METHODES

Dans sa présentation de la matière, le professeur peut u t ilis e r différen tes méthodes pédagogiques telles que textes polycopiés, présentations au dio-visuelles, travail en équipe, travail en bibliothèque , etc. Il s'agit ici d'évaluer si ce professeur varie ses méthodes, en util is e plusieurs, peu importe lesquelles.

1. Ne varie JAMAIS ses méthodes 2. Varie TRES RAREMENT ses méthodes 3. Varie RAREMENT ses méthodes

4. Varie OCCASIONNELLEMENT ses méthodes 5. Varie SOUVENT ses méthodes

Question A: Où situez-vous ce professeur (ce cours) sur l'échelle d'éva luation?

Question B: 00 devrait-il se situer pour que vous soyez satisfait(e)

Troisième exemple:

EXEMPLES ECLAIRANTS

Il s'agit ici d'évaluer si les exemples utilisés par ce professeur vous aident à mieux comprendre ce qu'il enseigne.

1. Exemples PEU éclairants

2. Exemples PLUS OU MOINS éclairants 3. Exemples ASSEZ éclairants

4. Exemples TRES éclairants

5. Exemples PARFAITEMENT éclairants

Question A: Où situez-vous ce professeur (ce cours) sur l'échelle d'éva-1uati on?

que ti t re d'item est accompagné d'une explication qui consiste en une des cription opérationnelle de 1 'aspect mesuré. C'est en ce sens que le PER PE Secondaire diffère des traditionnels questionnaires d'évaluation de cours dont les aspects à évaluer sont généralement présentés sous forme de brefs énoncés. La description opérationnelle du t it r e des items ici constitue la caractéristique qu'il nous intéressait d'étudier.

Nous nous sommes demandés quel pouvait être l 'e ff e t des explica tions accompagnant les titres des items du questionnaire sur les réponses

fournies par les élèves. En d'autres mots, les descriptions opérationnel

les des titres des items contribuant 5 spécifier les différents aspects à évaluer amènent-elles les élèves à répondre différemment ou de façon plus analytique? Des items rédigés de façon plus spécifique entraînent- i l s une compréhension plus univoque de la question chez les répondants? Si le fait que soient mieux spécifiés les items dans un questionnaire d'évaluation de cours modifiait sensiblement les réponses fournies par les élèves, il faudrait repenser à la formulation des questions de cer tains instruments servant à l'évaluation des cours et ces résultats ne pourraient la isser indifférents les spécialistes travaillant à l'élabo ration de tels types de questionnaires. L'objectif de notre étude est donc de vé rifier expérimentalement l' e ffe t des descriptions opérationnel les sur les réponses fournies par les élèves aux différents items du questionnaire. De façon plus précise, nous désirons voir si les descrip tions opérationnelles ont une influence sur la moyenne des items et sur la dispersion des réponses telle que décrite par l'écart-type.

5

Pour réaliser notre recherche, nous avons choisi de procéder de la façon suivante. Nous avons u t ilis é la forme originale du PERPE Secon daire que nous avons qualifiée de forme 1. Il s'agit bien sQr du ques tionnaire composé des 40 items comportant chacun un t i t r e , une description opérationnelle du tit re et une échelle de réponses. Nous avons également produit une forme modifiée du questionnaire (forme 2) oü nous avons con servé exactement tous les mêmes tit res d'items et toutes les mêmes échel les de réponses mais où les descriptions opérationnelles ont été omises.

Notre expérimentation devait nous conduire â distribuer les deux formes du questionnaire à plusieurs groupes d'élèves de secondaire V, les copies se trouvant à être assignées au hasard aux élèves de chacun des groupes. La façon d'étudier l ' e f f e t des descriptions opérationnelles sur la façon de répondre au questionnaire consiste â comparer, pour chaque i- tem, la moyenne obtenue â la forme 1 à celle obtenue à la forme 2. Pour savoir ensuite si l'ajout des descriptions opérationnelles influence la dispersion des réponses, il s'agit de comparer, pour chaque item, 1 'écart- type obtenu â la forme 1 à celui obtenu à la forme 2. Cette analyse doit être effectuée au niveau de chacun des groupes constituant l'échantillon.

Le f a it que les items dans un questionnaire d'évaluation de cours soient précisés par des définitions opérationnelles de leurs titres nous a amenés à réfléchir et â nous intéresser 3 la spécificité des items. En feuilletant la littérature dans le domaine des recherches ayant été réalisées sur les questionnaires d'évaluation de cours, nous avons relevé plusieurs études qui se sont penchées sur la fidélité et la validité des

instruments de mesure, sur le contenu des questionnaires d'évaluation de cours ainsi que sur la comparaison des types de questionnaires mai s Deu d'auteurs semblent s'être intéressés â la spécificité des items dans les

questionnaires d'évaluation de cours. Nous avons cependant retrouvé deux

études portant précisément sur cette question.

Bradenburg (1979) et Douglass (1979) ont poursuivi des recherches portant sur la spécificité des items. Bradenburg étudiait les propriétés de trois catégories d'items: des items globaux, des items généraux et des items spécifiques. Dans son étude, il se trouvait â comparer les proprié tés des items spécifiques à celles des deux autres catégories d'items. Par a ille u r s , au cours de la même année, Douglass conduisait également une é- tude oü i l comparait des items spécifiques à des items qu'il qualifia it d'items généraux. On remarque un point qui est commun à ces deux études. C'est que dans les deux cas, 1 'on se trouvait à comparer des items portant sur des contenus différents. En effet, les items spécifiques ne portent pas sur les mêmes aspects que les items généraux et que les items globaux. Notre recherche diffère de celles de Bradenburg et de Douglass en ce sens que nous avons voulu étudier la spécificité des items mais en comparant des items portant sur les mêmes aspects; c'est pourquoi nous avons produit deux formes du même questionnaire. De cette façon, un item rédigé dans la première forme du questionnaire concerne le même aspect que l'item cor respondant dans la deuxième forme du questionnaire. Ainsi lorsqu'il s ' a git par exemple d'évaluer la variété des méthodes pédagogiques du profes seur, si le tit r e de l'item est accompagné de sa description opérationnel le comme c'est le cas dans la forme 1 du questionnaire ou bien si la

des-7

criptîon a été omise comme dans la forme 2 du questionnaire, l'élève doit quand même d'une façon ou de l'autre se prononcer sur la variété des mé thodes pédagogiques de son professeur. C'est ainsi que dans notre étude, nous nous trouvons à comparer deux formes d'items portant sur les mêmes contenus: des items spécifiques (forme 1 du questionnaire) et des items moins spécifiques (forme 2).

Bradenburg et ses collaborateurs ont mené une étude dont l'objec t i f était de comparer les propriétés des items spécifiques à celles des items généraux. Pour conduire leur étude, i l s ont sélectionné 39 items dans le Instructor and Course Evaluation System Catalog. Il s'agit de 39

items cla ssifié s selon leur contenu et selon leur spécificité. Les items spécifiques qu'ils avaient sélectionnés portaient sur l'évaluation de com portements et d'attitudes du professeur alors que les items globaux et les items généraux concernaient des aspects plus généraux sur l'enseigne ment. I l s précisent également que pour répondre aux items globaux et gé néraux, il faut faire un effort de raisonnement inductif ou déductif. Par contre, comme les items spécifiques réfèrent à des caractéristiques obser vables, les élèves répondraient de façon plus spontanée à ce type d'item. Un des aspects que l'on trouvait intéressant dans l'étude de Bradenburg est qu'il posait l'hypothèse que les items spécifiques devraient avoir au sein d'une classe un écart-type inférieur â celui des items globaux et des items généraux puisqu'on devrait s'attendre S ce que les items spéci fiques donnent lieu â une plus petite dispersion des réponses. Passable ment dans le même esprit, nous nous sommes penchés sur 1 'écart-type des

ce qui semble a lle r dans le sens contraire de 1'hypothèse de départ. Il faut bien se rappeler toutefois que Bradenburg comparait trois types d ' i tems portant sur des contenus différents.

Par ailleurs en 1979, Douglass poursuivait une étude où il dési rait comparer deux types d'items: des items spécifiques et des items gé néraux. Le questionnaire u t ilis é par Douglass comportait quatre items généraux et 24 items spécifiques. Dans son étude, Douglass anticipait que la variance des items spécifiques devrait être inférieure â celle des items généraux, ce qui fut confirmé. Il postulait également que la moyen ne des items spécifiques devrait être supérieure à celle des items géné raux. On trouvait intéressante l'idée que Douglass se soit attardé à l ' é tude de la moyenne des items spécifiques puisque nous avons voulu égale ment procéder à cette analyse dans le cadre de notre recherche. Les con clusions de l'étude de Douglass révèlent que les deux hypothèses semblent

être supportées par leurs résultats. Les items spécifiques, portant sur

des caractéristiques observables et précises, ont entraîné de f a it un de gré d'entente plus uniforme chez les élèves c'est-à-dire un écart-type inférieur â celui des items généraux. D'autre part la moyenne des items

spécifiques s'.avérait supérieure à celle des items généraux. Finalement

Bradenburg et Douglass concluent leurs études en encourageant la recher che éventuelle sur la spécificité des items.

9

partir d'items oû la spécificité tient à l'ajout d'une description opéra tionnelle des traits mesurés nous semblait être une initiative intéressan te méritant d'être évaluée. Une consultation des différents rapports rédi gés sur l'élaboration et les expérimentations du questionnaire PERPE nous permettait de croire qu'aucune étude sur l' e ff e t des descriptions opéra tionnelles dans PERPE Secondaire n'avait été réalisée auparavant. S 'i l s'avérait que les descriptions opérationnelles modifient les réponses fournies par les élèves, nous saurions s ' i l est pertinent et efficace d'u t i l i s e r des items spécifiques dans les questionnaires d'évaluation de

cours. Cette étude concerne la validité des questionnaires puisque l'on

considère qu'un instrument de mesure est valide s ' i l mesure bien ce qu'il prétend mesurer. Or si une telle forme d'item nous permettait de recueil l i r des informations plus justes, il faudrait alors reconsidérer la natu re des items dans les questionnaires d'évaluation de cours. Aussi, peu importe les conclusions que nous devions en t i r e r , elles devraient a t t i rer l'attention de ceux qui s'intéressent à l'évaluation des cours et plus précisément ceux qui travaillent à l'élaboration et à l'amélioration des instruments de mesure dans ce domaine.

Dans la seconde section de ce chapitre, il sera question de l ' é valuation des cours réalisée à l'aide de questionnaires alors que dans la troisième et dernière section, nous présenterons le questionnaire PERPE Secondaire c'est-â-dire la façon dont il a été développé et les expérimen tations auxquelles il a été soumis pour en arriver à la forme qu'on lui connaît maintenant.

C'est autour des années 1920 qu'on a commencé à se préoccuper de la question de l'évaluation des cours et de l'enseignement. Doyle (1983) mentionne qu'au début des années 1920, un groupe d'étudiants de l'Univer

sité Harvard aux Etats-Unis avait mis sur pied le Confidential Guide to Courses destiné â aider les étudiants dans le choix de leurs cours. Doyle prétend que c'est cependant depuis 1960 et plus parti culièrement depuis les dix dernières années que s'est grandement développée cette pra tique qui consiste à inviter les étudiants â la fin d'un semestre ou d'u ne année scolaire â évaluer les cours qu'ils ont suivis et par le fait même les professeurs qui leur ont dispensé ces cours. En 1969, Spencer et Aleamoni développaient dans ce domaine un instrument qu'ils appelèrent: The Ill i n o i s Course Evaluation Questionnaire. Par la suite certains au teurs, par exemple Bolton (1973), Miller (1972,1974), Page (1974), Grasha

(1977), Centra (1979) et Millman (1981) se sont penchés parti culiêrement sur cette question et ont publié des livres sur l'évaluation de l'e n se i

gnement. L'évaluation des cours constitue une démarche qui est encoura

gée par beaucoup de professeurs soucieux de vérifier la qualité de leur

enseignement. Les informations qu'ils recueillent au moyen de question

naires d'évaluation de cours peuvent en principe les aider à améliorer leur enseignement. De plus, selon Gage (1958), Werdell (1967) et Doyle

(1975), les questionnaires d'évaluation de cours permettraient d'identi f i e r des critères susceptibles d'orienter la recherche sur l'enseignement. b) Evaluation de cours à 1 'aide de questionnaires

-11

sées en évaluation de cours par exemple l'évaluation des professeurs par des superviseurs, l'auto-évaluation des professeurs ou encore l'évaluation des professeurs basée sur l'amélioration ou le succès des élèves 5 des tests de rendement académique. Doyle (1983) prétend que l'évaluation des professeurs peut aussi être faite par des collègues de travail, d'autres professeurs ou même par des assistants. Centra (1979) soutient cependant qu'au cours de la dernière décennie, cette forme d'évaluation a été rem placée par une démarche beaucoup plus systématique qui consiste en une ë- valuation des cours par les élèves à l'aide de questionnaires. Denton

(1977) semble croire que la façon la plus populaire et finalement la plus juste de procéder à l'évaluation d'un cours consiste à r e c u e illir l ' i n f o r

mation auprès des étudiants eux-mêmes. Aussi les étudiants jouent-ils

un rôle important â ce niveau-ci puisque ce sont sur les informations qu'ils fournissent que sont susceptibles de se baser les professeurs sou haitant v é ri fier la qualité de leur enseignement et aussi les administra teurs des institutions d'enseignement rattachés à la supervision du per sonnel enseignant.

Dans les questionnaires d'évaluation de cours, on cherche habi tuellement 5 évaluer les points suivants: la précision, la clarté et l ' u t i l i t é des objectifs du cours, l'i n té rêt des étudiants pour le cours ou pour la matière, le climat de la classe, la quantité de travail exigée, la méthode d'enseignement du professeur, la pertinence des lectures sug gérées ou obligatoires, l'organisation et le contenu du cours, la d i f f i culté de la matière, la pertinence et la fréquence des contrôles ou exa mens, le matériel didactique, les livres de base, de référence, la

prêpa-ration du professeur, sa disponibilité, la compétence du professeur dans sa matière, la sévérité du professeur dans la correction des travaux et des examens, le type de relation professeur-élèves, la variété des métho des pédagogiques, l'humeur, la patience du professeur, etc. On tente en somme d'évaluer toutes sortes de caractëristiques propres au professeur lui-même ou des aspects d'un cours jugés comme étant importants.

Certains questionnaires d'évaluation de cours comportent des questions ouvertes. L'avantage de cette forme de question est que le ré pondant a la possibilité d'organiser lui-même sa propre réponse. Doyle

(1983) mentionne un autre type d'item qui est parfois u t il isé dans des

questionnaires d'évaluation de cours. Il s'agit d'items à choix forcés,

par exemple: "Le professeur est: a)amical; b)stimulant; c)compétent;

d)dynamique". Le répondant, en l'occurrence l'étudiant est contraint de choisir la réponse qui correspond la mieux à la perception qu'il a de son professeur sans toutefois qu'une réponse soit plus favorable qu'une autre. Cependant la plupart des questionnaires d'évaluation de cours sont compo sés d'items comportant une échelle d'appréciation se situant sur un con tinuum et le répondant choisit sur ce continuum la réponse qui correspond la mieux à sa perception, son jugement ou son opinion. On les appelle des échelles de Likert.

Les items dont les échelles de réponses sont construites sur le principe de l'échelle de Likert comportent de multiples avantages. Doyle

(1983) rappelle que les réponses fournies à ce type d'item sont faciles à compiler et à analyser statistiquement; ces items sont efficaces en ce

13

sens qu'ils permettent de r e c u e i l l i r facilement beaucoup d'information; i l s sont structurés de façon â permettre au répondant de fournir une ré ponse qui devrait correspondre assez bien à sa perception. Ainsi les ê- chelles de Likert dans des questionnaires d'évaluation de cours permet tent d'identifier le degré de satisfaction des étudiants d'une classe par rapport à des aspects précis d'un cours ou à des comportements d'un professeur.

Quoique certains facteurs tels que la réputation d'un professeur, l' in té rêt que les élèves portent pour la matière, le rendement académique des élèves ou leur attitude générale envers l'école peuvent influencer leur façon de répondre à des questionnaires d'évaluation de cours, il n'en demeure pas moins que ce type d'instrument permet de re c u e illir des infor mations intéressantes et utiles sur la qualité de l'enseignement.

Dans la troisième et dernière section de ce chapitre, nous a l lons présenter la façon dont les auteurs de PERPE Secondaire ont élaboré cet instrument.

Le questionnaire PERPE Secondaire (perception étudiante de la relation professeur-étudiants) est un questionnaire d'évaluation de cours par les étudiants développé en 1972 par messieurs Paul Pierre et Michel Mailhot, deux chercheurs qui faisaient 3 cette époque partie de l'INRS-

Education. Ce questionnaire se définit comme un instrument de mesure per

mettant aux professeurs de recevoir un feedback de leurs élèves sur les

cours qu'ils dispensent et sur leur mode d'enseignement. L'élaboration

de ce questionnaire et l'accomplissement du projet PERPE résultent du tra vail d'une équipe qui a duré plusieurs années. Le questionnaire PERPE Secondaire a été construit selon la même forme que le test PERPE Général qui avait été développé auparavant par Françoys Gagné qui se trouvait éga lement à 1 ' INRS-Education. Voyons maintenant la façon dont a été déve

loppé cet instrument et les qualités psychométriques qu'on lui attribue.

Le questionnaire PERPE Secondaire comporte 40 items de type Li- kert touchant chacun un aspect jugé important de la situation pédagogique au secondaire. On se souvient que chaque item est composé:

-d'un t it r e écrit en majuscules;

- d'une description opérationnelle de l'aspect 3 mesurer;

- d'une échelle d'évaluation en cinq points oû chaque point est décrit; - de deux questions dont l'une mesure la perception des étudiants de la

réalité (question A) et la seconde mesure les attentes des étudiants (question B).

L'élève doit répondre aux deux questions sur une feuille-répon ses.

C'est selon cette formule-ci qu'avaient été rédigés les items du test PERPE Général. L'idée d'opter pour cette forme d'item, c'est-à-

dire un t i t r e suivi d'une description de l'aspect mesuré, était intuitive ment venue aux chercheurs li é s au projet PERPE parce qu'ils croyaient qu' fournissant une description opérationnelle d'une attitude ou d'un compor tement, cela permettrait d'assurer une compréhension plus univoque de la réalité qui est objet de mesure. Cependant lorsque le test PERPE Général a été révisé de façon à devenir le questionnaire que l'on connaît mainte nant sous le nom de PERPE Supérieur, cette forme d'item a été abandonnée. Il faut toutefois préciser que les descriptions opérationnelles figurant dans le test PERPE Général étaient généralement plus élaborées que celles

qu'on retrouve dans PERPE Secondaire. Voici ce que mentionne l'auteur

Françoys Gagné (1977) au sujet de la rédaction révisée du PERPE Général:

Premièrement, les définitions opérationnel

les furent considérablement raccourcies. En

effet, plusieurs descriptions utilisaient des expressions souvent redondantes ou encore faisaient appel à des synonymes plus ou moins adéquats; sans compter que la lecture des i- tems allongeait inutilement le temps de pas

sation. Deuxièmement, le titrage des items

était abandonné, non seulement parce que les descriptions plus courtes rendaient ces t i tres inutiles, mais aussi parce que plusieurs commentaires reçus montraient que certains ë- tudiants ne lisa ient pas les descriptions, mais se référaient aux seuls titres pour iden t i f i e r les contenus à évaluer, (p. 8)

C'est ainsi que cette forme d'item utilisée dans le PERPE Géné ral fut abandonnée. Le questionnaire PERPE Supérieur que l'on util is e aujourd'hui existe en deux versions. La version longue comporte 45 items et la version abrégée compte les 18 items jugés les plus importants

par-mi les 45 items de la version longue. Le PERPE Supérieur s'adresse aux

niveaux collégial et universitaire. Les items de ce questionnaire ne com

portent ni t i t r e , ni description opérationnelle. I ls consistent en de courtes phrases â l'i n tér ieu r desquelles on a tenté d'inclure l'essentiel

des descriptions opérationnelles. Chaque item touche un aspect du cours

ou une attitude du professeur et l'échelle d'appréciation qui était une échelle de Likert en cinq points dans le PERPE Général a été modifiée de façon â devenir une échelle en sept points dans la nouvelle version PERPE

Supérieur. Permettons-nous de présenter en guise d'exemples deux items

du PERPE Général et la manière dont i l s ont été reformulés de façon â ap paraître dans la version PERPE Supérieur.

Premier exemple:

CONTENU SUBSTANTIEL: le professeur qui présente "un contenu substantiel" est celui dont on a l'impression qu'il u t ilis e pleinement le temps mis a

sa disposition. Il procède en allant directement â l'essentiel plutôt

qu'en couvrant superficiellement ou en périphérie les contenus abordés. 1. Contenu RAREMENT substantiel

2. Contenu OCCASIONNELLEMENT substantiel 3. Contenu SOUVENT substantiel

4. Contenu TRES SOUVENT substantiel 5. Contenu' TOUJOURS substantiel

C'est exactement ainsi qu'était présenté l'item dans le PERPE Général. Dans la nouvelle version PERPE Supérieur, cet item se l i t maintenant de la façon suivante:

17

Deuxième exemple:

STRUCTURATION: i l s'agit d'évaluer ici le degré d'organisation interne du contenu présenté. La présence d'une telle charpente se manifeste par le degré d'enchaînement des sections, le respect d'un plan de présentation, la présence de fréquentes subdivisions.

1. Contenu TRES PEU structuré 2. Contenu PEU structuré

3. Contenu PARTIELLEMENT structuré 4. Contenu STRUCTURE

5. Contenu TRES structuré

Dans le PERPE Supérieur, cet item a été reformulé de la façon suivante:

Ce cours est structuré, charpenté (ce professeur suit un plan détaillé) .

Le questionnaire sur lequel repose notre étude c'est-à-dire le PERPE Secondaire n'a cependant jamais été révisé contrairement au PERPE Général. C'est pourquoi il a conservé la forme qu'on lui connaît oû cha que item comporte un t i t r e , une description et une échelle d'évaluation en cinq points suivie des questions A et B que nous avons mentionnées pré cédemment. Il se trouve à être construit de la même manière que l'a va it été le PERPE Général. Décrivons maintenant la démarche qu'ont suivie les auteurs du PERPE Secondaire pour construire leur questionnaire.

La construction d'un instrument de mesure tel qu'un questionnai re d'évaluation de cours se structure sur la base du choix des items, de la rédaction de la question et de l'échelle ainsi que sur la validation

de l'instrument. Pour rédiger les items du questionnaire, les auteurs ont eu recours à trois sources d'information soit: la littérature sur le sujet, un sondage auprès des élèves de niveau secondaire et un sondage auprès des professeurs du niveau secondaire.

Dans un premier temps, les chercheurs ont retrouvé dans la l i t t é rature des questionnaires d'évaluation de cours de même que des l is t e s é- tablies par des auteurs sur les qualités d'un professeur et sur les élé ments de sa compétence. Quelque 130 items différents ont ainsi été re c u e i l l i s et retenus après que la sélection eût été effectuée.

Les chercheurs ont par la suite effectué un sondage auprès d'é tudiants de niveau secondaire auxquels on posait la question suivante:

"Quels sont les éléments de la situation de classe qui sont importants pour vous comme des qualités du professeur, des éléments de comportements etc.?". Environ 2700 élèves ont été rejoints par cette consultation. De

ce sondage, 198 items différents ont été retenus.

Le sondage auprès des professeurs leur posait la même question que celle qui avait été posée aux élèves. Une centaine de professeurs ont collaboré à cet effet. De ce sondage, 81 items différents ont été retenus.

Les chercheurs se retrouvèrent ainsi avec une banque d'items dont l'épuration les a conduits à l'établissement d'un questionnaire ap pelé "Pertinence et Importance" regroupant les 100 items qu'ils jugeaient

19

les plus importants.

Le questionnaire "Pertinence et Importance" a été soumis 3 un groupe d 'évaluateurs constitués d'ëlêves et de professeurs auxquels on de mandait de se prononcer sur la pertinence et sur le degré d'importance de chacun de ces items en ce qui concerne l'évaluation de différents as

pects de l'enseignement. Les chercheurs ont par la suite conservé les items qui avaient été jugés comme étant les meilleurs du questionnaire "Pertinence et Importance" pour construire leur instrument qu'ils dési raient établir 3 une quarantaine de questions environ.

Pour composer leur questionnaire, les auteurs privilégiaient des items rédigés de façon précise. A ce sujet d'ailleurs Paul Pierre et al. (1973) mentionnent: "Il est essentiel de donner une définition aussi simple, précise et restrictive que possible, dans le but d'assurer que les sujets comprennent tous la même chose", (p. 10). I ls ont également tenu 3 faire analyser la langue et le vocabulaire utilisés dans les des

criptions et les échelles de réponses par deux professeurs de français

afin de s'assurer que la formulation des items soit bien adaptée au n i veau secondaire. Pour constituer les échelles de réponses des items, i l s ont établi des échelles de Likert formulées soit en terme d'intensité lorsqu'il s'agit d'évaluer une qualité soit en terme de fréquence lo rs

qu'il s'agit d'évaluer un comportement. Illustrons par deux exemples en

Premier exemple:

COURS INTERESSANT

Sans évaluer le contenu du cours, cette question veut mesurer si les cours de ce professeur sont intéressants, vous semblent passer vite, ou s i , au contraire, i l s vous semblent "plattes", monotones, interminables.

1. Cours TRES monotones 2. Cours ASSEZ monotones

3. Cours PLUS OU MOINS intéressants 4. Cours ASSEZ intéressants

5. Cours TRES intéressants

Deuxième exemple:

QUESTIONS DU PROFESSEUR

Il s'agit ici de mesurer si ce professeur pendant ses cours pose des ques tions aux élèves pour v é ri fier s ' i l s comprennent bien.

1. Questions TRES RARES 2. Questions RARES

3. Questions OCCASIONNELLES 4. Questions FREQUENTES 5. Questions TRES FREQUENTES

Dans le premier exemple, on cherche à évaluer la qualité des cours, aussi les auteurs ont-ils construit un ensemble de réponses sous

forme d'une échelle d'intensité. Dans le deuxième exemple cependant,

comme il s'agit plutôt de mesurer un comportement, i l s ont opté pour une échelle de fréquence.

question-21

naire PERPE Secondaire qualifiée de "forme expérimentale I". Par la su i te, deux autres formes du questionnaire appelées "forme expérimentale II" et "forme expérimentale I II " ont été créées et expérimentées également. Au total, plus de 500 classes de différents niveaux secondaires ont expé rimenté le questionnaire à un moment ou l'autre des trois phases du

pro-A la suite de chacune des expérimentations, certaines analyses statistiques ont été effectuées , notamment des distributions de fréquences, des moyennes, des analyses factorielles ainsi que des mesures d'écarts

entre les réponses à la question A et celles à la question B. Lors de l'analyse des résultats, les chercheurs ont vérifié si les items ainsi formulés permettaient de bien discriminer les professeurs lorsqu'ils sont évalués sur des aspects précis. I ls ont également voulu s'assurer que les items donnaient lieu â une certaine cohésion entre les élèves qui é- valuent un professeur. Pour ce fair e, i l s ont vérifié s i , dans l'ensem ble, les élèves avaient tendance à évaluer leur professeur ou un aspect particulier d'un cours à peu près de la même façon.

Suite à l'analyse des résultats de chacune des expérimentations, des corrections ont été apportées au questionnaire telles que la dispa rition de certains items, la reformulation d'autres items, des modifica tions de l'échelle d'appréciation et des changements au niveau de 1'or dre séquentiel des items dans le questionnaire.

ef-fectués et les chercheurs se disaient satisfaits de la fidélité de l ' i n s trument fina l.

L'objectif du questionnaire PERPE Secondaire était donc de mesu rer la satisfaction ou l'insatisfaction des étudiants sur une série de questions se rapportant au comportement ou à l'attitude du professeur vis- à-vis de ses élèves. Comme les chercheurs ont fouillé la littérature pour identifier les différents aspects sur lesquels les professeurs sont habituellement évalués et que par surcroît i l s ont consulté professeurs et élèves pour connaître leur avis sur la question, i l s ont conclu que leur questionnaire représentait un échantillon valide de l'univers des éléments sur lesquels on évalue généralement les professeurs. La v a l i d i té de contenu de leur instrument leur a semblé très.satisfaisante.

Le questionnaire PERPE Secondaire qui est présentement u t ilis é au secondaire constitue la quatrième forme de la série. Ce questionnai

re s'applique à l'enseignement traditionnel en classe. Le questionnaire

comporte 40 items qui ont été regroupés en quatre sections: 17 items por tent sur l'organisation de la matière, la préparation du professeur, la présentation et la structure du cours; 14 items portent sur les relations interpersonnelles entre le professeur et ses élèves; 5 items ont tr a it 5 la maîtrise de soi du professeur et aux mesures de discipline en classe. Enfin quelques items concernent les méthodes d'enseignement qu'utilise le professeur.

troisième chapitre sera consacré à l'analyse des données de 1 1 expérimen tation. Nous procéderons alors à la comparaison des moyennes et des écarts-types des items aux deux formes du questionnaire en tentant d'ex pliquer les résultats que nous avons obtenus. Enfin, le quatrième cha pitre permet de conclure notre rapport de recherche.

METHODOLOGIE

L'objectif de ce chapitre est de présenter comment nous avons procédé pour réaliser notre expérimentation c'est-à-dire la cueillette des données et la constitution de notre échantillon. Dans la première section de ce chapitre, nous allons présenter l'expérimentation propre ment dite alors que dans la seconde, nous décrirons.1‘échantilion.

a) Expérimentation

On se souvient que nous avons produit deux formes du question naire. La forme 1 constitue la forme originale du questionnaire alors que la forme 2 représente la forme modifiée. Cette seconde forme compor te tous les mêmes titre s d'items et les mêmes échelles de réponses sans

toutefois les descriptions opérationnelles. Les deux formes du question

a ce que tous les questionnaires aient en quelque sorte la même apparence

La cueillette des données devait bien sûr se réaliser dans des écoles secondaires puisque c'est au niveau de l'enseignement secondaire que s'adresse le questionnaire PERPE que nous avons u t i l i s é i c i . Nous avons choisi de façon arbitraire de limiter notre cueillette de données à la cinquième année du secondaire.

Pour réaliser notre expérimentation, nous avons contacté une d i zaine de professeurs de secondaire V. Nous leur avons exposé l' obje ctif de notre étude et présenté brièvement les différentes étapes de celle-ci après quoi nous leur avons demandé s ' i l s accepteraient que l'on distribue notre questionnaire dans un de leurs groupes d'élèves. Pour susciter la collaboration des professeurs, nous avons proposé de leur fournir par la suite la compilation des données recueillies dans leur classe. Les pro fesseurs contactés ont tous accepté de collaborer avec nous.

Surtout pour élargir la portée de nos conclusions, il importait que les cours que nous évaluions au moyen de notre questionnaire soient des cours rattachés a différentes matières. Notre questionnaire a ainsi été distribué dans des groupes de différentes matières.

Pour pouvoir étudier l' e f f e t des descriptions opérationnelles sur la moyenne et 1'écart-type des items du questionnaire, nous avons dis tribuê au hasard les copies de façon à ce que dans chaque groupe, une moitié d'élèves reçoive la forme 1 du questionnaire et l'autre moitié la

forme 2. Les deux formes du questionnaire ont ainsi été distribuées dans dix groupes de différentes matières de secondaire V. C'est la même per sonne qui a administré le questionnaire dans tous les groupes. Voici en quoi consistent les directives que l'administrateur a lues 3 haute voix dans chacun des groupes:

Mon nom est Joanne Dubé et je suis présente ment étudiante à l'Université Laval. Je vous invite aujourd'hui 3 répondre 3 un question naire visant 3 évaluer le cours que vous sui vez habituellement 3 cette période-ci. Il n'y a ni bonnes ni mauvaises réponses. A cha cun des items du questionnaire, choisissez la réponse qui correspond la mieux 3 votre

opinion. N'oubliez pas d'inscrire votre âge

et votre sexe sur la feuille-réponses. S'il y avait parmi vous certains élèves qui pour

suivent des études en secondaire IV plutôt qu'en secondaire V, veuillez s ' i l vous plaît l ' i n s c r i r e dans le coin droit de votre f e u i l le-réponses. Même si je ne vous demande pas d'inscrire votre nom sur la copie que vous recevrez, je vous demande de répondre au ques tionnaire avec tout le sérieux dont vous êtes capables et toute la franchise dont vous sa vez faire preuve.

Au questionnaire original, nous avions toutefois apporté la mo dification suivante. On se souvient que dans le questionnaire PERPE Se condaire, on demande aux élèves de répondre 3 deux questions. La ques tion A qui a t r a i t 3 la perception qu'ont les élèves de leur professeur se l i t comme suit: Où situez-vous ce professeur (ce cours) sur l'é ch el le d'évaluation? La question B qui cherche plutôt 3 mesurer les attentes des élèves se formule ainsi: SI VOUS N'ETES PAS SATISFAIT(E), oû devrait-il se situer pour que vous soyez s a t i s f a i t ( e ) ? Pour les fins de notre recherche, nous avons posé aux élèves seulement la question A, notre

in-27

tention n'étant pas de juger de l'é ca rt entre les réponses à la question A et celles à la question B pour connaître le degré d'insatisfaction des élè ves mais bien de vé rifier s ' i l y a un écart entre les réponses fournies â la forme 1 du questionnaire et celles fournies à la forme 2. Il ne deve nait pas nécessaire pour les fins que nous poursuivions de mesurer les

attentes des élèves et c'est pourquoi nous avons laissé tomber la question B. Le questionnaire comportait également certaines informations de même que des directives écrites mentionnées en première page. Les deux formes du questionnaire figurent à l'appendice A.

La passation du questionnaire s'est déroulée à chaque fois dans de bonnes conditions caractêrisées par le calme, la discipline et un c l i mat de collaboration. La tâche que nous avons demandée aux élèves d'ac complir ne semble pas les avoir contrariés et de façon générale le ques tionnaire a été bien accueilli.

La passation du questionnaire nécessitait de 20 à 30 minutes. Nous avons remarqué que les élèves ayant reçu une copie de la forme 1 du questionnaire prenaient un peu plus de temps pour répondre que ceux ayant reçu une copie de la forme 2. Cette constatation ne nous étonne en rien puisque la forme 1 est celle qui contient les descriptions opérationnelles.

La passation du questionnaire a eu lieu dans deux écoles publi ques de la Commission Scolaire Régionale de T i l l y situées dans la v i l l e de Sainte-Foy.

Nous avons rejoint dix groupes d'élèves poursuivant des études

en secondaire V. Notre échantillon compte deux groupes de physique (grou

pe 01 et 02), deux groupes de mathématique (05 et 08), deux groupes de français (09 et 10), un groupe de géographie (03), un d'histoire (04), un de chimie (06) et un d'anglais (07).

L'ensemble de l'échantillon regroupe 255 élèves. L'échantillon

compte 132 garçons, 116 f i l l e s et 7 élèves ont omis d'identifier leur se xe sur la feuille-réponses. Tous les groupes sont mixtes. Un peu plus de la moitié des élèves ont 17 ans, près du tiers des élèves ont 16 ans et quelques élèves ont 15, 18 ou 19 ans. Il importe toutefois de préci ser que parmi les 255 élèves de l'échantillon, 23 sont des élèves qui poursuivent des études en secondaire IV plutôt qu'en secondaire V et qui

se répartissent dans les différents groupes de l'échantillon. Cela s'ex

plique par le f a i t que parfois certains élèves sont de niveau quatrième secondaire en ce qui concerne les cours obligatoires mais suivent un cours optionnel par exemple de chimie, de géographie ou d'histoire avec des étu diants de secondaire V. Nous ne tiendrons cependant pas compte de cette distinction puisque nous ne jugeons pas qu'elle soit d'une importance p r i mordiale pour les besoins de l'étude. En effet nous ne croyons pas qu'il b) Description de l'échantillon

s'agisse d'une variable susceptible d'influencer sensiblement les résul tats.

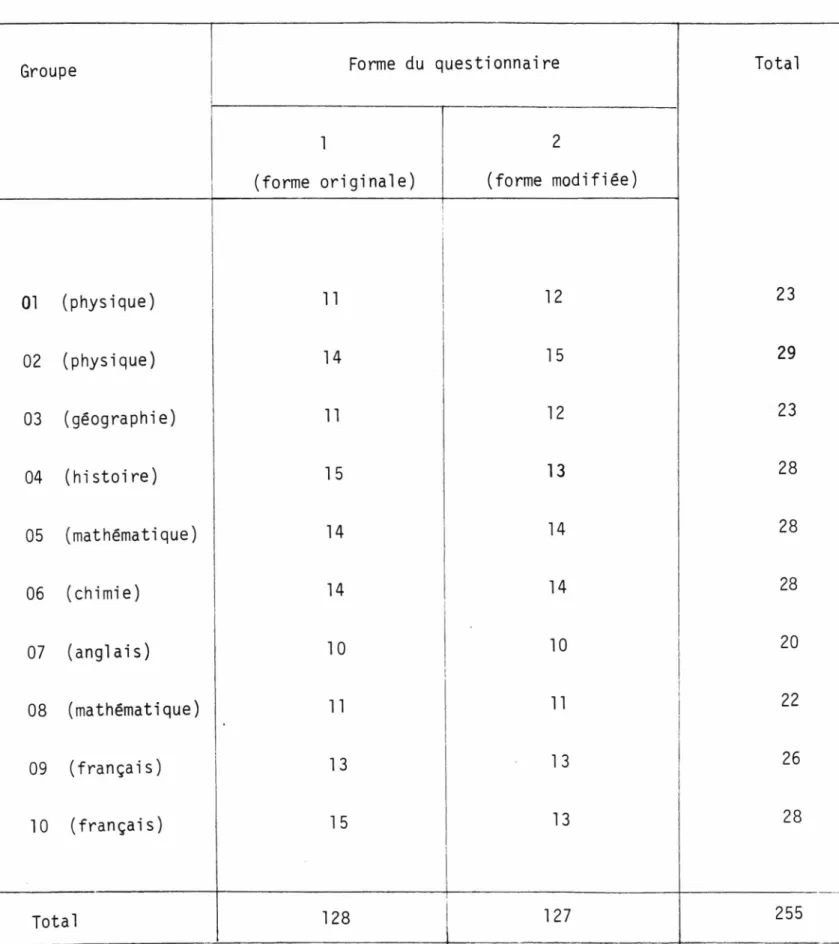

Le tableau 2.1 présente la répartition des élèves selon la for me du questionnaire qu'ils ont reçue et selon le groupe auquel i l s appar

tiennent. Ceci complète la description de notre échantillon.

Le prochain chapitre présentera l'analyse des résultats c'est-à dire la comparaison des moyennes et des êcarts-types des items aux deux formes du questionnaire.

Tableau 2.1: Répartition des élèves selon la forme du questionnaire et selon le groupe d'appartenance

Groupe Forme du questionnaire Total

1 (forme originale) 2 (forme modifiée) 01 (physique) | 11 12 23 02 (physique) 14 15 29 03 (géographie) 11 12 23 04 (histoire) 15 13 28 05 (mathématique) 14 14 28 06 (chimie) 14 14 28 07 (anglais) 10 10 20 08 (mathématique) 11 11 22 09 (français) 13 13 26 10 (français) 15 13 28 Total 128 127 255

CHAPITRE III

ANALYSE DES DONNEES

a) Introduction

Nous avons conduit cette recherche dans le but de vérifier si l'ajout des descriptions opérationnelles dans PERPE Secondaire modifie les réponses que les élèves fournissent au questionnaire. Nous nous de mandions également si le fait que les items soient plus spécifiques en traînait une compréhension plus homogène des traits évalués. Le but du troisième chapitre est donc de présenter et d'analyser les données re cuei llies lors de l'administration du questionnaire. Nous allons d'abord rappeler la façon d'étudier l'influence des descriptions opérationnelles sur les réponses des élèves et présenter les résultats sommaires de l'expé rimentation. Dans la seconde section du chapitre, nous procéderons à une étude plus détaillée de la comparaison des moyennes aux deux formes du questionnaire alors que dans la troisième section, nous nous pencherons sur la comparaison des écarts-types.

tionnaire (forme 1) aux résultats obtenus à la forme modifiée (forme 2) à l'in té r ie u r de laquelle les descriptions ont été omises. Essentielle ment, il s'agit de comparer pour chaque item, la moyenne obtenue à la for me 1 du questionnaire à la moyenne obtenue à la forme 2 et l'écart-type obtenu à la forme 1 à celui obtenu 3 la forme 2, et ce pour chacun des

dix groupes de l'échantillon. En consultant l'appendice B, le lecteur

peut retrouver les tableaux des moyennes et des écarts-types des 40 items aux deux formes du questionnaire pour chacun des dix groupes de l'échan tillon de même que le nombre d'élèves qui ont reçu chacune des deux for mes. En principe, le nombre d'élèves ayant reçu la forme 1 du question naire et le nombre d'élèves ayant reçu la forme 2 devrait être constant à l'i n té rieur d'un même groupe; cependant il arrive parfois que certains élèves s'abstiennent de répondre à un ou quelques items, c'est la raison pour laquelle on remarque dans l'appendice B certains écarts au niveau du nombre d'élèves. Avant d'entreprendre l'analyse des résultats de l ' e x périmentation, nous allons préciser comment nous avons procédé pour éta b lir la comparaison des items aux deux formes du questionnaire.

Le travail préliminaire 3 la comparaison des moyennes s'est ef fectué de la façon suivante. Dans chaque groupe, nous avons soustrait

la moyenne de l'item obtenue a la forme 2 de la moyenne obtenue à la for me 1. Nous avons effectué ce calcul pour chacun des 40 items du question naire et ce, pour chacun des dix groupes de l'échantillon. Ainsi ont été calculées toutes les différences de moyennes des items pour chacun des groupes et elles ont été arrondies 3 deux décimales près. Certaines

sous-33

tractions ont donné lieu 3 des différences positives et d'autres 3 des différences négatives.

Par la suite, il nous a fallu décider de ce que nous allions con

sidérer comme une différence sensible entre deux moyennes. Cette décision

est fonction de l'échelle d'appréciation que constitue l'ensemble de ré ponses. Comme l'échelle varie de 1 â 5 inclusivement, il nous apparais sait qu'une différence de 0,50 entre la moyenne d'un item à la forme 1 et la moyenne d'un item à la forme 2 pouvait être considérée comme une d i f férence sensible, Ta mesure de 0,50 constituant exactement la moitié d'un

intervalle entre deux réponses consécutives. Ainsi ont été considérées

comme différences sensibles de moyennes toutes les différences de moyen nes étant supérieures ou égales â +0,50 ou encore inférieures ou égales à -0,50.

Par a ille u r s , afin d'étudier l'influence des descriptions opéra tionnelles sur la dispersion des résultats, nous avons comparé les êcarts- types des items aux deux formes du questionnaire. L'écart-type constitue une mesure de variabilité et peut s ' interpréter comme étant une sorte de moyenne des écarts à la moyenne. Essentiellement il s'agit de comparer

pour chaque item l'écart-type obtenu à la forme 1 du questionnaire â ce lui obtenu 5 la forme 2.

Un travail semblable à celui fait dans le cas de la comparaison des moyennes a été effectué. Nous avons soustrait pour chaque item son écart-type obtenu â la forme 2 du questionnaire de celui obtenu â la for

me 1. Nous avons effectué cette opération sur chacun des 40 items du questionnaire au niveau des dix groupes de l'échantillon. Toutes les d i f férences d'écarts-types ont été calculées et elles ont été arrondies à deux décimales près. Tout comme dans le cas des différences de moyennes, certaines soustractions ont donné lieu à des différences positives et d'au tres à des différences négatives. Il nous a fallu par la suite décider également de ce que nous allions considérer comme une différence sensible

d'écarts-types. Il nous apparaissait qu'une différence de 0,25 entre

1'écart-type d'un item obtenu à la forme 1 et celui obtenu à la forme 2 pouvait être considérée comme une différence sensible d'écarts-types. Cette mesure correspond exactement au quart d'un intervalle entre deux ré ponses consécutives, l'ensemble de réponses étant gradué de 1 a 5. Ainsi toutes les différences d'écarts-types étant supérieures ou égales à +0,25 ou inférieures ou égales â -0,25 ont été considérées comme des différences sensibles d'êcarts-tyDes.

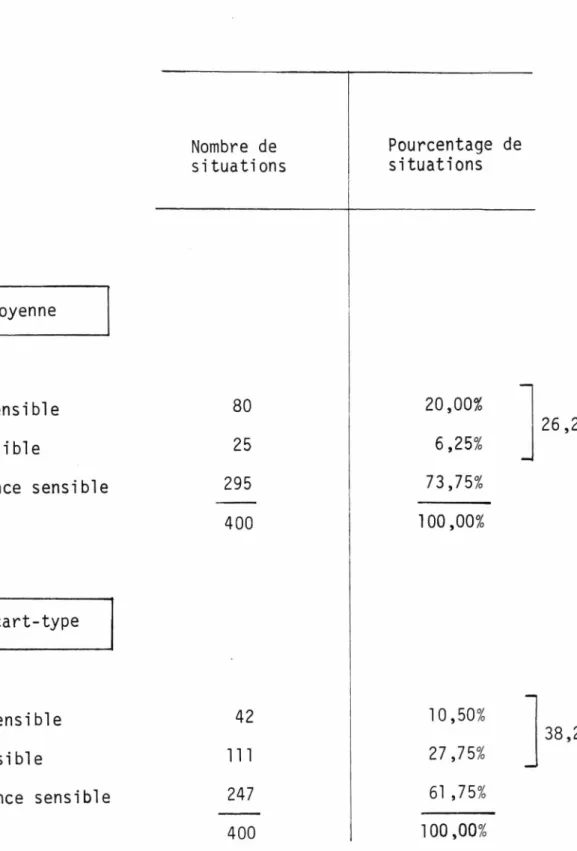

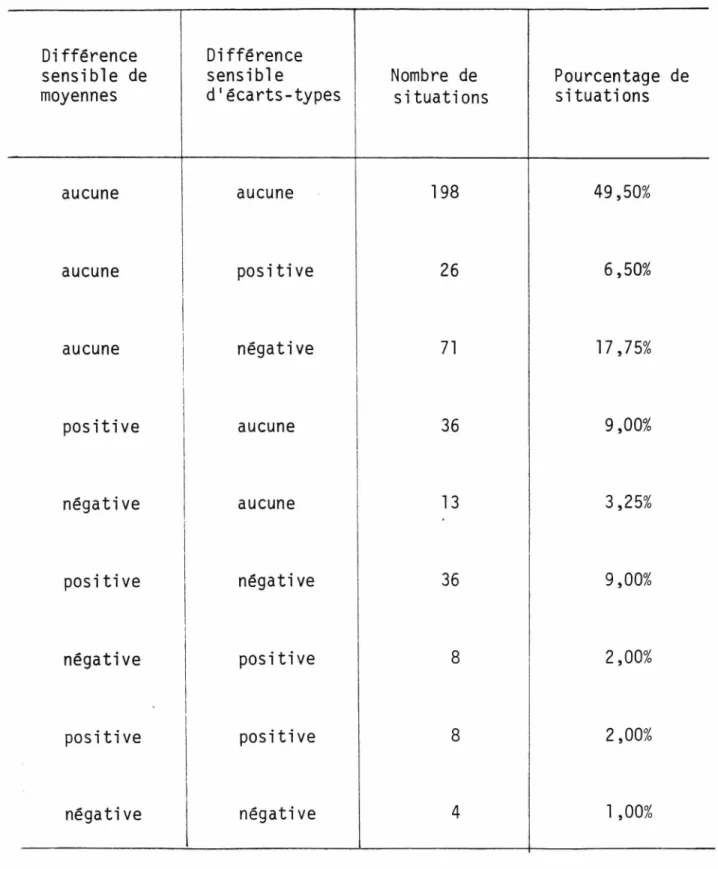

L'identification des différences sensibles de moyennes et d'écarts- types nous a amenés à construire le tableau 3.’1. Ce tableau présente la compilation des résultats en ce qui concerne les moyennes et les écarts-

types. L'analyse des informations contenues dans ce tableau permet d'étu

dier la caractéristique d'intérêt c'est-à-dire la description opération nelle du t i t r e des items.

En consultant le tableau 3.1, on constate que dans 20,00% des cas, l'ajout de la description opérationnelle a donné lieu à une augmen tation sensible de la moyenne. En effet, nous comptons 80 augmentations

35

Tableau 3.1: Effet des descriptions opérationnelles sur la moyenne

et 1'écart-type des items

Nombre de si tuati ons

Pourcentage de situations

j

Effet sur la moyenne :Augmentation sensible 80 20,00%

Diminution sensible 25 6,25%

Pas de différence sensible 295 73,75%

400 100,00%

Effet sur l'ëcart-type

Augmentation sensible 42 10,50%

Diminution sensible 111 27 ,75%

Pas de différence sensible 247 61 ,75%

400 100,00%

26,25%

sensibles de la moyenne sur une possibilité maximum de 400. D'autre part dans 6,25% des cas, la description opérationnelle a conduit â une diminu tion sensible de la moyenne. De façon générale, dans 26,25% des cas, on note une différence sensible de moyennes liée à la description opération nelle alors que dans 73,75% des cas, on n'enregistre aucune différence sensible de moyennes.

En ce qui a t r a i t à 1'écart-type, dans 10,50% des cas, la des cription opérationnelle a conduit â une augmentation sensible alors que dans 27,75% des cas, celle-ci donne lieu à une diminution sensible de 1 'écart-type. Cela signifie que dans 38,25% des cas, la description opé rationnelle entraîne une différence sensible d'ëcarts-types alors que dans 61,75% des cas, on ne note pas de différence sensible.

Les résultats contenus dans le tableau 3.1 confirment l'in flu en ce des descriptions opérationnelles â savoir que les réponses des élèves diffèrent effectivement entre la forme 1 du questionnaire et la forme 2. Les prochaines sections du chapitre présentent une étude plus détaillée des différences sensibles de moyennes et d'écarts-types.

37

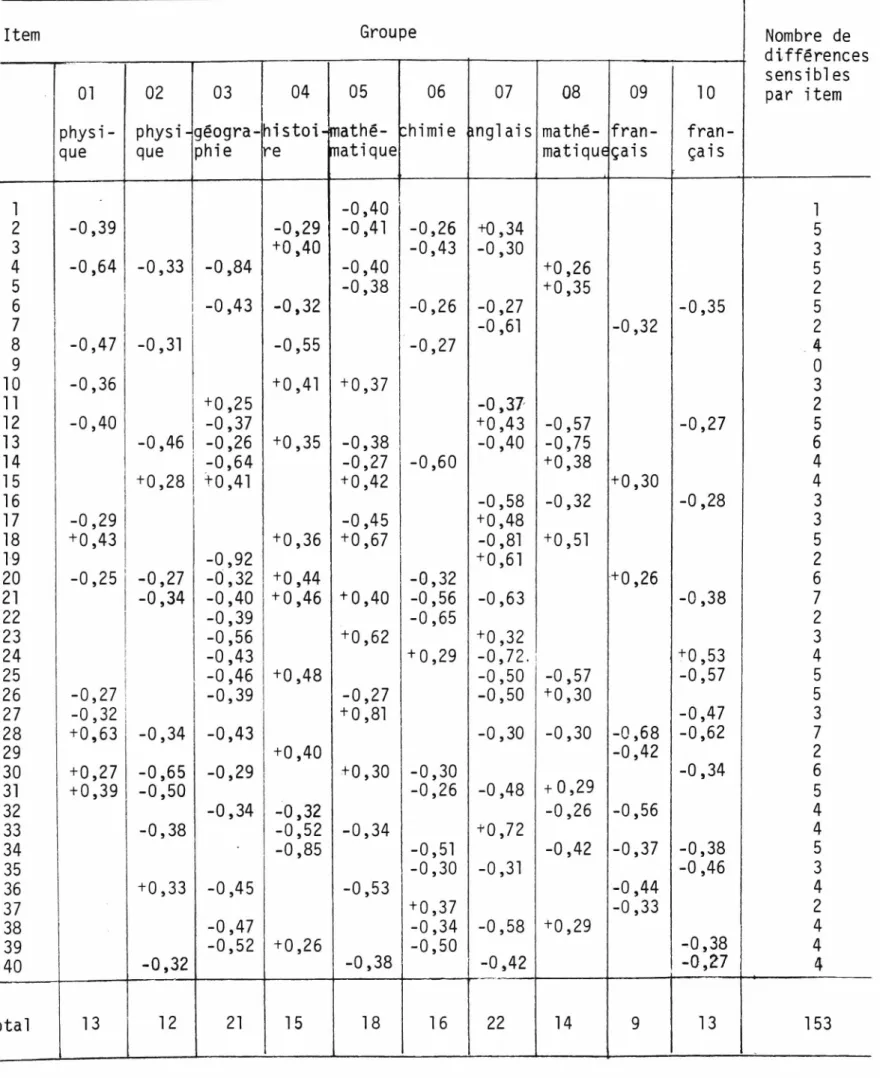

Afin d'avoir une vision un peu plus détaillée des résultats con cernant les différences sensibles de moyennes, nous avons construit le ta bleau 3.2 qui relève toutes les différences sensibles de moyennes ayant

été calculées antérieurement. Le tableau 3.2 présente les différences sen

sibles de moyennes pour chacun des 40 items du questionnaire au niveau des dix groupes de l'échantillon. La colonne de l'extrême droite présente le nombre de groupes oü l'on relève des différences sensibles de moyennes. Prenons un exemple pour mieux i l l u s t r e r la construction et la compréhen sion du tableau 3.2.

Dans la première rangée du tableau 3.2, on note une seule diffé rence sensible et elle s'est produite au niveau du septième groupe de l'échantillon. Elle correspond à une différence de -0,66 qui provient de la soustraction de la moyenne de l'item â la forme 2 du questionnaire

(3,5556) de la moyenne de l'item a la forme 1 (2,9000). On constate que -0,66 (-0,6556) correspond bien â l'une des deux conditions que nous avions fixées en guise de critère de décision. On se souvient que pour qu'une différence de moyennes soit considérée comme une différence sensible, elle devait répondre â l'une des deux conditions suivantes: soit d'être supé rieure ou égale â +0,50 ou encore d'être inférieure ou égale à -0,50. La valeur de -0,66 constitue donc pour nous une différence sensible de moyen nes. En ce qui concerne l'item 1, les différences de moyennes qu'on re trouve au niveau des autres groupes ne sont pas des différences sensibles, c'est pourquoi nous ne les retrouvons pas dans le tableau 3.2.