Analyse de sensibilité d’un multimodèle hydrologique

Mémoire

Charles Malenfant

Maîtrise en génie des eaux

Maître ès sciences (M.Sc.)

Québec, Canada

Analyse de sensibilité d’un multimodèle hydrologique

Mémoire

Charles Malenfant

Sous la direction de :

iii

Résumé

Les enjeux hydrologiques modernes, de prévisions ou liés aux changements climatiques, forcent l’exploration de nouvelles approches en modélisation afin de combler les lacunes actuelles et d’améliorer l’évaluation des incertitudes. L’approche abordée dans ce mémoire est celle du multimodèle (MM). L’innovation se trouve dans la construction du multimodèle présenté dans cette étude : plutôt que de caler individuellement des modèles et d’utiliser leur combinaison, un calage collectif est réalisé sur la moyenne des 12 modèles globaux conceptuels sélectionnés. Un des défis soulevés par cette approche novatrice est le grand nombre de paramètres (82) qui complexifie le calage et l’utilisation, en plus d’entraîner des problèmes potentiels d’équifinalité. La solution proposée dans ce mémoire est une analyse de sensibilité qui permettra de fixer les paramètres peu influents et d’ainsi réduire le nombre de paramètres total à caler. Une procédure d’optimisation avec calage et validation permet ensuite d’évaluer les performances du multimodèle et de sa version réduite en plus d’en améliorer la compréhension.

L’analyse de sensibilité est réalisée avec la méthode de Morris, qui permet de présenter une version du MM à 51 paramètres (MM51) tout aussi performante que le MM original à 82 paramètres et présentant une diminution des problèmes potentiels d’équifinalité. Les résultats du calage et de la validation avec le « Split-Sample Test » (SST) du MM sont comparés avec les 12 modèles calés individuellement. Il ressort de cette analyse que les modèles individuels, composant le MM, présentent de moins bonnes performances que ceux calés indépendamment. Cette baisse de performances individuelles, nécessaire pour obtenir de bonnes performances globales du MM, s’accompagne d’une hausse de la diversité des sorties des modèles du MM. Cette dernière est particulièrement requise pour les applications hydrologiques nécessitant une évaluation des incertitudes. Tous ces résultats mènent à une amélioration de la compréhension du multimodèle et à son optimisation, ce qui facilite non seulement son calage, mais également son utilisation potentielle en contexte opérationnel.

iv

Abstract

Contemporary hydrological challenges, such as forecasting and climate change impact evaluations, are forcing the exploration of new modeling approaches to address current gaps and improve the assessment of uncertainties. The approach discussed in this Master’s thesis is referred as multimodel (MM). The main innovation in this study lies in this multimodel construction: rather than individually calibrating the models and use their deterministic combination, a collective calibration is performed on the average of the 12 lumped conceptual models. One of the challenges of this innovative approach is the large number of parameters (82) complicating the computational cost and ease of use, in addition to potential equifinality problems. The first part of the solution proposed is based on a sensitivity analysis to determine the least significant parameters and thereby reduce the total number of parameters to be calibrated. The second part is based on an optimisation with calibration and validation to evaluate the performance of MM and its reduced version. Both lead to improve MM understanding.

Sensitivity analysis is performed with the Morris method, which reveal a version of the MM with 51 parameters (MM51) just as efficient as the original MM with 82 parameters and with decreased potential equifinality problems. Results of the calibration and validation with the "Split-Sample Test" (SST) of MM are compared with the 12 models calibrated individually. It emerges from this analysis that the MM individual models have reduced performances compared to the ones when calibrated separately. This decrease in individual performances, essential for an good overall MM performance, comes with an increase in diversity for the MM outputs. The latter is an important component of hydrological applications with uncertainty evaluation. These results lead to a better understanding of the multimodel and its optimisation, which facilitate not only the calibration, but also its potential use in an operational context.

v

Table des matières

Résumé ... iii

Abstract ... iv

Table des matières ... v

Liste des tableaux ... vii

Liste des figures ... viii

Liste des abréviations ... x

Remerciements ... xiii

1. Introduction ... 1

1.1. Mise en contexte et problématique ... 1

1.2. Objectifs et hypothèses ... 2 1.3. Plan du mémoire ... 3 2. Revue de littérature ... 4 2.1. Approche multimodèle ... 4 2.2. Analyse de sensibilité ... 8 3. Méthodologie ... 11 3.1. Modèles et multimodèle ... 11 3.2. Bassins versants ... 12 3.3. Analyse de sensibilité ... 14 3.3.1. Problème initial ... 17 3.3.2. Bornes paramétriques ... 17 3.3.3. Échantillonnage ... 17 3.3.4. Fonctions-objectif... 18 3.3.5. Méthodes d’analyse ... 19

3.3.6. Sélection et durée des périodes d’analyse ... 22

3.3.7. Bootstrap ... 23

3.4. Sélection des paramètres ... 23

3.5. Méthode de calibration ... 24

3.6. Évaluation des gains de performance ... 26

3.7. Évaluation de la diversité ... 26

vi

4. Résultats et discussion ... 28

4.1. Sensibilité des paramètres ... 28

4.2. Performances du multimodèle ... 37

4.3. Équifinalité ... 46

5. Conclusion ... 48

Bibliographie ... 51

Annexe A – Tableau des paramètres ... 58

Annexe B – Méthode de Sobol (exemple) ... 61

Annexe C – Méthode de Morris (exemple) ... 65

Annexe D – Sélection des périodes ... 69

Annexe E – Résultats des analyses ... 71

Annexe F – Résultats pour le scénario #1 (20BV) ... 84

vii

Liste des tableaux

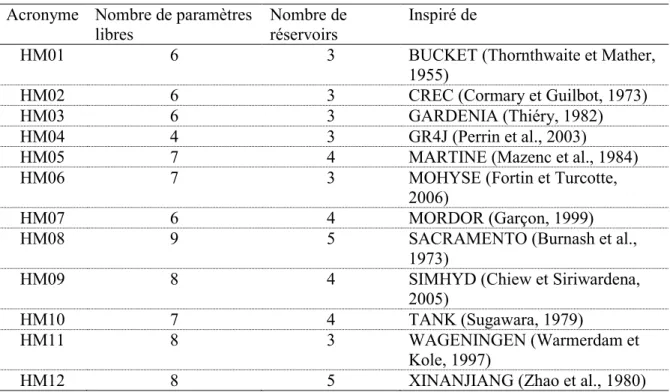

Tableau 1 – Liste des modèles ... 12

Tableau 2 – Caractéristiques hydroclimatiques des 20 bassins versants étudiés, établies à partir des données quotidiennes disponibles de 1948 à 2002 ... 13

Tableau 3 – Présentation des trois scénarios de seuil ... 23

Tableau 4 – Présentation des trois scénarios de seuil et les résultats associés ... 37

Tableau 5 – Gain (r2, en %) en validation pour les différentes versions du MM, pour les 20 BV. ... 41

Tableau A1 – Liste des paramètres du multimodèle ... 58

Tableau B1 – Paramètres du modèle HM04 et leurs bornes ... 61

Tableau B2 – Résultats pour l'exemple de Sobol (HM04, BV01, N = 10) ... 64

Tableau B3 – Résultats pour l'exemple de Sobol (HM04, BV01, N = 5000) ... 64

Tableau C1 – Échantillon-exemple pour HM04 (r = 10, k = 4 paramètres) ... 65

Tableau C2 – Résultats de HM04 pour les 50 jeux de paramètres (fonction-objectif NSEsqrt) ... 66

Tableau C3 – Effets élémentaires des 4 paramètres de HM04 (r = 10) ... 67

Tableau C4 – Résultats pour l'exemple de la méthode de Morris ... 67

Tableau D1 – Résultats pour la sélection des périodes ... 70

Tableau E1 – Résultats de l'analyse de sensibilité (médiane des 20 BV) ... 71

Tableau E2 – Comparaison des résultats d'AS entre le MM et les 12 modèles individuels ... 74

Tableau E3 – Résultats de l'AS pour les 20 BV. ... 76

Tableau E4 – Ensemble des résultats des tests (incluant les résultats pour les modèles individuels) ... 80

Tableau F1 – Résultats du seuil du scénario #1 (µ* = 0,01) appliqué aux 20 BV ... 84

viii

Liste des figures

Figure 1 – Schéma présentant la différence entre le MM classique et le MM proposé dans cette étude ... 8

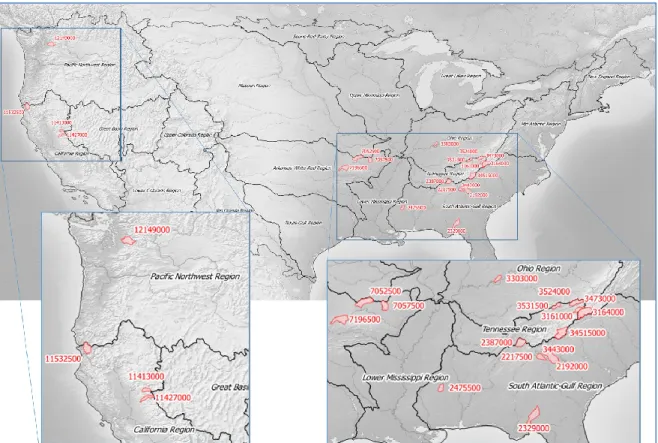

Figure 2 – Localisation et identification des 20 bassins versants sélectionnés du projet MOPEX ... 13

Figure 3 – Diversité des 20 bassins versants ... 14

Figure 4 – Schéma d'une analyse de sensibilité (adapté de Song et al. (2015). ... 15

Figure 5 – Schéma des tests d'AS effectués sur le multimodèle (MM) et sur les 12 modèles individuels ... 16

Figure 6 – Graphique des résultats d'AS pour la méthode de Morris (MM82, BV01, r = 1 200) ... 29

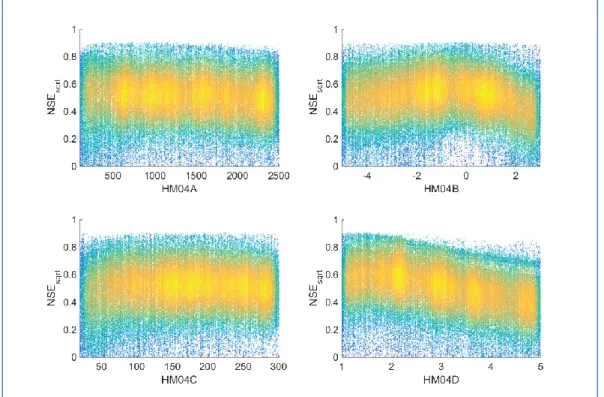

Figure 7 – Graphique présentant les scores (NSEsqrt) en fonction des valeurs des paramètres pour le modèle HM04 (ensemble des 20BV, pour r = 1 200) ... 29

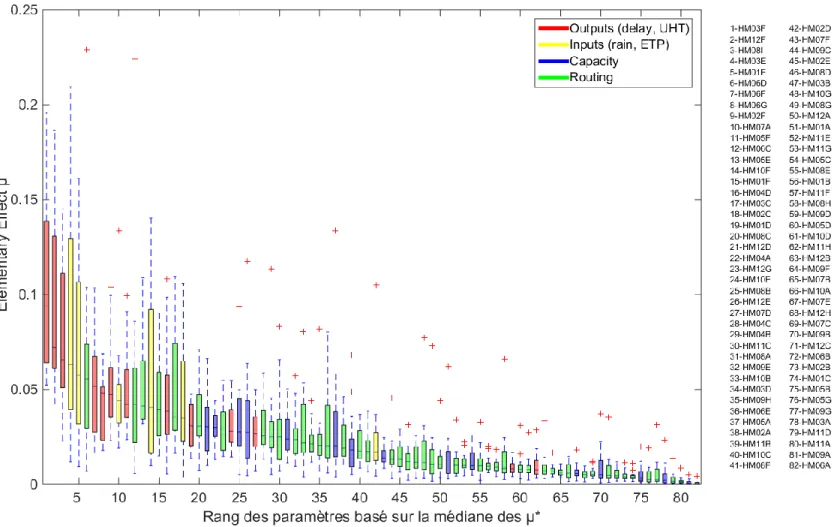

Figure 8 – Diagramme à moustache des résultats de l'AS pour les 20 BV, avec la méthode de Morris (r = 1200) et le MM82. ... 31

Figure 9 – Diagramme à moustache des résultats de l'AS pour les 20 BV pour MM82, avec la méthode de Morris (r = 1200), avec les fonctions. ... 33

Figure 10 – Convergence avec la méthode de Sobol pour MM82, pour N = 5 000. ... 35

Figure 11 – Convergence avec la méthode de Morris pour MM82, pour r = 20. ... 36

Figure 12 – Convergence avec la méthode de Morris pour MM82, pour r = 1 200. ... 36

Figure 13 – Diagramme de Venn des paramètres à fixer selon le scénario #1 ... 37

Figure 14 – Diagramme à moustache des résultats de l'AS pour les 20 BV pour les différents scénarios du MM, avec les fonctions (méthode de Morris, r = 1200). ... 39

Figure 15 – Performances pour le multimodèle, versions MM82, MM51, MM21 et MM14, ainsi que pour les 12 modèles individuels (20 BV). ... 40

Figure 16 – Hydrogramme interannuels des débits journaliers (BV01), période de validation. ... 42

Figure 17 – Hydrogramme interannuels des débits journaliers (BV01), période de validation. ... 43

Figure 18 – La diversité (« spread ») pour les 12 modèles calés individuellement (Indiv) et collectivement (MM82, MM51, MM21 et MM14). ... 44

ix

Figure 19 – La performance et la diversité (« spread ») pour les MM et la moyenne des 12 modèles calés

individuellement (20 BV) ... 45

Figure 20 – Comparaison de l'équifinalité entre les modèles avec le coefficient de variation (CV). ... 46

Figure 21 – Comparaison de l'équifinalité entre les modèles avec le Rapport d'étendue (RE). ... 47

Figure C1 – Résultats pour l'exemple de la méthode de Morris (µ et σ pour les 4 paramètres de HM04) ... 67

Figure D1 – Comparaison des moyennes interannuelles des débits entre l’ensemble des données (1948-2002) en bleu et les données de la période de 10 ans sélectionnée en rouge, pour les 20 BV ... 69

x

Liste des abréviations

AS Analyse de sensibilitéDDS Dynamically Dimensioned Search

DSST Differential Split Sample Tests

EE Elementary effect ou Effet élémentaire

EEM Elementary effect method (méthode de Morris)

EET Elementary effect Test (méthode de Morris)

ETP Évapotranspiration potentielle FAST Fourier amplitude sensitivity test

FSI First-order sensitivity indice (Si)

HM Modèle hydrologique

Indiv. Modèle(s) individuel(s) KGE Kling-Gupta Efficiency

LH-OAT Latin-hypercube one-factor-at-a-time [méthode d’analyse de sensibilité]

LHS-RT Latin hypercube sampling, radial type (design) [méthode d’échantillonnage]

MM Multimodèle

MM82 Multimodèle original, avec les 82 paramètres MM51 Multimodèle réduit à 51 paramètres

MM21 Multimodèle réduit à 21 paramètres MM14 Multimodèle réduit à 14 paramètres MOPEX Model Parameter Estimation Experiment

MS Modèle multistructure NSE Nash-Sutcliffe Efficiency

NSElog Nash-Sutcliffe Efficiency appliqué sur le logarithme des débits NSEsqrt Nash-Sutcliffe Efficiency appliqué sur la racine des débits NGS Number of complexes in a sample population

OAT One-at-a-time

PVE Percentage Volume Error

RMSE Root Mean Square Error

SA Sensitivity analysis

SCE Shuffled Complex Evolution

SMA Simple Model Averaging

xi SST Split-Sample Test

SUMMA Structure for Unifying Multiple Modeling Alternatives

TSI Total Sensitivity Index (STi) UHT Unit Hydrograph Time

xii

xiii

Remerciements

Je tiens d’abord à remercier mon directeur de recherche, François Anctil, pour ce projet, son accompagnement, ses conseils, sa générosité et sa confiance.

Merci à Gregory Seiller pour son soutien inestimable tout au long du projet et les nombreux échanges intéressants. Il m’aura presque convaincu de poursuivre au doctorat ! Gregory, tu constateras rapidement que la paternité est une forme d’analyse de sensibilité pour la modélisation que chacun se fait de sa vie…

Mes remerciements vont aussi à tous ceux que j’ai eu la chance de côtoyer durant cette dernière année intense, notamment mes collègues de bureau (Benoît, Julia, Gonzalo, Sisouvanh) pour les belles discussions et cette immersion culturelle quotidienne.

Je tiens également à remercier Dr. Francesca Pianosi et son équipe de l’université de Bristol pour la « SAFE toolbox », utilisée pour la réalisation d’une partie des analyses de sensibilité (AS). De même, je remercie Benoît Maranda pour ses explications et ses codes qui ont aussi été fort utiles pour les AS et Silvia Innocenti (INRS) pour son aide dans mes problèmes numériques et statistiques.

Merci à la Fondation Marthe-et-Robert-Ménard pour la généreuse bourse, qui a enlevé une large part de stress pécuniaire au paternel que je suis.

Merci à Mme Geneviève Pelletier et M. Amaury Tilmant qui ont gentiment accepté d’évaluer mon travail. Enfin, mes derniers remerciements, mais non les moindres, vont à mes parents, à mon épouse, Anne-Sophie, et à mes fils, Georges et Siméon.

1

1. Introduction

1.1. Mise en contexte et problématique

Au Québec, les prévisions hydrologiques issues de la modélisation ont des usages aussi diversifiés qu’importants : que ce soit pour la sécurité publique (inondations, sécheresses, gestion des barrages, prises d’eau potable, etc.), pour l’énergie et son exportation commerciale (Hydro-Québec) ou pour la gestion des barrages hydroélectriques d’alumineries, de nombreux modèles hydrologiques sont utilisés quotidiennement. Or, les changements climatiques ont et auront des impacts hydrologiques significatifs. De nouvelles approches en modélisation doivent donc être explorées afin de combler les lacunes actuelles (Liu et Gupta, 2007)et de permettre de quantifier les incertitudes qu’apporte « la mort de la stationnarité1 » (Milly et al., 2007).

Ainsi, plutôt que d’entrer dans la course à la création de nouveaux modèles pour des gains de performance souvent limités (Sanders, 1963), une approche multimodèle (MM), combinant 12 modèles hydrologiques globaux (Perrin, 2000; Seiller, 2013), a été privilégiée. Un multimodèle hydrologique (aussi appelé ensemble

hydrologique) est une combinaison de plusieurs modèles hydrologiques jugés complémentaires. Diverses

manières de combiner existent et sont brièvement abordées dans la section 2.1. Un multimodèle peut être traité de façon déterministe en ne fournissant qu’une seule sortie ou probabiliste. Dans ce dernier cas, c’est un ensemble de débits probables qui est donné à la sortie du multimodèle, permettant théoriquement d’obtenir non seulement une simulation efficiente et robuste, mais aussi l’incertitude associée. Le multimodèle présenté dans cette étude s’appuie sur la simple moyenne des 12 modèles et est de type déterministe. En revanche, l’idée ici est d’opérer ces modèles simultanément (en bloc) et non pas individuellement comme il est, au meilleur de notre connaissance, toujours le cas. L’originalité de cette approche vient du fait que les 12 modèles sont calés

collectivement. En effet, dans l’approche multimodèle « classique », les 12 modèles sont calés individuellement

et la moyenne est ensuite calculée, tandis que pour le multimodèle présenté dans ce travail, le calage s’effectue sur la moyenne des 12 modèles calculée à chaque pas de temps.

Un des défis soulevés par cette approche novatrice est le grand nombre de paramètres (82) qui complexifie le calage et l’utilisation, en plus d’entraîner des problèmes potentiels d’équifinalité2 (Beven, 1996; Poulin et al., 2011).

1 Stationnarité : concept signifiant que les propriétés statistiques de la série (les observations de température, par

exemple) sont invariantes dans le temps. Il s’agit d’une hypothèse de base essentielle en modélisation hydrologique, particulièrement pour les projections.

2 Équifinalité : concept référant au fait que plusieurs combinaisons de paramétrages peuvent donner des performances

2

Dans ce contexte, la problématique à laquelle ce mémoire tâchera de répondre est la suivante : quels sont les

paramètres essentiels du multimodèle hydrologique? Le fait étant qu’un nombre réduit de paramètres pourrait

potentiellement faciliter le calage et l’utilisation de ce multimodèle.

1.2. Objectifs et hypothèses

Ce mémoire s’inscrit dans le cadre d’un programme de recherche visant à développer de nouveaux et robustes outils de modélisation hydrologique ainsi qu’à améliorer l’évaluation de l’incertitude des prévisions et projections hydrologiques, dans une perspective d’adaptation de la gestion hydrique face aux changements climatiques. L’objectif spécifique de ce mémoire et les quatre sous-objectifs en découlant sont :

Réaliser une analyse de sensibilité (AS) sur le multimodèle hydrologique (composé de 12 modèles, pour un total de 82 paramètres) et sur les 12 modèles individuels.

1) Fixer les paramètres les moins importants du multimodèle et effectuer des calages-validations permettant de comparer les performances entre les différentes versions du multimodèle.

2) Comparer et analyser les performances des versions du multimodèle avec celles de ses membres pris individuellement.

3) Évaluer la diversité des membres (les modèles individuels) à l’intérieur du multimodèle. 4) Analyser si la diminution du nombre de paramètres diminue aussi les problèmes d’équifinalité. En bref, ces objectifs concourent à l’optimisation du multimodèle et à l’amélioration de sa compréhension, facilitant son calage et son utilisation en contexte opérationnel.

Quelques hypothèses sont posées au début de cette recherche :

1) En se basant sur des travaux précédents de Seiller (2013), il est estimé que l’analyse de sensibilité devrait permettre de fixer d’environ 30 paramètres du multimodèle.

2) La réduction du nombre de paramètres devrait avoir un impact positif, mais potentiellement modeste, sur les performances du multimodèle, seuls les paramètres ayant peu d’importance étant fixés. 3) Lorsque calés collectivement, les modèles présenteront de moins bonnes performances individuelles

3

Ces deux dernières hypothèses nécessitent quelques explications. Bien que la réduction du nombre de paramètres mène habituellement à une véritable augmentation des performances (ce qui est souvent le but visé des AS), il n’est pas attendu que cela soit le cas pour le MM. Le fait est que la méthode de calage utilisée (le DDS, présenté à la section 3.5) performe très bien et n’est théoriquement pas limitée par les 82 paramètres à optimiser. Par ailleurs, la réduction du nombre de paramètres du MM affectera probablement les performances des modèles qui le composent, puisqu’il est possible que certains modèles se retrouvent avec tous leurs paramètres fixés ou presque. Il est attendu que le calage collectif permettra des gains globaux de performances, cela sans améliorer les performances individuelles de ses modèles. En effet, comme présenté dans la revue de littérature, pour obtenir un multimodèle performant, le principal critère n’est pas nécessairement la performance individuelle de ses membres.

1.3. Plan du mémoire

La suite de ce mémoire est organisée comme suit. La présente introduction constitue le chapitre 1. Le chapitre 2 présente la revue de littérature sur les principaux aspects de cette recherche, soit l’approche multimodèle en hydrologie et les analyses de sensibilité en modélisation. La méthodologie est détaillée au chapitre 3. Le chapitre suivant est formé de la présentation des résultats et d’une discussion sur ceux-ci. Une conclusion clôt le mémoire et présente les perspectives.

4

2. Revue de littérature

La revue de littérature est divisée en deux sections. Chacune de ces sections présente les études publiées sur les deux grands thèmes de ce mémoire, soit l’approche multimodèle et l’analyse de sensibilité. Certaines études sont davantage générales, mais la plupart concernent spécifiquement la modélisation hydrologique

2.1. Approche multimodèle

Avant d’aborder en détail l’approche multimodèle, il importe de bien définir ce qu’est un modèle hydrologique. Dans sa plus simple expression, un modèle accepte des intrants pour produire des extrants, généralement en utilisant des équations mathématiques pour représenter les phénomènes impliqués dans la réalité que le modèle essaie de reproduire. En modélisation hydrologique, les intrants sont habituellement la précipitation et l’évapotranspiration, tandis que l’extrant est le débit à l’exutoire du bassin versant (modèle « pluie/débit »). Plus formellement, Mathevet (2005) donne la définition suivante du modèle hydrologique : « la représentation simplifiée de tout ou partie des processus du cycle hydrologique par un ensemble de concepts hydrologiques, exprimés en langage mathématique et reliés entre eux dans des séquences temporelles et spatiales correspondant à celles que l’on observe dans la nature ».

La modélisation hydrologique peut ainsi répondre à différents objectifs tels que la simulation, l’estimation (prédétermination), la reconstitution de débits manquants pour un climat observé, la prévision pour différents horizons temporels météorologiques ou la projection lorsque utilisée avec un scénario climatique. Il existe aussi plusieurs classes de modèles : ils peuvent être globaux ou distribués spatialement, événementiels ou continus, construits à partir des observations ou à partir des processus physiques. Cette dernière classe peut être subdivisée en « modèles physiques » (formalisation des phénomènes avec les équations de Richards, Boussinesq, etc.) ou « modèles conceptuels » (simplification des phénomènes utilisant des réservoirs imbriqués pour représenter les différentes couches de sols). Il est admis qu’aucun modèle ou classe de modèle n’est supérieur aux autres (Shamseldin et al., 1997).

Indépendamment de leur classe, tous les modèles restent des représentations simplifiées. En plus de l’incertitude inhérente à la nature stochastique du climat, les modèles hydrologiques ajoutent une incertitude structurelle, liée aux hypothèses et aux choix (notamment des équations) faits lors de leur élaboration (Beck, 1987; Liu et Gupta, 2007; Seiller et Anctil, 2014).

Afin de réduire et de mieux cerner ces incertitudes (particulièrement celles liées au choix des structures), une approche multimodèle a été proposée. Un bref et partiel historique de cette approche est présenté dans cette section.

5

Sanders (1963) présente une première intuition du potentiel d’une approche multimodèle en contexte de prévision. Dans le cadre de son expérience, il a comparé les scores des prévisions météorologiques de 12 étudiants-prévisionnistes avec les scores obtenus par des prévisionnistes expérimentés. Ses résultats montrent que la moyenne des prévisions des étudiants est meilleure que celle du meilleur prévisionniste. Il conclut ainsi: « Here is clear evidence that 12 heads are better than one ».

Toujours dans le domaine de la prévision météorologique, Clemen et Murphy (1986) et Fraedrich et Leslie (1987) font la transition entre cette idée de consensus subjectif des prévisionnistes à celui de multimodèle objectif. Clemen et Murphy (1986) présentent les avantages d’une combinaison des prévisions subjectives et des prévisions objectives. Fraedrich et Leslie (1987) ont combiné deux approches objectives de prévisions météorologiques (une chaîne de Markov et un modèle numérique de prévision), résultant en une amélioration des scores.

Cavadias et Morin (1986) sont parmi les premiers à combiner plusieurs modèles hydrologiques. Dans le cadre d’un projet de la World Meteorological Organization (WMO) d’intercomparaison de modèles hydrologiques avec fonte de neige (WMO, 1985), ils font différentes combinaisons parmi les 10 modèles disponibles. Leurs résultats montrent, pour plus de 80% des essais, une meilleure performance pour les modèles combinés comparativement aux modèles individuels.

Une dizaine d’années s’écoulent avant que le concept du multimodèle en modélisation hydrologique soit approfondi, notamment par Shamseldin et al. (1997). Ces derniers utilisent 5 modèles hydrologiques combinés de trois manières différentes (simple moyenne, moyenne pondérée et réseau de neurones), mais toujours dans une approche déterministe, sur 11 bassins versants de différents continents. Leurs résultats montrent les meilleures performances du multimodèle comparé aux modèles individuels, la nouveauté étant plutôt la découverte du grand potentiel du multimodèle, même lorsque non calibré.

Ensuite, à nouveau dans le domaine de la prévision météorologique, Fritsch et al. (2000) arrivent à la conclusion que l’utilisation d’un multimodèle apporte plus d’informations et moins d’erreurs, comparativement à l’utilisation d’un seul modèle, même lorsque ce dernier est utilisé avec différentes conditions initiales. Autrement dit, la diversité des modèles permet d’obtenir des solutions qui échappent aux modèles pris individuellement. De plus, les auteurs constatent que les biais s’annulent dans le multimodèle, permettant d’obtenir des erreurs absolues plus petites que pour les modèles individuels. Enfin, ils terminent en soulignant que le concept de multimodèle peut être encore amélioré, notamment en effectuant des « mélanges » de structures entre les différents modèles, pour obtenir de nouveaux ensembles de solutions.

6

Par la suite, une importante contribution est faite par Georgakakos et al. (2004) dans le cadre du Distributed

Model Intercomparison Project (DMIP). Leur étude vise à considérer les erreurs structurelles des modèles

hydrologiques dans l’utilisation d’un multimodèle. Les chercheurs ont utilisé les modèles du DMIP sur 6 bassins versants des États-Unis pour conclure que 1) la moyenne du multimodèle performe mieux que n’importe quel modèle individuel et 2) les ensembles multimodèles calibrés et non calibrés ont un grand potentiel comme outils opérationnels de prévisions hydrologiques.

Coulibaly et al. (2005) ont testé une combinaison de trois modèles – un modèle « du plus proche voisin » (nearest-neighbor), un modèle conceptuel (HSAMI) et un modèle en réseau de neurones. Ils ont ainsi pu valider leur hypothèse que cette approche combinée permet de s’affranchir de la post-correction des sorties. Encore une fois, il a été observé qu’aucun des trois modèles ne surpasse la performance de la combinaison des trois, indépendamment de la fenêtre de prévision étudiée. La même année, Hagedorn et al. (2005) cherchent à mieux comprendre pourquoi les multimodèles performent aussi bien. Ils démontrent que leur supériorité vient non seulement de la compensation des erreurs, mais aussi de leur plus grande cohérence3 et de leur plus grande fiabilité.

Ajami et al. (2006) ont poursuivi la réflexion en se questionnant sur ce qui pouvait influencer les performances d’un multimodèle. Ils ont principalement investigué les méthodes de combinaisons (simple moyenne des modèles individuels, moyenne pondérée et autres assemblages incluant une forme de régression), ainsi que l’impact des variations saisonnières, le nombre de modèles individuels intégrés dans le multimodèle et la qualité des modèles individuels. Les auteurs arrivent aux conclusions suivantes : 1) la simple moyenne des modèles obtient toujours de meilleures performances que n’importe lequel des modèles individuels; 2) un minimum de quatre modèles semble nécessaire pour avoir un multimodèle performant; 3) le multimodèle est tributaire de la qualité des modèles qui le composent – il faut de bons modèles individuels pour faire un bon multimodèle. Viney et al. (2009) apportent de nouvelles conclusions avec leur étude effectuée sur un seul bassin versant situé en Allemagne, mais comprenant 10 modèles de complexité très variable : de modèles physiques et distribués (DHSWM, MIKE-SHE) à des modèles globaux conceptuels (IHACRES). En effet, les auteurs concluent que même le modèle individuel le plus faible apporte de l’information et permet d’améliorer les performances de l’ensemble. Aussi, parmi les différentes techniques de combinaison, il ressort que le meilleur ensemble est généralement composé de cinq modèles, mais que ces derniers ne correspondent pas nécessairement aux cinq meilleurs modèles individuels.

3 « Consistency » : dans ce contexte, fait référence à la capacité du multimodèle à bien performer dans toutes les

7

Au cours des dernières années, de nombreuses autres études ont été réalisées à l’aide de multimodèles hydrologiques (Arsenault et al., 2015; Brochero et al., 2011; Chen et al., 2015; Thiboult et Anctil, 2015; Velazquez et al., 2010; Wei et Dong, 2015) pour n’en mentionner que quelques-unes. Ces études ont en commun de montrer que des gains sont souvent obtenus lorsque plusieurs modèles sont combinés.

Enfin, une nouvelle forme de modélisation inspirée du multimodèle s’est développée dans la dernière décennie : « l’approche flexible ». Cette approche a été initialement proposée par Leavesley et al. (1996) sous le nom « Modular Modeling System » et consiste à construire un modèle optimal en choisissant parmi plusieurs structures. Ces structures sont en fait les algorithmes associés à des processus particuliers de la modélisation hydrologique (l’infiltration, par exemple). De nombreux développements ont été apportés à ce concept (Clark et al., 2008; Clark et al., 2011; Fenicia et al., 2011; van Esse et al., 2013) et plus récemment, l’approche SUMMA (« Structure for Unifying Multiple Modeling Alternatives ») (Clark et al., 2015a; Clark et al., 2015b).

Il ressort ainsi que les trois principaux avantages de l’approche MM sont : 1) les gains de performances (lorsque les modèles sont diversifiés, les erreurs tendent à s’annuler); 2) la possibilité d’effectuer des prévisions et projections probabilistes et 3) la possibilité de quantifier les incertitudes (principalement celles liées aux structures des modèles).

La présente recherche est la troisième étape du développement de cette approche multimodèle au sein de l’équipe du professeur Anctil. Lors de la première étape, Seiller et al. (2012) ont utilisé la moyenne simple de 20 modèles calés individuellement (approche multimodèle « classique ») afin d’évaluer la robustesse du multimodèle en contexte de changements climatiques. En utilisant le Differential Split Sample Tests (DSST) de Klemeš (1986), ils ont montré que le multimodèle a le potentiel d’améliorer la transposabilité4, mais aussi qu’il n’y a pas nécessairement de lien entre les performances du multimodèle et celle des membres individuels qui le composent. Pour la deuxième étape, Seiller et al. (2015) ont exploré l’utilisation de moyennes pondérées plutôt que la moyenne simple. Grâce à la pondération des modèles individuels, ils ont obtenu des gains modestes en performance lors des DSST. Cela a mené à cette troisième étape où un gain supplémentaire est recherché, cette fois en intégrant une forme de pondération dans le calage par l’optimisation (figure 1). Les 20 modèles initiaux ont dû être réduits à 12 pour limiter l’ensemble à 82 paramètres et ainsi permettre un calage global (un seul calage plutôt qu’une douzaine). À chaque pas de temps, la moyenne des modèles individuels est calculée et utilisée pour le calage de l’ensemble des paramètres. De cette façon, l’optimisation pondère les modèles via les valeurs des paramètres. Cette approche novatrice est basée sur l’hypothèse qu’un gain supplémentaire est possible pour le MM au coût d’une baisse des performances individuelles. Cela soulève des

4 C'est-à-dire la capacité de transposition des paramètres dans le temps : l’aptitude d’un modèle à performer aussi bien

8

défis nouveaux, liés entre autres aux nombreux paramètres et au fait que les séries des modèles individuels ne sont plus les mêmes. Il est à noter que cette démarche serait probablement difficile à réaliser avec des modèles hydrologiques à base physique, en raison des temps de calculs trop importants.

Figure 1 – Schéma présentant la différence entre le MM classique et le MM proposé dans cette étude

Légende : (HM01, HM02, etc.) Modèles individuels; (Q) Débits; (Q obs) Débits observés; (P + E) Précipitation et évapotranspiration.

D’autres travaux ont aussi été réalisés dans l’équipe autour du multimodèle notamment pour évaluer le potentiel des multimodèles en contexte de prévisions (Thiboult et Anctil, 2015) et quantifier les incertitudes liées à la modélisation (Seiller et Anctil, 2014).

2.2. Analyse de sensibilité

Selon les disciplines, il existe différentes définitions de l’analyse de sensibilité (AS). La définition proposée ici reprend celle présentée par Song et al. (2015) spécifiquement pour la modélisation hydrologique, soit :

l’investigation de la fonction réponse qui relie la variation dans les sorties du modèle aux changements dans les variables d’entrées ou dans les paramètres. L’AS permet de déterminer quelle est la contribution de chaque

9

paramètre à l’incertitude du modèle, ce qui est différent de l’analyse d’incertitudes qui elle vise à quantifier l’incertitude sur la sortie du modèle. Les deux analyses sont souvent complémentaires. Les AS ont l’avantage de répondre à plusieurs questions permettant une meilleure compréhension et utilisation du modèle. Pour ce mémoire, la question est : « quels paramètres ont un effet suffisamment faible sur la sortie du modèle qu’ils puissent être fixés avec confiance à n’importe quelle valeur de leur espace paramétrique sans affecter les résultats? » (Song et al., 2015).

Il existe plusieurs méthodes d’AS qui peuvent d’être regroupées en catégories. Les méthodes peuvent être « locales » (seule une partie de l’espace paramétrique est investiguée) ou « globales » (l’entièreté de l’espace est considérée pour chacun des paramètres). Elles peuvent être « qualitatives » en donnant un score relatif de sensibilité ou « quantitatives » en calculant l’impact du paramètre sur la variance totale de la sortie du modèle. Bien que la popularité des AS soit croissante dans le domaine de la modélisation (Song et al., 2015), selon Saltelli et Annoni (2010) elles sont encore souvent mal utilisées. Par exemple, Zhang et al. (2013) mentionnent notamment l’importance de choisir une méthode d’analyse de sensibilité qui prenne en compte les interactions entre les paramètres pour éviter les erreurs5 de Type II. En effet, des paramètres très interactifs se retrouvent fréquemment dans les modèles environnementaux et plus particulièrement dans les modèles hydrologiques (Tang et al., 2007). Cela implique d’éviter les méthodes d’AS comme la populaire Latin-hypercube

one-factor-at-a-time (LH-OAT) et de considérer plutôt des méthodes plus coûteuses en termes de simulations, mais aussi

plus fiables, comme la méthode de Sobol ou la méthode de Morris. Ces deux dernières sont présentées ci-dessous, tandis que leurs méthodologies sont expliquées à la section 3.3.5.

La méthode de Sobol fait partie de la famille des méthodes quantitatives d’AS basées sur la variance. L’algorithme a d’abord été publié en russe par le mathématicien I. M. Sobol (Sobol', 1990), puis en anglais (Sobol, 1993). Sobol était lui-même inspiré par les travaux de Cukier et al. (1973) sur le Fourier Amplitude

Sensitivity Test (FAST). Il s’agit d’une méthode communément utilisée pour les AS en modélisation hydrologique

(Herman et al., 2013a; Herman et al., 2013b; Shin et al., 2013; Tang et al., 2007; Van Werkhoven et al., 2008; Zhang et al., 2013).

La méthode de Morris (aussi appelée Elementary effect method (EEM) ou Elementary effect Test (EET)) est une méthode semi-quantitative d’AS simple de type filtrage6 (« screening ») développée initialement par Morris (1991) et améliorée par Campolongo et al. (2007). Elle fait partie de la famille des méthodes One-at-a-time

5 En AS, une erreur de type I consiste à définir comme important un paramètre non-influent. Inversement, une erreur de

type II est de classer un important paramètre parmi les négligeables. Il existe aussi l’erreur de type III, qui est de chercher la bonne réponse pour un problème mal posé (« right answer for the wrong question »). Aucune méthode ne protège contre ce dernier type d’erreur.

10

(OAT), tout en palliant aux principaux défauts habituellement rencontrés avec cette famille de méthodes7. Il s’agit d’une méthode d’analyse globale, tout comme la méthode de Sobol, mais nécessitant beaucoup moins de calculs (simulations) (Song et al., 2015). L’idée de cette méthode est d’avoir deux indicateurs de sensibilité (µ et σ, définis plus loin) mesurant si l’effet de chaque paramètre est : a) négligeable, b) linéaire et additif, c) non linéaire ou d) impliquant des interactions entre les paramètres (Morris, 1991). Tout comme la méthode de Sobol, il s’agit d’une méthode couramment utilisée en modélisation hydrologique (Francos et al., 2003; Herman et al., 2013a; Herman et al., 2013c; Shin et al., 2013).

Enfin, une importante mise en garde concernant les analyses de sensibilité est faite par les professeurs Pilkey et Pilkey-Jarvis dans le livre « Useless arithmetic : why environmental scientists can't predict the future » :

« It’s important […] to recognize that the sensitivity of the parameter in the equation is what is being determined, not the sensitivity of the parameter in nature. […] If the model is wrong or if it is a poor representation of reality, determining the sensitivity of an individual parameter in the model is a meaningless pursuit. » (Pilkey et Pilkey-Jarvis, 2007).

7 « OAT sampling is inefficient when the number of parameters k is large and only a few of them are influencial. » (Saltelli

11

3. Méthodologie

Cette troisième partie décrit en détail la méthodologie utilisée pour l’atteinte de l’objectif de cette maîtrise qui est la réalisation d’une analyse de sensibilité d’un multimodèle hydrologique. Les modèles et les bassins versants sont d’abord présentés. La méthodologie entourant l’analyse de sensibilité est ensuite développée, de même que celle pour la sélection des paramètres. L’optimisation (calage et validation) qui permet d’évaluer les performances est la seconde étape essentielle, suite à l’AS; la description est donnée à la section 3.5. Enfin, différents indicateurs et méthodes d’évaluation utilisés pour atteindre les objectifs sont exposés à la fin de cette partie.

3.1. Modèles et multimodèle

Cette section décrit d’abord les 12 modèles individuels qui ont servi à la construction du multimodèle (MM) et enchaîne avec la description de celui-ci.

Le tableau 1 présente la liste des modèles individuels utilisés, leurs caractéristiques (nombre de paramètres libres et nombre de réservoirs) et les modèles initiaux auxquels ils se rattachent. Plusieurs études ont été réalisées sur ces modèles (Mathevet, 2005; Perrin et al., 2001; Perrin et al., 2003; Seiller, 2013). Ce mémoire s’appuie en partie sur les travaux de Perrin (2000) qui a d’abord rassemblé et restructuré selon un cadre commun un grand nombre de modèles hydrologiques, dont une trentaine a été retenue et programmée sous Matlab par Seiller (2013). Parmi eux, douze ont été retenus pour leur diversité structurelle et leurs bonnes performances individuelles. Ce sont tous des modèles globaux conceptuels, adaptés au pas de temps journalier. Ils reçoivent deux entrées : les précipitations et l’évapotranspiration potentielle (ETP). Leur seule sortie est le débit. Ce sont des modèles relativement simples et plutôt parcimonieux en paramètres (entre 4 et 9) et en réservoirs (entre 3 et 5).

Tel qu’expliqué à la section 2.1, le multimodèle utilisé dans ce projet a la particularité d’être le fruit d’un calage global et simultané des 12 modèles précédents, plutôt que la simple moyenne a posteriori des 12 modèles calés individuellement. Plus concrètement, le calage des paramètres du multimodèle s’effectue pour chaque itération à partir de la moyenne des débits de l’ensemble des 12 modèles, comparée à l’observation. Bien qu’il existe d’autres options pour combiner les modèles ensemble (moyenne pondérée, réseau de neurones, etc.) (Shamseldin et al., 1997), le SMA (Simple Model Averaging) est probablement la méthode la plus utilisée en multimodèle, notamment pour sa robustesse. Le SMA a aussi l’avantage de simplifier l’analyse de sensibilité, comparativement aux autres méthodes. De plus, comme mentionné précédemment, il n’est pas jugé nécessaire d’utiliser une moyenne pondérée puisque l’optimisation pondère indirectement les modèles en attribuant des valeurs aux paramètres lors du calage.

12

Tableau 1 – Liste des modèles

Acronyme Nombre de paramètres libres

Nombre de réservoirs

Inspiré de

HM01 6 3 BUCKET (Thornthwaite et Mather,

1955)

HM02 6 3 CREC (Cormary et Guilbot, 1973)

HM03 6 3 GARDENIA (Thiéry, 1982)

HM04 4 3 GR4J (Perrin et al., 2003)

HM05 7 4 MARTINE (Mazenc et al., 1984)

HM06 7 3 MOHYSE (Fortin et Turcotte,

2006)

HM07 6 4 MORDOR (Garçon, 1999)

HM08 9 5 SACRAMENTO (Burnash et al.,

1973)

HM09 8 4 SIMHYD (Chiew et Siriwardena,

2005)

HM10 7 4 TANK (Sugawara, 1979)

HM11 8 3 WAGENINGEN (Warmerdam et

Kole, 1997)

HM12 8 5 XINANJIANG (Zhao et al., 1980)

La liste des paramètres du multimodèle est présentée à l’annexe A : il s’agit en fait du regroupement de tous les paramètres des modèles individuels.

3.2. Bassins versants

L’AS a pour finalité première la réduction du nombre de paramètres. Un paramètre peut être insensible sur un bassin très humide mais sensible et important pour un bassin plus aride, par exemple. Ainsi, les résultats d’une AS ne sont strictement valides que pour le bassin versant sur lequel l’analyse a été réalisée (Shin et al., 2013). Pour généraliser, il faut s’assurer que les paramètres fixés soient insensibles pour une vaste gamme de bassins versants. Une analyse de sensibilité poussée étant très coûteuse en temps de calcul, un choix sur le nombre de bassins versants doit être fait. Dans le cadre de ce travail, vingt bassins versants états-uniens ont été sélectionnés pour leur diversité (en évitant toutefois les extrêmes) et la qualité de leurs données. Les séries proviennent de la base de données MOPEX (Model Parameter Estimation Experiment) qui contient de l’information pour 429 bassins versants (Duan et al., 2006). La figure 2 présente la localisation des 20 bassins retenus, alors que les statistiques hydrologiques pertinentes sont regroupées au tableau 2. Afin de limiter le nombre de paramètres à l’étude, les 20 bassins sélectionnés sont sans influence notable de la neige, ce qui permet d’éviter l’ajout d’un module de fonte au modèle étudié et les paramètres associés.

13

Figure 2 – Localisation et identification des 20 bassins versants sélectionnés du projet MOPEX Tableau 2 – Caractéristiques hydroclimatiques des 20 bassins versants étudiés, établies à partir des données

quotidiennes disponibles de 1948 à 2002

Nom Code Aire

(km2) P (mm/an) T (°C) Q (mm/an) Aridité (E/P) Longitude Latitude

BV01 2329000 2953 1314 19.50 322.64 0.93 -84.3842°E 30.5539°N BV02 11532500 1577 2748 11.05 2209.60 0.27 -124.0539°E 41.7894°N BV03 2475500 956 1406 17.46 460.76 0.80 -88.9097°E 32.3264°N BV04 2217500 1031 1288 16.05 450.36 0.81 -83.4228°E 33.9467°N BV05 2192000 3704 1254 16.05 426.22 0.84 -82.7700°E 33.9742°N BV06 2387000 1779 1426 14.85 623.21 0.70 -84.9280°E 34.6670°N BV07 11427000 886 1475 10.87 838.15 0.52 -121.0228°E 38.9361°N BV08 11413000 648 1707 10.06 1081.40 0.43 -120.9369°E 39.5250°N BV09 3443000 767 1933 12.41 1188.10 0.45 -82.6240°E 35.2990°N BV10 3451500 2448 1502 12.48 749.51 0.58 -82.5786°E 35.6092°N BV11 7196500 2484 1152 14.62 339.63 0.86 -94.9208°E 35.9214°N BV12 12149000 1562 2371 7.95 2135.50 0.24 -121.9240°E 47.6660°N BV13 3531500 826 1269 12.30 592.05 0.68 -83.0950°E 36.6620°N BV14 7057500 1453 1069 13.37 449.65 0.88 -92.2481°E 36.6228°N BV15 3303000 736 1126 12.89 817.77 0.80 -86.2280°E 38.2370°N BV16 7052500 2556 1071 13.19 341.52 0.87 -93.4610°E 36.8050°N BV17 3524000 1368 1090 11.32 460.51 0.75 -82.1550°E 36.9447°N BV18 3473000 780 1241 10.85 544.97 0.64 -81.8442°E 36.6517°N BV19 3164000 2929 1256 10.57 594.10 0.62 -80.9792°E 36.6472°N BV20 3161000 531 1412 10.50 741.29 0.55 -81.4072°E 36.3931°N

14

L’aire moyenne des bassins choisis est d’environ 1 600 km², le plus petit bassin drainant 531 km² et le plus grand, 3 704 km². La précipitation annuelle moyenne y varie entre 1069 mm et 2748 mm, et le débit, entre 323 mm/an et 2 210 mm/an.

La figure 3 illustre la diversité des 20 bassins versants sélectionnés. Cinq caractéristiques y sont présentées de manière relative par rapport au maximum. Par exemple, la valeur pour l’aire en pourcentage est obtenue en divisant l’aire du bassin X par celle du bassin le plus vaste.

Figure 3 – Diversité des 20 bassins versants

Le fait que la gamme des bassins couvre bien l’ensemble du pentagone illustre la diversité en termes physique (aire) et hydroclimatiques (aridité, décharge, température et précipitations) de cet ensemble. Il est ainsi raisonnable de penser que les résultats de l’AS présentée plus loin sont généralisables à d’autres bassins versants aux caractéristiques semblables.

3.3. Analyse de sensibilité

La méthodologie suivie pour la réalisation des analyses de sensibilité (AS) se base sur les travaux de Song et al. (2015) et de Saltelli et al. (2008). La démarche suivie est schématisée à la figure 4.

0% 20% 40% 60% 80% 100% Aire (km2) P (mm/an) T (°C/jour) Q (mm/an) Aridité (E/P) #1 #2 #3 #4 #5 #6 #7 #8 #9 #10 #11 #12 #13 #14 #15 #16 #17 #18 #19 #20

15

Figure 4 – Schéma d'une analyse de sensibilité (adapté de Song et al. (2015).

Les boîtes noires présentent le schéma général à suivre pour réaliser une AS, les boîtes bleues montrent les choix spécifiques à l’AS réalisée dans le cadre de ce mémoire. En italique sont d’autres choix qui ont été

également explorés.

Divers tests ont été réalisés pour identifier la meilleure méthodologie à utiliser (échantillonnage, nombre d’itérations, fonction-objectif, etc.). Ces tests ont été réalisés sur les 20 bassins versants ou sur une sélection de quelques bassins versants (figure 5). Au total, 18 400 200 simulations hydrologiques ont été réalisées, seulement pour les tests sur le MM. Ce nombre exclut les simulations réalisées durant les tests préliminaires et qui ont servi notamment à corriger certaines erreurs dans les codes des modèles et à ajuster les bornes des paramètres. Les simulations se sont échelonnées sur quelques mois en utilisant deux ordinateurs (des Intel

Xeon totalisant 96 GB de RAM).

Parmi tous ces tests, la méthodologie retenue (en vert sur la figure 5 : le scénario « E » pour le MM et le scénario « S » pour les 12 modèles individuels) est l’utilisation de la méthode de Morris (r = 1 200), un échantillonnage avec la méthode Latin hypercube samping – radial type et l’utilisation de la fonction-objectif Nash-Sutcliffe

16

Figure 5 – Schéma des tests d'AS effectués sur le multimodèle (MM) et sur les 12 modèles individuels

Légende : (MOD) Modèle; (MET) Méthode; (ECH) Méthode d’échantillonnage [LHS-RT : Latin hypercube samping – radial type; SQRS : Sobol quasi-random sampling]; (NBE) Nombre de trajectoires R (méthode Morris) ou nombre d’échantillons N (méthode Sobol); (OBJ) Fonctions-objectif; (NBV) Numéros des bassins

versants analysés; (SIM) Identification et nombre de simulations (« run ») pour les tests correspondant. En vert, les méthodologies retenues.

17

3.3.1. Problème initial

La première étape d’une AS consiste en la définition du problème et la sélection du modèle. Le problème est de type « factor fixing » : l’AS est utilisée avec l’objectif de réduire (« fixer ») les paramètres qui seront évalués peu ou pas sensibles. Cela correspond au premier objectif de ce mémoire. Le choix du modèle est le point de départ de ce projet : l’AS est effectuée sur le multimodèle, mais aussi sur les 12 modèles individuels pour comparaison.

3.3.2. Bornes paramétriques

L’étape suivante concerne la définition des bornes paramétriques : elles sont présentées au tableau A1. Cette étape est importante car le choix des bornes peut avoir un impact critique sur les résultats de l’AS (Shin et al., 2013; Song et al., 2015) et influencer l’identification des paramètres à fixer. Les bornes ont été établies à partir de la littérature sur les modèles respectifs, des travaux de Seiller (2013) et des analyses de sensibilité préliminaires effectuées dans la cadre de ce projet de recherche (plusieurs essais en variant les limites des paramètres).

3.3.3. Échantillonnage

La troisième étape est le choix d’une méthode d’échantillonnage. Une bonne méthode doit permettre de couvrir tout l’espace paramétrique pour éviter une AS déficiente (Saltelli et Annoni, 2010), tout en optimisant le nombre d’échantillon N pour un temps de calcul réaliste. Un échantillon complètement aléatoire aura des régions plus denses et d’autres vides. Cela a comme conséquence que la valeur moyenne estimée à partir d’un échantillon aléatoire a une incertitude qui diminue lentement (1/√𝑁) (Saltelli et al., 2008). Par exemple, pour diminuer l’incertitude d’un facteur 10, l’échantillon doit alors être augmenté d’un facteur 102 = 100, ce qui est problématique pour une AS. C’est pourquoi une méthodologie permettant d’obtenir des échantillons équidistribués (séquences pseudo-aléatoires) doit être considérée.

Différents choix d’échantillonnage sont possibles selon l’AS. Pour la méthode de Morris, les modélisateurs recourent souvent à un échantillonnage « latin hypercube sampling » (LHS) (McKay et al., 1979) de type radial (« radial design »), plutôt que de type trajectoire (« trajectory design »). La LHS appartient à la famille des méthodes de Monte-Carlo. Elle divise en N strates équiprobables (1/N) l’espace pour chaque dimension des paramètres, puis échantillonne aléatoirement chacune de ces strates. Les strates sont ensuite permutées pour chaque paramètre, résultant en N échantillons semi-aléatoires (Maranda, 2014). Un tel échantillonnage est justifié par plusieurs études (Campolongo et al., 2011; Saltelli et al., 2008; Saltelli et Annoni, 2010; Song et al., 2015; Tang et al., 2007). À noter que la méthode d’échantillonnage de Morris (Morris, 1991) a aussi été testée. Pour une AS de Sobol, en plus de la LHS, la Sobol quasi-random sequence (SQRS, aussi nommée LP-τ ou LPTAU) (Saltelli et al., 2008; Sobol et al., 1967) a souvent été retenue (Homma et Saltelli, 1996; Zhan et al., 2012). La question de la taille des échantillons est abordée à la section 3.3.5, pour chacune des méthodes.

18

3.3.4. Fonctions-objectif

L’étape suivante concerne le choix de la fonction-objectif. Song et al. (2015) souligne la pertinence de bien choisir les fonctions-objectif. Dans le cadre de cette étude, plus d’une dizaine de fonctions-objectif ont été utilisées simultanément (le Nash-Sutcliffe Efficiency appliqué sur le logarithme des débits (NSElog), le

Kling-Gupta Efficiency (KGE), le Percentage Volume Error (PVE), etc.), puisque l’impact de l’ajout de plusieurs

fonctions sur le temps de calcul était négligeable. Au final, trois fonctions ont été retenues et analysées en détail : le Nash-Sutcliffe Efficiency (NSE) (Nash et Sutcliffe, 1970), le Nash-Sutcliffe Efficiency appliqué sur la racine des débits (NSEsqrt) et la Root Mean Square Error (RMSE). Le NSE (éq. 1) est un critère fréquemment utilisé en hydrologie qui facilite beaucoup la comparaison des débits et est très populaire dans la réalisation d’AS (Song et al., 2015). Les valeurs du NSE sont comprises entre l’infini négatif et 1. Une concordance exacte entre les débits observés (Qobs) et simulés (Qsim) donne un NSE de 1, tandis qu’un NSE de 0 signifie que le modèle ne simule pas mieux le débit qu’une simple moyenne constante.

𝑁𝑆𝐸 = 1 −∑ (𝑄𝑠𝑖𝑚,𝑖− 𝑄𝑜𝑏𝑠,𝑖) 2 𝑁 𝑖=1 ∑𝑁 (𝑄𝑜𝑏𝑠,𝑖− 𝑄̅̅̅̅̅̅̅)𝑜𝑏𝑠,𝑖 2 𝑖=1 Éq. 1

où N est le nombre total d’observations et i est le jour du débit simulé et observé.

Le NSE a cependant comme désavantage de conférer plus de poids aux crues (Seiller, 2013). Une seconde fonction-objectif est ainsi considérée : le NSEsqrt (éq. 2). La transformation effectuée sur les débits assure une meilleure pondération entre les différents types de débits, sans favoriser les débits plus petits ou plus grands (Oudin et al., 2006). 𝑁𝑆𝐸𝑠𝑞𝑟𝑡 = 1 − ∑ (√𝑄𝑠𝑖𝑚,𝑖− √𝑄𝑜𝑏𝑠,𝑖) 2 𝑁 𝑖=1 ∑𝑁 (√𝑄𝑜𝑏𝑠,𝑖− √𝑄̅̅̅̅̅̅̅̅̅)𝑜𝑏𝑠,𝑖 2 𝑖=1 Éq. 2

Enfin, la dernière fonction présentée est la RMSE (éq. 3), également un critère largement utilisé pour les AS de modèles hydrologiques (Song et al., 2015).

𝑅𝑀𝑆𝐸 = √∑ (𝑄𝑠𝑖𝑚,𝑖− 𝑄𝑜𝑏𝑠,𝑖) 2 𝑁

𝑖=1

𝑁 Éq. 3

Les valeurs de RMSE s’étendent de 0 à l’infini positif, bien qu’en pratique la valeur 0 (concordance parfaite) n’est jamais atteinte. C’est pour cela que cette fonction a été retenue en plus du NSE et du NSEsqrt. En effet, comme il s’agit d’un multimodèle expérimental, certaines combinaisons de valeurs de paramètres risquent de

19

donner des résultats aberrants et donc des valeurs de NSE près de zéro ou même négatives. Cela pouvant causer des problèmes dans les calculs des indices des méthodes d’AS (voir les équations de la section suivante), la RMSE est calculée afin d’avoir des résultats strictement positifs pour au moins l’une des fonctions-objectif.

3.3.5. Méthodes d’analyse

Initialement, seule la méthode de Sobol était envisagée pour réaliser l’AS. Cependant, des problèmes de convergence (voir section 4.1) et les contraintes de temps de calcul ont fait évoluer le projet et c’est finalement la méthode de Morris qui a été utilisée pour fixer les paramètres. Une brève présentation des deux méthodes a été fournie à la section 2.2.

Méthode de Sobol

La procédure utilisée dans ce projet et décrite ci-dessous s’inspire de l’adaptation de la méthode de Sobol par Saltelli (2002). Un exemple numérique complet est présenté à l’Annexe B.

(i) Générer une matrice de dimension (2N,k) de nombres aléatoires, où k est le nombre de paramètres i (k = 82 dans le cas du multimodèle) et N est le nombre d’échantillons de base. Les valeurs recommandées pour N varient de quelques centaines à plusieurs milliers. Il est suggéré d’utiliser une méthode appropriée pour la génération des nombres aléatoires, comme la SQRS (voir section 3.3.3). Séparer ensuite la matrice en deux (A et B), chacune ayant exactement la moitié de l’échantillon initial, soit (N, k).

(ii) Créer la matrice Ci en copiant toutes les colonnes de B, sauf la colonne i qui vient de la matrice A. Répéter cette étape jusqu’à obtenir les k matrices Ci.

(iii) Calculer la fonction-objectif du modèle pour chacune des valeurs de paramètres des échantillons des matrices A, B et Ci. Ceci permet d’obtenir 3 vecteurs (N, 1) correspondant à :

𝑦𝐴= 𝑓(𝐴) 𝑦𝐵 = 𝑓(𝐵) 𝑦𝐶𝑖 = 𝑓(𝐶𝑖) Éq. 4

(iv) Calculer les indices de sensibilité Si et de sensibilité totale STi à partir de 𝑦𝐴, 𝑦𝐵 et 𝑦𝐶𝑖 à partir des équations suivantes. Noter que le symbole (∙) identifie le produit scalaire de deux vecteurs.

𝑆𝑖 =𝑉[𝐸(𝑌|𝑥𝑖)] 𝑉(𝑌) = 𝑦𝐴∙ 𝑦𝐶𝑖− 𝑓02 𝑦𝐴∙ 𝑦𝐴− 𝑓02 = (1 𝑁⁄ ) ∑ 𝑦𝐴(𝑗)𝑦𝐶 𝑖 (𝑗) 𝑁 𝑗=1 − 𝑓02 (1 𝑁⁄ ) ∑𝑁 (𝑦𝐴(𝑗))2 𝑗=1 − 𝑓02 Éq. 5

20 où 𝑓02= ( 1 𝑁∑ 𝑦𝐴(𝑗) 𝑁 𝑗=1 ) 2 Éq. 6 et 𝑆𝑇𝑖= 1 −𝑉[𝐸(𝑌|𝑥~𝑖)] 𝑉(𝑌) = 1 − 𝑦𝐵∙ 𝑦𝐶𝑖− 𝑓02 𝑦𝐴∙ 𝑦𝐴− 𝑓02 = 1 − (1 𝑁⁄ ) ∑𝑁 𝑦𝐵(𝑗)𝑦𝐶(𝑗)𝑖 𝑗=1 − 𝑓02 (1 𝑁⁄ ) ∑𝑁 (𝑦𝐴(𝑗))2 𝑗=1 − 𝑓02 Éq. 7

L’indice de sensibilité Si (first-order sensitivity indice, FSI) mesure l’effet principal de chaque paramètre i sur la sortie du modèle. Il s’agit de la contribution partielle et directe de chaque paramètre sur la variance de la sortie du modèle, divisée par la variance totale de la sortie. Autrement dit, Si correspond à la valeur de la réduction de la variance totale de la sortie si le paramètre i était fixé (Saltelli et Annoni, 2010). La valeur de Si est ainsi une fraction (entre 0 et 1) de la variance totale. L’indice de sensibilité total STi mesure l’effet total, c’est-à-dire l’effet de premier ordre (first-order effect) et des ordres plus hauts du paramètre Xi (éq. 8). Les ordres plus hauts correspondent aux interactions entre le paramètre Xi et les autres paramètres.

𝑆𝑇𝑖= ∑ 𝑆𝑖+ ∑ 𝑆𝑖𝑗

𝑗≠𝑖

+. . . +𝑆1…𝑘

Éq. 8

Ainsi, la différence entre STi et Si pour un paramètre est une mesure indirecte de son interaction avec les autres paramètres du modèle. La somme des Si est de 1 pour les modèles purement additifs et inférieure à 1 pour les modèles de type non-additif. Une valeur de ∑Si inférieure de beaucoup à 1 signifie que le modèle a beaucoup d’interactions entre les paramètres. La valeur de ∑STi est toujours plus grande que l’unité, sauf si le modèle est additif (aucune interaction entre les paramètres), auquel cas ∑STi = 1.

Song et al. (2015) mentionnent trois avantages d’une méthode basée sur la variance : 1) elle fonctionne indépendamment du type de modèle (non linéaire, non monotone, avec interactions entre les paramètres); 2) elle quantifie l’interaction entre les paramètres; 3) elle permet de regrouper des paramètres pour les traiter comme un seul. Par contre, il s’agit d’une méthode nécessitant un grand nombre de simulations.

Le coût de cette méthode (nombre de simulations requises) est de N + N pour les matrices A et B, plus les k fois N des matrices Ci, soit un total de N(k+2) simulations. Cela représente beaucoup moins que la méthode de force brute (N2 simulations). La valeur de N est généralement élevée : entre 102 et 104, pour donner un ordre de grandeur (Saltelli et al., 2008; Shin et al., 2013; Song et al., 2015), un plus grand nombre de paramètres

21

nécessitant un N plus grand. Par exemple, pour une AS sur 40 paramètres, Maranda (2014) a utilisé N = 4 000 (soit 168 000 simulations effectuées). Pour ce projet, en tenant compte des contraintes informatiques, des tests ont été faits avec N = 5000 (pour un total de 420 000 simulations par bassin versant, soit environ 12 jours de calculs) et N = 10 000 (soit 840 000 simulations par bassin versant) (voir figure 5). La section 4.1 discute de l’impact du nombre de simulations sur la convergence des résultats.

Méthode de Morris

La démarche proposée ici reprend les explications de Morris (1991) et de Saltelli et al. (2008). Un exemple numérique complet et détaillé est présenté à l’annexe C. En considérant l’espace paramétrique discrétisé en une grille Ω de p niveaux, l’effet élémentaire (EE) pour chaque paramètre i (i = 1, …, k) peut être définit par l’éq. 9 :

𝐸𝐸𝑖(𝑋) =[𝑌(𝑋1, 𝑋2, … , 𝑋𝑖−1, 𝑋𝑖+ Δ, … 𝑋𝑘) − 𝑌(𝑋1, 𝑋2, … , 𝑋𝑘)]

Δ Éq. 9

où p est le nombre de niveaux (« levels ») et Δ est une valeur au sein de { 1/(p-1),…,1-1/(p-1) }, X = (X1, X2, …,

Xk) est n’importe quelle valeur faisant partie de Ω, à la condition que le point (X+ei Δ) face aussi partie de Ω et

ei est un vecteur de zéros, sauf pour la i ème valeur qui est 1. La distribution pour EEi est obtenue en échantillonnant différents X de Ω (voir section 3.3.3 pour plus de détails) et est dénotée Fi. Dans le cas où p est pair et Δ est choisi égal à 𝑝/(2(𝑝 − 1)) (tel que recommandé par Saltelli et al. (2008)), alors le nombre d’éléments Fi est 𝑝𝑘−1[𝑝 − Δ(𝑝 − 1)]. Les indices proposés par Morris sont tout simplement l’estimation de la moyenne µ (éq. 10) et de la variance σ (éq. 11) de la distribution Fi.

µ𝑖 =1 𝑟∑ 𝐸𝐸𝑖(𝑗) 𝑟 𝑗=1 Éq. 10 𝜎𝑖 = √ 1 𝑟 − 1∑ [𝐸𝐸𝑖(𝑗) − 1 𝑟∑ 𝐸𝐸𝑖(𝑗) 𝑟 𝑗=1 ] 𝑟 𝑗=1 2 Éq. 11

où r est le nombre de trajectoires choisies. La moyenne µ est une mesure de l’effet total du paramètre sur la sortie du modèle. L’écart-type σ mesure les effets d’ordres supérieurs, comme la non-linéarité et les interactions entre les paramètres. Ainsi, l’importance (l’effet total) d’un paramètre est indiquée par un µ très différent de zéro,

22

tandis qu’un σ élevé signifie que le paramètre a un effet non linéaire sur la sortie ou qu’il y a plusieurs interactions entre ce paramètre et d’autres paramètres. Morris (1991) recommande d’utiliser les deux indicateurs ensemble pour éviter les erreurs de type II (échouer à reconnaître un paramètre important) puisque µ est vulnérable à ce type d’erreurs. En effet, dans le cas d’un modèle non monotone ou avec des effets d’interactions, la distribution

Fi peut contenir des valeurs positives et négatives, ce qui peut résulter en un faible µ si les valeurs d’effets s’annulent à cause des signes opposés, même pour un paramètre important. Dans ce cas, même si µ est faible,

σ sera élevé, permettant ainsi d’éviter l’erreur. Campolongo et al. (2007) a proposé une solution plus simple

pour pallier à cette vulnérabilité : il s’agit d’utiliser la valeur absolue de EEi (éq. 12).

µ𝑖∗=1

𝑟∑|𝐸𝐸𝑖(𝑗)| 𝑟

𝑗=1 Éq. 12

L’indicateur obtenu est nommé µ* et peut remplacer l’indicateur STi, (Saltelli et al., 2008) lorsque le coût en calculs est trop élevé pour utiliser la méthode Sobol. Plusieurs études montrent que µ* est comparable à STi pour l’ordre des rangs des paramètres (Campolongo et al., 2007; Herman et al., 2013a; Saltelli et al., 2008; Shin et al., 2013; Song et al., 2015). En effet, µ* est une mesure concise de l’effet direct du paramètre et de ses interactions avec les autres paramètres.

Le nombre total de simulations est égal à 𝑟 (𝑘 + 1). Des valeurs de l’ordre de quelques dizaines sont généralement prises pour r, en fonction du nombre de paramètres à l’étude (Campolongo et al., 2007; Morris, 1991; Ruano et al., 2012). Cependant, des valeurs plus élevées ont été utilisées par Shin et al. (2013) : pour comparer avec la méthode de Sobol (N =10 000), une valeur de r = 1 000 a été utilisée pour leur étude. Des tests ont été effectués pour différentes valeurs de r : r = 20, 1 200 ou 5 000 (voir figure 5). Finalement, une démarche semblable à Shin et al. (2013) a été suivie et la valeur de r = 1200 a été conservée (soit 99 600 simulations par bassin versant). En effet, les tests effectués avec r = 5 000 sur le BV01 ont mené à des résultats pratiquement identiques à ceux obtenus avec r = 1 200 sur le même bassin, tandis que ceux effectués avec r = 20 ne montraient pas une convergence suffisante (voir section 4.1).

3.3.6. Sélection et durée des périodes d’analyse

Le grand nombre de simulations nécessaires à l’analyse de sensibilité, multiplié par les 20 bassins versants, rend pratiquement impossible l’utilisation des séries complètes dans un délai raisonnable. Comme solution, une période de 10 ans représentative des 54 années de données disponibles a été sélectionnée pour chacun des bassins versants. La sélection se base sur la comparaison des moments linéaires (L) entre les débits de la série entière et les périodes de 10 années consécutives composant cette même série. La période retenue est celle ayant la plus petite différence entre ses moments L et les moments L de l’ensemble de la série. L’annexe D

23

présente les résultats de cette comparaison en détail. La moitié de cette période (5 ans) sert uniquement à la chauffe du modèle (« warm up »); les simulations servant pour l’AS sont réalisées sur la seconde moitié de la période (5 ans). La durée de 5 ans pour les simulations correspond au minimum suggéré par Shin et al. (2013). Herman et al. (2013b) ont considéré une période de 10 ans, mais ils ne mentionnent pas la part réservée pour la chauffe.

3.3.7. Bootstrap

Un ré-échantillonnage (« bootstrap ») est appliqué aux résultats afin de calculer l’intervalle de confiance 95% (α = 5%). Ainsi, pour la méthodologie retenue, les échantillons ont été ré-échantillonnés aléatoirement 1200 fois, avec remise. Pour tous les autres tests réalisés, le nombre de bootstrap était égal à la valeur de r (ou de N, le cas échéant). Il est important de mentionner que le bootstrap ne requière aucune simulation supplémentaire.

3.4. Sélection des paramètres

Cette section décrit la méthodologie employée pour la sélection des paramètres à fixer. Étrangement, même si le factor fixing8 est l’une des principales utilisations faites de l’AS, très peu de littérature a été trouvée sur le choix des seuils. Dans un exemple, Saltelli et al. (2008) utilisent un seuil µ* = 0,01 (les paramètres ayant un µ* < 0,01 sont jugés non-influents sur le modèle) pour fixer deux des six paramètres du modèle, tout en précisant l’aspect arbitraire de cette limite. Vanrolleghem et al. (2015), en se basant notamment sur les travaux de Sin et al. (2011), prennent un seuil à µ* = 0,1 et Si = 0,01 pour sélectionner les paramètres à fixer d’un modèle à 79 paramètres. Pour sa part, Francos et al. (2003) utilisent un seuil de 0,01 avec la méthode de Morris. Enfin, Shin et al. (2013) adoptent un seuil de STi = 0,2 pour différents modèles, en mentionnant que la prudence est de mise lorsque les valeurs sont près de ce seuil arbitraire.

Il a donc été choisi de construire quatre scénarios avec différents seuils afin d’éviter les erreurs de type II (fixer un paramètre important). Le tableau 3 présente les scénarios utilisés avec les valeurs des seuils pour la méthode de Morris (µ*) et l’équivalent de ces seuils pour la méthode de Sobol (STi). Pour simplifier la démarche, les seuils ont été appliqués sur les résultats de la médiane des 20 BV (voir les résultats d’AS à l’annexe E), plutôt que sur chaque bassin.

Tableau 3 – Présentation des trois scénarios de seuil

Scénario #1 #2 #3 #4

Seuil Morris (µ*) 0,01 0,03 0,04 0

Seuil Sobol (STi) (équivalent) 0,0025 0,015 0,025 0

8 Le factor fixing fait allusion au fait que les paramètres jugés non sensibles sont « fixées » à une valeur et ne sont plus