ةرازو

يلاعلا ميلعتلا

يملعلا ثحبلاو

Thèse

Présentée en vue de l’obtention du diplôme de

Doctorat 3

èmecycle

Intitulée

Domaine : Mathématiques et Informatique

Filière :

Informatique

Spécialité : STIC (Sciences et Technologies de l’Information et de la

Communication)

par

M

elleSoraya CHERIGUENE

Devant le jury

Dr. Nabiha Azizi

Université Badji Mokhtar – Annaba

Rapporteur

Pr. Hasina Seridi

Université Badji Mokhtar – Annaba

Président

Pr. Hamid Seridi

Université 8 Mai 1945 – Guelma

Examinateur

Pr. Labiba Souici-Meslati

Université Badji Mokhtar – Annaba

Examinateur

Pr. Yamina Mohammed Ben Ali

Université Badji Mokhtar – Annaba

Examinateur

Année 2018

UNIVERSITÉ de BADJI MOKHTAR –ANNABA

Faculté Sciences de l’Ingéniorat Département d’Informatique

راتخم يجاب تعماج

–

تبانع

Approches Ensemblistes de Classification et

Sélection des Prédicteurs pour la

I

Je remercie tout d’abord Dieu tout puissant de m’avoir donné le courage, la force et la patience d’achever ce modeste travail

Je tiens à exprimer ma profonde gratitude à mon directeur de thèse Dr AZIZI Nabiha pour la confiance et l'intérêt qu'elle a porté à mes travaux depuis mes débuts dans le monde de la recherche ainsi que pour m’avoir fait profiter de sa sagesse et de son expérience durant ces quatre années de thèse.

Je tiens également à remercier Pr SERIDI Hasina pour avoir bien voulu accepter de présider le jury de cette thèse. Mes remerciements vont également à Pr MOHAMMED BEN ALI Yamina, Pr SOUICI-MESLATI Labiba et Pr SERIDI Hamid qui ont participé à cette soutenance en tant qu’examinateurs.

Je voudrais également remercier tous les membres de laboratoire LABGED pour l’amitié et l’aide qu’ils m’ont témoignés durant cette thèse.

Les derniers mais non les moindres, j’adresse ici mes plus chaleureux remerciements à ma famille, mes proches et à mes amis qui m'ont toujours soutenu et encouragé pendant ce long travail avec une pensée particulière à Rana et Amel.

Merci papa pour être tellement fier de moi. Les mots me manquent pour exprimer à quel point je suis heureuse d’être à vos côtés. Merci Asma et Meryem, mes deux grandes sœurs adorées. Je peux dire sans hésitation que je n’aurais jamais réussie à en arriver là sans votre amour et votre soutien inconditionnels au cours des 27 dernières années. Merci à vous et à mes deux merveilles Frères, Zine Edinne et Amine pour m’avoir accompagnée dans cette aventure.

Enfin, bien que le mot merci ne soit pas suffisant ici pour celui qui est tous les jours à mes côtés depuis bientôt quatre ans, qui me soutient sans faiblir, qui a toujours su me réconforter dans les moments difficiles, par son écoute, son soutien et ses conseils : Merci Fouad.

II

صخلملا

حزٍخلأا دإُسنا ًف ج ، ذثذ دبٍجُٓي خػًٕجي فُصًنا دب بظُنا ٔأ و تافينصتلا ددعتم ًنَا ىهؼزنا غًزجي وبًزْا ىٓي فٍُصر ةٕهسأك . ٔ دبفُصًنا ٍي ذٌذؼنا ٍٍث غًجنا ٌأ سبحثلأا دزٓظأ ذق خطسٕزي ضفأ ْٕ ءادلأا ٍي مٓسأٔ م ذحأ زّشؤي ٍػ شحجنا خٌبغهن قٍقد . ًٍضزر ءبشَإ خٍهًػ دبفٍُصزنا دذؼزي وبظَ وبػ مكشث لاا :ًْ خٍسٍئر محازي سلاص ءبشَ ، ٔ ربٍزخلاا جيذنا . فُصًنا ربٍزخا دب يذنأ محازًنا ىْأ ٍي ْٕ خٍهًػ َّأ ىهػ ّفٌزؼر ٍكًٌ خٍيسرإخن بقفٔ ،ءبقزَا زٌٍبؼئ شحث حدذحي ، ن ث ؤجُزهن خٍفبك خجرذث خهْؤًنا دبفُصًنا ٍي خٍنبضي خػًٕجً ٍُؼنا خئف دب نا زٍغ خفُصي . ٔ ًف ًٌّذقر ىر يذنا شحجنا لٔبُزٌ خنبسزنا ِذْ ٌٕطر ز تٍنبسأ غًج ءبقزَا ٔ فُصًنا دب دبٍُقر ىًٍصر قٌزط ٍػ لا فُصًنا ربٍزخ دب ءبُث ىهػ ادبًزػا "عُٕزنا ٔ خقذنا" ٍٍث قفإر ت حرتم ةمهاسملا لولأا ى ةحورطلأا هذهل اماظن لااعف ،ةيبطلا روصلا فينصتل يئاوشعلا ءاضفلا ةميرط نيب عمجي رايتخلااو يياعم مادختساب تافنصملل تباثلا ر عونت .ةفلتخم امأ ةيناثلا انتمهاسم ف كلعتت حارتلاب جهنم ل ديدج لا رايتخ تباثلا تافنصملا دامتعلااب ىلع جمد ةمءلاملا سايمم و ريياعم ةفلتخم ثحب تايمزراوخ مادختساب عونتلا . ديدحتلا جذامن نأ انظحلا دمل ةلمعتسملا رابتخلاا تانيع لك فينصتل طمف ةدحاو ةيعرف ةعومجم راتخت يف لبمتسملا . .رابتخلاا تانيع ضعبل اًبسانم تافنصملا نم ةيلاثم ةيعرف ةعومجم رايتخا دعي لا ،نلذ عمو ،ببسلا اذهل يف حرتمن يمانيدلا رايتخلال ديدج جهنم ةيئاهنلا ةمهاسملا فينصتل ةءافك رثكلأا ةيعرفلا ةعومجملا رايتخاب حمسي ،يك رابتخا ةنيع لك . ةيبطلا تانايبلا دعاول فينصت ءادأ نيسحت ىلإ جهنملا اذه فدهي ةصاخ للاخ نم ةنزاوتملا ريغ قرط نيب عمجلا تانيعلا ذخأ تافنصملا رايتخلا ةيكيمانيدلا ةيجيتارتسلااو . ٍٍجر دبَبٍث ذػإق حذػ ىهػ بْبٌُزجأ ًزنا خفهزخًنا ةربجزنا ذٍجنا بْءادأ ٔ خحززقًنا دبٍجًُٓنا حءبفك بًٍف ًخصبخ ، دبفُصًهن ًكٍيبٌُذنا ربٍزخلابث قهؼزٌ . ةيحاتفملا تاملكلا : ،فينصتلا امنلأا ىلع فرعتلا ،عونتلا ،تافنصملا جمد ،ط ؛ةلدلا ،تافينصتلا ددعتم ماظن رايتخلاا يكيمانيدلا رايتخلاا ،تباثلا ، ."عُٕزنا ٔ خقذنا" ٍٍث قفإرIII

Ces dernières années, les approches d’Ensemble de Classifieurs (EdC) ou les systèmes multi-classifieurs ont attiré l’attention de la communauté de l’apprentissage automatique en tant que technique de classification significative. Trois mécanismes fondamentaux régissent la création d’un système multi-classifieurs : la génération d’un ensemble des classifieurs diversifiés, la sélection des classifieurs et finalement la combinaison des sorties des classifieurs sélectionnés. La sélection de classifieurs est une phase fondamentale dans le processus d’optimisation d’un système multi-classifieurs. Le travail de recherche présenté dans cette thèse concerne le développement d’approches de construction d’ensemble de classifieurs se basant sur le compromis « diversité-précision».

Dans un premier temps, un système multi-classifieurs combinant la méthode Random Subspace et la sélection statique est proposé pour la classification des images médicales. L’étape de sélection de classifieurs de cette approche est basée sur l’utilisation de différentes mesures de diversité pour l’évaluation de la compétence des sous-ensembles candidats. Notre deuxième contribution concerne la proposition d’une nouvelle approche de sélection statique de classifieurs basée sur l’intégration de la méthode mRMR (minimum Redundancy Maximum Relevance) et les mesures de diversité en utilisant différents algorithmes de recherche

.

Nous avons observé que cette approche de sélection a choisi un seul EdC pour classer tous les échantillons de test ou de généralisation. Cependant, il n y a aucune garantie que l’EdC sélectionné est l’ensemble le plus susceptible pour classer un échantillon non-étiqueté. À ce titre, notre dernière contribution porte sur une nouvelle approche de sélection dynamique de prédicteurs permettant de choisir, pour chaque exemple à classer, l’EdC le plus confiant pour décider la classe d’appartenance. Cette approche vise à améliorer la performance de classification des bases de données médicales déséquilibrées en combinant les approches d’échantillonnage des données d’apprentissage et la sélection dynamique de prédicteurs.

IV

montrent de très bonnes performances des approches proposées, plus particulièrement celle basée sur la sélection dynamique de classifieurs.

Mots-Clés : Classification ; Reconnaissance de Formes ; Combinaison de classifieurs ;

Mesures de Diversité ; Système Multi-Classifieurs ; Précision ; Sélection de Classifieurs Sélection Statique ; Sélection Dynamique ; Relevance ; Compromis « Diversité-Performance».

V

Abstract

In recent years, classifier ensembles approaches or Multiple Classifier Systems (MCSs) have attracted the attention of the machine learning community as a significant classification technique. In general, the MCS construction process consists of three main stages: generation, selection, and fusion. Classifier subset selection step plays a crucial role in the MCS construction process. The research work exposed in this thesis concerns the development of new schemes of classifier ensemble construction based on “diversity-accuracy” compromise.

First and foremost, a new multiple classifier system for medical images classification is proposed. This approach is based on combination of the Random Subspace method and the static classifier selection using different diversity measures to evaluate the competence of each candidate subset. Our second contribution concerns the proposition of a new static classifier selection approach based on the integration of the mRMR (minimum Redundancy Maximum Relevance) method and diversity measures using different search algorithms.

We have observed that these selection paradigms choose only one subset for all test or unseen instances. However, selecting a globally optimal subset of classifiers is not appropriate for some test samples. For this reason, the final contribution concerns a new dynamic classifier selection approach which allows choosing the most competent classifier subset for classifying each test sample. This approach aims to improve the classification performance of imbalanced medical databases by combining oversampling approaches and a dynamic classifier selection strategy.

Experimental results show that the proposed approaches have very good performances.

Keywords: Classification; Pattern Recognition; Classifier Combination; Diversity Measures;

Multiple Classifier System; Accuracy; Classifier Selection; Static Selection; Dynamic Selection; “Diversity-Accuracy” Compromise.

VI

Table des Matières

Remerciements ... I صخلملا ... II

Résumé ... III

Abstract ... V Table des Matiéres ... VI Liste des Figures ... X Liste des Tableaux ... XII Liste des Abréviations ... XIV

Introduction Générale ... 1

Chapitre 1. Concepts Généraux de Combinaison de Classifieurs ... 8

1.1 Introduction ... 8

1.2 Formalisme de la classification supervisée ... 11

1.2.1 Définition d’un classifieur ... 11

1.2.2 Evaluation des classifieurs ... 13

1.3 Combinaison de classifieurs ... 15

1.4 Les architectures de combinaison ... 17

1.4.1 Combinaison séquentielle ... 17

1.4.2 Combinaison parallèle ... 18

1.4.3 Combinaison hybride ... 18

VII

1.5.1 Problématique de la combinaison parallèle ... 20

1.5.2 Catégorisation des méthodes de combinaison ... 21

1.6 Méthodes de combinaison non paramétrique ... 23

1.6.1 Type classe ... 23

1.6.2 Type rang... 24

1.6.3 Type mesure ... 25

1.7 Méthodes de combinaison paramétrique ... 28

1.7.1 Type classe ... 29

1.7.2 Type rang... 32

1.7.3 Type mesure ... 34

1.8 Conclusion ... 36

Chapitre 2. La Diversité pour la Construction et la Sélection d’Ensemble de Classifieurs……….. ... 37

2.1 Introduction ... 37

2.2 Diversité pour génération des classifieurs ... 38

2.2.1 Échantillonner les données d’apprentissage ... 39

2.2.2 Modifier l’espace de représentation ... 41

2.2.3 Manipuler les membres de l'ensemble ... 42

2.2.4 Manipuler les sorties ... 43

2.3 Quantification de la diversité ... 43

2.3.1 Mesures pairwise (par-paires) ... 43

2.3.2 Mesures globales (non- pairwise) ... 46

2.3.3 Limites de mesures de diversité ... 48

2.4 Sélection de classifieurs... 49

2.5 Sélection statique de classifieurs ... 50

2.5.1 Regrouper et extraire ... 50

VIII

2.6 Sélection dynamique de classifieurs ... 59

2.6.1 Définition de la région de compétence ... 61

2.6.2 Critère de sélection ... 63

2.6.3 Schéma de sélection ... 64

2.6.4 Techniques de la sélection dynamique ... 65

2.7 Conclusion ... 70

Chapitre 3. Approche Hybride basée sur Random Subspace et la Sélection Statique des Classifieurs ……….. ... 71

3.1 Introduction ... 71

3.2 Système multi-classifieurs pour le diagnostic des images médicales... 72

3.2.1 Les bases des images médicales ... 74

3.2.2 Prétraitement et extraction de caractéristiques ... 75

3.2.3 Approche basée sur les mesures de diversité pour la sélection d’ensemble de classifieurs. ... 79

3.3 Etude expérimentale ... 83

3.3.1 Paramètres expérimentaux ... 83

3.3.2 Résultats expérimentaux ... 85

3.4 Conclusion ... 91

Chapitre 4. Sélection Statique de Classifieurs Combinant la Diversité et la Méthode mRMR…… ... 93

4.1 Introduction ... 93

4.2 La méthode mRMR ... 95

4.3 Sélection statique de classifieurs basé sur la méthode mRMR et les mesures de diversité ... 97

4.3.1 Génération des classifieurs ... 97

4.3.2 Sélection de classifieurs ... 97

4.3.3 Combinaison de classifieurs sélectionnés ... 102

IX

4.4.1 Paramètres expérimentaux ... 103

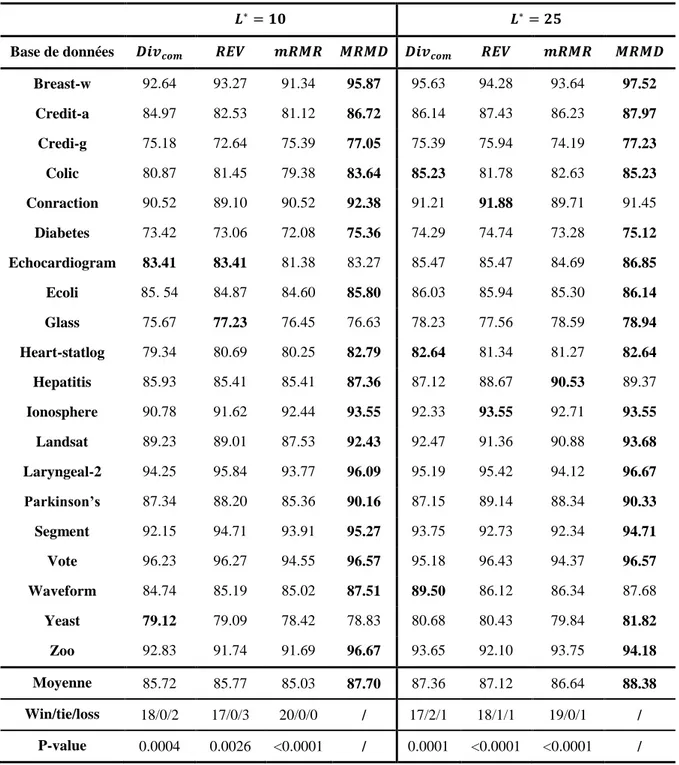

4.4.2 Evaluation de la méthode MRMD ... 105

4.4.3 Evaluation de la méthode MRMD-II ... 109

4.5 Conclusion ... 120

Chapitre 5. Sélection Dynamique de Classifieurs Combinant la Diversité et la Méthode mRMR ... 122

5.1 Introduction ... 122

5.2 Apprentissage sensible au déséquilibre des classes ... 124

5.2.1 Stratégies algorithmiques ... 124

5.2.2 Stratégies d’échantillonnage ... 125

5.2.3 Stratégies ensemblistes ... 126

5.3 Sélection dynamique de classifieurs basée sur la méthode mRMR et les mesures de diversité ... 126

5.3.1 Génération d’ensemble de classifieurs ... 127

5.3.2 Sélection dynamique de classifieurs ... 128

5.4 Expérimentation ... 132

5.4.1 Les bases de données utilisées ... 132

5.4.2 Résultats expérimentaux ... 132

5.5 Conclusion ... 143

Conclusion et Perspectives ... 145

Liste de Publications ... 149

X

Liste des Figures

Le schéma général d'un système de classification. ... 10

Figure 1.1.

Représentations de Dietterich pour les EdCs ... 16

Figure 1.2.

Combinaison séquentielle de classifieurs ... 17

Figure 1.3.

Combinaison parallèle de classifieurs. ... 18

Figure 1.4.

Combinaison hybride de classifieurs. ... 19

Figure 1.5.

Taxonomie des méthodes de combinaison parallèle de classifieurs... 22

Figure 1.6.

Description schématique de l’apprentissage et la combinaison d’un ensemble

Figure 2.1.

de classifieurs par la méthode Bagging. ... 40 Apprentissage et agrégation de classifieurs par la méthode Boosting... 41

Figure 2.2.

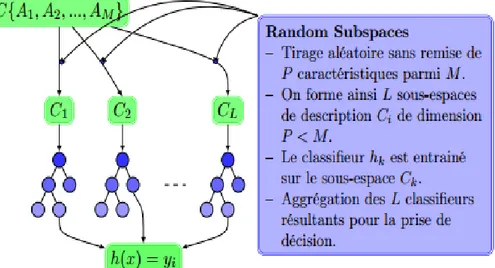

Illustration du principe de la méthode Random Subspace pour un ensemble

Figure 2.3.

d’arbres de décision……….. ... 42 Schéma général du processus OCS. OCS est divisé en deux phases de

Figure 2.4.

surproduction et de sélection ………. ... 52 Processus de la sélection dynamique de classifieurs. ... 60

Figure 2.5.

Schéma général du système multi-classifieurs proposé pour le diagnostic des

Figure 3.1.

images médicales………. ... 73 Un échantillon de la base DDSM : les images (a) et (b) représentent des

Figure 3.2.

images mammaires à masse maligne et les images (c) et (d) représentent des masses

bégnines…….. ... 74 Images de fond d'œil typiques tirées de la base de données RIM-One: (a et b)

Figure 3.3.

XI

Les quatre directions d'adjacence pour calculer les caractéristiques de texture

Figure 3.4.

de Haralick…. ... 78 Précision moyenne du système proposé RSS-SCS en utilisant différentes

Figure 3.5.

mesures de diversité sur les bases de données DDSM et RIM-One. ... 87 Précision moyenne du système proposé RSS-SCS sur les bases de données

Figure 3.6.

DDSM et RIM-One en utilisant différentes types de classifieurs de base. ... 88 Précision moyenne du système proposé RSS-SCS sur les bases de données

Figure 3.7.

DDSM et RIM-One en utilisant différentes tailles de . ... 89 Courbes ROC des bases de données DDSM et RIM-One. ... 90

Figure 3.8.

Schéma de génération d’ensemble préliminaire des classifieurs... 97

Figure 4.1.

Comparaison entre les résultats obtenus par MRMD utilisant différentes

Figure 4.2.

mesures de diversité, avec . ... 106 Comparaison entre les résultats obtenus par MRMD utilisant différentes

Figure 4.3.

mesures de diversité, avec . ... 107 Diagrammes Kappa-Erreur des bases : Breast-w, Credit-a, Credit-g, Colic,

Figure 4.4.

Contractions, Diabetes, Echocardiogram, Ecoli, Glass et Heart-statlog. ... 118 Diagrammes Kappa-Erreur des bases: Glass, Heart-statlog, Hepatitis,

Figure 4.5.

Ionosphere, Landsat, Parkinson’s, Vote, Waveform, Yeast et Zoo... 119

Figure 5.1. Un organigramme du système multi-classifieurs proposé. ... 127 Figure 5.2. Les courbes ROC des bases Appendicitis, Diabetes, DDSM,

Echocardiogram, Heart-disease et Hepatitis. ... 137

Figure 5.3. Les courbes ROC des bases Laryngeal1, Parkinson’s, Respiratory, RIM-One,

Weaning et WBC. ... 138

Figure 5.4. Les diagrammes kappa-erreur des méthodes : (a) Random Subspace, (b)

DES-MRMD-II et (c) DES-MRMD-III sur les bases Appendicitis, Diabetes et

Echocardiogram. ... 142

Figure 5.5. Les diagrammes kappa-erreur des méthodes : (a) Random Subspace, (b)

XII

Liste des Tableaux

Espace de connaissance du comportement à 2 dimensions. ... 31

Tableau 1.1.

Exemple de recherche des tailles des listes des classifieurs dans

Tableau 1.2.

l’intersection….. ... 33 Procédure min-max pour déterminer les seuils dans l’union. ... 34

Tableau 1.3.

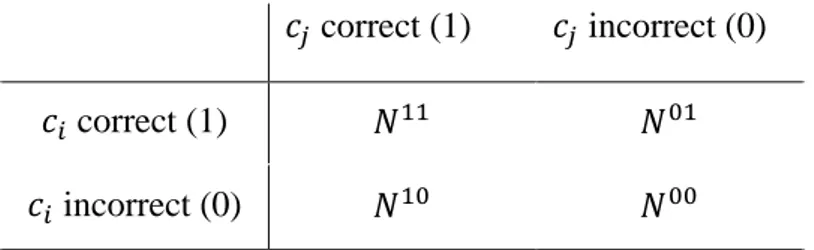

Tableau 2.1. Relation entre les sorties de deux classifieurs et . ... 44

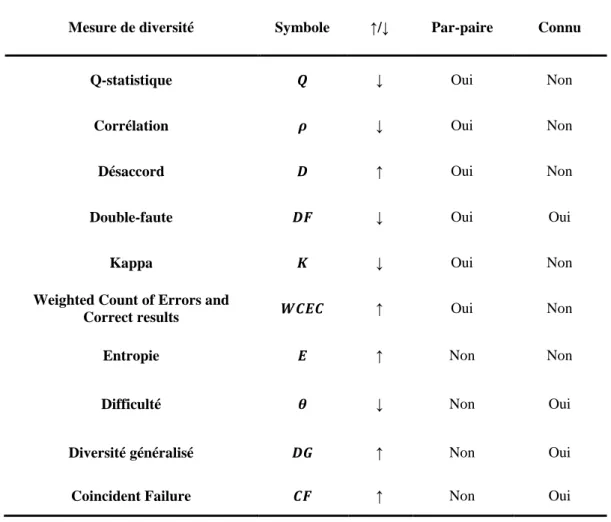

Tableau 2.2. Résumé des mesures de diversité, où ↑(↓) indique que plus la mesure est

grande (plus petite), plus la diversité est grande, "Connu" indique s'il nécessite de connaître la précision des classifieurs individuels……. ... 49

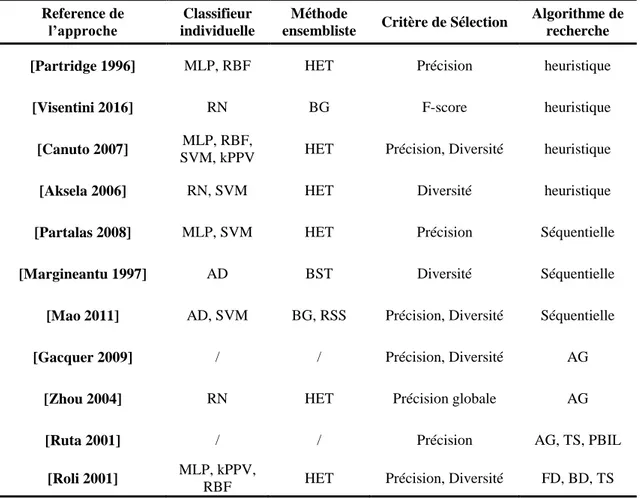

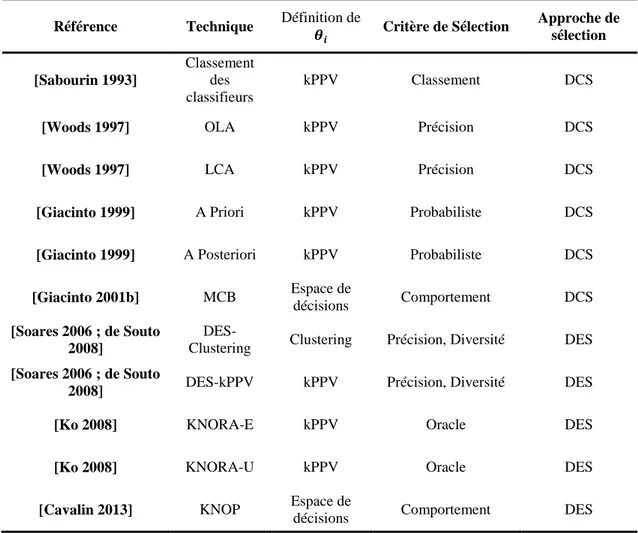

Tableau 2.3. Résumé de certains travaux de la sélection statique rapportés dans la littérature……… ... 57

Tableau 2.4. Catégorisation des méthodes de sélection dynamique. ... 65 Matrice de confusion. ... 84

Tableau 3.1.

Précision du système proposé RSS-SCS sur la base de données DDSM. . 86

Tableau 3.2.

Précision du système proposé RSS-SCS sur la base de données RIM-One.

Tableau 3.3.

……...87 Résultats obtenus sur les bases de données DDSM et RIM-One par

Tableau 3.4.

différents EdC………… ... 90 Différents systèmes de classification du cancer du sein. ... 91

Tableau 3.5.

Différents systèmes de classification pour le diagnostic du glaucome. .... 91

Tableau 3.6.

XIII

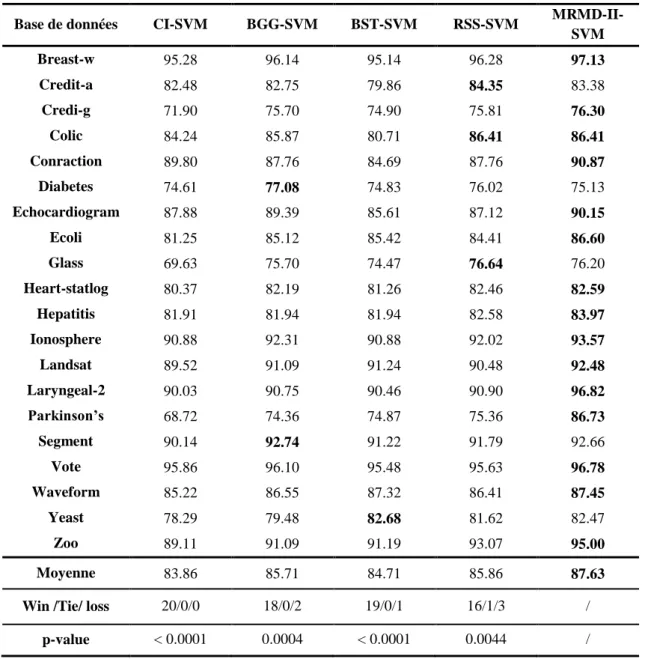

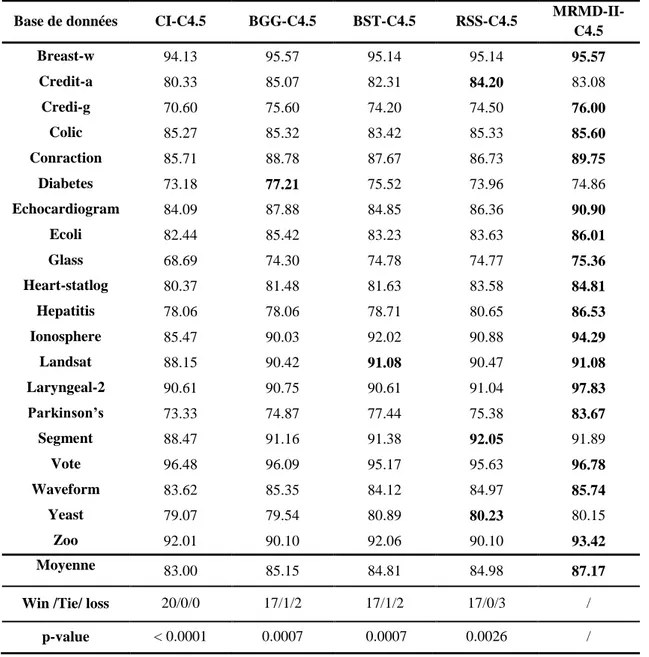

Tableau 4.2. Taux de classification des différentes méthodes de sélection, en utilisant

différentes valeurs de . ... 108

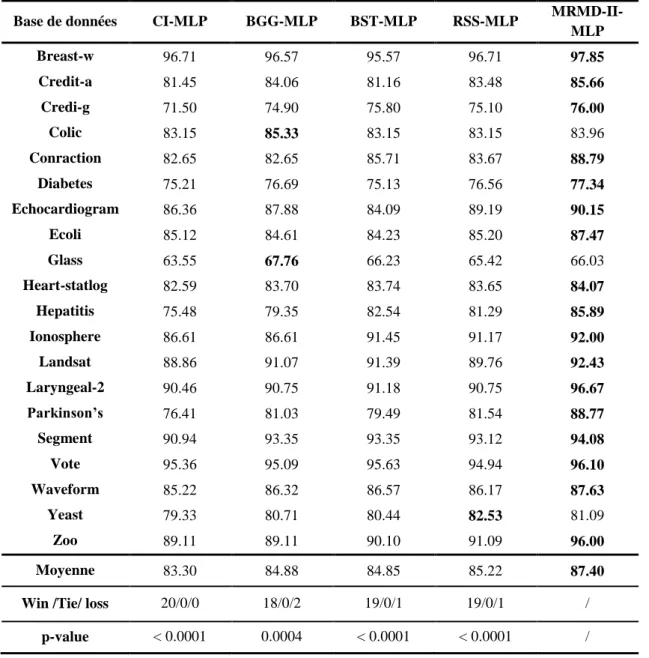

Tableau 4.3. Comparaison entre l’utilisation d’un classifieur unique et différents méthodes ensembliste utilisant le classifieur MLP... 110

Tableau 4.4. Comparaison entre l’utilisation d’un classifieur unique et différents méthodes ensembliste utilisant le classifieur SVM. ... 111

Tableau 4.5. Comparaison entre l’utilisation d’un classifieur unique et différents méthodes ensembliste utilisant le classifieur C4.5. ... 112

Tableau 4.6. Comparaison entre la méthode RSS et différentes méthodes de sélection utilisant un ensemble de classifieurs hétérogènes. ... 114

Tableau 4.7. Comparaison des résultats de précision de différentes versions de schéma de sélection MRMD-II. ... 115

Tableau 4.8. Description des bases de données déséquilibrées ... 116

Tableau 4.9. Résultats de Sensibilité (SEN) et de Spécificité (SPE) obtenus sur des jeux de données déséquilibrées en utilisant différents ensembles de classifieurs. ... 116

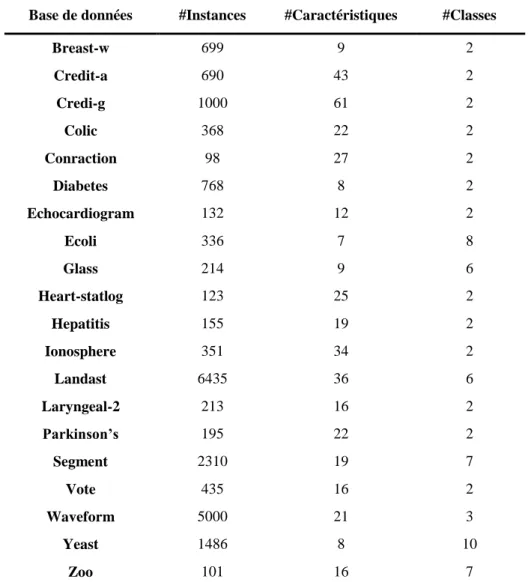

Tableau 5.1. Caractéristiques des bases de données utilisées. ... 132

Tableau 5.2. Résultats de précision de l’approche DES-MRMD-II et différentes méthodes de sélection…… ... 134

Tableau 5.3. Résultats de sensibilité de différentes méthodes de sélection. ... 135

Tableau 5.4. Résultats de spécificité de différentes méthodes de sélection. ... 135

Tableau 5.5. Résultats d’AUC de différentes méthodes de sélection... 136

Tableau 5.6. Description des bases de données déséquilibrées ... 139

Tableau 5.7. Taux de classification de différents ensembles de classifieurs sur des bases de données déséquilibrées. ... 140

Tableau 5.8. Résultats de sensibilité (SEN) et spécificité (SPE) de différents ensembles de classifieurs sur des bases de données déséquilibrées... 140

XIV

Liste des Abréviations

AG Genetic Algorithm AD Arbre de Décision

AUC L’air sous la courbe ROC (Area Under ROC Curve) BK Recherche en Arrière (Backward search)

BKS Espace de Connaissance du Comportement (Behaviour Knowledge Space)

DCS Sélection Dynamique de Classifieurs (Dynamic Classifier Selection) DDSM La base de données numérique pour la mammographie de dépistage

(Digital Database for Screening Mammography)

DES Sélection Dynamique d’Ensemble de Classifieurs (Dynamic Classifier Selection)

DSEL base de données de la sélection dynamique (dynamic selection dataset) EdC Ensemble de Classifieurs

FD Recherche en Avant (Forward search)

GANSEN Genetic Algorithm based Selective Ensemble

GLCM La matrice de co-occurrence des niveaux de gris (Gray Level Co occurrence Matrix)

HET Hétérogènes

IM Information Mutuelle

KNORA les k plus proches oracles (k-Nearest Oracles)

XV kPPV k- Plus Proche Voisins

KL Kullback-Leibler

LCA Local Classifier Accuracy

MCB Comportement de Classifieur Multiple (Multiple Classifier Behavior) MCS Système Multi-Classifieurs (Multiple Classifier system)

MID Mutual Information Difference MIQ Mutual Information Quotient

MLP Réseau de Neurones Multi-Couches (Multi-Layer Perceptron) mRMR minimum Redundancy Maximum Relevance

MRMD Maximum Relevance Maximum Diversity

OCS Surproduction et choix (Overproduce and Select Strategy) OLA Overall Local Accuracy

PBIL Population Based Incremental Learning

RBF Réseaux à Fonction de Base Radiale (Radial Basis Function)

RIM-One Une Base de données rétinienne pour l’évaluation du nerf optique (Retinal Image Database for Optic Nerve Evaluation)

ROC Fonction d’efficacité du récepteur (Receiver Operating Characteristic) RRC Randomized Reference Classifier

RSS Random Subspace

SCS Sélection Statique de Classifieurs (Static Classifier Selection) SVM Machine à Vecteur de Supports (Support Vactor Machine)

1

Introduction Générale

La classification est l’une des techniques les plus anciennes d’analyse et de traitement de données qui compte parmi les plus grandes réussites de l’apprentissage automatique. La classification peut être définie comme le problème de la détermination de l'appartenance d'un ensemble d’observations à une nouvelle catégorie. Cette détermination est basée sur un ensemble de données d'apprentissage qui comprend des observations dont leurs appartenances à une catégorie sont connues. Plusieurs algorithmes de classification ont été proposés et utilisés dans différents domaines de la reconnaissance de formes mais les travaux récents de l’apprentissage automatique ont montré qu’aucune méthode individuelle ne peut être efficace pour traiter tous les problèmes de classification et que le choix d’une méthode de classification dépend du problème posé. Ceci a confirmé le théorème No Free

Lunch de Wolpert stipulant que «no algorithm is better than any other over all possible classes of problems». Par conséquent, la question de savoir quelle méthode de

classification pourrait convenir à une étude spécifique n'est pas facile à répondre. Pour résoudre ce problème complexe de classification, la combinaison de classifieurs a été proposée comme solution prometteuse.

En général, les ensembles de classifieurs sont considérés comme un développement important dans le domaine de l'apprentissage automatique et de l'intelligence artificielle. Le concept intuitif de l'apprentissage d'ensemble est qu'aucune approche ou système unique ne peut prétendre être supérieur à un autre et que l'intégration de plusieurs approches améliorera la performance de classification. Différents scénarios et stratégies de combinaison ont été introduits dans la littérature, à savoir : séquentiel, parallèle et hybride. L’architecture parallèle est la stratégie la plus communément utilisée dans les travaux de la combinaison de classifieurs. Cette architecture est simple à mettre en œuvre et facilement

2

généralisable parce qu’elle ne nécessite pas de connaitre le comportementde chacun des classifieurs. De nombreuses règles de combinaison ont été proposées pour combiner en parallèle les résultats d’un ensemble de classifieurs. Ces méthodes de fusion peuvent être catégorisée sur la base des sorties des classifieurs utilisés dans la combinaison qui sont généralement divisés en trois types, à savoir : classe, rang et mesure.

La plupart de ces méthodes de combinaison reposent sur l’hypothèse que tous les membres de l'ensemble font des erreurs indépendantes. L'efficacité des méthodes d'ensemble dépend généralement de l'indépendance des erreurs commises par les classifieurs de base pris individuellement. En outre, les experts du domaine ont prouvé que la performance de l’ensemble ne peut être meilleure que celle des classifieurs individuels si ses membres sont différents et pas nécessairement indépendants. Par conséquence, les membres de l’ensemble doivent reflètent un certain niveau de diversité. Ce concept de diversité est généralement considéré comme la capacité des classifieurs à faire des erreurs différentes sur les mêmes points de données. La diversité entre les classifieurs peut être générée de différentes manières, par exemple en utilisant des modèles de classification différents; manipulant les données d’apprentissage; manipulant les caractéristique d’entrée ou en utilisant différents types de sorties de classifieur.

Bien que le débat sur la nature de la diversité des classifieurs se poursuive, du point de vue technique, la notion de diversité ne peut être évidente que si elle est soutenue par des mesures appropriées. C’est là que les problèmes de diversité ont commencé à apparaître à grande échelle. Différentes mesures pour la quantification de la diversité ont été étudiées par Kuncheva et Whitaker [Kuncheva 2003a]. Ces mesures ont ouvert la voie à plusieurs travaux sur l’utilisation de la diversité de manière explicite durant le processus de construction d’un système multi-classifieurs tant qu’outil théorique, outil de visualisation ou comme un critère de sélection de classifieurs. Les études de Kuncheva et Whitaker [Kuncheva 2003a] ont montré également que ces mesures ne permettent pas de donner une idée claire sur la relation entre la performance de l’ensemble et la diversité de ces membres.

Généralement, la performance d’un ensemble des prédicteurs peut se varier selon le nombre et le type des classifieurs combinés. Lorsqu’on dispose d’un grand nombre de classifieurs, on se pose toujours la question de savoir combien et quels classifieurs choisir pour améliorer la performance de l’ensemble. Une phase intelligente de sélection de

3

classifieurs au cours de processus de construction d’un système d’ensemble est devenue cruciale pour aboutir au meilleur taux de classification avec un nombre minime de classifieurs. Deux catégories de techniques de sélection de classifieurs existent: statique et dynamique. Dans le premier cas, les classifieurs sont sélectionnés pendant la phase d'apprentissage et combinés pour classer tous les échantillons de test, tandis que dans le deuxième cas, elles sont définies pendant la phase de classification en tenant compte des caractéristiques de l'échantillon à classer. La sélection dynamique de classifieurs est traditionnellement définie comme une stratégie qui suppose que chaque membre de l'ensemble est un expert dans certaines régions locales de l'espace des caractéristiques. Le classifieur le plus localement compétant est sélectionné pour estimer la classe de chaque échantillon particulier de test.

Problématique

En général, trois facteurs cruciaux interviennent dans l’optimisation d’un système ensembliste de classification : la construction d’un ensemble adéquat de classifieurs, la sélection des meilleurs membres et la conception d’une règle de fusion. La sélection de classifieurs est la phase fondamentale dans le processus d’optimisation d’un système multi-classifieurs, car elle se concentre sur la recherche du sous-ensemble des multi-classifieurs, dont leurs combinaison produit une précision optimale. La performance d’une méthode de sélection dépend du choix de l'algorithme de recherche et du critère de sélection. Nous avons vu que, même si plusieurs contributions importantes ont été apportées à ce sujet, beaucoup de questions restent ouvertes :

- Comment définir un meilleur critère de recherche pour trouver le meilleur sous-ensemble de classifieurs ? En outre, la sélection des classifieurs ou prédicteurs les plus performants n’est pas forcément la bonne solution pour aboutir au meilleur résultat, est-ce que la diversité est un meilleur critère de sélection par rapport à la précision? et est-ce qu’on peut équilibrer ces deux facteurs en définissant un compromis entre eux ?

- Bien que la recherche du sous-ensemble optimal de classifieurs puisse être exhaustive, des algorithmes de recherche peuvent être utilisés lorsqu'un grand groupe initial de classifieurs est généré en raison de la complexité exponentielle d'une recherche exhaustive. La question qui se pose est est-ce que l’utilisation des

4

méthodes de recherche non-exhaustive peut trouver un sous-ensemble optimal de classifieurs ?

- La majeure limite de la sélection statique est qu’un sous-ensemble fixe de classifieurs défini à l'aide d'un ensemble de données de validation qui ne peut pas être bien adapté à l'ensemble de données de test. De plus, le concept de la sélection statique est assez similaire à l’utilisation d’un classifieur individuel pour classer tous les échantillons de test ; c’est-à-dire qu’en raison des différences entre les échantillons, il n’existe aucun classifieur individuel parfaitement adapté à tous les échantillons de test. Par conséquence, la question revenant est savoir est-ce que la sélection dynamique consistant à choisir un sous-ensemble de classifieurs pour chaque échantillon de test, est meilleure que la sélection statique ?

Objectifs et Contributions

L'objectif principal de cette thèse est de développer une méthodologie pour améliorer la précision d’ensemble de classifieurs en concevant des techniques de sélection de classifieurs.Nos objectifs peuvent être cernés par les points suivants :

- Etudier le rôle des mesures diversité au cours de processus de sélection des classifieurs.

- Montrer expérimentalement le comportement de processus de choix de classifieurs en utilisant différent paramètres de sélection comme : le type des classifieurs, le nombre de classifieurs à sélectionner et le critère de recherche utilisé.

- Clarifier le lien existant entre la diversité et la performance des classifieurs en proposant un compromis entre eux et l’utiliser pour guider les différents algorithmes de recherche.

- Proposer une stratégie de sélection dynamique pour permettre le choix du sous-ensemble de classifieurs les plus compétents pour étiqueter chaque échantillon de test.

Afin de répondre aux besoins cités ci-dessus, trois contributions ont été proposées. La première contribution se fonde sur la notion de diversité et leur utilisation comme critère deconstruction et de sélection de classifieurs. Le système ensembliste proposé est basésur

5

la combinaison de la méthode Random Subspace et la sélection statique de classifieurs. L’objectif de cette contribution est de montrer que la création d’un certain niveau de diversité pendant la phase de génération et de sélection de classifieurs permet de construire un système robuste de classification. La diversité a été renforcée entre les membres de l’ensemble initial de classifieurs en modifiant l’espace de caractéristiques avant l’apprentissage de chaque classifieur donné. Afin d’analyser l’influence de la diversité sur la performance globale du système, des mesures de diversité ont été introduites au cours de la phase de sélection. De plus, une recherche exhaustive est appliquée sur toutes les paires de mesures de diversité durant la phase de validation.

Afin de pallier des principaux inconvénients de l’approche précédente qui sont le coût de calcul, et plus particulièrement l’utilisation d’un seul critère de sélection (qui est la diversité), notre deuxième contribution suggère différents algorithmes de recherche en utilisant un nouveau compromis « diversité-précision » pour obtenir une génération optimale d’un système ensembliste. Le concept de la relevance entre les sorties des classifieurs et la classe cible ainsi qu’une combinaison des mesures de diversité sont utilisés en tant que critère de sélection. Ce critère a été utilisé comme un outil pour mesurer le lien entre la diversité d’opinions évaluées entre les membres de l’ensemble et la performance globale.

Nous avons intéressé plus particulièrement dans cette thèse des données médicales qui souffrent en majorité de déséquilibre entre classes. D’où notre dernière contribution qui consiste à proposer un système de sélection dynamique de classifieurs pour la classification des données déséquilibrées. La stratégie de sélection dynamique proposée dans cette thèse permet la sélection, pour chaque exemple à classer, d’un sous-ensemble de classifieurs le plus confiant pour décider la classe d’appartenance. Notre système vise à résoudre le problème de l’asymétrie des classes en deux niveaux. Premièrement, une approche d’échantillonnage est considérée pour rééquilibrer l'ensemble de données d'apprentissage, ensuite, une approche de sélection dynamique est appliquée sur l’ensemble de classifieurs générés sur les données équilibrées. Cette stratégie de sélection est basée sur un nouveau compromis diversité-performance proposé pour les données déséquilibrées. La méthode de sélection dynamique proposée domine les approches conventionnelles (approches statiques) sur les problèmes de classification des données médicales étudiés dans le cadre de cette thèse.

6

Plan de la thèse

La présente thèse est organisée de la manière suivante :

Dans le premier chapitre, nous présentons un formalisme de la classification supervisée dans le cadre de la combinaison de classifieurs, et nous introduisons un ensemble de notations qui seront utilisées tout au long du présent manuscrit. En outre, Les principales architectures de combinaison (séquentielle, parallèle et hybride) sont présentées en revue. De plus, nous présentons un état de l’art varié et précis, bien que non-exhaustif, sur les méthodes classiques proposées pour la combinaison parallèle de classifieurs

Le chapitre 2 permet de répondre aux limitations des méthodes décrites dans le premier chapitre en introduisant la notion de la diversité. La première partie de ce chapitre décrit le problème lié à la diversité de classifieurs en illustrant les différentes stratégies de génération d’ensemble de classifieurs, ainsi que les mesures proposées pour estimer la diversité entre les membres de l’ensemble. Dans la deuxième partie, nous passons en revue les principales méthodes de sélection des classifieurs en présentant une taxonomie des systèmes de sélection (statique et dynamique), ainsi que le rôle que joue la diversité dans l’amélioration de performance durant le processus de sélection.

Le chapitre 3 présente notre première contribution qui est la proposition d’un système multi-classifieurs basé sur la méthode Random Subspace et la sélection statique de classifieurs pour la classification des images médicales. Dans ce chapitre, nous cherchons à clarifier le rôle de la diversité généralement dans le processus de construction d’ensemble de classifieurs et plus particulièrement dans la phase de sélection.

Le chapitre 4 aborde la seconde contribution basée sur la sélection statique de classifieurs en intégrant la méthode mRMR et les mesures de diversité. Dans cette contribution, nous mettons en œuvre deux approches originales de sélection basées sur un compromis diversité-précision pour tenir en compte simultanément de la diversité et de la performance des classifieurs en utilisant différents algorithmes de recherche de classifieurs. Les deux systèmes proposés seront détaillés successivement incluant les résultats expérimentaux et les bases de données intervenues dans la réalisation de ces systèmes.

7

Dans le chapitre 5, nous présentons notre dernière contribution qui est la proposition d’un système ensembliste basé sur la sélection dynamique de classifieurs. Ce système vise à traiter le problème des données déséquilibrées dans les cas médicales en combinant l’approche d’échantillonnage SMOTE et la sélection dynamique de classifieurs. Enfin, nous achevons cette thèse par une conclusion générale ainsi que les perspectives envisagées pour la poursuite de ce travail.

8

Chapitre 1

Concepts Généraux de Combinaison de

Classifieurs

1.1

Introduction

Parmi les nombreuses disciplines représentées en informatique, l’Apprentissage Automatique, ou Machine Learning en anglais, domaine d’étude de l’intelligence artificiel, concerne la conception, la recherche, le développement et l'implémentation d’algorithmes permettant à une machine d’apprendre réaliser l’induction automatique de règles à partir d’un ensemble d’exemples [Gacquer 2008a]. De manière formelle, nous disons que la machine doit apprendre à produire la sortie désirée lorsqu’elle est face à une situation spécifique [Mitchell 1999]. En apprentissage automatique, on peut distinguer deux grandes familles dépendantes des informations disponibles sur les données à classer : l’apprentissage supervisé et l’apprentissage non supervisé.

L’apprentissage est dite supervisé [Vincent 2003 ; Oltean 2009] si les classes auxquelles appartiennent les exemples sont connues à l’avance et si la tâche d'apprentissage est guidée par la décision d’un superviseur ou d’un expert. Le but est de trouver un modèle qui décrit au mieux la relation entre les attributs et les classes afin de prédire la classe d’appartenance d’un nouvel exemple issu du système à surveiller.

L’apprentissage non-supervisé (ou clustering) [Jain 1999] se distingue de l’apprentissage supervisé par le fait que la nature et le nombre des classes d’appartenance sont déterminés sans aucune connaissance préalable [Hansen 1997]. L'objectif, dans ce cas, est de partitionner un ensemble de données hétérogènes en plusieurs sous-ensembles d’individus ayant des caractères similaires. Les objets sont attribués aux différentes classes

9

estimées selon deux critères essentiels qui sont la similitude entre les individus de chaque classe et la bonne séparation entre les classes.

Cette thèse concerne plus particulièrement le problème de la classification. La classification [Cormack 1971 ; Belacel 1999 ; Henriet 2000] est l'une des tâches d'apprentissage supervisé consistant à classer les objets dans un ensemble fini de classes. L’objectif de la classification est de construire un modèle qui sera ensuite utilisé pour la classification des nouveaux objets (ou exemples) dont la classe d’appartenance est inconnue. Ces objets représentent des unités de données compactes spécifiques à un problème particulier comme les images, les paroles, les caractères manuscrits et sont généralement appelés « échantillon » ou « instance ». Une instance est représentée par un ensemble de propriétés quantifiables appelées « caractéristiques » qui devraient contenir des informations pertinentes sur la structure de l'objet que nous souhaitons à classer [Zhang 2003]. Ces caractéristiques peuvent potentiellement être collectées à partir d'un grand nombre de sources de données, ce qui se traduirait par un vecteur de mesures de haute dimensionnalité.

Pour prendre une décision sur un échantillon non étiqueté, un système de classification doit se baser sur la connaissance a priori qui prend souvent la forme d’exemples connus [Vapnik 1998]. L’ensemble de ces exemples est appelé la base d’apprentissage ou la base d’entraînement. Cette base est fournie par l’expert humain qui structure les données et les étiquettes. Pour mesurer les performances d’un système de classification, une autre base de données étiquetée est utilisée. Cette base; appelée base de test ; ne doit pas avoir servi de connaissance préalable pour ne pas biaiser la mesure de performance. Laclassification est validée en évaluant sa pertinence à travers le taux des exemples de test bien classés.

Afin de garantir la performance globale d’un système de reconnaissance, le processus de classification doit être précédé par d’autres étapes préliminaires qui sont le prétraitement [Liu 2001 ; Zhang 2003] et l'extraction de caractéristiques [Liu 2013 ; El-Atlas 2014 ; Sundararaj 2014]. Un schéma général d'un système de classification est illustré à la figure 1.1. Lors de l’étape de prétraitement, les objets d’entrée sont mis en forme et traités avant toutes manipulations afin de faciliter la tâche d’extraction de caractéristiques. Parexemple, c’est à cette étape qu’un signal sera filtré, qu’une image sera binarisée,normalisée ou redimensionnée pour obtenir une image plus lisible.

10

Échantillons d’apprentissage

Échantillons de test

Ensuite, ces objets seront représentés par des vecteurs de caractéristiques où chaque composante est un attribut qualitatif (vert, rond, chaud, etc.) ou une mesure faite sur les objets réels (hauteur d’un vérin dans un système mécanique, nombre de pixels noirs d’une image, amplitude, phase d’un signal électrique, etc.)

Le schéma général d'un système de classification.

Figure 1.1.

L’un des défis de la reconnaissance de formes est de créer des systèmes de classification qui soient à la fois simples et performants. Différents algorithmes de classification (ou d’apprentissage) ont été proposés dans la littérature, tels que les arbres de décision [Quigley 1986], les réseaux de neurones [Tang 2016], les k plus proches voisins (kPPV) [Tremblay 2004], machines à vecteurs de support (Support Vactor Machine, SVM) [Hearst 1998], etc. Étant donné l'échantillon et sa classe avec une fonction inconnue , tous ces algorithmes d'apprentissage cherchent à trouver dans l'espace d'hypothèses la meilleure fonction d'approximation , qui est un classifieur, à la fonction .Par conséquent, le but de ces algorithmes est la conception d'un classifieur unique robuste et bien adapté au problème concerné.

Il existe plusieurs façons pour améliorer la précision de ces algorithmes de classification. Les derniers travaux de l'apprentissage automatique [Woods 1997 ; Rahman

Prétraitement Extraction des caractéristiques Classification Prétraitement Extraction des caractéristiques Classification L'étiquette de classe

11

2003 ; Tulyakov 2008 ; Zhang 2015] ont proposé d’utiliser plusieurs classifieurs différents pour effectuer les tâches de reconnaissance de formes, ce qu'on appelle un système multi-classifieurs (Multiple Classifier system, MCS), système ensembliste ou un Ensemble de Classifieurs (EdC).

Dans cette thèse, les contributions apportées concernent les approches ensemblistes de classification. Cependant, nous présentons brièvement d’abord les différents aspects de la classification supervisée dans le cadre de la combinaison, pour éviter toute confusion éventuelle, et nous présentons ensuite les différentes architectures et stratégies de combinaison de classifieurs.

1.2

Formalisme de la classification supervisée

1.2.1 Définition d’un classifieur

Soit un ensemble de objets. est un exemple décrit par un vecteur d’attributs [ ] de mesures, , ainsi que par un label qui lui est associé, ou est l’ensemble des classes. Chaque exemple est un vecteur de dimension composé d’un ensemble des paramètres continus (numériques) et / ou discrets (nominaux). Le processus de classification a pour but d’établir une transformation de l’espace d’attributs vers l’espace de classes [Vapnik 1998]. C’est cette transformation qui est souvent appelée classifieur.

→ (1.1)

Basé sur la définition de la classification, un classifieur (prédicteur ou expert) peut être vu comme une fonction permettant d'assigner à chaque vecteur de caractéristiques d’un nouveau exemple une des classes pour lequel on ne dispose pas d’information a priori [Bishop 2006]:

→ (1.2)

La mise en œuvre d’unclassifieur nécessite généralement de choisir une représentation pour décrire les données(caractéristiques) et une base d'apprentissage qui permet de fixer les paramètres de l’algorithme de décision. Introduire des modifications à un classifieur que ce soit au niveau des données qu'il traite ou au niveau de ses paramètres (type de

12

sorties, règles de décision, etc.) modifie ses performances. Une généralisation de la définition d’un classifieur est proposée dans [Duda 1973] : un classifieur est un algorithme permettant d’associer à un exemple à reconnaitre un vecteur de niveau d’appartenance de cet exemple à une classe :

[ ] (1.3)

La fonction discriminantes avec représente le degré d’appartenance d’un objet à une classe . Dans ce cas, l’exemple peut appartenir à plusieurs classes si . La règle d'agrégation maximale est utilisée pour définir la classification comme suit:

(1.4)

Selon Xu [1992], cette réponse peut être divisée en trois catégories suivant le type d'information fournis par le classifieur :

Type classe: c’est le type le plus général mais qui apporte le moins d’informations. Dans ce type, le classifieur ne fournis que l'étiquette de classe attribuée à l’exemple d’entrée. Il pointe vers une catégorie unique en tant que classe gagnante en ignorant les informations sur les chances de sélection des autres classes en tant que décision finale.

(1.5) Type rang: dans ce niveau, la sortie d’un classifieur est un vecteur ordonné de classes candidates. La classe positionnée en premier est considérée comme le type de classe le plus probable, tandis que la classe placée à la fin du vecteur est la plus improbable. En outre, il n'y a aucune valeur de confiance incluse dans les étiquettes de classe dans ce type. Cependant, sa position dans la liste montre sa probabilité relative. Soit le rang attribué à la classe par le classifieur , la sortie de

est définie par :

13

Type mesure: nombreuses méthodes de classification génèrent leurs décisions sur la base de certaines mesures obtenues par une fonction discriminante d'un classifieur ou de certaines mesures de distance parmi les données de l'espace d'entrée. Dans ce type, la sortie d’un classifieur est un vecteur des mesures de taille , ou chaque mesure représente le niveau de confiance attribué à chaque classe . Cette mesure de confiance, normalisée ou non, peut-être des nombres arbitraires selon la structure de classification utilisée (une probabilité a posteriori, un score, une distance, une possibilité, une crédibilité, etc.). Par conséquent, le type mesure contient plus d'informations par rapport aux autres types de sortie.

(1.7)

1.2.2 Evaluation des classifieurs

L’évaluation des performances d’un classifieur est une phase importante dans le processus de conception d’un système de classification. Elle permet de savoir si ce système est suffisamment performant pour l’application visée et permet également de le comparer avec d’autres méthodes de classification. Une variété de mesures d’évaluation en fonction de différents critères a été proposée pour décrire la performance d’un classifieur, allant de la précision de classification et du taux d'erreur, en passant par la complexité du stockage et le temps de calcul jusqu'à la sensibilité et la robustesse [Vapnik 1998].

Pour évaluer le taux de classification ou la précision d’un classifieur, la méthode communément utilisée consiste à partitionner la base de données disponible en deux sous-ensembles et . La base est dédiée à l’apprentissage du classifieur et la base est utilisé comme un ensemble d’exemples de test inconnus pour l’évaluation de ses performances. La précision obtenue sur chacun des partitionnements est définie par :

| | ∑ { ( )} | | (1.8)

Où | | représente la taille de l’ensemble de test , représente la classe prédis par le classifieur pour l’échantillon et est sa classe réelle. La fonction est donnée par :

14

( ) {

(1.9)

Pour évaluer les qualités prédictives finales du modèle, on considère la précision moyenne des résultats obtenus sur les différents partitionnements réalisés. Cette méthode présente l’avantage de fournir une bonne estimation des facultés prédictives des modèles obtenus, en évitant une dépendance du résultat au choix particulier des échantillons d’apprentissage et de test. Le choix du partitionnement dépend principalement de la quantité de données disponibles. Une quantité très grande des exemples d’apprentissage peut induire un problème de sur-apprentissage du modèle, dont les facultés prédictives sur de nouveaux exemples sont diminuées. A l’inverse, un ensemble d’apprentissage de taille trop faible risque de provoquer une situation de sous-apprentissage, qui se traduit par un modèle incorrect et peu précis. Une étude des différentes approches de validation d’un modèle est présentée dans [Boser 1992] et [Gacquer 2008a]. Nous en présentons quelques-unes :

La méthode Hold-out consiste à partitionner aléatoirement les données de départ en deux sous-ensembles, généralement de tailles égales. Un sous-ensemble est utilisé pour la phase d’apprentissage, et l’autre servant à tester ou évaluer la performance du modèle de classification. Un cas particulier de cette méthode, appelé split-half consiste à de permuter les deux parties et d’évaluer le classifieur par la moyenne des deux estimations ainsi obtenues.

La validation croisée en blocs (k-fold cross validation) partitionne l'ensemble de données aléatoirement en sous-ensembles de taille approximativement égale. À chaque itération, un bloc est utilisé comme ensemble de test tandis que les autres blocs sont combinés pour former un ensemble d'apprentissage. L’algorithme d’apprentissage est exécuté fois, en changeant de bloc pour tester le classifieur. La précision finale est estimée en moyennant les performances obtenues à chaque itération. Afin de garantir que chaque sous-ensemble est un bon représentatif de la base de départ, les données sont souvent stratifiées avant d'être divisées en blocs de sorte que chaque bloc contient à peu près les mêmes proportions de classes que l'ensemble des données initial. Ceci est communément appelé validation croisée stratifiée en blocs.

15

La méthode leave-one-out est une version particulière de la validation croisée pour lequel est égal au nombre des exemples disponibles . L’ensemble test est alors constitué d’un seul exemple et la phase d’apprentissage est effectuée sur les exemples restants. Ce typede validation est plus long à mettre en œuvre du fait de la taille importante de l’ensemble d’apprentissage et du nombre d’itérations nécessaires mais elle s’avère particulièrement utile aux problèmes pour lequel la taille d’ensemble d'apprentissage est limitée. D’autre part, cette méthode donne une estimation précise du taux d’erreur du classifieur.

Les méthodes de validation croisée décrites précédemment sont basées sur le partitionnement des données initiales en plusieurs sous-ensembles sans remplacement. Une approche alternative basée sur le bootstrap consiste à générer ensembles d'apprentissage de taille , appelés bootstrap samples, en effectuant des tirages aléatoires avec remise sur l’ensemble de données initiale. Un classifieur différent est alors entrainé sur chacun des ensembles de données ainsi formés et les échantillons non inclus dans l'ensemble d'apprentissage sont utilisés pour tester le modèle. La moyenne des précisions de chaque classifieur constitue l’estimation par

bootstrap ordinaire [Efron 1994].

1.3

Combinaison de classifieurs

L’idée de combinaison de classifieurs a été apparue dans les années 80 dans de nombreux travaux de la de reconnaissance de l’écriture manuscrite [Srihari 1982 ; Hull 1983 ; Hull, 1988 ; Mandler ; Lam 1994] qui ont montré l’importance de combinaison de différents prédicteurs pour l’amélioration de performances de ces problèmes de classification. Cependant, ce n’est qu’à la fin des années 90 et plus abondamment par la suite que les systèmes ensemblistes ont été concrètement mis en œuvre [Zouari 2004]. L’objectif de la combinaison de classifieurs est de produire un nouveau système de classification robuste, constitué d’un ensemble de prédicteurs de base afin de bénéficier de leur éventuelle complémentarité. Intuitivement, un modèle ensembliste permet de réduire le nombre d’exemples qui seraient mal classés par un modèle unique tout en conservant un temps de calcul raisonnable.

Ces dernières années, plusieurs travaux ont montré que l’utilisation d’un ensemble de classifieurs permet d’améliorer de manière significative les performances obtenues en

16

classification par rapport à l’utilisation d'un seul modèle. Les auteurs de [Fuchs 2015] et de [Verbiest 2016] ont prouvé que l’utilisation d’un ensemble de kPPVs donne de meilleur résultats que l’utilisation d’un kPPV unique ; les travaux de [Stork 2015 ; Zhou 2018] et ont prouvé la supériorité des systèmes utilisant des SVMs combinés par rapport à ceux basés sur un seul SVM et Pham et al. [Pham 2017] ont montré des améliorations de performance en combinant un ensemble de réseaux neurones, au lieu d'utiliser un seul réseau de neurones.

Selon Dietterich [2000a], il y a trois raisons principales pour lesquelles un ensemble de modèles peut donner souvent des résultats plus précis qu'un seul modèle, qui sont de nature statistique, computationnelle et représentationnelle. La figure 1.2 illustre ces raisons.

Aspect statique : un algorithme d’apprentissage a une grande variance statique lorsqu’il trouve différentes hypothèses qui semblent bien approximer la fonction recherchée durant la phase d’apprentissage mais qu’il choisit l'hypothèse la moins compétente lorsqu'il est testé sur des données inconnues. Cette variance peut être diminuée en combinant plusieurs hypothèses.

Aspect computationnelle : les algorithmes d’apprentissage sont généralement basés sur des techniques exploitant les minimums locaux et, par conséquent, peuvent être bloqués dans de ces optimums. La combinaison de différents minimaux locaux peut fournir une meilleure approximation de .

Aspect représentationnel: l'espace d'hypothèse H ne contient pas toujours de bonnes approximations de la fonction . Dans ce cas, les EdC permettent d'élargir l'espace des fonctions évaluées conduisant à une meilleure approximation de .

Représentations de Dietterich pour les EdCs [2000a].

17

1.4

Les architectures de combinaison

Pour intégrer les sorties des classifieurs dans une décision finale, trois architectures de combinaison peuvent être envisagées : séquentielle parallèle, et hybride [Heutte 1994, Rahman 2003].

1.4.1 Combinaison séquentielle

Les classifieurs de cette topologie sont organisés à des niveaux successifs de décision où chaque classifieur produit un ensemble réduit de classes possibles d’un objet à classer. Dans chaque niveau, il existe un seul classifieur qui prend en compte la décision prise auparavant afin de traiter les rejets ou confirmer la décision obtenue aux niveaux précédents (figure 1.3). L’efficacité de ce type de combinaison dépend généralement de l’ordre d'exécution des classifieurs. Les classifieurs doivent donc être ordonnés de telle sorte que les premiers classifieurs n’éliminent pas la bonne solution [Rahman 2003]. Intuitivement, les premiers classifieurs de la chaîne nécessitent d'être robustes plus que d'être performants car leur tâche est de sélectionner certaines classes candidates de sorte que la classe réelle de l’objet à classer doit apparaître dansles listes successives produites par ces classifieurs. En effet, si cette classe était éliminée dès les premiers filtrages, la décision finale serait erronée. La fin de la chaîne doit contenir des classifieurs plus performants qui ont la faculté de discriminer un nombre restreint de classes.

Combinaison séquentielle de classifieurs ( représente l’échantillon

Figure 1.3.

18

1.4.2 Combinaison parallèle

Cette topologie est la plus communément utilisée dans les systèmes ensemblistes. Cette architecture est simple à mettre en œuvre et facilement généralisable parce qu’elle ne nécessite pas de connaitre le comportement de chaque membre de l’ensemble [Zouari 2004]. Les classifieurs fonctionnent indépendamment les uns des autres puis leurs décisions sont combinées pour prédire l'étiquette d'un modèle inconnu (voir la figure 1.4). L'ordre des classifieurs n'est pas important dans ce type de configuration. La majorité des travaux les plus importants de la littérature appartiennent à cette catégorie comme : la reconnaissance de l’activité humaine [Nazabal 2016], la reconnaissance de caractères et de mots manuscrits [Ahmed 2017], l’identification de visages [Bashbaghi 2017] et la reconnaissance des images médicales [Choi 2016].

Combinaison parallèle de classifieurs ( représente la décision du

Figure 1.4.

classifieur pour l’exemple ) [Zouari 2004].

1.4.3 Combinaison hybride

Certains systèmes de combinaison effectuent à la fois des techniques séquentielles et parallèles afin de tirer parti des avantages de ces deux architectures simultanément. dans une architecture hybride de combinaison, les classifieurs individuels sont combinés en une structure similaire à celle d'un arbre de décision. Les nœuds d'arbre, cependant, peuvent maintenant être associés à des classifieurs complexes nécessitant un grand nombre de caractéristiques [Gosselin 1997]. Ce type de combinaison nécessite une bonne

19

connaissance de chacun des classifieurs utilisés de façon à choisir l’architecture la plus adaptée. La figure 1.5 fournitune représentation de la combinaison hybride de classifieurs.

Combinaison hybride de classifieurs [Zouari 2004].

Figure 1.5.

1.5

Combinaison parallèle de classifieurs

Les approches séquentielles et hybrides de combinaison ont été largement ignorées par les chercheurs. La majorité des travaux dans le domaine d’ensemble de classifieurs se concentre principalement sur la combinaison parallèle de classifieurs. Plusieurs raisons peuvent expliquer l'intérêt porté par les chercheurs à la combinaison parallèle [Zouari 2004]:

Deux membres différents du même ensemble peuvent présenter des performances globales équivalentes mais chacun d'eux est un expert dans certaines régions locales de l'espace de caractéristiques ou il est le plus performant.

Dans un système ensembliste, il est possible d'utiliser un espace de caractéristiques de grande dimension mais en les repartant à des sous-ensembles différents ou chaque sous-espace est utilisé pour entrainer un classifieur individuel.

La performance d'un classifieur peut être affectée par le choix de paramètres initiaux tels que le nombre de voisins (k) pour un kPPV et les nombres de couches et de neurones par couche pour un réseau de neurones multicouches (Multi Layer

Perceptron, MLP). Plutôt que de chercher la meilleure configuration des

paramètres, la combinaison parallèle peut profiter des avantages de ces modèles appris différemment.

Dans la combinaison, on peut avoir à notre disposition, différentes bases d'apprentissage où chacune a été capturée sur les mêmes données par différents

20

capteurs ayant des caractéristiques différentes. L'apprentissage d'un même modèle de classification sur ces bases peut produire des résultats différents.

Ce sont ces avantages qui nous ont conduits à focaliser notre travail sur la combinaison parallèle.

1.5.1 Problématique de la combinaison parallèle

Dans un système de combinaison parallèle, chaque membre participe de manière indépendante sur le même problème de classification et les sorties de tous les classifieurs sont combinée dans une dernière étape à une décision unique. Le problème principal de la combinaison est comment combiner les réponses de ces classifieurs sont combinées pour produire une décision finale ? Ce problème nécessite l’utilisation d’un opérateur de combinaison pour élaborer une réponse finale [Zouari 2004].

Considérons un système de classification composé d'un ensemble de L classifieurs . Pour reconnaître la classe d’un exemple inconnu , chaque classifieur

produit une sortie sous forme d'un vecteur des fonctions discriminantes

. Cette sortie peut être de type classe, rang

ou mesure. La composante indique que le classifieur a attribué la classe à

l’exemple parmi l'ensemble de classes possibles ( , . Toutes les réponses de l'ensemble des classifieurspour un exemple peuvent être présenter sous forme d'unematrice . Chaque ligne de cette matrice représente les décisions de tous les classifieurs concernant la classe .

Chaque colonne représente le vecteur de sorties d'un classifieur pour l’échantillon .

( ) (1.10)

La décision de fusion est obtenue en combinant les vecteurs de s de chaque classifieur :

21

est appelé opérateur de fusion ou méthode de combinaison ou d'agrégation. De nombreux opérateurs de combinaison ont été proposés dans la littérature et ils ont été présentés par différentes taxonomies. Nous les passons maintenant en revue.

1.5.2 Catégorisation des méthodes de combinaison

Différentes taxonomies des méthodes de fusion des sorties des classifieurs ont été présentées dans la littérature [Xu 1992 ; Duin 2000 ; Jain 2000 ; Kuncheva 2000]. La première catégorisation a été proposée par Xu [1992] qui a construit une taxonomie simple basé sur le type de sorties des classifieurs (classe, rang, mesure). La faiblesse de cette catégorisation est qu'elle est trop générale et qu'au sein de chaque groupe, il existe encore une grande variété parmi les méthodes de combinaison de classifieurs.

Une autre taxonomie des méthodes de fusion baséesur la stratégie de combinaison est proposée par Kuncheva [2000] qui a fait la différence entre la fusion et la sélection de classifieurs. Rappelons que la fusion consiste à combiner toutes les réponses de classifieurs alors que la sélection consiste à choisir le meilleur sous-ensemble de classifieurs parmi l’ensemble initial pour identifier unéchantillon inconnu.

Selon Duin [2000], la catégorisation des méthodes de combinaison parallèle estliée au type de classifieurs à combiner : classifieurs hétérogènes (différents) et classifieurs homogènes (faibles). En effet, même si ces dernières tiennent compte de toutes les informations produites par les classifieurs, l'intérêt des méthodes de combinaison de classifieurs faibles réside dans la combinaison de classifieurs ayant la même structure mais entraînés sur différents sous-espaces de caractéristiques ou leurs paramètres sont configurés de manière différente [Zouari 2004].

La taxonomie présenté par Jain [2000] a catégorisé les méthodes defusion suivant trois critères d'égale importance : type de sorties des classifieurs, capacité d'exploitation des expertises des classifieurs et la capacité d'apprentissage de la combinaison. Ce travail a ouvert la voie à d’autres travaux sur l’utilisation de la capacité d’apprentissage pour séparer les méthodes de fusion comme le travail de Zouari [2004] qui a proposé une taxonomie des méthodes de fusion en fonction de deux critères: type de sorties des classifieurs à combiner et la capacité d'apprentissage.