I

J

I-l

I{

J

I

{

J

@"ou

nEPuBrre^arca,ryarlrn^n_

-trrinisftrede,c

roriffffwcanQuEE?

^"*"#;::

;;;;:".'

et de to

a""n

","J

WIVEngnE

r.

---'ztcfiQa€

.-'tcLtz€

Facuhd

des!",**

seddt

ut**,

a*nl

Ben

Yahia

-

Jiiel

Ddpan"n2sal

de

furatht

et

rnformAique

maiqaes

J

J

J

I

fuIimoire

Pour

I,obtet

irr,4STEn*:'#:;:#;;;;,

apion

: PRnBABILTTEs_s

TATrs

TrQ

UE

PTisident

:

SELLEfoII

NAWEL

Encadreur

:

ABDf

ZEWNEB

Examinateur

:

GHOUIL

DJOWEWDA

MQZ

qE$1W

BEKOIICHE

KIIADIDJA

A

BOTIfuTELTA

SONIA

{:v

-'!"**"

-[t

! ,l

dffi

I ; i l I-. vv*

trous

renfon'r

t:::

'ebu

{ui

nous

a

fontt

w

potience

et

fe

couwe

poo',

nrro*pfir

r,

:

ta^votow4

faide,

'odeste

fe

trovaif

tro16

tends d

remzrcie

vive_en+

p^-

?I

tatfe

et

fes

,",;:.:;':T::*ent

rencadt

cotueifsqu'e[[enou-r",":'::.':y'a66zqnu6pour

'1

""^

-'

nowaProdigws'

:\ ow

amenon

rprtto.yn)^-.

, ,

t

'

"*yu&r'

L

pr,tfe

s seu,

[,

;",:::'b

:':i

t

sin

ci

re meft

d

s

rn*;

&

nosJury.

uruaersitti

ft Jllt[

fli

a

nrrrori

ro;;;;ffifr

*

;i,"rm,!:f

::::.dreltercurgnouitDjnwyraW)

-foit

f

fronntur

'f,nr.on*.--r--,

doccepter

"'<'r

gruawl

Q$'

fepger

nos

tuavaif

A

toutcs

fes

ensrignantes

fe spdcwfit|

qui

ont

sa

f,onner

une

formation

cursus.

\

\

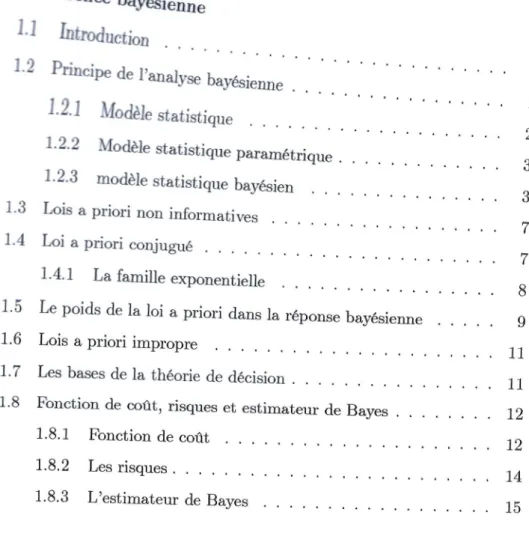

Table

des

rnatidres

lll 1 1 't 2 3 3 vt Fl t 8

I

11Ioi

apriori

conjugud1.4.1

La famille exponentielle1.5

Le poids de laloi

apriori

dans Ia r6ponse bay6sienne1.6

Lois apriori

impropreLes bases de

la

th6orie de ddcisionFonction de oorlt, risques et estimateur de Baves

1.8.1

Fonction de co0t1.8.2

Les risques1.8.3

L'estimateur de Bayesi

11 72 12I4

15Intr,oduction

I

Lrinf€neae

ba'dsienne

I.I

Intmduction

1.2

hincipe

de l,analyse ba},6sienne1.2.1

Mo&le

sratisrique1.2.2

Modlle

statistique param6trique1.2.3

modCle statistique bay€sien [,ois apriori

non informatives7.7

1.8

1.3

MBLE

DESMATIERES

2

Les

tests

bay6siens2.7

Introduction

2.2

l'approche standard2.3

Une premidre approche d,la th6orie des tests2.3.1

Approche parla

fonction de co0t detype

&.1.

.2.4

Une deuxi&me approche d6cisionnelle3

Le facteur de

Bayes

293.1

Introduction

293.2

Le facteur de Bayes pour tester lesparamdtres

293.2.7

Modification de laloi

apriori

313.3

Facteur de Bayes pour tester lesmoddles

343.4

Propri6t6s asymptotiques de facteur deBayes

. . .

.

.

394

La

comparaison

entre

les tests

bay6siens

et le

facteur

deBayes

424.1

Introduction

424.2

Les essaiscliniques

424.3

L'application avec les testsbay6siens

454.4

L'application

avec le facteur deBayes

484.5

mndusion

...50

Conclusion

Bibliographie

r.9 19 19 20 27 25 51 53Introduction

La

statistique est une science au raisonnementquantitatif.

Elle offre uncadre formel

pour

mesurerl'incertitude.

Plus sp6cifiquement,Ia

statistique permet de quantifier la probabilit6 d'un dvBnement pourtirer

des inf6renceset prendre des d6cisions.

Pour calculer des probabilit6s, faire des inf6rences et prendre des d6cisions, deux pa"radigmes coexistent :

- l'approche fr6quentiste, bas6e sur les tests d'h5rpothdse avec le calcul de

Ia p-value et le calcul d'intervalles de confiance.

-

I'approche bay6sienne, bas6e surla

notion de probabilit6 conditionnelleet

le th6orgme de Bayesqui

stipule quela

probabilit6d'un

6vdnement n'est pas uniquement d6termin6epar

les r6sultats expdrimentaux nouveaux mais aussi par des r6sultats ant6rieurs (probabilit6 apriori).

L'approche bay6sinne a donn6e beaucoup

pour

analyser les donn6es ex-pr€mentalesdrns

de nombreux domaines, enparticulier

dansla

rechercheclinique et de l'6conomie.

L'6tude des tests bay6siens a

fait l'objet

de plusieursliwes

et articles16-cent, et a gagner I'atention de nombrer:x chercheurs et statisticiens I Lecoutre

(2m6), Robert (2007), Bernardo (2010), Shein-Chung Chow (2010).

Et

6largiCHAPITRE

O.IN?RODUCTION

Ie domaine de son

utilisation,

et la recherche ne pas arreter dans cette limite, mais elle est 6tendue d une nouvelleformat qui

est le facteur de Bayes quia facilit6

la

t6che des statisticiens dla

possibilit6 deI'utilisation

de logicielsd'application tels que

R,

SAS...etc.Dans ce m6moire, la question qui est pos6e : Est-ce-que le facteur de Bayes

a

le

mdmer6le

que les tests bay6siens?

autrementdit,

danstel

probldmede d6cision, Est-ce-que nous avons

arriver

d la

m0me d6cision dansle

casd'utilisation

del'un

sans l,autre ?Ce m6moire est organis6 comme

suit

:Dans le premier chapitre, nous pr6sontons quelques d6finitions et

propri&

t6s des 6l6ments th6oriques de l'analyse bay6sienne cornme laloi

apriori,

laloi

a posteriori, les risques, la fontion decott

...etc.Pour

le

deuxidme chapitre,on

donnela

th6orie math6matique des tests bay6siens, on considdre d'abord une premi6re approche bay6sienne standarddes tests

qui

repose surl'6volution

des d6cisionspar

des coots 0-

1. puis on\a

construire une alternative d I'approche de Neyman-pe&rson fondde surdes coflts plus adapt6s pour

justifier

les probabilit6s a posteriori.Dans

le

troisidme chapitre,on

s'int6rdsseaux

deux types de facteur deBayes;

le

facteur de Bayespour

tester les pa,ra,mctreset

enoorele

facteurde Ba5'es

pour

tester les moddles, avec des propri6t6set

des exemples pourles deux t54res, puis nous donnons les propri6t6s asymptotique du facteur de

Bayes.

Et

on termine par le quatridme chapitre on oommence par une rappel surles essais cliniques. Puis on

fait

effectivement une 6tude d,un probldme dansles essais cliniques pour raison de comparer les tests bay6siens et le facteur de

bayes. dans

la

r6solution du probrdme onutilise

d,un c6t6 res tests bay6sienspar

des calculs statistiquesa l'aide

dela loi

a posterioriet

d,autrecot6 le

Chapitre

1

Ltinf6rence

bay6sienne

1.1

fntroduction

L'objectif

principal de

Ia

statistique

bay6sienneest

de mener, gr6,ce dI'ohserrration

d''n

phGnomdne al6atoire, soit d,analyse d.,un ph6nomdne pass6,soit une

pr6dictif

d'rm ph6nomcne, en nous attachanttout

particulidrement aux aqrect ddcisionnels de I'inf6rence bay6sienne.L'inf6rence baydsien'e s'accompagne d'une mod6lisation de probabilitd

du ph6nomCne ohserv6 qui est n6cessaire.

1.2

Principe

de ltanalyse

bay6sienne

soit

x :

(rt,...,rn)

n-6chantillon de variables al6atoiresiid

de densit6CYIAPITEE

1.

L'INFEP,ENCE

BAI'd,SIEJVJVE

observations ff1,...,

rn

est not6ef (*lg)

telle que :r@til:

I1

r@,to)

z=1

Dans l'inf6rence bay6sienne, on considdre d un param6tre ar6atoire

et on a associ6e a

I'information

tir6e de l,6chantillon,une information prevennant

d'une

autre

souree, cetteinformartion

additionnellesur d

est r6sumfu par uneloi

deprobabilit6

n(.)

dite rloi a

priorir

du

paramdtre0.

L,inf6rence bay6sienne est alors fond6e su.r uneloi

dite

rrioi a posteriori'r de 0 qui est une fonction de waisembiance du moddreet

dela

roi apriori

de d.

Le

sch6ma suivant r6sumela

d6marche bay6sienne dans re cadre de rastatistique param6trique inf6rentielle : les obsenrations frLt ...,

tis

..., frnt

r1t ...t frir ...rIn

r;10-

P6l'information

apriori

: dt

Ioi apriori

: 0\

loi

a posteriorir(0lr)

L.z.L

Mod6le statistique

[,e moddle statistique est un

objet

mathdmatique ass6rie d l,observation1,2,

PHIN

PE DEL,ANALYSE

BAYESIENNEDeftnition L'2'L

math€'mati,quement le mod,cle stati,sti,que(la structure

sta-ti,sti,que) associ,E d, I,erp1rience et le

triplet

(X, A,p)

Otty

:

est *ensemble des r^surtats (r'espace des obseruations).A:

est la tri,bu des €uCnements associfues.p

:

est une fami,lle d,e loi,d,e probabi,li.t,s possi,bles d,€finis sur A.

L'int€ret

de

ce moddle

Est

qutl

perrnet detraiter

toutes les observations dansle mdme forma-lisme.

I,e moddle est discret si

1

estfini

ori d6nombrableA:

p(X).

On

dit

que le moddle est continue siX C Rd,

A:

fi(X).

1,2.2

Mod6le statistique param6trique

D6rftnition

r.2.2

un modcre statisti,que param€trique m,r (y, A,p)

cons,isted

I'obse,ation

d,'unn uari,abre a,r6atoi,rex

d,e toi,f

(r;/0),

,i:f,7,,

otr seule_mett

le

pamm^he

g

estinunnu

et

apparti,ent d,un

espacf d,e di,rnensi,on

fini.

1.2.4

moddle

statistique

bay6sien

c,omparde d

la

mod6lisation probabiliste I'analyse statistique se ramdnefondamentalement

d

une inversion, carele

se propose deremonter, m6me

imparfaitement, des efiets (ohservations) aux causes.

CYIAPITRE

1.

L'INFEP.ENCjE 8.AYESI},NIVE

par ie parametre d, les m6thodes statistiques permettentde conduire d

partir

de ces observations

d

une inf6rence, alors quela

mod6iisation probabiliste

caract6rise

le

comportement des observations conditionnelrementd,

d.

une telle inversion est flagrante dansla notion

m6me de waisembrance, puisqueformellement, elle ne

fait

que r66crire ra densit6 dans le bon ordre,r(rl0)

:

f (rl0).comme

une fonction de d inconnu d6pendant dez

observ6.

une

description g6n6rare de|inversion

desprobabilit6es est donn6e par le th6ordme de Bayes : soit

A

et .E sontdes 6vdnements tels que

P(E)

+

aP(AIE)

et

P(EIA)

sont reti6spar

IP(AIE):

P(EIA)P(A)

P(EIA)P(A)+F@$@

Bayes donne en

r6alit6

une version continue de ces r6surtats,a

savoir,pour

deux variables ar6atoiresr

et y,

dedistribution

conditionnellef(rly)

et marginale g(gr) alors :

g(ylx):m

Bayes

utilisait

la

version continue de ce th6ordme,ed

enon"" pour ia loi apriori

r(0)

etla

fonction de waisemblancef

{nl|)

alors :r(olr):

,

fr('1,2n$)

=.

Jef

@lo)n(o)doD6ftnition

t.2-3

un

rnod,cre statisti,que bayilsien estunstitu|,

d,,un mod,crestatistiqte

parc'm€triquef

@!il,

et

d.'une di,stribution a pri,ori,pour re para-metre

r(0).

1,2.

PEINCIPE

DE

L'ANALYSE

BAYESIENNELa

loi

a

priori

La

loi

apriori

dedensit6

lr(d)

estla

loi

marginaledu

paramdtre d, ou en d'autre terme,la

loi

du paramdtre avant quer

soit observ6. Elle r6sume, donc

l'information

sur 0 disponibre apriori

(avant observation).La

loi

a posteriori

C'est la loi conditionnelle de 0 sachant

r,

sa densit6 not6er(glr),en

vertu de Ia formule de Bayesor

a :r(o/r)

'

-

-f!Fle-)r@)

h

f @le)rp)ao

Ori enmrer@lr)af

(rl0)r(0)

Cette

loi

a posteriori peut s'interpr6ter cornme une combinaison del,in-formation a

priori

disponible sur d avec celle apport6e par les observations.La

loi

marginale

de

x

Sa densit6 est not6em(x)

et on a :f

m(r):

J

f @le)r(ilae

e

La

loi

du

ouple

(0,x)

Sa densit6 est not6ep(0,4

est donn6epar

:

p(0,r)

:

f (rlg)r@)

Exemple L.2.1

soit e12r2t...,tn

un n_€chantiilonon

cutsidile

k

modAle de Bayes sui,uant :r;

-

Bernmtlli(O)

et

g-

Beta(a,b)CHAPITHE

1.

T'NVFER.ENCE

BAYdSIENNE

Alors

: Ir(0)

:

EA^fir.-l(l

_

0)r-r,

o<

g<

I

_/^,

\

f(rlfl)n(O)

n\n/r):

ffi@lr4",|6)do

I

0e

x"vl"ts)dr:

I

#65rs+a-t(r

-

0)n+t-s-t6,

:#lt"-rt-o)e-tor:"m

eon

a:

s*a

et

8: n+b-

sf(rl|)r(0)

:

ffirs+4-1(1

-

0)n+b_-8_', 0(

d<

1Por

unsEqtene:

L3.

JOIS A

PHIOEINON

.nnOR./t4Arr]r

?is

0fr*Beta(a+\-' Z-t

i:7

i'b+n-f"tl

1.3

Lois

a

priori

non informatives

Les lois non informatives repr6sentent

'ne

ignorance sur le probrdme enmain, mais ne signifient pas que

l'on

sache rien sur ia

distribution

statistique du paramdtre.En efiet on connait au moins son domaine de

variation, c-a-d l,ensemble

des 6tats de

la

nature 6), et re rdre de chaque composantz du paramdtresur les obser'*ables(paramdtre de localisation, d,6chelle, etc).

ces lois doivent 6tre donc particulidrement construits d

parti

de ra distri_

bution

d'6chantillonnage.A

cet

6gard, leslois a priori

non

informatives peuvent6tre

consid6r6soonune des lois de r6f6rence aux quelles ehacun

pourrait

avoir recours quand toutes informatives a

priori

sur g est absente.L.4

Loi

a

priori

conjuguG

c€

tJrpe de lois estutilis6

quandl,information

apriori

disponible sur lemodgle est

trop

vague' ou peu faible. Dans ce cas l,analyste regarde la forme dela

fonction de waisemblanceet

choisit une fa,mille deloi

F

qui

se marie bien avec elle, dite familte mnjugu6e.

D6ffnition

L.4-L

unefamilte

F

de toi, apri,ori sur

a

est d,i,te conjugu€e si,

pour tout

r

€

F,

laloi

a posteri,ori\,ln)

apparti,ent EgarementcHAprrRE

t

n

rNrr,,nnNcn.aatatssrprvvp

L.4.L

La

famille

exponentielle

La famille

exponentielle regroupe reslois

deprobabilit6

qui

admettentune densitd de

la

forme :f

("/0):

exp(a(d)r@) _ g(0))h(r);

de

6

7

est alors une statistique exhaustive.Une telle famille est dite rdgulier si d est ouvert

tel

que :

e:

{0/

I

n@)

ocp(o(o)r@))

d.p(x)<

m}

ThdorCme

L.A.L

(Lois conjugu€ d,esfamilles

etponentielles) :Si

X

- f(cll):

exp(d,T(x)-

Qp))

n(r)

Alors

lafamille

de loi,s apriori

{zr^,u(d)

a

exp(|'p

-

}e(0))

h(r);

\,

1ti} est mnjusu€e.La

loi

aposteriori

cortespond,ante est :r(01\

*

I,

F+

"(c))

['e tableau suivant prGsente quelque

loi

apriori

conjigu6es pour querques familles exponentielles usuelles :Thble

1

: lois apriori

conjugu6e1.5.

LE

POIDSDE

LA LOI

A

PHIOEI

DANSLA

NEPOTVSPf

("lo)

n(0lr)

Normale

N(0,o2)

Normale

N(p,r')

Normale

N(p(o'p

*

r2r)., po2r2) avecp: ;"*!

G(a+r,/3+1)

G(a+u.,p+r)

!9@*r,9rn-r)

BAIdSIE}-AE

1'5

Le

poids

de

ra

loi

a

priori

dans Ia

r6ponse

bay6sienne

D'apr0s (J6r6me

DUPUS

2C/|/l),nous allons examiner cette question sur un exemple

po'r

oomprendre oommentl'information

a

priori

et l,informationoontenue dnns les obsenrations se combinent l'une a l,autre pour produire la rdponse baydsienne.

On se donne le moddle bay6sien suivant

:

r;10

-

Berrurutti(0) et

0-

Beta(a,b) donc

illx

_

Beta

(a*r,b*n_r)

Nous avons calculer

l'estimateur

bay6sien sous remot

quadratique quiCHAPITRN

T. TT]W'I'R'ENCE

BAI{dSIEAINE

est la moyenne de la lois a posteriori cornme

suit

:ntr

E(?lr)

:

a+b+n

:

atb

a

n

fr

na+b+n

;.i-;i;+"

;,

*:I'n

,i:1:

a+b -"tt

,

-

b(al

-Fn

---:-7

a+

o+n

a* b*n

Et

de travailler avecla

formule suivante :E(olfl:

a+b+n-'-'

?!?

E(o)+--!--n

aIb+n*

L'estimation baydsienne de d apparait donc cornme la moyenne pond6r6e de

7

(c-d-d de I'estimation ded par

maximum de waisemblance),et

de lamoyenne a

priori

E(d):le

poids dez

estla taille n

de l'6chantillon,et

,E(0)et

d

sont a,fiect6s respectivement ar:x coefficients#*.

et

#.

A

noter que a*

b:

n,

I'estimation bay6sienne de 0 se situe exactement au milieu del'intervalle lE(O),

7].

Si a

*

b)

n

cette estimation est plus proche de .E(d) que def.

Si

a*

bI

nc'est

I'inversequi

se produit.Pour examiner I'influence de

la loi

a

priori

sur

E(0lr)

il

est6difiant

des'int6resser aux oes

limites

a*b

---+ 0 et af

b ----+ oo. Dans le premier cas,le poids de

I'a priori

estnul, et

E(|lr)

---rt

estla

r6ponse classique; dansle

second cas, le poids des donn6es estnul,

et

E(llr)

---E(0)

ne d6pondplus de

r.

!.6.

LO/s

A

PHTOHT TMPROPHEL.G

Lois

a

priori

impropre

La

ioi

impropre est une mesure o-

f i,ni,esur |espace des paramatreso.

c-d-d une mesuren

telle que :f

J

n@)ae:

*oo

6

Les lois a

priori

impropres sont utiles dans les moddies non informatives,cette

loi

estutile

du

moinstant

quela loi

a posterioriedste.

Aussi, on selimite

aux lois impropre telle que :m*(r)

:

I

f @Wn(o\dr<

+oo.I

1.-7

Les

bases

de

la th6orie

de

d6cision

-

Un probldme de d6cision eston g6n6rale fond6 sur les

trois

6l6mentssui-vants:

Un espae des paramdtres O.

-Un epace de d6cision

D,

qui est I'ensemble de d6cisions possibles:

>si

l,objectif

est d'estimer 0, alorsD

:

0.

>pour un test

p:

{0,1}.

Une fonction de

mot L(0,6)

quid'6crit

le corlt de prendrela

d6cision dlorsque le paramCtre est d.

D6ffnition L.T.r

une

ftgle

est

d,€finie @rnrneune apprimtion

6

d,e yen_semble

fus inlonnations

(ou ft.sutta,ts d,'erp€ri,ence) d,ans I'ensemble d,esac-tions :

CWAPITEE

1.'

TATFdn"ENCE BAYESIEATNIE

5:y"->D

r-

>

6(n)1.8

Fonction

de

coat,

risques

et

estimateur

de

Bayes

L.8.1

Fonction

de

cott

D€ftnition

L.8.1 soit

6

e

D

une rdgle d,e d€ci,si,on, unefonction

demat

(pert4

est une foncti,on m,esumble d,e(o x D)

d

uareurs d,ansR*,

not€.eL(0,6)

est d€.fini,e tels que :LV(e,fi:

L(0d)

>

02.V0

€ O,:ld.

e

D: L(0,d-(a)):6

S'il faut

faire un choix entre deux rdgles de ddcision, ce choix est impos-sible sans crit0re de coflt, de sorte d d6finir comectement la notion de meilleurestinateur.

Fonctions de co0t

usuelles

Quand

le

contexted'une

exp6rience nepermet

pas une d6termination dela

fonctiond'utilitd

(manque de temps,information, etc.),

unealterna-tive

courante est de faire appeld

des fonctions decoot

classiques,qui

sont math6matiquement simpleset

de propri6t6s connues.1.8.

F'ONCTIONDLqOTJ!,

RISQUESET

ESTIMETEUR

DE

BA]y?,SLecofftO-1

ce

corlt est surtout utilis6 dans l'approche classique des tests d,hypothdse,propos6e

par

Neymanet

Pearson. Plus g6n6ralement, c,est'n

exemplety-pique

d'un

cott

nonquantitatif.

un

test estla

donn6e d,unepartition

deo

en O6et6t,

0€

6,; correspond A,I'hypothdseffi,

f/6

est appel6e l,hypothdsenulle, le principe du

test

(d6cisions) d est d6fini commesuit

:(

,,:{1sioe

os[

0side

O,La fonction de

cott

correspondant au test est d6finiepar

:L(0,6):

loeeox

-Ia=r*

4ee, x

/a=oLe co0t quadratique

Introduit

par

Legendre (1805)et

Gauss (1810), cecott

est sans conteste le c.ritOre d'6valuation le plus cnrmmrrn. Une fonction de coflt quadratique est une fonction d6finie de Ox D

dans lR1et

donn6epar

:L2(0,6):

(0-

d)2Le co0t

absolu

Une solution alternative au

cott

quadratique en d.imension un est d,utiliser le coflt absoluh(0,5):

l0-

dlCHAPITHE

1.

I

TNT'dII.ENCE BAI{6SIEI\I]VE

L.8.2

Les

risques

Le risque fr6quentiste

Ddffnition

L.8.2

pour

une foncti,on d,e coatL(0,6),

Ia foncti,on d,e risqueassoc,i€ est :

/i(p,

d):

Es(L(od(r))

:

l

tr,6(r))f

(nlo)dp(r)

x

c'est

'ne

fonction de

0 et

ne d6finit

pasun

ordretotale sur

D

et

nepermet donc pas de comparer toutes d6cisions et estimateurs,

il

n,existe donc pas de meilleur estimateur dans un mns absolu. Ainsi, I'approche fr6quentisteresteint I'espace d'estimation en pr6f6rant la classe des estimateurs sans biais

dans laquelle

il

existe des estimateurs derisque

uniformm6mentr

l,6cole bay6sienne ne perd pas en g6n6ralit6 en d6finissant'n

risquea

posteriorioI'id6e est dTnt6grer sur I'eqrece des paramdtres pour

pallier

cette difficult6.Le risque a posteriori

Ddffnition

L.8.3

une foi,s donn€.ela

loi a

priori

du

le

paramctre0

et

Iaforctiott,

deu&t,

k

risry,e a posteri,ori est d,Efinipar

:Ainsi,

Ie prcblame change selon les d,onn€e.;eci,

est d,a d,Ia non

eristene,d'un

ordretotal

sur les esti,mateurs.pQr,6la):

E*(L(0 d(e)le)

:

I

t(t,6(r))r@lr)d0

J 6

ESTIM,{TEUR

DE

BAYESLe risque int6gr6

Deffnition

r.9.4

a foneti,on de coat d,onn6e, re risque int6.gr€ est d,c.fini, par :Tq

R(0,6)

est Le risque frEquentiste1.8.8

Lrestimateur

de

Bayes

D6finition

t'8.5

un

est'imateur bay€sien estla

rdgled,e d,€ci,si,on

6,

qu,imi,-nimise le risque i,nt€gr€.

r(r,6)

;

i.e.

qui, u€rifi€. :r(tr,6"):

infr(n,

d)Pour obtenir la valeur de I'infimrrm de risque int6gr6

il

faut donc en th6orieminimiser une integrale double.

I'introduction

du risque int6gr6 se justifie par

le th6ordme suivant :

Th€or0me L.B.L

(method,e d,e calcut)Sz

ld

€ D,

r(tr,g) <

oo

etYr

e

X,

6,(n):

arg3ninpQr,6lr) alors

6n(u)

estun

estirnateur bay 6sien.rQr,6):

E"(R(0

d)lr)

:

{*@,6\tr(0\d0

J'

E

caaprrne

r. r'nwtsRqivcr

.aayEsrprvnre

Preuve

Nous cherchons d minimiser la fonctionde risque

r(tr,6)

f

r\It,d)

:

I

R(o,d)tr(o)do J orf

:

|

(|

4a,

o)f (rlo)d,r)r(o)do

JJ

et

:

!

{

t''

q{kry%m*@),*o

ff

:

|

(I

L(6,0)r(0ln)d.0)m^(r)dr

J

'J aAf

:

J

n6,6lr)m^(r)d,x

Ainsi,pour

:

t

6e

D,p(n,6,lx)

S p(.ndlr)

___+r(tr,d")

< r(tr,6)

on

conclut que l'estimateur Bay6sien est la rdgle de d6cisionqui minimise re

risque a posteriori :

p(tr,6lr).

I

Ltestimateur

bayGsien

sous

le

co0t

0-1

Dans ce cas le risque a posteriori est

:

pQr,6lx):

Ia:op"(0

e Olla)

*

I5=yp"(0e

Oole)Ainsi I'estimateur de Bayes associ6 est

:

(

,t"(r):

{

1

si

P"(fleo6le)

>

P^(le61lr)

[

0

sinonTTMKIEUR

DE

BA:res

L'estimateur

bay6sien

sous

le coOt

quadratique

L'estimateur de Bayes sous le coOt quadratique est :

d"(c)

:

E(olr)

:

I

sn(olr\oo

t"

En efiet ; comme l'estimateur bay6sien est la rdgle de

d6cision qui minimise

pQr.6lr)

alors on pose :f(6,")

:

p(tr,6lr)

D'orlr

(6'")

:

T

ii:f',I',?,.,

0,

J er

=

l(0-6)2n(0lx\ae

J A:

f

o,rplr)ao

_ zt

Iotrlelx)d,0

+

6,Itrelr)d0

o6t

:

E(02w)_

26rr(0lr)

+

52 La d6cision d quiminimi""

"f(d,r)

est cellequi

v6rifi6 dd6l(d,

r)

:

o I.e.26

-28(elu)

:

0:+

2d:28(0lr)

D'orl

d"(u)

:

E(olr)

:

Ion(elda,

t"

Donc sous le cofit quadratique l'estimateur baydsien est la moyenne

de la

loi

a posteriori.CHAPITRE

I.

T'NVF6n'ENCE BAYdSIEIVJVE

L'estimateur

bay6sien

sous

le

cofft

absolu

L'estimateur de Bayes sous le coot absoru est

la m6diane>w

de

la loi

aposteriori.

En effet I en remplaqant

L(0

d)

dans',expr6ssion de p(tr,

dlr),

nous obte_ nonsf

:

Il0_6lr(0lr)d0

J 6f

.

v

:

I

(t

-

o)tr(olx)do+

|

@_ 6)r(olr\do

J

J'

) \'!

-&6

Nous cherchons d minimiser

p(n

dlr)

donc :do.

fr(o'dlr):6

VT

I

rglx)a|:

lnplr)d0

JJ

-m6

p(tr,,6lr)

:

E"(L1(0,6)lr)

f

:

lLr(0,,6)n(0lx)d0

J IJ ImpliqueDonc d est bien la m6diane.

Chapitre

z

Les

tests

bay6siens

2.I

fntroduction

Il

existe des diff6rentes notions entrela

th6orie des tests fr6quentistes etcelle des tests bay6siens. De ce point d.e vue, le cadre des

tests rend l,approche bay6sienne

plutdt

attrayante, carla

notion

deprobabilit6

d,'ne

hypothdser(0

e

oolc),

ne peutttre

d6finie qu,d travers cette approche.Dans ce e}apitre, on considgre les tests d'hypothdses

corune l,estimation

de probldme (tester /eo(0)), rerifu avec la th6orie de ra d6cision. puis on peut

arriver d quelques conclusions int6ressantes.

2.2

ltapproche standard

L'hypothdse des tests classiques est construite selon le lemme de

Neyrnan_

Pearson.

Et

les r6sultats dans ra rdgle de d6cision sontles rdgles 0

_

1. ces formes detest

bien qu'elles soient optimales dansle

sens des fr6quentistes

CHAPITHE

2.

TES TES?S BAYESIE]\TS

strictement mais elles ont des critdres pour des directions dif6rentes. peut6tre

la

critique

de Neyrnan-pearson devient active en pratique, carres formures

de ia th6orie de Ne,'rnan-pearson ne sont pas rargement utilis6es

en pratique. D'autre

part,

lapvaleur

est impricitementutilis6e cornme une mesure de

la preuve pour les hypothdses, donc Kiefer considAre

la

p-vaieur comme une6valuation de Ia waisemblance de I'hypothdse nulle.

2'3

une

premiare approche

d

la

th6orie

des

tests

Soit un moddle statistique

f

("10).,0e@

Etant

donn6un

sous ensembled'int6r6t

66

deo,

eventuellementr6duit

aun

point'

on cherche d d6terminer le vrai paramdtreappartenant d (Js, i.e. d

tester l'hypothAse :

116:geOn

sourant appelfu hypothtsse

nu[e.

Dans l,approchede Neyrnan-pearson, ce

probldme est envisag6 avec un espace de d6cision

D,

restreint d{oui, non} ou de manidre 6quivalente

e

{1,0},

ee qui revient destimer 1eo(0), uniquement

par

des estimateurs a raleurs dans{0,1}.

Ir

est parfois n6cessaire de d6finirl'hypothdse alternative par

rapport

d raquele onva tester

r/o

:Ilr

:0

e

Or2.3.

UNE PREAIIEHE

APPROCHEA-LA

THfrOHIEDES

?ESTS

QDonc

un

test

seformalise de

la

mani0re suivante

:

IHo,

de

Oo[a,:aeo,

De

tel

sorte que06nO1

:0

etOoUOrC6

QPour un moddle paramdtrique

:Y

e

(y,8,{pe,0

e O}),

Oo UOr

c

OLe cas propre correspond au cas ori ra lois

a

priori

ettele

que si 6suit

raloi

zr alorsr(60)*zr(0r):1

Cette dernitsre condition

peut

s'exprimer aussi sous la forme suivante:

n@/A6U01):6

Ainsi

puisquetout

test

est enfait un

estimateur de.r,sr(d),

il

suffit

dedisposer

d',ne

fonction demdt

L@,6)pol,,

proposer des estimateur de Bayesassoci6s, par exemple la fonction de

cott

introduite par

Neymanet pearson

est0-1.

2.3.L

Approche

par la

fonction

de

cott

de

type

0-1

Dans oette

partie,

r'espace des ddcisionsest

D

:

t0,1),

ra

d6cisioni

oorrespondant d accepterflt,

i:

DlT.CHAPITHE

2.

TES ?]9S"S

BA)'ESIENS

A ces d6cisions vus 6tre associ6es des corits

L(0,60) et L(0,,ri1), la fonction

de co0t est alors

la

suivante :(

L(o,D:11

sid:Ioo(d)

[ 0

sinonPar d6finition, les d6cisions bay6sienne sont cele qui

minimise le risque a

posteriori

pQr,d/r)

Calculons le risque a posteriori de chaque d6cision :

p(tr,d,lr)

:

E"(L(0,,tn(")))

f

:

I

L(0,6;)r@lr)tt0

,I 0f

:

Jr(fllr)ae:

P"(0 €

Oalr),e:0,7

g,i Autrementdit,

siP*(0 eOol") <

p"(0

€

Ollr)

Alors on choisit de rejeter 1/0,

u

test bay6sien consiste a, choisirl,hypo-thdse ayant la plus grande probabilit6 a posteriori.

on

peut

aussi envisager uncott

plus g6n6ralequi

r6arise diff6rement lesmau'aises d6eisions suivant que

|h)pothdse

nulle est waie ou fausse :(

|

0

si

d:

/eo(d)L(0,6):l as

si

ge

€16et

d:o

I

I ot

si 0€01

etd:l

2.3,

UNE

PREX/IIEEE APPROCHEA

LA

TI{EOHIE

DES?ES"S

Proposition 2.3.L

sous Iemat

plus ghncrare, I'esti,mateur bag|si,en associ,6d,

la

loi, a priori,r

est :d"(r):{ I

siP"(oe

o6lr)>a?*

[ 0

s'i,nonPreuve

il

suffit d'6crire le corit a posterioripQr,6lr)

:

E"(L(e,ri(r))lc)

I

:

J

"(t,6)n(0lx)d0

0fr

:

I

antr(fllr)d,0_t

J

a1r(0lr)d0

ds'6:1

dr,6:O:

asp"(0 e

O6[r)*

a1p"(0

€

Olfr)

On accepte f16 si

af"(0

€O1lr) <asp"(e

€g6lr)

tn(|eOrlr)

,en

F(da6-&l

.

A

P"(0 e

Oolr)

+

p"(0

€ Olla)

:

1 I.e.Or

Alors 23CHAPITRE

2.

TES ?ESTS .BA}dSIEIVS

P"(0

€

olr)

+

p"(0

€

ooln)_

p"(0

€

oolr)

a6;i

140

_1P"(0eOolr) --a1

P"(0

eoolr)

t

^+A

C'est la rdgion d'acceptation de

Ho

l

Exemple

2.3.L

soitr

-

N(0,o2)

et0

-

N(p,r2),

alorsr(elfl

est ra roi,normale

N(p,u2)

aueci \

o2rt+,r, ut,2_

o2r2P\t)

:-o2

+-T)

oz+

12 Pour tester D'orl Notn mculnnsHs:0

<

0P"(o

<olr):

p"(

-!(x).

#l

:

or#l

Si zoo,orest le

qtantite

#"o,

doncs,il

satisfait@('oo'o'):

o'

at*,ao

2.4.

On accePte

Hs

lorsqueI.e.

-p(r)

2

lrzao,atAlors l'hypoth|se nulle sera accepter lorsque

:

R2 02.

*

<

-"Vp-

(1+

-=)(izoo'o'-p(x)

>

2.4

IJne deuxidme approche

d6cisionnelle

Danscettesectionnousconstnrisonsunea}ternativedl,approchede

Neyman.Pearsonpourjrrstifier}esprobabi}it6saposteriorietdvaluerlesp

values'

comme

dansla

section pr6c6dente,le

problOme detest

formalise par

NeymanetPearsonpeuts,exprimercommel,estimationdelafonctionindi-catrice

/"0(g)

sous Ie co0tG1'

de faqon 6quivalente'le

m0t

eneneur abso

Iue :

L{0,6):

16-

/"'(0)l

En

effet, si les estimateurs d ne prennent que les valeurs 0et

f

il

existedenombreusesmani}resd,6crirelecotrtetrelTeurabsolue6tantl'rmed,elle,

maisdeNeyman-Pearsonessentielleuneth6orie'|pr6-donn6esl'quenefournit pasdesolutionl|postdonn6esl'(oup}usad.aptative),Norrsnoustournonsalors

CHAPITHE

2.

TES

TES"S BA}'tsSIENS

vers u.ne th6orie moins restrictive, pour laquelle les estimateurs prennent leurs

valeurs dans

D

:

[0,1]et

pouvent 6tre consid6r6s comme des indicateurs dedegr6e de cerbitude contre ou on faveur

fI6-Paraiidlement d, Shaafsma et al(1989), Hwang et al(1992) examinent cette

approche des problemes de test,

pour

iaquelle les estimateurs de 160(d)ap-partiennent

d

[0,11, Iorsque Ia restriction a,{0,1}

est 1ev6e, le choix decott

devient plus

important,

par exemple, le corlt en erueur absolue esttrop

sem-blable

i, la

fonction decott

0-

1, car ellefournit

les mdmes proc6dures deBayes :

( t

siP"(o €

o6lr) >

P"(o e

ollr)

d"(r)

:

1

[ 0

sinonEn revanche, les cotts strictement convexesr cornme les cofrts quadratiques

L2@,6):

(d-

/..(d))'

Mdnent A des estimateurs plus adaptatifs'

Proposition2.4.L

sous Ie co$,t quadratique, I'esti'mateur de Bages assoc'i'6d,

r

est la probabi'li't€ a posteri,ori'6"(r):

P"(0

e Oolr)

Preuve

I'estimateur bay6sien commeiI

est d6fini pr6c6dement est la ragle de d6cision qui minimise le risque a posteriorip(n,6lr)'

On pose :

f

(6,*)

:

p(n ,,6lt)

2.4.

UNEDEwghME

AppRocHE

nfiustonttpnnn

D'or)/(d,

")

:

ppr,6lr)

:

E.

(L(6(r),0)lr)

:

E"((,t

-

/5,(d))2lr)

:

E"((6,

-

2d100(d)+ Ifl.(e))1r1

Orf

tr(16,(0\lx)

:

/ n$lr)d0

:

P" (0€

Onlr)

J €o:

E"@214 -268"(1€,.(d)1")

+

E"(/Ao(o)lu)

:

62-

268"(16,(d)lr)

+,E"(€,(d)ln)

La

d6cision dQ"i

minimisef (5,*)

Est cellle qui v6rifi6

d

+/(d''r)

:

odd-'

I.e. 25-28"(16"(0)1")

:

026

:

28"(16,(0)ln)

6"(*):

E"(16.(0)lr)

27CHAPITRE

2.

LES

TESTS

BA]'6SIEIV^S

Donc l'estimateur de Bayes sous Ie

cott

quadratique est :6"

(r)

:

E"(16o(0)fr)

I

Chapitre

3

Le facteur

de

BaYes

3.1

Introduction

Le facteur de Bayes est un critare bayesien de s6l6ction de modale, comme

il

est unoutil

pour comparerla

cr6dibilit6 de deux hypoth6ses.3.2

Le facteur

de

Bayes

pour tester

les

para-mCtres

Le facteur de Bayes est Ie rapporb des probabilite a posteriori des hypo' th€ses nulle et alternative sur le rapporb des probabilite a

priori

de ces m6me hypoth6ses.fr, \

tiir(0J

: p@Mp,6

P"(H6lx)P(Ht)

Ix(0

e 06lr) P"(d €

Oil

CHAPrcRE

3.

LE

FAffEUR

DE

BNES

Etona

P"(H)-l-P"(Ho)

Et

P"(frrlr)-l-

P"(HolrJ

Cas

particulier

:

Oo:

{go}, Ot

:

{0r}

P(0olr)

P(0')

B,:r(r): F6;i")F(oJ

ffi"10,)

wrc;

/(rl0o)n(00)

44

1"14';zr1e') t(00)

y1rl0o):T@

AlasuitdeJefirey(1939)etdeGood(1952),lefacteurdeBayesdesormais

un

outil

dpart

enti6re. Enparticulier,

Jefirey(1939) a d6velopp6 une echelle ilabsoluetrpour

6'valuerle

degr6 de certitude en faveurou

aud6triment

defl6apport6parlesdonn6es,enl,absenced'uncadred6cisionnelv6ritable,

l'6chelle de JefireY est le sui'mnte :

1. si 0

< log(BIJ

(

0'5,la

certitude quefig

est fausse est faible' 2. si 0.5<

log(Bfo)

(

l,

cette certitude est substantielle'3. si 1

<

l"S(BIo)

<

2, elle est forte' 4. silog(Bfs)

>

2, elle est d6cisive' Or)I

B[,

BIo:

5.2.

LE

FACTEURDE

BArES

POUR TESTER LESPARAvErnns

3.2.1

Modiftcation

de

la

loi

a

priori

La

notion

defacteur

de Bayespermet

aussi demettre

en 6vidence unaspect

important

destests

Bay6siens.En

fait,

cefacteur

n'est

d6fini

que IorsquePo*

0et

h*

0 telle que :Po:

n(0e

Os)Pt":

t(0eOr)

:l-Po

Si

flo

oufft

sont apriori

impossibles, Ies observations ne vont pas modifier-

cetteinformation

absolue.Le test d'une hypoth0se nulle ponctuelle impose par cons6quent une

mo-^

dification radicale dela loi

apriori,

caril

exige de constmire uneloi

apriori

pour

les deux sous ensembles O6et 01,

par

exemple, deslois

7r0et

7r1 de densit6sgicn(0)Iso(d),

g1a?r(d)16,(0)En d'autres termes

r(0):poro(O\*pttr{O)

Lorsque Oo

:

{00}, la

loi

apriori

sur O6 estjuste

la

masse de Dirac en06.

Soit I'hypothAse nulle ponctuelle

Hs:

0-

Aoi notons p6la probabilit6

apriori

que 6:

06et

g1la densit6 apriori

sous I'alternative. Laloi

apriori

estalors

n6(0):

p0leo(0)+(1

-

p0)gi(0) et Iaprobabilit'e

a posteriori de "Ffo est 31CHAPITRE

3.

LE

FACTEUF-

DE

EffES

/(rldo)Po

f

("loo) Pon(d6lr):

Iu

f

@le)"@)asf

WJPI+

(1-

Pirr,i'@) Laloi

marginale sousff1

6tant

:f

mt(r):

J

f

@'0)s(0)d0

Or

Cette probabilit6 a posteriori

peut

aussi s'6crirea'(gnlr):[1+t-powl^

\-ur*./

po

f@l?o|

De la mdme fagon, le facteur de Bayes est :

8s,("):#ffi+:

etnousobtenonslarelationg6n6ralesui.vanteentrelesderrx

quantit6s

zr(dnrr):

[t

+

l-po

=]^t-'

Po

B&(t)'

Commenousl,avonsd6jaindiqu6,IefacteurdeBayesdonneindicateur

objectif

de l'hYPothBseIlo:deOo

L'utiiisation

de Ioi non informative dans le contexte de la th60rie des tests est assez limit6e. Comme nous avons remarqu6 le contexte des tests n'est pascompatible avec u.ne approche enti6rement non informative, puisqu'ils

pr6

supposentunedivisiond.el,6spaced.esparamBtreenderrxSous-espace,cette incompatibilit6 et en

fait

plus fondamentale car elle empecheI'utilisation

demt(r)

3.2.

LE

FACTEURDE

BAYESPOUR TESTERLES PARAIUfiTANS

lois

impropre dans les tests des hypothdses,la

r6solution g6n6rale de cetteincompatibilit6 entre les tests bay6sien et lois a

priori

impropre reste un pro-bl6me ouvert.Remarque 3,2.L

I

.

Lorsque les deur hgpothCses sont 4qui,probable lefac-teur de Bayes corcespond au rapport des probabi,li,t€, a posteri'ori, de

Hs

sur H1Rtr

r-'f

P"(Holr)

"or\-,

p"(H1lr)

2.

le facteur d,e Bayes est une quanti,tE non bom€, i,l peut prendre des ualeurs entre A et*a.

Exemple 3,2.L

Soientr

*

B(n,0)

et pour A, et pour on prend la loi, apri'ori

uni.forme

r(F)

:

t

Soi,t d, tester

Ho:

112

untre

Hr

+

Il2,

i'l ui'ent que :r(oslr)

'

:

tr

L

1l:&.j^t-'

Po

ts$t(")'

:

tr

a

l-Pt

2"p(n

I

L,n-

r

+

1l-1 Porr_1-po rl(n-r)!

rq-t

:

Ir-r-Po

nl.

-r

m(r)

: ( ;

)

Betu(r

*r,n-u

+

1) ott,Par

eremple, si,n

:

5,

r :

3

et

po:

l/2,

la

probabi,li,t6 a posteri'ori, est(1

+

*

2u):

ft

et Iefacteur

de Bayes estft

CHAPITRE

Lorsquetatailted"€chanti'llonaugmente'lesuari'ati'onsd'esreponsespossi'bles

s,€'largi,ssent aussr, al,nsi, si,

n(0)

estBeta(If

2,112)

et

n

:

10, on obti'ent Ia table sui,aante pour les probabili,t[s a posteri,ori', bi,enque

la

loi, a priori, soi't 40 1 2 J

0.:17:17 0.6416 0.7688

P(0

:

|lr)

0.0055 0.0953To,ble

7 :

probabi'li't€ a posteri'ori' de{0

:

Il2}Pour

n:10

Etant

donn6 deux hypothdsesfJt et

Hi

correspondant d des hypothbses d.,autre mtrd6lesM;

et

M5

powles

dorm6esr,

le facteurde Bayes en faveur de

H;

(etmntre

'FIi)s'6crit

:P(M,lr\

P(Mi)

F@T6 F@J

3.3

Facteur

de

Bayes

pour tester

les

mod6le

n[,@):

AvecP(M)

+

P(Mi)

--

LLorsqueonestappelerdfairerrnes6lectionentrederrxmodblesMoet,Mt

i.e.i:0etj:lronaffectedchacundesdeuxmodAlesdesprobabilit6sa

priori P(M*),

k:0,1

Duth6oramedeBayes,onpeutalorsexprimerlesprobabi}itdsapostelrorr

P(Mrln):

' k:0'1

343.3.

FACTEUNDE

BA:/J,SPAUR ?ES?ER

LES MODELESAvec

P(Mlr)

-

1-

P(M6lr)

On peut 6crire :

P(Molr)

_

P(rlMo)

P(Mo)

P(Mrlr)

P(rlM)

P(M')

or

njr

P(rlM6)

DOI:FWJ

B$, repr6sente le facteur de Bayes en faveur du moddle

Ms

eonfie My. Lerapport

;i##i

estdit

quotient d'eqjeux a posteriori en faveur du mo-ddle Mo contre le moddle M1.Le

rapport

ffi

".t

dit

quotint

d'e4jeux apriori

en faveurffi

contreML.

On peut alors exprime

la

relation commesuit

:P(Molr) r,

P(Mo)

M:Do1

p7il)

Remarque 3.3.1 si

on aunrd,le

m€mepoiils

a pri,ori,pour

lesdcur

hypo-th4ses i,.e.

P(Mo):

P(MI)

:

12

Le

facteur

de Bages s'Ecri,tCHAPITRE

3.

LE

FACTEVN

DE

E.AYF,Sr21t

-

P(M

olr)uo1

-

P(M

rlr)

Intuitivement,

Ie facteur de Bayesfournit

une mesurepour

savorr donn6esy

ont

augment6ou

diminu6 les chancesde

Ht

par rapport

ainsi :

n[i

>

L

signifie donc quefll

est plus plausible dla

lumiAre der'

n}i

<

1 signifie quela

plausible relative deHi

a augment6'Exemple 3.3.L

Si I'on

testHs:0

:0

mntre

H1:0

I

AOn cnmParc le mod\le

M1

otlr

-

I{(0,1)

Au

mod,illeM2

ott'r

-

N(0,1)

si lesdHi

et d-

N(0,10)

Le

facteur

d,e BagesB,z@)

est d,onc le mpport des densit, marginoles.Btz(r)

:

- -

Ql!E)""t',?#,i,lz)

,(*#)

r-,,

do3.3.

F/ICTEURDE

BA]trjSPOUR

TESTERLES

MODELESLe mar

d,eBe(r)

est attei,ntpour

fr

:

0

et

est fauorable d,Mt

pui'squ'i,lprend,

la

ualeurJi,

d"

logari,thme Egaled.L.2.

De

plus,ktgrogp(r)

uauta

pourr :

1.62,

et

-!

pour

r :

2.I9 .on

peut renxarquerla

dffirence

auec les borytes classi.ques,

puisquer :

!.62

corresytond presqueh

niueauile signi,ficatiue d,e 0.L et

r :

2.19 d.un

ni,ueau de si'gnifim,ti,ui't€' de 0.A1. Onrejettera d,onc plus dffici,Iement I',hypothcse nulle

Hs:0

:0

en uti,li'sant uneprooEdure baY € si,enne.

Exemple

3.3.2

Ms

:

NB(q

11, do), M1 :P(r;l?t)i

:

L,...,n

Dans ce cns le

facteur

de Bages est donndpar

:n

NB

@1lr,

os)Bflr(")

:

EL--,---ll

P(ral01) 0T0-

0)"8

0q'

{n"u!}-'exp

{-n

d2}On nppose

pour

I'i,Ilustrati'on que06: !,

0t:

2

'S,i

n:

2,

7,t:

3.2:

0,

d,oncB[r(r)

:

u;-

6.1;

i,ndi'quant une o,ugrnentati'onde Ia Plausibihte de Ms.

S,in:2, rt: t2:2,

d,oncB[r(n)

: # -

0.3;

i,nd,i,quarrt une l€gCrvaugnentation de la plausibi'li't| de M1'

On

suppose ma,intenant que 06, 01 sont'i,nconnueset

i,lssont

ass'ign€s aur37

CHAPITRE

3,

LE

FACTEUN

DE

B.AYES

di,stributi,ons a pri'ori' su'i'uantes :

zro(do)

:

Beta(1olao, Fo)rrr(dr)

:

G(drlar,,6r)

Il

suit

que :p(nt,...,n,rMo)

: ffiffi

|

$**-'r,

-

vo)nn-

o-rttuo0

f(oo +

9o)f(a6

*

n)f(oo)f(,9.)

l(n

+

nT

t-

ao*

Fo)&,

que:

P(frt,"',r"lMl :

+ao r,.rl7 f--4 " - |

0"t-"'-texp{-(n

+

P)lr];

d|r

r(oo)

ll

to!

df(n

r

+

ot)Di'

l(c1)(n

*

l3)"

t*''

ff

",'

;- 1Noter en outre que :

1

E(r;lMs)

:

{

npStnto,06)Be(0slao,9o\,t00 J 0 1f(1-oo\

:

J

tBe(o6lo6'

1;doo

Uf(oo

+,30)f(ao

-

1)f(60

+

1)r(c6)r(po)

f(oo +

9o)a

PO

s.4.

PRAPR;5;zESLSVtvpTUrrQWS

DE FACTEUR DE

BAWS

EY

+oo

f

E(r,lM)

:

I

nlrlutt,0lG(0lat,

fir)d0'J 0 +.n

f

: I

0$(0lor,0r)d0t

J 0 A1 D lJIDe sorte que la sp€cifi,cati,on pr€,alable &aec

o,sol:

Fo/u

i,mplique les m€mesles detn modCles 8.

0o

:

1,flo:2

at:2,9r : I

tro:

iJ0r Fo:

600r:60, 6r:30

o4:

l,

0o:

2&t:4, frt:2

tto:$1:0

t.5 5.5 0.27fro: fi1:2

0.29 0.30 0.38To,ble

2

:

D*pendanre duBtJ")

sur des cambi'nai,sons apri'ori

3.4

Propri6t6s asymptotiques

de

facteur

de

Bayes

Cette section cherche en outre

i,6tablir

un lien entre le facteur de Bayeset

la

waisemblance p6nalis6e. Le contexte est d6sormais usuel :Xn

: (ru..,,fin)

CHAPITRE

3.

LE

FACTEUN

DE

BAYF,S

Et

X-f(r,0).0-r

Le test s'6crit toujours

H0:0

€Os

et flr:de

OrDans Ie cadre un peu plus restrient

6 c

R'd'si

le modale est r6gulieret

si d6€

oo

tel

que 7r1(d6))

0et

de sur croltdtrS(0)

:

ri(O)

dd, alors dans le cas or) :d,n(0):

ons(g)/oo(0)+

(t

-

c)n1(0)/6,(0)

On peut d6finir une sorte derapport

de waisemblance parhr

-[""oP(

tog(d"))

drs(0)dObot:@

ori

log(0,)

d6signelog(/(X"ld))

la

valeur dela

log-waisemblance, Les propri6t6s asymptotiques de 861 d6coulent du maximun du rapport de waisemblanceet

sont les suivantes :oSi

doe

Oo,

86'.3

+oooSi

go€Or, B[r

t*

OAinsi, le

facteur de Bayes distinguela

bonne hypothdse, avec unepro-babilit6

qui tend exponentiellement rapidement avecl)

vers 1' Le facteur de Bayes estdit

consistant'L[,emarquons que I'hypothdse