FACULTE DES SCIENCES DE L'EDUCATION

THESE PRESENTEE

A L'ECOLE DES GRADUES DE L'UNIVERSITE LAVAL

POUR L'OBTENTION

DU GRADE DE MAITRE ES ARTS (M.A.) PAR

J E A N - C L A U D E G A L L A N T

LICENCIE EN EDUCATION DE L'UNIVERSITE LAVAL

LES PRINCIPES FONDAMENTAUX_DE_L^APPRENTISSAGE D A N S LE PARADIGME DU BEHAVIORISME SOCIAL

L'auteur désire remercier son directeur de thèse, madame Aimée Leduc, professeur titulaire, qui l'a constamment guidé et conseillé.

Introduction k

«Chapitre premier Les principes fondamentaux de l'appren 6 tissage

■» Le conditionnement classique 7

, Le conditionnement instrumental ■ 17 Chapitre II Les sousprincipes de l'apprentissage 37

*l>a généralisation du stimulus 38

i.$La discrimination du stimulus ^0

L'extinction de la réponse.. ^2.

Les programmes de renforcement ^3

La privation et la satiété 32

Le contreconditionnement 33

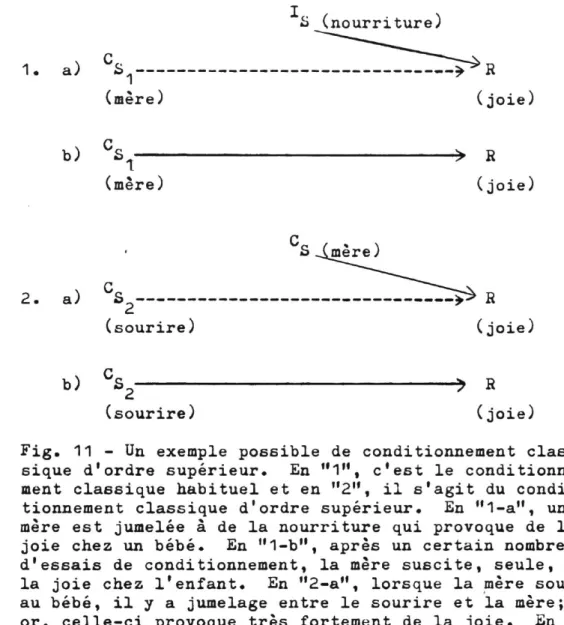

Le conditionnement d'ordre supérieur 39

Chapitre III L'interrelation entre les principes fondamen 65

taux ••

La fonction renforçante des stimuli inconditionnés. 66 L'apprentissage des fonctions conditionnées et renforçan

tes des stimuli • 69

L'apprentissage de la fonction directive des stimuli 72

Chapitre IV Les stimuli et les réponses manifestes et

Chapitre V - Les mécanismes S-R gl+ La séquence des réponses 86 Le mécanisme de stimuli multiples 89

Le mécanisme des réponses multiples 92 La combinaison des stimuli multiples et des réponses

mul-tiples 93 Résumé et conclusion.. 96

Figure 2 - L'expérience de Watson et Raynor.... 13 Figure ^ - Le schéma du conditionnement classique 1^

Figure k - L'expérience de Tolman . 2h

Figure 3 ~ L'appareil de Staats pour la lecture 26

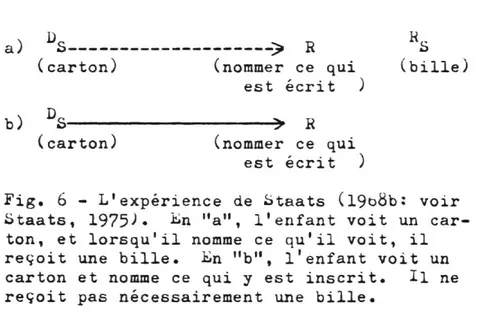

Figure 6 - L'expérience de Staats 28 Figure 7 - De schéma du conditionnement instrumental 29

Figure 8 - L'effet renforçant de la présentation et du retrait des stimuli renforçants positif et négatif sur la réponse

ins-trumentale • 33

Figure 9 - Un exemple de conditionnement classique v kk

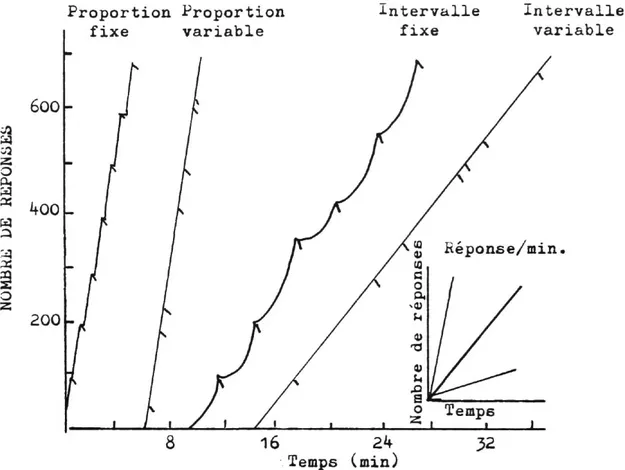

Figure 10 - L'illustration des résultats des taux de réponses

obtenus sous différents programmes de renforcement.... ^8 Figure 11 - Un exemple de conditionnement d'ordre supérieur... 60

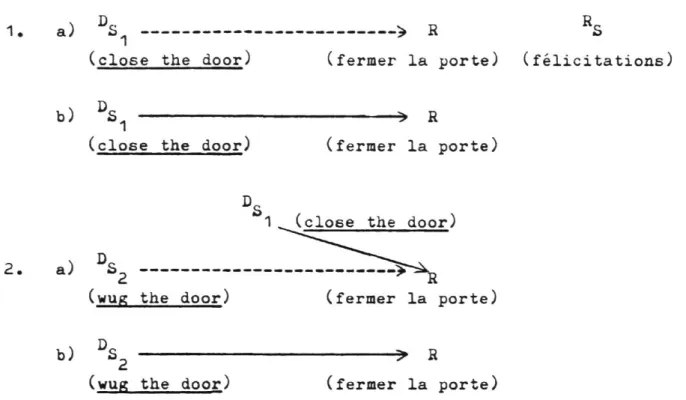

Figure 12 - Un exemple de conditionnement instrumental d'ordre

supérieur • 63 Figure 13 - L'expérience de Pavlov selon la symbolisation

uni-forme proposée par Staats 68 Figure 1^ - L'expérience de Tolman selon la symbolisation

uni-forme proposée par Staats "9 Figure 15 - L'expérience de Zimmerman . 71

Figure 16 - Le schéma du conditionnement instrumental selon la

symbolisation uniforme proposée par Staats 73 Figure 17 - L'expérience de Trapold et Winokur 75

Figure 18 - L'expérience de Razran 80 Figure 19 - L'expérience d'Hefferline 81 Figure 20 - L'expérience de Miller.... 83 Figure 21 - Une séquence de réponses verbales... •••• 87

Figure 22 - Le mécanisme de stimuli multiples qui provoquent une

même réponse 89 Figure 2.~^ - Le mécanisme de stimuli multiples qui provoquent

Figure 23 - Ee mécanisme des réponses multiples 93 Figure 26 - La combinaison des stimuli multiples et des réponses

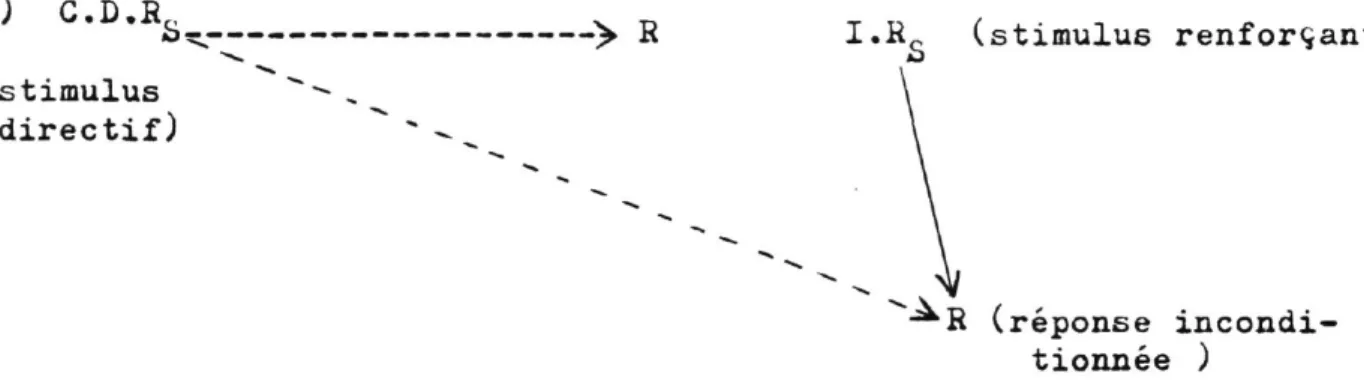

dans son paradigme du behaviorisme social. L'ap-proche qu'il propose inclut une intégration des conditionnements classique et instrumental qui sont les deux principaux types d'apprentissage. De plus, cette approche accorde une importance considérable à l'étude et au développement théorique et expéri-mental du comportement humain complexe.

Le chapitre premier décrit les principes des con-ditionnements classique et instrumental; le cha-pitre II en développe les sous-principes, alors que le chapitre III met en évidence 1'interrelation entre ces deux types de conditionnement. Le chapitre IV traite des stimuli et des réponses manifestes et voilés. Le chapitre V expose les différents types de mécanismes £>-R.

Chapitre premier

Le conditionnement classique

Dans cette section, il sera question de l'expérience de Pavlov, des conditions au jumelage, de la symbolisation du condition-nement classique, de l'expérience de Watson et Raynor ainsi que de l'énoncé du principe du conditionnement classique.

L'expérience de Pavlov

Pavlov (1927: voir Staats, 1975) fut le premier chercheur à avoir isolé le principe du conditionnement classique. Dans cette ex-périence, des chiens avaient une réponse instinctive de salivation lorsqu'ils étaient en présence de nourriture. Pavlov recueillit puis mesura les gouttes de salive présentes dans leur gueule. Par la suite il fit tinter une cloche juste avant de présenter de la nourriture aux chiens. Il reproduisit cette situation un certain nombre de fois. En-suite, il fit entendre aux chiens seulement le son de la cloche et il recueillit et mesura la quantité de salive présente à ce moment dans leur gueule. Les résultats démontrèrent que la quantité de salive re-cueillie la dernière fois, soit après avoir fait tinter la cloche sans avoir présenté de la nourriture, était quasiment égale à la quantité

de salive recueillie la première fois alors qu'il y avait présence de nourriture. En d'autres mots, il en est résulté que les chiens ont appris à émettre involontairement une réponse physiologique de salivation lorsqu'ils entendaient le son d'une cloche.

Dans cette expérience, il y a les éléments suivants: la salivation, la nourriture et le son d'une cloche. La salivation est une réponse physiologique de type glandulaire de l'organisme. La nourriture est un stimulus qui provoque de façon innée la réponse de salivation dans l'organisme, elle est dite stimulus inconditionné. Enfin, il y a le son d'une cloche qui parvient après un entraînement spécifique à provoquer seul la réponse de salivation, il est qualifié stimulus conditionné.

Staats suggère que toute situation-stimulus à laquelle l'or-ganisme est sensible, bien qu'elle n'y provoque pas de réponse, puisse être conditionnée. La principale exigence à ce type d'apprentissage est que le stimulus conditionné soit jumelé un certain nombre de fois à un stimulus inconditionné.

Les conditions au .jumelage

Toutefois, pour obtenir un apprentissage optimal, le jumelage des stimuli doit respecter certaines conditions. Ainsi, il est préfé-rable que le stimulus conditionné précède le stimulus inconditionné. Par exemple, quand le son de la cloche précède la présence de la nour-riture, le son peut, après plusieurs essais, agir comme un signal

de la nourriture. Si le son est présenté après la vue de la nourri-ture, l'organisme aura de la difficulté à le percevoir comme un si-gnal avertisseur de nourriture; le son prendra alors beaucoup plus de temps à susciter de la salive.

De plus, l'intervalle de temps entre le stimulus conditionné et le stimulus inconditionné doit être bref. Par exemple, si l'on pré-sente le son cinq minutes avant de prépré-senter la nourriture, le jumelage des deux stimuli sera moins efficace que si l'on présente le son une minute avant la nourriture. Un intervalle de cinq minutes est trop long, il n'existe presque plus de contiguïté entre les deux stimuli; en outre, d'autres situations peuvent interférer durant cet intervalle de temps. L'intervalle d'une demi-seconde semble le plus efficace.

Enfin, le nombre d'essais de conditionnement, jusqu'à une certaine limite maximale, affectera la force du conditionnement. Par exemple, dans l'expérience de Pavlov deux ou trois essais de condition-nement ne suffisent pas pour que le son suscite seul de la salivation. Autrement dit, jusqu'à un certain point maximal, plus il y a d'essais de conditionnement, plus le son de la cloche déclenche la réponse de salivation rapidement et en grande quantité.

La symbolisation du conditionnement classique

10

En effet, les schémas simplifient la présentation des expériences de conditionnement afin de mieux faire comprendre le processus impliqué. Toutefois, Staats a modifié quelque peu la symbolisation usuelle afin de pouvoir intégrer ultérieurement d'autres principes dans un langage continu et fonctionnel. La figure 1 illustre le conditionnement obte-nu par Pavlov. Dans ce schéma, les éléments importants sont: les

let-tres majuscules, les divisions "a" et "b", les lignes pleines ou poin-tillées ainsi que l'ordre de présentation des lettres majuscules.

Les lettres majuscules sont R, S, I et C. i->a lettre R re-présente la réponse et la lettre S, le stimulus. La lettre I indique la fonction de stimulus inconditionné et la lettre C la fonction de stimulus conditionné; ces lettres s'inscrivent en haut et à gauche de

I C

la lettre S de façon suivante: S et S. A moins d'avis contraire» toutes ces lettres sont écrites en majuscule.

CS > R

(son) (salivation)

b) CS » R

(son) (salivation)

Fig. 1 - Expérience de Pavlov. En "a", un stimulus neutre, le son, est présenté en con-tiguïté à un stimulus inconditionné, la nour-riture. Ce stimulus inconditionné provoque une réponse de salivation. En "b", après un nombre suffisant d'essais de ce type de condi-tionnement, le son provoque seul la réponse de salivation (Extrait de A.W, Staats, 1975i P« 2.2) 9

La figure 1 se subdivise en deux parties "a" et "b". Ces parties indiquent le début ou la fin de la période d'apprentissage. Ainsi, la partie "a" signifie qu'il s'agit des premiers essais de conditionnement et la partie "b" montre le résultat final.

De plus, il y a des lignes pleines et pointillées dans le schéma. Une ligne pleine indique l'existence d'une relation entre le stimulus et la réponse. Par exemple, la ligne pleine entre S et R en "a" signifie que le stimulus inconditionné, la nourriture, pro-voque la réponse de salivation, dès les premiers essais. L>a ligne pleine entre S et R en "b" indique que le stimulus conditionné, le son, provoque la réponse de salivation après une période d'apprentis-sage impliquant un certain nombre d'essais. D'autre part, la ligne pointillée entre un stimulus et une réponse indique qu'il n'y a pas encore de relation entre les deux, bien qu'il y ait des essais de

con-Q

ditionnement pour le faire. Ainsi la ligne pointillée entre S et R en "a" indique que le stimulus conditionné, le son, ne déclenche pas encore la réponse de salivation, bien qu'il subisse un entraînement pour y parvenir.

Enfin, dans le schéma, les lettres sont présentées de gauche à droite selon l'ordre chronologique des événements, ^ar exemple,

C I dans l'expérience de Pavlov le son ( S) précède la nourriture ( S ) .

C I

-Alors S est a gauche de S dans le schema. ^n outre, la salivation (R) est provoquée par les stimuli de sorte qu'elle est le dernier

12

Q

événement à survenir. Par conséquent, R doit être à la droite de S et de S. De plus, l'intervalle de temps entre la salivation (R) et la nourriture ( S) semble plus court que celui qui est entre le son

C I

( S) et la nourriture ( S ) , parce que le processus est inné. Alors, l'espace entre S et R dans le schéma sera plus court que celui qui

C I est entre S et S.

L'expérience de Watson et Raynor

Une autre expérience, celle de Watson et Raynor (1920: voir Staats, 1975) peut illustrer un conditionnement semblable à celui de Pavlov, mais chez un humain. Dans cette étude, les expérimentateurs présentent à un enfant un rat blanc comme stimulus conditionné ( S ) , ^uand l'enfant regarde l'animal, ils produisent un bruit fort et sec comme stimulus inconditionné ( S ) . Ce bruit provoque une réponse de pleurs (R) chez l'enfant. Après un certain nombre d'essais de

condi-tionnement, la seule vue du rat blanc ( S) suscite des pleurs (R) chez l'enfant.

a) I

C£ Zy. R

(rat blanc) (pleurs)

b) Cb > R

(rat blanc) (pleurs) Fig. 2 - L'expérience de Watson et Raynor (1920:

voir Staats, 1975)» En "a", il y a jumelage du rat blanc et d'un bruit fort et sec. En "b", après un nombre suffisant d'essais de ce condi-tionnement, la vue du rat seule provoque une ré-ponse de pleurs chez l'enfant.

La figure 2 illustre le conditionnement impliqué dans cette expérience. La lecture des lettres dans le schéma indique que le rat blanc est le stimulus conditionné, que le bruit sourd et sec est le stimulus inconditionné et que les pleurs de l'enfant sont la réponse. La ligne pointillée entre S et R en "a" signifie que le rat blanc ne suscite pas de pleurs chez l'enfant au début de l'expérience. La li-gne pleine entre S et R, en "a" indique que le bruit fort et sec

pro-Q

voque une réponse de pleurs. La ligne pleine entre S et R en "b" dé-montre qu'il y a eu suffisamment d'essais pour que le rat blanc provoque des pleurs. La lecture du schéma de gauche à droite indique que le rat blanc est présenté avant le bruit fort et sec et qu'ensuite, il y a des pleurs.

L'énoncé du principe du conditionnement classique

L'expérience de Pavlov et celle de Watson et Raynor sont des exemples de conditionnement classique. Dans les deux cas, le procédé consiste à présenter un stimulus neutre en contiguïté à un stimulus

14

inconditionné, de sorte que le stimulus neutre en vienne à provoquer seul la réponse quand le jumelage est suffisamment répété.

a) I S^(stimulus inconditionné)

CS £-R

(stimulus neutre) (réponse)

b ) CS > R

(stimulus neutre) (réponse) Fig. 3 - Schéma du conditionnement classique proposé par

Staats. En "a", un stimulus neutre est jumelé à un stimulus inconditionné qui déclenche une réponse. En "b", le stimu-lus neutre déclenche seul la réponse après qu'il fut suffi-samment répété.

Ea figure 3 illustre l'énoncé du principe du conditionnement classique. Tout d'abord, en "a", il y a le jumelage entre le stimulus neutre et le stimulus inconditionné qui provoque la réponse. Puis en "b", le stimulus neutre provoque la réponse en absence du stimulus in-conditionné, après qu'il y ait eu suffisamment d'essais de jumelage.

Le principe du conditionnement classique peut donc s'énoncer de la façon suivante: si l'on présente, de façon continue et répétée,

C » I un stimulus conditionné ( S) jumelé à un stimulus inconditionné ( S ) ,

le stimulus conditionné en viendra à déclencher, seul, une réponse (R) semblable à celle que déclenchait le stimulus inconditionné ( S ) .

Dans cet énoncé les éléments importants sont: le jumelage, la contiguïté, le nombre d'essais, le stimulus inconditionné, la ré-ponse et le stimulus conditionné. Le jumelage, la contiguïté et le

nombre d'essais ont été traités dans la section des conditions au ju-melage. Cette section concerne le stimulus inconditionné, la réponse et le stimulus conditionné.

Il existe dans la nature beaucoup de stimuli inconditionnés, plusieurs sources d'énergie peuvent être considérées comme tels. Inci-demment, il y a les vibrations de l'air (ouïe), les rayons lumineux (vue), les énergies mécaniques (toucher), les substances alimentaires (goût) et les odeurs (odorat). Toutefois, ces énergies ne seront pas toutes des stimuli inconditionnés ( S) pour un organisme particulier. Il existe des différences entre les espèces et entre les individus quant à l'éventualité que ces sources d'énergie soient des stimuli in-conditionnés, différences qui doivent être établies empiriquement. Mise à part leurs différences sensitives ou leurs anomalies spécifiques, il semble que les stimuli inconditionnés provoquent des réponses sembla-bles dans les organismes d'une même espèce.

De plus, l'organisme est construit de telle sorte qu'il réa-git aux énergies positives et plaisantes ou aux énergies négatives et déplaisantes de l'environnement comme à des stimuli inconditionnés. Autrement dit, il existe des stimuli inconditionnés positifs et

d'au-tres négatifs. Par exemple, la nourriture dans l'expérience de Pavlov est un stimulus inconditionné positif parce qu'elle provoque une ré-ponse émotionnelle plaisante dans l'organisme. Par contre le bruit fort et sec dans l'expérience de Watson et Raynor est un stimulus

16

inconditionné négatif parce qu'il provoque une réponse émotionnelle déplaisante dans l'organisme.

Par exemple, la salivation dans l'expérience de Pavlov est une réponse physiologique de type glandulaire alors que les pleurs dans l'expérience de Watson et Raynor constituent une réponse motrice réflexe. Les réponses aux stimuli inconditionnés peuvent être entre autres, des réactions des glandes, des viscères et des vaisseaux san-guins, ou des réponses motrices réflexes. Il semble que tous les or-ganismes normaux d'une même espèce réagissent de façon semblable à ces stimuli. Ces réponses émotionnelles sont de deux ordres: les réponses émotionnelles positives et le6 réponses émotionnelles négatives.

L'organisme doit constamment affronter de nouvelles situa-tions et il est vital qu'il apprenne à rechercher celles qui assurent sa survivance ainsi qu'à éviter celles qui le mettent en péril. Toute situation et tout événement peuvent devenir un stimulus conditionné, s'ils sont perceptibles par l'organisme. Par exemple, le son de la cloche dans l'expérience de Pavlov en vient à provoquer une réponse émotionnelle positive qui se manifeste par de la salivation. Dans la vie courante le mot "bon" est souvent jumelé à plusieurs expériences agréables, de sorte que pour la plupart des gens le mot "bon" est un stimulus conditionné positif: les gens recherchent la bonne

D'autre part, le rat blanc de Watson et Raynor en vient à provoquer une réponse émotionnelle négative qui se manifeste par des pleurs. Ultérieurement, l'enfant pourra éviter de pénétrer dans une pièce où il y aura un rat blanc ou s'enfuir lorsqu'il l'apercevra. Les organismes évitent autant que possible les circonstances qu'ils ont appris à identifier comme désagréables, mauvaises ou dangereuses. J-a plupart de ces circonstances sont des stimuli conditionnés néga-tifs.

Le résumé

Bref, toutes sortes de stimuli neutres et perceptibles par l'organisme peuvent provoquer des réponses conditionnées chez ce der-nier, pourvu qu'il y ait un nombre suffisant d'essais de jumelage du stimulus conditionné au stimulus inconditionné. De plus, il n'est pas nécessaire que l'individu ait conscience du processus pour qu'il ait lieu, généralement cela se fait à son insu.

Le conditionnement instrumental

A peu près à la même époque que Pavlov, un psychologue amé-ricain, E.L. Thorndike, rapporte des résultats de recherche sur le conditionnement instrumental. A l'opposé du conditionnement classi-que qui concerne les réponses des glandes, des viscères et des vais-seaux sanguins, le conditionnement instrumental s'applique aux réponses des muscles striés ou squelettiques. Depuis, de nombreux chercheurs ont conduit des expériences sur l'application de ce principe tant chez

18

les animaux que chez les humains.

Cette section comprend l'expérience de Tolman, les condi-tions nécessaires au renforcement, la symbolisation du conditionne-ment instruconditionne-mental, l'expérience de Staats et l'énoncé du principe du conditionnement instrumental.

L'expérience de Tolman

Tolman (1938: voir Staats, 1975) a utilisé une boîte qui est un labyrinthe en forme de T. Il place un rat à la base du T. L'animal doit suivre l'allée jusqu'à la jonction des voies où il peut choisir entre tourner à gauche ou à droite. Les corridors, même s'ils sont diamétralement opposés, sont identiques. Au bout de chacun d'eux, il y a une lumière près de laquelle se trouve un réceptacle à nourriture construit de telle manière que l'animal ne peut y déceler la présence de nourriture qu'une fois parvenu.

Si le rat s'engage dans un corridor où la lumière est allu-mée, il y trouve de la nourriture qu'il peut immédiatement manger. Par contre, si l'animal parcourt le corridor lorsque la lumière est éteinte, il ne trouve pas de nourriture et l'expérimentateur le re-place au point de départ. Les lumières sont allumées alternativement au hasard.

Les résultats démontrent qu'après un certain nombre d'essais de la sorte, le rat choisit plus souvent le corridor où la lumière est

allumée et où il reçoit de la nourriture que le corridor où la lumière est éteinte et où il ne reçoit pas de nourriture. Donc, l'animal a appris à différencier le corridor où la lumière est allumée du corri-dor où elle est éteinte. Autrement dit, la lumière allumée est devenue un stimulus incitateur qui amène l'animal à choisir le corridor corres-pondant plutôt que l'autre.

Dans l'expérience de Tolman, les éléments importants sont les suivants: la lumière allumée, l'action d'approcher cette lumière et la nourriture. La lumière allumée est initialement un stimulus neutre. Puis, elle devient graduellement, au fur et à mesure des es-sais d'apprentissage, un stimulus incitateur qui pousse le rat à s'en approcher. Elle est alors qualifiée de stimulus directif. L'action d'approcher la lumière allumée est un comportement que l'animal apprend à produire lorsque la lumière est allumée; il s'agit de la réponse instrumentale. La nourriture est un stimulus qui récompense l'animal pour avoir accompli la bonne réponse instrumentale; elle est qualifiée de stimulus renforçant.

Il est suggéré que toute situation puisse susciter une ré-ponse instrumentale chez un organisme si ce dernier le perçoit, s'il est en mesure d'émettre la réponse instrumentale et s'il y a eu suffi-samment de renforcement de cette réponse instrumentale.

Ainsi, il existe des stimuli imperceptibles pour une espèce et non pour une autre. Par exemple, les chiens entendent des sons que

20

l'homme ne peut percevoir. Dans ces conditions, le chien pourra ap-prendre à courir au signal, mais pas l'homme. Des différences analo-gues peuvent également exister entre les membres d'une même espèce. De plus, les espèces et les organismes ne peuvent émettre tous les com-portements. Le chien ne peut pas parler et l'homme ne peut pas voler sans appareil. Enfin, un organisme n'émet pas volontairement un com-portement s'il n anticipe pas par expérience y trouver son intérêt. Par exemple, après un certain nombre d'essais de conditionnement, le rat de Tolman s'approche de la lumière allumée parce qu'il prévoit y trouver de la nourriture, compte tenu de ses expériences antérieures.

Mises â part les caractéristiques anatomiques et physiolo-giques de chaque espèce ou de chaque individu, il y a des conditions essentielles à l'apprentissage de réponses instrumentales. La pro-chaine section traitera de ces conditions au renforcement.

Les conditions au renforcement

L'apprentissage de réponses instrumentales doit s'effectuer selon certaines conditions. Parmi les plus importantes, il y a la présentation consécutive à la réponse du stimulus renforçant, l'inter-valle de temps entre la réponse et ce stimulus, le nombre d'essais de conditionnement et la quantité de substance du stimulus renforçant.

A. La présentation consécutive à la réponse du stimulus renforçant Par exemple, ce n'est que parvenu à la lumière que le rat

a organisé la situation pour que le renforcement n'ait lieu qu'une fois le comportement émis. Ainsi, après un certain nombre d'essais le rat se dirige plus rapidement qu'au début vers la lumière, parce qu'il anticipe recevoir de la nourriture en récompense de sa réponse d'approche. Si le stimulus renforçant avait été donné à d'autres mo-ments, il est probable que le rat n'aurait pas appris à approcher la lumière. Donc, il est essentiel que la réponse instrumentale appa-raisse pour que le stimulus renforçant ait lieu.

B. L'intervalle de temps entre la réponse et le stimulus renfor-çant

De plus, l'intervalle de temps entre la réponse instrumen-tale et le stimulus renforçant influence ce type d'apprentissage. En effet, ce dernier est d'autant meilleur que le stimulus renforçant est contigu à la réponse instrumentale. En d'autres mots, plus cet inter-valle de temps est court, plus le stimulus directif est puissant pour susciter la réponse instrumentale.

Ainsi, le rat de Tolman reçoit la nourriture dès qu'il a atteint la lumière allumée. Autrement dit, le rat reçoit un stimulus renforçant à l'instant même où il termine le comportement d'approche. Dans cette expérience, l'intervalle de temps entre la réponse et le stimulus renforçant est quasiment nul. Cependant, Tolman aurait pu prolonger l'expérience et l'organiser de telle sorte qu'un autre rat ne reçoive pas immédiatement sa récompense dès qu'il a atteint la

22

lumière allumée. Par exemple, il aurait pu établir un intervalle de temps de trente minutes entre la réponse instrumentale et le stimulus renforçant. Les résultats auraient alors démontré que le second rat répond beaucoup plus lentement que le premier, toutes les autres va-riables étant égales. Ainsi, la force de l'apprentissage diminue dans la mesure où l'intervalle de temps augmente. Chez les animaux, les résultats expérimentaux suggèrent un intervalle maximal d'environ trente secondes.

C. Le nombre d'essais de conditionnement

En outre, le nombre d'essais affecte également la force de l'apprentissage. Tolman (1938: voir Staats, 1975) a démontré que plus il y a d'essais de conditionnement, plus le rat réagit rapidement à la lumière allumée. Autrement dit, chaque essai de conditionnement aug-mente la force du stimulus directif, de sorte que dans les essais sub-séquents ce stimulus suscite davantage et plus rapidement la réponse , instrumentale.

D. La quantité de substance du stimulus renforçant

De plus, Kintsch (1962) a démontré que la quantité de subs-tance- du stimulus renforçant affecte la force du conditionnement. L'auteur récompense des rats qui traversent une branche de labyrinthe par .25, 1.75 ou 3*5 en d'eau. Bien que l'entraînement améliore la performance des trois groupes, le taux d'augmentation de la performan-ce et la vitesse terminale de la course sont fonction de la quantité

d'eau donnée en récompense. Jusqu'à une certaine limite donc, plus il y a de substance du stimulus renforçant, plus l'apprentissage est rapide. L'inverse est valable également.

En résumé, l'apprentissage d'une réponse instrumentale est affecté par le délai entre la réponse et le stimulus renforçant, par le nombre d'essais de conditionnement et par la quantité de substance du stimulus renforçant.

La symbolisation du conditionnement instrumental

Staats propose un langage continu dans les principes d'ap-prentissage. En conséquence, la symbolisation du conditionnement instrumental est complémentaire à celle du conditionnement classique. La figure k illustre le conditionnement instrumental dans l'expérience de Tolman. Dans ce schéma, les éléments importants sont les symboles D R S, S et R, les divisions "a" et "b", les lignes pleines et pointil-lées ainsi que l'ordre de présentation des symboles.

2k

lumière comportement nourriture allumée d'approche

*> DS > R KS

b ) DS ^ R

Fig. k - Expérience de Tolman (1938: voir Staats, 1975). En "a", lorsque la lumière est allumée

(^S), le rat s'en approche (R) et reçoit de la nour-riture (**s). En "b", après plusieurs essais de con-ditionnement de la sorte, le rat s'approche (R) de la lumière lorsqu'elle est allumée (^s) , sans recevoir de nourriture.

Les divisions "a" et "b", les lignes pleines et pointillées et les lettres S et R sont semblables à celles présentées dans les schémas des deux principes de conditionnement. Ainsi la division "a" signifie qu'il s'agit des premiers essais de conditionnement et la di-vision "b" montre les derniers essais ou le résultat obtenu. De plus, la ligne pointillée signale que l'organisme est en train d'apprendre, alors que la ligne pleine signifie qu'il répond à la présentation du stimulus. Enfin, la lettre R représente la réponse et la lettre S le stimulus. Toutes les lettres utilisées comme symboles sont majuscules.

Les lettres D, R ainsi que l'ordre de présentation des sym-boles diffèrent du schéma du conditionnement classique parce qu'ils sont relatifs au conditionnement instrumental. La lettre D indique la fonction directive et la lettre R la fonction renforçante du sti-mulus. Mais, comme il s'agit de fonction du stimulus ces lettres s'inscrivent en haut à gauche de la lettre S comme dans le

condition-I D R nement classique ( S ) ; elles s'écrivent réciproquement i> et S. De

plus, l'ordre de présentation est chronologique: stimulus directif, réponse instrumentale et stimulus renforçant s'il y a lieu.

Bref, la ligure 4 représente l'expérience de Tolman. Elle est aussi un schéma exemplaire du conditionnement instrumental et se lit de la façon suivante: la division "a" signale le debut de l'expé-rience; la ligne pointillée entre S et R indique que la lumière al-lumée ne suscite pas encore ue comportement d'approche, mais qu'il y a un apprentissage en conséquence; les lettres i> à l'extrême droite montrent que l'émission du comportement d'approche est récompensée par de la nourriture qui est un stimulus renforçant. La division "b"

indi-û

que la fin de l'expérience; la ligne pleine entre S et R signale que la présence de la lumière allumée provoque le comportement d'approche; l'absence de S démontre que la lumière allumée provoque seule le com-portement d'approche sans qu'il soit nécessaire de donner de la nourri-ture en récompense.

L'expérience de Staats

Staats (1968: voir Staats, 1975) a étudié l'apprentissage de divers types de comportements intellectuels chez des enfants. Il s'a-git d'un exemple de l'application du principe du conditionnement instru-mental chez les humains.

26

Fig. 5 - L'appareil utilisé par staats pour faciliter des apprentissages intellectuels à des enfants. L'en-fant et l'expérimentateur sont assis de part et d'autre d'un panneau. L'enfant a à sa gauche des jouets et des tubes à billes correspondants. L'expérimentateur lui présente des cartons dans une fenêtre du panneau. Sur ces cartons, il y a des lettres, des chiffres ou des mots selon l'apprentissage souhaité. L'enfant les nomme et reçoit en récompense une bille qu'il peut échanger contre un colifichet ou un petit bonbon ou qu'il peut accumuler dans un des tubes à jouets pour l'obtenir (ex-trait de Staats, 1968 b, p. 31).

Dans cette expérience, Staats fait asseoir un enfant face à un panneau et à sa gauche se trouvent des jouets et des tubes à billes correspondants. La figure 5 montre l'appareil utilisé. L'expérimen-tateur s'asseoit de l'autre côté du panneau. Il présente à l'enfant des tâches d'apprentissage en plaçant des cartons dans une fenêtre du panneau. Sur ces cartons, l'enfant peut voir des dessins, des lettres,

des chiffres ou des mots. Il doit les identifier pour être récompen-sé. S'il ne le peut pas, l'expérimentateur prononce le nom et le lui fait répéter. Lorsque l'enfant identifie ce qui est écrit, il reçoit une bille qui roule face à lui. Cette bille, il peut en disposer im-médiatement ou plus tard. Ainsi, s'il la dépose dans un orifice spé-cifique du panneau, il obtient à l'instant soit un colifichet, soit de la nourriture comme un raisin, une arachide ou un petit bonbon. Par contre, s'il la dépose dans un des tubes sous les jouets, il pour-ra obtenir le jouet correspondant au tube lorsqu'il l'aupour-ra rempli de billes.

Puis au fur et à mesure qu'ils participent aux séances, les enfants apprécient le système. Alors Staats récompense les réponses occasionnellement. De plus, il prolonge la durée des séances. De cette façon, il est démontré que les enfants apprennent vite et bien. De plus, leur temps d'attention augmente. Enfin, ils démontrent un vif intérêt et un empressement à venir jouer à apprendre.

28

a) DS -> R KS (carton) (nommer ce qui (bille)

est écrit )

b) DS > R (carton) (nommer ce qui

est écrit )

Fig. 6 - L'expérience de Staats (I9b8b: voir Staats, 1975J. En "a", l'enfant voit un

car-ton, et lorsqu'il nomme ce qu'il voit, il reçoit une bille. En "b", l'enfant voit un carton et nomme ce qui y est inscrit. Il ne reçoit pas nécessairement une bille.

La figure 6 illustre le conditionnement instrumental im-pliqué dans cette expérience. Les cartons sont les stimuli

direc-tifs. Lorsque l'enfant apprend à les identifier, il apprend à émettre la réponse instrumentale spécifique à chaque stimulus directif. Quanti il reçoit une bille en récompense, il s'agit du stimulus renforçant. Ainsi en "a", la ligne pointillée entre le ^S et R indique que le sti-mulus directif, le carton, ne déclenche pas encore la réponse instru-mentale, le nom spécifique, chez l'enfant. De plus, la présence du

S à droite signifie qu'il faut un stimulus renforçant, une bille, pour récompenser la bonne réponse lors de l'acquisition. En "b", la ligne pleine entre le S et R indique que le stimulus directif, le carton, déclenche la réponse instrumentale, le nom spécifique. L'absence du S signifie que le stimulus renforçant, une bille, n'est plus néces-saire pour que l'enfant identifie le carton.

L'énoncé du conditionnement instrumental

L'expérience de Tolman et celle de Staats sont des exemples du principe du conditionnement instrumental. Ainsi, dans les deux cas, il y a une situation stimulus directif ( S ) qui déclenche des réponses instrumentales et il y a également un stimulus renforçant ( S) qui suit seulement une de ces réponses (R). Après un certain nombre d'es-sais de conditionnement de ce genre, où le stimulus directif ( S) sus-cite la réponse instrumentale désirée (R) et où un stimulus renforçant

R D ( S) suit cette réponse (R), le stimulus directif ( S) suscite la

ré-ponse instrumentale (R) même en absence du stimulus renforçant (R). Ea figure 7 illustre ce principe.

Stimulus Réponse Stimulus directif instrumentale renforçant

a) DS > R RS

b) DS — > B

Fig. 7 - Schéma du conditionnement instrumental suggé-ré par Staats. En "a", un stimulus directif (^S) sus-cite une réponse instrumentale (R) qui est suivie d'un stimulus renforçant (**S). En "b", après un certain

nombre d'essais de conditionnement, le stimulus directif ( S) provoque la réponse instrumentale (R), même en l'ab-sence du stimulus renforçant ( S) (Extrait de Staats, 1975, P- 28)

Le principe du conditionnement instrumental peut donc s'é-noncer de la façon suivante: lorsqu'une réponse instrumentale a lieu en présence d'un stimulus et qu'elle est suivie d'un événement parti-culier appelé stimulus renforçant, cette réponse aura tendance à se

30

reproduire en présence de ce stimulus s'il y a un nombre suffisant d'essais de conditionnement, même en l'absence du stimulus renfor-çant.

Dans cet énoncé, les éléments les plus importants sont: le renforcement de la réponse, le nombre d'essais de conditionnement, le stimulus directif, la réponse instrumentale et le stimulus renforçant. Le renforcement de la réponse ainsi que le nombre d'essais de

condi-tionnement ont déjà été présentés dans la section des conditions au renforcement. La section qui suit traitera du stimulus directif, de la réponse instrumentale et du stimulus renforçant.

A. Le stimulus directif

Toute situation peut devenir un stimulus directif pourvu qu'elle soit perceptible par l'organisme et qu'il soit conditionné à y répondre. Autrement dit, n'importe quel événement peut provoquer

des comportements dans un organisme s'il a subi un conditionnement instrumental en conséquence. Ainsi dans la vie de tous les jours, l'homme apprend â répondre à plusieurs stimuli directifs. Par exem-ple, lorsqu'il conduit un véhicule, il obéit aux signaux routiers comme l'enfant répond aux cartons dans l'expérience de Staats.

B. La réponse instrumentale

Le conditionnement instrumental réfère à l'apprentissage de comportements et de gestes. La réponse instrumentale est principale-ment motrice. Ainsi, dans l'expérience de Tolman le rat s'approche de

la lumière; dans l'expérience de Staats, l'enfant nomme ce qu'il voit dessiné ou écrit sur les cartons. Dans les deux cas, il s'agit de gestes impliquant les contractions de muscles relevant du système nerveux volontaire. Les organismes ont de grands répertoires de ré-ponses appris par conditionnement instrumental. L'homme semble avoir acquis plus de répertoires de comportements et des comportements plus sophistiqués que toutes les autres espèces parce que son système ner-veux volontaire est plus complexe.

C. Le stimulus renforçant

Tous les stimuli n'ont pas un effet renforçant pour un orga-nisme. Il en existe qui n'auront pas d'effet sur la force d'émission ultérieure de la réponse motrice même s'ils sont présentés après cette dernière» Ces stimuli sont neutres et ne peuvent être qualifiés de renforçants. Par exemple, à supposer que Tolman remplace la nourri-ture par du sable dans son expérience, il est probable que le nombre de comportements d'approche n'augmentera pas. En effet, le sable ne récompense pas le comportement d'approche du rat, de sorte que la lu-mière allumée n'acquiert aucune valeur directive.

Toutefois, il y a des circonstances où les stimuli qui sui-vent la réponse motrice agissent comme une récompense ou comme une pu-nition. Ainsi, dans l'expérience de Tolman et dans celle de Staats, les stimuli renforçants agissent comme une récompense, car ils augmen-tent la force avec laquelle le stimulus directif déclenche la réponse.

32

Ces stimuli renforçants sont qualifiés de positifs. Cependant, il en existe d'autres qui à l'inverse agissent comme une punition, car ils diminuent la force avec laquelle le stimulus directif déclenche la ré-ponse; ce sont des stimuli renforçants négatifs. Par exemple, Tolman aurait pu substituer un courant électrique à la nourriture. Dans ces conditions, il punit les comportements d'approche. La lumière allumée aurait alors provoqué une diminution des comportements d'approche.

De plus, le retrait du stimulus renforçant a l'effet opposé à sa présence sur la force avec laquelle le stimulus directif déclen-che la réponse instrumentale. Ain sif si Staats retire une bille à l'enfant qui émet une bonne réponse, il affaiblit la force des cartons à susciter ultérieurement ces comportements. Le retrait du stimulus renforçant positif lorsque l'enfant a bien répondu agit comme une pu-nition en ce sens qu'elle diminue la probabilité que l'enfant réponde dans les occasions futures. Inversement, le retrait d'un stimulus ren-forçant négatif, comme un choc électrique, agira comme une récompense, en ce sens qu'il augmentera la probabilité que le stimulus déclenche la réponse attendue.

La figure 8 illustre l'effet de la présentation ou du retrait des stimuli renforçants positif et négatif sur la réponse instrumentale. En ordonnée, il y a trois colonnes; la première correspond à l'opéra-tion de l'intervenant, la deuxième, au stimulus renforçant positif et la troisième, au stimulus renforçant négatif. Dans la première colonne,

il y a les deux opérations mentionnées précédemment, à savoir la présentation et le retrait du stimulus après la réponse. Dans les deux autres colonnes, il y a les effets de ces procédés sur la force du stimulus directif à provoquer la réponse, lorsqu'il s'agit d'un stimulus renforçant positif ou d'un stimulus renforçant négatif.

Stimulus renforçant positif Stimulus renforçant négatif -f- renforce l'émission de la réponse vU affaiblit l'émission de la réponse <l affaiblit l'émission de la réponse f renforce l'émission de la réponse. Présentation du stimulus après la réponse Retrait du stimulus après la réponse

Fig. 8 - L'effet renforçant de la présentation et du retrait des stimuli renforçants positif et négatif sur la réponse instrumentale (Extrait de Staats, 1975» p. 32).

Quand le procédé vise à augmenter la force avec laquelle le stimulus directif déclenche la réponse, il s'agit d'un procédé ae ren-forcement. Mais lorsque le procédé vise à diminuer la force du stimu-lus directif, c'est un procédé de punition. Alors, tel que décrit dans la figure 8, le renforcement et la punition s'obtiennent chacun soit par la présentation ou soit par le retrait du stimulus renforçant.

Ainsi, lorsque Staats récompense le comportement approprié de l'enfant par une bille, il effectue un renforcement. En effet, les

3^

résultats démontrent que le carton présenté à l'enfant suscite davan-tage les réponses dans les essais subséquents, ^ar contre, quand une personne évite d'en rencontrer une autre parce que cette dernière est déplaisante, elle vient d'être également renforcée. En effet, la per-sonne déplaisante est un stimulus renforçant négatif; l'éviter équi-vaut à retirer le stimulus renforçant négatif. C'est pourquoi changer de trottoir, entrer dans un magasin ou tourner le dos à la vue d'une personne déplaisante sont des comportements susceptibles de se repro-duire ultérieurement s'ils permettent de se soustraire à un stimulus renforçant négatif.

Il y a donc deux opérations qui augmentent la force d'un stimulus directif à déclencher une réponse instrumentale. Lorsque l'opération consiste à faire suivre la réponse instrumentale d'un sti?-mulus renforçant positif, comme dans l'expérience de Tolman et celle de Staats, il s'agit d'un procédé de renforcement positif. Cependant, lorsque l'opération consiste à enlever le stimulus renforçant négatif quand la réponse instrumentale a eu lieu, comme dans l'exemple de la personne déplaisante, il s'agit d'un procédé de renforcement négatif.

Dans ce dernier procédé, il y a les comportements qualifiés d'échappement et ceux qualifiés d'évitement. Le comportement d'échap-pement consiste à mettre fin à un stimulus négatif ou à fuir une

situa-tion négative. Par exemple, une personne en rencontre une autre qui lui déplaît. Elle trouve un prétexte pour se retirer et coupe court

à la discussion. Donner le prétexte est un comportement d'échappement à une situation négative. Le comportement d'évitement consiste à pré-venir ou à retarder la mise en présence de l'organisme avec un stimu-lus. Par exemple, changer de trottoir ou tourner le dos sont des com-portements d'évitement d'une personne qui ne veut pas en rencontrer une autre.

Il existe aussi deux opérations dans le procédé de punition, la punition par addition et la punition par soustraction. Lorsqu'un parent tape les fesses de son enfant, il utilise le procédé de

puni-tion par addipuni-tion. Ce procédé consiste à faire suivre la réponse ins-trumentale d'un stimulus renforçant négatif, de sorte que dans l'ave-nir le stimulus directif ne déclenche plus cette réponse instrumentale. Il y a également la punition par soustraction qui est obtenue en enle-vant un stimulus renforçant positif lorsqu'il y a eu une réponse mo-trice. Par exemple, le parent qui retire les clés de l'automobile à sa fille quand cette dernière entre trop tard ou conduit trop vite. Par ce procédé, le parent vise à empêcher que la voiture suscite des comportements indésirables chez sa fille, les fois suivantes.

Le résumé

Les organismes apprennent un grand nombre de mouvements et de comportements selon le principe du conditionnement instrumental. Face à une nouvelle situation, l'organisme cherche à s'en approcher

36

émet le comportement souhaité, plus vite il s'adapte à la situation, ■^l semble que l'être humain ait l'avantage de s'adapter plus rapide ment que les autres espèces. Il est possible que cela soit dû à la complexité de son système nerveux.

Ce chapitre présente les sous-principes d'apprentissage: la généralisation du stimulus, la discrimination du stimulus, l'ex-tinction de la réponse, les programmes de renforcement, la privation et la satiété, le contre-conditionnement et le conditionnement d'ordre supérieur.

La généralisation du stimulus

Des stimuli différents du stimulus original peuvent provo-quer des réponses conditionnées ou des réponses instrumentales.

Dans l'expérience de Watson et Kaynor, il est possible de retrouver un exemple empirique de ce sous-principe dans le cadre du conditionnement classique. En effet, suite à leur expérience, ils ont présenté au même enfant un lapin blanc au lieu d'un rat blanc. Ce dernier a quand même eu une réaction de pleurs. Il semble bien que l'enfant ait confondu les stimuli. Dans ce cas il s'agit d'animaux petits, de même forme, à fourrure, blancs et placés dans la même pièce.

Toutefois, le lapin blanc n'évoquera pas la réponse de pleurs avec la même force que le rat blanc. En effet, la force de déclenche-ment de la réponse classique variera proportionnelledéclenche-ment au degré de ressemblance avec le stimulus conditionné original. Par exemple, si

Watson et Raynor avaient présenté à l'enfant un lapin noir plutôt que blanc, sa réaction de pleurs aurait probablement pu être moindre ou nulle.

Par ailleurs, dans le conditionnement instrumental des sti-muli semblables au stimulus directif peuvent déclencher la réponse instrumentale. Par exemple, une fois l'apprentissage établi, Tolman aurait pu continuer son expérience mais en modifiant l'intensité de la lumière. Alors, il aurait pu constater que le rat s'approche moins vite et moins souvent de la lumière allumée, au fur et à mesure que l'intensité se différencie du stimulus original.

Staats aurait pu lui aussi modifier certaines caractéristi-ques des cartons utilisés dans son expérience lorsque le conditionne-ment est établi. Par exemple, il aurait pu varier la couleur et la dimension des symboles. Alors, les résultats auraient probablement démontré que l'enfant hésite plus souvent à répondre, qu'il prend plus de temps pour identifier le symbole et qu'il se trompe plus fréquem-ment; ceci, au fur et à mesure que les caractéristiques qui sont mo-difiées se différencient des caractéristiques des symboles originaux.

En résumé, les stimuli semblables au stimulus conditionné et au stimulus directif déclenchent une réponse dans l'organisme. Tou-tefois, ce dernier répond moins bien au fur et à mesure que les stimu-li sont dissemblables. ^1 ne s'agit pas d'un procédé, mais bien d'un mécanisme naturel qui facilite l'adaptation de l'organisme aux

varia-ko

tions des stimuli, sans quoi, il devrait apprendre une réponse spéci-fique à chaque situation.

La discrimination du stimulus

Il existe des situations semblables où l'organisme ne doit pas répondre de la même façon. Parfois, la généralisation du stimu-lus peut aboutir à des conséquences fâcheuses. Dans ces circonstances, l'organisme doit apprendre à répondre uniquement au stimulus directif: il doit discriminer ce stimulus des autres stimuli semblables. Les prochains paragraphes expliquent le principe de la discrimination du stimulus.

Ainsi dans l'expérience de Watson et Raynor, l'enfant ré-pond émotionnellement par des pleurs lorsqu'il aperçoit un rat ou un lapin blancs. Il répondra également aux autres animaux semblables. Cependant, il est faisable que le rat soit le seul animal à déclencher une réponse de pleurs. Il s'agit d'organiser l'apprentissage de sorte que le rat soit le seul animal parmi une multitude à être jumelé au bruit sourd. Autrement dit, l'expérimentateur présente à l'enfant plusieurs animaux semblables dont le rat blanc. Lorsqu'il présente le rat blanc à l'enfant, il produit le bruit sourd. Mais lorsqu'il lui présente un autre animal, il ne produit pas le bruit. Après un certain nombre d'essais de conditionnement classique de ce genre, l'enfant discrimine le rat blanc des autres animaux. Alors, seule la vue du rat blanc suscite chez lui des pleurs.

iaur le plan instrumental, Staats (1986b: voir i>taats, 1975) entraîne un enfant à discriminer les lettres "b" et "d". Il utilise l'appareil illustré en figure 5« H présente au hasard à l'enfant des cartons sur lesquels une des lettres est écrite. Lorsque celui-ci l'identifie correctement, il reçoit une bille en récompense. »%uand il se trompe, il ne reçoit rien. Autrement dit, Staats renforce les bonnes réponses par une bille, et il ignore les mauvaises. Après un certain nombre d'essais, les cartons suscitent uniquement les compor-tements appropriés. Par cette stratégie, l'enfant apprend à distin-guer la lettre "b" de la lettre "d".

Bref, l'organisme peut apprendre à discriminer des tions qu'il généralise naturellement. Lorsqu'il s'agit d'une situa-tion de condisitua-tionnement classique, le procédé consiste à ne jumeler au stimulus inconditionné que le stimulus conditionné original, pré-senté parmi d'autres semblables. Quand il s'agit d'une situation de conditionnement instrumental, le procédé consiste à ne renforcer que les réponses émises en présence du stimulus directif original

présen-té parmi d'autres semblables.

La capacité d un organisme à différencier deux stimuli sem-blables dépendra des expériences de conditionnement envers ces deux stimuli et de son acuité sensorielle.

k2

L'extinction de la réponse

Les organismes qui ont évolué biologiquement généralisent leurs apprentissages dans les conditions usuelles. Cependant si, les acquisitions étaient immuables, il est probable qu'ils n'auraient pas atteint un tel niveau d'adaptation. Si parfois ils doivent dis-criminer le stimulus, d'autres fois ils doivent cesser d'y répondre. Cette section traitera de cette dernière situation: l'extinction de la réponse.

Pavlov (1927: voir Staats, 1975) a appris à un chien à sa-liver lorsqu'il entend le son d'une cloche. Hilgard et Marquis (1935« voir Staats, 1975) ont démontré qu'un stimulus conditionné présenté un certain nombre de fois sans être jumelé au stimulus inconditionné, perdait de sa puissance à évoquer la réponse conditionnée. Alors si Pavlov fait entendre le son de la cloche plusieurs fois à son chien, sans lui présenter de la nourriture, le son perdra de sa puissance à évoquer la réponse de salivation.

Sur le plan instrumental, la lumière allumée dans l'expé-rience de Tolman peut finir par ne plus provoquer de comportement d'approche. En effet, si les réponses d'approche ne sont jamais plus renforcées par de la nourriture, la lumière allumée en viendra au bout d'un certain nombre d'essais à ne plus les susciter.

Comme autre exemple, un enfant peut avoir appris une mauvai-se réponmauvai-se lorsqu'il voit un carton comme dans l'expérience de Staats.

Après un certain nombre d'essais où la réponse n'est pas récompensée par une bille, l'enfant va cesser de répondre lorsqu'il verra le car-ton.

Donc, l'organisme peut désapprendre des réponses. S'il s'a-git d'un conditionnement classique, l'opération consiste à ne plus jumeler le stimulus conditionné au stimulus inconditionné. S'il s'a-git d'un conditionnement instrumental, l'opération consiste à ne plus présenter le stimulus renforçant. Dans les deux cas, les stimuli per-dent de leur puissance évocatrice au fur et à mesure que la situation se répète.

Les programmes de renforcements

Dans la réalité, l'environnement ne permet pas toujours au-tant de continuité que dans les expériences de laboratoire, de sorte que les apprentissages n'ont pas toujours lieu en présence des stimu-li inconditionnés ou des stimustimu-li renforçants.

Ainsi, Watson et Raynor ont conditionné une réponse de pleurs à la vue d'un rat blanc. Dans cette expérience, le stimulus condition-né est toujours jumelé au stimulus inconditioncondition-né. D'autre part, «ones

(1920: voir Staats, 1975) a contre-conditionné une telle réponse. Dans cette expérience, le stimulus conditionné n'est plus jumelé au stimulus inconditionné original. Cependant, dans la vie de tous les jours, il arrive fréquemment que le stimulus conditionné soit occasionnellement

kk

jumelé au stimulus inconditionné.

^ar exemple, une personne sursaute violemment lorsqu'elle entend passer une voiture à la suite d'un accident dont elle a été la victime. La figure 9 représente le conditionnement impliqué dans cette situation.

S ..(accident)

a

)

cs

_ m r r ^ R

(bruit de voiture) (réponse émotionnelle négative de douleur)

b) CS > K

(bruit de voiture) (réponse émotionnelle

négative ) Fig. 9 - Un autre exemple de conditionnement classique. En "a", un bruit de voiture (^s) est jumelé à un acci-dent (^s) qui provoque une réponse émotionnelle négati-ve. En "b", par la suite le bruit de voiture seul pro-voquera cette réponse.

Normalement, la force avec laquelle le bruit de la voiture déclenche la réaction émotionnelle négative devrait diminuer. En ef-fet, une personne entendra habituellement plusieurs fois passer une voiture sans se faire heurter pour autant. Dans ces conditions, il y a extinction de la réponse. Mais si durant ce processus d'extinc-tion, la personne subit â nouveau un accident semblable, le bruit de voiture provoquera avec force la réponse émotionnelle négative. Bien plus, dorénavant pour éteindre cette réponse, il faudra que cette per-sonne entende ce bruit sans jumelage plus de fois que lors de la pre-mière période d'extinction. Et si le conditionnement a encore lieu

durant cette deuxième période d'extinction, il faudra davantage d'es-sais sans jumelage pour éteindre la réponse.

Donc, il faut plus d'essais pour éteindre une réponse à un stimulus conditionné lorsque ce dernier a été jumelé occasionnellement au stimulus inconditionné. En d'autres mots, un programme intermit-tent de conditionnement classique rend plus difficile l'extinction de la réponse conditionnée.

Au plan instrumental, les comportements dans la vie courante ne sont pas toujours suivis d'un stimulus renforçant comme dans les expériences de Tolman ou de Staats. Par exemple, les personnes ne reçoivent pas une récompense à chaque mot qu'elles disent. Souvent, elles doivent parcourir des chapitres entiers avant de connaître le résultat d'un match, le dénouement d'une intrigue, le maniement d'un appareil. Une telle performance semble résulter en partie des con-tingences du renforcement.

Ainsi, lorsque Staats enseigne à lire à un enfant, il

ren-force continuellement les réponses. Après un certain nombre d'essais, lorsque l'enfant répond au stimulus, il ne le renforce qu'occasionnel-lement. Au début, il aurait pu récompenser toutes ses deux bonnes ré-ponses; puis ses trois, ses quatre, etc.. Ainsi, le renforcement devient contingent à l'émission d'un nombre de réponses. Il s'agit d'un programme à proportion.

kG

Un tel programme peut être fixe, c'est-à-dire que l'orga-nisme obtient un renforcement après avoir émis le nombre exact de fois le comportement attendu. Par exemple, si Staats spécifie qu'il s'agit d'un programme à proportion fixe de quatre (PF k ) , toute qua-trième réponse sera suivie du stimulus renforçant. L'enfant émettra quatre fois la réponse avant d'obtenir une bille.

Toutefois un tel programme peut être variable; c'est-à-dire que le nombre de comportements pour obtenir un stimulus renforçant va-rie autour d'un nombre moyen de réponses. Par exemple, si Staats pré-cise qu'il s'agit d'un programme à proportion variable de quatre (PV 4 ) , le stimulus renforçant pourra cuivre la troisième, la cinquième et la quatrième réponse d'un ensemble, selon le rapport d'un stimulus renfor-çant pour quatre réponses émises. Ainsi, sur douze réponses, la sixiè-me, la neuvième et la douzième peuvent être récompensées, et cela, en respectant la moyenne d'une bille pour quatre réponses.

D'autre part, un programme intermittent s'obtient également en établissant un intervalle de temps fixe ou variable entre la répon-se et les stimuli renforçants. Par exemple, si Staats instaure un programme à intervalle fixe de quatre minutes (IF 4), il renforcera la première réponse émise quatre minutes après avoir donné un stimulus renforçant; il ignorera toutes les autres réponses. Autrement dit, après avoir récompensé une bonne réponse, Staats ne donne aucune bille durant quatre minutes; puis, passé ce délai, il récompense la première

bonne réponse émise. Par la suite, il attend encore quatre minutes avant de renforcer à nouveau.

Par contre, si Staats établit un programme à intervalle va-riable de quatre minutes (IV 4), il renforcera une seule réponse à

toutes les quatrès minutes, comme dam le programme à intervalle fixe, sauf que la durée de l'intervalle variera autour d'une moyenne de

quatre minutes. Autrement dit, sur une période de 20 minutes, i>taats accordera cinq fois une bille, soit en moyenne une à toutes les quatre minutes.

Donc, un programme de renforcement intermittent s'obtient en organisant les contingences au renforcement. Celles-ci sont spé-cifiés en terme du nombre de réponses émises ou en terme d'intervalle de temps. Dans la première alternative, il s'agit d'un programme à proportion; dans la seconde, c'est un programme à intervalle. Dans les deux cas, ces programmes sont fixes ou variables, si bien qu'il y a des programmes à proportion fixe, à proportion variable, à inter-valle fixe et à interinter-valle variable. La figure 10 illustre les

kb s o a, 35 35 o 600-400 200 Proportion Proportion

fixe variable intervalle fixe

Intervalle variable

Réponse/min.

16 24 Temps (min) 32

Fig. 10 - L'illustration des résultats des taux de réponse obtenus sous différents programmes de renforcement. Les marques diagonales sur les lignes indiquent le renforcement* En bas et à droite il y a une indication de la pente des di-vers taux de réponses. Dans un programme à proportion fixe, il y a un haut taux de réponse, avec une courte pause après le renforcement; puis il y a un changement abrupt de la pause pour un haut niveau de réponse. Dans un programme à propor-tion variable, il y a un haut taux de réponse soutenu et aucune pause après le renforcement. Dans un programme à

in-tervalle fixe, il y a un taux bas de réponse et une pause après le renforcement; la longueur de la pause augmente avec la longueur de l'intervalle; le taux de réponse est plus éle-vé vers la fin de l'intervalle. Dans un programme à inter-valle variable, il y a un taux bas de réponse soutenu et, au-cune pause après le renforcement (Extrait de Reese, 1966, p. 16)

Les programmes à proportion

Les programmes à proportion renforcent l'organisme à répon-dre rapidement. Par exemple, plus l'enfant répond rapidement, plus vite il obtiendra une bille. Un haut taux de réponse caractérise donc ce type de programme. Quand la proportion est fixe, il y a une pause après le renforcement, mais lorsqu'elle est variable, le niveau de ré-ponse est soutenu. La raison en est que l'enfant, par exemple, s'a-percevra qu'il ne reçoit pas deux renforcements successifs dans un pro-gramme à proportion fixe. En conséquence, les cartons qui sont présen-tés après un renforcement deviennent des signaux l'avertissant qu'il n'aura pas de bille même s'il répond. Donc, après le renforcement le

taux de réponse diminue, puis il augmente, tel que décrit dans la cour-be la plus à gauche de la figure 10. Par contre, dans un programme à proportion variable, l'enfant ne peut prévoir le moment exact où il re-cevra une bille. En conséquence, il répondra toujours rapidement. C'est pourquoi la deuxième courbe de la figure 10, à partir de la gau-che, est constante et d'inclination élevée.

L'extinction de la réponse dans un programme à proportion fixe est caractérisée par un grand nombre de réponses émises à un taux élevé dans une période de temps relativement courte.

Les programmes à intervalle

La figure 10 démontre que l'inclination des lignes illus-trant des programmes à intervalle est moins accentuée que celle des

5Q

programmes à proportion. C'est-à-dire que dans un programme à inter-valle, le taux de réponse est plus bas que dans un programme à propor-tion. La raison en est que le renforcement dépend du temps écoulé et non des réponses accumulées. Ainsi, la personne soumise à un programme à intervalle répondra moins que si elle l'était à un programme à pro-portion, parce qu'elle n'a aucun avantage à répondre plus rapidement.

De plus, dans le programme à intervalle fixe, la courbe é-volue par paliers. Ainsi, après le renforcement il y a un plateau; c'est-à-dire que le taux de réponse est nul. Mais dans un tel pro-gramme, la probabilité pour un organisme d'être renforcé successive-ment deux fois est nulle. Par exemple, dans un programme à intervalle fixe de quatre minutes, l'enfant ne recevra pas deux fois de suite une bille parce qu'il a bien répondu par deux fois. Il devra obligatoire-ment s'écouler un intervalle de quatre minutes depuis l'obtention de la dernière bille pour que l'expérimentateur lui en donne une autre. De cette façon, le stimulus renforçant devient un stimulus directif

l'incitant à ne pas répondre immédiatement. La durée de cette pause dépend de la longueur de l'intervalle. Par exemple, si l'intervalle est IF 3> l'enfant peut attendre deux à trois minutes avant de commen-cer â répondre. Mais si l'intervalle est IF 3O1 il peut attendre par-fois jusqu'à vingt minutes.

Après s'être maintenue sous forme de plateau, cette courbe monte de façon abrupte. C'est-à-dire qu'après un certain laps de

temps sans réponse, l'organisme commence à répondre plus rapidement. Ainsi, pour continuer l'explication avec l'exemple précédent,

l'en-fant ne répond plus une fois qu'il a été récompensé. Puis, après un certain délai, il commence à nommer les stimuli. Quand l'intervalle de quatre minutes est atteint, il obtient une bille. Par la suite, le cycle recommence; il y a un plateau suivi d'une courbe ascendante.

Dans le programme à intervalle variable, la courbe se pré-sente sous la forme d'une droite. En d'autres mots, l'organisme répond régulièrement avec la même rapidité. Par exemple, l'enfant répond continuellement aux stimuli. Contrairement au programme à in-tervalle fixe, la bille ne devient pas un stimulus directif d'une pé-riode de non-récompense et l'enfant est continuellement incité à ré-pondre. Le taux de réponse est relatif à la durée de l'intervalle. Plus celui-ci est long, plus le taux est bas.

L'extinction de la réponse instrumentale apprise dans un programme à intervalle se caractérise par un taux de réponse bas et soutenu qui diminue graduellement. Lorsque le nombre de renforce-ments est constant, les programmes à intervalle produisent des appren-tissages très difficiles à éteindre. Par exemple, il peut y avoir dans un hôpital psychiatrique des bénéficiaires qui quémandent de l'ar-gent. Si à l'occasion, des personnes se montrent charitables et ren-forcent ce comportement par des pièces de monnaie, il sera très diffi-cile par la suite d'éteindre le comportement de quémander, même si

^

tout le personnel s'entend pour ne plus donner d'argent.

En résumé, lorsque l'expérimentateur désire qu'un compor-tement dure, même en absence du stimulus renforçant, il organise un programme à renforcement intermittent. Cependant, lorsqu'il entre-prend l'extinction du comportement, il doit complètement cesser de le renforcer sinon il applique un programme intermittent. Ainsi, le qué-mandeur cesse graduellement de solliciter les gens quand personne ne lui donne de l'argent. Mais si quelqu'un lui en donne un jour, il renforce le mauvais comportement après un certain nombre d'essais ou après un intervalle de temps. En d'autres mots, il renforce de façon intermittente un comportement inadéquat. Les résultats démontrent qu'il sera très difficile par la suite d'éteindre ce comportement. Il y aura alors beaucoup de frustration car la persévérance des interve-nants sera mise à dure épreuve.

La privation et la satiété

La privation et la satiété d'un stimulus inconditionné ou d'un stimulus renforçant affectent le conditionnement. En général, la privation augmente la force avec laquelle la réponse est déclen-chée alors que la satiété diminue cette force.

Dans le conditionnement classique, la privation du stimulus inconditionné augmente la force avec laquelle ce stimulus suscitera la réponse inconditionnée. Par exemple, un chien salivera plus à la

vue de la nourriture s'il est affamé. Finch (1938: voir Staats, 1975) a démontré que le conditionnement classique d'une réponse, lorsque le stimulus inconditionné est de la nourriture, dépend de la période de jeune ou de privation de l'organisme. En d'autres mots, un stimulus conditionné comme le son d'une cloche pourra susciter une réponse de salivation chez un chien, si ce dernier est affamé lors du condition-nement.

D'autre part, la satiété du stimulus inconditionné diminue la force avec laquelle il suscite la réponse inconditionnée. Par exemple, le chien salivera moins à la vue de la nourritue quand il est rassasié. Le conditionnement classique de la réponse au stimulus conditionné sera moins fort, ^ar exemple, le chien salivera moins au son de la cloche s'il n'est pas affamé. En d'autres termes, la nour-riture ne provoquera pas la réponse de salivation avec la même inten-sité, de sorte que cette réponse sera moins ou ne sera pas condition-née au son de la cloche. Donc, contrairement à la privation, la sa-tiété réduit la force du stimulus inconditionné à déclencher la réponse inconditionnée; par conséquent, le conditionnement est plus diffici-lement réalisable.

Ces considérations valent pour tous les stimuli provoquant des réponses internes comme les stimuli sexuels, ceux qui suscitent des réponses motrices réflexes, des réactions des glandes, des vis-cères et des vaisseaux sanguins. De plus, elles semblent concerner

54

surtout les stimuli positifs. En effet, il n'apparaît pas que l'or-ganisme soit rapidement saturé par des stimuli négatifs. Par exemple, il semble que l'organisme réagisse au bruit fort même après plusieurs répétitions.

En résumé, dans le conditionnement classique, la privation augmente la force avec laquelle un stimulus positif déclenche une ré-ponse émotionnelle. D'autre part, la satiété d'un stimulus positif diminue sa force de déclenchement. Ainsi l'organisme ne recherche pas continuellement les stimuli positifs. Par exemple, l'organisme ne mange pas de façon continuelle. Il ne fait pas non plus l'amour sans arret. Par contre, il semble que les conditions de privation ou de satiété d'un stimulus négatif n'affectent que très peu la force de déclenchement de ce stimulus. Par exemple, une brûlure sur une main suscite de la douleur; il faut que l'organisme soit brûlé à un très haut degré pour qu'il devienne insensible.

Les conditions de privation et de satiété du stimulus forçant affectent le conditionnement instrumental. Un stimulus ren-forçant comme de la nourriture, présenté suite à une réponse instru-mentale, augmente la force du stimulus directif à déclencher ultérieu-rement la réponse instrumentale. Cependant, Hilman, Hunter et Kimble (1953: voir Staats, 1975) ont démontré que la nourriture est un stimu-lus renforçant efficace en autant que l'organisme en est privé. Au-trement dit, la valeur renforçante d'un stimulus varie selon les

conditions de privation et de satiété de l'organisme par rapport à ce stimulus.

De plus, Skinner (1938: voir Staats, 1975) a obtenu des taux élevés de réponse quand l'animal était privé du stimulus ren-forçant utilisé. Donc, un stimulus renren-forçant augmentera davantage la force de déclenchement du stimulus directif si l'organisme en a auparavant été privé. Par exemple, le rat dans l'expérience de Tolman réagirait plus fortement à la lumière allumée s'il était affamé. En outre, dans ces conditions, il continuerait à s'approcher plus souvent et plus longtemps sans obtenir de la nourriture. En effet, Périn

(1942: voir Staats, 1975) a démontré que la privation du stimulus ren-forçant rend plus difficile l'extinction de la réponse instrumentale.

En résumé, pour obtenir un conditionnement instrumental ef-ficace, il faut que l'organisme soit privé du stimulus renforçant uti-lisé. De plus, la privation du stimulus renforçant augmente la valeur directive du stimulus directif, car l'organisme répond davantage. En-fin, l'organisme a une plus grande résistance à l'extinction lorsqu'il est privé du stimulus renforçant. Dans tous ces cas, la satiété a l'effet contraire.

Le contre-conditionnement

Souvent, des organismes apprennent des réponses qui ne