L b

S . S

U L

S / f i

FACULTE DES SCIENCES DE L'EDUCATION

THESE PRESENTEE

A L'ECOLE DES GRADUES DE L'UNIVERSITE LAVAL

POUR L'OBTENTION

DU GRADE DE MAITRE ES ARTS (M.A.) PAR

GEORGETTE ST-PIERRE BACHELIERE ES ARTS

DE L'UNIVERSITE DE BATHURST (N.B.)

UNE APPROCHE DE REVISION EMPIRIQUE D'ITEM: L A SENSITIVITE A L'ENSEIGNEMENT

L'auteure désire exprimer ses remerciements à mon sieur Richard Girard pour la haute qualité d'assistance qu'il a bien voulu lui assurer dans l'élaboration de cette thèse.

Elle remercie également les élèves du Collège Notre- Dame de Bellevue et leur professeure, Madame Annette Al lard, qui se sont généreusement prêtées à l'expérimentation qu'a né cessitée cette étude.

Table des matières

AVANT-PROPOS ... i

TABLE DES MATIERES ... ii

LISTE DES TABLEAUX ... iv

INTRODUCTION ... 1

CHAPITRE PREMIER - Présentation du problème ... 4

1.0- Le contexte du problème ... 5

2.0- Définition de concepts ... 10

3.0- Justification de la recherche ... 12

4.0- Limites de la recherche ... 14

CHAPITRE 2 - La revue de la littérature et le cadre théorique ... 15

1.0- La revue de la littérature ... 16

1.1- Première partie: le concept de sensitivité — 16 1.2- Deuxième partie: la comparaison d'indices ___ 24 1.3- Conclusion ... 34

2.0- Cadre théorique ... 36

3.0- Liste des variables ... 37

3.1- Variables indépendantes... 37

3.2- Variables dépendantes ... 38

4.0- Hypothèses ... 39

CHAPITRE 3 - Le déroulement de l'expérience ... 40

1.0- L'échantillon ... 41

2.0- L'instrument de mesure utilisé ... 41

2.1- Contenu de l'épreuve ... 41

3.0- Les stratégies ou modalités d'enseignement ...

^

4.0- Le modèle expérimental ... 44

5.0- L'expérimentation ... 44

6.0- Le traitement des données ... 45

CHAPITRE 4 - Présentation et discussion des résultats ... 47

1.0- Relevé des résultats ... 48

1.1- Description des résultats reliés à la première hypothèse et touchant les variables: indices et modalités d'enseignement ... 51

2.0- Discussion des résultats ... 59

2.1- Discussion des résultats relatifs au degré élevé de sensitivité visé pour les i t e m ... 59

2.2- Discussion des résultats relatifs aux faibles valeurs de sensitivité ... 63

2.3- Discussion des résultats relatifs aux valeurs négatives de sensitivité ... 63

2.4- Discussion des résultats relatifs aux modifica tions apportées à l'indice d'Harris pour le ren dre comparable aux indices qui répondent aux critères d'acceptation ... 64

CHAPITRE 5 - Conclusion et recommandations ... 70

BIBLIOGRAPHIE ... 74

ANNEXE I - Echelle inspirée de Cl.B. Chadwich servant à la caractérisation des approches permissive et non-permissive et au contrôle du contexte d'enseignement systématique ... 78

ANNEXE II - Pré et post-test portant sur la division algé brique administrés aux élèves faisant partie de l'échantil lon (deuxième secondaire) ... 81

Liste des tableaux

Tableau 1 - Patron individuel de réponse de cinq élèves

pour 1 'objectif X ... 7

Tableau 2 - Tableau-type de contingence â deux dimensions utilisé 5 titre de grille d'entrée des données recueillies, pour un item donné, à un prétest et â un post-test... 7

Tableau 3 - Auteurs: Cox et Vargas, 1966-1969 et 1974 ... 27

Tableau 4 - Auteur: Harris (1974) ... 29

Tableau 5 - Auteur: Brennan (1971) ... 31

Tableau 6 - Auteur: Roudabush (1973) ... 32

Tableau 7 - Auteurs: Kosecoff et Klein (1974) ... 33

Tableau 8 - Résultats obtenus aux pré et post-tests par le groupe 03 ... 50

Tableau 9 - Résultats obtenus aux pré et post-tests par le groupe 05 ... 51

Tableau 10 - Tableau des patrons de réponses par item et par ... 52

Tableau 11 - Résultats de la mesure de la sensitivité par item et par classe pour chacun des six indices retenus ... 53

Tableau 12 - Moyennes obtenues par les deux groupes réunis â la suite de l'application des indices, pour l'ensemble des dix item ... 54

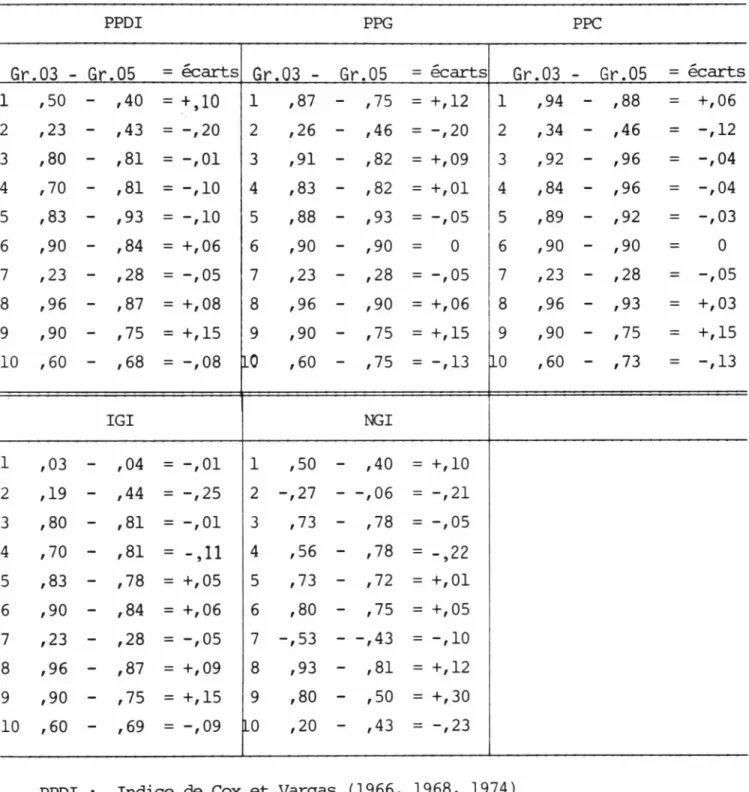

Tableau 13 - Ecarts enregistrés entre les indices sous chacun des traitements ... 56

Tableau 14 - Tableau-synthèse en nombre absolu des écarts enre gistrés â chacun des traitements pour chaque indice ... 57

Tableau 15 - Test de l'hypothèse nulle selon la technique du SIGN TEST ... 58

Depuis quelques années, la recherche axée sur l'aspect formatif de l'é valuation des apprentissages accorde une grande importance à l'examen critique des instruments de mesure. Maximiser la qualité des tests utilisés en contex te critérié de façon à ce qu'ils soient utiles et efficaces pour déterminer le degré d'atteinte d'objectifs, telle semble être la visée première des c h e r c h e u r s .

A u nombre des moyens reconnus efficaces pour assurer la qualité des item des tests se classe la REVISION d'item. Cette opération comporte, selon Berk, Haladyna et Roid, deux séries d'interventions distinctes: la première concerne la révision logique d'item (Logical Item Review). Elle pose le problème de la congruence objectif-item associée aux aspects structure du test et format de l'item. La seconde, qui a trait à la révision empirique d'item (Empirical Item Review), pose le problème de l'interprétation des résultats recueillis à la suite de l'administration d'un test. Elle prend en considération les divers patrons de réponses que fournissent les élèves pour un item donné (Patterns of Students' Responses).

Notre étude, qui se limite à cette seconde catégorie d'interventions, vise à déterminer un moyen concret, une procédure simple qui puisse permet tre à l'enseignant de vérifier, à posteriori - une fois effectuée la vérifi cation à priori - si les item qu'il utilise couranment reflètent avec exacti tude le degré des acquis de ses élèves.

Pour y arriver, nous avons cerné la portée théorique et pratique du concept de SENSITIVITE de l'item à l'enseignement (Instructional Sensitivity), concept qui, selon les auteurs précités, peut être considéré comme le fonde ment essentiel des opérations de révision empirique d'item en contexte cri

térié .

En nous appuyant sur les postulats sous-jacents au modèle d'Haladyna et Roid, nous avons formulé deux hypothèses de recherche. La première prévoit que, dans un contexte d'enseignement systématique, les valeurs de la sensiti vité des item se doivent d'être hautes, c'est-à-dire être comprises entre

Une expérimentation impliquant deux modalités différentes d'ensei gnement, soit les approches permissive et non-permissive, fut menée dans deux classes de deuxième secondaire; ces classes comptant respectivement 30 et 32 élèves.

L'enseignant fut soumis à un questionnaire ayant pour fonction, premièrement, de caractériser chacune des approches utilisées et deuxiè mement, de vérifier dans quelle mesure le contexte d'enseignement systéma tique a été respecté. (L'on sait qu'un tel contexte est requis en étude de sensitivité pour assurer la fiabilité des résultats).

De leur côté, les élèves ont été soumis à un test de maîtrise com prenant dix item portant sur les opérations de la division algébrique; le choix de cet objet d'enseignement étant justifié du fait des risques mini mes qu'il présente sur le plan des apprentissages extérieurs, parallèles.

Les résultats recueillis nous ont permis de confirmer les deux hypothèses de cette recherche. En effet, les valeurs de la sensitivité des item se sont, en général, avérées hautes en contexte d'enseignement systématique; et, sous l'influence de deux modalités d'enseignement diffé rentes, l'un des cinq indices engagés dans la course, s'est avéré plus résistant que les autres, enregistrant la plus faible variation entre les valeurs de sensitivité obtenues sous chacune des deux modalités.

Nous en arrivons ainsi à proposer à l'enseignant un moyen simple, rapide et efficace de révision empirique d'item: un indice ou formule à appliquer, qui permette de déterminer le degré de sensitivité des item utilisés dans une pratique courante. C'était le but poursuivi dans la présente recherche.

Georgette St-Pierre, étudiante

Richard Girard, Directeur detation critériée.

Dans un contexte où l'intérêt est centré sur le degré d'atteinte d'objectifs, l'élève s'inscrit dans un cheminement progressif: il est ap pelé à passer d'un point "A" de son apprentissage à un point "B" défini dans l'objectif visé. Les instruments de mesure qui sont alors utilisés tiennent compte du dcmaine de questions que recouvre l'objectif et fournis sent des résultats interprétés en fonction d'un seuil de réussite.

La plupart des recherches conduites jusqu'ici en mesure d'inter prétation critériée redéfinissent les concepts traditionnels de base en évaluation, en introduisent de nouveaux et proposent des procédés égale ment nouveaux d'élaboration et de révision d'instruments de mesure propres à l'approche critériée.

Il est évident qu'il en résulte un bénéfice réel pour le renouveau de l'évaluation pédagogique qui se voit actuellement appuyé sur une techno logie en constant progrès.

Quoiqu'un très grand nombre de domaines couverts par l'évaluation des apprentissages aient été touchés, il nous apparaît que certaines des nombreuses questions que se posent les enseignants relativement à l'amélio ration des instruments de mesure, n'ont pas encore reçu de réponses suffi samment explicites. Une de ces questions est la suivante: Existe-t-il des moyens qui permettent de vérifier de façon simple et efficace la qua lité des item sous l'aspect de leur "capacité" d'établir des différences entre divers niveaux de compétence?

3

Cette question pose le problème de la mesure de la sensitivité des item â l'enseignement et appartient à l'opération de révision empi rique d'item (empirical review).

L a présente étude tentera de répondre à cette question en mettant d'abord en lumière le concept d ' INSTRUCTIONAL SENSITIVITY (ou de sentivité de l'item à 1 ' enseignement ) ; ce concept constituant 1 ' élément fondamental sur lequel repose l'approche critériée. Elle fera également état du con cept d'enseignement systématique, du fait de sa relation très étroite avec celui de sensitivité à l'enseignement.

La présentation que nous ferons de ces concepts et des implications de leur application concrète devrait favoriser une vue d'ensemble plus glo bale et plus conplète du champ théorique et pratique qui entoure la notion

d 'Instructional Sensitivity.

Dans un premier chapitre, nous décrirons le contexte du problème et définirons les principaux concepts auxquels il est fait référence dans la présente étude.

Une revue de la documentation sera présentée dans un second chapi tre qui fera état d'études relatives au concept d 'Instructional Sensitivity de même qu'à différents indices propres à l'évaluation de cette même carac téristique d'item.

Nous analyserons de plus près, dans un troisième chapitre, divers indices proposés pour la mesure du degré de sensitivité des item à l'en seignement. Cette analyse comportera l'expérimentation d'indices reconnus les plus utiles et les plus facilement applicables dans la pratique ensei gnante quotidienne, en vue d'établir des priorités parmi eux.

Nous exposerons, en conclusion, les réflexions, les commentaires et les hypothèses de recherche qu'aura suscités notre étude.

Il est à souhaiter que cette étude puisse contribuer à l'améliora tion des procédés de vérification empirique d'item en contexte critérié.

1.0 Le contexte du probLème

Une des principales fonctions propres à la révision d'item appli cable e n mesure d'interprétation critériée est la propriété qu'a l'item

(ou le test) de refléter avec exactitude la mesure d'un acquis attribuable à l'enseignement. L'item qui a la propriété de réfléchir ainsi l'image de l'acquisition d'une connaissance ou d'une habileté est dit, à juste titre, SENSIBLE à l'enseignement.

Si l'on pousse plus avant cette idée, l'on se rend carpte que, dans un tel contexte, le niveau de difficulté d'un item est d'abord conditionné par 1'en se ig ne men t. En effet, un item administré à la suite d'un enseigne ment raisonnablement bien dispensé s'avère généralement facile aux élèves,

alors que ce même item, administré à des élèves qui n'auraient pas suivi l'enseignement, risque fort d'être jugé difficile. C'est pourquoi les item qui ne permettent pas de détecter de différences entre les acquis de tels groupes d'élèves, devraient faire l'objet d'une révision.

Relativement à cette opération de "détection" de différence entre niveaux de compétence, au moins deux grandes catégories d'interventions sont identifiées et analysées dans la documentation récente (Haladyna et Roid, 1981, pp. 32 et 235). La première catégorie d'interventions concerne la ré vision logique d'item (logical item review) et pose le problème du lien étroit qui doit exister entre un item et l'objectif mesuré par cet item. La seconde a trait à la révision empirique d'item (empirical item review) et pose l'im portante question de l'information utile qui doit résulter d'une opération de révision effectuée à la suite de l'administration d'item.

La révision logique d'item (ou révision à priori) fournit des infor mations qui permettent de juger si l'item est acceptable sous le double as pect de sa structure et de son format et s 'il est conforme à 1'intention pédagogique initiale contenue dans l'objectif. Ce genre de révision requiert généralement la participation d'experts et débouche sur la détermination du

degré de la congruence qui existe entre les i te m et les objectifs qu'ils doivent mesurer.

Quant à la révision empirique d'item, elle fournit des informations sur les modifications que l'enseignement fait subir à l'apprentissage des élè ves. En permettant de déterminer le degré d'exactitude selon lequel un item reflète les acquis des élèves, elle concourt à établir le degré de sensiti vité de cet item.

Relativement à l'identification de ces deux catégories d'interven tions, les révisions logique et empirique d'item, les auteurs Haladyna et Roid s'expriment ainsi:

"Logical review refers to the logical relatedness of items to their instructional intent. Empirical review refers to p a t t e m s of students' responses that are viewed as desirable." (1982, p. 203).

Il faut entendre par " p a t t e m s of students' responses" le mode se lon lequel se présentent les réponses données par les élèves à chacun des item d'un test. C'est ce qu'il est convenu de narmer le patron de réponses des élèves.

Un patron de réponses tient généralement compte des résultats obte nus à un prétest et à un post-test, soit pour un élève, soit pour plusieurs élèves. Les réussites y sont le plus souvent représentées par le chiffre 1 et les échecs par le chiffre 0.

L'exemple suivant illustre le patron individuel de réponses de cinq élèves d'un groupe à un pré et à un post-test. Ces tests comprennent cinq

item et mesurent un objectif donné.

Selon Haldyna et Roid, une telle façon d'illustrer des patrons de réponses d'élèves à des item administrés avant et après un enseignement, re vêt une grande importance en révision empirique puisqu'elle constitue la base sur laquelle se fonde cette catégorie d'interventions.

7

Patron individuel de réponses de cinq élèves pour l'objectif X

Tableau 1

OBJECTIF X

Item 1 Item 2 Item 3 Item 4 Item 5 Pré Post Pré Post Pré Post Pré Post Pré Post

Elève 1 0 1 0 1 0 1 0 0 0 1

Elève 2 0 1 0 1 0 1 0 1 0 1

Elève 3 0 1 0 1 0 1 0 1 0 1

Elève 4 0 1 1 0 0 0 0 1 0 0

Elève 5 0 1 0 1 0 1 0 0 0 0

En se référant à l'indice de Cox et Vargas (1966), que nous expli citerons plus loin, Serge Racine (1982, p. 96) présente le cadre (tableau de contingence à deux dimensions) devant servir de support au patron collec tif des réponses des élèves. Nous reproduisons ce tableau croyant, par ce moyen, souligner l'importance de la mise en place de données organisées en vue de l'application d'indices. Voici ce tableau à double entrée:

Tableau 2

Tableau-type de contingence à deux dimensions

utilisé à titre de grille d'entrée des données recueillies, pour un item donné, à un prétest et à un post-test

POST-TEST 1

Keu

A: (0,1): B: (0,0): C: (1,1): D: (1,0): 1 0 0 > o va f—* B (0,0) 1 r—i w> r—f V D (1,0) A + C B + D A + B • • • • • • C + D N ou 0: échec 1: succèsproportion d'étudiants qui ont échoué au prétest et réussi au post-test.

proportion d'étudiants qui ont échoué à la fois au prétest et au post-test.

proportion d'étudiants qui ont réussi à la fois au prétest et au post-test.

proportion d'étudiants qui ont réussi au prétest et échoué au post-test.

Il est clair que le cas idéal est A (0,1) où l'élève passe d'une non-compétence à une compétence. Dans le cas B (0,0), aucun apprentissage n'est enregistré. Le cas C (1,1) indique que l'élève n'avait sans doute pas besoin d'être informé, l'étant déjà avant l'enseignement. Quant au cas D (1,0), il présente une situation problématique: l'élève passe de la compétence à la confusion.

On aura remarqué que l'utilisation de tels tableaux permet d'organiser systématiquement les données en vue de faciliter la dé tection des niveaux de performance atteints par les élèves. Ce qui nous replace au coeur du problème que nous soulevons, problème qui consiste 5 déterminer quels indices sont les plus appropriés à une utilisation courante, compte tenu des influences que peuvent exercer diverses modalités et d'enseignement sur les résultats de la sensiti vité.

A la lumière des propos d'Haladyna et Roid (1982) et de ceux de Berk (1980), il nous paraît opportun d'examiner brièvement les ca ractéristiques du contexte formatif dans lequel doit se dérouler l'en seignement lorsqu'il est question de révision formelle d'item.

Les auteurs précités ont clairement décrit le contexte â l'in térieur duquel les méthodes de révision d'item qu'ils proposent trouvent leur plus grande efficacité. Ce contexte est qualifié d'enseignement systématique (Systematic Instruction) et comporte trois éléments essen tiels ainsi présentés par ces mêmes auteurs.

CRITERION-REFERENCED

Fig.l: Three aspects of systematic instruction (Haladyna et P.Did, 1983, p. 14)

9

Au moins trois facteurs entrent en jeu. dans ce contexte:

1. la formulation précise de l'objectif à atteindre;

2. le choix des stratégies appropriées pour atteindre 1'objectif, et de toute forme de renforcement pour susciter, améliorer ou maintenir le comportement désiré;

3. la mise en place et 1'application de procédés d'évaluation adéquats.

Il est clair que ce contexte s'apparente à celui qui est propre au critérié et que, de ce fait, il se confond avec ceux de "mastery learn

ings" et de "mastery testing". Rappelons que ces dernières approches se définissent à la fois comme une philosophie et cornue l'ensemble cohérent des stratégies permettant d'appliquer cette même philosophie. (J.H. Block, 1973, p. 30).

Le lien très étroit qui existe entre le concept d'enseignement sys tématique et celui "d' Instructional Sensitivity" ne laisse donc aucun dou te du fait des affirmations d'Haladyna et Roid et du consensus que les au teurs établissent implicitement sur cette question. Quoique peu connue et diffusée, 1'importance d'unir inséparablement ces deux concepts dans une pratique cohérente devrait s'imposer à tout enseignement qui se veut adapté aux exigences de l'heure.

Or, lorsque l'on considère où en est actuellement la pratique éva- luative courante, en particulier, du point de vue des approches de révision empirique d'item critériés, pour ne pas dire du point de vue précis des moyens dont disposent les enseignants pour évaluer la sensitivité des item qu'ils administrent à leurs élèves, nous scmmes forcés d'admettre que bien peu de chose n'a encore été fait jusqu'ici en ce sens.

En effet, aucun type d'instruments utilisables à ces fins ne paraît connu des enseignants, quoique la documentation actuelle de production ré cente se veuille, pour sa part, vulgarisée, pratique et de surcroît dispo nible.

Devant ces faits et conscient de l'importance de remédier à la situation, nous avons crû bon de conduire cette étude au terme de laquelle certains des modèles retenus seraient présentés carme les plus aptes à ré pondre aux besoins de l'enseignant.

Formulons-nous ici un besoin encore trop peu ressenti chez l'ensem ble des enseignants? Ou nous faisons-nous le porte-parole de ceux qui, sensibilisés à certaines exigences de qualité, n'ont pas la possibilité d'y consacrer le temps nécessaire? Peu importe. L'exigence se pose du point de vue de l'amélioration des instruments de mesure en contexte critérié et l'état actuel de la recherche nous permet de nous engager sur cette

voie. Aussi notre étude se donne-t-elle pour objectif de déterminer si, parmi un certain nombre d'indices, il en existe un qui soit plus résistant que les autres à l'influence des diverses modalités que peut prendre l'en seignement.

2.0 Définition de concepts

Les définitions suivantes se veulent plutôt opérationnelles que formelles. Elles ne touchent que les deux pôles essentiels de l'étude: la sensitivité de l'item à l'enseignement et l'enseignement systématique.

Sensitivité (Instructional Sensitivity)

Tel que présenté par Ozenne (1971) et repris par Haladyna et Roid (1981), le concept d'Instructional Sensitivity se définit carme la proprié té qu'a un item de discriminer entre divers niveaux de performance.

"Sensitivity is a measure of the test's ability to discriminate competency levels". (Ozenne, 1971, p. 81).

"Instructional sensitivity is a characteristic of CR test items that reflects the change from pre-test to posttest that is a result of highly effective ins- truction. Students perform poorly prior to instruc- tion, but they perform well after instructions".

11

"Instructional sensitivity has been defined as the tendency for items to vary in difficulty as a func tion of instruction (Haladyna and Roid, 1981). Simply stated, this means that when students have net been taught, item performance will be low, suggesting a difficult item; when students have had instruction, item performance will be high, suggesting an easy item. (Haladyna et Roid, 1982, p. 36).

Enseignement systématique Systematic Instruction)

Haladyna et Roid (1982,1983) qualifient de systématique le contexte dans lequel doit s'effectuer l'enseignement en CRM.l Parmi les principales formes d'enseignement systématique, nous avons déjà signifié celles qui se fondent sur le concept de MAITRISE. Nous nous limitons à ces approches en citant un passage de James H. Block (1973) particulièrement éclairant sur le caiportement de l'enseignant engagé dans un tel processus:

[...] Cperating Procedures for Mastery learning - The teacher is now ready to teach. Since students are not accustomed to learning for mastery or to the notion that they all might earn A's, the teach er usually must spend seme time at the course's out set orienting them to the procedures to be used.

During this period, teachers have stressed the follow ing points:

1. The student will be graded solely on the basis of his surtmative examination performance.

2. The student will be graded against predetermined per formance standards and not in relation to the per formance of his peers.

3. All students who attain a particular level of per formance will receive the corresponding grade (hope fully an A), and there will be no fixed number of A's, B's, C's, D's or F's.

4. Throughout the course, the student will be given a series of ungraded diagnostic-progress tests to promote and pace his learning.

5. Each student will receive all the help he needs in ordre to learn.

This orientation period - combined with continual encoura gement, support, and positive evidence of learning success - should develop in most students the belief that they can learn and the motivation to learn. (J.H. Block, 1973, p. 15)

La présentation du concept "d'Instructional Sensitivity" associé aux implications que suscite son application dans le domaine de la révision d'item, met en évidence une première hypothèse: il devrait être possible d'établir, parmi un ensemble de moyens (ou indices) proposés en vue de me surer le degré de sensitivité d'item, ceux qui s'avèrent les plus appropriés à la pratique enseignante.

Dans le sens de cette hypothèse générale, nous soutenons que cette idée de faciliter à 1'enseignement l'utilisation d'indices de sensitivité rejoint celle de certains auteurs, en particulier celle de Berk qui soutient que trop peu d'attention a jusqu'ici été apportée par les chercheurs à l'ef fet de fournir aux praticiens des moyens adaptés à l'utilisation qu'ils veulent en faire. Aussi a-t-il rédigé un Guide-*- à l'usage des enseignants, où il compare, en les critiquant, de nombreux indices.

Les travaux de plusieurs auteurs avaient devancé ceux de Berk (1978). Qu'il s'agisse de Cox et Vargas - les initiateurs (1966), d'Ozenne (1971), de Crehan (1974), d'Herbig (1976), de Klein et Kosecoff (1976), d'Haladyna et Roid (1982) pour ne citer que ceux-là, leurs études comparatives et cri tiques ne manquent pas de mettre en lumière l'importance de la recherche d'indices applicables en révision d'item dans le domaine critérié.

Quant à la pertinence et à l'urgence de contribuer à faire passer à la salle de classe les découvertes des travailleurs des laboratoires, point n'est besoin, il nous semble, d'en prouver la nécessité. Berk est l'un de ceux qui s'y sont appliqués. C'est d'ailleurs dans la ligne des suggestions qu'il formule en conclusion d'un important article que se si tue notre recherche, (cf. Berk, 1978, p. 73.3).

Il existe un très grand nombre d'indices nouveaux qui font actuel lement l'objet de comparaisons entre eux et avec ceux qui appartiennent à l'approche classique. Ces comparaisons nous permettent de sélectionner

1. R.A. Berk, A Consumer's Guide to Criterion-Referenced Test Item Statistics, dans, A Serie of Spécial Reports of the NCME, volume 9, no. 1, Winter, 1978.

13

ceux qui sont d'application simple, rapide et efficace en classe et de les mettre de nouveau à l'épreuve. Ceux qui, parmi ces derniers, s'avéreront résistants à certaines variations introduites dans l'approche méthodologi que, pourront être reconnus "recommandables", en priorité.

Le fait de pouvoir en arriver ainsi à fournir à l'enseignant un instrument nouveau et original qui lui permette l'auto-évaluation d'item qu'il construit lui-même en vue d'une utilisation courante, nous paraît justifier aussi cette recherche. D'autant plus qu'au Québec, actuellemennt, un grand courant de renouveau met l'enseignant en présence d'exigences aux quelles il ne peut se soustraire: la réforme des programmes d'études l'amè ne à une approche plus systématique de son enseignement, y compris de ses démarches d'évaluation.

Dans l'état actuel des choses, nous croyons qu'il serait imprudent de croire que, étant appelés à améliorer les tests critériés qu'ils font subir à leurs élèves, les enseignants disposent actuellement des moyens qui leur permettent d'accomplir cette tâche avec facilité et compétence.

Les nouvelles approches suscitent des attentes, font naître des be soins vis-à-vis l'instrumentation pertinente. L'un de ces besoins est sans contredit l'habileté à sélectionner, dans un ensemble d'item devant mesurer le degré d'atteinte d'objectifs, ceux qui doivent être retenus en raison de leur qualité à discriminer entre divers degrés de performance; habileté qui nous apparaît de première importance pour que les fonctions propres à la mesure d'interprétation critériée soient adéquatement effectuées.

Pour toutes ces raisons, nous croyons qu'il est tout-à-fait justi fié de conduire la présente étude.

pirique d'item, c'est-à-dire de la vérification à postériori d'item, sous l'aspect précis de la faculté qu'ont ces derniers de discriminer parmi di vers niveaux de compétence.

Nous nous en tenons donc à l'indice de discrimination entre perfor mance (ou sensitivité) en prenant pour acquis que les item utilisés ont déjà subi, en révision logique, l'épreuve de la vérification de la congruen ce avec l'objectif auquel ils se rattachent, et qu'ils sont adéquatement formulés. Quant à l'indice de difficulté, nous ne 1'écartons pas puisqu'il est conceptuellement lié à l'indice de discrimination entre performance.

Il va sans dire que l'aspect normatif de la mesure n'est pas touché: nous nous en tenons à la mesure d'interprétation critériée tel que l'exige l'objet même du concept de base sur lequel repose notre étude.

Puisqu'il s'agit de support à l'enseignant, l'instrument qui sera recorrrnandé pour la révision d'item, sera adapté à son usage propre. C'est dire que notre étude écartera tout indice non approprié à une utilisation simple, rapide et efficace.

Il ne saurait être question d'une étude exhaustive portant sur l'ensemble des indices actuellement engagés dans la course, mais bien d'une analyse critique de ceux qui, étant reconnus les plus appropriés à l'usage quotidien de l'enseignant, peuvent subir avec succès l'épreuve d'une révi sion. De cette étude relativement limitée, découlera une recommandation relative au choix de l'indice de sensitivité jugé le plus apte à servir efficacement en révision enpirique d'item, rien de plus.

La revue de la littérature et le cadre théorique

1.0 La revue de la littérature

Laissant de côté les études qui touchent la révision logique (Logical Review of Test Item), nous nous bornons à mettre en relief les conclusions des recherches portant sur la révision empirique (Qnpirical Review of Test Item), c'est-à-dire la validation, à postériori, d'item en mesure d'interprétation critériée et ce, sous le seul aspect de la sensitivité.

Deux catégories de documents nous ont été utiles dans cette recher che. La première touche le concept de sensitivité et la recherche d'indi ces relatifs à cette caractéristique des item ; la seconde a trait â la com paraison d'indices.

Les auteurs dont les travaux font actuellement l'objet d'une gran de attention dans le domaine qui nous intéresse sont: Cox et Vargas (1966), Brennan (1971-72), Popham (1971), Ozenne (1971), Roudabush (1973), Kosecoff et Klein (1974), Berk (1978-80), Haladyna et Roid (1980-81-82-83)

1.1 Première partie: le concept de sensitivité

1.1.1 Cox et Vargas (1966)

Lorsque Cox et Vargas présentèrent leur indice de discrimination, il n'était pas encore clairement question de sensitivité. L'approche critériée était alors de conception nouvelle et soulevait des questions par comparaison avec l'approche normative depuis longtemps implantée.

L'apport original de ces auteurs fut de produire un indice de dis crimination entre les performances des élèves d'un groupe, le PPDI ou Pré-

Post-test Différence Index.

La proportion des élè ves qui réussissent un item au POST-TEST

MOINS

i

La proportion des élè ves qui réussissent cet item au PRETEST17

Des précisions fournies lors de la définition du problème ont déjà indiqué qu'un tel indice donne des informations non seulement sur le degré de sensitivité de l'item à l'apprentissage mais aussi sur les causes possi bles d'une situation problématique.

Il faut noter que Cox et Vargas avaient d'abord misé sur un indice dit "de différence" (A Différence Index) ou indice de discrimination qua lifié de typique en approche normative. Il s'agissait de calculer, pour chaque item, le pourcentage d'élèves situés dans les 27% plus forts sur le total du test qui réussissent l'item, moins le pourcentage de ceux qui se situent parmi les 27% plus faibles, qui réussissent également l'item.

En établissant des comparaisons entre le PPDI et cet indice de dis crimination pour deux catégories différentes d'item, les auteurs ont pu établir la consistance de l'indice PPDI avec la notion de CRM puisque, dans le cas du nouvel indice PPDI, la différence établie entre les performances est attribuable aux effets de l'enseignement.

Cox et Vargas ont aussi démontré qu'il existe un bas degré de cor rélation entre l'indice de discrimination et le PDPI utilisé en contexte critérié.

1.1.2 Brennan (1971-72)

Brennan a produit un indice jugé similaire à celui de Cox et Vargas: le pourcentage du gain possible (PPG). Cet indice présente une corrélation de 0,92 avec le PPDI de Cox et Vargas et trouve sa justification du fait que la mesure du degré de difficulté obtenu au prétest ne peut être que le gain maximum de 1,00 moins l'indice de difficulté obtenu au post-test. La for mule statistique se présente carme suit:

ppç _ difficulty (post- test) - difficulty (pretest) 1 - difficulty (pretest)

Cet indice sera explicité plus loin alors qu'une application numé rique en sera donnée.

De conception très voisine de cet indice, le "Percentage Gain Score" (PGS) de T.E. Lawson se formule selon cette équation:

Percentage Gain Score

Post-test Performance Pretest Performance ou PGS Maximum Score Possible Post-T ~ Pre-T Max Sc. - Pre-T Pretest Performance

Cet indice (PGS) repose sur le fait que toute démarche d'enseigne ment consiste à faire passer l'élève d'un état d ' incompétence (prétest) à un état de compétence (post-test). Le "Gain Scores" provient de cette dif férence, mais parce qu'il peut ne pas être exempt d'influences étrangères à l'enseignement, l'auteur ajoute des précisions à ce PGS et en fait un "Ajusted Gain Scores"; non sans avoir reconnu expérimentalement ce qui suit, au sujet du PGS:

"This percent gain score attends to, and is SENSITIVE of, differential amounts of learning between individual learners in accordance with the amount of learning toward mastery of competencies in a gain instructional products" (1972, p. 98).

1.1.3 Popham (1971)

Cox et Vargas avaient utilisé le "design" du pré et du post-test; Popham explicite cette démarche. Il identifie quatre possibilités (Item Response Pattems) qu'il insère dans le tableau déjà connu de contingence à deux dimensions (Fourfold Table). Pour un item donné, les réponses des élèves sont ainsi compilées:

- réussite au pré et au post-test (PP) ou 1,1

- réussite au prétest et échec au post-test (PF) ou 1,0 - échec au pré et au post-test (FF) ou 0,0

19

Popham introduit donc de façon formelle l'utilisation du tableau de contingence à deux dimensions. Seulement une cellule du tableau peut

strictement refléter, selon lui, le degré de la sensitivité d'un item. C'est celle du FP (Fail-Pass) ou 0,1. Les item qui sont les plus "consis tants" avec l'étiquette 0,1 sont sensibles à l'enseignement.

L'apport de Popham dans le domaine de la sensitivité se veut sur tout utile, selon le jugement de Harris (1974), en ce qui touche l'usage du tableau de contingence. C'est là une contribution qui a son importance puisque, dans la suite, la grande majorité des concepteurs et des compara teurs d'indices s'y référeront pour faciliter l'organisation des données avant de les soumettre aux traitements.

1.1.4 Ozenne (1971)

Les travaux de Gilbert Ozenne (1971) sur la sensitivité des item à l'enseignement se situent dans la continuité de ceux de Cox et Vargas

(1966). Dans l'intention d'investiguer empiriquement les caractéristiques de la sensitivité, il présente un design différent du pré-post-test jusque là utilisé par ses prédécesseurs.

«Rather than measuring the same individuals before and after instruction, one could measure two sets of persons who are similar except that one group has had the benefit of instruction while the other has not.»(p. 28).

A partir de sources multiples et variées, et en utilisant des données simulées et réelles, Ozenne fournit un ensemble d'informations utiles pour la validation de tests et pour la mesure de l'impact de séquences d'ensei gnement.

Parce qu'encore trop près de l'approche traditionnelle (il y a utili sation de l'analyse de la variance dans l'estimation de la sensitivité), les travaux d'Ozenne ne nous furent signifiants que du point de vue de ces énoncés de base qui concluent sa recherche, entre autres:

"Dans une mesure critériée, plus le test s'approche de sa forme idéale, plus il doit être sensible aux effets de l'enseignement". (1971, p. 94).

"Le concept de sensitivité est inséparable des effets de l'enseignement". (1971, p. 88 et 94).

1.1.5 Roudabush (1973)

A partir des "Item Response Pattems", de l'usage du tableau de

contingence suggéré par Pqpham (1970) et des travaux de Marks et Noll (1967), Roudabush (1973) présente des procédés de correction aptes à minimiser l'in fluence du choix au hasard. Il en arrive ainsi à produire un nouvel indice de sensitivité qui tient compte de la proportion d'élèves qui ont manqué l'item au prétest et qui l'ont réussi au post-test, de même que de la cor rection à appliquer pour le choix au hasard. D'où la formule suivante:

TG T = _ Ç _ - _ J _______ N B + D où B B + D et où C N

égale la correction ou indice de proba bilité que l'élève a de choisir au hasard égale la proportion des élèves qui ont manqué l'item au prétest et l'ont réus

si au post-test.

B C

En soustrayant ~'B~ +' p~ de — la correction s'effectue.

Les études qu'a menées Roudabush sur plus de 1 500 items fournissent un grand nombre d'informations relatives à la signification des valeurs is sues de l'application d'indices; et ce, par rapport aux données inscrites à divers patrons de réponses et par rapport au moment où intervient l'éva luation .

C'est ainsi que l'auteur a pu relativiser les procédures plutôt stric tes de l'application du DESIGN "pré et post-test". Il a également adapté les procédures à une discipline (langue) où le contrôle des connaissances acquises préalablement à l'enseignement formel ou parallèlement à cet ensei gnement s'avère difficile et complexe.

21

En général, ces études de Roudabush confirment une fois de plus que l'indice de sensitivité est un critère majeur pour la révision d'item en CRM parce qu'il conduit à des choix différents de ceux qui sont ordinaire ment faits en NRM (1973, p. 11).

1.1.6 Kosecoff et Klein (1974)

Kosecoff et Klein se sont appuyés sur le concept de sensitivité ap pliqué par Cox et Vargas pour proposer deux nouveaux indices qui se veu

lent également distincts de l'indice traditionnel de discrimination’, ce sont: the "Internal Sensitivity Index" (ISI) et the "External Sensitivity Index" (ESI).

Le premier ISI mesure la sensitivité d'un item à l'intérieur du con texte global du test; le second ESI mesure cette sensitivité indépendamment du test total, fournissant ainsi une estimation de la capacité de chaque item à réfléter l'enseignement reçu.

Ces auteurs utilisent quatre différents "Design" pour déboucher sur les conclusions suivantes: ISI présente à peu près les mêmes caractéris -tiques que d'autres indices de discrimination reliés à l'approche tradition nelle. Cependant, lorsque pour un item donné, il se rencontre un grand nom bre de "réussites" au prétest, l'application d'une forme d'ISI s'avère utile voire nécessaire pour démontrer la sensitivité de l'item.

Quant à l'indice ESI, il n'apparaît pas suffisamnent stable pour don ner une mesure relativement juste de la sensitivité.

1.1.7 Berk (1978-1980)

Berk se présente comme un innovateur en procédures de révision d'item pour le critérié. Désirant situer nettement l'action en salle de classe,

il s'exprime ainsi:

"One reason for the prominence of this issue is the fact that many criterion-referenced tests are cons tructed by teachers, people not necessarily sophis ticated regarding psychometric principles and proce dures"! (1978, p. 1)

Jusqu'ici aucun chercheur n'avait mis à ce point l'accent sur la re cherche d'indices répondant aux critères de simplicité et de facilité d'ap plication et d'interprétation, bien que tous reconnaissaient la pertinence, dans un processus de développement d'item en CRM, de la sensitivité des item à l'enseignement.

En regard de ces critères, Berk (1980) a analysé et comparé au total 19 indices. Nous ferons état du résultat de ces comparaisons dans les pages qui suivent.

1.1.8 Haladyna et Roid (1981, 1982, 1983)

Ces auteurs présentent le concept de sensitivité dans la même ligne de pensée que leurs prédécesseurs. Ils sont cependant les premiers à met tre l'accent sur le contexte requis pour 1'enseignement quand il s'agit de la recherche du degré de sensitivité des item .

Ces auteurs affirment en effet que parmi les théories d'apprentissa ge actuellement en cours, il en est une qui se présente cornme particulière ment appropriée en CRM pour la révision empirique d'item, c'est l'approche

systématique (Systematic Instruction), (cf. définition de concepts p. 10).

/près avoir analysé les six formes principales reconnues à cette ap proche, ces auteurs affirment que:

1) la précision de l'objectif à atteindre,

2) le choix judicieux des moyens à utiliser pour y arriver, 3) la congruence entre l'objectif et l'item qui le mesure bref,

que l'exigence nouvelle de précision rattachée à la CRM est essentielle à la recherche du degré de sensitivité de l'item.

Depuis que ces auteurs ont décrit avec une remarquable précision le rôle de la sensitivité dans un processus de révision empirique d'item, il semble désormais clairement établi que le concept de sensitivité revêt une très grande importance dans le processus de révision d'item en CRM. Et ce, dû au fait qu'en CRM, la sensitivité des item à l'enseignement

offre jusqu'ici la meilleure alternative de remplacement du tradition nel indice de discrimination utilisé en contexte normatif (Haladyna et Roid, 1981, p. 222, 1983, p. 35).

1.1.9 Racine et Larose (1982)

La documentation de langue française comprend fort peu d'auteurs qui jusqu'ici ont produit des articles sur la sensitivité. Serge

Racine et R. Larose nous paraissent être les seuls qui, au Québec, s'y soient appliqués. Dans un article publié par l'ASME en 1982, ces au teurs analysent et interprètent la sensitivité 5 partir de l'observa tion de patrons de réponses inscrits 3 des tableaux de contingence 3 deux dimensions. Après avoir identifié cinq situations 3 l'intérieur desquelles peuvent se situer les élèves par rapport 3 leurs acquis:

SITUATION SCORE % INFORMATION SUPPLEMENTAIRE

Incertitude 0-40 non motivé et/ou incapable

Problème 0-40 motivé et capable

TSche 40-80 apprentissage incomplet

Compétence 90-100 apprentissage complété Performance 80-100 motivé 3 dépasser la tctche

(1982, p. 131)

les auteurs affirment que c'est lors des situations d'incertitude et de problèmes divers qu'il faut chercher les causes du manque de sensitivité des item (ou des tests) 3 l'enseignement/apprentissage.

Les auteurs ajoutent que les causes explicatives d'un manque de sensitivité peuvent se retrouver au niveau de la tâche elle-même comme au niveau de l'individu et de l'enseignement; elles peuvent être multi ples et souvent complexes.

La contribution de S. Racine et de R. Larose au domaine de la sen sitivité nous paraît intéressante en particulier du point de vue de l'in terprétation qu'ils proposent pour les faibles valeurs de sensitivité at tribuées aux item.

Plusieurs indices de discrimination furent comparés à des indices de sensitivité par des auteurs tels que Hsu (1971), Popham (1971), Helmstadter

(1972), Haladyna (1974), Haladyna et Roid (1976, 1981), Wedman (1973), Henrysson et Wedman (1974) et Moyer (1977). Nous ne nous arrêterons ici qu'aux comparaisons effectuées entre divers indices applicables en mesure d 'interprétation critériée.

Parmi les auteurs qui ont comparé de façon particulièrement signi ficative des indices de sensitivité, il s'en rencontre quatre dont les

travaux sont d'un grand intérêt pour notre recherche. Ce sont: Crehan (1974), Herbig (1976), Haladyna (1978) et Berk (1980).

Compte tenu des "combinaisons" possibles d'indices, il se rencontre un nombre impressionnant de 42 indices qui, comparés entre eux, ont permis de déterminer:

1) le bas niveau de corrélation qui existe entre eux et les indi ces traditionnels de discrimination utilisés en NRM; ^

2) les hauts niveaux de corrélation qui existent entre les indi ces utilisés en CRM.

Nous nous limitons à ces quatre importantes analyses comparatives: AUTEURS NOMBRE D'INDICES COMPARES

Crehan (1974) 6

Herbig (1976) 6

Haladyna et Roid (1978) 17

Berk (1980) 19

A noter que le nombre total d'indices comparés passe de 48 à quel que 38 si l'on tient compte du fait des "combinaisons" possibles et que certains d'entre eux sont touchés plus d'une fois. C'est ainsi que, par exemple, l'indice de Cox et Vargas (1966) fait l'objet des analyses des quatre auteurs-comparateurs et que l'indice de Brennan (1972) fait l'ob jet des analyses de trois de ces mêmes auteurs.

1.2 Deuxième partie : la comparaison d'indices

25

Les conclusions de ces études nous ont permis non seulement d'éta blir les perspectives de notre recherche mais aussi de déterminer les critères à utiliser dans le choix d'indices de sensitivité les plus appro priés en CRM.

Considérées séparément, ces quatre importantes études comparatives nous ont servi à qualifier, un à un, quelque 30 indices, de sorte qu'il nous a été possible d'effectuer une première élimination réservant à la se conde et dernière élimination l'utilisation de critères plus "fins".

Les indices qui ont été rejetés dans une première élimination sont ceux à qui ont été reconnus des limitations ou des lacunes qui les rendent

inaptes à être utilisés aux fins de notre étude, c'est-à-dire 1- ceux qui sont propres à la NRM;

2- ceux qui sont de conception et d'application complexes; 3- ceux qui ne sont pas manuellement calculables.

Les critères de la seconde élimination, dont la plupart ont déjà déjà été, à l'occasion, formulés au cours de ces textes, se présentent com me suit:

Les indices doivent

1- viser la validité d'item en CRM;

2- être simples et faciles d'application; 3- être faciles d'interprétation;

4- être utiles et signifiants pour l'enseignant en exercice.

Cette double élimination a considérablement réduit le nombre d'in dices qui seront appliqués au cours de notre étude. Voici quels sont les indices retenus:

1- de Cox et Vargas (1966-1969-1974) ... PPDI* 2- de Brennan (1971) ... PPG

* Pour la signification de ces sigles, bien vouloir se référer aux ta bleaux des pages 27 à 33.

3 - d'Harris (1974) ... 4 - de Roudabush (1973) ... 5 - de Kosecoff et Klein (1974) PPC NGI IGI

Des quatre études comparatives que nous avons analysées, celle de Berk (1981) nous a été particulièrement utile. C'est ainsi que nous avons

pu établir, dès le départ, les comparaisons suivantes:

Parmi les indices appliqués en situation de pré-post tests, celui de Cox et Vargas (1966) apparaît le plus simple, et celui de Kosecoff et Klein (1974) le plus sensible aux gains individuels. Ce dernier semble re quérir plus d'informations et cortprend une étendue de valeurs possibles plus vaste que dans le cas de l'indice de Roudabush (1973).

L'indice de Kosecoff et Klein est statistiquement plus sensible que ne l'est celui de Cox et Vargas parce qu'il tient compte du gain individuel plutôt que du gain total.

Cette dernière affirmation critique au sujet de PPDI est relati vement nouvelle. Nous nous demandons si elle ne risque pas de compromet tre l'acceptation sans réserve attribuée jusqu'ici à l'indice de Cox et

Les tableaux des pages 27 à 33 présentent une brève description de chacun des cinq indices retenus. Caractéristiques générales, avantages et désavantages y sont précisés pour chacun d'eux. Nous y avons ajouté une application traduisant numériquement les données littérales fournies par les auteurs.

27

Tableau 3

Auteurs: Cox et Vargas, 1966-1969 et 1974

Pré-test and Post-test Discrimination Index (PPDI) (A + C) (C+D) (A+C+B+D) “ (A+C+B+C) w u M g M 4-1 en 0) -P 'CD eu Post-test 1 0 0 A B 1 C D

La proportion des élèves qui réussissent un item au Post-test

MOINS

la proportion des élèves qui réussissent cet item au Prétest c'est le "raw gain"

-C = n. d'élèves qui ont réussi l'item au pré te au post-test (1,1)

D = n. d'élèves qui ont réussi l'item au pré et échoué aupost-test (1,0)

A = n. d'élèves qui ont échoué l'item au pré et réussi au post-test (0,1) B = n. d'élèves qui ont échoué au pré

et aupost-tests (0,0)

- L'étendue s'étend de -1 à +1

- Les auteurs cherchent à vérifier le degré de discrimination en d'item auprès de groupes en situation de pré et de post-tests. ^ Leur approche en CRM s'enrichit du fait qu'ils utilisent aussi

l'approche du "upper-lower 27%", pour déterminer si les item <f) qui discriminent bien entre les performances des élèves forts g et des élèves faibles sont aussi discriminatifs entre les grou-E-i pes avant et après l'enseignement. Ce qui leur permet aussi < d'identifier les item qui sont les plus utiles pour le dia-< gnostic en situation de pré-test.

- Pour Ozenne, la sélection d'item au moyen de cet indice devient plus "consistante" quand la maximisation de la "sensitivité" a été préalablement reconnue.

C'est la plus connu jusqu'ici et le plus utilisé des indices en ^ CRM. Il est simple de conception, d'application et d 'interpréta is tion. Tel que décrit ci-dessus, il se présente, pour l'enseignant fc comme un moyen facile, expéditif et signifiant pour la validation gi d'item lors de vérification d'item ou de simple sélection à l'in-< térieur d 'un "pool".

> in < w Q E-i

L'indice n'est pas sensible aux changements qui surviennent dans les performances individuelles il ne l'est qu'au gain (ou à la perte) d 'un groupe.

Application à partir de données simulées: Post-test +j en

eu

-P '0) eu 1 0 1 5 3 0 50 10 55 13 8 60 68Résultats obtenus par 68 élèves aux pré et post-tests pour un item: si A = 5, B = 3 C = 50, D = 10 PPDI = (A + C) - (A + B) A + B + C + D 5 5 - 8 68 = 0,69 Remarque:

Nous avons dû adapter la disposition du tableau de contingence pour faciliter la comparaison entre indices. C'est ainsi que le tableau a) est devenu le tableau b ) . La seule modification apportée touche la première colonne de droite où 0-1 (échec-réus

site) est remplacée par 1-0 (réussite-échec).

a) Post-test 4-1 t/l QJ 4-> 'CU ^4 eu b) Pcst-test 1 0 0 A B 1 C D devient 1 0 1 A B 0 C . D

29

Tableau 4

Auteur: Harris (1974)

Index of effectiveness for criterion-referenced item used in pre et post -tests

(PPC)

E + G

(E + F) + (G + H) ou C + D

Le narbre d'élèves qui ont enregistré un gain (au post test)

SUR

le nombre d'élèves qui se sont abstenus de répondre à l'item au prétest .(sans quoi ils y au

raient répondu incorrectement)

H u M 4J o U) 01 M -p '0) ^4 eu 4-1 cn <u 4-> '(D ^4 eu Post-test 1 0 1 A B 0 et aOs • C D Post--test 1 0 1 A B abs. > E * F 1 0 G 'h ! E: G: E+G(=€)

n. d'élèves qui se sont abstenus de répondre à l'i tem au prétest et qui l'ont réussi au post-test.

n. d'élèves qui ont échoué au prétest et réussi au post test.

n. d 'élèves qui ont enregis tré un GAIN à l'item.

F: n. d'élèves qui se sont abs tenus au prétest et qui ont échoué au post-test.

E+F: n. d'élèves qui se sont abs tenus de répondre au prétest

quel que soit leur résultat au post-test (échec ou réus site)

Harris utilise un tableau de contingence 2x3. Les fréquences A et B ne sont pas considérées dans les calculs. E et H résul- £3 tent de la subdivision de C et D en abstentions et échecs.

D _

g 0> L'auteur part du principe que l'eleve qui s'abstient de repondre ^ ^ ou qui répond incorrectement au prétest, à un item donné, de-“ M vrait répondre correctement au post-test qui suit l'enseignement.

De ce point de vue, un item considéré "parfait" en cotation éga lerait 1/1. Harris établit des limites à ce ratio théorique 1/1 qui a peu de chance de se rencontrer en situation pratique concrète. Il fixe ces limites à 0.75 et 1.5.

De plus, l'auteur considère que l'élève suit sans faute la con signe de s'abstenir en cas d'ignorance ou de doute. Il croit aussi exclure, au départ, le risque du choix au hasard.

en H <c

En CRM, les gains par item sont plus utiles que les gains sur le total des item ; or cet indice tient compte de cette exi gence .

Cet indice peut s'appliquer sur de petits échantillons. L'interprétation des valeurs excédant 1,5 et n'atteignant pas 0,75 ne présente aucune difficulté.

Cet indice permet d'intégrer dans les calculs les cas

d'abstention. En l'absence de ces derniers, l'indice devient:

% C + D

Le traitement statistique est très simple.

Des études ont reconnu la supériorité de cet indice sur plusieurs autres, du point de vue de son utilité lorsqu'il est évident que la contamination de l'effet du choix au ha sard n'a pas joué.

- Les limites (inférieure et supérieure) respectivarient fixées co à 0,75 et 1,5 sont arbitraires,

w

- L'application des limites fixées peut entraîner l'élimination z - d'item discriminants entre performances.

<(j - Le danger de deviner n'est pas totalement ecarte bien que Har n s w considère que la consigne doit être suivie par tous obligatoirement.

Application à partir de données simulées: Post-test -p co

eu

+> XQJ U eu 1 0 1 5 3 afcs.c 40 00 4-1 0 i l0g 2 h) fD PPC = E + G (E + F) + (G + H) 40 + 10 50 ou (48) + (12) 60 C + D 0,8331 läbleau 5 Auteur: Brennan (1971) w u M Index du pourcentage du gain maximum possible

(PPG)

Diff. (post-test) - Diff (prétest) 1 - Diff. (prétest)

Le pourcentage des élèves qui ont réussi l'item au post-test

MOINS

le pourcentage des élèves qui ont réussi l'item au prétest

SUR

un (1) moins le pourcenta ge d'élèves qui ont réussi l'item au pré-test.

Extension du PPDI de Cox et Vargas et en très haute corréla tion avec lui (0,93).

¡4 w Sensiblement les mêmes avantages que le PPDI de Cox et § § Vargas

< < Eh

I

^ w La valeur et l'interprétation diffèrent, selon Berk, de la plu-^ § part des autres indices de discrimination,

w < W Eh

Application à partir des données réelles - cf. l'item 1 du test tel que répondu pour le groupe 03.

■p tfl

tu

-p eu PPG = A + C N A + B N Post--test 1 0 1 13 2 15 0 15 2 17 28 32 1 - A + B N PPG = 28 32 15 32 i - 15 32 = 0,88 - 0,47 = 0,41 = o 77 1 - 0,47 0,53Auteur : Roudabush (1973)

Individual gain Index (IGI)

La proportion d'élèves qui ont ré pondu incorrectement à l'item au prétest et correctement au post test, après qu'une correction ait été appliquée. B w u N B + D TABLEAU I: Post-test 4J U) CD ■P

v<D

CU 1 0 1 A B 0 C DN.B. B formule suggeree pour B + D la correction de la pro

babilité de choisir au hasard; donnée à sous traire de C.

N

C = n. d'élèves qui ont répondu in correctement au prétest mais cor rectement au post-test

N = A+B+C+D = ou total d'élèves qui ont répondu à l'item.

en

- Cet indice est axé sur le gain individuel; ce qui lui donne S une valeur certaine en CRM.

en

M - Une correction pour contrer l'effet du choix au hasard est suggérée (Marks et Noll, 1967).

- L'étendue va de -1 à +1 avec la correction, et de 0 à +1 sans correction.

ë en <2 H > u <

- Simple et facile de conception, d'application et d'interpré tation. (Cf. Item - Selection for Criterion-Referenced Tests, Roubabush, 1973).

I

g en M %Les suggestions relatives à la correction du choix au hasard sent remises en question particulièrement par Berk.

Application à partir de données simulées: Post-test IGI = -S '<U M eu 1 0 1 5 3 8 0 50 10 60 55 13 68 50 5+3+50+10

3+10

= .73 - .23 = .50

50 6813

33

Tableau 7

Auteurs: Kosecoff et Klein (1974)

Net Gain Index (NGI)

C D A + B + C + D A + B + C + D TABLEAU I: Post-test 1 0 -p en (U 1 A B -P '0 Vh eu 0 C D

Extension du IGI de Roudabush Individual Gain Idex

MOINS

la proportion des élèves qui ont répondu incorrectement à l'item dans les deux occasions de pré et de post-tests.

C = n. d'élèves qui ont répondu incorrectement au prétest mais correctement au post-test.

D = n. d'élèves qui ont répondu in correctement au pré et au post- tests . 03 8H £ H 05

- Cet indice considère les gains/pertes individuels corme un résul tat de l'enseignement. Il est plus axé sur le conservatisme que les quatre précédents indices.

- Il propose, à titre optionnel, un correctif pour réduire l'effet du choix au hasard.

- L'étendue va de -1 à +1 avec ou sans correction.

Cet indice peut être considéré de conception, d'application et d'interprétation simples et faciles quoiqu'à un degré relativement moindre que les quatre indices précédents.

Les corrections relatives au choix au hasard suscitent certaines in- 53 terrogations de la part des critiques.

8

Application à partir de données simulées: Post-test U) QJ -P '(1) S-l Pu 1 0 1 5 3 0 50 10 55 13 8 60 68 NGI = 50 5+3+50+10 50 68 10 68