HAL Id: tel-01485292

https://hal.archives-ouvertes.fr/tel-01485292v2

Submitted on 17 Jun 2017HAL is a multi-disciplinary open access archive for the deposit and dissemination of sci-entific research documents, whether they are pub-lished or not. The documents may come from teaching and research institutions in France or abroad, or from public or private research centers.

L’archive ouverte pluridisciplinaire HAL, est destinée au dépôt et à la diffusion de documents scientifiques de niveau recherche, publiés ou non, émanant des établissements d’enseignement et de recherche français ou étrangers, des laboratoires publics ou privés.

Isabelle Leang

To cite this version:

Isabelle Leang. Fusion en ligne d’algorithmes de suivi visuel d’objet. Intelligence artificielle [cs.AI]. Université Pierre et Marie Curie - Paris VI, 2016. Français. �NNT : 2016PA066486�. �tel-01485292v2�

��������������������

�������� �����������������������������������������

� ��������

���������� �������� ������������������������ ��������

���� ������������

����������������������������������������

�� ���� ���������������������� �������!"�� �� ����#$!%

����������&��'��� ��� ����(�

������)*++*,�

�#*�-��.��,

/���������

��������/0�1,��

2*��,3���-���������� �2��������,����

/���������

.��������40��

+*�%-���������� ����������������������

�5� �������

������6���/�7

* ��������������+��-������������

�5� �������

8��������/0�+�7

*�*/-���������� ����������������������

������������������

�� ������4�/1*.

��*�-�0.�/,

���������

1���9��2*/,/�

*�*/-���������� ����������������������

���������

��������

� ����������� ������� �� ����� �������������� ����� �� ���������������������� ������������������� ��� ����� �������������������� �������������� ���� ��������� ���������� ��� �������������� �� ���!���� �" ���� �� ��������� ����� �� ���������� �� �������� ������ ��#��$���� ������� �� ��������� ��������� � ������������������ ����������� ��� ��������� "������ �� �������� ��� ����� � ��� �� �� ������� �� ��� �������� �� ������� ��� �� ���������������� �� ����������������������������"������������"����� � �� ������ �� �������"�����$ � �������� ���� ����� ������ �� �� ����� � ����� ������ ������������ ������������� �� ��� �����$������ ��� ������" %�����& ���'"� ����� ��������� ��������$� ��� �������� ����$� ������� ��� �� �������� ��$������� � ��� �� � ���!� � � � ������ � ������� � � � �������� � � ��� ������ � � � � � ����& �� � � ������ � ��������� ��� � � � ��� ��������� � ��"� ������� ��� ��������� �� �� �� �������$ ����������������� ����$� �� ������ ������������� ���� �������� ������������������ �� ���� �������(���� ���������� �������������� ������������� � ������ ��� �������!� "����������� �� �)*������$���������� ��������������� ���+����� ������,���� ��� ����� �"������� ������� ������ �� ������ ����������������������������� ���� ������� �������� �������� ����������� � �� � �� � ������ �� � � � ������- � �� � ���� ����� � � � ��� � � ���� � �� � ��������� � � �� �����������������-���� ��������������$ ���� ������� ������ ��������� �� �����& ���������� ����� �� ��� � �������� ������$�� ��������$���������� �-���������� �� �� �������������� ��������� �� �����& �� ���������� � ����� ��� �������������� "�� ������ �� ��� ���� ������ ������������������ �����& �� ������ � �������� �� ������������������ #��������������������� ������� ��-������� �� �� �������-�������� ��������� ������& ���-������������� ����� �-�����������������������-����� ������� ������ ����� ������������������� ������������������ ��������

.��������

/��������� �� �����&��$ ��� ��� � � � ����������������� ������� � ������������ ���� �� � ��� ����� �� ��� ��� ���������� ���0������� ����� ������ ������ ����������������� ��� ���������� ��� ���� ����� ������ �� �� ���� ������������� ����$ ��� ��$�����& ���0 ���� ��� ���� ������������� �������� ������� ��� ����� ��������� ��������� ��� ���"���� ����� ������������ ������ �������������� �������� �������� ����� ������������� ��������������������������������������"����������"����� ����� � ��������� ��" ����$ ������� ���� 1� ���� ���� � �� ����� ��� ���� �� ���� ������ ��� � ����� � ������� ��� ��� � � ���� ����&��$ ���$�������� �� � � �����$���2��� ������������� $� �������� ������������$��� ��$ � ���������1� ������� �������������� ������������� � ����$��� �����& ����������������������$��������������$"���������$��� �������������� ���� ����$��� ���3�2��� ��������� ��������4�������� �������& �� � � �������� �� � ������� �������� 5 � ��� � � ����� � �� � ������ � � ��� � ��� � �� � � �� � �� � �����" � $����$ � ��� � �� � )* � ������� � ������ �����$��������� � 6������ � � �� � , � ������� �" � �� � ����� � ��$���$�� � � � � ��� � & � � ������$�� � �� ���� � � ������$� ����������� ��������� ��-�1� ����� ������������ ���� �������� ����������� ������ ������� � � �����"���&��$��������$��� � ���� ����� ��������7�����-�8�������� ��������$ ������������� �������� ���� � � �� � ����� � ����� � ����& �� � 4��� � ����$ � ��� � � �������� � � ���� � � � ���$ � ���� �- � 1� ������� ���������������������������� ���������& ���������� ��� ������� �������� � � ���� ���� "�4���� ��& ������������ ����� � ����� ����������� ��������������������& ��������$�� ������������������ ��� 9 �4����� � ������ � ��� �� � ����&��$- � ����&��$ � ������� ��- � ����& � � ����� � �������- � ����� � �� �������-������������������-���� ������ ������Je voudrais remercier un certain nombre de personnes sans qui cette thèse n’aurait pas été possible. Merci à Philippe Bidaud qui a eu l’idée de cette collaboration entre l’ISIR et l’ONERA, à Stéphane Herbin et à Benoît Girard qui ont monté ce projet de recherche, et à Jacques Droulez qui en a accepté la direction.

Merci à Stéphane, Benoît et Jacques de m’avoir accompagnée, conseillée et encouragée tout au long de ces trois années. Merci pour nos nombreuses discussions à l’ONERA et à l’ISIR.

Stéphane, merci de m’avoir transmis ton expérience et ton savoir, tu n’étais jamais à court d’idées et ton habileté à trouver les mots justes pour les exprimer m’a toujours impressionnée.

Benoît, merci pour ton enthousiasme, ta spontanéité et ton optimisme, qui m’ont toujours encouragée à continuer à aller de l’avant.

Jacques, merci pour ton expérience, ta sagesse et ton humilité, tes remarques étaient toujours très pertinentes.

Il y a encore tellement de choses pour lesquelles je voudrais vous remercier mais les mots ne suffiront pas à vous exprimer toute ma gratitude. Je n’oublierai pas ce que vous m’avez appris. J’aimerais vous dire que vous formez un trio complémentaire, à l’image de mes tracteurs :)

Je voudrais également remercier les membres du jury : un grand merci à David Filliat et à Michèle Rombaut d’avoir accepté, l’examen minutieux de ma thèse, à Patrick Pérez d’avoir accepté de faire partie de mon jury malgré son emploi du temps très chargé, et enfin, à Nicolas Thome d’avoir présidé ma soutenance.

Je voudrais remercier tout le laboratoire ISIR pour son accueil, Michèle Vié et Ludovic Billard pour leur aide logistique.

Un grand merci à tout le département DTIM de l’ONERA pour son accueil et pour la bonne ambiance qui règne dans les couloirs : Alain Michel, Gilles Foulon, Patrick Secchi, Fabrice Savignol, Françoise Pradines, Elise Koeniguer, Fabrice Janez, Alexandre Alakian, Adrien Chan-Hon-Tong, Alexandre Boulch, Benjamin Pannetier, Julien Moras, Robin Doumerc, Martial Sanfourche, Alexandre Eudes, Anthelme Bernard-Brunel, Guy Le Besnerais, Frédéric Champagnat, Aurélien Plyer, Kaouthar Benameur, Valentina Dragos, Eric Glemet, Olivier Poirel, Jerôme Besombes,

Bertrand Le Saux, Annie Bastière, Pauline Trouvé, Philippe Cornic, Christian Musso, Jean Dezert. Merci pour toutes ces belles rencontres et ces échanges, je ne vous oublierai pas.

Merci à tous les doctorants du DTIM pour toutes ces pauses conviviales et pour tous ces bons moments : Thibaut Castings, Oana Alexandra Ciobanu, Cédric Le Barz, Hicham Randrianarivo, Flora Weissgerber, Maxime Derome, Hélène Roggeman, Calum Burns, Joris Guerry, Guillaume Brigot, David Caruso, Nicolas Audebert, Maxime Bucher, David Schwartz, Florent Bonnier, Maxime Ferrera, Marcela Carvalho. Je n’oublie pas les apprentis : Sémi Mechaab, Elyse Cordeau. Ainsi que les stagiaires : Thierry Dumas, Jonathan Lardy, Adrien Lagrange, Manuel Tanguy, Oriane Simeoni, Martin Touzot.

Je remercie tout particulièrement mes co-bureaux, Thibaut, Maxime D. et Hicham, pour vos blagues et vos encouragements.

J’ai apprécié chacun d’entre vous et vous souhaite le meilleur. Pardon à tous ceux que j’ai oublié de citer.

Merci à David Picard et à Thomas Tang de m’avoir donné l’opportunité d’encadrer les TP à l’ENSEA, ce fut très enrichissant.

Matthieu, mon petit fiancé, merci d’avoir été là dans les moments difficiles, tu m’as donné le courage d’aller jusqu’au bout, merci pour ta joie et ta bonne humeur qui m’ont accompagnée chaque jour. Papa, Maman, Tatou et Margue, merci pour votre soutien inconditionnel ! Vous avez été formidables.

Introduction 13

1 Bibliographie 17

1.1 Le suivi d’objet . . . 17

1.1.1 Modélisation de l’apparence de l’objet . . . 21

1.1.2 Localisation de l’objet . . . 26

1.1.3 Mise à jour du modèle d’apparence . . . 28

1.1.4 Évaluation qualitative des approches . . . 32

1.2 Évaluation des trackers . . . 35

1.2.1 Bases de vidéos pour le suivi d’objet . . . 35

1.2.2 Métriques de performance . . . 39

1.2.3 Le benchmark VOT [Kristan et al., 2013] . . . . 42

1.3 Fusion en suivi d’objet . . . 45

1.3.1 Architectures de fusion, généralités . . . 46

1.3.2 Fusion de modèles . . . 49

1.3.3 Fusion de modules . . . 52

1.3.4 Conclusion . . . 55

2 Matériel et Méthodes 59 2.1 Méthodologie d’évaluation des trackers . . . 59

2.1.1 Bases d’évaluation . . . 60

2.1.2 Métriques de performance . . . 62

2.1.3 Protocole d’évaluation . . . 62

2.2 Répertoire de trackers . . . 65

2.2.1 NCC (Normalized Cross Correlation) [Lewis, 1995] . . . 65

2.2.2 KLT (Kanade Lucas Tomasi Tracker) [Kalal et al., 2012] . . . . 66

2.2.3 CT (Compressive Tracking) [Zhang et al., 2012] . . . . 67

2.2.4 STRUCK (Structured Output Tracking with Kernels) [Hare et al., 2011] . 69 2.2.5 Tracker basé DPM (Deformable Part Models) [Felzenszwalb et al., 2010, Kalman, 1960] . . . 71

2.2.6 DSST (Discriminative Scale Space Tracker) [Danelljan et al., 2014] . . . . 73

2.2.7 MS (Meanshift) [Bradski, 1998] . . . 75

2.2.8 ASMS (Adaptive Scale mean-shift) [Vojir et al., 2014] . . . . 75

2.3 Développement de la plateforme C++ de fusion de trackers . . . 76

2.3.1 Intégration des trackers . . . 76

2.3.2 Entrées/Sorties, paramètres de fusion . . . 80

3 Étude de la complémentarité des trackers 85 3.1 Complémentarité de conception . . . 85

3.2 Mesure des performances . . . 90

3.2.1 Performances globales . . . 90

3.2.2 Performances locales . . . 92

3.3 Étude des instants de dérive des trackers . . . 93

3.3.1 Instants de dérive . . . 93

3.3.2 Simuler une piste de suivi reconstituée . . . 96

3.3.3 Proposition d’une métrique pour mesurer la complémentarité d’un ensemble de trackers . . . 96

3.4 Discussion et travaux futurs . . . 103

3.5 Conclusion . . . 104

4 Prédiction en ligne des dérives des trackers 105 4.1 Indicateurs de bon comportement . . . 106

4.1.1 Score de confiance . . . 107

4.1.2 Carte de scores . . . 109

4.1.3 Autres indicateurs spécifiques . . . 110

4.2 Prédiction en ligne des dérives par apprentissage des indicateurs de comportement (BI) . . . 115

4.2.1 Estimation des seuils des indicateurs de comportement . . . 115

4.2.2 Apprentissage SVM . . . 116

4.2.3 Fusion de trackers par mélange d’experts à partir des indicateurs de com-portement . . . 116

4.3 Prédiction en ligne des dérives par une analyse de la distribution spatiale des boîtes englobantes . . . 117

4.3.1 Filtrage temporel de boîtes (BF) . . . 118

4.3.2 Consensus de boîtes (BC) . . . 118

4.4 Évaluation des prédicteurs de dérives par apprentissage des indicateurs de com-portement . . . 119

4.4.1 Recherche des indicateurs de comportement . . . 119

4.4.2 Estimation des seuils des indicateurs . . . 128

4.4.4 Fusion de trackers par mélange d’experts . . . 134

4.5 Discussion et travaux futurs . . . 137

4.6 Conclusion . . . 137

5 Conception de mécanismes de fusion de trackers 139 5.1 Différents schémas de fusion possibles . . . 140

5.1.1 Fonctionnement général d’un tracker . . . 140

5.1.2 Fusion en boucle ouverte . . . 141

5.1.3 Fusion en boucle fermée . . . 141

5.1.4 Conclusion . . . 143

5.2 Approche de fusion proposée . . . 144

5.2.1 Schéma générique de fusion . . . 144

5.2.2 Sélection des trackers par prédiction en ligne des dérives . . . 145

5.2.3 Fusion des boîtes . . . 146

5.2.4 Correction de la position et/ou du modèle des trackers . . . 147

5.2.5 Une variété de configurations possibles de fusion . . . 148

5.3 Évaluation . . . 149

5.3.1 Évaluation des configurations de fusion . . . 149

5.3.2 Meilleure combinaison de trackers ? . . . 153

5.4 Discussion et travaux futurs . . . 171

5.5 Conclusion . . . 172

Conclusion 175

Productions Scientifiques 179

A Performances des trackers sur VOT2015 et VOT-TIR2015 181

B Incomplétude des trackers sur VOT2015 et VOT-TIR2015 185

Le suivi visuel ou visual tracking en anglais, et plus communément appelé « poursuite visuelle » en vision naturelle, est une fonction élémentaire d’analyse des signaux visuels, présente dans le système visuel humain, et des primates supérieurs. Mais cette fonction est également essentielle pour la conception des algorithmes de vision artificielle dès lors que l’on analyse des séquences vidéo, car elle assure une cohérence et une stabilité spatio-temporelle des entités d’intérêt présentes dans la scène, nécessaires à leur interprétation ou à une interaction. Ainsi, le suivi visuel a fait l’objet de nombreux travaux dans le domaine de la vision par ordinateur, et cités dans un certain nombre de revues : [Yilmaz et al., 2006, Yang et al., 2011, Salti et al., 2012, Wu et al., 2013, Li et al., 2013, Smeulders et al., 2014]. On peut distinguer deux littératures sur ce sujet : le « suivi visuel d’objet » et le « pistage multi-objets ». Le suivi visuel d’objet est une fonction élémentaire de suivi d’un seul objet, tandis que le « pistage multi-objets » se rapporte à un problème d’association de données temporelle, d’une image à la suivante, pour reconstituer les pistes des objets présents dans la scène. Ces données sont par exemple des détections issues d’un radar. Nous parlerons de VOT (Visual Object Tracking) et de MOT (Multiple Object Tracking) pour les distinguer, et nous nous intéresserons essentiellement à VOT.

VOT est une fonction élémentaire, nécessaire à un grand nombre d’applications d’interpréta-tion et d’exploitad’interpréta-tion de vidéos. C’est une brique de base utilisée par d’autres foncd’interpréta-tionnalités telles que MOT. Les algorithmes de VOT produits sont appelés trackers en anglais et c’est le terme que nous utiliserons dans la suite. Ils consistent à estimer la position d’un objet mobile dans un flux vidéo, pris par une caméra fixe ou embarquée, avec comme seules informations sa position et ses caractéristiques images à l’instant initial.

Le problème qui nous intéresse en particulier dans VOT est le phénomène de dérive. La dérive est une mauvaise estimation de la position de l’entité suivie pendant un certain intervalle temporel et qui aboutit à la perte définitive de l’entité. Elle renseigne sur la robustesse de suivi d’un tracker, définie comme étant le nombre de fois où le tracker perd la cible sur une base de vidéos. Différentes perturbations visuelles sont à l’origine des dérives telles que les changements d’apparence de l’objet, les changements d’illumination de la scène, le contraste dans l’image, les mouvements de caméra, les occultations, etc.

Les approches proposées pour répondre à ces difficultés sont nombreuses. Tous les ans, de nouvelles approches sont publiées, toujours plus performantes que les précédentes, voir les

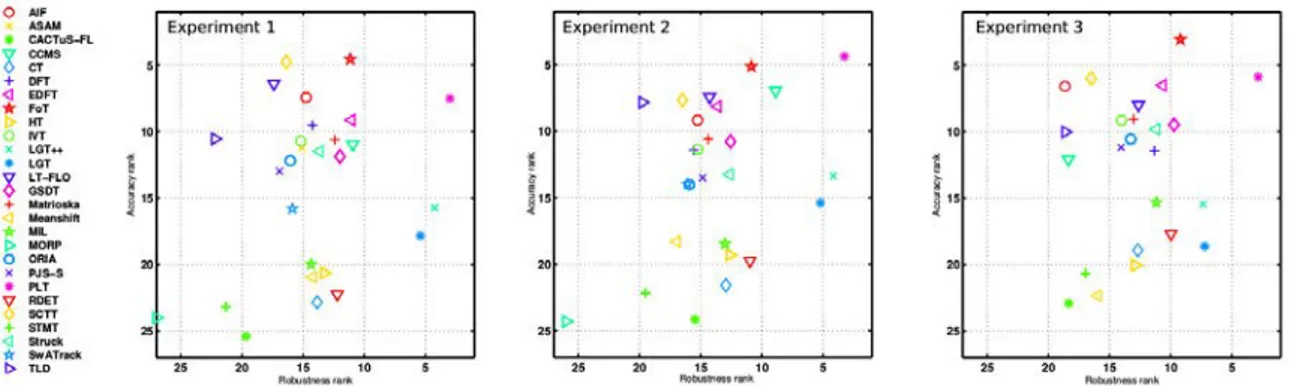

résultats des challenges VOT2013 [Kristan et al., 2013], VOT2014 [Kristan et al., 2014] et VOT2015 [Kristan et al., 2015a]. Une récente étude de [Kristan et al., 2015b] a analysé plus finement les performances des trackers du challenge VOT2014 [Kristan et al., 2014] par rapport à différents types de perturbations visuelles (illumination, occultation, mouvement de camera, forte variation d’apparence). Les principales conclusions de cette étude sont les suivantes : les trackers se spécialisent soit en précision de localisation, soit en robustesse ; aucun tracker ne surpasse tous les autres sur tous les critères de performance (précision, robustesse) et pour toutes les perturbations visuelles. Enfin, les trackers qui réussissent les mieux, sont de conception variée (représentation globale ou par parties, apprentissage discriminant, segmentation).

Étant donné les limites des trackers individuels et le nombre important de solutions proposées, une idée naturelle est d’étudier dans quelle mesure leur fusion permet d’améliorer globalement les performances de suivi. Il existe des travaux s’intéressant à la fusion en suivi d’objet mais peu se rapportent à la fusion de trackers individuels. Les quelques travaux réalisant la fusion de trackers améliorent les performances globales de suivi par rapport aux performances individuelles des trackers mais limitent le type d’objet suivi [Stenger et al., 2009], le nombre de trackers étudiés [Kalal et al., 2012, Vojir et al., 2015] ou le type de trackers [Moujtahid et al., 2015b], combinent spécifiquement les entrées et sorties des trackers [Santner et al., 2010], ou limitent les interactions possibles entre les trackers dans la chaîne de fusion [Bailer et al., 2014]. Chacun de ces travaux présente donc des limites.

C’est dans ce contexte que notre étude a été développée. L’objectif de l’étude est de proposer une fusion en ligne de trackers la plus générique possible permettant d’améliorer la robustesse du suivi : un schéma générique de fusion qui n’est pas limité par le type d’objet suivi, le type de trackers et qui autorise un certain niveau d’interaction entre les trackers dans la chaîne de fusion. L’intérêt de l’approche proposée est de pouvoir fusionner des trackers très hétérogènes en performance et en structure algorithmique. Une démarche expérimentale approfondie a permis d’identifier la meilleure stratégie de fusion parmi un large répertoire de configurations de fusion possibles. Le manuscrit est organisé comme suit :

Dans le chapitre 1, nous réalisons un état de l’art sur le suivi d’objet, afin de montrer la diversité de conception des approches développées mais aussi leur complémentarité pour résoudre un certain nombre de difficultés, incitant à développer une approche de fusion. Nous présentons les principales bases, ainsi que les métriques et protocoles d’évaluation, en particulier ceux du challenge VOT [Kristan et al., 2013] utilisés en suivi d’objet pour l’évaluation des trackers individuels. Enfin, nous proposons un état de l’art sur la fusion en suivi d’objet en distinguant la fusion de modèles de la fusion de modules.

Dans le chapitre 2, nous précisons les bases, les métriques et le protocole d’évaluation utilisés pour réaliser l’évaluation de notre système de fusion de trackers. Nous décrivons ensuite le fonctionnement de chacun des trackers du répertoire utilisé. Enfin, nous donnons quelques détails

d’implémentation sur la plateforme C++ que nous avons développée pour intégrer les trackers du répertoire et réaliser leur fusion, et pour évaluer leurs performances individuelles ou fusionnées.

La démarche a consisté dans un premier temps à démontrer l’intérêt de la fusion pour améliorer la robustesse de suivi, décrite dans le chapitre 3. Nous étudions en particulier les instants de dérives des trackers sur les séquences de la base pour révéler une complémentarité locale des comportements, et pour vérifier qu’il est possible de reconstituer une piste continue de suivi. Nous proposons une métrique mesurant la complémentarité d’un ensemble de trackers en termes de robustesse atteignable lorsqu’ils sont fusionnés. Cependant, la reconstitution d’une piste continue n’est qu’une simulation. Dans une situation réelle de fusion en ligne de trackers, les instants de dérive ne sont pas connus.

Le chapitre 4 a donc consisté à développer des méthodes d’estimation en ligne du bon fonc-tionnement d’un tracker pour pouvoir prédire ses éventuelles dérives. Plusieurs méthodes ont été étudiées : des méthodes exploitant le comportement individuel des trackers à partir d’informations intrinsèques au modèle d’apparence ou d’informations de localisation des prédictions, et des méthodes exploitant le comportement collectif des trackers à partir de la distribution spatiale des prédictions. Une évaluation des performances de prédiction de certaines de ces méthodes a pu être réalisée. Cependant, les méthodes n’étant pas intégrées dans une chaîne de fusion en ligne des trackers, l’évaluation réalisée ne permet pas de dire si ces méthodes sont performantes et améliorent la robustesse de fusion.

C’est l’objet du chapitre 5 de décrire une chaîne de fusion générique de trackers disposant d’une étape de sélection et d’une étape de correction des trackers. Les méthodes de prédiction en ligne des dérives dans la chaîne de fusion développées dans le chapitre 4, servent à sélectionner les bons trackers à fusionner à chaque instant. Des méthodes permettant de les combiner et éventuellement les corriger ont été développées. A partir de cette chaîne de fusion, nous avons expérimenté différentes stratégies de fusion pour identifier les stratégies de fusion permettant de renforcer la robustesse de suivi. L’idée est d’optimiser chaque niveau de la fusion : choisir les trackers à combiner, la méthode de sélection des trackers, la méthode de fusion des boîtes, et la méthode de correction (boucle ouverte ou fermée, mise à jour ou réinitialisation). Au total, 46 configurations de fusion ont été évaluées sur 105 séquences vidéo et ont abouti aux principales conclusions suivantes : la sélection performante des trackers améliore considérablement les performances de suivi. La correction des trackers ayant dérivé est utile lorsque la sélection est bien maîtrisée. La fusion d’un grand nombre de trackers n’est pas nécessairement une bonne stratégie mais en revanche, fusionner des trackers complémentaires et homogènes en performance apporte une meilleure robustesse.

Bibliographie

Sommaire

1.1 Le suivi d’objet . . . . 17

1.1.1 Modélisation de l’apparence de l’objet . . . 21

1.1.2 Localisation de l’objet . . . 26

1.1.3 Mise à jour du modèle d’apparence . . . 28

1.1.4 Évaluation qualitative des approches . . . 32

1.2 Évaluation des trackers . . . . 35

1.2.1 Bases de vidéos pour le suivi d’objet . . . 35

1.2.2 Métriques de performance . . . 39

1.2.3 Le benchmark VOT [Kristan et al., 2013] . . . . 42

1.3 Fusion en suivi d’objet . . . . 45

1.3.1 Architectures de fusion, généralités . . . 46

1.3.2 Fusion de modèles . . . 49

1.3.3 Fusion de modules . . . 52

1.3.4 Conclusion . . . 55 Ce chapitre a pour objectif de présenter dans un premier temps, un état de l’art sur le suivi d’objet visant à montrer la diversité des approches proposées mais aussi leur complémentarité pour résoudre un certain nombre de difficultés en suivi dans la section 1.1. Nous présenterons dans un deuxième temps, les principaux benchmarks, bases de vidéos et métriques utilisés pour évaluer les performances de trackers individuels dans la section 1.2. Enfin, nous présenterons un état de l’art sur la fusion en suivi d’objet dans la section 1.3.

1.1

Le suivi d’objet

Le suivi visuel d’objet est l’un des sujets de recherche les plus explorés en vision par ordinateur avec à la clé de nombreuses applications : sécurité, vidéo-surveillance, contrôle du trafic, production industrielle, interaction homme-machine, etc. Les thèmes de recherche vont du suivi mono-cible (Challenge VOT [Kristan et al., 2013]) au suivi multi-cibles (Workshop PETS [Ferryman et Ellis,

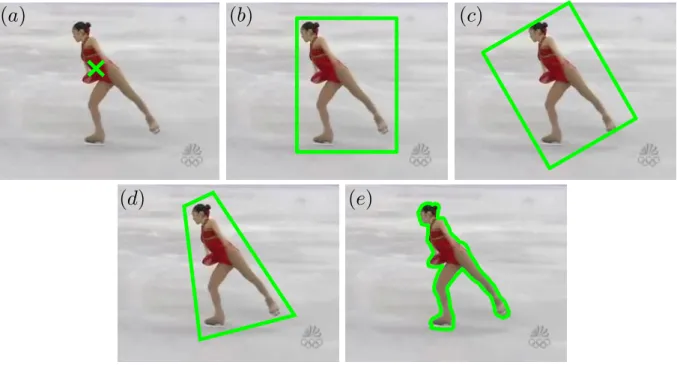

Figure 1.1 – Représentations de l’objet. (a) un point, (b) une boîte englobante rectangulaire, (c) une boîte englobante rectangulaire orientée, (d) un quadrilatère, (e) un contour.

2010], Challenge MOT [Leal-Taixé et al., 2015]), du suivi d’objets catégorisés (visages, piétons, véhicules) au suivi d’objets arbitraires, désignés manuellement par l’utilisateur. Dès lors, des avancées majeures ont contribué à améliorer le suivi sur différents aspects comme une meilleure caractérisation de l’apparence de l’objet par des caractéristiques images de meilleure capacité descriptive et, l’intégration des variations d’apparence temporelles par des modèles d’apparence plus sophistiqués inspirés des techniques d’apprentissage automatique (machine learning).

Objectif du suivi

Le suivi mono-objet consiste à estimer la position d’un objet dans une vidéo (séquence d’images successives) connaissant sa position dans la première image I0.

Il existe différentes manières de repérer la position d’un objet dans une image, comme illustrées dans la figure 1.1. La représentation la plus approximative est un point (figure 1.1a) et la plus précise est un contour (figure 1.1e). La représentation la plus fréquemment utilisée est une boîte englobante rectangulaire (figure 1.1b) car c’est une représentation minimale, et aussi parce que l’on suppose que des algorithmes de segmentation pourront l’isoler de l’arrière-plan. C’est la représentation que nous utiliserons dans la suite.

Notons ˆB0 = (x0, y0, w0, h0) la boîte englobante rectangulaire de l’objet dans l’image I0 à

l’instant t = 0, (x0, y0) correspondant aux coordonnées du coin supérieur gauche de la boîte,

w0 à la largeur et h0 à la hauteur. Cette position est connue, c’est la vérité terrain de l’objet à

t = 0. Un algorithme de suivi ou tracker en anglais, a alors pour objectif d’estimer précisément la

position (xt, yt) et la taille (wt, ht) de la boîte englobante de l’objet ˆBt= (xt, yt, wt, ht) à chaque

(a) apparence initiale (b) illumination (c) occultations

(d) variations d’apparence

Figure 1.2 – Difficultés rencontrées lors du suivi d’une camionnette de la base KITTI [Geiger

et al., 2012] à partir de son apparence initiale (a) : illumination (b), occultations (c) et variations

d’apparence (d).

Figure 1.3 – Suivi d’objet quelconque : un sac plastique, un ballon, un poisson, un papillon, un lapin, un oiseau, un motocycliste et un hélicoptère, provenant de la base VOT2015 [Kristan

et al., 2015a].

Difficultés du suivi

Un certain nombre de facteurs rendent le suivi difficile. Ces facteurs sont liés à :

— l’acquisition : la qualité des images acquises (bruit, résolution, flou), les mouvements de caméra et les changements d’illumination ;

— la scène : le bruit de contexte (objet mobile, décor changeant, environnement complexe, contraste faible), les occultations partielles ou totales et les variations d’apparence de l’objet (réflectance, déformation, changement d’échelle ou de point de vue). Certaines de ces difficultés sont illustrées dans la figure 1.2.

Une autre difficulté de la tâche de suivi est la nature des objets suivis, ils peuvent être très variés comme ceux présents dans la figure 1.3. Un bon tracker doit donc être capable de suivre l’objet quelles que soient les perturbations rencontrées à partir de sa seule apparence initiale connue.

Formalisation du problème

Pour résoudre le problème du suivi, les trackers exploitent l’apparence de l’objet de manière dynamique. Le schéma générique de fonctionnement est le suivant (figure 1.4) :

Tracker i (𝑀𝑀𝑡𝑡−1𝑖𝑖 , 𝑊𝑊𝑡𝑡−1𝑖𝑖 )

𝐼𝐼𝑡𝑡 , 𝐵𝐵�𝑡𝑡−1𝑖𝑖 𝐵𝐵�𝑡𝑡𝑖𝑖, 𝑐𝑐𝑡𝑡𝑖𝑖 MAJ modèle et fenêtre MAJ position

Figure 1.4 – Schéma générique de fonctionnement d’un tracker. Le Tracker i prédit la position de la cible ˆBti dans l’image It, à l’instant t, à partir de sa position à l’instant précédent ˆBt−1i , d’une fenêtre de recherche Wt−1i définie par ˆBit−1et de son modèle d’apparence calculé à l’instant précédent Mt−1i . Un score de confiance citest associé à la prédiction ˆBti. La position de l’objet, la fenêtre de recherche et le modèle d’apparence sont mis à jour (MAJ) en utilisant la nouvelle position.

— Initialisation : le Tracker i construit un modèle d’apparence de l’objet M0i à partir de sa position B0 à la première image I0.

— Prédiction : il prédit la position de l’objet ˆBti dans la nouvelle image It à partir de sa position ˆBt−1i , d’une fenêtre de recherche Wt−1i et du modèle d’apparence Mt−1i construit à l’instant précédent. Un score de confiance cit qualifiant la qualité de la prédiction ˆBti est calculé par le modèle.

— Mise à jour : il met à jour son modèle Mt−1i → Mi

t à partir de la nouvelle prédiction ˆBti

pour intégrer les changements d’apparence de l’objet dans le temps.

Les étapes de prédiction et de mise à jour sont répétées dans chaque nouvelle image.

Revues de l’état de l’art

La littérature sur ce sujet est importante pour répondre aux difficultés du suivi. Plusieurs revues de l’état de l’art ont été publiées et rendent compte des approches de suivi proposées (catégorisation, comparaison, évaluation).

Pour les citer chronologiquement, [Yilmaz et al., 2006] proposent une classification des méthodes de suivi en fonction de la représentation d’objet utilisée (correspondance de points, modèles géométriques et modèles d’évolution de contours) et présentent les méthodes de détection d’objet existantes. Une discussion est réalisée sur les représentations d’objet, les modèles de mouvement, l’estimation des paramètres et les avantages et inconvénients des différentes approches de manière qualitative. [Yang et al., 2011] réalisent un état de l’art sur les différents composants d’un tracker : descripteurs de caractéristiques, méthodes d’apprentissage en ligne, prise en compte de l’information de contexte et méthodes d’échantillonnage de Monte-Carlo. [Salti et al., 2012] focalisent l’étude sur les modèles d’apparence adaptatifs et leur fonctionnement (échantillonnage et labellisation des exemples d’apprentissage, extraction de caractéristiques, estimation du modèle et sa mise à jour), et évaluent quantitativement plusieurs d’entre eux. [Wu et al., 2013] évaluent quantitativement 29 trackers de l’état de l’art sur une base de 50 vidéos. [Li et al., 2013] fournissent une description très détaillée de tous les modèles d’apparence existant en suivi et discutent de leur composition (représentation visuelle et modélisation statistique de l’apparence). [Smeulders et al., 2014] analysent les différents composants principaux d’un tracker (région d’objet, représentation

de l’apparence et du mouvement, méthode de localisation de l’objet et mise à jour du modèle) et réalisent une étude expérimentale sur 19 trackers connus, conçus sur des approches différentes, en les évaluant sur une base de 315 vidéos (ALOV++).

Grille de lecture proposée L’objectif de notre analyse bibliographique n’est pas de faire une synthèse des approches de suivi existantes mais d’analyser les spécificités de chacune d’elles pour les combiner dans un algorithme de fusion. Elle est organisée en trois parties décrivant les trois principales étapes de fonctionnement d’un tracker générique : modélisation de l’apparence de l’objet, prédiction de la localisation et mise à jour du modèle. Pour chacune des étapes, nous exposons et discutons des forces et faiblesses des approches proposées, ce qui va permettre de cerner les domaines d’emploi des trackers vis à vis des perturbations rencontrées dans les séquences.

Notre voulons ainsi montrer la diversité des approches mais aussi leur complémentarité pour résoudre un certain nombre de difficultés.

1.1.1 Modélisation de l’apparence de l’objet

L’apparence de l’objet est la principale information exploitée par les trackers ; sa modélisation est donc une étape importante pour réussir à suivre l’objet correctement. Il existe une diversité de représentations d’un objet, chacune étant adaptée à un type de difficulté rencontré en suivi (nature de l’objet, nature de la scène, qualité d’image, etc.). Nous présentons les principales

représentations utilisées et examinons les avantages et inconvénients de chacune d’elle.

Template Les techniques de mise en correspondance de templates ou recalage d’images [Lucas

et al., 1981] ont trouvé leur application dans de nombreux problèmes de vision, notamment

en suivi d’objet. Le template ou patch rectangulaire contenant les pixels de l’objet (intensité brute) mais aussi quelques pixels du fond est l’une des représentations les plus utilisées en suivi. Un nombre important de métriques ont été introduites pour mesurer la similarité entre deux

templates telles que la SSD (somme des différences au carré), la SAD (somme des différences

absolues), la corrélation croisée normalisée NCC [Lewis, 1995] ou sa version centrée ZNCC [Di Stefano et al., 2005] plus robuste aux changements de luminosité, ou encore l’information mutuelle. L’intérêt de cette représentation est qu’elle conserve l’information spatiale. Cependant, elle est peu robuste aux changements d’apparence ou de point de vue puisqu’elle ne représente qu’une seule vue ou apparence de l’objet, qui de plus est de taille fixe.

Points Une des techniques répandues est le suivi de points d’intérêt extraits de l’objet : points de Harris [Harris et Stephens, 1988], SIFT [Lowe, 2004], SURF [Bay et al., 2008], etc. Cette représentation par points hérite des techniques de recalage de la même façon que l’approche par template. Les points d’intérêt sont invariants à certaines transformations géométriques ou radiométriques, ce qui rend leur suivi plus robuste. Ils sont répertoriés et discutés dans [Tuytelaars

et Mikolajczyk, 2008]. La mise en correspondance des points entre deux images utilise soit une mesure de similarité des descripteurs locaux de texture (SSD, SAD), soit un flot optique [Shi et Tomasi, 1994]. Cette représentation par points d’intérêt est adaptée aux objets non rigides (articulés ou déformables) et texturés en tolérant un certain nombre de déformations de l’objet dans le plan mais est peu robuste aux occultations, changements d’illumination et variations importantes de l’apparence de l’objet.

Au lieu de restreindre le suivi aux points d’intérêt, des méthodes réalisent le suivi de tous les points, par flot optique dense [Lucas et al., 1981], mais présentent les mêmes problèmes que le suivi de points d’intérêt. Pour répondre à ces difficultés, des contraintes d’apparence ou de mouvement sont utilisées. [Kalal et al., 2010b] filtrent les mauvaises correspondances de points en calculant l’erreur de flot optique aller-retour de chaque point ou en calculant un score de corrélation NCC (proche voisinage) pour chaque paire de points appariés. Le tracker FoT [Matas et Vojíř, 2011, Vojíř et Matas, 2014] (amélioration de [Kalal et al., 2010b]) impose des contraintes de mouvement en utilisant une grille de cellules de points pour renforcer la robustesse de l’estimation de mouvement de l’objet. Pour gérer les occultations et réapparitions de l’objet dans l’image, [Brox et Malik, 2010] exploitent les trajectoires long-terme des points par flot optique dense pour permettre un suivi long-terme de l’objet dans la vidéo.

Une autre méthode très utilisée consiste à estimer la meilleure transformation géométrique (translation, affine, similitude, homographie) de l’ensemble de points entre deux images, par un algorithme appelé RANSAC (Random Sample Consensus) [Fischler et Bolles, 1981]. Les paires de points n’observant pas cette transformation sont rejetées. Cependant, ces contraintes de mouvement empêchent de modéliser les déformations de l’objet. Pour pouvoir modéliser ces déformations, [Zass et Shashua, 2008] utilisent des hypergraphes pour représenter les relations géométriques complexes entre les points. CMT [Nebehay et Pflugfelder, 2015] modélise la déformation de l’ensemble de points par une mesure de dissimilarité géométrique pour classer les correspondances de points, permettant par ailleurs d’estimer la rotation de l’objet.

Contour et silhouette La représentation de l’objet par son contour et la région interne au contour appelée « silhouette », est adaptée aux objets déformables. Elle est utilisée en imagerie médicale, en suivi d’objet ou de membres [Isard et Blake, 1998, Lebeda et al., 2016]. Nous ne l’exploitons pas dans la suite.

Parties d’objet Une autre approche classique est la représentation par parties [Li et al., 2015, Xiao et al., 2015]. Cette représentation surpasse la représentation par points car elle exploite l’apparence de chacune des parties, ainsi que leur configuration géométrique. Un avantage de la modélisation locale de l’apparence de l’objet est qu’elle est plus précise que la modélisation globale. Au lieu de calculer un histogramme global, [Adam et al., 2006] fragmentent l’objet en un ensemble de cellules réparties uniformément dans une grille, chaque cellule étant représentée par un histogramme.

Une des possibilités de la représentation par parties est la sélection des parties d’objet intéressantes pour le suivi. Dans le cadre de la détection d’objets, [Felzenszwalb et al., 2010] entraînent des modèles à parties déformables pour différentes catégories d’objet, les parties correspondent à des régions discriminantes de l’objet (faciles à détecter). [Kwon et Lee, 2013] disposent d’un ensemble de parties prises aléatoirement sur l’objet et proposent une méthode de mise à jour de cet ensemble (ajout et suppression de parties) en mesurant la robustesse de chaque partie définie par son apparence. RPT [Li et al., 2015] exploite un ensemble de parties fiables en utilisant une métrique construite sur la réponse du tracker pour mesurer cette fiabilité. [Xiao

et al., 2015] segmentent l’objet en « superpixels », régions homogènes et stables, par l’algorithme

de segmentation SLIC [Achanta et al., 2012], pour ne suivre que des régions d’objet et non de fond.

Représentation éparse Pour pouvoir gérer les occultations de l’objet, [Mei et Ling, 2011] modélisent l’apparence de l’objet par un ensemble de templates dans lesquels différentes régions sont masquées afin de simuler les occultations partielles de l’apparence, pouvant survenir lors du suivi. Cette représentation a été largement utilisée [Mei et al., 2011, Wang et al., 2013].

Histogrammes (Densité de probabilité) L’information contenue dans le template objet peut être transformée en une densité de probabilité (histogramme, modèle de mélanges) de certaines caractéristiques locales. A la différence de la représentation par template, cette modélisa-tion permet d’intégrer plusieurs vues ou apparences de l’objet dans un espace de dimension faible, plus facile d’exploitation mais ne permet pas la conservation de l’information spatiale. [McKenna

et al., 1999] estiment un modèle paramétrique de mélange de gaussiennes pour représenter la

distribution des couleurs de l’objet dans l’espace HS (teinte-saturation). [Zhang et al., 2012] mo-délisent les distributions de caractéristiques de Haar appartenant à l’objet et à l’arrière-plan par des modèles gaussiens. L’intérêt de ces modèles est la possibilité de mettre à jour les paramètres des distributions dans le temps et donc d’adapter les modèles aux variations d’apparence de l’objet. [Comaniciu et al., 2000, Allen et al., 2004, Vojir et al., 2014] représentent la distribution de couleurs de l’objet par un histogramme de couleurs et construisent une métrique basée sur la distance de Bhattacharyya ρ [Kailath, 1967] pour mesurer la similarité entre deux histogrammes

p et q : ρ(p, q) =Pm

u=1

√

puqu où pu et qu sont les probabilités de la uièmeclasse des histogrammes p et q. Par ailleurs, une estimation des variations de taille de l’objet est réalisée.

Sous-espace de représentation Certains ont recours à un sous-espace de représentation de l’objet de dimension plus faible qu’un template et dans l’objectif de représenter plusieurs vues ou apparences de l’objet. [Black et Jepson, 1998] représentent l’objet dans un espace propre (eigenspace) à partir d’un ensemble de vues de l’objet. [Ross et al., 2008] utilisent comme sous-espace de représentation une décomposition en composantes principales (PCA) des caractéristiques extraites de l’objet pour représenter plusieurs points de vue de l’objet.

Caractéristiques visuelles Habituellement extraites d’un template objet, d’une partie d’objet ou du voisinage d’un point (descripteurs locaux), les caractéristiques visuelles ont été largement exploitées par les trackers. Elles fournissent une description plus robuste de l’apparence de l’objet par rapport à l’information d’intensité des pixels. Cette dernière étant sensible à la plupart des perturbations de l’image (bruit, illumination, réflectance). La plupart des caractéristiques visuelles sont construites « à la main » et présentées sous forme de vecteur. [Dalal et Triggs, 2005] proposent un histogramme de gradients orientés (HOG) pour caractériser la forme globale des objets pour la détection de piétons. [Henriques et al., 2015] intègrent ces caractéristiques dans un filtre de corrélation discriminant. [Viola et al., 2005, Zhang et al., 2012, Hare et al., 2011, Ahonen et al., 2006] utilisent des caractéristiques de texture telles que les caractéristiques de Haar ou les motifs binaires locaux (LBP). [Klaser et al., 2008, Zhao et Pietikainen, 2007] exploitent des caractéristiques spatio-temporelles telles que les HOG3D et DLBP.

Les propriétés recherchées des caractéristiques sont multiples : robustesse face aux changements d’apparence de l’objet (réflectance, transformation géométrique, déformation, point de vue, occultation) quel que soit le type d’objet (rigide, déformable, texturé ou peu texturé, etc.), aux dégradations de l’image (bruit, illumination, floue, mauvaise résolution) et au bruit de contexte (contraste, similarité entre objet et fond, objets similaires). Cependant, certaines caractéristiques le sont plus ou moins : les caractéristiques de forme sont moins sensibles aux changements de luminosité et aux dégradations de l’image, tandis que les caractéristiques de couleur sont moins sensibles aux transformations géométriques. La plupart des trackers n’utilisent qu’un seul type de caractéristiques alors qu’elles peuvent être complémentaires, c’est comme cela que [Wang et al., 2015b] montrent une amélioration des performances de suivi de l’ordre de 20% en combinant des HOG et des couleurs. La combinaison de caractéristiques offre donc de nombreux avantages mais toutes les caractéristiques ne sont pas discriminantes. [Grabner et Bischof, 2006] proposent alors de sélectionner les caractéristiques discriminantes parmi un large répertoire de caractéristiques simples en utilisant du Boosting, une technique d’apprentissage automatique. [Kwon et Lee, 2013] sélectionnent la caractéristique la plus discriminante pour modéliser l’apparence des parties d’objet en comparant à la vraisemblance de leur arrière-plan.

Deep features Récemment, l’utilisation des caractéristiques calculées par des réseaux profonds, appelées deep features, est devenue très populaire. Connus pour leur grande capacité de représen-tation des objets, les réseaux profonds issus de « l’apprentissage profond » (Deep learning) sont utilisés comme fournisseurs de caractéristiques pour le suivi d’objet [Wang et Yeung, 2013, Hong

et al., 2015a, Danelljan et al., 2015]. Le réseau est tout d’abord pré-entraîné sur une grande base

d’images, par exemple ImageNet [Russakovsky et al., 2015] (plusieurs millions d’images), puis utilisé en tant que boîte noire pour fournir les cartes de caractéristiques des images passées en entrée du réseau. C’est le cas du tracker Deep-SRDCF [Danelljan et al., 2015], deuxième au classement du challenge VOT2015 (Visual Objet Tracking) [Kristan et al., 2015b], qui exploite les

R-CNN [Girshick et al., 2014] pré-entraîné sur la base ImageNet dont l’avant dernière couche (fully-connected) sert d’extracteur de deep features. Ces caractéristiques alimentent un classifieur SVM (en anglais Support Vector Machine) en ligne (dernière couche du réseau remplacée par un SVM) dont l’objectif est d’apprendre les caractéristiques spécifiques à la cible permettant de discriminer la cible du fond. Cependant, l’information spatiale de localisation de la cible n’est pas conservée par les deep features à cause des opérations de pooling (groupements de neurones) qui ont lieu dans différentes couches du réseau. Par conséquent, pour avoir accès à la localisation spatiale de la cible, l’idée est de générer des cartes de saillance spécifiques à la cible en rétro-propageant les caractéristiques spécifiques à la cible classées par SVM dans le réseau jusqu’à la première couche. Cette méthode est inspirée de [Simonyan et al., 2014] qui génèrent des cartes de saillance spécifiques à une classe d’objet donnée, permettant d’identifier les régions de l’image saillantes pour cette classe.

Les caractéristiques exploitées dans les réseaux proviennent habituellement des couches supérieures, et ne sont pas directement adaptées au suivi d’objet car leur fonction est de renseigner sur la sémantique des objets de l’image. Ils ne permettent donc pas de discriminer un objet en particulier parmi d’autres objets similaires. Pour remédier à ce problème, [Wang

et al., 2015a, Qi et al., 2016] cherchent à exploiter les caractéristiques des couches intermédiaires

pour le suivi d’objet. [Wang et al., 2015a] utilisent le réseau VGG à 16 couches de [Simonyan et Zisserman, 2014] pré-entraîné sur ImageNet et exploitent les propriétés complémentaires d’une couche profonde et d’une couche moins profonde du réseau pour localiser la position de l’objet. La plus profonde fournit des caractéristiques sémantiques (objets de même classe) tandis que la moins profonde fournit des caractéristiques plus précises de la cible pour la discriminer des objets de même classe. Par ailleurs, ils observent que toutes les cartes de caractéristiques ne sont pas utiles pour discriminer l’objet, une méthode de sélection des cartes sur ces deux couches est proposée. [Qi et al., 2016] exploitent les cartes de caractéristiques de différentes couches du réseau pré-entraîné VGG [Simonyan et Zisserman, 2014], chaque carte étant utilisée pour apprendre un filtre de corrélation. La cible est localisée en réalisant une somme pondérées des réponses des filtres.

Classifieur/modèle discriminant L’idée est d’exploiter directement un classifieur fond/forme capable de discriminer l’objet du fond. Le fond doit donc être caractérisé. Le classifieur est obtenu en utilisant des techniques d’apprentissage automatique telles que le Boosting [Grabner et al., 2006, Babenko et al., 2009], les forêts aléatoires [Ozuysal et al., 2010, Kalal et al., 2012], les machines à vecteurs de support (SVM) [Avidan, 2004, Hare et al., 2011], les filtres de corrélation discriminants [Bolme et al., 2010, Danelljan et al., 2014, Henriques et al., 2015] ou les réseaux de neurones [Nam et Han, 2015], mais avec une dimension « en ligne », c’est-à-dire avec une mise à jour du classifieur à chaque instant.

L’approche de suivi par classifieur a été largement adoptée par la communauté ces dernières années grâce aux avancées des travaux en apprentissage automatique. Souvent apparentée à de

la détection d’objets dans une image par fenêtre glissante, elle est appelée Track-by-detection. La première image sert à initialiser le classifieur en prenant comme exemple positif la position de l’objet et comme exemples négatifs les positions contenant du fond. Les images suivantes servent à entraîner le classifieur en ligne. L’intérêt de cette approche est d’améliorer la robustesse de suivi en intégrant à la fois les apparences de l’objet et les informations de contexte dans le modèle, de manière dynamique. Plusieurs problèmes se posent : la construction d’un détecteur objet-fond, la mise à jour incrémentale du modèle et la gestion des exemples positifs et négatifs dans le modèle du fait qu’ils sont bruités.

Combinaison de plusieurs représentations En fonction de la nature de l’objet (déformable ou rigide), du contexte (fort ou faible contraste) et des perturbations de l’image (niveau de bruit), certaines représentations d’apparence sont plus adaptées que d’autres. Les trackers suivants cherchent à exploiter leur complémentarité. LGT [Čehovin et al., 2011] combine un modèle d’apparence globale et des modèles d’apparence locale de parties d’objet pour une représentation plus robuste. [Xiao et al., 2015] construisent un tracker robuste aux déformations de l’objet et aux occultations en exploitant trois niveaux de représentation de l’objet (pixel, partie et boîte). Les parties d’objet sont formées de superpixels de l’objet contenant uniquement l’objet, sans le fond. Leur regroupement est réalisé par un arbre de décision adaptatif qui sert ensuite à suivre les parties d’une image à l’autre. A chaque partie est associée un histogramme de caractéristiques de couleurs et de mouvement. L’apparence globale de l’objet est modélisée par deux histogrammes de caractéristiques de couleurs et de mouvement, l’un pour l’objet et l’autre pour l’arrière-plan. Le dernier niveau de représentation associe à chaque pixel individuel son intensité RBG et une vraisemblance calculée à partir de l’apparence globale.

1.1.2 Localisation de l’objet

Estimer la meilleure localisation de l’objet dans chaque image (position, taille et parfois, angle et pose), soulève le problème du coût de calcul nécessaire pour le réaliser. Pour cela, différentes approches ont été utilisées pour estimer la position ou l’état de l’objet.

Méthodes d’optimisation Le problème de suivi est formulé sous la forme d’une optimisation de fonction différentiable par rapport à la variable position et où l’estimation de position de l’objet est résolue par une descente de gradient, comme c’est le cas du flot optique [Lucas et al., 1981] ou de l’algorithme Meanshift [Comaniciu et al., 2000]. Le flot optique estime le déplacement 2D d’un pixel d’une image à l’autre en imposant une contrainte de conservation d’intensité de celui-ci. Cette estimation peut être rendue plus robuste éventuellement par des contraintes supplémentaires d’intensité ou géométriques de déplacement [Kalal et al., 2010b, Matas et Vojíř, 2011].

Le Meanshift [Comaniciu et al., 2000] est une procédure itérative de recherche du maximum d’une densité de probabilité où la position estimée de l’objet est déplacée vers un centre de

gravité local jusqu’à convergence. CamShift (Continuously Adaptive Mean Shift) [Allen et al., 2004] est une extension du Meanshift avec une adaptation de taille de la fenêtre. Cependant, un des risques classiques présents dans ces méthodes d’optimisation est la convergence vers un minimum local qui ne soit pas la position réelle de l’objet, i.e. minimum le plus proche de la position initiale. Ces méthodes ne sont donc pas adaptées aux grands déplacements de l’objet.

Filtrage de Kalman Une autre stratégie de recherche est d’utiliser un modèle de mouvement pour restreindre l’espace de recherche de l’objet, notamment un filtre de Kalman [Kalman, 1960]. Celui-ci réalise la prédiction d’état de l’objet (localisation) en supposant que l’état de l’objet est normalement distribué (gaussien) et le modèle de mouvement linéaire (par exemple, un modèle à vitesse constante [Čehovin et al., 2011]). Cette prédiction est réalisée en deux temps : une étape de prédiction puis de correction de l’état. L’étape de prédiction est assurée par le modèle de mouvement linéaire calculé à l’instant précédent Mt−1. L’étape de correction corrige la prédiction d’état en utilisant l’écart entre l’observation prédite (modèle) et l’observation courante (par exemple issue de la détection). A l’origine conçu pour le suivi de points (radar), le filtre de Kalman linéaire est peu adapté au suivi d’objets dans des vidéos. En effet, ces derniers suivent difficilement un modèle de mouvement linéaire (changement brusque de direction, mouvement de caméra). Des modèles de mouvement plus complexes ont été développés mais l’apparence de l’objet y est peu exploitée : EKF (Extended Kalman Filter ) [Julier et Uhlmann, 2004], UKF (Unscented

Kalman Filter ) [Julier et Uhlmann, 1997], IMM (Interacting Multiple Model) [Bar-Shalom et al.,

2004], etc.

Échantillonnage stochastique Le filtrage particulaire (ou méthodes de Monte-Carlo séquen-tielles) [Gordon et al., 1993, Kitagawa, 1996] est une solution aux limitations du filtre de Kalman. La variable d’état n’est plus décrite par une gaussienne et le modèle de mouvement utilisé est non linéaire (plus de contraintes). Un modèle d’apparence de l’objet est exploité. L’objectif est d’approximer la distribution de filtrage de l’état à partir de N particules échantillonnées aléatoirement dans l’espace d’état. Chaque particule simule une trajectoire possible de l’objet, l’importance de chacune d’elle dépend de la vraisemblance observée (relative au modèle d’appa-rence). Le filtrage particulaire est largement utilisé en suivi mono-objet et multi-objets [Ross

et al., 2008, Kwon et Lee, 2011, Penne et al., 2013]. Son coût de calcul dépend du nombre de

particules utilisées. Il est adapté aux trajectoires complexes des objets et aux occultations, par exemple deux piétons se croisant.

Échantillonnage dense La plupart des trackers contemporains n’utilisent pas de modèle de mouvement, afin de pouvoir considérer tous les déplacements possibles de l’objet. Ils recherchent l’objet par l’apparence en tenant compte de la variabilité de celle-ci en maximisant un score de confiance ou de prédiction calculé par le modèle dans l’espace de recherche échantillonné de manière dense : corrélation [Lewis, 1995], vraisemblance [Zhang et al., 2012], classification [Hare

et al., 2011], détection [Kalal et al., 2012], etc. C’est le cas des approches de suivi basées sur la

correspondance de template ou de type Track-by-detection. Cet espace de recherche peut être toute l’image (recherche exhaustive), ce qui implique un coût de calcul élevé mais s’avère utile lorsque la cible effectue de grands déplacements dans l’image. Il répond aussi à des problématiques de ré-identification de la cible lorsqu’elle est perdue pendant plusieurs images et que l’on cherche à le ré-identifier dans les images suivantes. Le détecteur du TLD remplit cette fonction [Kalal

et al., 2012].

Pour réduire le coût de calcul, la plupart des trackers font l’hypothèse que les déplacements de l’objet sont faibles d’une image à l’autre et recherchent l’objet dans une fenêtre locale (recherche locale) de manière uniforme ou gaussienne autour de la position précédente de l’objet.

Pour une localisation plus précise, la recherche multi-échelles permet d’adapter les variations de taille de l’objet. C’est le cas par exemple des filtres de corrélation discriminants [Danelljan

et al., 2014, Henriques et al., 2015]. Ceux-ci ont connu une forte popularité ces dernières années

pour répondre aux problématiques du suivi d’objet, en modélisant l’apparence de l’objet par un filtre de caractéristiques dans le domaine des fréquences spatiales. Ils permettent de calculer facilement les corrélations pour une population de déplacements (fenêtres candidates), de l’ordre de la centaine d’images par seconde. Nous présenterons en détails un algorithme de cette famille, le tracker DSST [Danelljan et al., 2014] dans la section 2.2.6.

D’autres paramètres peuvent être intégrés dans la recherche telle que l’orientation de l’objet [Yilmaz, 2007, Hua et al., 2015].

1.1.3 Mise à jour du modèle d’apparence

Un des points centraux du suivi d’objet est la capacité des trackers à s’adapter aux variations d’apparence de l’objet en mettant à jour leur modèle d’apparence. Évidemment, la façon dont cette mise à jour est réalisée est cruciale et peut entraîner la dérive du tracker lorsque de mauvaises mises à jour sont introduites dans le modèle. Deux problématiques s’articulent donc autour de ce sujet :

— Comment mettre à jour le modèle ? (techniques de mise à jour en ligne, choix des exemples d’apprentissage, labellisation)

— Quand effectuer la mise à jour ? A quelle fréquence ? Comment décider qu’une mise à jour est bonne ou mauvaise ?

Les trackers élémentaires réalisant la correspondance de template [Lewis, 1995] ou d’histo-grammes [Comaniciu et al., 2000, Vojir et al., 2013] ne disposent pas de mise à jour de leur modèle, leur modèle est dit « statique » :

où Mt est le modèle d’apparence de l’objet à l’instant t et est construit uniquement à partir de l’apparence initiale de l’objet. La constance du modèle évite les mauvaises mises à jour, cependant le suivi long-terme de l’objet ne peut être assuré dès lors que l’apparence change de manière très importante. La plupart des trackers modernes disposent donc d’une politique d’adaptation de leur modèle d’apparence.

Mécanisme de mise à jour

Processus dynamiques d’ordre 1 Une manière naïve de réaliser cette mise à jour est de remplacer le modèle précédent par le modèle courant :

Mt−1← Mt (1.2)

C’est le cas du suivi de points par flot optique dans [Kalal et al., 2010b] où à chaque instant la grille de points est réinitialisée à partir de la nouvelle prédiction.

[Matthews et al., 2004] proposent une alternative à la méthode naïve pour l’adaptation du modèle par correspondance de template incorporant le template original T1 :

Mt= f (Tt, T1) (1.3)

où Ttest le template issu de la prédiction courante.

Une autre stratégie de mise à jour consiste à contrôler la vitesse d’adaptation de leur modèle par un pas d’apprentissage λ. A chaque instant t, le nouveau modèle Mt est obtenu par une

somme pondérée de la nouvelle apparence At et du modèle passé Mt−1 :

Mt= λAt+ (1 − λ)Mt−1 (1.4)

C’est le cas du tracker IVT [Ross et al., 2008], qui réalise l’apprentissage incrémental d’un sous-espace de représentation de l’objet (PCA) et adapte le modèle en intégrant la nouvelle apparence de l’objet avec un facteur d’oubli sur les apparences passées de l’objet. L’inconvénient d’une telle approche est que la nouvelle apparence est intégrée au modèle sans contrôle, ce qui peut facilement conduire à une dérive du modèle. De plus, un aspect important de la mise à jour concerne le choix des exemples utilisés dans la mise à jour et leur labellisation. Pour ces trois derniers trackers [Kalal et al., 2010b, Matthews et al., 2004, Ross et al., 2008], la localisation de l’objet est le seul exemple positif utilisé pour la mise à jour de leur modèle. Cette méthode est clairement peu robuste en particulier lorsque la localisation de l’objet est imprécise. Pour éviter ce problème, [Kim et al., 2008] réalisent le suivi de visages en ajoutant des contraintes de variations d’apparence du visage (pose, alignement) pour empêcher l’adaptation du modèle à des apparences candidates qui ne sont pas des visages. Ces contraintes sont apprises hors ligne à partir de connaissances a priori. Les apparences candidates sont pondérées en fonction de leur

pose et de leur alignement, ce qui permet de rejeter les candidates mal-alignées par exemple. Toutefois, ce procédé ne peut s’appliquer au suivi d’objet quelconque.

Apprentissage en ligne du contexte par un processus d’ordre 1 D’autres trackers exploitent l’information de contexte pour être plus robustes à la dérive, par exemple en construisant un modèle de fond [Zhang et al., 2012] ou un modèle discriminant [Henriques et al., 2015, Danelljan

et al., 2014, Ma et al., 2015]. Leur mécanisme de mise à jour s’apparente à celui de [Ross et al.,

2008], i.e. en utilisant un pas d’apprentissage λ. [Zhang et al., 2012] génèrent des exemples positifs et négatifs à partir de la prédiction (position de l’objet) pour mettre à jour les modèles d’objet et de fond respectivement. Les exemples positifs labellisés à 1 sont sélectionnés dans un rayon faible α autour de la prédiction, et les exemples négatifs labellisés à −1 sont sélectionnés sur une couronne externe α < c < β. Cette labellisation binaire des exemples {−1, 1} permet d’intégrer une variation de l’apparence de l’objet autour de la position prédite (plusieurs instances labellisées à 1) mais conduit souvent à une confusion du modèle et une mauvaise discrimination de l’objet par rapport à son contexte. En revanche, les filtres de corrélation discriminants sont plus précis [Henriques et al., 2015, Danelljan et al., 2014, Ma et al., 2015] en utilisant une régression : les exemples sont labellisés entre [0, 1]. Les exemples d’entraînement sont présentés sous la forme d’une matrice circulante [Henriques et al., 2012], centrée sur la position de l’objet : les exemples d’entraînement sont générés par translation dense autour de cette position et labellisés avec les valeurs d’une gaussienne centrée sur cette position. De plus, [Danelljan et al., 2014, Ma et al., 2015] comportent une étape d’estimation d’échelle permettant une localisation précise de l’objet et donc permettent une meilleure robustesse à la dérive.

Classifieurs appris en ligne Les trackers inspirés des techniques d’apprentissage automatique (Boosting, forêts aléatoires, SVM, réseaux de neurones) adaptent les classifieurs hors ligne en classifieurs en ligne. [Grabner et al., 2006] présentent un version en ligne de l’algorithme AdaBoost (Adaptive Boosting) [Grabner et Bischof, 2006] pour le suivi d’objet. [Hare et al., 2011] utilisent une méthode d’optimisation [Platt, 1999, Bordes et al., 2007, Bordes et al., 2008] pour entraîner en ligne un classifieur SVM sur des données à labels structurés. Cette méthode permet la mise à jour des vecteurs de support tenant compte des nouveaux exemples d’apprentissage sans avoir à ré-entraîner le classifieur sur tous les exemples existants. Dans beaucoup de cas, les classifieurs sont utilisés à la fois pour prédire la position de l’objet et pour générer les exemples d’entraînement, une imprécision du classifieur peut alors entraîner des erreurs de labellisation des exemples.

Labellisation robuste des exemples d’apprentissage Pour rendre les classifieurs plus robustes aux erreurs de labellisation, différentes approches de labellisation ont été développées. Au lieu de suivre un apprentissage classique avec un label par exemple d’apprentissage, [Babenko

![Figure 1.2 – Difficultés rencontrées lors du suivi d’une camionnette de la base KITTI [Geiger et al., 2012] à partir de son apparence initiale (a) : illumination (b), occultations (c) et variations d’apparence (d).](https://thumb-eu.123doks.com/thumbv2/123doknet/14736135.574622/20.892.140.760.80.346/difficultés-rencontrées-camionnette-apparence-illumination-occultations-variations-apparence.webp)

![Figure 1.5 – Séquences de la base OTB [Wu et al., 2013]. Les images correspondent à la première image de chaque séquence avec l’objet d’intérêt détouré par une boîte englobante rouge](https://thumb-eu.123doks.com/thumbv2/123doknet/14736135.574622/38.892.126.770.89.343/figure-séquences-correspondent-première-séquence-intérêt-détouré-englobante.webp)

![Figure 1.6 – Séquences de la base VOT2015. [Kristan et al., 2015a].](https://thumb-eu.123doks.com/thumbv2/123doknet/14736135.574622/39.892.127.767.84.629/figure-séquences-la-base-vot-kristan-al-a.webp)

![Figure 1.7 – Séquences de la base VOT-TIR2015. [Felsberg et al., 2015].](https://thumb-eu.123doks.com/thumbv2/123doknet/14736135.574622/40.892.134.760.83.524/figure-séquences-la-base-vot-tir-felsberg-al.webp)