Une devise canadienne ou plusieurs?

La question de l’optimalité de la zone monétaire canadienne à travers

l’étude de chocs exogènes dans un cadre VECM

Mémoire

Domar-Anas Berkouch

Maîtrise en économique

Maitre ès arts (M.A)

Québec, Canada

iii

RESUME

L'objectif de cette étude est de savoir si la fédération des provinces du Canada forme aujourd’hui une zone monétaire optimale. Les travaux précédents ont suggéré que l’espace monétaire canadien soit divisé en deux espaces, l’un de l’Est et l’autre de l’Ouest. Notre méthodologie, qui intègre des données des Etats-Unis et du cours du pétrole WTI, fait ressortir l’existence de deux zones économiques pouvant se doter de leur propre devise. L’analyse par VECM montre l’existence d’une relation de long terme entre les provinces canadiennes, les États-Unis et le cours du pétrole. Une interprétation possible de nos résultats est que ceux-ci suggèrent que le Canada devrait avoir deux monnaies distinctes une pour la zone de l’Ouest (Alberta/Colombie-Britannique), une pour la zone de l’Est (Québec/Ontario/Nouveau-Brunswick).

v

ABSTRACT

The aim of this study is to assess whether the federation of the provinces of Canada today form an optimal currency area. Previous work has sometimes suggested that the Canadian monetary zone be divided into two spaces, one in the East and the other in the West. Our methodology, which incorporate data from the United States and WTI oil prices, highlights the existence of two economic areas that could develop their own currency. VECM analysis shows the existence of a long-term relationship between the Canadian provinces, the United States and oil prices. The results can be interpreted as suggesting that Canada should have two separate currencies for an area of the West (Alberta / British Columbia), one for the area (Quebec/Ontario/New-Brunswick).

vii

TABLE DES MATIERES

RESUME ... III ABSTRACT ... V

Partie 1 : REVUE DE LITTERATURE ... 1

INTRODUCTION : ... 1

I. CRITERES DES ZMO TRADITIONNELLES. ... 3

L’APPORT INITIAL DE MUNDELL ... 3

1. LE CRITÈRE D’OUVERTURE ÉCONOMIQUE DE MCKINNON ... 4

2. LE CRITÈRE DE DIVERSIFICATION DE LA PRODUCTION ... 5

3. L’INTÉGRATION FINANCIÈRE COMME CRITÈRE D’OPTIMALITÉ ... 6

4. II. ENDOGENEITE OU EXOGENEITE DES CRITERES D’OPTIMALITE ? ... 7

CRITÈRES OPTIMAUX ENDOGÈNES SELON FRANKEL ET ROSE ... 7

1. CRITÈRE ENDOGÈNE DES PRÉFÉRENCES HOMOGÈNES ... 9

2. LA CRITIQUE DE LA THÉORIE DU COMMERCE INTERNATIONAL PAR KRUGMAN ... 11

3. III. LES NOUVEAUX CRITERES D’UNE ZMO. ... 12

CRÉDIBILITÉ DES ZONES À TRAVERS DES CRITÈRES DE CONVERGENCES ... 12

1. SOLIDARITÉ DE LA ZONE MONÉTAIRE ... 13

2. IV. EFFETS DE CHOCS DANS UNE UNION MONETAIRE. ... 14

CHOCS EXOGÈNES ASYMÉTRIQUES D’OFFRE ... 14

1. CHOCS EXOGÈNES ASYMÉTRIQUES DE DEMANDE ... 15

2. V. COORDINATION DES POLITIQUES BUDGETAIRES ET FEDERALISME FISCAL ... 16

SYNCHRONISATION DES POLITIQUES BUDGÉTAIRE ... 16

1. FÉDÉRALISME BUDGÉTAIRE ET FISCAL ... 17

2. Partie 2 : ETUDE ECONOMETRIQUE ... 19

VI. ANALYSES DES SERIES TEMPORELLES ... 20

LA STATIONNARITÉ ET LES TESTS DE RACINES UNITAIRES. ... 20

1. LES RELATIONS DE COINTÉGRATION ET LES TESTS ASSOCIÉS. ... 22

2. VII. LA REPRESENTATION VECM ... 24

LA SÉLECTION DU NOMBRE DE RETARDS ... 25

1. LA STABILITÉ DU MODÈLE VECM ... 26

2. NORMALITÉ DES RÉSIDUS ... 27

3. HOMOSCEDASTICITÉ DES TERMES D’ERREURS ... 28

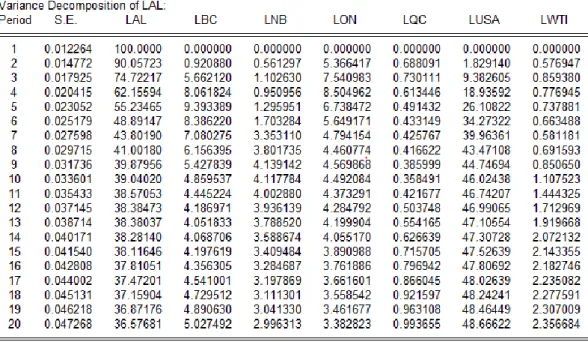

4. VIII. DECOMPOSITION DE LA VARIANCE ... 33

IX. RÉPONSES IMPULSIONNELLES ... 38

CONCLUSIONS ... 45

ix

LISTE DES TABLEAUX

T

ABLEAU1 :

T

ESTS DE STATIONNARITÉ DES VARIABLES INTÉGRÉES D’

ORDRE1 ---22

T

ABLEAU2

:

T

EST DEJ

OHANSEN NON-

RESTREINT(

TEST DE LA TRACE) ---24

T

ABLEAU3

:

L

A SELECTION DU NOMBRE DE RETARD---26

T

ABLEAU5 :

T

EST DE NORMALITÉ DES RÉSIDUS---28

T

ABLEAU6 :

T

EST DEW

HITE AVECVECM

À2

RETARDS---29

T

ABLEAU8 :

T

EST DE NORMALITÉ DES RÉSIDUS DU MODÈLE À4

RETARDS---30

T

ABLEAU9

:

T

EST DEW

HITE AVECVECM

À4

RETARDS---30

T

ABLEAU10 :

L

ES RELATIONS DE LONG-

TERME---31

T

ABLEAU11 :

L

ES ÉQUATIONS COINTÉGRANTES---31

T

ABLEAU12:

D

ÉCOMPOSITION DE LA VARIANCE:

L’A

LBERTA---35

T

ABLEAU13:

D

ÉCOMPOSITION DE LA VARIANCE:

LAC

OLOMBIE-B

RITANNIQUE---35

T

ABLEAU14:

D

ÉCOMPOSITION DE LA VARIANCE:

L’O

NTARIO---36

T

ABLEAU15:

D

ÉCOMPOSITION DE LA VARIANCE:

LEQ

UÉBEC---36

xi

LISTE DES FIGURES

F

IGURE1 :

L

A FRONTIÈRE D’

OPTIMALITÉ... 8

F

IGURE2 :

B

ÉNÉFICES/

PERTES D’

UNE UNIFICATION MONÉTAIRE... 9

F

IGURE3 :

R

ACINES INVERSES DU POLYNÔME CARACTÉRISTIQUE DUVECM

À2

RETARDS

... 27

F

IGURE4 :

R

ACINES INVERSES DU POLYNÔME CARACTÉRISTIQUE À4

RETARDS... 29

F

IGURE5

:

R

ÉPONSES ACCUMULÉES DESPIB

DUQ

UÉBEC APRÈS UN CHOC SUR LEPIB

DESÉ

TATS-U

NIS ET SUR LE PRIX DU PÉTROLEWTI... 38

F

IGURE6

:

R

ÉPONSES ACCUMULÉES DESPIB

DE L’O

NTARIO APRÈS UN CHOC SUR LEPIB

DESÉ

TATS-U

NIS ET SUR LE PRIX DU PÉTROLEWTI ... 39

F

IGURE7

:

R

ÉPONSES ACCUMULÉES DESPIB

DUN

OUVEAU-B

RUNSWICK APRÈS UN CHOC SUR LEPIB

DESÉ

TATS-U

NIS ET SUR LE PRIX DU PÉTROLEWTI ... 39

F

IGURE8

:

R

ÉPONSES ACCUMULÉES DESPIB

DE L’A

LBERTA APRÈS UN CHOC SUR LEPIB

DESÉ

TATS-U

NIS ET SUR LE PRIX DU PÉTROLEWTI ... 40

F

IGURE9

:

R

ÉPONSES ACCUMULÉES DESPIB

DE LAC

OLOMBIE-B

RITANNIQUE APRÈS UN CHOC SUR LEPIB

DESÉ

TATS-U

NIS ET SUR LE PRIX DU PÉTROLEWTI ... 40

F

IGURE10 :

R

ÉPONSES ACCUMULÉES DESPIB

DE L’O

NTARIO APRÈS UN CHOC SUR LEPIB

L’A

LBERTA ET LAC

OLOMBIE-B

RITANNIQUE... 41

F

IGURE11 :

R

ÉPONSES ACCUMULÉES DESPIB

DUQ

UÉBEC APRÈS UN CHOC SUR LEPIB

L’A

LBERTA ET LAC

OLOMBIE-B

RITANNIQUE... 42

F

IGURE12 :

R

ÉPONSES ACCUMULÉES DESPIB

DUN

OUVEAU-B

RUNSWICK APRÈS UN CHOC SUR LEPIB

L’A

LBERTA ET LAC

OLOMBIE-B

RITANNIQUE... 42

F

IGURE13 :

R

ÉPONSES ACCUMULÉES DUPIB

DE L’A

LBERTA APRÈS UN CHOC SUR LEPIB

DE L’O

NTARIO,

DUQ

UÉBEC ET DUN

OUVEAU-B

RUNSWICK... 44

F

IGURE14 :

R

ÉPONSES ACCUMULÉES DUPIB

DE LAC

OLOMBIE-B

RITANNIQUE APRÈS UN CHOC SUR LEPIB

DE L’O

NTARIO,

DUQ

UÉBEC ET DUN

OUVEAU-B

RUNSWICK... 44

xiii REMERCIEMENTS

J'aimerais remercier mon directeur de recherche, à savoir Mr. Kevin MORAN pour l’intérêt et la confiance qu’il a porté à ma recherche, pour la disponibilité qu’il a eu à mon égard . Je voudrais aussi remercier Mr. Eloi DESSY qui dès mon arrivée au département d’économique, m’a poussé et motivé afin de croire en mes chances de réussite.

Un grand merci à mes parents Mr. BERKOUCH Driss et Mme. BERKOUCH Rahma, mon frère Réda et mes sœurs Sarah et Myriam, qui de l’autre côté de l’océan m’ont apporté soutien et confiance.

Et enfin, un merci à mes amis, notamment FILALI Nabil, ZIANI Ilias, AJOUAMAI AYOUB BHALIL Ishaq qui m’ont soutenu à travers toute la recherche de ce mémoire.

1

Partie 1 : REVUE DE LITTERATURE

I

NTRODUCTION:

La question de l’optimalité d’une zone monétaire est une problématique souvent soulevée et d’actualité. A titre d’exemple, la zone monétaire européenne a récemment vécu une crise ayant mis en danger l’existence même de l’euro. Au Canada, une fédération de plusieurs provinces partageant le dollar canadien, la question de l’optimalité se pose également. La fédération canadienne doit-elle conserver la monnaie unique, ou devrait-elle plutôt former plusieurs zones monétaires?

Nous allons donc étudier la question de l’optimalité de la zone monétaire optimale canadienne. Afin d’analyser cette question, nous devons nous en remettre à la littérature concernant la théorie des zones monétaires optimales. Plusieurs champs sont à étudier et suggèrent des critères d’optimalité différents. Le début de la recherche est à imputer à R. Mundell, qui en 1961 pose le premier jalon de la « théorie des zones monétaires optimales », en étudiant la mobilité du travail en cas de choc asymétrique sur une économie. S’en suivront beaucoup d’autres auteurs qui viendront affiner cette théorie.

Afin de répondre à notre problématique, notre étude commencera par un survol de la littérature concernant le sujet, de la théorie classique aux nouveaux critères apportés. Nous verrons notamment que la question de l’endogénéité ou de l’exogénéité du processus menant à la formation d’une zone monétaire optimale a été soulevée dans plusieurs débats.

Plusieurs analyses ont remis en question l’optimalité de la zone monétaire canadienne par le passé. En effet, R. Mundell (1961) a suggéré que la mobilité réduite des facteurs entre l’Est et l’Ouest du pays rendait la zone monétaire sous-optimale. Dudley (1973) propose la création de deux monnaies : un « dollar de l’ouest » (Ontario et le reste de l’ouest canadien) et un « dollar de l’est » (Québec et les Maritimes), contrôlées par la même autorité monétaire. T. Bayoumi et B.

2

Eichengreen (1993), dans une analyse de l’accord de libre-échange nord-américain, montrent la sous-optimalité de cette zone économique. Ils avancent que l’Ouest canadien a plus intérêt à partager la même devise avec l’Ouest américain qu’avec l’Ontario, le Québec et les Maritimes. Tremblay (1997) conclut que le Canada ne forme pas une zone monétaire optimale en se basant sur l’étude de la cointegration des PIB des différentes provinces mais plutôt que des sous-regroupements seraient profitables. Selon ses résultats, il rejoint la conclusion de Dudley (1973) qui divise le Canada en deux zones monétaires distinctes (Est et Ouest).

La structure économique du Canada s’est toutefois grandement modifiée au cours des dernières décennies, grâce aux grandes réserves de pétrole le rendant un producteur et exportateur net important. Tributaire de l’évolution du prix de l’or noir, le dollar canadien a connu une période d’appréciation importante depuis 10 ans faisant craindre une surévaluation de sa valeur, syndrome d’un potentiel « mal hollandais » pour le pays. Cependant, les réserves ne sont pas proportionnellement distribuées dans le pays, et l’Alberta concentre à elle seule 75% des réserves prouvées du Canada. Les provinces canadiennes ont donc désormais des structures économiques différentes, certaines misent sur les ressources naturelles et d’autres sur des activités industrielles et de services. Cette situation implique donc qu’une hausse du cours du pétrole représente un choc positif pour l’Alberta alors que pour d’autres régions non productrices, c’est un choc négatif. La présence de ces chocs asymétriques d’une province à l’autre pourrait remettre en cause l’optimalité de la zone monétaire du Canada.

Dans le cadre de cette étude, nous étudierons la cointégration entre les PIB des régions canadiennes, le PIB des États-Unis et le cours du pétrole WTI pour savoir si l’ensemble des provinces forme une zone monétaire optimale sur la période d’étude.

Dans un second temps, nous nous intéresserons plus particulièrement à l’étude des chocs exogènes. Si dans les années 1990 les chocs exogènes étaient asymétriques d’une province à l’autre. Il apparaissait cependant que certaines provinces répondaient aux chocs de manière assez semblables, et des « sous-régions économiques » apparaissaient, pouvant potentiellement partager une monnaie commune. Notre objectif sera de voir si aujourd’hui, les mêmes sous-régions économiques existent toujours, ou si de nouvelles apparaissent. Grâce à un modèle

3 VAR/VECM nous analyserons l’effet de chocs exogènes sur les économies des régions sélectionnées, afin de proposer nos conclusions quant à l’optimalité de la zone monétaire canadienne.

I. CRITERES DES ZMO TRADITIONNELLES.

L’apport initial de Mundell 1.

Mundell (1961) a été le premier à discuter du concept de zone monétaire optimale, en posant la mobilité des facteurs de production et le degré de « symétrie des réactions » face aux chocs externes comme principaux critères d'optimalité. La mobilité permet l'ajustement aux chocs asymétriques sans variation du taux de change et selon cet auteur, une zone économique sera monétairement optimale si les ajustements se font à « taux fixe » à l’intérieur de la zone et à « taux variable » avec l’extérieur.

En effet, après un choc de demande asymétrique affectant la zone, la main d’œuvre peut se déplacer de la zone où le chômage est en hausse vers la zone qui connait un regain d’activité. Ce transfert de travailleurs aura de fait un impact sur les deux zones composant ladite union monétaire : celle qui a vu une augmentation du taux de chômage connait parallèlement un déficit de la balance courante, tandis que l’autre région aura des excédents. Par le mécanisme de transfert de travailleurs, la demande de produit de la zone en déficit augmentera de manière à équilibrer la balance commerciale de cette dernière. Quant à la région en excédent, la hausse de sa population active entraînera une hausse de la demande des produits qu’elle exporte, et ceci jusqu’à l’équilibre. Grâce à la mobilité du facteur travail, les deux régions sont de nouveau à l’équilibre.

Lorsque ce mécanisme n’est pas présent, un choix doit être fait entre déflation et dépréciation. En effet, la réponse au choc de demande doit passer par une baisse des prix relatifs des produits exportables de la région qui subit le choc négatif. Il doit y avoir une dégradation des termes de l’échange pour la province déprimée, afin de stimuler l’exportation. La baisse du terme de l’échange peut passer soit par une baisse du coût de production via la baisse des salaires, soit par une dépréciation de la

4

monnaie. Si les prix et salaires sont rigides, la seule alternative est la variation du taux de change, mais en présence d’un régime de taux de change qui rend cette variation impossible (currency board, régime de change fixe) alors l’ajustement se fera par le recul de la production et la hausse du chômage.

Le deuxième critère cité réside dans le fait de savoir si les chocs affectant la zone sont surtout symétriques ou surtout asymétriques. Dans le premier cas, un évènement exogène aura un impact similaire sur la demande agrégée et/ou sur l'offre agrégée des différentes régions de la zone. Par exemple, les variations du prix du pétrole constituent des chocs d'offre symétriques pour les pays de la zone euro, alors que les

fluctuations de l'activité aux États-Unis constituent des chocs de demande symétriques pour les provinces canadiennes. Dans ce cas, les termes de l’échange ne seront pas touchés, ce qui peut permettre l’optique d’une union monétaire.

Le critère d’ouverture économique de McKinnon 2.

McKinnon (1963) ajoute un critère d’optimalité relié à l’ouverture économique à ceux analysés par Mundell. Par cela, nous entendons le rapport entre le volume de biens échangeables et celui de biens non-échangeables dans le PIB d’une économie. Plus ce rapport est élevé, plus l’ouverture au marché mondial est prononcée, en ce sens que les prix du pays considéré sont largement influencés par les cours internationaux (on considère une petite économie ouverte) et les variations des taux de change.

Plus un pays est ouvert au commerce extérieur, plus il aura intérêt à pencher vers un régime de change fixe avec ses principaux partenaire commerciaux; par contraste plus il sera fermé, plus l’alternative d’un régime flottant sera intéressante. McKinnon utilise deux notions pour mesurer le degré d’ouverture économique comme un critère d’optimalité : la sensibilité du volume de biens importés et des biens exportés aux variations de taux de change et l’impact sur la compétitivité-prix de l’économie. La première notion indique que plus un pays est ouvert sur l’extérieur, ce qui selon l’auteur correspond à une forte part des biens échangeables, plus la variation du taux de change aura un impact sur le volume de la demande internationale des biens exportables. Une appréciation de la devise domestique lèsera la capacité exportatrice de l’économie. En effet, si les biens échangeables représentent 60% des biens produits, une chute de 10% de la demande de biens exportables liée à l’appréciation de la

5 devise nationale nécessitera une hausse de 15% de la demande de biens non-échangeables pour garder le niveau revenu réel stable. Au contraire si la part des biens échangeables n’est que de 10%, la hausse nécessaire de la demande biens non-échangeables pour maintenir le revenu réel stable est de 1.1%.

Si l’on considère la deuxième notion utilisée par McKinnon, une ouverture forte impliquera de forts impacts de la variation du taux de change sur les prix relatifs des biens exportables et non-échangeables. Cette modification en termes relatifs des prix, combinée aux degrés d’élasticité de transformation et de substitution commerciales, aura comme effet la réallocation des facteurs de production vers le secteur le plus efficace. Si le taux de change fluctue constamment, le secteur des biens non-échangeable est parfois plus intéressant pour les entreprises, alors que c’est celui des biens échangeables à d’autres moments, ce qui conduit à une instabilité et rend le régime de change fixe plus intéressant.

Le critère de diversification de la production 3.

Kenen (1969) définit comme critère d’optimalité le degré de diversification productive. Il nous éclaire sur le lien existant entre le type de régime de change à adopter et le degré de diversification productive. Plus une économie sera polyvalente en terme de production, plus elle pourra adopter un régime de taux de change fixe, car les chocs externes sur la demande des produits exportés se compenseront en moyenne et maintiendront les recettes stables.

De plus, au niveau d’une zone économique impliquant plusieurs pays, plus les productions nationales seront spécialisées, plus elles peuvent faire face à des chocs asymétriques. Il sera donc d’autant plus intéressant pour les régions d’une zone économique de partager la même devise qu’elles verront leurs productions diversifiées. Ces économies seront capables de compenser les effets néfastes de l’instabilité de la demande de certains produits et de palier à la faible mobilité des facteurs.

En outre, si l’on s’intéresse au taux de chômage, la baisse de la demande étrangère d’un produit aura d’autant plus d’effet sur le taux de chômage que la zone est spécialisée et qu’elle est sous un régime de change fixe. Kenen apporte ainsi comme argument, qu’une modification du taux de change pour annuler l’effet négatif d’un

6

choc de demande sur le taux de chômage sera d’autant plus efficace que l’économie est peu diversifiée.

En conclusion, Kenen suggère aux petits états spécialisés de conserver un régime de change flexible, afin de pouvoir se protéger des chocs négatifs de demande et des détériorations des termes de l’échange.

L’intégration financière comme critère d’optimalité 4.

Le critère d’intégration financière est aussi à souligner. En effet, une union monétaire nécessite des transferts compensateurs pour rééquilibrer les balances de paiements des économies la formant. Plus deux pays seront intégrés financièrement plus il sera facile de combler les déficits sans toucher aux taux de change et aux taux d’intérêt. Par contraste les critères des auteurs précédents laissent peu de place au rôle de la monnaie : en effet, dans leurs modèles, les prix sont exprimés en terme réel de l’échange et les ajustements se font directement sur le solde du compte courant. Selon Ingram (1969), il devient nécessaire de regarder le degré d’intégration financière à « court terme » et à « long terme » comme un autre critère d’optimalité.

Si l’intégration est faible, alors la différence des structures des taux d’intérêt se répercute sur les taux d’intérêt à long terme, car à court terme les investisseurs peuvent se couvrir grâce aux marchés forward et d’options. La difficulté des échanges à long terme des titres financiers entre les différentes économies peuvent être à l’origine d’instabilité de la balance des paiements. En effet, à court terme une baisse du différentiel d’intérêt mène à un retrait du capital de l’économie.

Du point de vue d’Ingram (1969), l’intégration financière à long terme est la plus importante pour juger si deux économies sont aptes à former une union monétaire. Il reconnait néanmoins qu’en présence de taux de change fixe et d’une séparation institutionnelle des marchés financiers, la présence d’attaques spéculatives peut avoir lieu. Si un taux de change fixe existe entre les deux zones et que les marchés financiers sont libres dans la zone de la future union, seule une faible partie des variations des taux d’intérêt seront affectées par le mouvement des capitaux entre les deux zones. Il apparait que plus des économies sont intégrées financièrement, plus elles peuvent conserver un régime de change flexibles, alors que dans le cas contraire, un change fixe est de mise.

7

II. ENDOGENEITE

OU

EXOGENEITE

DES

CRITERES

D’OPTIMALITE ?

Les études menées sur l’optimalité des zones monétaires ont connu une réorientation sans doute influencée par la création de la Zone Euro qui est un cas d'application de la doctrine économique. La nouvelle approche, dite des critères endogènes, postule que l'union monétaire produit d'elle-même les conditions de son optimalité. L’évolution à travers le temps des critères traditionnels, les rendant endogènes au fonctionnement d'une zone monétaire, montre que l’appréciation doit se faire ex post. Nous nous attarderons dans un premier temps aux apports de Frankel et Rose (1996), pour qui la corrélation des cycles d’affaires et le commerce constituent les pivots à étudier. Ensuite, nous nous pencherons sur l’homogénéité des préférences présentée par Bourguinat (1973) et Kindleberger (1986) qui apparait comme critère endogène. Cependant certains auteurs, notamment Krugman (1993) et Eichengreen (1991) montrent les limites de cette vision endogène et proclament plutôt qu’au contraire les critères étudiés sont totalement exogènes du fait de l’union.

Critères optimaux endogènes selon Frankel et Rose 1.

Selon Frankel et Rose (1996), le processus d’intégration monétaire est endogène dans la mesure où l’union monétaire renforce la symétrie des chocs et justifie « ex-post » la création d’une devise commune. Ils mettent en avant deux conditions importantes pour évaluer les gains résultant des unions monétaires, à savoir la corrélation des cycles d’affaires et le niveau du commerce bilatéral.

8

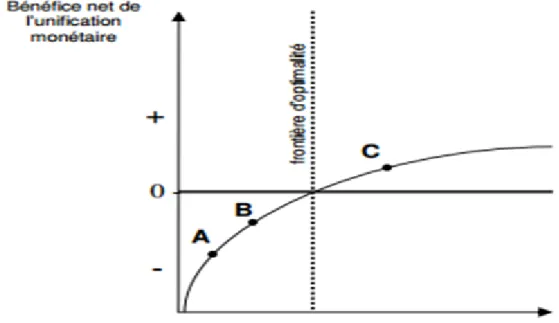

Figure 1 : La frontière d’optimalité

Un ensemble de pays ont alors intérêt à mettre en place une union monétaire lorsqu’ils ont un niveau d’échange élevé et/ou une corrélation forte de leur cycle économique. Dans la Figure 1, la frontière d’optimalité marque le moment où le partage d’une même devise devient la meilleure solution. Les pays se trouvant en dessous de la frontière auront intérêt à conserver leur souveraineté monétaire alors qu’au-dessus, l’union monétaire devient une meilleure alternative. De plus, Frankel et Rose (1996) démontrent que la corrélation des cycles d’affaires augmente à mesure que l’intégration commerciale s’intensifie, réduisant par la même occasion les chocs asymétriques. Il en résulte des gains à l’union, même si l’on prend en compte les coûts engendrés par la perte d’autonomie de la politique monétaire nationale.

La mise en place d’une monnaie unique rend les partenaires plus aptes à remplir les conditions d’optimalité. En effet, l’intégration monétaire réduit les coûts de transaction au-delà des simples économies liées à l’élimination de la volatilité des changes. Une monnaie commune est perçue par les acteurs économiques comme un engagement durable et plus stable qu’un système de changes fixes, car elle exclut toute possibilité de dévaluation compétitive. En résumé, une monnaie commune est une sorte de catalyseur, qui permet la propagation des gains de productivité d’une région aux

9 autres, l’intensification du commerce intra-zone et le renforcement de l’intégration économique et financière.

Figure 2 : Bénéfices/pertes d’une unification monétaire

Sur la Figure 2 le bénéfice net de l’unification monétaire est négatif pour un groupe de pays qui serait au point A ou B en suivant les recommandations de la théorie traditionnelle; la formation d’une union monétaire serait donc inenvisageable. Malgré tout, si ce groupe de pays décide de partager la même monnaie il y aura un renforcement de l’intégration commerciale et de la symétrie des cycles d’affaires. Le groupe de pays se situe dorénavant au point C, soit dans la zone de bénéfice net positif. Les implications d’un tel résultat sont importantes : la capacité de certaines régions du monde à former des zones monétaires optimales devrait être nécessairement reconsidérée à la hausse. Si la satisfaction des critères d’optimalité n’est pas avérée avant l’unification monétaire il est certainement possible qu’elle le devienne ex-post.

Critère endogène des préférences homogènes 2.

Toujours dans la littérature des intégrations régionales, un nouveau volet a été ouvert par plusieurs auteurs, notamment Bourguinat (1973) et Kindleberger (1986). Ces auteurs soulignent que pour atteindre une union monétaire, les différentes régions ou

10

pays aspirant à l’unification monétaire doivent partager les mêmes « préférences » et être averse aux mêmes risques. Ils décrivent un nouveau critère d’optimalité, à savoir celui des « préférences homogènes ».

L’homogénéité des préférences est présentée pour la première fois par Bourguinat en 1973. Son analyse des politiques monétaires dans la C.E.E (organisation supranationale créée en 1957 pour mener une intégration économique entre la RFA, la France, l'Italie et le Benelux) montre qu’en plus des critères traditionnels cités précédemment, deux autres conditions sont requises pour rendre une union monétaire optimale : la convergence longue des indicateurs économiques et la circulation libre des actifs dans l’ensemble de la zone.

Dans un premier temps, Bourguinat postule qu’au-delà de l’intensification des échanges commerciaux à l’intérieur de la CEE, c’est la convergence des taux de productivité et compétitivité qui reste à observer. Lorsqu’une convergence des prix et des taux d’inflation est visible parallèlement, alors l’optique d’une union monétaire devient intéressante.

Des divergences des balances de paiements peuvent toutefois survenir malgré une convergence des différents taux cités précédemment et un mécanisme de compensation doit être mis en place pour les rééquilibrer. Ce dernier ne peut se faire que s’il y a totale « accessibilité » des actifs. Il est donc absolument nécessaire que des valeurs mobilières soient reconnues et acceptées partout dans la zone. Les différentes économies doivent se mettre à accepter et reconnaitre les différents titres financiers et monétaires de ses co-adhérents.

Pour Kindleberger (1986) les critères traditionnels (mobilité des facteurs, ouverture des économies et la diversification de la production) sont les conditions primaires nécessaires d’une union monétaire. Cependant, l’existence d’un accord entre les pays membres sur les grandes préférences liées aux objectifs futurs doit être absolument discutée. La réalisation d’une telle condition nécessite une forte intensité des échanges et des préférences identiques ou proches à la fois sur les biens et services qu’ils échangent et ceux collectifs.

11 La critique de la théorie du commerce international par Krugman

3.

Krugman rejette catégoriquement l’idée d’endogénéité des critères d’optimalité. En effet, il s’appuie sur la théorie du commerce international pour dresser une optique moins optimiste que Frankel et Rose. Il considère que l'intégration économique, financière et monétaire mène nécessairement les économies vers une spécialisation à l'intérieur de la zone économique. Les différentes économies de l’union se spécialisent dans la production dans laquelle elles ont un avantage comparatif. Les pays deviennent de moins en moins diversifiés et ont des cycles d’affaires de moins en moins corrélés, ce qui rend l'utilisation d'une même monnaie plus difficile.

Chaque pays réagit en effet aux évolutions spécifiques du secteur dans lequel il se spécialise. Ce paradigme appelé “lessons of Massachusetts” est celui qui a été développé durant le 20e siècle aux Etats-Unis dans beaucoup de secteurs avec le regroupement des industries automobiles autour de Détroit, des industries informatiques dans Silicon Valley, etc. Plus généralement, la théorie du commerce international implique une spécialisation accrue de chacun des membres de l'union monétaire, les rendant plus vulnérables aux chocs d’offre et transformant les chocs autrefois symétriques en chocs asymétriques.

Cependant il est assez dangereux d'utiliser le cas des États-Unis pour illustrer cette thèse car les revenus des états américains sont de plus en plus corrélés depuis un demi-siècle grâce au fédéralisme fiscal.

Les nations forment-elles des unions monétaires parce qu'elles commercent beaucoup entre elles ou commercent-elles beaucoup entre elles parce qu'elles forment des unions monétaires potentielles ? Il est difficile de trancher entre les paradigmes de la spécialisation de Krugman rendant le processus d’unification monétaire exogène, et l’endogénéité que l’on retrouve chez Frankel et Rose et chez Bourguinnat et Kindlelberger.

12

III. LES NOUVEAUX CRITERES D’UNE ZMO.

Crédibilité des zones à travers des critères de convergences 1.

L’évolution de la théorie des zones monétaires optimales a montré que l’analyse traditionnelle de celles-ci n’est plus suffisante. En conséquence, les critères récents prennent en considération la crédibilité de la banque centrale de la zone et la cohérence temporelle.

La crédibilité de la zone économique passe par la convergence des différentes variables non plus seulement en termes réels mais aussi en termes nominaux. L’objectif devient de placer les différentes régions de la zone sur la même trajectoire économique en terme de chômage, de croissance de l’output et d’inflation. Autrement les politiques des différents pays pourraient mener à augmenter les chocs asymétriques et donc rendre l’union non-optimale et impossible. La convergence doit être étudiée sur trois volets : la convergence nominale, la convergence réelle et la convergence structurelle.

La convergence nominale correspond à la convergence des taux d’inflation des régions composant la zone économique. Grâce à la théorie de la parité des pouvoirs d’achat, l’idée de stabilité monétaire mène à la convergence des taux d’inflation. En effet, selon cette loi, on considère le taux de change comme étant le rapport des prix domestique (p) sur les prix étrangers (p*), soit e = p/p*. En termes de variations, ce rapport devient dln(e)/dt =dln(p)/dt - dln(p*)/dt, et exprime la variation du taux de change comme étant le différentiel d’inflation. Des politiques préalables sont donc nécessaires afin d’aligner les différent taux d’inflation pour qu’il y est stabilité monétaire et pas de changement dans les termes d’échanges. Dans le cas européen, Jacquelain (2004) montre l’existence d’un processus de politique de désinflation dans l’ensemble des états de l’ex bloc communiste afin de prétendre à l’adoption de l’euro.

La convergence réelle correspond à la convergence des taux de croissance économique des régions composant la future union monétaire. En effet, une divergence de ces taux mènerait inéluctablement à des déséquilibres des balances de paiements. À travers une asymétrie des échanges, les pays de la zone concernée verraient nécessaire soit un relâchement de leur croissance pour revenir à la moyenne de croissance de la zone, soit à un changement des parités de change, ce que connait la zone euro aujourd’hui.

13 Par convergence structurelle, on entend les convergences de nature technologique entre les différents pays de la zone. En effet, la théorie schumpéterienne et les théories de la croissance endogène montrent qu’une différence de niveau technologique et de capital humain propulse les économies dans des sentiers de croissance différents, jusqu’à même faire diverger les économies au fil du temps.

L’importance de tenir compte de cette convergence réside dans le fait que dans une union monétaire, l’exercice de la politique monétaire et celle de change n’est plus une prérogative souveraine. Dans ce cas, les économies partant de niveau technologique initial moins favorable ne peuvent plus utiliser le taux de change pour compenser des écarts cumulatifs de productivité ou de compétitivité et risquent d’être obligées d’emprunter des sentiers de faible croissance et de chômage élevé pour respecter la contrainte de parité fixe. Dans un tel cas, le pays n’a pas intérêt à accepter un tel régime de change.

Au final, l’optimalité d’une union monétaire passe par la convergence des taux d’inflation, de croissance et de niveau technologique. Ainsi les différentes économies se voient évoluer dans le même sentier de croissance, écartant ainsi les risques de divergence de productivité et les asymétries des balances de paiements, permettant ainsi d’éviter que les chocs exogènes ne viennent fragiliser les économies nationales, comme ce qui se passe en Europe depuis 2010.

Solidarité de la zone monétaire 2.

Par solidarité, il faut comprendre qu’au-delà de définitions purement économiques et financières une sorte « d’altruisme étatique » doit être mis en place. Par ce terme on entend une propension à accepter des transferts de fond vers une région qui est en besoin. En ce sens l’altruisme mesure « l’aptitude d’un pays à accepter le coût de la gestion d’un autre » (Ossa 2000). Cette solidarité mesure la capacité des régions formant l’union monétaire à s’aider, sachant que toute dévaluation pour redynamiser une économie affaiblie devient impossible.

Ossa (2000) montre que l’union monétaire deviendra optimale si la solidarité entre les candidats à l’union est plus forte qu’avec de tiers pays ou régions. La « solidarité » se traduit par des transferts de capitaux visant à rééquilibrer les balances et devient une condition nécessaire à la mise en place d’une monnaie unique.

14

IV. EFFETS DE CHOCS DANS UNE UNION MONETAIRE.

La perte de l’autonomie de politique monétaire représente un outil de politique public en moins. Selon Burda et Wyplosz (2009) afin que cette perte ne représente pas un coût, il devient nécessaire que les chocs soient symétriques, c’est-à-dire qu’ils touchent l’ensemble de zone de manière homogène.

Dans la théorie relative aux zones monétaires optimales l’absence d’asymétries de chocs s’ajoute donc aux critères « traditionnels » et « nouveaux ». En ce sens, plus deux pays possèdent des structures économiques et productives proches, moins ils sont sujet à des chocs spécifiques.

Afin de visualiser les conséquences de chocs d’offre et de demande, nous allons utiliser le cadre théorique IS-LM-BP et celui d’offre et de demande agrégée.

Chocs exogènes asymétriques d’offre 1.

Un choc d’offre peut être la conséquence d’une amélioration technologique, qui rend la productivité plus élevée

.

De ce fait, nous allons observer, dans le modèle d’offre agrégée/demande agrégée, un déplacement vers la droite de l’offre agrégée. Pour un même niveau de prix, la production sera donc plus élevée. L’augmentation de la production par unité de stock de capital entraîne à long terme une hausse plus importante de la production et une nouvelle baisse du niveau général des prix.Un problème potentiel de décalage structurel apparaît donc entre les différent pays de l’union. Ne pouvant pas être « menacée » par une dévaluation de la monnaie de l’autre économie compte tenu de la perte de la souveraineté de la politique monétaire, la région de l’union connaissant un choc positif d’offre se transformera en principal fournisseur de biens et services. Une spécialisation des régions de l’union en fonction de leur productivité est donc observée, et les risques que les chocs deviennent asymétriques s’accroissent. La question de la capacité d’innovation technologique devient importante dans la prise en compte de l’optimalité d’une zone monétaire. Il en résulte qu’une convergence en terme de productivité, de politique de recherche et développement et de PIB par tête doit être recherchée afin d’éviter des chocs asymétriques d’offres.

15 Chocs exogènes asymétriques de demande

2.

Un choc exogène de demande peut prendre la forme d’une augmentation de la demande étrangère pour les produits domestiques. Cette hausse entraîne une croissance des exportations nationales et une amélioration du solde du compte courant. Dans le cadre d’analyse IS-LM-BP, cela se traduit d’abord par un déplacement vers le nord-est de la courbe IS. Nous nous retrouvons donc avec un nouvel équilibre caractérisé par une hausse du taux d’intérêt et du niveau de production et donc ceteris

paribus, une entrée de capitaux qui devrait générer une appréciation du change. Or,

dans une zone de change fixe, cette hausse est impossible et un déséquilibre va plutôt se créer. Ne pouvant utiliser le change, les autorités monétaires devront jouer sur le marché de la monnaie (LM) afin de faire descendre le taux d’intérêt au niveau d’équilibre. Ce processus va se poursuivre aussi longtemps que les rendements des actifs domestiques restent supérieurs à ceux de l’étranger.

Au niveau de la demande et de l’offre agrégée, à court terme nous allons nous retrouver dans un nouvel équilibre caractérisé par une augmentation des prix et du niveau de production. Le niveau de salaire réel baissant, cela encourage à l’embauche, mais la combinaison des deux va pousser à la hausse les salaires nominaux quand les agents vont se rendre compte de la baisse du niveau réel.

A long terme, la courbe d’offre agrégée devient verticale, elle ne dépend plus alors que de l’offre de travail, du stock de capital et du niveau technologique utilisé pour transformer ces ressources en biens et services. Au final l’économie revient à son niveau initial, mais avec un niveau de prix plus élevé.

Dans le cas d’une union monétaire où théoriquement il n’existe plus qu’une seule banque centrale et un seul taux d’intérêt, les choses se compliquent si les économies sont trop divergentes. En effet, dans ce cas lorsqu’ une région est lésée par la hausse des prix et l’autre en tire avantage. Les seules solutions offertes aux pays de l’union pour lutter contre ces chocs sont au niveau des politiques budgétaires et du fédéralisme fiscal.

16

V. COORDINATION DES POLITIQUES BUDGETAIRES ET

FEDERALISME FISCAL

Synchronisation des politiques budgétaire 1.

La coordination peut être envisagée sous deux angles selon Jacquet et Pisani-Ferry (2000) : l’un considérant que l’objectif de la coordination est de fournir et de préserver des biens publics internationaux ("coordination bien public"), l’autre appréciant la coordination comme une réponse aux interdépendances économiques entre pays ("coordination stratégique"). La coordination devient nécessaire car les politiques budgétaires d’un état membre ont des impacts plus ou moins importants, dépendamment des élasticités et des niveaux des multiplicateurs, sur les autres économies de l’union. Ne pas coordonner les politiques économiques mènerait à un équilibre sous-optimal, d’où la nécessité de les synchroniser. Cette coordination est d’autant plus nécessaire que les différentes conjonctures nationales demandent des réponses budgétaires adaptées.

Commerce extérieur, taux d’intérêt, fiscalité sont les canaux par lesquels s’expriment les « externalités budgétaires » ou « effets de débordement ». En effet, la hausse du déficit public dans un pays stimule les importations du pays et donc les exportations des autres, alors qu’un déficit budgétaire conduit normalement à une hausse des taux d'intérêt.

Une relance budgétaire dans un grand pays peut donc conduire à une hausse des taux d'intérêt directeurs de l'ensemble de la zone menant à une appréciation du taux de change de la devise unique.

Au total, les pays partenaires de celui où a lieu la relance peuvent souffrir d'une hausse des taux d'intérêt et d'une éventuelle appréciation du taux de change, qui peuvent rendre les chocs asymétriques.

Du côté de la fiscalité, une baisse des impôts dans un pays peut avoir pour conséquence d'attirer des entreprises au détriment des autres pays. La stimulation de l’offre et de la demande faisant suite à une baisse de la fiscalité ne garantit pas une hausse des importations, ce qui obligera les économies partenaires à s’aligner sur la

17 fiscalité du pays ou rationner les dépenses publiques. De plus, des effets d’offre peuvent se réaliser à travers l’indice de prix de la zone économique après une modification de la fiscalité (par exemple une variation des taxes sur la valeur ajoutée). Dans un travail prenant en compte l’ensemble des canaux de transmission, Bénassy-Quéré et Cimadomo (2006) montrent que les externalités budgétaires sont positives, mais qu'elles tendent à diminuer au cours du temps. En revanche, une relance par baisse des impôts ou hausse des transferts publics affecte positivement les autres pays. Au final, les effets de débordement sont vraisemblablement positifs au sens où une hausse du déficit budgétaire dans un pays élève la demande dans les pays voisins.

Fédéralisme budgétaire et fiscal 2.

En réponse aux chocs asymétriques, les politiques budgétaires et fiscales sont la plupart du temps décidées de manière autonome au sein de l’union monétaire (comme c’est le cas dans l’union européenne). Or cette absence de coordination rend sous-optimale l’union monétaire. Johnson (1970) propose l’intégration fiscale comme nouveau paramètre pour mesurer l’optimalité de l’union monétaire suite à la perte de l’autonomie monétaire comme moyen d’ajustement. Ce nouveau critère « se définit à travers la présence d’un mécanisme de stabilisation automatique des déséquilibres entre régions » (Trichet 2003).

Selon Johnson ou encore Zumer (1999) la mise en place d’un budget fédéral devient nécessaire pour faire face aux chocs asymétriques frappant l’union. Chaque état membre se verra attribuer une quote-part du budget fédéral, celle-ci sera variable en fonction de l’activité économique et du niveau d’allocation chômage à distribuer. « En cas de choc asymétrique favorable à certains membres de la zone et défavorable aux autres, les recettes fiscales prélevées par la structure fédérale augmenteraient mécaniquement dans les pays favorisés et baisseraient dans les pays défavorisés, tandis que les dépenses fédérales progresseraient au bénéfice des pays défavorisés et diminueraient (ou augmenteraient moins) dans les pays favorisés » (Christian 2011). Sans ce mécanisme, le recours à l’emprunt et une hausse de la dette nationale devient inévitable, ce qui peut conduire à la question de la soutenabilité de la dette nationale et de la solvabilité du pays.

18

Aussi, la variation des parts allouées au budget joue un rôle de stabilisateur automatique, freinant l’expansion par les prélèvements fiscaux d’un côté et neutralisant la chute de l’activité de l’autre. « Au total, pour Johnson une forte intégration fiscale par le biais d’un budget fédéral est de nature à réduire les effets d’un choc asymétrique » (Trichet 2003).

Au final, nous nous rendons compte qu’un fédéralisme fiscal a deux fonctions, d’une part la redistribution et d’autre part la stabilisation. Zumer (1998) décrit la « redistribution » comme étant le mécanisme qui tend à réduire à long terme les inégalités structurelles entre les régions et la stabilisation comme un système budgétaire central qui amortit un choc conjoncturel subi par une ou plusieurs régions.

19

Partie 2 : ETUDE ECONOMETRIQUE

L’objectif de notre étude est de considérer la question suivante : Est-ce que les provinces canadiennes forment une zone monétaire optimale? Nous allons considérer cette question en étudiant la symétrie des réponses de l’activité économique des provinces canadiennes suite à un choc sur le PIB des États-Unis, le principal partenaire commercial du Canada, et suite à un choc sur le prix du pétrole WTI, référence de base sur le cours du pétrole en Amérique du Nord.

La première étape de cette étude économétrique consiste en l’analyse des séries chronologiques à travers l’étude de leur stationnarité et de la présence de relation de cointégration entre les variables. En fonction des résultats obtenus dans cette première étape, la seconde sera l’estimation d’un système de type VAR (Vector Autoregressive) en cas de non-cointégration, ou d’un systeme VECM (Vector Error Correction Model) s’il y a cointégration. Finalement l’étude des réponses impulsionnelles et des décompositions des variances nous permettra d’évaluer à quel point les provinces canadiennes répondent de manière symétrique ou asymétrique aux chocs. Ces résultats serviront de base à notre discussion sur l’optimalité de la zone monétaire canadienne.

Pour mener cette étude, nous avons sélectionné cinq provinces canadiennes pour représenter la diversité de la fédération canadienne: le Nouveau-Brunswick, le Québec, l’Ontario, l’Alberta et la Colombie-Britannique. L’estimation du VAR/VECM se basera sur un échantillon allant du premier trimestre 1987 au quatrième trimestre 2013 et utilisera les données suivantes : le PIB réel trimestriel pour chacune de ces provinces, de même que le PIB réel américain et le cours du pétrole WTI. Les données sur les PIB provinciaux, sur le PIB des Etats-Unis et le cours du pétrole WTI proviennent du Conference Board du Canada (http://www.conferenceboard.ca/e-data/anonymous.aspx). Toutes les données sont utilisées en logarithme et sont représentés par les acronymes suivants : LAL correspond au logarithme du PIB réel de l’Alberta, LBC au logarithme du PIB réel de la Colombie-Britannique, LON au logarithme du PIB réel de l’Ontario, LQC au logarithme du PIB réel du Québec, LNB au logarithme du PIB réel du Nouveau-Brunswick, LUSA au logarithme du PIB réel des États-Unis et LWTI au logarithme du cours du pétrole WTI.

20

VI. ANALYSES DES SERIES TEMPORELLES

La stationnarité est une propriété de base à rechercher dans l’analyse de séries chronologiques. En effet un modèle construit avec des variables non stationnaires peut conduire à des résultats biaisés et des statistiques de test qui ne correspondent à aucune vérité structurelle. Il est donc indispensable d’analyser la stationnarité de l’ensemble des séries que nous voulons utiliser. Il existe deux formes de stationnarité (Lardic et Mignon 2002) : d’une part la stationnarité dite forte et d’autre part la stationnarité faible. Dans le cadre de notre étude, nous abordons la question de stationnarité à travers celle dite faible.

La stationnarité et les tests de racines unitaires. 1.

La stationnarité dite faible implique qu’une variable aléatoire ait une espérance, une variance et une covariance avec ses valeurs passées constante dans le temps. Les conditions sont donc les suivantes :

( ) ( )

( )

( ) ⟦( )( ⟧

Les tests de racine unitaire permettent d’examiner la stationnarité d’une série temporelle. La littérature en la matière propose trois types de tests : Dickey-Fuller, Philips-Perron et Kwiatkowski-Phillips-Schmidt-Shin. En plus de détecter la présence d’une racine unitaire, ces tests permettent de savoir si la non-stationnarité est de type déterministe ou de type aléatoire. En fonction du type de processus suivi, la stationnarisation choisie sera différente.

Dans notre étude nous utilisons d’abord le test de Dickey-Fuller Augmenté (1981) qui généralise le test de Dickey-Fuller simple en relâchant l’hypothèse que les erreurs du modèle sont des bruits blancs.

21 ∑ [ ] ∑ [ ] ∑ [ ]

Ici, le nombre de retards p permettant de rendre les erreurs des bruits blancs peut être obtenu par minimisation des critères d’informations tels que ceux de Schwartz et d’Akaike.

Le test ADF se déroule en deux étapes. D’abord nous testons la significativité de la tendance (i.e le coefficient b dans le modèle 3). Si la tendance est significativement différente de 0 alors nous passons au test de stationnarité, soit l’hypothèse H0 : ρ=0 tel qu’il y a présence d’une racine unitaire et donc non-stationnarité. Si nous acceptons H0, on conclut que la série suit un processus en tendance, et la stationnarisation doit passer par le calcul des résidus par rapport à une tendance estimée par MCO.

Dans le cas où la tendance n’est pas significative (i.e. b = 0), nous devons passer par le modèle 2 et commencer par voir si la constante (i.e. le coefficient c) est significative. Si le terme c est significativement différent de 0, alors nous passons au test de stationnarité, soit l’hypothèse H0 : ρ = 0. Si nous acceptons H0, on conclut à la présence de racine unitaire et si nous ne la rejetons pas, alors nous sommes en présence d’une série suivant un processus de marche aléatoire avec dérive.

Dans le cas où la significativité de la constante est rejetée nous procédons à un test de racine unitaire avec le modèle sans constante et tendance (i.e. modèle 1). Si l’hypothèse nulle H0 est rejetée alors nous sommes en présence d’une série stationnaire.

Pour confirmer le test ADF, nous utiliserons également le test de Phillips-Perron (PP), qui suit la même méthodologie, et celui de Kwiatkowski- Phillips-Schmidt-Shin (KPSS), qui propose la stationnarité comme hypothèse nulle. Pour chacun des tests, nous prenons la décision en comparant les valeurs critiques au seuil de 5 %.

22

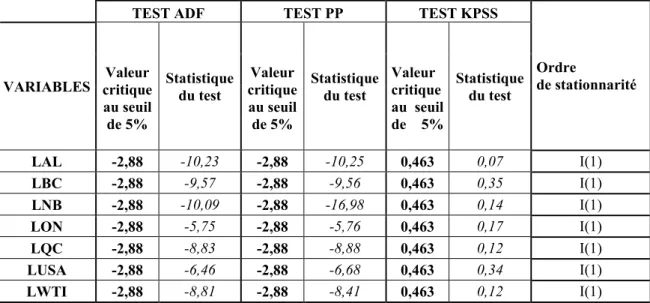

Pour les trois tests utilisés, si la valeur de la statistique du test est inférieure en valeur absolue à la valeur critique tabulée, nous acceptons l’hypothèse nulle. Il apparait dans le Tableau 1 que l’ensemble des séries de PIB (i.e. LAL, LBC, LON, LQC, LNB et LUSA) ne sont pas stationnaires et suivent plutôt des processus de marche aléatoire avec dérive, alors que la série LWTI n’est pas stationnaire mais suit une marche aléatoire sans dérive. Afin de rendre ces séries stationnaires nous les avons différenciés une fois. L’analyse de l’ensemble des 6 séries de PIB et de la série du WTI montre qu’elles sont stationnaires grâce à une intégration d’ordre 1.

Tableau 1 : Tests de stationnarité des variables intégrées d’ordre 1

TEST ADF TEST PP TEST KPSS

Ordre

de stationnarité VARIABLES critique Valeur

au seuil de 5% Statistique du test Valeur critique au seuil de 5% Statistique du test Valeur critique au seuil de 5% Statistique du test LAL -2,88 -10,23 -2,88 -10,25 0,463 0,07 I(1) LBC -2,88 -9,57 -2,88 -9,56 0,463 0,35 I(1) LNB -2,88 -10,09 -2,88 -16,98 0,463 0,14 I(1) LON -2,88 -5,75 -2,88 -5,76 0,463 0,17 I(1) LQC -2,88 -8,83 -2,88 -8,88 0,463 0,12 I(1) LUSA -2,88 -6,46 -2,88 -6,68 0,463 0,34 I(1) LWTI -2,88 -8,81 -2,88 -8,41 0,463 0,12 I(1)

Les relations de cointégration et les tests associés. 2.

L’analyse de la cointégration présentée par Granger (1983) et Engel et Granger (1987) devient incontournable afin d’éviter le risque d’estimation « fallacieuse » et de rendre les interprétations sous-jacentes fausses. En effet, plusieurs variables économiques peuvent fluctuer de manière indépendante à court terme et mais être liées par un équilibre à long terme : dans ce cas la modélisation ECM (Error Correction Models) est plus appropriée.

Selon la méthodologie d’Engel et Granger, l’exploration de la cointégration de deux variables se fait en deux étapes. D’une part nous devons tester le degré d’intégration des séries et d’autres part estimer la relation de long terme. Il est nécessaire de

23 déterminer grâce aux tests de racine unitaire le type de processus que suivent les deux séries puis de connaitre l’ordre d’intégration des séries temporelles. En effet, deux séries n’étant pas intégrées du même ordre ne peuvent avoir de relation de cointégration. Posons que les variables xt et yt soient intégrées d’ordre d,

l’estimation de la relation de long terme se fera par les MCO et nous donnera yt = a1

xt +a0 + εt. Si le résidu et = yt - â1 xt – â0 de la régression s’avèrait être stationnaire

alors il existe une relation de cointégration.

La généralisation à k (> 2) variables devient plus complexe, l’existence potentielle de plusieurs vecteurs de cointégration linéairement indépendants rendant la méthodologie d’Engel et Granger inutilisable (sauf s’il existe un seul vecteur de cointégration).

Afin de connaitre le rang de la cointégration (i.e. le nombre de relations de cointégration) nous allons suivre l’approche de Johansen (1988). Il a construit deux tests (test de la trace et test de la valeur propre maximale) basés sur les valeurs propres d’une matrice calculée à partir de 2 régressions nous donnant 2 résidus ut et

vt de dimension k (i.e nombre de variables) et n (i.e nombre d’observations) de ces

deux résidus nous calculons quatre matrices variances-covariances permettant d’extraire les valeurs propres de la matrice calculée. Il devient possible de déterminer le nombre de relations de cointégration entre plusieurs séries. Les hypothèses des deux tests sont les suivantes :

H0 : les séries ne sont pas cointégrées ;

H1: il existe au moins une relation de cointégration entre les séries.

Nous nous intéressons au ratio de vraisemblance et à la valeur critique du test. Si le rang de cointégration est égal à zéro, alors nous acceptons l’hypothèse nulle, dans le cas contraire le logiciel Eviews nous indique le rang de cointégration de la matrice. Il est cependant possible que les deux tests donnent des rangs différents : dans ce cas, nous considérons le test de la trace.

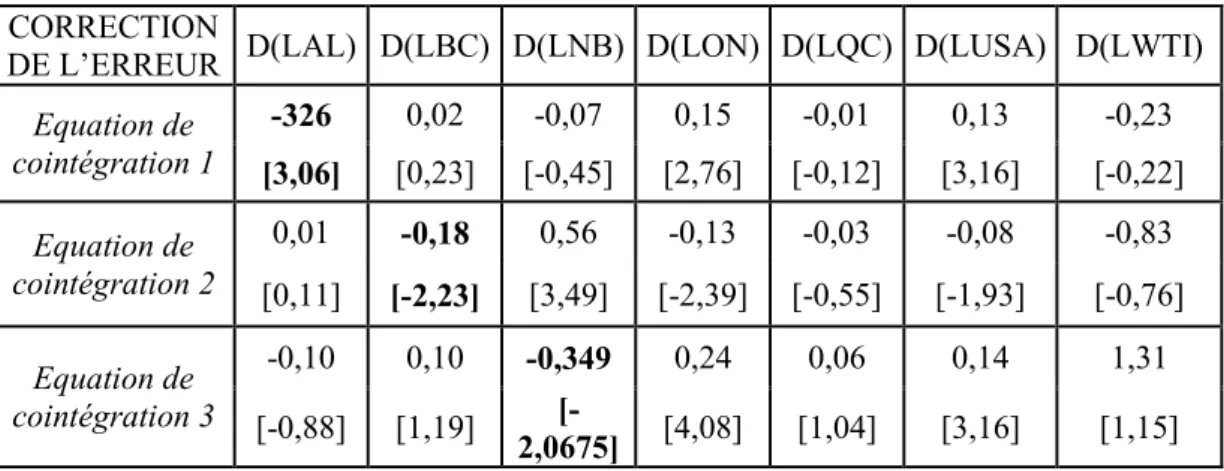

Le Tableau 2 rapporte les résultats. Dans celui-ci, le test de la trace nous indique l’existence de trois relations entre les PIB des provinces canadiennes, du PIB des États-Unis et du prix du pétrole WTI. Étant donné que l’ensemble des séries des PIB suivent une marche aléatoire avec dérive et que la série du prix WTI suit un processus de marche sans dérive, nous allons spécifier qu’il y a absence d’une

24

tendance linéaire dans les séries et absence d’une constante dans les relations de cointégration. On va donc considérer qu’il existe trois relations de cointégration dans notre base de données

Tableau 2 : Test de Johansen non-restreint (test de la trace)

Echantillon ajusté 1987Q3 2013 Q4

Hypothèse de tendance : Type déterministe et linéaire Séries: LAL LBC LNB LON LQC LUSA LWTI

Série exogène : DUM (La série exogène DUM a été introduite afin de corriger les effets de la crise économique de 2008)

Test de Rang de Cointégration Non-restreint (Trace) Relation de

cointégration

hypothétique Valeur-propre Trace

Valeur critique 5% Prob** Aucun* 0,44152 167,1612 125,6158 0 Au moins 1* 0,278636 105,401 95,75366 0,0092 Au moins 2* 0,247594 70,78023 69,81889 0,0418 Au moins 3 0,170583 40,62549 47,85613 0,2009 Au moins 4 0,084211 20,80005 29,79707 0,3702

Le test de la Trace indique l’absence de cointégration au seuil de 5%

* denote le rejet de l’hypothèse de cointégration au seuil de 5% **

MacKinnon-Haug-Michelis (1999) p-values

VII.

LA REPRESENTATION VECM

Le modèle VECM est une modification à la représentation VAR qui s’applique lorsque les séries ne sont pas stationnaires en niveau et qu’elles présentent des relations de cointégration. Le modèle VECM inclut ces relations dans la spécification de manière à ce qu’à long terme, les variables endogènes convergent vers l’équilibre représenté par les relations de cointégration, tout en permettant des ajustements dynamiques de court terme. Le terme de cointégration est le terme de correction puisque la déviation de l’équilibre de long terme est graduellement corrigée à travers une série d’ajustements partiels de court terme. C’est pourquoi les coefficients de rappel doivent être négatifs. Le modèle peut être représenté de la manière suivante :

25 ∑

avec A0 la matrice des constantes de dimension n (nombre de variable) * 1, la

matrice des paramètres à estimer et dont les dimensions sont n × n et εt le vecteur

des innovations. Le vecteur α, de dimension n * m (nombre de relations de cointégration < n), représente la force de rappel vers l’équilibre et β’ (m*n) le vecteur composé des coefficients des relations de long terme des variables, de manière que chaque combinaison linéaire représente une relation de cointégration. Le rang de la matrice π = αβ’ permet de connaitre le nombre de relations de cointégration. Dans notre cas, nous sommes en présence de 3 relations de long terme et nous avons donc un vecteur α de dimension 7*3 et un vecteur β’ de dimension

3*7.

Avant de pouvoir tirer de bons résultats d’un système VECM, nous devons sélectionner le nombre optimal de retard, étudier la stabilité du modèle proposé à travers les racines inverses du polynôme caractéristique du modèle et, enfin, vérifier si les résidus sont normaux et les erreurs homoscédastiques.

La sélection du nombre de retards 1.

La sélection du nombre optimal de retards à introduire dans un modèle VECM se fait grâce à plusieurs critères. Nous utilisons le critère d’Akaike (AIC) compte tenu de sa large utilisation dans les études. D’autres critère sont mentionnés dans la littérature, tel que celui de Schwarz (SC), du ratio de vraisemblance (LR), et celui de la prédiction de l’erreur final (FPE).

L’objectif de la procédure est de trouver la valeur h qui minimise la fonction d’Akaike donné par l’équation suivante :

( ) ( ) ( )

où SCR correspondant à la somme des carrés des résidus pour le modèle avec h retards et n correspond au nombre d’observations disponibles. Dans notre cas, l’étude des R2 ajusté indique que le nombre de retards à choisir serait au maximum de 4, nous allons regarder les résultats du tableau 3 présentant les AIC de h =1, 2, 3 et 4 et choisir un retard de deux périodes compte tenu que le AIC y est le plus faible.

26

Tableau 3 : La sélection du nombre de retard

Variables endogènes : D(LAL) D(LON) D(LBC) D(LQC) D(LNB) D(LUSA) D(LWTI) Variables exogènes : C DUM

Echantillon : 1987Q1 2013Q4 Observations: 103

Retard LogL LR FPE AIC SC HQ

0 2019,04 NA 9,09E-27 -40,09 -39,74 -39,95 1 2142,68 116,16 6,86E-27 -40,38 -38,77 -39,73 2 2199,95 96,76 5,93E-27 -40,54 -37,68 -39,38 3 2242,04 65,37 7,03E-27 -40,40 -36,29 -38,74 4 2285,84 62,09 8,32E-27 -40,31 -34,94 -38,13 Les résultats en italique indiquent le nombre de retard à sélectionner en fonction des critères choisis

LR: Statistique de tes LR FPE: Erreur de prédiction finale AIC: Critère d’Akaike

SC: Critère de Schwarz HQ: Critère de Hannan-Quinn

La stabilité du modèle VECM 2.

D’après R. Bourbonnais (1993), la stabilité du modèle renvoit au fait que le système demeure stationnaire au fil du temps. La littérature démontre que les conditions de stationnarité reviennent à imposer des conditions sur les racines du déterminant du polynôme caractéristique du VAR. En effet, nous considérerons un processus Xt

(avec t appartient à l’ensemble Z) de dimension n*1 tel que: ( )

( ) [( )( ) ] ( )

Un processus suivant de tel conditions peut être représenté par un VAR(n) tel que : ( )

La condition de stationnarité réside dans le fait que les racines caractéristiques du polynôme ( ) sont supérieures à l’unité en module.

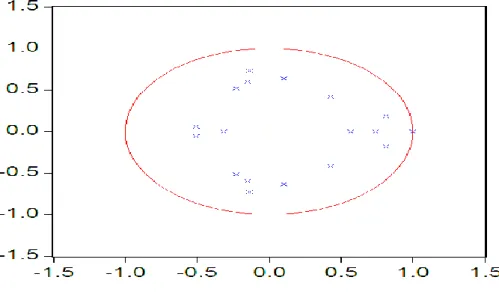

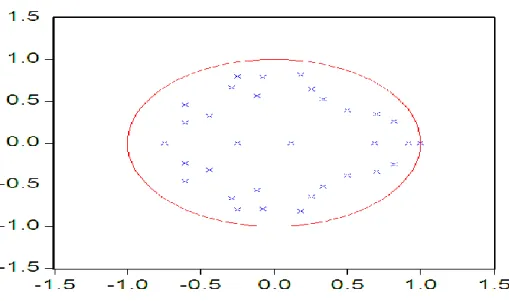

27 Dans le logiciel Eviews, il nous est possible de voir la stabilité du modèle grâce à l’inverse des racines de Φ(L) Xt. Sur la représentation graphique, lorsque l’ensemble

des racines ne se situent pas à l’extérieur du cercle, le modèle est stable. La Figure 3 suggère que dans notre étude, nous pouvons conclure que notre représentation VECM est stationnaire.

Figure 3 : Racines inverses du polynôme caractéristique du VECM avec 2 retards

Normalité des résidus 3.

La validation de la représentation passe également par l’étude des résidus, ces derniers devant suivre une loi normale. Plus précisément, cette analyse passe par les tests de kurtosis et de skewness : le premier critère s’intéresse à l’aplatissement de la distribution des résidus et le second a l’asymétrie de ces derniers. Le test de Bera et Jarque (1984) synthétise ces deux tests. La stratégie du test est classique : nous posons que l’hypothèse nulle est celle de normalité des résidus. Toujours selon R. Bourbonnais, à l’aide des coefficients de symétrie (Skewness) et d’aplatissement (Kurtosis) , il devient possible de calculer la quantité s tel que :

( ) (

28

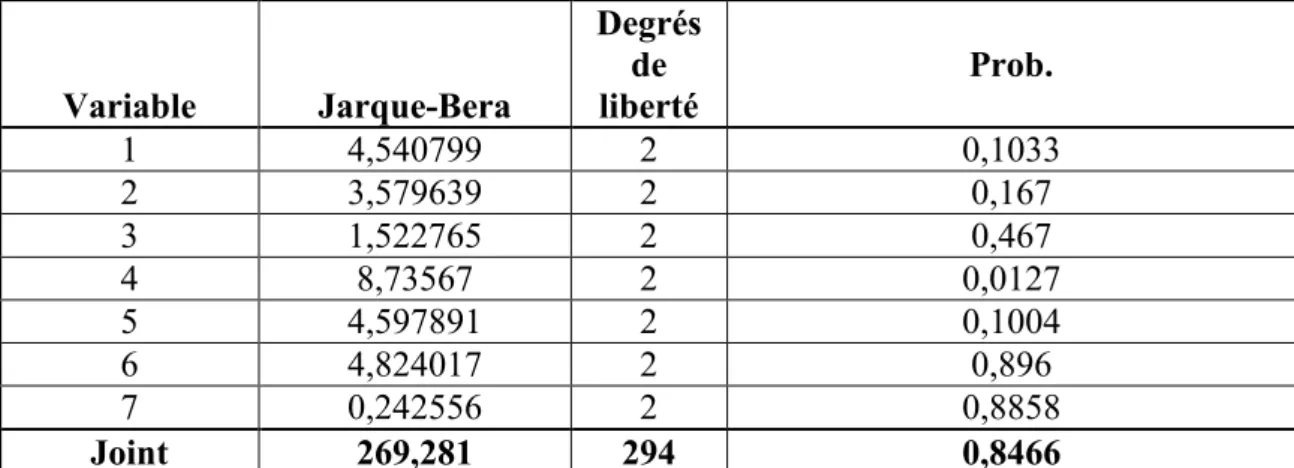

Le Tableau 5 nous présente les résultats issus du test de Bera et Jarque. Nous acceptons l’hypothèse que les résidus soient normaux au seuil de 5%, puisque la probabilité de 0,8466 est supérieure à 0,05.

Tableau 5 : Test de normalité des résidus

Variable Jarque-Bera Degrés de liberté Prob. 1 4,540799 2 0,1033 2 3,579639 2 0,167 3 1,522765 2 0,467 4 8,73567 2 0,0127 5 4,597891 2 0,1004 6 4,824017 2 0,896 7 0,242556 2 0,8858 Joint 269,281 294 0,8466

Homoscedasticité des termes d’erreurs 4.

La notion d’homoscédasticité renvoie à la constance de la variance de l’erreur. La présence d’hétéroscédasticité implique que les estimateurs de la méthode d’estimation des MCO ne sont plus à variance minimale. Afin de tester cela, nous utiliserons le test de White. Selon Cadoret et al. (2004), le test de White se base sur la comparaison des variances estimées des erreurs quand le modèle est estimé par MCO une fois sous l’hypothèse de variance constante et l’autre fois sous celle hétéroscédasticité. Si l’écart entre les deux estimations n’est pas significativement différent de zéro alors l’hypothèse nulle d’homoscédasticité est acceptée.

Lardic et Mignon (2002) proposent d’étudier la significativité des coefficients de la régression permettant d’avoir le carré des erreurs d’un modèle donné. En effet il existe une relation entre les carrés du résidu d’un modèle et les variables explicatives à niveau ou au carré. S’il s’avère que l’un des coefficients expliquant le carré des erreurs soit significatif, alors nous rejetons l’hypothèse d’homoscedasticité.