Rabat

Faculté des Sciences, 4 Avenue Ibn Battouta B.P. 1014 RP, Rabat – Maroc Tel +212 (0) 37 77 18 34/35/38, Fax : +212 (0) 37 77 42 61, http://www.fsr.ac.ma

N° d’ordre 2634

THÈSE DE DOCTORAT

Présentée par

ZENNOUHI Rachid

Discipline

: Physique

Spécialité

: Electronique et traitement des images

Contribution à la segmentation des images couleurs par classification des

pixels dans l’espace HSV et application de l’imagerie pour la détection du

stress hydrique chez Mentha spicata L.

Soutenue le:

20 Avril 2013

Devant le jury

Présidente:

CHERKAOUI EL MOURSLI Rajaa, PES, Faculté des sciences - Rabat

Examinateurs:

MASMOUD Lhoussaine, PES, Faculté des sciences - Rabat

LAGE Mounira, Docteur d'Etat, Ingénieur en Chef Principal au Centre

Régional de la Recherche Agronomique - Rabat

HAMRI Mohamed, PES, Faculté des sciences - Rabat

AKSASSE Brahim, PH, Faculté des sciences et techniques - Errachidia

CHAOUKI Brahim El Khalil, PH, ENSA - Agadir

Remerciement

Le travail présenté dans ce mémoire a été effectué au laboratoire d’Electronique et Traitement du Signal/Géomatique à la faculté des sciences de Rabat. La partie expérimentale du travail a été réalisée au Centre Régional de la Recherche Agronomique – Rabat.Je tiens à remercier Monsieur MASMOUDI Lhoussaine, Professeur d’Enseignement Supérieur à la FSR, mon directeur de thèse de m’avoir accueilli et encadré. Je lui exprime ici ma profonde gratitude pour la qualité de son encadrement, sa patience, ses compétences scientifiques et ses hauts caractères personnels que j’ai beaucoup appréciés tout au long des travaux de ma thèse. Je ne sais comment remercier MadameLAGEMounira (Co-Encadrant), Docteur d'Etat, Ingénieur en Chef Principal au Centre Régional de la Recherche Agronomique – Rabat pour les conseils et l’aide qu’elle m’a toujours prodigués.

J’exprime ma profonde gratitude à Madame CHERKAOUI EL MOURSLI Rajaa, Professeur d’Enseignement Supérieur à la FSR de m’avoir fait l’honneur de présider le Jury de cette thèse.

Je remercie vivement Monsieur HAMRI Mohamed Professeur d’Enseignement Supérieur à la FSR, d’avoir rapporté ce mémoire et pour ses encouragements tout au long de ce travail de thèse de doctorat.

J’adresse mes remerciements les plus sincères à Monsieur CHAOUKI Brahim El khalil Professeur d’Habilité à Ecole Nationale des sciences Appliquées-Agadir pour avoir soumis ses précieux jugements sur la qualité et le contenu de ce travail.

C’est avec un grand plaisir que j’adresse mes remerciements les plus chaleureux à monsieur AKSASSE Brahim Professeur d’Habilité à la FST-Errachidia d’avoir accepté de juger ce travail en tant que rapporteur. Je tiens à le remercier aussi pour m’avoir accueilli au laboratoire de la FST-Errachidia.

Je remercie également EL ANSARI Mohammed Professeur d’Habilité à faculté des sciences Agadir qui a accepté d’être mon examinateur pour ma soutenance.

Je tiens à remercier GABOUN Fatima chercheuse à L’INRA pour son aide en statistiques et Naima Shaimi pour son aide en mesure des paramètres physiologiques avec le système Li-cor 6400.

A tous ceux et toutes celles qui, de près ou de loin, ont contribué à la réalisation de cette étude, je vous prie de recevoir mes sincères remerciements.

Résumé

Ce travail traite le problème de segmentation des images couleur d’une part. D’autre part il étudie comment la vision artificielle peut être utilisée selon des méthodes d'analyse de couleur comme un indicateur du changement d’état d’un végétal.Ce mémoire comporte deux volets:

Nous présentons un nouvel histogramme à deux dimensions (2D) pour la segmentation d'images couleur en utilisant l'espace couleur HSV (teinte, saturation et intensité). L'approche est réalisée en deux étapes principales. Premièrement, on construit un histogramme 2D selon une fonction de seuil prédéfinie provenant des propriétés de HSV et le changement des valeurs de pixels dans un bloc 3x3 de pixels voisins. La seconde étape est fondée sur l’analyse hiérarchique de l'histogramme 2D afin de détecter les classes. Les pixels n’appartenant à aucune des ces classes ainsi déterminées seront reclassée selon le critère de la distance colorimétrique. La méthode a été appliquée sur des images synthétiques et réelles. Les résultats de la segmentation sont prometteurs par rapport à ceux obtenus soit par histogramme 1D en utilisant HSV ou un histogramme 2D en utilisant l'espace RGB.

Dans le deuxième volet, nous avons étudié la capacité de l’imagerie numérique à détecter le changement d’état de la plante sous un stress hydrique dans le domaine visible du rayonnement électromagnétique. L'étude est réalisée sur des images de la menthe (Mentha

spicata L.) acquises en vue verticale. L'approche est basée sur les informations couleur et sur

l'utilisation du concept d'entropie. Dans un premier lieu, nous avons classé les pixels de l’image en deux groupes (végétal et fond) en utilisant la méthode proposée dans la première partie. Dans un deuxième lieu, un indicateur non-destructif, en utilisant le concept d'entropie de Shannon, est calculé pour le végétal afin de détecter le stress hydrique chez la menthe. Une étude physiologique de l'état hydrique de la plante est menée en parallèle afin de comparer les résultats obtenus par rapport à l'approche proposée. Des mesures des paramètres physiologiques (température de surface foliaire, taux photosynthèse, taux de transpiration, conductance de H2O et concentration intercellulaire CO2) ont été effectuées avec un système

photosynthèse portable Li-cor 6400 et le thermomètre infrarouge. Les résultats obtenus par la méthode proposée sont encourageants.

___________________________________________________________________________

MOTS CLES: Segmentation, classification, histogramme 2D, espace HSV, stress hydrique, plante, Mentha spicata L., image couleur, distance colorimétrique.

Abstract

This work treats the problem of color image segmentation. And studies how the vision can be used by methods of color analysis as an indicator of the state change of plant. This memory has two parts:We present a new two-dimensional (2D) histogram technique for color image segmentation using HSV (hue, saturation, and value) color space. The approach is achieved into two main steps. In the first one, we build a 2D histogram according to a predefined threshold function derived from properties of HSV and the change of the pixel values in a block of 3x3 neighbouring pixels. In the second one, we use a hierarchical analysis of 2D histogram for detecting the classes, and we perform the segmentation algorithm by reclassification of the pixels not classified in the determined classes, according to Euclidian distance. The method has been applied on synthetic images and reel images devoted to agriculture application. This segmentation technique gives promising results compared with those obtained either by 1D histogram using HSV or 2D histogram using RGB space.

In the second part, we purpose to demonstrate the capability of digital imaging within the visible range of the electromagnetic radiation to detect early signs of water stress in plants. The approach is based on color information and on using the entropy concept. The method is composed of two main steps. The first one classifies pixels of the image that contains plant and soil into plant and background pixels. The classification is performed by a hierarchical analysis method by using a two-dimensional (2D) histogram algorithm. The second one introduces a non-destructive water stress indicator using the entropy concept. The method is applied to detect the extent of modification in menthe plants occurring under water-stress conditions. A physiological study of the water status of the plant is undertaken in order to compare the results obtained by the proposed approach. The results show that the proposed methodology is able to detect the signs of water stress in the menthe plant.

___________________________________________________________________________

KEYWORDS: Segmentation, classification, histogram 2D, HSV space, water stress plant, Mentha spicata L., image color, distance colorimétrique.

SOMMAIRE

Remerciement... i

Resumé ... ii

Abstract ...iii

Sommaire ... iv

Liste des abréviations ... vii

Liste des tableaux ...viii

Liste des figures ... ix

Liste des symboles ... xii

Introduction Générale... 1

Chapitre I: Image couleur

I. Introduction... 5II. Images numériques ... 5

II.1 Images matricielles ... 6

II.1.1 Image à niveaux de gris ... 6

II.1.2 Image couleur ... 8

II.1.3 Image multicomposante... 8

II.1.4 Image stéréoscopiques ... 9

II.2 Images vectorielles ... 9

III. Perception de la couleur ... 9

III.1 Les illuminants ... 11

III.2 Influence de la nature de l’objet ... 12

III.3 l’observateur... 13

IV. Mécanisme de la vision des couleurs ... 14

IV.1 Œil de l’être humain... 14

IV.2 La rétine ... 15

IV.2.1 Transmission et transformation de l’information visuelle ... 16

IV.2.2 Sensation de la couleur... 18

IV.3 Cortex visuel ... 20

V. La colorimétrie ... 22

V.1 Trivariance... 22

V.2 Expérience d’égalisation ... 23

V.3 Fonctions colorimétriques de la CIE ... 25

V.3.1 Fonctions colorimétriques r(λ), g(λ) et b(λ) ... 25

V.3.2 Fonctions colorimétriques x(λ), y(λ) et z(λ)... 27

V.4 Mesure de la couleur ... 29

VI. Systèmes de représentation de la couleur... 29

VI.1 Les systèmes de primaires... 30

VI.2 Les systèmes luminance-chrominance... 31

VI.4 Les systèmes d’axes indépendants ... 33

VI.5 Les systèmes hybride ... 33

VII. Espaces RGB & HSV ... 34

VII. 1 Espace RGB... 34

VII. 2 Espace HSV ... 37

VIII. Conclusion... 39

Chapitre II: Segmentation des images couleurs

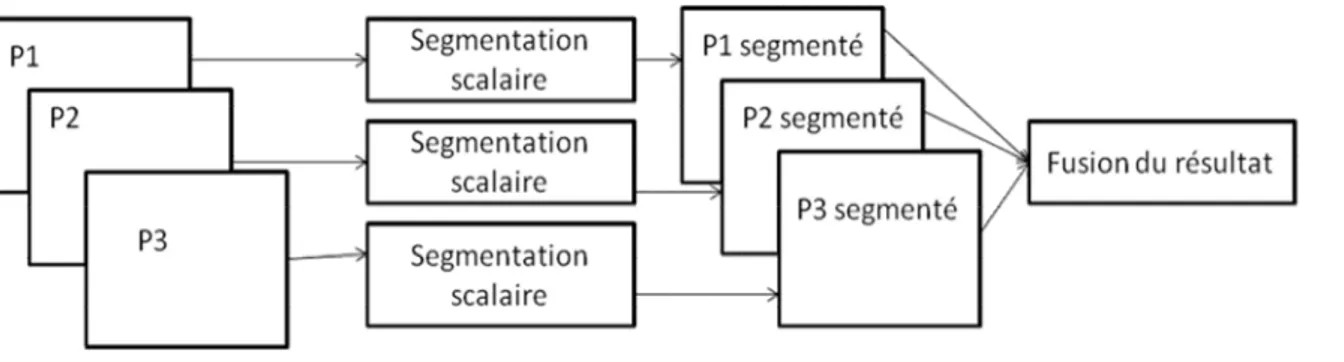

I. Introduction... 40II. Stratégies de segmentation ... 41

II.1 Stratégies scalaires... 41

II.2 Stratégies marginale... 42

II.3 Stratégie vectorielle ... 42

II.4 Stratégie hybride... 43

III. Approche contour ... 44

IV. Approche région... 45

IV.1 les méthodes de croissance en région ... 46

IV.1.1 Phase d’initialisation ... 46

IV.1.2 Phase d’agrégation des pixels à la région ... 46

IV.2 Méthodes structurelles ... 47

IV.2 .1 Méthode basé sur division-fusion de régions... 47

IV.2.2 Méthodes basées sur fusion de régions ... 49

V. Classification pixellaire ... 50

V.1 Méthodes de clustering... 50

V.1.1 Méthodes de centres mobiles ... 51

V.1.2 Algorithme Isodata ... 52

V.1.3 Classification floue... 53

V.2 Analyse d’histogrammes ... 53

V.2.1 Classification à partir d’histogrammes 1D ... 54

V.2.1.1 Analyse récursive des histogrammes 1D... 54

V.2.1.2 Analyse hiérarchique des histogrammes 1D ... 56

V.2.2 Classification à partir d’un histogramme 2D ... 56

V.2.3 Classification à partir d’un histogramme 3D ... 57

V. Approche mixte ... 58

VI. Evaluation de la segmentation ... 59

VI.1 Evaluation supervisé ... 59

VI.2 Evaluation non supervisé ... 60

VI. Conclusion ... 62

Chapitre III: Classification par analyse hiérarchique

d’histogramme 2D

I. Introduction... 63II. Construction de l’histogramme 2D... 64

III. Nouvelle méthode d’obtention de l’histogramme 2D ... 65

IV.1 Phase d’apprentissage ... 70

IV.2 Phase de décision ... 71

V. Algorithme... 72

VI. Résultats et discutions ... 74

VI.1 Segmentation des images monochrome ... 74

VI.2 Segmentation des images couleur par histogramme 2D dans l’espace RGB ... 77

VI.2.1 Image de synthèse de cinq classes ... 78

VI.2.2 Segmentation d’image en deux classe (végétation et sol)... 78

VI.3 Segmentation par le nouveau histogramme 2D dans l’espace HSV ... 81

VII. Conclusion ... 85

Chapitre IV: Application de la segmentation à la détection

du stress hydrique chez la menthe

I. Introduction... 87II. Stress hydrique ... 88

III. Evaluation du stress hydrique chez les plantes ... 89

III.1 Méthode classique ... 89

III.1.1 Mesure de la teneur en humidité ... 90

III.1.2 Potentiel hydrique foliaire ... 90

III.1.3 Potentiel hydrique de substrat ... 90

III.1.4 Mesure physique ... 91

III.1.5 Méthodes biochimiques... 91

III.1.6 Température de surface ... 91

III.2 Méthode d’imagerie ... 92

III.2.1 Imagerie de fluorescence... 92

III.2 .2 Imagerie visible ... 93

IV. Nouvelle méthode de détection du stress hydrique... 95

V. Test préliminaire sur le Forsythia... 96

VI. Matériel et méthode ... 100

VI.1 La menthe-Mentha spicata ... 100

VI.2 Déroulement de l’expérience ... 101

VI.3 Acquisition des images ... 102

VI.4 Mesure physiologique ... 102

VII. Résultats et discutions... 104

VII.1 Méthode physiologique ... 104

VII.2 Méthode d’imagerie... 111

VIII. Conclusion... 116

Conclusion générale ... 117

Appendice: Entropie... 119

Publication... 122

Liste des abréviations

CIE Commission Internationale de l’Éclairage AFNOR Association Française de Normalisation

PLE Plexiforme Externe

PLI Plexiforme Interne

CGL Corps Genouille Lateral

EBU European Broadcasting Union

FCC Federal Communications Commission

RGB Rouge, Verte Et Bleu

CMJ Cyan, Magenta et Jaune

HSV Teinte , Saturation Et Luminosite

ACP Analyse En Composante Principales

Isodata Iterative Self-Organizing Data Analysis Techniques A

2D Deux Dimensions

3D Trois Dimensions

1D Une Seul Dimensions

Min Minimum

Max Maximale

Id Matrice Identité

TER Teneur Relative en Eau

Photo Taux De Photosynthese

Cond Conductance de H2O

Ci Concentration Intercellulaire de CO2

Trmmol Taux De Transpiration

Tair Température De L’air

IGVi Composante G de l’image du Végétale pour la ième jour de l’expérience

Liste des tableaux

Tableau 1.1: Quelques types d’image [Rabaud, 2005]………...………...………7 Tableau 1.2: Du multispectral à l’ultraspectral: définition numérique [Gorretta, 2009] ..…...9 Tableau 1.3: Principales caractéristiques des cellules photoréceptrices de la rétine [Perreira,

2010]………...20

Tableau 3.1: Les valeurs du critère d’uniformité intra-région Levine Et Nazif (CLN) pour les différentes images……….75

Tableau 3.2: Valeurs du critère d’uniformité intra-région Levine Et Nazif pour les distances

Euclidienne et Mahalanobis………..77

Tableau 3.3: Les valeurs de la fonction d'évaluation «Q» pour les différentes images………...……83

Tableau 4.1: Entropie des images à niveaux de gris du plante stressé et témoin au début et à

la fin d’expérience……….98

Tableau4.2: Moyenne d’entropie des images des plantes témoins et stressé……...……….100 Tableau 4.3: Méthodologie……..……….……….103 Tableau 4.4: Valeurs de température obtenu par infra rouge du premier jour de

l’expérience……….105

Tableau 4.5: Valeurs de température obtenu par infra rouge du sixième jour de l’expérience……….105

Tableau 4.6: Valeurs de température obtenu par infrarouge du dixième jour de

l’expérience……….106

Tableaux4.7: Ecarte type et la moyenne des températures enregistrées à la surface des plantes

stressées et des plantes témoins au cours de dix jours de l’expérience………..107

Tableau 4.8: Paramètres physiologiques mesurés le premier jour de l’expérience par le

system li-cor………108

Tableau 4.9: Probabilité des différents paramètres…………..……….109 Tableau 4.10: Entropie du composante vert de l’image du plante stresse et témoin pendant les

dix jours de l’expérience……….113

Tableau 4.11: Probabilité des trois paramètres pendant les dix jours d’expérience………...…….114

Listes des figures

Fig. 1.1: Une image numérique stocke les intensités lumineuses des pixels dans une

matrice...7

Fig. 1.2: Spectre électromagnétique[Yang, 2009]………...………...……….…….10

Fig. 1.3: Perception humaine de la couleur [Vandenbroucke, 2000]………....11

Fig. 1.4: Principaux illuminant standards de la CIE[Vandenbroucke, 2000]……….………..12

Fig. 1.5: Schéma global du système visuel humain [McGillSite] ..……...……….… 15

Fig. 1.6: Schéma général de l’œil [Kolb, 1996]….……….…..16

Fig. 1.7: Organisation des couches cellulaires de la rétine [GsbmeSite]………...……….…..17

Fig. 1.8: Concentration des photorécepteurs en fonction de l’excentricité [McGillSite]…....19

Fig. 1. 9: Fonctions d’absorption relative des cônes et des bâtonnets [Dartnall, 1983]……...20

Fig. 1.10: Cheminement de l’information visuelle à travers les différentes couches du cortex visuel [Perreira, 2010]……….……..21

Fig. 1.11: (a) Synthèse additive. (b) Synthèse soustractive [Gouiffès, 2005]……….……….23

Fig. 1.12: Egalisation d’une couleur monochromatique par trois primaires Monochromatiques [Heus, 2009]………..……….….…..25

Fig. 1.13: Fonction colorimétrique du système RGB de l’observateur de référence CIE 1931 à 2° [Vandenbroucke, 2000]……….………...…23

Fig. 1.14: Fonction colorimétrique du système XYZ de l’observateur de référence CIE 1931 à 2° [Vandenbroucke, 2000]……….……...28

Fig. 1.15: Espace couleur RGB. seuls sont représentés dans ce diagramme, les stimuli de coordonnes positives [Vandenbroucke, 2000]……….….36

Fig. 1.16: Diagramme de chromaticité(r,g) [Vandenbroucke, 2000]……...….………...37

Fig. 1.17: (a) Projection du cube des couleurs ; (b) Projection d’un sous-cube [Vandenbroucke2000]……….…..38

Fig. 1.18: Le système de cône hexagonal HSV… ……… ………..39

Fig. 2.1: Segmentation par stratégie scalaire………....41

Fig. 2.2: Segmentation par stratégie marginale………....42

Fig. 2.3: Segmentation par stratégie vectorielle……….…..43

Fig. 2.4: (a) Image de synthèse originale (b) Image segmenté………...….…45

Fig. 2.5 : Structure arborescente tétra-arbre [Macaire, 2004]……….…..48

Fig. 2.6: Graphe d’adjacence de région[Macaire, 2004]………..……….…..49

Fig. 2.7: (a) Régions homogènes de l’image, (b) nuages de points-couleur dans l’espace RGB [Macaire, 2004]……….…51

Fig 3.1: (a) Image originale dans l’espace HSV. (b) image intermédiaire. (c) les pixels de l’image représenté par la teinte. (b) pixels de l’image représenté par l’intensité………….…67

Fig. 3.2: Bloc de 3x3: (a) et (c) d'image intermédiaire;(b) et (d) leur composante dans l'image originale………68

Fig. 3.3: (a) et (b) Histogramme représente les pixels associe aux valeurs des intensités et la teint respectivement. (c) Histogramme 2D……….………..69

Fig. 3.4: Exemple de décomposition hiérarchique [Clément, 2002]………71

Fig. 3.5: (a) Image de synthèse monochrome ; (b) et (c) images médicales. . (d), (e) et (f) résultats de segmentation en utilisant l’histogramme de Abutaleb. (g), (h) et (l) résultats de segmentation en utilisant l’histogramme de Zhang……….……….76

Fig. 3.6: Classification par histogramme 2D: (a) les régions construite en utilisant la

distance euclidienne, (b) les régions construite en utilisant distance de Mahalanobis……....77

Fig. 3.7: Exemple d'image de synthèse: (b) l'image RVB et (a) image segmentée en cinq

régions (c) vue verticale de la RG-histogramme………...78

Fig. 3.8: Exemple d'image de la Menthe: (a) l'image RVB et (b) image segmentée en deux

régions………...79

Fig. 3.9: Vue verticale de la histogramme 2D : (a) RG-histogramme,(b) BR-histogramme et (c) BG-histogramme………..79

Fig. 3.10: Résultat de la segmentation avec BG-histogramme……… ……….….….80 Fig. 3.11: Nombre de classe en fonction du seuil……… …………....80 Fig. 3.12: Classification par l’histogramme 2D (plan RG): (a) les classes construites en

utilisant la distance euclidienne, (b) les classes construites en utilisant la distance de Mahalanobis. Dans (a) et (b), les centres de masse sont marqués avec des croix rouges…....81

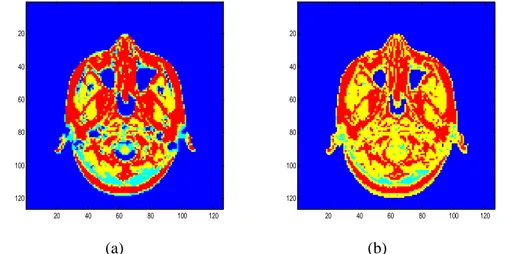

Fig. 3.13: (a,c) Images originales; (b,d) Images segmentées……… ..…….83 Fig. 3.14: (a) Image de synthèse ; (b) RG-histogramme; (c) Méthode de Sural; (d) Méthode

proposée………84

Fig. 3.15: (a) Image de la menthe; (b) RG-histogramme; (c) Méthode de Sural d) Méthode

proposée………85

Fig. 4.1: Influence du stress hydrique sur les variables d'état de la plante [Kotchi, 2004]…..88 Fig. 4.2: Angle de Gardeta[Gardet, 1996]………94 Fig. 4.3: (a) Image témoin (b) image stressée [Eon, 1997]………..94 Fig. 4.4: Image de Forsythia[Foucher, 2003]………..97 Fig. 4.5: Variation de l’entropie des images à niveaux de gris au début et à la fin

d’expérience………..99

Fig. 4.6 : Entropie des composantes R,G et B des plantes stressées et témoins au début et à la

fin de l’expérience………...………..………99

Fig. 4.8: Chambre noire………..102 Fig. 4.9: Li-Cor 6400 [EseSite]………..103 Fig. 4.10: Evolution de la moyenne des températures de surface des plantes stressées et des

témoins………107

Fig. 4.11: (a) Evolution moyenne de la concentration intercellulaire de CO2 mesuré par le

système Li-cor (■, plantes stressé; ♦, plantes témoin); (b) évolution du probabilité P………...………...109

Fig. 4.12: (a) Evolution moyenne de la conductance de H2O (■, plantes stressé; ♦, plantes

témoins); (b) Evolution du probabilité P……….110

Fig. 4.13: (a) Evolution moyenne le taux de transpiration (■, plantes stressé; ♦, plantes

témoins) ; (b) évolution du probabilité P………110

Fig. 4.14: (a) Evolution moyenne le taux de photosynthèse (■, plantes stressé; ♦, plantes

témoins); (b) Evolution du probabilité P……….111

Fig. 4.15 Evolution moyenne la différence de température entre la feuille et l'air (Tl - Ta)

(■, plantes stressé; ♦, plantes témoins); (b) évolution du probabilité P……….111

Fig. 4.16: Présente les images RGB des plantes stressées (deuxième ligne) et des plantes

témoins (première ligne) di: jour i, (i = 1,…10)………111

Fig. 4.17: (a), (b) Images témoins et (c), (d) Image stresses. Résultants de segmentation en

deux classes: végétation et sol (e), (f) et (g), (h)……….…………112

Fig. 4.18: (a) Evolution du moyenne taux d'entropie de la différence de la plante et le fond

sur leur somme (■, plantes stressés; ♦,plantes témoins); (b) évolution du probabilité P………...114

stressés; ♦,plantes témoins);(b) Evolution du probabilité P………114

Fig. 4.20: (a) Evolution de moyenne de l’entropie de la composante G de la plante (■, plantes

stressés; ♦,plantes témoins); (b) Evolution du probabilité P……….…..115

Fig. 4.21: Différence de moyenne entre les plantes témoins et stressés (●taux du végétale sur

le sol ■ composante G ▲ taux de la différence entre la plante et le fond sur leur somme)……….……116

Liste des symboles

f (x, y) Fonction bidimensionnelle

f Amplitude à tout couple de coordonnées (x, y) appelée l'intensité ou niveau gris de l'image

i (x, y) Illumination

r (x, y), Réflectance

S(λ) Stimulus de couleur

I(λ) Source lumineuse

R(λ) Réflectance d’un objet

) , (

1 x y

f Intensités de la première composante d’une image couleur )

, (

2 x y

f Intensités de la deuxième composante d’une image couleur )

, (

3 x y

f Intensités de la troisième composante d’une image couleur E(λ) Répartition spectrale d’énergie

D65 Illuminant qui correspond à la moyenne des lumières durant la

journée

A Illuminant correspond à une source de lumière équivalente à une lampe à filament de tungstène

E Illuminant théorique d’énergie constante

F Illuminants qui représentent le rayonnement émis par diverses lampes fluorescentes

R(λ) Réflectance spectrale de la lumière T(λ) Transmittance spectrale de la lumière V2et V3 Aires du cortex visuel

Cône “L” Cône sensible aux grandes longueurs d’onde visibles Cône “M Cône sensible aux longueurs d’onde visibles moyennes Cônes “S” Cônes sensible aux longueurs d’onde visibles courtes, R,G et B Trois couleurs primaires: rouge, verte et bleu

r(),g() et b() Fonctions colorimétriques associées aux trois couleurs primaires R, G et B

x(λ), y(λ) et z(λ) Fonctions colorimétriques associées aux trois couleurs primaires X, Y et Z.

R10G10et B10 Système de référence colorimétrique supplémentaire

r10(λ), g10(λ) et b10(λ). Fonctions colorimétriques associées aux trois couleurs

primaires R10G10et B10

K Facteur de normalisation des composantes trichromatiques par rapport à la fonction colorimétrique g(λ) et par rapport à la source lumineuse qui est caractérisée par sa répartition spectrale d’énergie I(λ)

P1, P2et P3, Trois couleurs primaires

1

P ,P2et P3 Vecteur unitaire de l’espace RGB

C Point couleur

Ri Régions de l’image

Uj(j=1,…m) Régions de l’image de référence

) , ( ji T Table de partition N N U R dv( , ) Mesure de dis-similarité Y C Critère de Yasnoff ) (I

F Critère de Liu et Yang

) (I

Q Critère de Brosotti

p (x1, x2), Nombre de pixels dans l’image présentant les composants

colorimétriques (x1, x2).

J Image dont la résolution spatiale est égale à 256x256 pminet pmax Valeurs minimale et maximale de p respectivement

) , (x y

G Filtre gaussien bidimensionnel

) (V

ThS Fonction de seuil pour déterminer si un pixel doit être représenté par sa teinte ou de son intensité.

Max Maximale de la teinte ou l'intensité dans le bloc 3x3 sauf les pixels de quatre connexités

Min Minimale de la teinte ou l'intensité dans les quatre-connexités. Ph(Min, Max) Nombre de pixels présentant le minimum et le maximum (Min

et Max) dans tout le bloc 3x3 de l'image pour un pixel central représenté par la teinte ( H )

Pv(Min, Max) Nombre de pixels présentant le minimum et le maximum (Min

et Max) dans tout le bloc 3x3 de l'image pour le pixel central représenté par l’intensité (V)

μ (Ki) Centre de masse μ (Ki) de chaque feuille retenue Ki dans

l'espace couleur 2D

β Couleur correspondant au point de coordonnées (x1, x2) dans

l'espace couleur 2D

d [μ (Ki); (x1; x2)] Distance entre μ (Ki) et (x1; x2)

dist2 Distance entre le centre de masse µiet la couleur β

M Matrice définissant la métrique

(Cv)-1 Inverse de la matrice de covariance de la classe Ci

CLN Critère d’uniformité intra-région LevineEtNazif

max

facteur de normalisation

S Seuil utilisé pour extraire les pics de l’histogramme (2D)

Q Critère de Borsotti

H(X) Entropie de Shannon

Pi(x,y) Probabilité

Hv Entropie de la végétation

Hs Entropie de la région du sol

R1 Rapport d'entropie de la plante et le fond

R2 Rapport d'entropie de la différence de la plante et de fond

sur leur somme

D Différence de moyenne entre les plantes témoins et stressées Ht Entropie de la plante irriguée

Hst Entropie de la plante stressée

Cond Conductance de H2O (mol m s )

Ci Concentration intercellulaire de CO2(µmol/ mol).

Trmmol Taux de transpiration (mmol H2O / m2s)

Tair Température de l’air

TC-TA Différence de températures entre la surface de la feuille et l'air

IGVi Entropie de la composante G de l’image du végétal pour le nième jour de l’expérience

Introduction Générale

Le traitement d’images consiste à extraire, à partir d’une image numérique, les informations pertinentes en regard de l’application concernée, les traiter puis les interpréter. Généralement, le traitement d’images par un ordinateur repose sur les mêmes principes quelle que soit l’application envisagée.

Un des premiers domaines où le traitement a été utilisé pour améliorer des images est celui de la recherche spatiale. En 1964, des images de la lune transmises par la sonde Ranger 7 ont été traitées par l’ordinateur afin de corriger les distorsions introduites par la caméra. Après, les applications s’étendent de jour en jour. Aujourd’hui, on rencontre le traitement d’images dans d’autres domaines telles que la médecine, la biologie, la météorologie, les applications militaires, la géographie, la cartographie, l’astronomie, la télésurveillance, la robotique, l’audiovisuel, la géologie et la physique. Le traitement d’images apporte aussi des solutions appropriées pour traiter des problèmes correspondant à des situations auxquelles l’observateur humain n’avait jamais été confronté. Ceci est lié à l’´evolution de la technologie, la flexibilité et la qualité du matériel disponible sur le marché (capteurs numériques, support de stockage de données, microprocesseurs, périphériques d’affichage).

En traitement d'images, il existe plusieurs procédures pour arriver à un bon résultat. Lors de la phase de la programmation, les résultats sont évalués et c’est à l’utilisateur de choisir la meilleure solution en fonction de l'application considérée.

La segmentation est l’un des axes principaux de traitement d’images. Elle consiste à extraire des primitives, soit de type contour, soit de type régions. Ces primitives seront exploitées lors de la reconnaissance de formes, de recalage, de la mise en correspondance, de la compression, … [Trémeau, 2004].

La segmentation d’images consiste à transformer une image en image binaire (contour/non contour) ou bien une image en régions. Concernent la segmentation en région, les pixels de chaque région sont étiquetés par la même étiquette. Une grande partie de notre travail est consacrée à la segmentation des images couleurs. En effet, il nous semble essentiel de comprendre comment se forme la couleur et les principaux facteurs qui l’influencent avant d’aborder le problème de la segmentation. La couleur d’un objet, telle que nous la percevons, est une notion très compliquée qui obéit à des lois physiques, physiologiques et psychologiques particulières [Macaire, 2004]. C’est pour cette raison que le chapitre I est consacré à : la mesure, la formation de la couleur qui est liée très fortement à la lumière et les différents systèmes de représentation de la couleur.

Plusieurs recherches ont été consacrées au problème de segmentation automatique. Mais, aucune de ces méthodes n’est valable pour tout type d’image. Le choix d’une telle méthode est lié soit:

A la nature de l’image (éclairage non homogène, reflets, présence de bruit, contour flou…),

Aux opérations situées en aval de la segmentation (contrôle de qualité, reconnaissance de forme ….),

Aux primitives à extraire (contour, segment de droit, régions, forme…), Aux choix de l’espace couleur,

Aux contraintes d’exploitation (complexité de l’algorithme, fonctionnement en temps réel…).

La segmentation d’images (chapitre II) fait référence aux notions de différence et de similarité comme les perçoit le système visuel humain. C’est ces deux notions qui sont à l’origine de l’approche contour et de l’approche région [Cocquerez, 1995]. Ces deux approches qui sont la base de la segmentation d’images peuvent être employées d’une manière coopérative

(méthode mixte). Avant de les aborder, nous présentons les différentes stratégies utilisées dans le domaine de traitement d’images. Le dernier paragraphe du chapitre II est consacré aux méthodes d’évaluation des méthodes de la segmentation.

Les méthodes de l’approche région existantes peuvent être classées dans deux catégories, selon que l’analyse s’effectue dans le plan image ou dans un espace couleur. La deuxième est fondée sur la classification de pixels en fonction de leurs attributs spectraux, cette méthode appelée classification pixellaire (chapitre II).

Les méthodes de segmentation d’images par classification définissent une partition de l’image en un ensemble de classes. Les classes sont formées à partir des attributs des pixels. Les classes doivent être aussi distinctes que possible les unes des autres [Jain1999]. Chaque pixel est affecté à une classe unique indépendamment de ses voisins dans l’image. Les critères de proximité employés sont en effet, des distances entre vecteurs d’attributs [Cocquerez, 1995]. Une région sera constituée de pixel d’une même classe mais il peut y avoir dans l’image plusieurs régions correspondant à une même classe. Finalement la segmentation est complétée par l’extraction des composantes connexe et étiquetage des pixels appartenant à une même classe. C’est une opération qui consiste à attribuer à tous les pixels d’une composante connexe une même étiquette (valeur entière).

Il est démontré que, en cas de classification non supervisée, les méthodes basées sur le seuillage de l’histogramme sont de bons candidats pour la réalisation de segmentation pour une large classe d'images avec la complexité de calcul faible [Cheng, 2001]. C’est la raison pour laquelle, nous décrirons de façon plus détaillée une méthode de classification par analyse hiérarchique d’histogrammes bi-dimensionnels (2D) (chapitre III). Nous appliquons cette méthode sur des images couleur et monochrome et dans différents espaces. Et nous étudions les résultats en fonction de la métrique utilisée pour la reclassification. Enfin, Nous présentons un nouvel histogramme à deux dimensions (2D) pour la segmentation d'images

couleur en utilisant l'espace couleur HSV (teinte, saturation et valeur). Cet espace est fondamentalement différent de l'espace de couleur RGB car il sépare l'intensité et l'information de couleur (chrominance), ce qui est proche à la vision humaine.

Dans le quatrième et dernier chapitre, nous montrons comment notre approche s’applique à la segmentation d’images couleur afin de détecter le stress hydrique chez la plante de la menthe. Dans un premier temps nous classifions les pixels de l'image RGB en deux classes distinctes: la végétation et le sol. Cette étape est fondée sur la méthode proposée au chapitre III. La deuxième étape utilise un nouvel indicateur de stress hydrique basé sur la mesure de la quantité d’information couleur (entropie). Nous appliquons la méthode sur des séries d’images des plantes de la menthe stressée et témoin, et nous la comparons avec une méthode classique de détection du stress hydrique (physiologique).

Image couleur

I. Introduction

Quelle que soit l’application envisagée, le traitement de l’information optique par une machine automatique repose sur les mêmes principes [Postaire, 1987].

Schématiquement, on peut considérer que, partant d’une information brute très volumineuse et difficile à manipuler, la machine doit analyser l’image qui lui est soumise afin d’en décrire et interpréter le contenu [Postaire, 1987]. L’ordinateur n’analyse que les images numériques, dans le paragraphe II nous présentons les différents types des images numériques.

Notre contribution porte sur la segmentation d’images couleur. Avant de la segmenter, il nous semble essentiel de comprendre comment se forme la couleur et les principaux facteurs qui influencent cette notion. La couleur d’un objet, telle que nous le percevons, est une notion très complexe qui obéit à des lois physiques, physiologique et psychologiques particulière [Macaire, 2004]. C’est pour cette raison que ce chapitre est consacré à la mesure, à la formation de la couleur qui est liée fortement à la lumière et aux différents systèmes de représentation de la couleur. Afin de mieux comprendre la notion de la couleur nous décrivons, dans le paragraphe IV, l’œil et le mécanisme de la vision de la couleur chez l’homme.

II. Images numériques

Pour qu’une image puisse être traitée par ordinateur, il faut qu’elle soit disponible sous format numérique, c’est à dire échantillonnée et quantifiée. Cette transformation induit une

adaptation de la représentation mathématique du signal mesuré. Pendant de nombreuses années, ce sont les techniques issues de la théorie de l’échantillonnage de Shannon qui ont assuré cette adaptation [Rabaud, 2005]. Les images numériques peuvent être classées en deux classes: les images matricielles et les images vectorielles.

II.1 Images matricielles

Les images matricielles sont des images numériques qui stockent les informations sous la forme d’une matrice. Elles peuvent être regroupées en plusieurs catégories: images à niveaux de gris, image couleur, image stéréoscopiques et image multicomposante.

II.1.1 Image à niveaux de gris

Une image peut être définie comme une fonction bidimensionnelle f (x, y), où x et y sont les coordonnées spatiales (plan), f est l’amplitude à tout couple de coordonnées (x, y) appelée l'intensité ou niveau gris de l'image à ce point. Alors que x, y et les valeurs d'amplitude de f sont tous finis, des quantités discrètes. Nous appelons cette image une image numérique. Le domaine du traitement numérique de l'image se réfère au traitement des images numériques au moyen d'un ordinateur numérique [Gonzalez, 1993]. Notez qu’une image

numérique est composée d'un nombre fini d'éléments, dont chacun a un endroit particulier et une valeur. Ces éléments sont appelés pixel, de l’anglais ”picture element”, il est souvent considéré l’équivalent du point dans le monde continu. Un pixel regroupe les deux transformations appliquées à l’image réelle: il est repéré par un jeu de coordonnées entières (coordonnés x et y) et un niveau de gris (amplitude de f) quantifié qui lui est associé. Utilisés sous forme de mosaïque, les pixels, vus de loin, donnent l’impression d’une image continue [Rabaud2005]. Par convention, le pixel origine(0,0) est en général en haut à gauche (figure 1.1b)

(a) (b)

Fig. 1.1: Une image numérique stocke les intensités lumineuses des pixels dans une matrice

La valeur de f en coordonnées spatiales (x, y) est une quantité scalaire positive dont l'interprétation physique est déterminée par la source de l'image. Le tableau 1 présente les types d’images les plus courants, les grandeurs physiques associées et les capteurs utilisés.

Phénomène physique Grandeur mesurée Exemples de capteurs

Lumière visible Flux photoniques émis ou réfléchi

CCD, CMOS, scanner

Rayonnement infra-rouge Luminance infra-rouge(chaleur) Bolomètre

Echo ultrasonore Distance, densité des tissus Echographe, sonar

Résonance magnétique Temps de relaxation de spin IRM

Echo électromagnétique

Distance, spécularité de surface Radar

Absorption des rayons X Densité de tissus Radiographe

Quand une image est générée à partir d'un processus physique, ses valeurs sont proportionnelles à l'énergie du rayonnement de la source physique (par exemple, les ondes électromagnétiques). En conséquence, f (x, y) doit être non nulle et finie,

( , )

0 f x y (1.1)

La fonction f (x, y) peut être caractérisée par deux éléments: (1) la quantité d’illumination de la source incidente sur la scène observée, et (2) la quantité de l'éclairage réfléchi par les objets dans la scène. De façon appropriée, on les appelle composants de l'illumination et de réflectance et sont notés par i (x, y) et r (x, y), respectivement. Les deux fonctions se combinent pour produire la fonction f (x, y) [Gonzalez, 1993].

La qualité d’une image numérique dépend d’une part de sa résolution, i.e. du nombre de pixels dans l’image, ainsi que de la quantification de l’intensité lumineuse, i.e . le nombre de bits utilisés. Pour des images en niveaux de gris, l’intensité d’un pixel est codée sur un octet et il y a donc 28=256 nuances de gris possibles.

II.1.2 Image couleur

Nous verrons par la suite qu’une couleur quelconque peut être synthétisée par la superposition de trois couleurs de base appelées les couleurs primaires. Il en résulte qu’une image en couleurs est en pratique trichrome et elle est représentée par trois fonctions

) , ( ) , ( ), , ( 2 3 1 x y f x y et f x y

f traduisant les intensités des trois composantes au point (x,y). L’acquisition d’une scène colorée nécessite donc en fait 3 acquisitions et le résultat est un ensemble de 3 matrices de nombres f1ij, f2ij et f3ij[Marion, 1997].

II.1.3 Image multicomposante

Il s’agit d’une généralisation du cas précédent. Une image multispectrale analogique est représentée par n composantes f1(x,y), f2(x,y)...fn(x,y). C’est le cas par exemple

pour des vues de la même région du globe observées par satellite dans n bandes de longueurs d’ondes différentes. Les n numériseurs nécessaires créent n tableaux de nombre (acquisition multispectrale)[Marion, 1997] Ou bien Lorsque plusieurs images numériques scalaires sont produites pour caractériser une scène selon différentes modalités (en IRM par exemple, ou en associant IRM et rayons X) [Ouattara, 2009]. La gamme de valeurs possibles pour les images multispectrales varie en fonction du type de l’image considéré (tableau 2). Cette thèse s’intéresse particulièrement à la segmentation d’images couleurs (3 band).

Multispectral Superspectral Hyperspectral Ultraspectral

Nombre bande 5-10 10-20 100-200 1000-10000

Tableau 1.2 Du multispectral à l’ultraspectral: définition numérique [Gorretta, 2009]

II.1.4 Image stéréoscopique

On appelle image stéréoscopique deux images matricielles représentant la même scène mais prises de deux points de vue légèrement différents afin de simuler la vision stéréoscopique humaine (deux yeux).

II.2 Images vectorielles

Les images vectorielles, contrairement aux images matricielles, contiennent les primitives de dessin (formes, position, couleurs...) des objets géométriques qu’elles représentent (segments de droite, polygones, arcs de cercles...). Ces images sont essentiellement utilisées pour réaliser des schémas ou des plans. Ces images présentent deux avantages: elles occupent peu de place en mémoire et peuvent être redimensionnées sans perte d'information.

III. Perception de la couleur

Notre contribution porte sur la segmentation d’images couleur. Avant de la segmenter, il nous semble essentiel de comprendre comment se forme la couleur et les principaux facteurs qui

influencent cette notion. La couleur d’un objet, telle que nous le percevons, est une notion très complexe qui obéit à des lois physiques, physiologique et psychologiques particulières [Macaire, 2004]. Nous ne pouvons pas dissocier ces deux mots lumière et couleur si nous voulons définir la couleur. Un objet nous apparaît coloré de par la manière dont il réfléchit (ou transmet) la lumière incidente. La lumière peut être considérée comme un flux de particules énergétiques dénuées de masse (photon), qui se propagent sous forme d’ondes électromagnétiques, dont les radiations se situent dans le domaine 380nm et 780nm et qui, de ce fait, stimulent notre sens de la vue(figure 1.2) [Trémeau, 2004].

Fig. 1.2 Spectre électromagnétique [Yang, 2009]

L’expérience de Isaac Newton (1642-1727) en 1672 sur la dispersion de la lumière à travers un prisme (spectre de la lumière) est le départ de deux théories scientifiques sur l’explication de la lumière. Cette expérience nous a amenés à concevoir la notion de la couleur pure, chaque onde monochromatique du spectre de lumière donnée par l’expérience du prisme est dite couleur ‘pure’ [Trémeau, 2004]. la figure 1.3 présente la perception humaine de la couleur. La perception que nous aurons de la couleur d’un objet sera donc influencée par trois facteurs principaux: le type de la source éclairant l’objet, la nature de l’objet et l’observateur qui regarde la scène.

Fig. 1.3: Perception humaine de la couleur [Vandenbroucke, 2000]

III.1 Les illuminants

La couleur apparente d’un objet sera déterminée par le type de lumière incidente. Il existe plusieurs sources de lumière: les flammes, les lampes à incandescence, les lampes à halogène, les tubes fluorescents et la lumière du soleil qui change selon l’heure de la journée et selon les conditions atmosphériques. Certaines sources correspondant à des conditions d’observation courantes ont été normalisées par la CIE (Commission Internationale de l’Éclairage) sous le nom d’illuminants [Vandenbroucke, 2000 ; Trémeau, 2004]. La CIE a défini le terme « illuminant» comme une répartition spectrale d’énergie particulière, non nécessairement fournie directement par une source ni obligatoirement réalisable à l’aide d’une source [CIE, 1986]. Alors que le terme « source » se réfère à un objet physique qui émet de la lumière, tels une lampe, le soleil ou le ciel. Chaque source lumineuse peut être décrite par sa

répartition spectrale d’énergie E(λ), qui est la quantité d’énergie émise par intervalle de

longueur d’onde (généralement 1nm). La répartition spectrale d’un illuminant est toujours normalisée, à 1 ou à 100, relativement à une longueur d’onde donnée, en général λ=560 nm pour la plupart des illuminants. On peut également caractériser un illuminant par sa température de couleur exprimée en Kelvin(K), qui est la température à laquelle il faudrait

porter un corps noir pour obtenir une répartition spectrale d’énergie identique à celle de la source.

La figure 1.4 présente les principaux illuminants standards de la CIE. On distinguera tout d’abord la famille des illuminants D, qui définissent différentes phases de la lumière solaire en fonction de leur température de couleur. Parmi ceux-ci, l’illuminant D65 qui

correspond à la moyenne des lumières durant la journée, sa température de couleur est de 6500K [Trémeau, 2004]. L’illuminant A correspond à une source de lumière équivalente à une lampe à filament de tungstène, sa température de couleur est 2856K. L’illuminant E est un illuminant théorique d’énergie constante, il ne correspond à aucune source réelle. Il existe également Les illuminants F, qui représentent le rayonnement émis par diverses lampes fluorescentes, selon le phosphore utilisé, il existe 12 sous-familles de ce type d’illuminant [Hunt, 1991].

Fig. 1.4: Principaux illuminants standards de la CIE [Vandenbroucke, 2000]

III.2 Influence de la nature de l’objet

Lorsque la source lumineuse produit un rayonnement électromagnétique à partir d’une transformation d’énergie, on parle d’une source primaire. En revanche, une source secondaire

est une source qui émet des rayons lumineux issus de la réflexion ou de la transmission par un matériau des rayons d’une source primaire. De ce fait, la couleur d’un objet sera influencée par la nature de l’objet.

En effet, un objet nous apparaît coloré de par la manière dont il réfléchit (ou transmet) la lumière incidente. S’il réfléchit entièrement toutes les longueurs d’onde de la lumière qui l’éclaire, il apparait de la même couleur que cette dernière (ex mimoir). S’il absorbe toutes les longueurs d’onde de la lumière incidente, alors il apparait noire [Trouve, 1991]. Entre ces deux extrêmes, et suivant l’état de surface, la structure chimique, la nature physique d’un objet, ses caractéristiques optiques peuvent changer du tout au tout, celui-ci peut devenir plus au moins réfléchissant, plus ou moins transmittant ou absorbant, etc… [Trémeau, 2004]. La lumière qui n’est pas absorbée par l’objet est diffusée ou transmise, formant un stimulus de couleur qui porte l’information de couleur de cet objet. La couleur d’un objet, selon sa nature, est définie et mesurée par son spectre de réfléctance (sa capacité à réfléchir) ou de transmitance (sa capacité à transmettre). Un matériau réfléchissant (transmettant) la lumière est caractérisé par son réflectance (transmittance) spectrale R(λ)(T(λ)) ; rapport entre l’énergie de la lumière réfléchie (transmise) par le matériau et l’énergie de la lumière incidente. Cet objet est caractérisé aussi, par son facteur spectral de luminance. Ce facteur est défini comme étant le « rapport de la luminance énergétique de l'élément de surface dans la direction donnée à celle d'un diffuseur parfait par réflexion ou par transmission irradie dans les mêmes conditions» [CIE, 1987]. La luminance énergétique est le rapport de l’intensité énergétique élémentaire sur l’aire de la surface apparente vue de l’émetteur.

III.3 l’observateur

Le troisième aspect intervenant dans la perception des couleurs tient au fait qu’il peut exister des variations individuelles appréciables, non seulement dans le temps pour un même sujet, mais aussi d’un sujet à l’autre [Trouve, 1991]. En effet, La vision des couleurs pour une

même personne se modifie au fil des ans par le vieillissement progressif du cristallin qui jaunit. Alors que l’œil, organe de vision, est caractérisé par des paramètres physiologiques propres à chaque individu [Vandenbroucke, 2000].

L’AFNOR (Association Française de Normalisation) a défini physiquement le stimulus de couleur comme un rayonnement qui pénètre dans l’œil et produit une sensation de couleur. Autrement dit, on appelle stimulus S(λ) le signal qui résulte du produit du spectre d’une source I(λ) avec le spectre de réflectance d’un objet R(λ) [Trémeau, 2004].

S(λ) = I(λ) x R(λ) (1.2)

IV. Mécanisme de la vision des couleurs

Un stimulus qui parvient à un récepteur est le même quelque soit ce récepteur. Pour la perception humaine, le récepteur est l’œil. Afin de comprendre l’ensemble des phénomènes conduisant à la perception des couleurs, attardons-nous quelque peu sur l’œil et le mécanisme de la vision.

IV.1 Œil de l’être humain

Quatre-vingt à quatre-vingt-dix pour cent des neurones du cerveau humain sont dédiés à la vision [Young, 1991]. Ce qui explique l’importance de ce sens chez l’être humain mai aussi la complexité de son fonctionnement.

L’œil est le siège de la première étape du processus visuel qui consiste à projeter avec le maximum de précision, l’image d’un objet observé sur la rétine.

Après différents traitements préliminaires réalisés par la rétine, l’information visuelle transmise au cerveau, via le nerf optique, au niveau des aires visuelles que l’on trouve dans la partie arrière des deux hémisphères cérébraux (figure 1.5).

Fig. 1.5: Schéma global du système visuel humain [McGillSite]

La figure 1.6 présente le schéma général de l’œil humain, c’est un système optique évolué. Sa fonction est de focaliser un stimulus de couleur sur sa partie photosensible. Ce système fait intervenir principalement les trois éléments suivants: la cornée, le cristallin et l’iris.

La cornée, par sa forme convexe, rassemble les rayons lumineux. La quantité de lumière qui pénètre dans l’œil est ajustée par la fermeture ou la dilatation de l’iris. La lumière traverse alors le cristallin, ou lentille à focale variable, dont la forme peut être modifiée par les muscles ciliaires afin de mettre au point avec précision l’image d’un objet sur la rétine.

IV.2 La rétine

C’est au niveau de la rétine que se déroule une autre étape du processus visuel. La rétine est située sur le fond de l’œil. La figue 1.7 montre l’organisation des couches cellulaires de la rétine. Elle est constituée d’un assemblage de cellules de différents types, organisées en couches et ayant des propriétés particulières. La première couche sont des photorécepteurs, la

couche des cellules horizontales, des cellules bipolaires et des cellules amacrines et enfin la couche des cellules ganglionnaires. Ces couches sont séparées par des zones de connexions synaptiques: la couche plexiforme externe (PLE) et la couche plexiforme interne (PLI) [Benoit, 2007].

Fig. 1.6 : Schéma général de l’œil [Kolb, 1996]

IV.2.1 Transmission et transformation de l’information visuelle

La couche plexiforme externe correspond à la zone de jonctions entre les photorécepteurs, les cellules bipolaires et les cellules horizontales (figure 1.7). Chaque jonction permet le traitement de l’information issue des photorécepteurs via des interactions chimiques et électriques entre les différents éléments.

Les cellules horizontales, proches des cônes et des bâtonnets (figure 1.7), sont bien

moins nombreuses que les photorécepteurs. Grace à la prolongation de leur axone, ces cellules permettent de capter l’information électrique d’un grand nombre de photorécepteurs via des jonctions électriques résistives («Gap») [Mead, 1988]. Chaque cellule horizontale effectue un lissage spatio-temporel de l’information lumineuse des photorécepteurs auxquels elle est rattachée. Les cellules horizontales ont également une action dans la transmission en direction des cellules bipolaires de l’information provenant des photorécepteurs.

Fig. 1.7: Organisation des couches cellulaires de la rétine [GsbmeSite]

Les cellules bipolaires (figure 1.7) relient l’ensemble photorécepteurs/ cellules horizontales

aux cellules ganglionnaires. Elles constituent un relai de l’information.

La Couche Plexiforme Interne est le siège des interactions entre les cellules bipolaires, amacrines et ganglionnaires. Le résultat des interactions au niveau de la PLI est disponible au niveau des cellules ganglionnaires dont les axones forment le nerf optique.

Il existe une grande diversité de cellules ganglionnaires et amacrines. Les cellules amacrines sont de 20 types différents dont le rôle de beaucoup reste encore inconnu [Benoit, 2007]. Elles sont impliquées dans des processus de modulation de gain de la réponse des cellules bipolaires et des cellules ganglionnaires [Kolb, 1996]. Elles modulent aussi la réponse des champs récepteurs des cellules ganglionnaires en fonction de l’intensité des signaux afférants [Benoit, 2007].

Une fois traitée par la rétine, l’information visuelle est transmise par le nerf optique (axones des cellules ganglionnaires), pour 80(90) % d’entre eux, au corps genouillé latéral (noté

CGL), pour finalement aboutir au cortex visuel. Les autres fibres nerveuses cheminent en direction du colliculus supérieur [Chauvin, 2003] et le pluvinar avant de rejoindre les aires V2 et V3 du cortex visuel [Perreira, 2010]. Cependant, avant d’arriver dans les aires corticales, les axones se rassemblent au chiasme pour se partager selon les champs visuels auxquels ils correspondent. Ainsi, les parties droites de chaque oeil, comme elles sont représentées sur la figure 1.5, convergent vers le CGL du lobe gauche du cerveau, et vice-versa.

Le rôle principal des CGL est une fonction de relais de l’information, mais d’autres fonctionnalités sont supposées comme un rôle de relais de l’information portant sur les commandes motrices par exemple [Sherman, 2002].

IV.2.2 Sensation de la couleur

Le stimulus traverse les couches neuronales de la rétine et arrive au niveau des photorécepteurs. Ces cellules ont pour but d’effectuer la transduction du stimulus lumineux en un potentiel de membrane (signal nerveux). Les photorécepteurs présentent des sensibilités spectrales (couleur) et des sensibilités en amplitude (quantité de lumière) différentes [Benoit, 2007]. C’est donc à l’aide de ces cellules que s’effectue la majeure partie de la perception des couleurs. On trouve deux types de photorécepteurs: cônes et bâtonnets.

Le tableau 1.3 résume les principales caractéristiques des cellules photoréceptrices de la rétine. La population des bâtonnets est nettement plus importante que celle des cônes [Bullier, 1998]. La répartition des cônes et des bâtonnets n’est pas uniforme sur la rétine, les bâtonnets ont une répartition plus dense à la périphérie. Les bâtonnets sont responsables de la vision scotopique: faible intensité lumineuse (vision de nuit). Ce type de cellule est activé lorsque la quantité de luminance varie entre 10-6cd/m2à 10-2cd/m2. A cette faible intensité de la lumière, l’œil ne perçoit plus l’information couleur. Le seuil de saturation de ces cellules est 10 cd/m2. La sensibilité spectrale des bâtonnets est liée à la présence d’un potopigment particulier, la rhodopsine, qui présente un maximum à 500 nm.

Fig. 1.8 Concentration des photorécepteurs en fonction de l’excentricité [McGillSite].

Lorsque l’intensité de la lumière augmente jusqu’à 10-3cd/m2, seuil d’activation des cônes, la sensation de la couleur apparaît. Ils sont responsables de la vision photopique: vision dans les hautes intensités lumineuses (vision de jour). La figure 1.8 présente la variation de la concentration des photorécepteurs. La zone centrale (faible excentricité) ne contient que des cônes, elle constitue la fovéa. La fovéa, située au centre de la macula, correspond à une petite région circulaire de 1,5 cm de diamètre [Meurie, 2005]. Dans cette zone les cônes sont présents en très grande majorité avec une densité 150 000 cônes par mm2 [Trémeau, 2004]. Donc, ils sont responsables de la vision de précision (haute résolution). Il existe trois types de cônes selon leurs sensibilités spectrales [Bowmarker, 1980] L, M, et S, d’où la notion de trivariance de la perception humaine. Ils présentent chacun une réponse différente selon les longueurs d’onde du rayonnement lumineux incident (figure 1.9). Cône “L” (Long) sensible aux grandes longueurs d’onde visibles, la réponse maximale se situe dans la teinte rouge à 580nm. Cône “M”(Medium) sensible aux longueurs d’onde visibles moyennes, la réponse maximale se situe dans la teinte verte à 545 nm. Cônes “S” (Short) sensible aux longueurs d’onde visibles courtes, la réponse maximale se situe dans la teinte bleue à 440 nm.

Type localisation Résolution

spatiale Réponse sensibilité couleur nombre Cônes Dans la

fovéa élevée rapide basse

Oui (R,V,B)

6millions 5% bâtonnets Sauf la

fovéa basse Lent élevée non

125millions 95%

Tableau 1.3: Principales caractéristiques des cellules photoréceptrices de la rétine [Perreira, 2010].

Fig. 1. 9: Fonctions d’absorption relative des cônes et des bâtonnets [Dartnall, 1983].

IV.3 Cortex visuel

Le signal couleur parvient enfin au cortex visuel situé dans la partie postérieure du cerveau. C’est à ce niveau que nous interprétons le signal couleur et nous donnons un sens aux scènes observées par nos yeux.

Le cortex est organisé en six couches, noté V1, V2, V3, V3A, V4, V5. Chacune

des couches a un rôle dans le traitement de l’information. La figue 1.10 présente le cheminement de l’information visuelle à travers les différentes couches du cortex visuel. C’est le chemin principal de notre vision consciente.

Seul le fonctionnement de l’aire V1 étant le plus connu. Ce qui se passe exactement

dans les autres couches n’est pas parfaitement connu et reste l’objet de plusieurs recherches.

Fig. 1.10: Cheminement de l’information visuelle à travers les différentes couches du cortex visuel [Perreira, 2010].

Notons que la moitié de la surface corticale correspond à la zone fovéale de la rétine. Ceci est principalement dû à l’échantillonnage non régulier des photorécepteurs sur la rétine (leur répartition est particulièrement dense dans la fovéa) [Bullier, 2001].

Des chercheurs [DeValois, 1985] ; [Harvey, 1990] ont montré qu’il existe au sein de l’aire V1 des cellules sensibles aux orientations et aux fréquences qui conduisent à la décomposition de la scène visuelle en bandes d’orientations et en bandes de fréquences. En plus le V1 a pour rôle de traiter l’information couleur; les cellules de cette zone effectuent un calcul de rapport entre les trois couleurs de base (rouge, vert et bleu) [Perreira, 2010]. A la sortie de V1, l’information concernant la forme, la couleur et le mouvement sont séparés.

Plus loin dans la voie ventrale, lorsque les signaux atteignent le lobe temporal, les cellules réagissent à des caractéristiques de bien plus haut niveau (visages, objets complexes). A ce stade, les champs récepteurs des cellules sont tellement larges que toute information spatiale est perdue. Il se pose alors le problème de la correspondance entre l’objet perçu (traité par la voie ventrale) et sa localisation dans le champ visuel (traitée par la voie dorsale) [Perreira, 2010].

V. La colorimétrie

Beaucoup d’applications nécessitent la mesure de manière objective la couleur d’un objet. La colorimétrie a pour but d’associer à chaque stimulus élémentaire (correspondant à une zone définie du champ visuel, placé sous un éclairage uniforme, sur un fond de couleur neutre, n’ayant pas de texture apparente) une mesure de stimulus couleur [Trémeau, 2004]. Elle est fondée sur la théorie trichomatique. L’existence de trois types de pigments dans les photorécepteurs des cônes fournit une base physiologique à la théorie trichromatique ou trivariance visuelle de la perception des couleurs [Trouvé, 1991].

V.1 Trivariance

Le principe de la trivariance est basé sur le fait que la perception humaine de la couleur est caractérisée par son aspect tridimensionnel. En effet, le principe de la trivaraiance a été défini par l’AFNOR comme suit: « principe selon lequel un rayonnement de couleur quelconque mais réel, c’est-à-dire issu de sources réelles ou non, peut être reproduit visuellement à l’identique, dans des conditions d’observation déterminées, par mélange algébrique, en proportions définies de manière unique, des flux lumineux de trois rayonnements de couleur réels (appelés primaires ou stimuli de référence) qui ne peut être reproduit par un mélange approprié des deux autres».

Il existe deux types de mélange (figure 1.11): mélange par synthèse additive et mélange par synthèse soustractive. Le mélange par synthèse additive résulte de la juxtaposition de trois lumières primaires (rouge, verte et bleue). La superposition des trois couleurs primaires en quantité égale donne le blanc. La synthèse additive est utilisée pour constituer l’image d’un téléviseur ou d’un moniteur couleur, celle d’une photographie ou celle acquise par une caméra couleur, par exemple. Le mélange par synthèse soustractive résulte par élimination ou diminution de certaines plages de longueurs d’onde. En effet, on effectue un mélange soustractif lorsqu’on mélange les différentes peintures. La synthèse soustractive

est utilisée en imprimerie et en peinture. La synthèse soustractive de trois primaires (magenta, le cyan et le jaune) doit permettre d’absorber une lumière blanche et donner ainsi le noir.

(a) (b)

Fig. 1.11 :(a) Synthèse additive. (b) Synthèse soustractive[Gouiffès, 2005]

Les lois consignant les propriétés fondamentales des mélanges de couleurs sont proposées par Grassman en 1853 et Abney en 1913 [Grassman, 1953], [Abney, 1913]. Ces lois permettent d’appliquer les propriétés additives, associatives, multiplicatives et transitives des égalités algébriques aux égalités colorimétriques [Trouvé, 1991]. Elles sont aujourd’hui les bases mathématiques de la colorimétrie.

C’est cependant Maxwell [Maxwell, 1960] qui réalise les premières mesures visuelles en 1855 et détermine en 1860 les premières fonctions de mélanges, appelées aujourd’hui fonctions colorimétriques, par une expérience d’égalisation ou expérience d’appariement [Vandenbroucke, 2000].

V.2 Expérience d’égalisation

La théorie de trivariance se base sur un principe expérimental d’égalisation de lumières colorées par synthèse additive de trois lumières primaires. Ces trois couleurs sont arbitrairement choisies sous la seule réserve qu’aucune d’entre elles ne puisse être reproduite par un mélange approprié des deux autres [Trémeau, 2004], car cela reviendrait à ne travailler

qu’avec deux primaires. En théorie, cette synthèse permet de reproduire l’ensemble des couleurs visibles par le système visuel humain.

Le principe de base de ces expériences est celui de l’égalisation de couleurs qui consiste, pour un observateur lambda, à comparer un stimulus visuel à un stimulus de référence. Les stimuli présentés sont placés dans un champ visuel uniforme entouré d’un fond achromatique.

Les trois couleurs les plus naturellement utilisées sont le rouge (R), le bleu(B) et le vert(V), rejoignant ainsi les trois types de pigments des cônes (Figure 1.12). En se basant sur les expériences de Guild [Guild, 1926] et Wright [Wright, 1981], la CIE en 1931 a normalisé un système de primaire RVB. Dans l’expérience de Guild, le champ visuel est carré sous-tendant un angle de 2°, vu sur un fond noir, et les primaires utilisés proviennent d’une source à incandescence, filtré pour donner des lumières presque monochromatiques, de longueur d’onde dominante à 630 nm, 543 nm et 460nm. Wright a réalisé l’expérience dans les mêmes conditions sauf que les primaires utilisées proviennent d’un monochromateur générant des longueurs d’onde monochromatiques à 650 nm, 539 nm et 460nm.

Ces expériences ont permis de montrer qu’il est possible d’égaliser n’importe quel stimulus monochromatique S avec un minimum de trois lumières monochromatiques.

Fig. 1.12: Egalisation d’une couleur monochromatique par trois primaires Monochromatiques [HEUS, 2009].

L’expérience consiste à déterminer le seul triplet de valeurs (r ,g ,b)

i qui permet d’obtenir une égalisation visuelle parfaite entre le stimulus monochromatique

s

présenté et la couleur issue de cette combinaison de primaires R, G et B, et ce pour tous les stimuli du domaine du visiblei 380nm,...,700nm. Ce triplet (r, g, b) définit les composantes trichromatiques de S dans l’espace colorimétrique engendré par R, G et B (équation 1.3).) 3 . 1 ( ). ( ). ( ). ( ) ( r R g G b B S

L’ensemble des composantes trichromatiques de tous les stimuli monochromatiques du spectre visible forme les fonctions colorimétriques notées r(λ) g(λ) b(λ), également appelées composantes trichromatiques spectrales.

V.3 Fonctions colorimétriques de la CIE

Dans ce paragraphe, nous ne présentons que les fonctions colorimétriques normalisées par La Commission internationale de l’éclairage (CIE): les fonctions r(),g(),b()

associées aux trois couleurs primaires R, G et B, ainsi les fonctions x(λ), y(λ) et z(λ) associées aux trois couleurs primaires X,Y et Z.

V.3.1 Fonctions colorimétriques r(λ), g(λ) et b(λ)

En 1931, la CIE s’appuie sur les expériences d’égalisation de Guild et Wright pour définir les fonctions colorimétriques associées aux trois couleurs primaires suivantes : 700nm pour les rouges, 546,1nm pour le vert et 435,6 nm pour le bleu.

Ces fonctions colorimétriques traduisent le comportement d’un observateur moyen ayant une vision normale des couleurs et utilisant un champ visuel restreint d’une étendue angulaire de 2°. Ces fonctions (nommées r(λ), g(λ), b(λ)) correspondent aux fractions de lumière de couleurs primaires R, G, B nécessaires pour reproduire toutes les couleurs du spectre visible (figure 1.13) [Pousset, 2009]. Ces courbes se vérifient pour 90% des

observateurs. Elles caractérisent ce que l’on appelle l’observateur standard CIE 1931[Trémeau, 2004].

Fig. 1.13: Fonction colorimétrique du système RGB de l’observateur de référence CIE 1931 à 2° [Vandenbroucke, 2000]

La figure 1.13 montre que la courbe de la fonction r(λ) présente une partie négative, ce qui contredit le principe de la synthèse additive. C’est le cas par exemple des couleurs très saturées qui ne peuvent pas être égalisées par ce principe même avec l’élimination de l’une ou plusieurs des primaires. Dans ce cas, on utilise l’artifice de dé-saturation; c’est une opération qui consiste à superposer une faible quantité de la primaire complémentaire à la couleur considérée. Prenons par exemple la couleur bleu-vert très saturé, il est impossible d’obtenir une égalisation où les trois composantes primaires RGB sont positives. Dans ce cas, l’artifice consiste à désaturer la couleur bleu vert en lui ajoutant une quantité du primaire rouge, ce qui donne: ) 4 . 1 ( ). ( ). ( ). ( ) ( r R g G b B S Soit: ) 5 . 1 ( ). ( ). ( ). ( ) ( r R g G b B S

![Tableau 1.1: Quelques types d’images [Rabaud, 2005]](https://thumb-eu.123doks.com/thumbv2/123doknet/2198608.12245/22.892.99.794.676.1082/tableau-quelques-types-d-images-rabaud.webp)

![Fig. 1.10: Cheminement de l’information visuelle à travers les différentes couches du cortex visuel [Perreira, 2010].](https://thumb-eu.123doks.com/thumbv2/123doknet/2198608.12245/36.892.118.788.199.409/cheminement-information-visuelle-travers-couches-cortex-visuel-perreira.webp)

![Fig. 1.13: Fonction colorimétrique du système RGB de l’observateur de référence CIE 1931 à 2° [Vandenbroucke, 2000]](https://thumb-eu.123doks.com/thumbv2/123doknet/2198608.12245/41.892.201.687.247.580/fig-fonction-colorimetrique-systeme-rgb-observateur-reference-vandenbroucke.webp)

![Fig. 1.14: Fonction colorimétrique du système XYZ de l’observateur de référence CIE 1931 à 2° [Vandenbroucke, 2000]](https://thumb-eu.123doks.com/thumbv2/123doknet/2198608.12245/43.892.199.685.266.608/fig-fonction-colorimetrique-systeme-xyz-observateur-reference-vandenbroucke.webp)