Faculté des Sciences, 4 Avenue Ibn Battouta B.P. 1014 RP, Rabat – Maroc Tel +212 (0) 37 77 18 34/35/38, Fax : +212 (0) 37 77 42 61, http://www.fsr.ac.ma

Rabat N° d’ordre : 2858

THÈSE DE DOCTORAT

Présentée par

Zakaria El KADMIRIDiscipline : Physique

Spécialité : Électronique Et Traitement Des Images

Titre

TRAITEMENT DES IMAGES OMNIDIRECTIONNELLES ET

STEREOVISION CATADIOPTRIQUE

Soutenue le 16 Avril 2016 devant le jury composé de :

Président :

Mr. Abdenbi BOUZID PES Faculté des Sciences Meknès, Maroc

Examinateurs :

Mr. Lhoussaine MASMOUDI PES Faculté des Sciences de Rabat, Maroc Mr. Noureddine ZAHID PES Faculté des Sciences de Rabat, Maroc Mr. Ahmed ROUKHE PES Faculté des Sciences de Meknès, Maroc Mr. Hlou LAAMARI PES Faculté des Sciences de Kenitra, Maroc Mr. Abderrahmane HAJRAOUI PES Faculté des Sciences de Tétouan, Maroc

A mon père ;

A la mémoire de ma mère ;

A ma femme Ilham ;

A mon frère Omar ;

A ma sœur Nadia ;

A mon frère Samir ;

Remerciements

Les travaux de la présente thèse qui s’intéressent aux domaines de la vision artificielle et du traitement des images numériques ont été mené au Laboratoire d’Electronique et de Traitement du Signal/Géomatique, structure de recherche affiliée à la Faculté des Sciences de Rabat, Université Mohammed V.

Je voudrais commencer par remercier le Pr. Lhoussaine MASMOUDI pour m’avoir accueilli au sein du laboratoire d’électronique et de traitement de signal/Géomatique et pour avoir accepté d’être mon directeur de thèse. Qu’il reçoive mes sincères remerciements pour les conseils et encouragements qu’il m’a prodigués et pour la confiance qu’il m’a témoignée.

Je suis très reconnaissant à M. Abdenbi BOUZID, Professeur d’enseignement supérieur à la Faculté des Sciences de Meknès de m'avoir fait l'honneur de présider le jury.

Je remercie également le Professeur d’enseignement supérieur à la Faculté des Sciences de Tétouan, M. Abderrahmane HAJRAOUI, d’avoir rapporté ma thèse et en tant que membre du jury.

Je tiens à remercier M. Ahmed ROUKHE, Professeur d’enseignement supérieur à la Faculté des Sciences de Meknès en tant que rapporteur ainsi que membre du jury.

Mes remerciements sont adressés à M. Hlou LAAMARI, Professeur d’enseignement supérieur à la Faculté des Sciences de Kenitra ayant rapporté ma thèse et en tant que membre du jury.

Je remercie le Professeur d’enseignement supérieur à la Faculté des Sciences de Rabat, M. Noureddine ZAHID d’avoir accepté de rapporter ma thèse, et d’avoir assisté à ma soutenance de thèse en tant que membre du jury.

Bien qu'il y ait généralement un seul nom comme auteur, une thèse de doctorat est communément le fruit de la collaboration entre plusieurs chercheurs, et mon cas n’était pas une exception. En plus du soutien que je reçu, j’ai eu la chance de collaborer avec mon frère Omar EL KADMIRI. J'aimerais lui exprimer ma sincère gratitude pour sa contribution, son aide qui a amélioré la qualité de cette thèse. Le soutien et l’aide de personnes en dehors du laboratoire sont aussi importants. Mes vifs remerciements vont à M Saih Abdelilah et Aziz Bahomad, qui ont sacrifié des heures de travail en atelier pour la concrétisation des réalisations dans le cadre de ce travail.

Je tiens à remercier Saleh EL JOUMANI, Salah MOUGHYT, Said OUKACHA, et Zakaria EL JOUAHARI, qui ont partagé avec moi la passion de l’électronique et de la robotique.

Mais bien sûr, tout cela a été possible grâce à l'appui inconditionnel et encouragements de ma famille. Surtout de mes parents, Ali et Fatima, et ma sœur Nadia. Merci!

Abstract

In computer vision, many applications require acquiring images with a wide field of view. A constraint that cannot be satisfied by conventional vision systems. Researchers and practitioners are using different techniques for acquiring images of the entire scene. In this context, one of the effective means for improving the field of view is the use of mirrors in combination with conventional cameras to acquire catadioptric images.

Omnidirectional cameras can certainly increase the field of view but to the detriment of the simplicity of processing. The specific formation geometry of catadioptric images, the strong distortions they incorporate make using conventional processing operators inappropriate.

Also, omnidirectional vision has become a relevant tool for the visual perception of depth through omnistereo configurations. A need that some types of application require. However, the design and the choice of the configuration of an omnistereo system seems problematic since it must satisfy the requirements of the desired application.

As a contribution in the field of omnidirectional images processing, the first part of this study has been devoted to the development of a new edge detection operator adapted to the geometry of these images.

In a second part, we focus on omnistereo systems where we present the design of two new catadioptric omnistereo systems with spherical mirrors in vertical configuration. The experimental results obtained are encouraging and demonstrate that these sensors can be used in applications involving robotic systems.

Back to the initial motivation for the design of new sensors, i.e. applications. We discover the use of catadioptric cameras for a mobile robot and then for a solar tracker.

Keywords: omnidirectional stereo vision, catadioptric camera, image processing, autonomous systems.

Résumé

En vision artificielle, de nombreuses applications exigent l’acquisition d’images avec un large champ de vue. Une condition qui ne peut être remplie par les systèmes de vision conventionnels. Les chercheurs et les praticiens ont donc recours à différentes techniques pour l’acquisition d’images de la scène entière. Dans ce contexte, l’un des moyens efficaces pour améliorer le champ de vision est l'utilisation de miroirs en combinaison avec des caméras classiques pour l’acquisition des images catadioptriques.

Les caméras omnidirectionnelles permettent certes, d’augmenter le champ de vision mais cela au détriment de la simplicité des traitements. La spécificité de la géométrie de formation des images catadioptriques, les fortes distorsions qu’elles incorporent rendent l’utilisation des opérateurs classiques de traitement d’images inadaptée.

Aussi, la vision omnidirectionnelle s’est imposé comme outil pertinent pour la perception visuelle de la profondeur (3D) par le biais de configurations omnistéréo. Besoin que certains types d’application exigent. Cependant, la conception et le choix de la configuration d’un système omnistereo s’avère problématique dans la mesure où celui-ci doit rependre aux exigences de l’application ciblée.

En guise de contribution dans le domaine du traitement des images omnidirectionnelles, un premier volet de cette étude a été consacré au développement d’un nouvel opérateur de détection de contours adaptés à la géométrie de ces images.

Dans un deuxième volet, nous nous concentrons sur les systèmes omnistéréo où nous présentons la conception de deux nouveaux systèmes omnistéréo catadioptriques à miroirs sphériques et à configuration verticale. Les résultats expérimentaux obtenus sont encourageants et prouvent que ces capteurs peuvent être utilisés dans des applications impliquant des systèmes robotisés.

En retour à la motivation initiale pour la conception de nouveaux capteurs, à savoir les applications. Nous découvrons l’exploitation de l’intégration des caméras catadioptriques à un robot mobile puis à la conception d’un suiveur solaire.

Mots-clefs : traitement d’images, caméra catadioptrique, stéréovision omnidirectionnelle, systèmes autonomes

Table des Matières

Remerciements ... i

Abstract ... ii

Résumé ... iii

1.

La vision omnidirectionnelle ... 1

1.1 Introduction ... 1 1.2 La vision panoramique ... 11.3 Acquisition des images omnidirectionnelles ... 5

1.3.1 Images multiples ... 5

1.3.2 Les lentilles spéciales ... 7

1.3.3 Les capteurs catadioptriques ... 9

1.4 Contexte, problématique et contribution ... 10

2.

Traitement des images omnidirectionnelles ... 12

2.1 Introduction ... 12

2.1 Outils classiques de détection de contours ... 14

2.1.1 Méthodologies de détection de contours ... 14

2.1.2 Détecteurs de contours du premier ordre / Basé sur le gradient ... 14

2.1.3 Détecteurs de contours du second ordre ... 18

2.2 Le traitement des images omnidirectionnelles ... 19

2.2.1 Équivalence avec la projection sphérique puis stéréographique ... 19

2.2.2 Développement d’un nouveau détecteur de contours... 21

2.3 Conclusion ... 33

3.

Capteurs catadioptriques : caractéristiques, classification

et application aux systèmes robotisés ... 34

3.1 Introduction ... 34

3.2 Les systèmes de visions catadioptriques ... 35

3.2.1 Contexte et notions de base ... 35

3.2.2 Caractéristiques et classification des systèmes catadioptriques ... 37

3.3 Application à la robotique mobile ... 56

3.3.1 Introduction ... 56

3.3.2 Plateforme expérimentale ... 57 3.3.3 Algorithme de représentation et de suivi par invariance chromatique

3.3.4 Résultats expérimentaux ... 61

3.4 Application à la conception et réalisation d’un Suiveur Solaire ... 62

3.4.1 Introduction ... 62

3.4.2 Conception du suiveur solaire omnidirectionnel ... 65

3.4.3 Résultats expérimentaux ... 67

3.4.4 Discussions et perspectives ... 70

3.5 Conclusion ... 72

4.

Etude et conception de capteurs de stéréovision

omnidirectionnels ... 73

4.1 Introduction ... 73

4.2 Configurations des systèmes de stéréovision omnidirectionnelle ... 76

4.2.1 Configuration binoculaire-H ... 76

4.2.2 Configuration binoculaire-V ... 79

4.2.3 Notes sur la stéréovision omnidirectionnelle ... 83

4.3 Conception d’un nouveau capteur omnistéréo à caméra unique ... 84

4.3.1 Sélection du miroir ... 84

4.3.2 Sélection de la configuration ... 85

4.3.3 Solution matérielle et étalonnage ... 85

4.3.4 Estimation de la profondeur par triangulation passive ... 87

4.3.5 Protocoles expérimentaux et méthodes de validation ... 90

4.3.6 Discussion et synthèse ... 93

4.4 Conception d’un nouveau capteur omnistéréo à double caméra ... 94

4.4.1 Architecture matérielle du capteur omnistéréo ... 95

4.4.2 Modélisation et calcul de la profondeur ... 95

4.4.3 Résultats expérimentaux et discussion ... 99

4.5 Conclusion ... 104

5.

Conclusions et perspectives ... 105

Table des figures

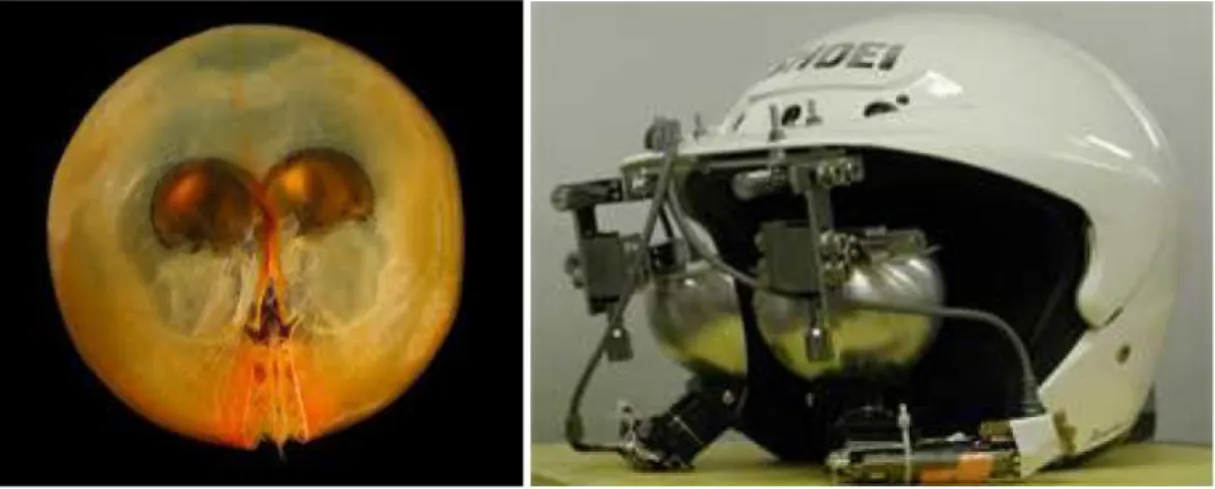

Figure 1-1 : œil composé de la Libellule ... 2

Figure 1-2 : Système d'imagerie modélisé comme un ensemble de capteurs de lumière sur une sphère. Proposé par Grossberg M.D. et Nayar S.K ... 3

Figure 1-3 : Gigantocypris en comparaison avec le HMD (Head Mounted Display). (a) l’Ostracod Gigantocypris avec de larges yeux réfléchissants agissant comme un capteur catadioptrique. (b) Head Mounted Display pour la vision immersive. ... 4

Figure 1-4 : Capteur de mesure de la profondeur 3D à l'aide d'une caméra montée sur un bras de robot tournant ... 5

Figure 1-5 : Un anneau de caméras avec des champs de vue complémentaires .... 6

Figure 1-6 : Lentille Fish-eye. (a) Image acquise avec une lentille Fish-eye. (b) Lentille Nikkor montée sur un appareil Nikon F3. ... 7

Figure 2-1 : Classification de détecteurs de contours ... 14

Figure 2-2 : Modèle de projection unifié ... 20

Figure 2-3 : La projection stéréographique. ... 21

Figure 2-4: Distribution de charges électriques sur la sphère ... 22

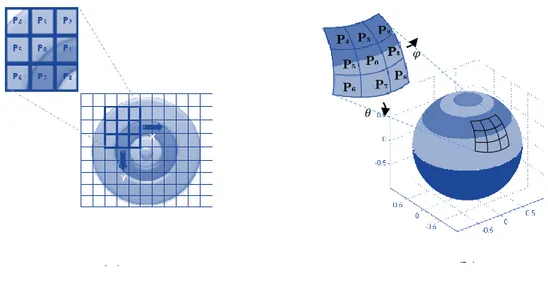

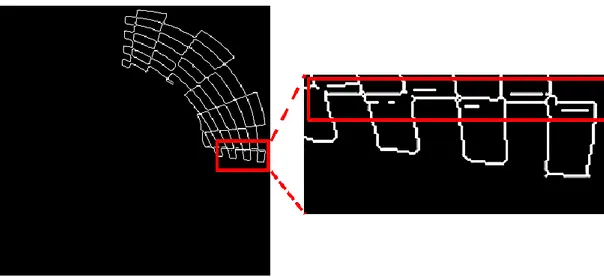

Figure 2-5 : a): illustration du voisinage dans le cas des filtres plans. (b): Voisinage dans le cas de filtrage sphérique. ... 25

Figure 2-6 : (a) Image catadioptrique. (b) Image mappée sur la sphère. (c) L’image panoramique correspondante. ... 26

Figure 2-7 : Algorithme de détection de contours proposé ... 26

Figure 2-8 : L’image synthétique générée pour l’évaluation quantitative de la détection de contours, avec un contour vertical à 0° et un contour diagonal à 60° ... 28

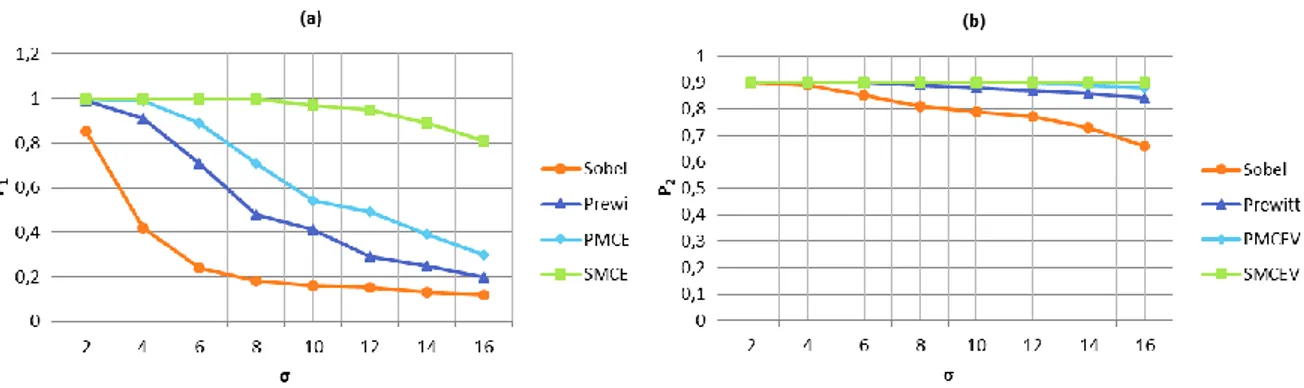

Figure 2-9 : (a) Valeurs de 𝑃1 avec bruit gaussien de variance croissante (contour vertical, un saut de 50 niveaux de gris). (b) Valeurs de 𝑃2. ... 29

Figure 2-10 : (a) Valeurs de 𝑃1 avec bruit gaussien de variance croissante (contour vertical, un saut de 100 niveaux de gris). (b) Valeurs de 𝑃2. ... 29

Figure 2-11 : (a) Valeurs de 𝑃1 avec bruit gaussien de variance croissante (contour vertical, un saut de 150 niveaux de gris). (b) Valeurs de 𝑃2. ... 29

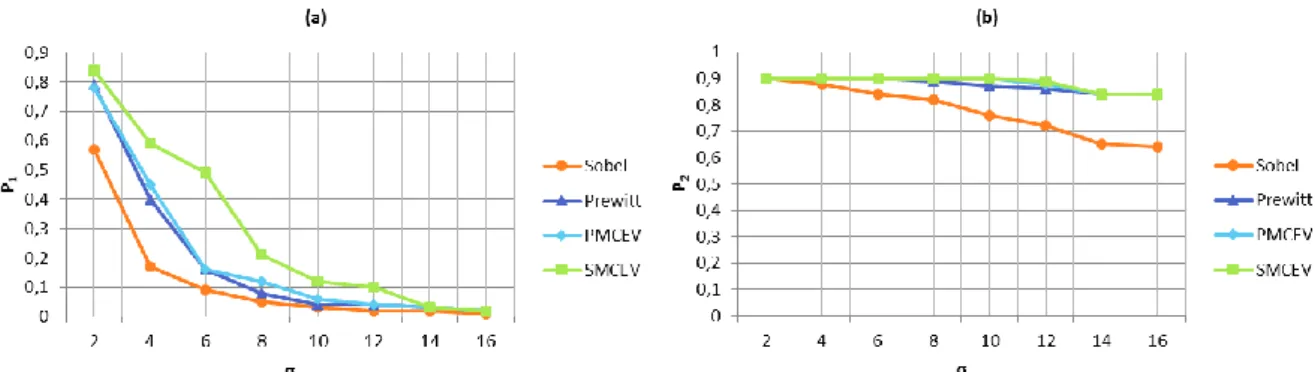

Figure 2-12 : (a) Valeurs de 𝑃1 avec bruit gaussien de variance croissante (contour diagonal, un saut de 50 niveaux de gris). (b) Valeurs de 𝑃2. ... 30

Figure 2-13 : (a) Valeurs de 𝑃1 avec bruit gaussien de variance croissante (contour diagonal, un saut de 100 niveaux de gris). (b) Valeurs de 𝑃2. ... 30

Figure 2-14 : (a) Valeurs de 𝑃1 avec bruit gaussien de variance croissante (contour diagonal, un saut de 150 niveaux de gris). (b) Valeurs de 𝑃2. ... 30

Figure 2-15 : Image réelle utilisée pour l’évaluation de la détection de contours 31 Figure 2-16 : Image réelle filtrée avec l’opérateur de Sobel. ... 32

Figure 2-17 : Image réelle filtrée avec l’opérateur de Prewitt. ... 32

Figure 2-18 : Image réelle filtrée avec l’opérateur PMCEV ... 32

Figure 2-19 : Image réelle filtrée avec l’opérateur SMCEV. ... 33 Figure 3-1 : (a) Des exemples de sections coniques : la parabole et l'ellipse formées par l’intersection d'une seule nappe de cône avec un plan qui n’est pas perpendiculaire à l’axe ; le cercle produit par l'intersection du cône avec un plan

perpendiculaire à son axe; et l'hyperbole, formée par un plan coupant les deux

nappes d'un cône. (b) Quatre coniques ayant même foyer et même directrice ... 36

Figure 3-2 : Capteur catadioptrique associant une caméra classique et un miroir de révolution ... 37

Figure 3-3 : Système catadioptrique à miroir plan ... 38

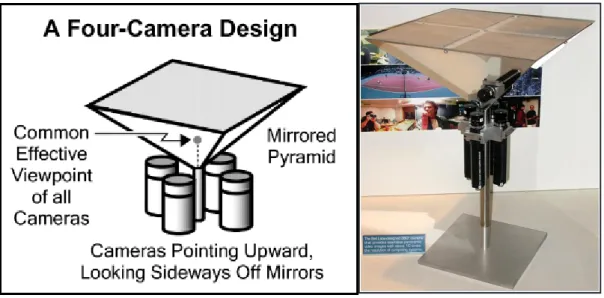

Figure 3-4 : La conception originale de Nalwa a été composée par quatre miroirs disposés dans une configuration pyramidale et le même nombre de caméras orienté vers chaque miroir. ... 39

Figure 3-5 : Système stéréoscopique à caméra unique et deux miroirs plans ... 40

Figure 3-6 : Système catadioptrique à miroir ellipsoïde ... 41

Figure 3-7 : la projection d’un point q de l’espace par un système stéréo catadioptrique avec caméra unique et deux miroirs ellipsoïdaux ... 42

Figure 3-8 : Système catadioptrique à miroir hyperbolique ... 42

Figure 3-9 : Prototype du système HyperOmni Vision ... 43

Figure 3-10 : Système catadioptrique à miroir parabolique ... 45

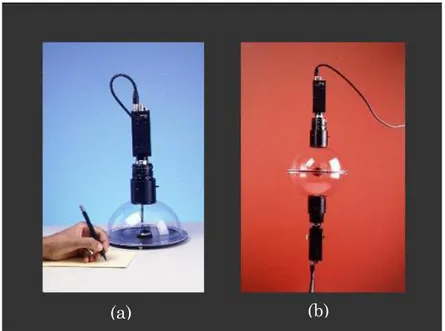

Figure 3-11 : Caméras omnidirectionnelles réalisées par Nayar en 1997. (a) champ de vision hémisphérique. (b) Champ de vision sphérique. ... 46

Figure 3-12 : Système catadioptrique à miroir conique ... 48

Figure 3-13 : Système catadioptrique à miroir sphérique ... 50

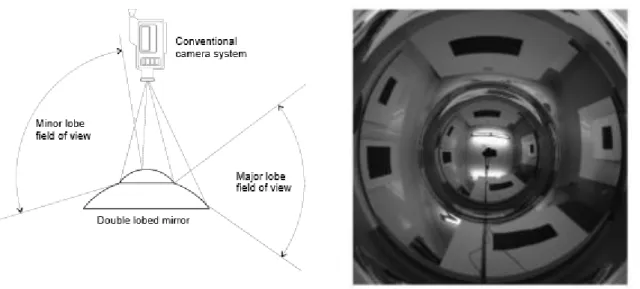

Figure 3-14 : Système stéréoscopique à miroir sphérique. (a) Deux miroirs sphériques associés à une caméra perspective. (b) Image réfléchit sur les deux miroirs sphériques lobés. ... 51

Figure 3-15 : Miroir spécial conçu pour une projection perspective. (a) Miroir spécial réalisé par A. Hicks. (b) Image obtenue par le miroir de Hicks ... 52

Figure 3-16 : Miroir spécial utilisé par J. Gaspar. ... 53

Figure 3-17 : Formation des courbes caustiques sur une surface plane ... 53

Figure 3-18 : Capteur de vision omnidirectionnel utilisé ... 58

Figure 3-19 : le robot "ESCALADE360 v2.0" avec le capteur omnidirectionnel embarqué ... 58

Figure 3-20 : Détection et orientation du robot vers la cible ... 60

Figure 3-21 : Expérience de suivi autonome d’une cible en mouvement ... 61

Figure 3-22 : Photo-capteur à balance de luminosité ... 63

Figure 3-23 : (a) Carte de la trajectoire solaire de Rabat (Maroc). (b) Illustration de la localisation du soleil avec une caméra catadioptrique. ... 64

Figure 3-24 : (a) Helianthus360. (b) Architecture du suiveur solaire proposé ... 65

Figure 3-25 : (a) Image omnidirectionnelle échantillon d'un ciel partiel. (b) L'image omnidirectionnelle après seuillage. (c) Schématisation de la procédure de suivi du soleil. ... 66

Figure 3-26 : Les mesures de puissance du 17 Juillet 2013. ... 67

Figure 3-27 : Les mesures de puissance du 20 Septembre 2013. ... 68

Figure 3-28 : (a) Première expérience 17 Juillet 2013. L’ensoleillement total journalier: 25.7 𝑀𝐽𝑚2 (b) Deuxième expérience 20 septembre 2013. L’ensoleillement total journalier: 21 𝑀𝐽𝑚2. ... 69

Figure 3-29 : Module d’acquisition à balance d’illumination. (b) Circuit de commande du suiveur solaire classique. ... 70

Figure 4-1 : Stéréoscopie binoculaire à une seule caméra mobile ... 73

Figure 4-2 : Stéréoscopie binoculaire à deux caméras ... 73

Figure 4-3 : Modèle géométrique du capteur stéréoscopique binoculaire ... 74

Figure 4-4 : le système de stéréovision omnidirectionnelle SPHEREO ... 75

Figure 4-5 : (a) Système omnistéréo à configuration binoculaire horizontale. (b) Triangulation ... 77

Figure 4-6 : lignes épipolaires ... 78

Figure 4-7 : Structure modulaire de la tête d’humanoïde ... 78

Figure 4-8 : Robot mobile équipé du système omnistéréo binoculaire-H ... 79

Figure 4-9 : Géométrie épipolaire. (a) les lignes épipolaire sont radiales dans l’mage omnidirectionnelle. (b) les lignes épipolaires deviennent parallèles après transformation en image panoramique ... 79

Figure 4-10 : Deux types de conceptions binoculaire-V. (a) deux paires caméra-miroir alignés verticalement. (b) Deux caméra-miroir et une caméra alignés verticalement. ... 80

Figure 4-11 : Configuration binoculaire-V ... 81

Figure 4-12 : Système omnistéréo binoculaire-V conçu par Gluckman, Nayar et Thoresz ... 81

Figure 4-13 : Système omnidirectionnel Stéréo à miroir parabolique. (b) Image acquise par le capteur ... 82

Figure 4-14 : (a) image Omnidirectionnelle acquise par un système de miroir à double lobes. (b) image panoramique obtenue par projection de l’image omnidirectionnelle sur un cylindre. ... 83

Figure 4-15 : (a) Structure du capteur catadioptrique proposé. (b) Configuration matériel du système omnistéréo réalisé. ... 86

Figure 4-16 : Illustration du processus d’ajustement du capteur catadioptrique. (a) Capteur non ajusté. (b) Capteur ajusté ... 87

Figure 4-17 : Triangulation passive dans le cas du système omnistéréo proposé. 88 Figure 4-18 : Une paire d’images omnistéréo. (a) Image acquise à position haute. (b) Image acquise à position basse. ... 91

Figure 4-19 : Courbe de variation de l’erreur, D=2.18. ... 91

Figure 4-20 : Courbe de variation de l’erreur, D=3.18. ... 92

Figure 4-21 : Courbe de variation de l’erreur, D=4.18. ... 92

Figure 4-22 : Champ de vision pour une configuration face à face ... 94

Figure 4-23 : Architecture du capteur omnistéréo proposé ... 95

Figure 4-24 : Modélisation conique axiale pour un miroir sphérique ... 96

Figure 4-25 : Triangulation passive du système proposé ... 97

Figure 4-26 : a) image de la grille acquise par le capteur catadioptrique b) Grille de calibration utilisée. ... 100

Figure 4-27 : Illustration des résultats de détection de coins du damier par l’opérateur de Harris dans l'image acquise par la caméra inférieure ... 101

Figure 4-28 : Illustration des résultats de détection de coins du damier par l’opérateur de Harris dans l'image acquise par la caméra supérieure ... 101

Figure 4-29 : scène représentant quatre cibles disposées à différentes directions azimutales ... 102

Liste des Tableaux

Tableau 3-1 : Configurations et caractéristiques des systèmes catadioptriques . 55

Tableau 3-2 : Variation de l’erreur en fonction de D, h=0.425m. ... 62

Tableau 3-3 : Gain journalier total de production d’électricité des suiveurs solaires étudiés ... 70

Tableau 4-1 : Tableau récapitulatif des principales configurations omnistéréo. . 84

Tableau 4-2 : Variation de l’erreur sur la profondeur en fonction de h pour D=2.18m ... 91

Tableau 4-3 : Variation de l’erreur sur la profondeur en fonction de h pour D=3.18m ... 92

Tableau 4-4 : Variation de l’erreur sur la profondeur en fonction de h pour D=4.18m ... 92

Tableau 4-5 : Estimation de la profondeur pour un baseline H= 43cm ... 99

Tableau 4-6 : Estimation de la profondeur pour un baseline H= 47,8cm ... 99

Tableau 4-7 : Estimation de la profondeur pour un baseline H= 53,5cm ... 99

Tableau 4-8 : Résultats d'estimation de la profondeur pour les coins identifiés par le détecteur de Harris avec la ligne de base H = 16,8 cm ... 101 Tableau 4-9 : Estimation de la profondeur pour les quatre cibles (H=16,8 cm) . 102

1. La vision omnidirectionnelle

1.1 Introduction

Les caméras actuelles sont des imitations de l'œil humain et sont, dans leur conception, descendants proches d'idées et de technologies qui sont vielles de plus d'un siècle. Dans la vision par ordinateur, les chercheurs ont traditionnellement utilisé des caméras standard pour des fins de recherches auxquels elles n’étaient pas destinées : ces caméras sont conçues pour capturer des images à imprimer sur papier ou à projeter sur un écran téléviseur, et non pas pour guider les robots ou concevoir des modèles 3D de l'environnement ou même surveiller une grande zone où un large champ de vue, des précisions géométriques et photométriques élevées sont nécessaires.

Des efforts significatifs ont été consentis, pertinemment, dans la vision par ordinateur visant à surmonter algorithmiquement ces problèmes. En fait, de nombreux travaux dans ce domaine ont démontré qu'il est possible de renoncer à la voie traditionnelle de l'utilisation de la caméra standard et de suivre le chemin de la conception de nouvelles caméras, explicitement, pour résoudre les tâches à accomplir dans les applications de vision par ordinateur. Cela conduit à différents concepts et permet d'atténuer un grand nombre des difficultés rencontrées dans le traitement des images prises avec les caméras "traditionnelles".

Avant d’aborder le contexte, la problématique abordée dans le cadre de cette thèse -que nous détaillerons en fin de ce chapitre- nous offrons, d’abord un aperçu sur la vision d'un point de vue sensoriel et sur les capteurs de vision panoramique depuis la perspective de la robotique. Le lecteur trouvera la séquence des arguments suivants : parmi les sens, la vision est généralement le meilleur choix ; parmi les capteurs de vision, ceux qui reproduisent les modèles de la nature sont les plus polyvalents ; parmi les capteurs de vision inspirées par la nature les omnidirectionnelles sont les plus appropriés pour les tâches de reconstruction et de navigation 3D.

1.2 La vision panoramique

La vision est certainement le plus important de nos cinq sens. Elle est un processus complexe qui nécessite la combinaison du travail de l'œil humain et le cerveau. Une composante essentielle du système de vision, soit humaine, animale ou artificielle, est le capteur de vision qui rassemble les données de l'environnement. A cause de nos capteurs, les yeux, la vision humaine a un champ de vision très limité (FOV : Field Of View) par rapport à d'autres organes visuels trouvés dans la nature. La puissance de calcul imposante offerte par le cortex cérébral permet aux humains d’effectuer des tâches de navigation et de reconnaissance, malgré le manque de l'information visuelle. Au cours de leur vie, d'autres animaux ont aussi besoin de trouver leur chemin dans des environnements imprévisibles, de reconnaître la nourriture ou éviter les prédateurs, entre autres tâches vitales.

Néanmoins, les cerveaux des insectes, par exemple, possèdent 105 à 106 neurones

par rapport à 1011 d'un cerveau humain et disposent donc de moins de puissance

de traitement. L'information visuelle est traitée par les insectes en utilisant un réseau neuronal, qui est un calculateur de bord biologique dont le poids est moins d’un milligramme et à la taille d'une tête d'épingle [1]. Il est plausible que la mémoire et la capacité de calcul d'un tel petit ordinateur sont inférieurs à ceux fournis par les puissants ordinateurs de nos jours. Cependant, les humains ne sont pas encore capables de construire des systèmes de vue similaire. Par conséquent, il est logique de penser que les performances de ces systèmes parfaits sont améliorées par la construction particulière de leurs yeux.

La majorité des arthropodes profitent d'un large champ de vue assuré par leurs yeux composés, comme le montre la 1figure 1-1. Un œil composé est un organe

visuel qui consiste entre 12 et 1000 ommatidies qui sont de minuscules capteurs qui distinguent entre la luminosité et l'obscurité, et parfois peuvent détecter la couleur. L'image perçue par l'arthropode est une combinaison des contributions de nombreuses ommatidies, qui sont orientés dans des directions légèrement différentes afin de couvrir un large champ de vue. Contrairement à d'autres types d'œil, il n'y a pas de lentille ou de la rétine centrale, entraînant une mauvaise résolution de l’image ; cependant, il peut détecter un mouvement rapide.

Trois classes principales d'yeux composés pour animaux, avec une capacité de vue panoramique ont été identifiées : insectes diurnes et nocturnes et certaines espèces de crustacés [2]. Alors que les yeux des insectes diurnes utilisent des cellules photoréceptrices qui couvrent une superficie maximale de la vision, ceux des insectes nocturnes concentrent tous les rayons incidents en un point focal ce qui améliore la vision nocturne. Dans les yeux composés des arthropodes diurnes, chaque ommatidie est séparée de ses voisins par des cellules pigmentées, ou d'iris,

1 Source de la figure : [130]

Figure 1-1 : œil composé de la Libellule

dans toutes les conditions d'éclairage. En conséquence, la 2rhabdome de chaque

ommatidie reçoit de la lumière uniquement à travers sa propre lentille cornéenne ; la lumière des lentilles d'autres ommatidies est bloquée par le pigment. Dans les yeux composés des arthropodes nocturnes, les rhabdomes sont au fond de l'œil, loin de la cornée et le cône cristallin ce qui crée un écart entre la cornée et la rhabdome. Le résultat est une image à la moitié du rayon de l'œil, soit à l'extrémité des rhabdomes. Par conséquent, en mettant en même temps de nombreux capteurs tels ommatidies de manière contrôlée conduit à un système d'imagerie souple et extrêmement fonctionnel. L'œil composé d'une libellule est un système de vision complexe qui aurait pu inspirer le capteur avec une structure et un comportement similaire proposé par Grossberg et Nayar [3] (voir 3figure 1-2)

Les yeux des crustacés sont constitués par des combinaisons de miroirs et surfaces de réfraction qui concentrent la lumière à différents points sur la rétine. L’ostracode gigantocypris montré sur la 4figure 1-3 (a) est un crustacé avec de

grands yeux ayant une structure similaire à l'optique utilisés pour les télescopes. Ses yeux sont adaptés aux conditions d'éclairage très faible des profondeurs des

2 Structure translucide en forme de bâtonnet au centre des ommatidies de l'Œil composé des arthropodes

3 Source de la figure [3] 4 Source de la figure [126]

Figure 1-2 : Système d'imagerie modélisé comme un ensemble de

capteurs de lumière sur une sphère. Proposé par Grossberg M.D. et Nayar S.K

océans. Le miroir parabolique qui compose ses yeux œuvre d'une manière similaire aux miroirs paraboliques utilisés par le HMD construit par Nagahara et al. [4] et présenté à la 5figure 1-3 (b).

La conception de nouveaux capteurs de vision est inspirée non seulement par les yeux des animaux, mais aussi par l'œil humain. Une vision pointue de l'œil se produit lorsque la lumière se concentre sur la petite partie de la rétine appelée fovéa. Cette région a une densité plus élevée de cellules photosensibles que partout ailleurs dans la rétine. Les capteurs visuels (space-variant visual sensors) [5] utilisent l'analogie avec l'œil humain : le capteur CCD (Charged Coupled Device) d'un tel capteur est composé par des cellules photoélectriques réparties en fonction de l'excentricité. La densité des cellules photoélectriques est plus élevée dans le centre ce qui signifie que la résolution du capteur est élevée dans la région centrale et diminue de façon monotone vers ses bornes. Une telle configuration de la rétine assure un compromis entre la résolution et champ de vue, réduit le volume des informations transmises et traitées par l'unité centrale et nécessite donc moins de puissance de calcul.

Comme nous l'avons vu dans les exemples ci-dessus, les gens ont réalisé que les modèles de caméras actuelles sont trop simples pour la plupart des tâches requises de nos jours. Les caméras traditionnelles sont conçues pour capturer les images à imprimer sur papier et non pas pour la reconnaissance de formes, la navigation de robot ou des tâches de surveillance. Par conséquent, un nombre important d'algorithmes et techniques ont été développées afin de surmonter les problèmes engendrés par l’utilisation des caméras perspectives. L'étude des systèmes autonomes trouvés dans la nature, ont suggéré qu’en adaptant la conception des

5 Source de la figure [4]

Figure 1-3 : Gigantocypris en comparaison avec le HMD (Head Mounted Display). (a) l’Ostracod Gigantocypris avec de larges yeux réfléchissants agissant comme un capteur catadioptrique. (b) Head Mounted Display pour

capteurs de vision pour les tâches souhaitées peut épargner l'effort de traiter les images obtenues au moyen d'appareils classiques.

1.3 Acquisition des images omnidirectionnelles

Nous appelons capteur omnidirectionnel ou caméra omnidirectionnelle un capteur de vision qui a un champ de vision (FOV) azimutale complet (360 degrés). Les capteurs panoramiques ont aussi un champ de vision azimutale de 360° mais ne couvrent pas toute la sphère. Une classification commune de capteurs omnidirectionnels existant est liée à la technologie appliquée dans leur fabrication. Pour obtenir des images omnidirectionnelles, on distingue 3 classes de systèmes possibles :

– L’utilisation d’images multiples – L’utilisation de lentilles spéciales – L’utilisation de miroirs convexes. 1.3.1 Images multiples

Des vues panoramiques à haute résolution peuvent être obtenues en utilisant une mosaïque formée par plusieurs images fournies par une caméra rotative. Par exemple, Peer et Solina [6] ont effectué des mesures de distance de la scène avec une seule caméra attachée à un bras rotatif, comme le montre la 6figure 1-4. Une

image omnidirectionnelle complète est obtenue en mettant les clichés ensemble au moyen d'une procédure de temps ce qui rend cette méthode inappropriée dans les applications en temps réel. La construction de l'image omnidirectionnelle est accélérée au moyen de caméras avec un étroit champ de vue. La caméra tourne à vitesse angulaire constante tout en opérant un balayage de lignes verticales étroit à partir des différentes images qui sont jointent pour former une vue panoramique.

6 Source de la figure : [6]

Figure 1-4 : Capteur de mesure de la profondeur 3D à l'aide d'une caméra montée sur un bras de robot tournant

Les yeux composés des insectes ont été une source d'inspiration pour un nouveau type de systèmes omnidirectionnels. En 2000, Fermuller et al. [7] ont développé un système de vision omnidirectionnelle composé de plusieurs caméras orientées dans différentes directions. Chaque caméra peut être considérée comme un œil avec un champ de vision limité.

Neuman et al. [8] ont étudié la relation entre la conception de l'appareil et la qualité de l'information visuelle au cours du temps. L'information complète obtenue par un capteur de vision, formé par un appareil photo ou une structure de caméras, est décrite par la fonction plénoptique. En examinant la variation temporelle de cette fonction, Neuman et al. ont classifié les capteurs de vision en fonction de la stabilité et de la complexité des calculs nécessaires pour évaluer la structure et le mouvement. Ils ont obtenu une hiérarchie qui commence avec la caméra sténopé et au plus haut niveau est placée la caméra polydioptrique au champ de vue complet.

Des applications telles que la vidéo-conférence n’a besoin que d'un champ de vue vertical limité. R. Cutler et al. [9] ont conçu un modèle de caméra panoramique qui couvre un champ de vue panoramique complet en agençant les caméras dans le même plan horizontal comme le montre la 7figure 1-5. Ce type d'arrangement offre

seulement la partie nécessaire du champ de vue omnidirectionnel requis ce qui réduit le nombre de caméras et, par conséquent, les coûts de fabrication.

Les caméras avec champs de vue complémentaires surmontent certains problèmes des caméras mobiles, mais le capteur devient plus difficile à calibrer car elle implique plusieurs caméras et d'images correspondantes acquises.

7 Source de la figure [9]

Figure 1-5 : Un anneau de caméras avec des

En résumé, l'avantage de l'utilisation de caméras rotatives ou d’une configuration de plusieurs caméras couvrant la scène offre une très bonne qualité d'image à haute résolution. Cependant, cette fonction très utile est altérée par un ensemble d'inconvénients. Dans le cas de la rotation d'une caméra, la partie de la scène derrière le plan d'image est toujours caché, ainsi ce type d'appareils ne peut pas être utilisé dans des applications en temps réel. La vue omnidirectionnelle obtenue à partir de plusieurs images partielles est difficile à réaliser, coûteuse et peut contenir des discontinuités.

1.3.2 Les lentilles spéciales

L’utilisation de lentilles spéciales est l’une des approches qui permettent d’élargir le champ de vision. Elle consiste à remplacer l’optique de la caméra par une lentille de distance focale très courte appelée "Fish-eye" (œil de poisson) illustrée 8figure

1-6 (a). La lentille offre un angle d’ouverture de 180° en déviant les rayons lumineux. Les auteurs dans [10], ont utilisé les lentilles Fish-eye pour acquérir des images 360°×360° à l’aide d’une technique de mosaïque.

Les images obtenues bénéficient d'une bonne résolution au centre, mais ont une mauvaise résolution sur la région marginale, comme le montre 9la figure 1-6 (b)

8 Source de la figure: [129] 9 Source de la figure: [129]

Figure 1-6 : Lentille Fish-eye. (a) Image acquise avec une lentille Fish-eye. (b) Lentille Nikkor montée sur un appareil Nikon F3.

Dans la vision humaine, une zone centrale de la rétine, appelée la fovéa, fournit une vision de haute qualité tandis que la région périphérique traite des images moins détaillées. Par conséquent, la vision acquise par une lentille Fish-eye est en quelque sorte similaire à la vision humaine du point de vue de la répartition de la résolution. En outre, les lentilles fish-eye introduisent une distorsion radiale qui est difficile à corriger. Un autre inconvénient important de ces lentilles est le manque d’un point de vue unique (SVP : Single View Point) qui cède place à une zone de points de vue, appelés "diacoustiques" [11].

Malgré les inconvénients mentionnés ci-dessus, le large champ de vision offert par les lentilles fish-eye fait de ce type d'éléments dioptriques un choix attrayant pour plusieurs chercheurs. En 1993, Basu et al. [12] ont publié une étude fournissant deux solutions mathématiques pour compenser la distorsion générée.

En 1997, Xiong et Turkowski [13] ont conçu un algorithme de calibrage automatique pour caméras équipées de lentilles fish-eye. Une caractéristique remarquable de l'algorithme de Xiong est que la caméra se calibre tout en enregistrant des images ce qui fait que la qualité de l'information extraite de l'image s’améliore de manière itérative.

Un système de vision active équipé d’une lentille fish-eye binoculaire a été développé plus tard par Kurita et al. [14]. Ils ont réalisé un système de contrôle du regard en temps réel qui a la capacité de détecter et suivre des objets en mouvement dans le champ de vue. En raison de la résolution non linéaire de la perception du monde, les lentilles fish-eye sont appropriées pour ce type d'applications, car les mouvements de la scène peuvent être détectés avec des coûts de calcul inférieurs à ceux en utilisant des caméras traditionnelles, soit avec une résolution uniforme. En outre, les caméras à lentilles fish-eye bénéficient de la résolution élevée au centre de sorte que si l'appareil est réglé à capter l'objet en déplacement dans la région centrale, il peut être perçu clairement.

Une autre étude de la correction de la distorsion de l'objectif fish-eye a été délivrée par Brauer-Burchardt et Voss [15]. Ils compensent la distorsion de l'image en utilisant une seule image prise avec un appareil non calibré. La méthode calcule le coefficient de distorsion radiale en inspectant les arcs de cercles dans le plan d'image correspondant à des lignes droites de la scène.

En 2003, Bakstein et Pajdla [16] ont présenté un mosaïquage omnidirectionnel complet avec une caméra fish-eye. Avec un champ de vue plus de 180 °, l'ensemble de la mosaïque est obtenu par la rotation de la caméra. Cet article présente le modèle d'un appareil photo avec rétine sphérique et définit sa fonction de projection. En outre, l'algorithme de calibrage et d'un ensemble de résultats expérimentaux sont également fournis.

Tenant compte des points évoqués ci-dessus, nous voyons que les caméras à lentilles grand angle peuvent fournir des images appropriées pour un certain nombre d'applications. Cependant, la modélisation de ces caméras est un processus

compliqué à cause de la distorsion radiale, la résolution non uniforme et faible et l'absence d'un point de vue unique qui rend impossible le déballage des images.

1.3.3 Les capteurs catadioptriques

Le mot « catadioptrique » se réfère simplement à l'utilisation d'éléments en verre et de miroirs dans un système d'imagerie. En photographie, une lentille catadioptrique est également connue comme une lentille de miroir.

L'idée originale des capteurs de vision omnidirectionnelle combinant un miroir et un système d'imagerie conventionnelle a été proposée par Rees dans le brevet US No. 3, 505,465 en 1970 [17]. L'idée est d'utiliser un miroir hyperbolique pour acquérir une image omnidirectionnelle qui a un seul centre de projection. Autrement dit, l’image peut être transformée en images en perspective normales. En 1990, les progrès des technologies informatiques ont permis le traitement en temps réel des données visuelles et des chercheurs ont mis en place plusieurs types de système de vision omnidirectionnels pour des applications en vision par ordinateurs et la robotique. Vagi et Kawato [18] ont réalisé un capteur de vision omnidirectionnelle en utilisant un miroir conique. Hong et d'autres [19] ont conçu un capteur de vision omnidirectionnelle en utilisant un miroir sphérique. Leur but était de faire naviguer des robots mobiles avec les systèmes de vision omnidirectionnelle. La vision omnidirectionnelle d'un robot est pratique pour détecter des obstacles mobiles autour du robot et pour sa propre localisation. Ensuite, Yamazawa et d'autres [20] ont réalisé à nouveau un capteur de vision omnidirectionnelle utilisant un miroir hyperbolique. Les images omnidirectionnelles peuvent être transformées en images en perspectives. Ils ont même proposé un système de surveillance avec capteur omnidirectionnel. Les systèmes de vision omnidirectionnelle conçus l'aide d'un miroir hyperboloïde peuvent générer une image prise à partir d'un unique centre de projection en combinaison avec une caméra de type perspective. Malheureusement, l'un des deux points focaux de l'hyperboloïde doit coïncider avec le centre de la caméra. Cette caractéristique le rend difficile à concevoir.

Nayar et Baker [21] ont réalisé une analyse théorique des systèmes de vision omnidirectionnelle et ont développé un capteur omnidirectionnel idéal à l'aide d'un miroir parabolique et une lentille télécentrique.

Ainsi et à partir du milieu des années 90, l'attention accordée à la vision omnidirectionnelle et sa base de connaissances a connu une croissance continue que le nombre de chercheurs impliqués dans l'étude des caméras omnidirectionnelles a augmenté. De nouveaux modèles mathématiques pour la projection catadioptrique et, par conséquent, de meilleurs capteurs catadioptriques performants ont fait leur apparition.

En résumé, le grand intérêt suscité par les capteurs catadioptriques est dû à leurs avantages spécifiques par rapport à d'autres systèmes omnidirectionnels, notamment le prix et la compacité.

1.4 Contexte, problématique et contribution

Les travaux de thèse présentés dans ce mémoire s'inscrivent dans le cadre d'un contexte de travaux menés dans le domaine de la vision artificielle et du traitement des images numériques. Cette recherche qui s’intéresse particulièrement aux capteurs de vision catadioptriques est motivée par le large champ de vision offert par les caméras omnidirectionnelles, de l'utilité de ces techniques et de leur application aux systèmes autonomes s’offrant ainsi comme une solution possible aux problèmes spécifiques introduits par l'utilisation des caméras traditionnelles. Il se trouve que la conception de ces caméras ouvre beaucoup de nouveaux domaines de recherche intéressants qui se caractérisent par une mixture complexe d’optique et de géométrie. Cette étude a été menée au Laboratoire d’Electronique et de Traitement du Signal/Géomatique, structure de recherche affiliée à la Faculté des Sciences de Rabat, Université Mohammed V.

Les travaux de cette thèse traite d'abord en profondeur le problème de la conception de nouvelles générations de caméras pour la production de vues de scène panoramiques, à savoir, des images avec de larges champs de vue. Néanmoins ce besoin d’élargir le champ de vue s’accompagne d’un autre besoin d’interpréter les images avec plus de fiabilité. Ce qui fait du traitement d’image un champ de recherche à fort apport et une discipline indissociable de de la vision artificielle en réunissant l’assortiment d’outils et de techniques qui permettent d’extraire et agir sur les caractéristiques d’une image et sa reproduction. Dans ce contexte, la définition des opérateurs de détection de mouvement, d’extraction de contours, de lissage ou autres traitements, repose sur l’hypothèse de l’invariance par translation. Autrement dit, l’effet du traitement dans l’image reste le même quelle que soit la position où il est appliqué. C’est le cas pour une image perspective d’une scène parallèle au plan focal sans différences de profondeur. Pour le cas d’une image omnidirectionnelle, la condition d’invariance par translation n’est pas satisfaite du moment qu’il est irréalisable d’apercevoir une position de la caméra le permettant puisque l’image présente une résolution non-homogène. En conséquence, tout traitement classique, aura des effets différents depuis le centre vers la périphérie de l’image. L’utilisation des opérateurs de traitement d’images classiques, développés pour des images perspectives, aboutissent à des résultats non satisfaisants pour les images omnidirectionnelles. C’est dans cette perspective que s’inscrit une première étude menée dans la présente thèse qui présente un outil que nous avons développé pour le traitement des images omnidirectionnelles qui s’avère adapté à leurs contraintes géométriques.

Une fois de nouveaux capteurs panoramiques sont conçus, il est possible de revenir sur l'un des plus vieux problèmes de la vision de la machine, à savoir, le problème stéréo. La combinaison de plusieurs de ces nouveaux capteurs introduit la possibilité passionnante de produire des représentations 3D de l'environnement beaucoup plus rapide et beaucoup plus facile que ce qui est possible avec des caméras standards. Tel est l'objet de la seconde étude menée dans le cadre des travaux de cette thèse.

Ainsi, ce mémoire est constitué de quatre chapitres relatant les principales contributions apportées dans le domaine de la vision omnidirectionnelle :

- Au premier chapitre, on présente un aperçu sur la vision omnidirectionnelle. Plusieurs qualités importantes des caméras à large champ de vue sont discutées et une classification générale est introduite avec des exemples de capteurs omnidirectionnels plus courants.

- Dans le deuxième chapitre nous exposons les différentes approches et techniques développées dans le traitement des images omnidirectionnelles. Deux outils mathématiques sont introduits : le modèle de projection unifiée, ainsi que la projection stéréographique qui ont été utilisés pour développer un algorithme d’extractions de primitives, adapté à la géométrie de formation des images sphériques. Il s’agit d’un opérateur de détection de contours, basé sur un modèle sphérique de charges électriques virtuelles. - Dans le chapitre 3, on présente une étude des sections coniques poursuivie

par une prospection des systèmes catadioptriques existants. Ensuite, on y aborde le problème de la détection en temps réel de cible mobile, et son suivi. Nous proposons une technique basée sur la détection des couleurs moins sensible à la variation de l'éclairement de l'environnement, en utilisant une caméra omnidirectionnelle. Les résultats expérimentaux confirment que la méthode proposée basée sur l’invariance chromatique permet effectivement de distinguer et de suivre des cibles mobiles en environnement intérieur et extérieur.

En guise d’application visant l’exploitation des techniques de traitement d’image en association avec les systèmes embarqués, nous présentons, enfin du présent chapitre, le concept d’un nouveau suiveur solaire à caméra catadioptrique.

- Dans le quatrième chapitre, les systèmes d’acquisition 3D omnidirectionnels sont étudiés, classés selon la technologie appliquée dans leur fabrication et leurs caractéristiques. Ensuite les systèmes de stéréovision omnidirectionnelle catadioptriques, sont examinés en fonction de la configuration, la résolution, l’isotropie et leur capacité à fournir des mesures 3D sont présentés.

Une partie de ce chapitre est consacrée à la présentation de deux nouveaux concepts de capteurs omnidirectionnels stéréo (omnistéréo) réalisés, l’un à caméra unique et le second à deux caméras. Leurs architectures, techniques d’étalonnages, formules de triangulation, ainsi que les résultats d’estimation de la profondeur obtenus sont également exposés.

- Dans la dernière partie de cette thèse, nous résumons les différents points clés abordés, et nous proposons des perspectives aux problèmes soulevés.

2. Traitement des images omnidirectionnelles

2.1 Introduction

Le traitement d'image et la vision artificielle sont des disciplines relativement jeunes (~années 60) et qui évoluent rapidement. Elles sont en plein expansion et donnent lieu chaque année à une profusion de travaux, académiques, technologiques, et industriels. L'engouement pour ces disciplines s'explique par la multiplication permanente d'applications et d'enjeux industriels dans des domaines assez variés. Aujourd'hui, grâce aux technologies toujours en progression, les images ont envahi notre vie, que ce soit dans les loisirs (Photos numériques, jeux vidéo...) ou dans un cadre plus utilitaire. Citons par exemple l'utilisation croissante de la vision dans des domaines variés comme la médecine (IRM), la télésurveillance (sécurité, analyse routière...), la robotique, la défense (missiles, détection, véhicules autonomes...), l'astronomie...

Ainsi, Le traitement d'images, désigne l'ensemble des opérations sur les images numériques, qui transforment une image en une autre image, ou en une autre primitive formelle, tant qu'à la vision par ordinateur désigne la compréhension d'une scène ou d'un phénomène à partir des informations (images), liant intimement perception, comportement et contrôle. Les domaines liés à ces deux disciplines vont du traitement du signal à l'intelligence artificielle, on ne saurait donc prétendre à l'exhaustivité, mais on vise plutôt l'exploration d'un certain nombre de techniques importantes et actuelles.

Le besoin d’interpréter les images avec plus de fiabilité fait du traitement d’image un champ de recherche à fort apport et une discipline indissociable de de la vision artificielle en réunissant l’assortiment d’outils et de techniques qui permettent d’extraire et agir sur les caractéristiques d’une image et sa reproduction. Ce processus à deux objectifs : l'un est d'obtenir l'image la plus appropriée pour l'observation et la compréhension de l'homme, l'autre est de reconnaître automatiquement l'image par ordinateur. L'étape clé de ce processus réside dans décomposition d’une image large et complexe en image partielle avec fonctions indépendantes. Le contour en est la caractéristique fondamentale et peut être définie comme un ensemble de pixels connectés qui constituent une frontière entre deux régions distinctes. La détection de contours est essentiellement un procédé de segmentation d'une image en régions de discontinuité et permet à l'utilisateur d'observer les caractéristiques de l’image où il y’a un changement plus ou moins brusque de niveau de gris ou de texture indiquant la fin d'une région dans l'image et le début d'une autre. Le contour détecté peut devenir large ou discret avec l'existence de bruit et d'ambiguïté. Il est donc, nécessaire pour obtenir le contour complet de détecter la discontinuité de l'image partielle puis éliminer les points de rupture du contour.

La détection de contours trouve des applications pratiques en l'imagerie médicale, le diagnostic et la chirurgie guidée par ordinateur, la localisation d’objet dans des images satellite, la reconnaissance du visage, et la reconnaissance de l'empreinte digitale, les systèmes de contrôle automatiques du trafic…

Beaucoup de techniques ont été développées pour extraire les contours des images numériques. Les opérateurs classiques basés sur le gradient comme celui de Robert, Prewitt, Sobel ont été initialement utilisés pour la détection de contour mais étaient très sensibles au bruit. Les opérateurs Laplacian et Marr Hildrith souffrent également de deux limitations : forte probabilité de détection des faux contours et l'erreur de localisation peut être significative aux contours incurvés. L’algorithme proposé par John F. Canny en 1986 est considérée comme l'algorithme idéal de détection de contour pour les images avec présence de bruit. [22] [23] [24] [25]. Bien entendu, ces outils sont développés initialement pour les images acquises par des caméras perspectives.

Dans le contexte de l’omnidirectionnel, La reproduction à 360° de la scène est essentiellement intéressante pour la navigation de robots mobiles [26] [27]. Grace aux caméras panoramiques, quelques ambiguïtés sont levées en séquences vidéo pour l’estimation de mouvement. Néanmoins, La définition des opérateurs de détection de mouvement, d’extraction de contours, de lissage ou autres traitements, repose sur l’hypothèse de l’invariance par translation. Autrement dit, l’effet du traitement dans l’image reste le même quelle que soit la position où il est appliqué. C’est le cas pour une image perspective d’une scène parallèle au plan focal sans différences de profondeur. Pour le cas d’une image omnidirectionnelle, la condition d’invariance par translation n’est pas satisfaite du moment qu’il est irréalisable d’apercevoir une position de la caméra le permettant puisque l’image présente une résolution non-homogène. En conséquence, tout traitement classique, aura des effets différents depuis le centre vers la périphérie de l’image. En effet, dans le cas des systèmes de vision catadioptriques, la géométrie du miroir de révolution génère des distorsions considérables dans l’image par concentration de l’information au centre de l’image. Ainsi, les caméras omnidirectionnelles ont permis, certes, d’augmenter le champ de vision des caméras classiques, mais les conditions d’utilisation des traitements classiques ne sont pas remplies pour les images acquises par ces systèmes. L’utilisation des opérateurs de traitement d’images classiques, développés pour des images perspectives, aboutissent à des résultats non satisfaisants pour les images omnidirectionnelles. C’est dans cette perspective que s’inscrit l’étude menée dans le présent chapitre qui présente un outil que nous avons développé pour le traitement des images omnidirectionnelles qui s’avère adapté à leurs contraintes géométriques. Une série d’expérimentations sera présentée en vue de mettre en avant la robustesse de notre outil dans le cas d’images synthétiques et réelles. Nous exploitons ensuite les paramètres de Fram et Deutsch afin de prouver que nous obtenons de bons résultats quelle que soit l’image utilisée et en présence de différents degrés de bruit. Nous illustrons

également les performances du détecteur proposé en présentant les résultats obtenus sur des images par comparaison avec les approches classiques.

2.1 Outils classiques de détection de contours

2.1.1 Méthodologies de détection de contoursLa détection de contours utilise des opérateurs différentiels pour détecter les changements dans les gradients des niveaux de gris. Elle est divisée en deux catégories principales :

2.1.2 Détecteurs de contours du premier ordre / Basé sur le gradient

La détection des contours du premier ordre se base sur le calcul du gradient de l'image en x et y, et en observant les emplacements dans l'image où il change brusquement. Si l'image est représentée par la fonction 𝑓(𝑥, 𝑦), alors l'idée de base est de calculer ce gradient :

𝛻𝑓(𝑥, 𝑦) = 𝑥̂

𝜕𝜕𝑥

𝑓(𝑥, 𝑦) + 𝑦̂

𝜕𝜕𝑦

𝑓(𝑥, 𝑦)

2.1

Et puis afficher l'amplitude du gradient défini par :

|𝛻𝑓| = √(

𝜕𝑓 𝜕𝑥)

2+ (

𝜕𝑓 𝜕𝑦)

2 .2.2

Détecteur de contour Détecteur de premier ordre/Opérateur basé sur le GradientDétecteur de Canny contours classiquesDétecteur de

Détceteur de Sobel Détecteur de Prewitt Détecteur de Robert Détecteur de second ordre/Opérateur basé sur le Laplacien Détecteur de Marr Hildrith

Un seuillage peut être ensuite appliqué sur l’image résultante. Seules les valeurs de l’amplitude du gradient dépassants un certain seuil, sont retenues. Une image binaire représentant les contours, est alors obtenue.

Les différentes méthodes basées sur le gradient pour la détection de contours, sont résultantes d’approximations discrètes de ∇𝑓. Les approximations disponibles sont agglomérées dans une classe d'opérateurs appelés gradients numériques. Une fonction continue 𝑓(𝑥) peut être étendue à point 𝑥 = Δx comme une série de Taylor :

𝑓(𝑥 + 𝛥𝑥) = 𝑓(𝑥) + 𝛥𝑥

𝜕 𝜕𝑥𝑓(𝑥) +

(𝛥𝑥)2 2! 𝜕2 𝜕𝑥2𝑓(𝑥) + ⋯

2.3

Si nous négligeons tous les termes à partir du deuxième, alors on obtient une approximation de la dérivée de 𝑓(𝑥) à Δx, donnée par l'équation de différence :

𝜕

𝜕𝑥

𝑓(𝑥) =

𝑓(𝑥+𝛥𝑥)−𝑓(𝛥𝑥)

𝛥𝑥

2.4

Aux dérivées partielles que nous avons :

𝜕 𝜕𝑥

𝑓(𝑥, 𝑦) =

𝑓(𝑥+𝛥𝑥,𝑦)−𝑓(𝛥𝑥,𝑦) 𝛥𝑥2.5

Et 𝜕 𝜕𝑦𝑓(𝑥, 𝑦) =

𝑓(𝑥,𝑦+𝛥𝑦)−𝑓(𝑥,𝑦) 𝛥𝑦2.6

Ainsi avec une image numérique 𝑓𝑖𝑗, nous pouvons remplacer les dérivées partielles

par les différences :

𝐷

𝑥𝑓

𝑖𝑗= 𝑓

(𝑖+1)𝑗− 𝑓

𝑖𝑗2.7

Et

𝐷

𝑦𝑓

𝑖𝑗= 𝑓

𝑖(𝑗+1)− 𝑓

𝑖𝑗2.8

Ces opérations sont équivalentes à une convolution de 𝑓𝑖𝑗 avec le noyau (−1,1) dans

la direction de 𝑥, et avec le même noyau (−1

1 ) dans la direction 𝑦. Les noyaux ou les filtres qui sont utilisés pour la convolution d'une image numérique de cette manière, sont appelés masques. Ils sont des opérateurs invariants par translation, qui nous permettent d'écrire les anciennes équations de différences sous la forme :

𝐷

𝑥𝑓

𝑖𝑗= 𝐷

𝑥⊗ 𝑓

𝑖𝑗2.9

Et𝐷

𝑦𝑓

𝑖𝑗= 𝐷

𝑦⊗ 𝑓

𝑖𝑗2.10

Avec𝐷

𝑥= (−1,1)

et𝐷

𝑦= (

−1

1

)

2.11

2.1.2.1 Opérateur de RobertLe filtre de Robert [28] est basé sur l’approximation du gradient de premier ordre, où l’amplitude du gradient est donnée par :

𝐺

𝑖𝑗= √( 𝑓

𝑖𝑗− 𝑓

(𝑖+1)(𝑗+1))

2+ ( 𝑓

(𝑖+1)𝑗− 𝑓

𝑖(𝑗+1))

22.12

Ce qui revient à appliquer les masques :

𝐷

𝑥= (

1

0

0 −1

)

2.13

Et :𝐷

𝑦= (

0 −1

1

0

)

2.14

Ces masques opèrent sur des zones de pixels relativement petites, et sont par conséquent plus sensible au bruit. Les applications pratiques de gradients numériques tels que l'opérateur Roberts, nécessitent habituellement du prétraitement pour réduire le bruit inhérent à une image.

2.1.2.2 Operateur de Sobel

L’opérateur de Sobel [29] est un opérateur utilisé pour calculer une approximation de la fonction de gradient d'intensité de l'image pour la détection de contours. A chaque pixel d'une image, l'opérateur de Sobel donne soit le vecteur de gradient correspondant ou la normale au vecteur. L'image d'entrée est convoluée, l'amplitude et la direction du gradient sont calculées. Il utilise les deux masques 3x3 suivant :

𝐷

𝑥= (

−1 0

1

−2 0

2

−1 0

1

)

,

𝐷

𝑦= (

−1

−2

−1

0

0

0

1

2

1

)

2.15

Par rapport à l'opérateur Robert, le temps de calcul est relativement lent. Comme il a un filtre plus large, il est moins sensible au bruit mais peut conduire également à la détection de faux contours.

2.1.2.3 Operateur de Prewitt

L’opérateur de Prewitt ressemble à celui de Sobel mais utilise les masques suivant :

𝐷

𝑥= (

−1 0

1

−1 0

1

−1 0

1

)

,

𝐷

𝑦= (

−1

−1

−1

0

0

0

1

1

1

)

2.16

2.1.2.4 Détecteur de contour de Canny

L’algorithme de détection de Canny passe par les étapes suivantes :

En le comparant aux opérateurs de détection de contours décrits précédemment, il s’avère que le détecteur de Canny permet une détection de contours optimale. Nous citons ci-après quelques points mettant en avant les avantages de filtre de Canny : Moins sensible au bruit : Par rapport aux opérateurs classiques comme Prewitt, Robert et Sobel, le Filtre de Canny est moins sensible au bruit. Il utilise le filtre gaussien qui élimine le bruit considérablement par rapport aux filtres ci-dessus.

Elimine les problèmes de stries : Les opérateurs classiques comme Robert utilisent la technique de seuil unique, mais cela résulte en stries. Ce problème de stries s’explique : si le gradient du contour est juste au-dessus ou juste en dessous de la limite du seuil fixé, la partie utile du contour relié est supprimée résultant en un contour final déconnecté. Pour surmonter cet inconvénient, l’algorithme de Canny emploie la technique de l'hystérésis qui utilise deux valeurs de seuils

Adaptif : les opérateurs classiques ont des noyaux fixes et ne peuvent donc pas être adaptés à une image donnée. Cependant, les performances de l'algorithme de Canny dépendent de variables ou paramètres ajustables tels

Réduction du bruit •Lissage de l’image avec un filtre gaussien pour réduire la quantité de bruit notamment de type speckle. Il est important d'éliminer les composantes à très haute fréquence qui dépassent celles qui sont associées au filtre de gradient utilisé, autrement, ceux-ci peuvent provoquer de fausses détections de contours. Calcul du Gradient •Cela conduit à la création de deux images, l'une contenant les amplitudes de gradient G, et un autre contenant de l’orientation θ(G). Les implémentations les plus courantes, utilisent la simple dérivée discrète du premier ordre

Seuillage des amplitudes de gradient

•A partir d’une valeur minimale, de sorte que seuls les contours signifiants sont détectés. Un seuillage avec une valeur maximale est également spécifié. Sur toute une ligne continue, au moins l'un des points du contour doit dépasser cette valeur maximale. Cela supprime les petits ou les insignifiants segments de ligne.

que l’écart type des valeurs de filtre gaussien et les valeurs de seuils minimales et maximales. En contrôlant l'écart type de la Gaussienne du filtre de lissage, ainsi que les deux valeurs des seuils haut est bas, la plupart des bords généraux peuvent être détectés. Mais en présence de bruit, l’ajustement adéquat de ces paramètres, n’est pas évident.

Bonne localisation : le détecteur de Canny restitue l’orientation du gradient permettant ainsi une bonne localisation.

2.1.3 Détecteurs de contours du second ordre

Les détecteurs de contours du second ordre sont basés sur le calcul de la dérivée seconde, en particulier le Laplacien. Dans cet opérateur un pixel est marqué comme étant un contour à la position où la dérivée seconde de l'image devient nulle. Le Laplacien

𝛻

2 d’une image 2D,I(i, j)

est exprimé par la formule :𝛻

2𝐼(𝑖, 𝑗) =

𝜕2𝜕𝑖2

𝐼(𝑖, 𝑗) +

𝜕2

𝜕𝑗2

𝐼(𝑖, 𝑗)

2.17

Le principal avantage de la dérivée seconde est qu'elle est indépendante par rapport à l’orientation. Mais plus sensible au bruit.

Il est bien connu que les détecteurs basés sur le gradient sont sensibles au bruit car le processus de dérivation du signal image l’intensifie. L’alternative à ces outils fait l’objet de nombreux travaux de recherche. Dans cette optique notre équipe a développé dans [30] un détecteur de contour non basé sur le gradient se base sur une modélisation de l’image perspective comme un distribution de charges électrostatiques virtuelles. Cette modélisation a donné naissance au masque suivant :

𝐺

𝑥= (

√2/4

0 −√2/4

1

0

−1

√2/4

0 −√2/4

) 2.18

Et𝐺

𝑦= (

√2/4

1

√2/4

0

0

0

−√2/4 −1 −√2/4

)

2.19

Ce détecteur présente l’avantage d’être moins sensible au bruit et donc son extension aux images omnidirectionnelles s’avère potentiellement intéressante dans la mesure où un tel outil serait à la fois mieux adapté à la géométrie des images catadioptriques et présente de meilleurs performances face aux dégradations de l’image. C’est ce que se propose l’étude développée dans la section 2.2.

2.2 Le traitement des images omnidirectionnelles

Comme nous l’avons mentionné dans l’introduction de ce chapitre, appliquer de façon abrupte les techniques classiques de traitement sur les images omnidirectionnelles induit à des résultats entachés d’erreurs. En effet les images obtenues par les systèmes de vision omnidirectionnelles ont une géométrie sphérique. En plus de la distorsion introduite, la résolution angulaire de ces images varie depuis le centre vers l’extérieur. Un autre problème majeur à surmonter est celui du voisinage pixellique qui peut être illustré, dans le cas simple de la convolution d’une image omnidirectionnelle avec un masque quelconque. En effet, et à titre d’exemple, quand une image est convoluée avec un filtre 3x3 selon les deux axes du repère cartésien, le voisinage spatial du pixel central du filtre utilisé se trouve mal positionné. Surmonter cette contrainte revient à balayer l’image selon les vecteurs unitaires d’un repère polaire situé au centre de l’image omnidirectionnelle ou selon un repère sphérique.

Des procédés ont été proposés dans le but de surmonter ce désavantage. Dans [31], les auteurs proposent de calculer le voisinage en projetant un voisinage conçu sur un cylindre, puis utilisent des opérateurs morphologiques flous à noyaux variables pour images omnidirectionnelles. Une approche similaire a été utilisée dans [32] pour le calcul du gradient. Les auteurs de [33], ont proposé la correction du gradient classique en adéquation du miroir utilisé dans le capteur catadioptrique. Dans [34] proposent l’adaptation de l’algorithme de détection des coins de Harris aux images catadioptriques.

2.2.1 Équivalence avec la projection sphérique puis stéréographique

2.2.1.1 Projection géométrique unifiée pour système catadioptrique Une approche pertinente pour le développement d’outils de traitement adaptés aux images omnidirectionnelles proches de ceux utilisés pour les images perspectives, revient à trouver un espace de substitution à celui des images omnidirectionnelles. Dans [35] et [36] Geyer et Daniilidis, ont démontré que pour des systèmes catadioptriques respectant la propriété du point de vue unique, cet espace virtuel est une sphère unité, appelé sphère équivalente. La modélisation se décompose donc en deux étapes, La première étape est une projection centrale sur la sphère et la seconde étape, une projection centrale (stéréographique) d'un point B (sur l'axe de la sphère) sur la rétine (figure 2-2). La position B dépend du type de miroir utilisé dans le capteur catadioptrique. Un miroir parabolique est représenté par un point B se trouvant sur le pôle nord de la sphère. Pour un miroir elliptique ou hyperbolique, B se situe entre le pôle nord et le centre de la sphère. Un énorme avantage de cette modélisation est qu'il n’implique que deux paramètres (𝜑, 𝜉) Pour représenter un point visible 3-D M (X, Y, Z) avec sa projection m (x, y) sur l'image panoramique. Cette projection est décrite par les équations 2-20 et 2-21,où