Université de Montréal

En quoi le Big Data est-il la pierre angulaire de la détection du blanchiment

d’argent et du financement du terrorisme dans les institutions financières

canadiennes ?

Par

Hamza Abouabdelmajid

École de criminologie

Faculté des arts et des sciences

Travail dirigé présenté à la Faculté des études supérieures et postdoctorales en vue

de l’obtention du grade de maitrise (M. Sc.) en criminologie

Décembre 2016

Résumé:

L’univers de la lutte contre le blanchiment d’argent et le financement des activités terroristes LAB/FAT est désormais un sujet d’actualité. Il est aujourd’hui l’un des champs règlementaires les plus couteux auxquels les institutions financières doivent se conformer. L’évolution des mentalités face à la définition du blanchiment d’argent et du financement des activités terroristes, l’accroissement des exigences réglementaires en matière de conformité, l’aversion aux risques réputationnels et de sanctions amènent les institutions financières à investir des sommes conséquentes en dispositifs technologiques de «surveillance financière», et en ressources humaines pour les implanter, les paramétrer et les opérationnaliser. Les groupes de conformité mobilisent désormais des bases de données, traitent, filtrent et analysent à l’aide de solutions technologiques des volumes importants de données afin de surveiller et détecter les transactions et les clients suspects. Dans le cadre du processus d’implantation du dispositif de surveillance financière dans le Mouvement Desjardins, nous présentons une mise en perspective des grands enjeux technologiques, organisationnels et économiques pour l’institution financière.

Table des matières

Résumé...2

Abréviations………..………..5

Remerciements………...…………6

Introduction………7

Chapitre I : Recension des écrits………...……9

1 .1 Big Data………...………..9

1.1.1 Le Big Data et l’innovation technologique : «une exploitation tous azimut»...9

1.1.2 Projets Big Data : enjeux et perspectives………..…....13

1.1.3 Big Data et algorithme : «une architecture forcée d’une société»………...15

1.1.4 La surveillance à l’ère du Big Data : «un fantasme de sécurité»………...……20

1.2 Lutte anti-blanchiment et financement du terrorisme au Canada……….………26

1.2.1Contexte historique et enjeux ………...26

1.2.2 Lutte anti-blanchiment dans les institutions financières : « devoir ou volonté »………..32

Chapitre II : Méthodologie ……….……36

Chapitre III : Résultats et analyses……….39

3.1 Réalité de la LBA/FAT dans le Mouvement Desjardins………..……39

3.1.1 Importance de la conformité (AML) dans le contexte actuel………..…39

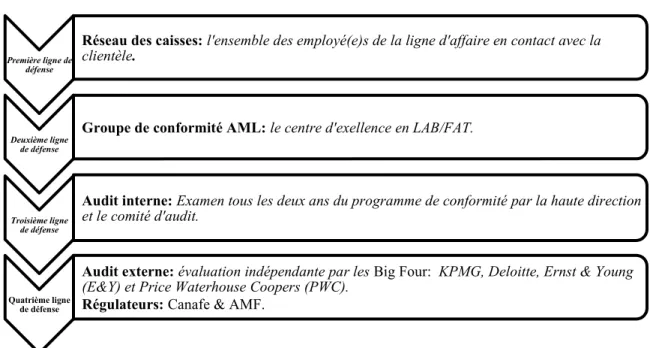

3.1.2Programme de conformité chez Desjardins……….….…44

3.1.3 Approche axée sur le risque : un modèle sur mesure………..………47

3.1.4 Compromis révélateur d’un écart entre deux pôles : finance et sécurité………48

3.1.4.1 Divergence et convergence : une lutte au milieu de la finance et de la sécurité..48

3.1.4.2 L’institutionnalisation de la coopération entre acteurs financiers et de sécurité...49

3.1.5 Signalement d’Opération Inhabituelle : le facteur humain comme enjeu de collecte…52 3.1.6 Déclaration d’opération douteuse : un processus qui gagne en maturité………53 3.1.7 Absence d’identifiant membre/client unique: enjeu pour la conformité et le Canafe…56

3.2 Processus d’acquisition de la solution «Actimize» : enjeux et limites………57

3.2.1 Espace de formulation du dispositif de surveillance………...58

3.2.1.1 Planification et évaluation des besoins………...60

3.2.1.2 Choix et mise à l’essai du dispositif………...62

3.2.2 Espace de mise en œuvre du dispositif technologique de surveillance………..66

3.2.3 Chef Data Officer «CDO» : profession« transversale» à l’ère du Big Data…………....68

3.2.4 Rentabilisation du «Know Your Customer» : vers une reconversion commerciale...…70

Conclusion……….74

Abréviations:

AMF: Autorité des marchés financiers

BSIF: Bureau du surintendant des institutions financières

BIG FOUR: Deloite Touche Thmatsu, Ernst & Young, KPMG, Price water house Coopers. CANAFE: Centre d’analyse des opérations et déclarations financières du Canada

CDD: Customer Due Diligence CDO: Chief Data Officer

CAMLO: Chief Anti-Money Laundering Officer DOD : Déclaration d’Opération Douteuse DSI: Directeur des systèmes d’information ERCM: Entreprise Risk Case Manager

ETL: Extract Transform Load

GAFI: Groupe d’action financière KYC: Know Your Custmor

LAB/FAT: Lutte anti-blanchiment et financement d’activités terroristes RBA: Risk Based Approach

SCRS: Service canadien de renseignement et de sécurité SME: Subject Matter Expert

SAM: Suspicious Activity Monitoring SOI: Signalement d’Opération Inhabituelle WLF: Watch List Filtering

Remerciements

:

Mes remerciements vont en premier lieu à mon directeur de recherche, Anthony Amicelle pour sa patience, sa compréhension et son dévouement. Ce travail lui est largement redevable tant aux précieux conseils qu'il m'a généreusement prodigués qu'à la liberté d'actions qu'il m'a permis tout au long de ma rédaction. Ils s'adressent ensuite à la direction de la conformité de Desjardins, qui a bien voulu m’ouvrir ses portes et me permettre d’en savoir plus sur les enjeux de conformité et sur ce que représente la lutte contre lutte anti-blanchiment dans le milieu financier. Je remercie également mon épouse et mon fils «de quelques jours» pour leurs présences réconfortantes. Enfin, un grand merci à mes parents et beaux-parents pour leurs soutiens inconditionnels.

INTRODUCTION

Le Big Data est souvent reconnu pour être la nouvelle source de création de valeur et d'innovation (Cukier et Mayer-Schönberger, 2013). Ce serait notamment un moyen pour faire progresser et améliorer la productivité dans une multitude de domaines et de secteurs d’activités, allant des activités économiques et commerciales à l'administration publique, et de la sécurité aux diverses recherches scientifiques (Tene et Polonetsky, 2012; Chen et Zhang, 2014; Lyon, 2014). Les professionnels de la sécurité, publique et privée, mobilisent le Big Data et adoptent de plus en plus un langage et des méthodes de calcul a priori bien connus du milieu commercial et du marketing à des fins de prédiction et de détection du crime. Les dispositifs technologiques et le

Big Data semblent offrir aujourd’hui des réponses à un large éventail de problèmes de

(in)sécurité par des perspectives prometteuses en matière de prévention et de prédiction du crime (Aradau et Blake, 2016).

Le Big Data est aussi une préoccupation des institutions financières. Le régime de lutte contre le blanchiment d’argent et le financement des activités terroristes LAB/FAT est aujourd’hui un champs règlementaires couteux auxquels les institutions financières doivent se conformer (Favarel-Garrigues et al., 2011; Tauzin, 2014). L’évolution des mentalités face à la définition du blanchiment d’argent et du financement des activités terroristes, l’accroissement des exigences réglementaires en matière de conformité, l’expansion du online money laudering, l’aversion aux risques réputationnels et de sanctions amènent les institutions financières à investir des sommes conséquentes en dispositif technologique de « surveillance financière » (Amicelle, 2013), et en ressources humaines pour les implanter, les paramétrer et les opérationnaliser. Les groupes de conformité mobilisent désormais des bases de données, traitent, filtrent et analysent à l’aide de logiciel de LAB/FAT des volumes importants de données afin de surveiller et détecter les transactions et les clients suspects pour enfin partager les informations pertinentes avec les services de renseignement compétents (Favarel-Garrigues, Godfroy et Lascoumes, 2011).

Par ailleurs, l’ère du Big Data a amené une « fraicheur technologique » ; traditionnellement, l’intelligence d’affaire reposait sur des entrepôts de données limitées en taille (quelques téraoctets), menant à une gestion difficile de données non structurées et des analyses en temps

réel (Karoui, Devauchelle, Dudezert, 2014), tandis que l’ère du Big Data propose des architectures et infrastructures évoluées permettant des traitements et des analyses sophistiqués, prenant en compte ces nouvelles données intégrées à l’écosystème de l’organisation (Chen et al., 2012). L’enjeu central à l’ère du Big Data consiste désormais à pouvoir traiter et analyser en temps réel des flux importants de données, structurés ou non, émanant de sources et de bases de données différentes pour en extraire de la valeur et en tirer un avantage à tous les niveaux de l’organisation. Les projets Big data exposent les établissements financiers et bancaires à des enjeux technologiques puisqu’une architecture adaptée à leur environnement existant est nécessaire, à des enjeux organisationnels par rapport à la nature des données à traiter, la désignation d’une équipe qualifiée, les budgets à allouer et l’accompagnement du changement à mettre en œuvre, ainsi qu’à des enjeux économiques en termes de création de valeurs (Karaoui, Davauchelle et Dudezert, 2015).

Dans le cadre du processus d’implantation du nouveau dispositif technologique de surveillance financière « Actimize » dans le Mouvement Desjardins, l’objectif de ce travail est de présenter dans un premier temps une mise en perspective des enjeux de conformités et de LAB/FAT dans l’institution financière. Dans cette partie, nous abordons le contexte légal et institutionnel, ainsi que la dynamique de coopération entre les acteurs clés de la LAB/FAT. Dans un deuxième temps, nous tentons de mettre en lumière certains défis technologiques et organisationnels auxquels le groupe de conformité de Desjardins est confronté dans son processus d’implantation. Nous proposons enfin certaines recommandations, notamment en matière de gestion et de gouvernance des données.

CHAPITRE I

: RECESION DES ÉCRITS

1.1 BIG DATA

1.1.1 Big Data et innovation technologique : « une exploitation tous azimut »

Bien que le Big Data soit un concept utilisé depuis les milieux des années 1990, ce n’est que 20 ans plus tard qu’il est devenu répandu dans la littérature (Diebold, 2012). Selon certains auteurs, son foisonnement actuel peut être attribué en grande partie aux initiatives promotionnelles faites par différentes sociétés de technologie de premier plan, à commencer par IBM qui ont participé à la construction du marché de l’analytique « Market analytics » (Gandomi et Haider, 2015). Le

Big Data désigne généralement des ensembles de données si vastes et complexes qu’ils

nécessitent l’utilisation de systèmes de gestion de base de donnée, de logiciels de statistique et de visualisation pour générer les analyses et les connaissances nécessaires à la prise de décision dans une variété de domaines (Dholakia, Nichilesh, 2015). Selon Manovitch (2011), le terme Big Data n’est pas utilisé à bon escient. Il a été originellement utilisé dans le milieu des sciences en référence à de très grands volumes de données nécessitant l’utilisation de superordinateurs, alors qu’aujourd’hui, de grandes masses de données peuvent être analysées sur des ordinateurs de bureau avec des logiciels standard.

« Le Big Data est un phénomène culturel, technologique et scientifique faisant appel à

l'interaction de trois enjeux centraux. Premièrement, la technologie qui optimise à la fois la puissance de calcul et la précision algorithmique pour collecter, analyser, établir des liens et comparer un ensemble de masse de données. Deuxièmement, l’analyse qui a pour but d’identifier les tendances « Patterns » aux fins de revendications économiques, sociales, techniques et juridiques. Troisièmement, le mythe qui repose sur cette croyance commune que de grandes masses de données offrent et génèrent une forme supérieure d'intelligence et de connaissances qui sont à la fois véridiques, objectives et précises, ce qui auparavant était impossible.» (Boyd et Crawford, 2012 : traduction libre).

Le volume est naturellement une caractéristique fondamentale du Big Data. Toutefois, d’autres caractéristiques d’importance égale y sont intiment liées (Gandomi et Haider, 2015). D. Laney (2001) évoque à ce propos que le volume, la variété et la vélocité représentent trois enjeux centraux dans la gestion des données. Ces enjeux peuvent être perçus comme un cadre commun pour définir le Big Data (Chen, Chiang et Storey, 2012). Le volume des données disponibles est en effet important, mais ce n'est pas la caractéristique la plus pertinente de ce nouvel écosystème des données. La force et la pertinence du Big Data ne résident pas seulement dans son volume, c’est aussi et surtout dans sa capacité à établir des liens avec d'autres données (ou bases de données) qu’il prend tout son sens (Boyd et Crawford, 2012). Autrement dit, la capacité à répondre aux questions fondamentales progresse à mesure que les faits colligés et analysés s’accroissent, en utilisant des méthodes de corrélation avancées d’information, amenant à identifier des « patterns » et des informations qui demeureraient autrement invisibles (Bollier, 2010).

Le Big Data est une nouvelle source de création de la valeur économique et de l'innovation (Cukier, Mayer et Schönberger, 2013). Ce serait un moyen pour faire progresser et améliorer la productivité dans une multitude de domaines et de secteurs, allant des activités économiques et commerciales à l'administration publique, et de la sécurité aux diverses recherches scientifiques (Tene et Polonetsky, 2012). De ce fait, un nombre de plus en plus important d’entreprises collectent et analysent des données concernant les interactions entre ces données sur leurs inventaires et leurs fournisseurs pour optimiser et réorienter leurs processus d’affaires (Brynjolfsson et McAfee, 2011). Des entreprises telles que Facebook, Amazon et Google mènent en temps réel et de façon continue des expériences auprès de leurs utilisateurs afin de créer des opportunités et identifier rapidement les produits et services appropriés pour les offrir au bon moment, au bon prix et par le bon canal de distribution (Bollier, 2010 ; Davenport et al., 2011 ; Ouellet et al., 2013). Au moyen d’outils de ciblage comportemental, des entreprises personnalisent les contenus (articles textuels, produits, publicité, etc.) en fonction des comportements des internautes, en identifiant leurs centres d’intérêt. Des systèmes de recommandations sont développés par plusieurs distributeurs et diffuseurs de produits culturels tels qu’Apple, Netflix et Amazon, et par des réseaux socionumériques tels que Facebook en analysant des traces laissées consciemment ou non par les utilisateurs (Grossman, 2010), ou

encore des technologies de prédictions tentant de deviner le succès d’un bien culturel particulier avant, pendant ou après sa création (Davenport et Harris, 2008 ; Ouellet et al., 2013).

Bien que ces objectifs d'influence et de canalisation de comportements d’utilisateurs (consommateurs) aient toujours été importants pour les stratèges d'affaire, de marketing et d’autres secteurs d’activités, ce qui est nouveau à l'ère du Big Data, ce sont les changements ontologiques et épistémiques (Tene et Polonetsky, 2012). L’accès aux données est un enjeu capital. Généralement, seules les entreprises et les réseaux socionumériques permettent un accès très large aux données sociales, notamment aux données transactionnelles. Généralement, un chercheur peut obtenir certaines de ces données par le biais des API fournies par la plupart des services de médias sociaux et les plus grands détaillants de médias en ligne (YouTube, Flickr,

Amazon, etc.). L’API (Interface de programmation applicative) est un ensemble de fonctions

permettant d’accéder aux services d’une application, par l’intermédiaire d’un langage de programmation, afin de récupérer les données stockées dans les bases de données d'une entreprise. Par exemple, l'API de Flickr peut être utilisée pour télécharger toutes les photos d'un groupe particulier et récupérer l’information sur leurs tailles, les commentaires disponibles à leur sujet, l'emplacement géographique, la liste des personnes aimant cette photo et ainsi de suite (Manovitch, 2011). Selon Boyd et Crawford (2012), un anthropologue travaillant pour Facebook ou un sociologue travaillant pour Google aura accès à des données que le reste de la communauté scientifique et universitaire ne pourrait avoir. Certaines entreprises restreignent totalement l'accès à leurs données, d'autres offrent l'accès aux données moyennant des frais importants, ou offrent de petits ensembles de données aux chercheurs universitaires, sans oublier les problèmes liés aux compétences informatiques. La difficulté et le coût lié à l’accès aux données produisent des irrégularités considérables dans le système. Autrement dit, ceux qui ont les moyens financiers ou sont à l'intérieur de l'entreprise peuvent produire des résultats de recherches différents de ceux qui ont un accès restreint ou limité, d’autant plus que ces derniers ne peuvent ni reproduire ni évaluer les conclusions de ceux qui ont un accès privilégié . Cet écosystème actuel autour du Big Data crée selon les auteures un nouveau type de fracture numérique « Data divide »: Le Big Data riche et le Big Data pauvre.

« vérité objective » ou toute interprétation est nécessairement biaisée par un filtre subjectif et par la manière dont les données sont « nettoyées »? Les décisions émanant du design qui détermine ce qui doit être mesuré proviennent de l'interprétation. Dans le cas des données des médias sociaux, il existe un processus de « nettoyage des données ». Les décisions seront prises au regard des attributs et variables qui seront appréciés, mais aussi ignorés. Boyd et Crawford (2012) évoquent par ailleurs les limites liées aux erreurs de la donnée. Les grandes masses de données provenant de sources Internet sont souvent peu fiables, sujettes à des pannes ou à des pertes, et pour comble, ces erreurs et lacunes s’amplifient à mesure que plusieurs ensembles de données (ou bases de données) sont utilisés ensemble. Effectivement, les chercheurs en sciences sociales se sont longtemps posé des questions critiques sur la collecte de données et ont tenté de tenir compte de la fiabilité de leurs données. Cela nécessite de comprendre les propriétés et les limites d'un ensemble de données « dataset », quelle que soit sa taille. Un ensemble de données peut avoir plusieurs millions de morceaux de données, mais cela ne signifie pas qu'il est aléatoire ou représentatif. Pour faire des déclarations statistiques sur un ensemble de données, nous devons savoir d'où proviennent les données; Il est également important de connaître et de tenir compte des faiblesses de ces données. En outre, les chercheurs doivent être en mesure de rendre compte des faiblesses dans leur interprétation des données. Pour ce faire, il faut reconnaître que son identité et sa perspective éclairent l'analyse (Behar & Gordon, 1996). L'interprétation est au centre de l'analyse des données. Indépendamment de la taille d'un ensemble de données, il est sujet à la limitation et au biais. Sans ces biais et limitations étant compris et décrit, une mauvaise interprétation est le résultat. Big Data est le plus efficace lorsque les chercheurs tiennent compte des processus méthodologiques complexes qui sous-tendent l'analyse des données sociales. Le Big Data permet également la pratique de l'« apophénie », c’est-à-dire, voir des modèles là où il n'y en a pas, sachant que de grandes masses de données peuvent produire des corrélations qui vont dans toutes les directions. L’interprétation des données par les outils du Big Data a de grandes prétentions à l’objectivité. Sans le contexte, le Big Data perd son sens. Les liens ne sont pas semblables pour tous, la fréquence de contact n'indique pas forcément la force de la relation, l'absence d'une relation n'indique pas nécessairement qu'une relation doit être établie (Boyd et Crawford, 2012), dans une recherche, un échantillon n’est pas forcément aléatoire parce qu’il est grand, ou nécessairement plus représentatif parce qu’il est petit, dans certaines organisations, les

fonctions d’archivage et de recherche sont très limitées, ce qui implique une absence d’ancrage dans un quelconque contexte historique (Bollier, 2010). Les données ne sont pas génériques. Il est utile d'analyser les abstractions de la donnée, le maintien du contexte demeure critique, en particulier pour certains types de requêtes. Le contexte est difficile à interpréter à grande échelle et encore plus difficile à maintenir lorsque les données sont réduites pour s'adapter à un modèle. La gestion du contexte à la lumière de Big Data constituera un défi permanent (Boyd, Crawford, 2012).

1.1.2 Projets Big Data : enjeux et perspectives

Selon Aurélie Dudezert (2014), les enjeux entourant les projets Big Data sont nombreux, mais peuvent être regroupés en trois catégories, à savoir les enjeux technologiques, organisationnels et économiques. Sur le plan technologique, les projets impliquant le Big Data demandent de repenser l’infrastructure technologique. Ce qui a priori nécessite l’acquisition de solutions technologiques assurant le stockage, les traitements et les analyses avancées ou prédictives de données massives. Outre l’acquisition de nouvelles technologies, il va également falloir assurer leur intégration dans un environnement technologique existant, autrement dit, réussir l’interopérabilité de l’ensemble des systèmes en travaillant sur les formats de données et l'écriture de composants. Ce qui amènera à des travaux sur la véracité, l’intégrité et la fiabilité des données (qualité de la donnée), compte tenu du taux important d’erreurs parmi les données collectées par les entreprises (1% à 5%) et de l’impact que cela puisse avoir sur la qualité des prises de décision (Redman, 1998). La sécurisation des technologies demeure également un enjeu requérant une attention particulière sur deux plans : le droit d’accès aux bases de données (ou aux données) et le niveau de sécurité des systèmes informatiques compte tenu des applications et des activités de l’organisation. Néanmoins, les enjeux organisationnels et économiques sont souvent perçus par les responsables de projets beaucoup plus importants comparativement aux enjeux technologiques (Dudzert, 2013).

autrement dit, la gouvernance des données. L’attribution des budgets nécessaires et des effectifs qualifiés et spécialisés dans la manipulation de données à grande échelle est désormais requise à la fois pour extraire une valeur économique et/ou stratégique et pour accompagner le changement lié à l’accès à ces données massives (McAfee et al., 2012 ). L’un des principaux enjeux stratégiques des organisations est celui d’isoler les données pertinentes qui, en réalité, représente un faible pourcentage, de l’ensemble de données dont dispose l’entreprise. De plus, il demeure difficile de gérer ces grands volumes d’informations compte tenu des sources multiples de données (Dudzert et al., 2013). Une étude de Barton et Court (2012) s’est penchée sur la gestion des données dans une dizaine d’organisations de divers secteurs d’activités. L’étude a démontré que la majorité des organisations ne font pas bon usage des grandes masses de données pour améliorer leurs processus décisionnels. D’autres ne comprennent pas le sens des données et investissent dans des bases de données inadaptées à l’ensemble des processus métiers de l’organisation, ce qui complique le choix des données à exploiter. Colman Parkes (2012) a également fait une étude auprès de 760 directeurs d’entreprises européennes et britanniques à la tête de divers départements, à savoir les TI, le marketing, les services juridiques et les services client. Cette recherche montre que la moitié des dirigeants européens ne savent pas comment rendre profitables les masses de données et comment les organiser. Il est donc important d’établir une stratégie de gouvernance des données pour organiser par priorités analytiques et réfléchir aux combinaisons et aux croisements de données nécessaires pour en extraire une valeur stratégique (Dudzert et al., 2013).

Sur le plan économique, le but d’un projet Big Data est de mettre à profit, à travers une stratégie appropriée, toutes les fonctions de l’organisation (ressources humaines, finance, réglementations, Marketing et autres). Autrement dit, il est question d’aligner la stratégie Big Data aux processus opérationnels pour parvenir à en tirer bénéfice, voire à reconstruire le modèle de création de valeurs de l’entreprise (restructuration, réaffectation, création de nouveaux produits et services) (EMC, 2012). Dans le secteur de la finance, ces projets peuvent aider aux prises de décisions par rapport à la conservation et l’épuration des données dans le cadre réglementaire. Compte tenu des historiques transactionnels dont disposent les banques, l’exploitation de ces données peut être utile pour la ligne d’affaires mais aussi pour le client de la banque. Toutefois, des recherches menées par l’IDC et d’autres travaux scientifiques convergent vers un même constat : la plupart

des entreprises restent immatures sur le sujet et ont une prise de conscience insuffisante sur les défis d’un projet Big Data (Dudezert et al., 2013).

1.1.3 Big Data et algorithme : « une architecture forcée d’une société »

D’après le sociologue Paul Hallé (2016), les masses de données sont de plus en plus gigantesques et nous en sommes responsables, nous les alimentons avec notre assentiment plus ou moins conscient, par la manipulation de nos divers gadgets, par les « traces » que nous laissons pendant nos mobilités virtuelles et physiques et par leurs interconnexions croissantes avec des bases de données tant étatiques que commerciales. La disponibilité et l’attrait aux données exigent à la fois une sophistication technique croissante et une volonté accrue des entreprises de chercher des moyens permettant l’influence des consommateurs et la canalisation de leurs comportements loin des concurrents (Tene et Polonetsky, 2012). Afin de pallier aux masses de données de plus en plus grandes, rendant ainsi leur collecte et leur traitement hors de portée humaine « Too Big to Know » (Weinberger, 2012), les algorithmes permettent une exploration de la donnée, la rendant source de connaissance et de découverte (corrélations, patterns, caractéristiques, etc.) pouvant servir à justifier une décision, agir et même dans certains cas prédire un événement ou une action (Cardon, 2010). Les technologies d'analyse et de surveillance sont dirigées vers plusieurs types de personnes et d’activités, annulant ou rejetant une grande partie du « contexte matériel » dans lequel elles sont extraites. Les algorithmes de collecte ou « d’ingestion », de partitionnement et de mémoire transforment la nature de l'analyse et du savoir et en définitive, de la nature même de la gouvernance de la vie économique, sociale et politique. (Amoore, Piothuc, 2015). Contrairement à la gouvernementalité « disciplinaire » et à la « biopolitique » avancées par Foucault, la gouvernementalité du Big Data conceptualise l’espace/temps comme des « points chauds » abstraits et les sujets de gouvernance comme des singularités (Aradau et Blanke, 2016). Par conséquent, la constitution de l'espace-temps et de la subjectivité reconfigure les interventions et conduit à des effets politiques importants nécessitant une révision des pratiques de sécurité (ibid).

Il faut cependant rappeler que le calcul existe depuis « la nuit des temps ». Aujourd’hui, ceci prend une forme assez singulière, car nous vivons dans une société associée à une idéologie dite néolibérale, dans un monde convaincu par cette ambitieuse idée voulant que tout soit quantifié et calculé. Gabriel Tarde l’avait d’ailleurs quelque peu anticipé dans son ouvrage de 1890. Les lois

de l’imitation.

« Comme on voit ses résultats numériques se régulariser, affecter plus de constance, à

mesure qu’elle porte sur de plus grands nombres, on est quelquefois enclin à penser que, bien plus tard, si la marée montante de la population continue à accroître et les grands États à grandir, un moment viendra où tout, dans les phénomènes sociaux, sera réductible en formules mathématiques. D’où l’on induit abusivement que le statisticien pourra un jour prédire l’état social futur aussi sûrement que l’astronome la prochaine éclipse de Vénus. En sorte que la statistique serait destinée à plonger toujours plus avant dans l’avenir comme l’archéologie dans le passé. Mais nous savons par tout ce qui précède que la statistique est circonscrite dans le champ de l’imitation et que celui de l’invention lui est interdit » (Tarde, 1890, p.510).

La « gouvernementalité algorithmique » telle que décrite par Antoinette Rouvroy (2011), ne s’identifie pas facilement à un cadre disciplinaire de la censure ou de l’enfermement. Elle établit plutôt un environnement qui guide sans contraindre. Par ailleurs, le néolibéralisme a été décrit par Michel Foucault comme l’action de gouverner les conduites par la liberté et l’autonomie, dans le monde des Big Data, les nouvelles techniques d’apprentissage, qui se développent à grande vitesse, calculent les individus en fonction de leurs comportements passés en leur renvoyant constamment la responsabilité de leurs choix. Ces nouvelles techniques de calcul fabriquent des représentations de la société. Et inversement, la transformation qui s'opère actuellement dans la manière de calculer les données épouse les mutations sociopolitiques de nos sociétés. La statistique sociale a longtemps représenté la société « par le haut » à travers des catégories et des conventions qui permettaient de décrire les univers sociaux sans pénétrer dans l'intimité des individus. Le refus actuel d'appartenir à une catégorie, la diversification des trajectoires de vie, l'éclectisme des goûts et des consommations, tout se passe comme si les nouveaux calculateurs numériques avaient entendu ces nouvelles attentes et proposaient leur solution : calculer la société « par le bas », depuis les comportements individuels. La limite est que ces nouveaux algorithmes prédisent des phénomènes sans en comprendre les causes. On ne cherche pas à expliquer pourquoi les enfants issus de familles aisées ont plus de chance de réussir leurs études,

par exemple. On passe de l'explication à la prédiction, d'une société qui cherche à se comprendre comme un système à une société en quête d'efficacité (Cardon, 2015).

Le sociologue D. Cardon (2015) répond dans son ouvrage « à quoi rêvent les algorithmes» aux interrogations entourant la manière dont la société est calculée et façonnée. Selon l’auteur, dans l’espace public traditionnel, l’information était autrefois traitée par des journalistes, communément appelés « gatekeeper », qui avaient un pouvoir décisif de choisir l’information qui voulait diffuser au monde. Actuellement, les nouveaux « gatekeepers » sont des artefacts calculatoires que nous appelons communément des métriques ou des algorithmes, qui trient, filtrent et organisent, selon des choix, le web de manière à nous guider. Zwick and Dholakia (2012) convergent également vers cette vision et affirment que les consommateurs sont désormais construits et fabriqués à partir d’un ensemble de données pour correspondre à ce qui est offert.

Le choix d’une technique de calcul produit des valeurs, des formes et des architectures de mondes différents. Autrement dit, un calcul qui a été programmé correspond à des anticipations relatives à des projets, des intérêts et des préoccupations. Afin de bien saisir les algorithmes dans le monde numérique, D. Cardon (2012) nous propose quatre grandes familles de calculateurs qui dépendent métaphoriquement de la position du calculateur par rapport aux données. Ces grandes familles s’appuient sur des signaux très différents les uns des autres : sur des liens, sur des boutons « like », sur des clicks « vus » et sur l’historique des clicks qui représente les « traces » de navigation. Le calcul qui sera fait, s’appuiera soit sur des données qui ont été explicitement produites par l’utilisateur (avec des liens et like), soit sur des données implicites parce que la personne qui produit ses données ne se rend pas compte ou moins compte qu’elle est en train de les produire. Les grandes familles de calculateurs sont :

La popularité est une reproduction des techniques de mesure d’audience des médias classiques que le web a adoptées par la suite. Cette mesure d’audience s’inspire du vote « démocratique » faisant ainsi correspondre une voix à un clic de l’internaute. Elle utilise l’adresse IP de l’ordinateur pour s’assurer de ne pas comptabiliser plusieurs fois le même internaute. Les sites classés en tête sont ceux qui ont recueilli le plus de votes. L’auteur

rappelle que la mesure d’audience des sites web sert en réalité à mesurer des parts de marchés et intéresse principalement le marché publicitaire qui va ainsi déterminer la valeur des bandeaux publicitaires.

L’autorité est une mesure « méritocratique » qui, en mesurant le nombre de liens hypertextes qui mènent à une page Internet, permet d’en évaluer l’autorité. Ce principe a été vu pour la première fois chez Google avec l’algorithme de PageRank. Dans ce cas, la visibilité soit ça se mérite soit ça s’achète. Dans cette mesure d’audience, le nombre de clics est remplacé par le nombre de liens qu’un site reçoit d’autres sites, le lien hypertexte étant vu comme une reconnaissance d’autorité. Peu importe que le site A dise du bien ou du mal du site B, seul compte le fait que le site A ait estimé important de citer le site B (comme une référence, une source, une preuve, un exemple ou un contre-exemple). L’information la plus visible n’est plus la plus vue (le principe de popularité de la première technique) mais celle que les internautes ont plébiscité en lui adressant beaucoup de liens.

La réputation est un algorithme qui se place plus près de l’individu pour intercepter des signaux plus volatils, spontanés et conversationnels sur les réseaux sociaux tels que les

« likes » et les « retweets », etc. C’est plus axé sur l’affinité et la « viralité ».

Contrairement aux métriques d’autorité qui se focalisent sur la reconnaissance dont les documents font l’objet sans se soucier de la qualité de leurs auteurs, les métriques de réputation poussent les internautes à se mesurer eux-mêmes au sein du web. Il s’agit de rendre audible les nombreux internautes s’exprimant sur les réseaux sociaux. Le nombre de like obtenus, le nombre d’amis sur Facebook, le nombre d’abonnés sur Twitter ou encore le nombre de fois qu’une information produite aura été commentée ou partagée par d’autres permettent de mesurer cette réputation numérique et d’offrir un nouveau mode de classement. Il s’agit de « mesurer le pouvoir qu’a l’internaute de voir les autres relayer

les messages qu’il émet sur le réseau, […], de mesurer la force sociale d’un nom, d’un portrait ou d’une image ». Contrairement au monde de l’autorité où la visibilité se mérite,

celle-ci peut se fabriquer et s’anticiper dans celui de la réputation. Il existe par exemple des manuels de management de la « e-réputation » donnant des conseils sur le jour et l’heure optimale à laquelle poster un tweet pour s’assurer de son retweet : « placés dans

La prédiction cherche à rendre le calculateur invisible. Il calcule l’individu à l’aide des traces singulières de son comportement réel, et prédit son action tout en l’orientant à l’aide de méthode d’apprentissage telle que l’« apprentissage automatique ». Il s’agit de personnaliser les calculs à partir des traces d’activités des internautes pour les inciter à agir dans telle direction plutôt que dans telle autre. L’algorithme, en comparant un profil à ceux d’autres internautes ayant effectué la même action que lui, anticipe qu’ une personne pourrait faire telle ou telle chose qu’elle n’a pas encore fait parce que celles qui lui ressemblent l’ont, elles, déjà faite. Il est donc possible de prévoir le futur de l’internaute à l’aide du passé de ceux qui lui ressemblent.

D. Cardon (2015) évoque cette ambition qui est au cœur des nouveaux modèles algorithmiques qui consiste à calculer la société par le bas à partir des comportements des utilisateurs (consommateurs et internautes) en installant un environnement technique invisible qui permet de nous orienter sans nous contraindre en se basant sur notre historique du comportement, ce qui insinuerait que nous sommes simplement la suite de nos comportements passés. Dans le même ordre d’idées, Lawrence Lessig (1999) dans son ouvrage « Code » aborde les systèmes et affirme qu’ils sont réglementés par quatre forces, soit le marché, la loi, les normes sociales et l'architecture. Boyd et Crawford (2012) évoque que dans le cas de la technologie, l’architecture devient le « code », et lorsqu’il est question du Big Data, les quatre forces sont au travail, mais souvent en désaccord. Bien que des fonctionnalités telles que la personnalisation permettent un accès rapide à beaucoup d’informations pertinentes, ils présentent tout de même des enjeux éthiques très critiques et fragmentent le public de façon très discutable (Pariser, 2011).

La façon dont la société est calculée risque de créer des mécanismes de centralisation encore plus forts et de nouvelles inégalités sociales et culturelles. Cette perspective grandissante de déléguer notre conduite à des « automates » sans même pouvoir discuter de leur fonctionnement et de leur idéologie, demande selon certains l’instauration d’un débat démocratique à ce sujet. (Cardon, 2015).

1.1.4 La surveillance à l’ère du Big Data : « un fantasme de sécurité »

Faisant du projet Benthamien le modèle abstrait d’une société disciplinaire axée sur le contrôle social, Foucault définit le panoptique comme un système de surveillance « ou une personne ou un système automatisé en surveille plusieurs ». Ceci représente selon l’auteur « l’esquisse géométrique d’une société rationnelle » (Bentham, Foucault, Perrot, 1977) dont l’effet est d’être telle que, « même en l’absence d’un surveillant, le détenu dans sa cellule, non seulement se croit observé, mais se sache observé» (Bentham, Foucault et Perrot, 1977). Le modèle panoptique a été promu comme un cadre de référence pour discuter de la surveillance (Albrechtslund, 2008). Cependant, ce modèle tend à proposer un récit mettant l'accent sur la coercition et la rationalité. Selon certains auteurs, il ne permet pas de tenir compte des contextes contemporains à la fois saturés par les médias sociaux et les technologies numériques de la surveillance qui ne cessent de se multiplier (Lyon, 2003). De ce fait, les médias de masse peuvent être considérés comme «synoptique» dans lesquels de nombreux citoyens regardent les élites (Lyon, 2001). En parallèle, nous verrions le passage d’une société de la discipline fondée sur une « logique bureaucratique » à une société du contrôle fondée sur la « logique du logiciel » (Deleuze, 1992; Haggerty et Ericson 2000), permettant la surveillance des populations mobiles et non seulement celles qui se trouvent confinées dans des espaces relativement circonscrits, capable de retracer le moindre comportement des individus (Lyon, 2003). Il demeure néanmoins que ces deux systèmes de surveillance, le « panoptique » et le « synoptique », représentent les deux pôles de surveillances appliqués dans nos sociétés (Fraser, 2012). En effet, les pratiques de surveillance ont constamment été en mouvement, allant de la surveillance ciblée des populations et des individus à la « surveillance de masse », à la recherche de « l’intelligence décisionnelle » dont la surveillance par le Big Data demeure le parfait exemple (Lyon, 2012, p.125).

Dans son ouvrage « surveillance studies : an overview », David Lyon (2007, p.95) adhère à la notion deleuzienne de l’« assemblage » qui réfère au « rassemblement d'éléments disparates

pour créer une entité de surveillance vaguement associée ». Selon l’auteur, les processus de

surveillance à l’ère du Big Data sont beaucoup plus complexes, ambigus, et vastes. Pour interroger les systèmes de surveillance, il identifie trois types de surveillance: la surveillance face à face, le système de fichiers ou la surveillance bureaucratique et finalement, l’interface électronique. Conçus en tant que dispositifs heuristiques, ils peuvent être trouvés ensemble dans

un seul système de surveillance. Ces systèmes sont présents dans les villes et à travers certains États-nations, et la prolifération des technologies de surveillance les plus récentes est de plus en plus importante, comprenant la biométrie, la reconnaissance faciale, les technologies de localisation « location technologies » telles que le GPS dans les téléphones et l’identification par radiofréquence RFID, menant potentiellement et dans certains cas à un « tri social » et à de la discrimination. (Lyon, 2007).

Lyon définit la surveillance comme « …l'attention focalisée, systématique et routinière sur des données personnelles utilisées à des fins d'influence, de gestion, de protection ou de direction » (Lyon, 2007, p.14). Le but principal de la surveillance est généralement de recueillir des informations sur des sujets, leurs activités ou leurs associés. Il peut y avoir également une intention secondaire de dissuader toute une population d'entreprendre certains types d'activités (Clarck, 2006).

La surveillance est un ensemble de processus dans lequel nous sommes tous impliqués, en tant que surveillés et surveillants (Lyon, 2007). Les personnes participent activement à leur propre surveillance, consciemment ou non, en encourageant les systèmes de surveillance à collecter des données sur leur personne. Selon Marwick et Boyd (2001), il est même contradictoire de voir des utilisateurs de médias sociaux moins préoccupés par les gouvernements et les entreprises qui surveillent leurs faits et gestes en ligne que par les membres de leur réseau social, soit leurs patrons ou leurs parents par exemple. Aujourd’hui, les personnes se surveillent entre elles en ligne dans un but de maintenir un équilibre voulu entre la publicisation et l'isolement, en consommant facilement les profils et les mises à jour des statuts des uns et des autres. Cette surveillance montre les effets d’une domestication des pratiques de surveillance dans la vie des citoyens et dans leurs relations interpersonnelles au quotidien, autrement dit, c’est une autosurveillance qui vise à internaliser la pratique de la surveillance sociale (Boyd et Marwick 2011; Marwick 2010). Daniel Trottier (2011) écrit à ce propos : « le potentiel d'être observé par

d'autres contextualise leur propre surveillance ». Ce processus révèle beaucoup sur les normes

sociales, les actions des utilisateurs et les stratégies de présentation de soi dans le « logiciel social ». (Marwick, 2012). Voici trois situations ou l’utilisateur devient un surveillé et/ou un surveillant :

La surveillance latérale, ou bien la surveillance par les pairs, est un concept avancé par Andrejevic (2005) voulant dire que les individus utilisent les mêmes stratégies d’investigation que la police ou le marketing pour recueillir de l'information sur les personnes faisant partie de leur cercle social. Ceci démontre comment la peur et la suspicion sont utilisées pour normaliser et encourager la surveillance par les pairs.

La surveillance participative est un concept que Albrechtslund (2008) définit comme le partage des activités (des préférences, des croyances, des localisations, etc.) sur les réseaux sociaux par les internautes. Le partage de ces renseignements personnels est en réalité une participation à sa surveillance.

La surveillance sociale est l'utilisation des sites Web 2.0 tels que Twitter, Facebook et

Foursquare pour voir quels amis, familles et connaissances sont à la hauteur (Joinson 2008;

Tokunaga 2011). Ces technologies sont conçues pour que les utilisateurs puissent continuellement enquêter sur les traces numériques laissées par les personnes connectées dans les médias sociaux (Marwick, 2012).

« Depuis les technologies biométriques déployées dans les aéroports et aux frontières, en

passant par la vidéo de surveillance dans les écoles, jusqu’aux puces RFID dans les hôpitaux et les cartes à bande magnétique des banques alimentaires, les technologies de surveillance s’intègrent dans tous les aspects de la vie moderne, mais avec des effets variés en fonction des populations concernées » (Monahan, 2006, p.10).

Néanmoins, la surveillance des données est avant tout une priorité des gouvernements et des entreprises. Elle comprend des images de vidéosurveillance, de la biométrie telle que les empreintes digitales ou de l'iris, des dossiers de communications papier ou en ligne, des contenus d’appels et des transactions. Ces données sont souvent numériques (Lyon, 2007). Ce type de surveillance de données appelée « Dataveillance » ou « surveillance actuarielle » a été défini par Roger Clarke (2006) comme étant l'utilisation systématique des systèmes de données personnelles dans l’investigation ou la surveillance des actions ou des communications d'une ou plusieurs personnes. De nombreuses entreprises, dont les médias sociaux, recueillent systématiquement les données personnelles partagées par les utilisateurs (internautes) (Clarke, 1997; Phillips 2010). Des société de marketing surveillent les traces numériques laissées par les internautes pendant leur consultation des sites web ou des réseaux de publicité (Grimmelmann,

2009; Turow, 2006). En définitive, nous vivons aujourd’hui dans une société de surveillance (Lyon, 2008), une surveillance qui désormais est une propriété de la modernité (Haggerty et Ericson, 2006 ).

Les révélations d’Edward Snowden représentent un point de départ pertinent pour discuter de la relation entre « Big Data et sécurité » (Lyon, 2014). Les professionnels de la sécurité adoptent de plus en plus un langage et des méthodes de calcul de prédiction inspirées des applications du

Big Data dans le monde des affaires. En effet, dans cette révolution des données, le secteur de la

sécurité démontre un intérêt tangible pour les techniques de prédiction du crime, en utilisant des méthodes d’apprentissage automatique (expliquées précédemment), communément appelées «

l’apprentissage automatique » (Aradau, Blanke, 2016). Selon C. Aradau et T. Blanke (2016), la

prédiction a toujours existé dans nos appareils gouvernementaux. Simplement, un mode numérique distinct de prédiction a émergé, à la fois d’une représentation de la « discipline » de la présente « norme » et de la normalisation « biopolitique » prospective basée sur un calcul statistique des fréquences. La promesse des techniques prédictives du Big Data se traduit par de nouvelles capacités visant à permettre aux professionnels de la sécurité d’anticiper une attaque terroriste, une crise migratoire et la criminalité au sens large. Le Big Data promet ainsi une «révolution» dans les pratiques de sécurité, allant du contreterrorisme et des contrôles frontaliers au « policing » du crime et aux interventions d'urgence (Aradau, 2015). Ceci est rendu possible grâce à l’utilisation des technologies de l'information qui, selon les circonstances, s’avèrent plus abordables pour les organismes de sécurité et de surveillance comparativement à d’autres méthodes telles que la surveillance directe ou spécifique (par exemple : l’écoute électronique). Cette accessibilité offre également d’autres avantages incitant à étendre la fonction du système et à s’intéresser à des données n’ayant aucune nécessité à l’atteinte de l'objectif initial (Lyon, 2007).

Depuis le 11 septembre 2001, la surveillance est incontestablement en pleine prolifération. L'un de ses principaux effets se trouve être le processus de déstructuration et de restructuration de l'information dans le but de trouver des corrélations ou des éléments sur des personnes ayant des attributs spécifiques (par exemple : l’exploration des enregistrements téléphoniques). Le but n'est pas seulement de trouver le suspect qui a commis un acte, mais d’empêcher l’acte lui-même

(Lyon, 2014). En effet, le renseignement, la lutte contre le terrorisme et le « policing » ont été en partie transformés par cette promesse du Big Data et de l'analyse prédictive voulant repérer les tendances inattendues et identifier les suspects potentiels. De ce fait, l'analyse prédictive semble être exploitée à des fins de gouvernance et d’anticipation pour répondre à un éventail croissant de problèmes de sécurité. (Aradau, 2015). Les capacités du Big Data, y compris des « métadonnées », intensifient la surveillance par l’élaboration d’ensembles de données interconnectés. Les dynamiques actuelles d'influence, de gestion des risques et de contrôle augmentent leurs vitesses et leurs portées grâce à deux nouvelles techniques passant en particulier l'analyse prédictive (Lyon, 2014). L’incorporation d’une grande masse de données, à la fois dynamiques et hétérogènes, dans un processus d’analyse prédictive promu pour générer de nouvelles capacités de regard sur l'avenir de manière à contrôler et à gouverner l’inconnu. (Boyd et Crawford, 2012; Cukier et Mayer-Schoenberger, 2013; Lyon, 2014; Aradau et Blanke, 2015).

À ce propos, Bilel Benbouzid (2016) a publié un article afin d’objectiver la vocation d’une des prestigieuses entreprises de conception de logiciels de prédiction Predpol; une entreprise californienne dont la mission est de développer des logiciels de prédiction de la criminalité permettant aux patrouilleurs, grâce à un tableau de bord analytique de « style plateforme », d’accéder à une information prédictive quotidienne. Dans ce cas précis, l’algorithme utilisé s’inspire des méthodes de prédictions sismiques. D’où le questionnement sur la pertinence et l’efficacité de l’outil. Il s’est avéré que la réussite de ce produit est due en grande partie à des stratégies marketing agressives, allant jusqu’à vendre le produit à des prix dérisoires en échange d’un engagement de la part des responsables des services de police de parler positivement de la marque, une sorte de « earned media ». Autrement dit, le but n’était pas d’offrir l’innovation et l’ingéniosité technologiques, mais plutôt de vendre un produit promu par des acteurs clés de la sécurité. Cette stratégie repose selon B. Benbouzid sur trois piliers, à savoir une nouvelle forme, les distinguant ainsi des autres et leur permettant de s’imposer rapidement sur le marché (plateforme facile d’utilisation, stockage sur le Cloud, analyse des données en temps réel), un slogan accrocheur (More than hotspot) et un mythe fondateur basé sur cette prétention d’être différent des méthodes traditionnelles, s’appuyant sur les origines sismologiques de l’algorithme utilisé. Predpol adopte dans son algorithme le « principe de contagion » du crime dans l’espace

et dans le temps. L’hypothèse avancée est donc celle de dire que le crime appelle le crime. « Il

est difficile d’appliquer une telle approche structurelle de l’espace pour un phénomène aussi contingenté que le crime ». Après l’étude de l’algorithme, l’outil ne fait pas plus que

cartographier les points chauds (Benbouzid, 2016). Autrement dit, « Predpol » se sert d’une science dure pour déguiser la subjectivité des techniques prédictives des Big Data.

Les pratiques de surveillance de masse révélées par Edward Snowden montrent clairement comment les gouvernements, en l’occurrence américain, britannique, canadien, et d'autres organismes connexes exercent une surveillance à très grande échelle sur les populations (Lyon, 2014). L’étendue du programme (PRISM) autorisait la National Security Agency, à l’insu des populations à avoir un accès direct aux serveurs des géants de l’informatique et d’internet tels que : Apple, Facebook, Google, Microsoft, Skype, Yahoo et YouTube. D’autant plus que les mécanismes de cryptage et de contrôle de confidentialité ont été contournés avec la complicité même de ces entreprises (Gellman et Poitras, 2013; Lyon, 2014).

Les questions éthiques liées à la surveillance des données ont été regroupées en trois catégories par Lyon (2014), soit la vie privée, le tri social et la préemption.

La vie privée fait référence dans une société démocratique à un droit humain, au même titre que la liberté d’expression. À l'ère post-Snowden, il est légitime de se questionner sur la menace de nos valeurs et d'établir une éthique des pratiques du Big Data qui traite du problème de l'écart croissant entre les données et les individus (Amoore, 2014; Stoddart, 2014). La protection de la vie privée reste aujourd’hui la principale référence juridique mobilisée par les mouvements d’opposition à une surveillance jugée inappropriée, disproportionnée ou illégale. À l’instar de ces mouvements militants, des experts et chercheurs universitaires estiment qu’il est ainsi important de proposer des limites techniques telles que le cryptage, les applications d’anonymat et tout autre moyen permettant de rendre approprié le contenu du Big Data (Lyon, 2014).

Le tri social est un concept qui nous met en garde contre plusieurs pratiques connexes qui

produisent des résultats faux ou biaisés, lorsque des techniques du Big Data supposées neutres et éclairantes (le profil prédictif) sont appliquées à des problématiques sociales et politiques. Nous voyons une mutation d’une logique de « séduction catégorielle » (categorical seduction) vers une

logique de « suspicion catégorielle » (categorical suspicion). L’enjeu de la surveillance ne se résume plus au ciblage des groupes de consommateurs pouvant bénéficier de produits ou services privilégiés. L’identification des individus et des groupes « à risque » devient aussi et surtout l’objet d’une attention particulière de la part des acteurs de la sécurité (Lyon, 2007; Bardet et Purenne, 2010).

En somme, la transparence permet de protéger les personnes contre les conséquences potentiellement néfastes du tri social, de la discrimination et d’autres effets de ces nouveaux mécanismes de surveillance que David Lyon (2007, p.184) appelle « l’État de sécurité ». À ce propos, l’auteur encourage un examen plus approfondi des processus de profilage et de classification puisqu’ils sont directement impliqués dans la création et le maintien des pratiques discriminatoires. (Lyon, 2007)

Lyon (2014) énonce également trois principales façons dont l'engagement dans des pratiques du

Big Data pourrait modifier ou accentuer la surveillance : premièrement, du fait que le Big Data

implique une utilisation accrue des algorithmes d'analyse, il existe à la fois une dépendance croissante à l'égard du logiciel de surveillance et une dépendance concomitante relative à la relation « humain / algorithme », définissant les manières dont les sujets humains sont traités par les systèmes de surveillance. Une telle automatisation transforme la discrétion dans les systèmes de surveillance. Deuxièmement, il y a une grande tendance dans les pratiques du Big Data, notamment dans les opérations de surveillance, à se concentrer sur la prédiction et l’anticipation du futur. Dans le contexte de la gouvernance néo-libérale, cette anticipation est susceptible de mettre davantage de poids sur la surveillance, gérant ainsi les conséquences plutôt que d’essayer de comprendre les causes du problème social telles que la criminalité et le désordre. Enfin, le troisième élément fait référence à l'adaptation ou plutôt à la propension à l'analyse de traiter n’importe quel tyoe de données comme si les méthodes peuvent être transférées avec succès et avec peu de risques d'un champ à l'autre. L'enthousiasme pour les solutions de Big Data peut conduire à un transfert inapproprié de techniques d'un champ à un autre.

1.2.1 Contexte historique et enjeux.

La conversion des revenus criminels à des formes qui permettent aux délinquants de dépenser et d’investir sans entraves a été un enjeu pour eux, mais aussi pour les représentants de l’État, et cela depuis les débuts de la « mafia américaine » (Levi et Reuter, 2006; Roberge, 2008). Les « mafieux », tels que Meyer Lansky, avaient par exemple compris qu’il était possible de dissimuler l'origine de leurs capitaux, grâce au réseau d’îles politiquement indépendantes, dit offshore, ou en acquérant des biens immobiliers et des entreprises légitimes, rendant ainsi difficile de retracer le lien entre leurs richesses et leurs sources criminelles (Levi et Reuter, 2006 ; Jetha, 2016). L’objectif étant d'éviter ce qui avait fait abattre le célèbre Al Capone, les accusations d'évasion fiscale. C’est à partir de ce moment que les autorités américaines ont commencé à porter un intérêt particulier au crime organisé et au blanchiment d’argent. Cette réussite du fisc américain a convaincu le gouvernement qu’il était possible de lutter efficacement contre le crime organisé par la voie financière. (Levi et Reuter, 2006 ; Roberge, 2008). Toutefois, les mesures prises pour lutter contre ce phénomène varient d'un pays à l'autre, d’autant plus que le blanchiment d'argent reste d’une grande plasticité. De plus, il demeure difficile de lutter efficacement contre l’« argent sale », sans organisations internationales puissantes et efficaces (Schneider, 2010). À ce propos, Dolar et Shughart (2007) ont démontré qu’aux États-Unis, les mesures prises à la suite des attaques du 11 septembre visant à prévenir le blanchiment d'argent et le financement des activités terroristes dans les institutions financières américaines ont eu peu d'effet malgré l’accroissement important de la surveillance, notamment dans les institutions financières. Quantifier l’ampleur du blanchiment d’argent demeure aussi très difficile. Bien que bon nombre de chercheurs aient tenté de le faire, les estimations sont généralement sans support sérieux et peu crédible (Reuter et Truman, 2005 ; Levi et Reuter, 2006). Le Fonds monétaire international (FMI) l’a estimé en 1996 dans une fourchette comprise entre 2% et 5 % du produit intérieur brut (PIB) mondial, soit un montant estimé entre 590 et 1 500 Md US. Une étude plus récente réalisée sur 21 pays membres de l’OCDE chiffre l’économie de l’ombre ou « souterraine » à 15 % en moyenne du PIB, la Grèce et l’Italie arrivent premières, avec 30 % et 27 %, respectivement. Les pays scandinaves et la France se situant dans la moyenne, tandis que les États-Unis et l’Autriche, avec 10 % du PIB, et la Suisse, avec 9 % du PIB, se classent derniers (Schneider, 2010; Schneider et Enste, 2003).

Comme d’autres pays occidentaux, le Canada a déclaré la guerre aux organisations criminelles et au terrorisme, avec une augmentation graduelle des initiatives législatives et de leur mise en application ciblant ainsi les aspects financiers du crime. Depuis 1981, les saisis et les confiscations des produits de la criminalité par les autorités canadiennes n’ont cessé d’augmenter, de même que les poursuites et les ressources qui y sont affectées (Beare, 2007). Sur le plan du secteur privé, nous avons observé une mutation d’un système de déclaration volontaire des transactions à un régime obligatoire de déclaration de soupçon, tenant légalement responsables les entités déclarantes à défaut de se conformer (Levi, 2010). C’est ce que David Garland (1996) appelle « the responsibilisation strategy of governance », qui explique l’avènement d’acteurs privés dans un domaine originellement régi par l’État, dans une volonté de ce dernier, de responsabiliser les acteurs non étatiques, afin de pallier sa propre incapacité à endiguer la délinquance (Garland,1996 ; 2001). En effet, l’État ne peut espérer surveiller et contrôler directement les transferts financiers (Levi, 2010). Les efforts de lutter contre l’« argent sale » reposent désormais sur la coopération entre les forces de l'ordre et les diverses professions financières impliquant une manière de gouverner qui trahit l'existence d'une tension entre deux logiques contradictoires, soit la souveraineté de l'État et la gouvernance néolibérale (Amoore et De Goede, 2008 ; Favarel-Garrigues et al., 2011). En effet, la poursuite de la lutte contre le blanchiment d'argent et le financement des activités terroristes est souvent considérée comme une question de souveraineté des États, car elle repose sur une « intervention préventive des institutions étatiques » (Vlcek, 2008). Bien que la lutte contre le financement du terrorisme soit une composante non militaire de la « guerre contre le terrorisme » (Heng et McDonagh, 2009), elle a néanmoins été liée à la nécessité de répondre à la possibilité d'une attaque imminente (Aradau, 2007). « Nous devons mettre au point des cellules terroristes dans 60 pays ou plus en

utilisant tous les outils de la finance, du renseignement et de l'application de la loi » (Bush,

2002). La question de la souveraineté est soulignée par des analyses qui mettent l'accent sur l'exceptionnalisme de la « guerre contre le terrorisme ». La composante financière de cette « guerre » est associée à un ensemble de mesures de « sécurité préventive » qui normalisent les soupçons et tendent à inclure ou à exclure les acteurs des flux financiers internationaux (Martin, 2007). Gérées dans des situations très incertaines, ces mesures reflètent des décisions souveraines

en ce sens qu'elles sont présentées comme des mesures urgentes et techniques et ne doivent donc pas être soumises au débat politique (Aradau et Van Munster, 2008).

Selon Margarette Beare (2007), l’évolution des mesures de lutte contre l’argent sale et le financement des activités terroristes au Canada est le résultat de deux types de pression, interne (domestique) et externe (internationale). Sur le plan interne, l’escalade des mesures punitives doit être mise dans un contexte où les autorités canadiennes intensifiaient les efforts en matière d’opérations policières et de poursuites contre le crime organisé ces dernières années. L’attention élevée généralement accordée au crime organisé au Canada, particulièrement dans les dossiers très médiatisés tels que « la guerre des motards » au Québec, a entrainé une multitude d’initiatives légales visant à élargir les pouvoirs d'enquête criminelle et de poursuites de l'État, adoptant ainsi une approche hautement punitive. Sur le plan externe, le rôle des États-Unis et de certains organismes internationaux, en l’occurrence le GAFI « FATF », a été central dans la reconfiguration des mesures de lutte contre le trafic de drogue et le crime organisé transnational (Reuter et Truman, 2005; Beare, 2007 ; Levi, 2010 ; Favarel-Garrigues et al., 2011 ). Ces deux acteurs ont utilisé leur influence pour définir le problème, identifier les solutions et les imposer unilatéralement au reste de la « communauté internationale ». De nombreux pays ont ainsi modifié (ou créer) leur législation sur le blanchiment d’argent en y incluant celle du financement du terrorisme (Reuter et Truman, 2005). Ils étaient également convaincus que le régime des déclarations d’opérations douteuses « suspicioustransaction reporting » représentait une mesure fondamentale, dont tous les pays devraient se munir pour combattre les aspects financiers du trafic de drogue et du crime organisé de manière générale (Beare, 2007). L’attaque terroriste du 11 septembre 2001 est considérée comme un évènement crucial en la matière, notamment par son impact significatif sur le renforcement des politiques entourant la surveillance financière et le pouvoir de l’État (Favarel-Guarriges et al. 2001 ; Levi et Reuter, 2006 ; Lyon, 2014). Cet événement a donné lieu à une nouvelle orientation et de nouvelles mesures législatives visant le financement du terrorisme : une législation draconienne, punitive et intrusive jamais introduite au auparavant au Canada (Beare, 2007). En somme, les effets de ces divers développements et pressions, aussi bien domestiques qu’internationaux ont amené le Canada, comme d’autres pays d’ailleurs, à adopter des mesures spécifiques de lutte contre le blanchiment d’argent et du financement du terrorisme (Levi et Reuter, 2006)

Margarette Beare et Stephen Schneider (2007) ont identifié des évènements contribuant à la création du régime canadien de lutte contre le blanchiment d’argent et du financement du terrorisme au Canada. Nous vous dressons donc une liste chronologique récapitulant les dates importantes.

En 1989, le gouvernement canadien a amendé le Code criminel en ajoutant la possession des produits de la criminalité et le blanchiment d’argent aux activités criminelles. Les modifications ont traité de tous les aspects des produits de la criminalité, y compris l'identification d'infractions spécifiques, les mandats spéciaux de perquisition, les ordonnances de restriction et les confiscations. La législation autorisait la saisie des produits de certains crimes et à accordait l'immunité aux personnes qui rapportent volontairement des actes suspects à la police. Les infractions relatives à la possession et au blanchiment des produits de la criminalité ont également été ajoutées à la Loi sur les aliments et drogues (l'ancienne Loi sur les stupéfiants a depuis été abrogée et remplacée par la Loi réglementant certaines drogues et autres substances de 1996). En 1990, le Bureau du surintendant des institutions financières (BSIF) a édicté les lignes directrices et les pratiques exemplaires en matière de lutte contre le blanchiment d'argent. Un an plus tard, la Loi sur le produit de la criminalité (blanchiment d'argent) a été proclamée. Cette loi était la première à introduire à la fois la tenue des dossiers bancaires et la déclaration volontaire. Dans la même année, la Stratégie canadienne antidrogue a financé la mise en place de trois unités pilotes intégrées de lutte antidrogue (PDAI) auprès de la Gendarmerie royale du Canada (GRC). En 1993, il y a eu le Mémorandum de déclaration volontaire de toutes les transactions suspectes pouvant indiquer des activités de blanchiment d'argent. Au même moment,

la Loi sur la gestion des biens saisis a été proclamée. Les infractions de possession et

d'allotissement du produit de certains crimes ont été ajoutées à la Loi sur les douanes et à la Loi

sur l'accise.

En 1996, le gouvernement canadien a mis en œuvre l'initiative intégrée sur les produits de la criminalité (IPOC), en créant dix unités intégrées, complétant les trois unités existantes de l'IADP. Entre 1997 et 1999, des amendements au Code pénal ont eu lieu. (La Loi sur les drogues