Plus-value hydrologique du post-traitement de la

prévision météorologique d'ensemble

Mémoire

Emixi Sthefany Valdez Medina

Maîtrise en génie des eaux - avec mémoire

Maître ès sciences (M. Sc.)

Plus-value hydrologique du post-traitement de la

prévision météorologique d’ensemble

Mémoire

Emixi Sthefany Valdez Medina

Sous la direction de :

Résumé

La prévision d’ensemble hydrologique est devenue un élément clé pour atténuer les effets des catastrophes naturelles (crues et sécheresses) et pour aider à la gestion des barrages (gestion du risque et de la ressource). Une approche probabiliste permet de représenter l’incertitude de prévision et de faciliter la prise de décision. Dans cette étude, un système automatique de prévision d’ensemble du débit tenant compte des principales sources d’incertitude est utilisé. L’incertitude météorologique est décrite en utilisant des prévisions d’ensemble météorolo-giques (MEPS) qui, malgré des améliorations constantes, peuvent rester localement biaisées et/ou peu fiables. Ces deux problèmes peuvent affecter la qualité de la prévision du débit et les décisions qui en résultent. Cette étude vise à évaluer si un post-traitement de la prévi-sion météorologique est utile pour améliorer la préviprévi-sion du débit produite par un système quantifiant les principales sources d’incertitude. Deux techniques de post-traitement météo-rologique sont utilisées pour corriger des prévisions de précipitation ECMWF : “Censored, Shifted Gamma Distribution” (CSGD) et “Distribution-based scaling” (DBS). Les prévisions de précipitations brutes et post-traitées sont utilisées pour forcer 20 modèles hydrologiques et obtenir des prévisions d’ensemble de débits. L’incertitude liée aux conditions initiales sont décrites par une assimilation de données (filtre d’ensemble de Kalman). Le post-traitement de la prévision de précipitation est évalué sur les sous-bassins de la rivière Gatineau au Québec en utilisant une évaluation multi-critères (diagramme de fiabilité, MCRPS...). Les résultats montrent une amélioration de la prévision météorologique en termes de fiabilité pour tous les bassins. Cette amélioration dépend de la quantité de précipitations, de l’horizon de prévision et de la saison. Les améliorations en termes d’exactitude sont plus modérées. Cependant, l’amélioration de la qualité de la prévision de précipitation a un impact faible sur la prévision du débit.

Abstract

Ensemble streamflow forecast has become a key element to mitigate the effects of natural disasters such as floods and droughts and to help dam management (risk and resource man-agement). A probabilistic framework allows to represent the uncertainty linked to the forecast and in this way help the decision making. In this study, an automatic streamflow ensemble prediction system that accounts for three sources of uncertainty is used. Meteorological uncer-tainty is accounted for by using a meteorological ensemble prediction systems (MEPS) which despite constant improvements remain locally biased and/or unreliable. These problems can affect the quality of the streamflow forecast and consequently, the resulting decision. This study aims at evaluating if a MEPS post-processing is useful to improve streamflow forecasts issued by a modeling chain that quantifies the main sources of uncertainty. Two MEPS post-processing techniques were used to correct the ECMWF precipitation forecast: Censored, Shifted Gamma Distribution (CSGD) and Distribution-based scaling (DBS). The raw and post-processed ensemble precipitation forecasts are used as forcing variables to 20 rainfall-runoff models to produce ensemble streamflow forecasts. To consider the uncertainty arising from the initial conditions, the hydrological models benefit from data assimilation (Ensem-ble Kalman Filter). The post-processing of precipitation forecast is assessed over Gatineau’s sub-basins in Quebec using a multi-criteria evaluation (reliability diagram, MCRPS...). The results show an improvement in the meteorological forecast in terms of reliability for all the basins. This improvement varies by amount of precipitation, forecast lead time and sea-son. The improvements in terms of accuracy were more moderate. However, the use of a meteorological post-processing technique did not lead to an improvement of the streamflow forecast.

Table des matières

Résumé iii

Abstract iv

Table des matières v

Liste des tableaux vii

Liste des figures viii

Remerciements xii

1 Introduction 1

1.1 Mise en contexte . . . 1

1.1.1 Enjeux de la prévision des débits . . . 1

1.1.2 Bref aperçu historique des prévisions météorologiques et hydrologiques 2 1.1.3 Prévision météorologique d’ensemble . . . 3

1.1.4 Prévision hydrologique d’ensemble . . . 7

1.2 Définition de la problématique . . . 8

1.3 Objectif et questions de recherche. . . 9

1.4 Plan du mémoire . . . 10

2 Chapitre 2 : Aspects méthodologiques et données 11 2.1 Bassins versants de l’étude. . . 11

2.2 Données observées . . . 13

2.3 Données des prévisions météorologiques . . . 15

2.4 Modélisation et prévision hydrologique . . . 16

2.4.1 Modèles hydrologiques et module de neige . . . 16

Calage et validation des modèles hydrologiques . . . 16

2.4.2 Schémas d’initialisation des modèles . . . 18

2.5 Post-traitement statistique des prévisions de précipitation . . . 19

2.5.1 Particularités de la précipitation . . . 19

2.5.2 Pré-requis du post-traitement statistique. . . 20

2.5.3 Approche Censored Shifted Gamma Distribution . . . 22

2.5.4 Approche Distribution-based scaling (DBS). . . 26

2.5.5 Processus de sélection de la période d’entraînement. . . 28

2.6 Évaluation de la qualité des prévisions d’ensemble . . . 29

Exactitude . . . 30

Fiabilité et dispersion de l’ensemble . . . 30

Performance générale . . . 33

Les scores standardisés . . . 33

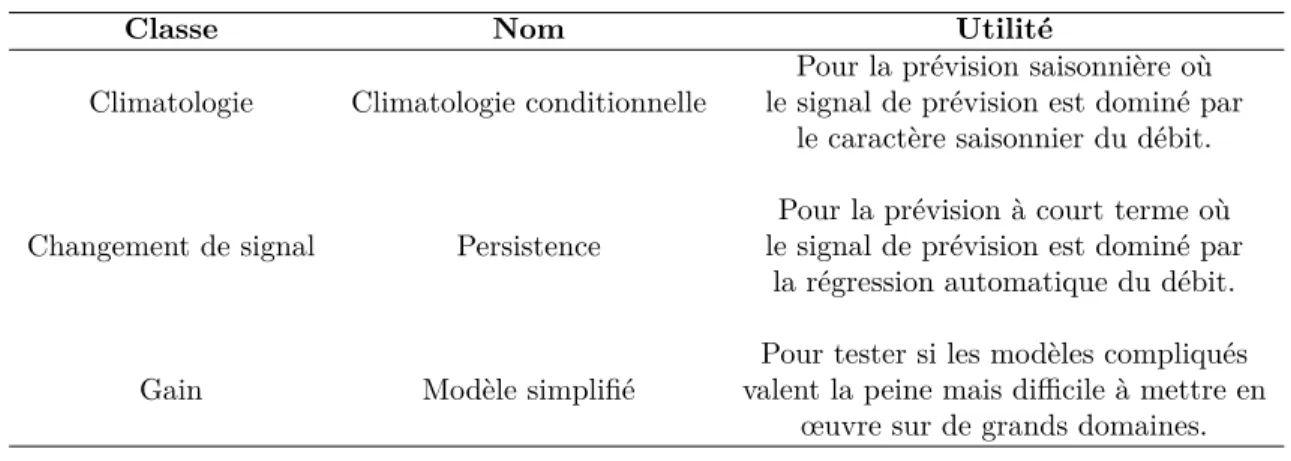

Systèmes de références utilisés . . . 34

2.7 Synthèse . . . 35

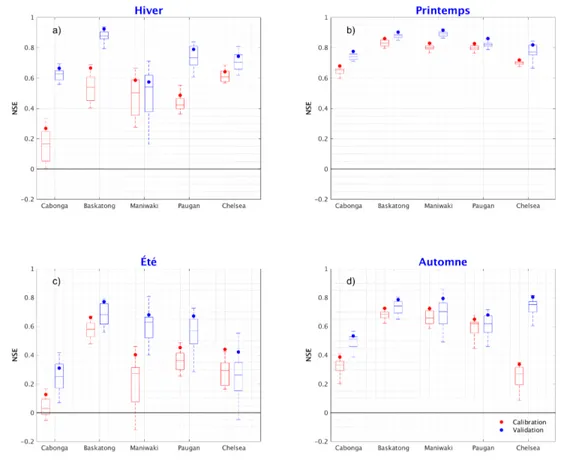

3 Chapitre 3 : Résultats et discussions 37 3.1 Performance des modèles hydrologiques en calage et validation . . . 37

3.1.1 Impact de la saison. . . 39

3.1.2 Impact de la gamme de débit . . . 40

3.2 Évaluation de la qualité initiale de la prévision météorologique ECMWF . . 41

3.2.1 Fiabilité . . . 42

Fiabilité globale . . . 42

Impact de la saison et de la gamme de précipitation . . . 44

3.2.2 Performance générale . . . 47

Performance globale . . . 47

Impact de la saison et de la gamme de précipitation . . . 47

3.3 Performance de la prévision du débit sans post-traitement météorologique . 48 3.3.1 Fiabilité . . . 49

Fiabilité globale . . . 49

Impact de la saison et de la gamme de débit. . . 52

3.3.2 Performance générale . . . 53

Performance globale . . . 53

Impact de la saison et de la gamme de débit. . . 53

3.4 Synthèse sur l’évaluation du système . . . 54

3.5 Évaluation de la qualité des prévisions de précipitation après post-traitement météorologique . . . 55

3.5.1 Effets de la correction sur la fiabilité . . . 57

3.5.2 Effets de la correction sur la performance générale . . . 57

3.5.3 Comparaison entre les approches de post-traitement (Gain) . . . 57

3.6 Effets du post-traitement de la précipitation sur la prévision du débit . . . 62

3.6.1 Effets de la correction sur la fiabilité . . . 62

3.6.2 Effets de la correction sur la performance générale . . . 64

3.6.3 Synthèse de l’effet d’un post-traitement météorologique . . . 67

Conclusion 71

Liste des tableaux

2.1 Caractéristiques physiques des sous-bassins versants étudiés.. . . 13

2.2 Caractéristiques hydroclimatiques des bassins versants étudiés (1985 à 2017). Les dé-bits ont été convertis en mm pour être en accord avec les unités que les modèles

fonctionnent. . . 15

2.3 Principales caractéristiques des 20 modèles (Thiboult et al., 2018) . . . 17

2.4 Hyperparamètres utilisés dans l’assimilation de données. Les perturbations de la pré-cipitation et du débit sont proportionnelles à leurs valeurs, et pour la température est

une constante. . . 19

Liste des figures

1.1 Illustration de la technique ESP. (Image modifiée de l’original publié par le

COMET MetEd, MOOC : An introduction to ensemble streamflow prediction). 4

1.2 Illustration de la sensibilité de l’atmosphère aux conditions ninitiales. Deux membres qui sont très proches au début peuvent s’éloigner complètement au cours de la

prévi-sion. (Image modifiée de l’original publié par le Met Office, visité le 23 juin 2018). . . 5

1.3 Prévision d’ensemble. (Image modifiée de l’original publié par le Met Office, visité le 26 juillet 2018). . . 5

1.4 (a) Ensemble fiable. (b) Un ensemble sous-dispersif qui ne fournit par une bonne estimation de l’erreur. 𝑚𝑖 est l’ième membre, 𝑚 est la moyenne de l’ensemblē et X est la dispersion. . . 6

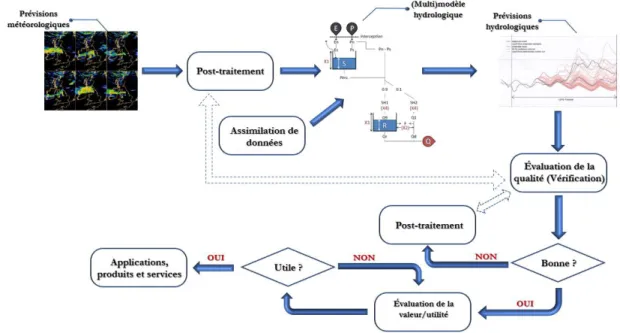

1.5 Principaux éléments d’une chaîne de prévision hydrométéorologique. Figure adaptée de Zalachori (2013).. . . 8

1.6 Chaîne de prévision hydrométéorologique utilisée. . . 10

2.1 Localisation du bassin versant de la rivière Gatineau. . . 12

2.2 Occupation des sols du bassin versant de la rivière Gatineau. . . 13

2.3 Sous-bassins, topographie, centrales hydroélectriques et régimes hydrométéorologiques du bassin de la rivière Gatineau. . . 14

2.4 Étapes de la méthode Shuffled Complex Evolution. Modifié à partir de Duan et al. (1993) . . . 18

2.5 Flux post-traitement statistique (modifié de Li et al. (2017)). Les valeurs des prévisions et des observations historiques sont utilisées pour gérer leur distribution conjointe à partir d’un modèle statistique. Avec cette distribution conjointe 𝑝(𝑦, 𝑓) et des informations fournies par la prévision en temps réel (𝑝(𝑓)), on obtient la distribution de probabilité prédictive qui corrige les prévisions brutes. . . 20

2.6 Étapes de la méthode CSGD. . . 23

2.7 Schéma du processus DBS . . . 27

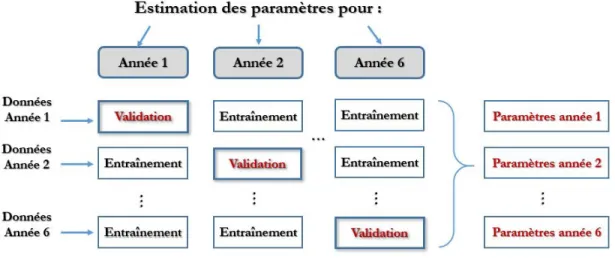

2.8 Schéma de l’approche ‘leave-one-out’ pour l’entraînement et validation des post-traitements. . . 29

2.9 Fenêtre mobile de longueur égale à 3 . . . 29

2.10 (a) Illustration du diagramme de fiabilité. (b) MAE du diagramme. . . 31

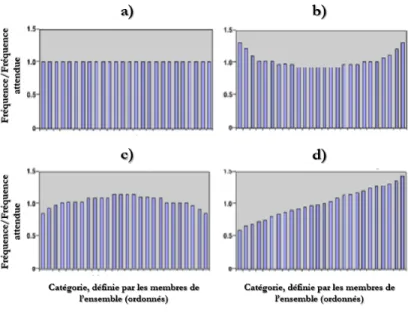

2.11 Diagramme de Talagrand. a) Système bien calibré. b) Sous-dispersion dans le sys-tème. c) Surdispersion dans le syssys-tème. d) Présence de biais. Source : tirée du MOOC Introduction to Verification of Hydrologic Forecast. . . 32

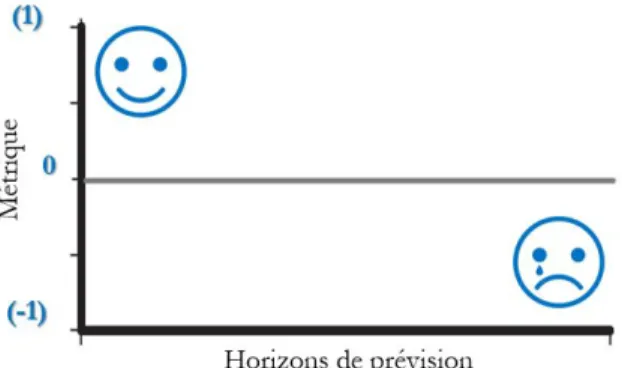

2.12 (a) Illustration du CRPS. . . 33

2.13 Représentation graphique du gain. Des valeurs supérieures à zéro indiquent que le système a de meilleures performances que la référence.. . . 34

2.14 Outils utilisés à chaque étape du processus de prévision de débit. . . 36

3.1 Performance des 20 modèles hydrologiques durant les périodes de calage et de validation. Durant la période de validation, les modèles bénéficient de l’assi-milation des données de débits par l’EnKF. Les points pleins représentent la

performance de la combinaison des 20 modèles. . . 38

3.2 Régime hydrologique pour les bassins versants Baskatong et Cabonga durant la période de validation. La zone grisée correspond à la variabilité des régimes

simulés par les 20 modèles. . . 39

3.3 Performance des 20 modèles en fonction de la saison de l’année. . . 40

3.4 Performance des 20 modèles en fonction de la gamme de débit. . . 41

3.5 Diagramme de Talagrand pour les prévisions d’ensemble du ECMWF sur les

cinq sous bassins de l’étude au 1e jour de prévision. . . 42

3.6 Diagramme de Talagrand pour les prévisions d’ensemble du ECMWF sur les 5

sous bassins de l’étude à un horizon de neuf jours. . . 43

3.7 Diagrammes de fiabilité de la prévison d’ensemble du ECMWF des 5 sous

bassins de l’étude pour les horizons 1, 3, 6 et 9, plus le MAEdf. . . 44

3.8 Graphique “précision-dispersion” des prévision du ECMWF pour les bassins

de l’étude. . . 45

3.9 Impact de la saison et de la gamme de débits sur la fiabilité des prévisions de

précipitation. . . 46

3.10 MAEdf du bassin Chelsea pour les saisons d’été et d’hiver et les différents seuils. 47

3.11 MCRPS des bassins de l’étude des prévision du ECMWF. . . 48

3.12 Impact de la saison et de la gamme de précipitation sur la précision des prévisions 49

3.13 Fonction de distribution cumulative de la prévision du ECMWF pour le bassin

Baskatong. au 9e jour de prévision . . . 50

3.14 Diagramme de Talagrand de la prévision du débit à l’horizon de prévision un

jour. . . 51

3.15 Diagramme de fiabilité de la prévision du débit pour des horizons 1, 3, 6 et 9 et pour les 5 bassins versants, ainsi que le MAE du diagramme de fiabilité pour

tous les horizons de prévision. . . 52

3.16 Impact de la saison et de la gamme de débit sur la fiabilité de la prévision . . . 54

3.17 Performance générale du système de prévision du débit pour les cinq bassins

versants étudiés. . . 55

3.18 Impact de la saison et de la gamme de débits sur la précision de la prévision

du débit. . . 56

3.19 Diagramme de Talagrand de la prévision de la précipitation corrigée par la

méthode CSGD à l’horizon de prévision un jour. . . 58

3.20 Graphique “précision-dispersion” de la prévision ECMWF corrigée par la

mé-thode CSGD pour les bassins étudiés. . . 59

3.21 Diagramme de Talagrand de la prévision de la précipitation corrigée par la

méthode DBS à l’horizon de prévision un jour. . . 60

3.22 Graphique “précision-dispersion” de la prévision ECMWF corrigée par la

mé-thode DBS pour les bassins étudiés. . . 61

3.23 Gain de fiabilité de la précipitation obtenu par post-traitement. . . 62

3.24 Gain de fiabilité de la précipitation obtenu par post-traitement, pour le bassin

3.25 Diagramme de fiabilité des prévisions de précipitation brutes et corrigées par

la méthode CSGD dans le 9e jour de prévision et pour les bassins étudiés. . . . 64

3.26 Gain dans la performance générale de la prévision de la précipitation obtenu

par post-traitement. . . 65

3.27 Gain dans la performance générale de la prévision de la précipitation obtenu

par post-traitement, pour le bassin versant Chelsea. . . 66

3.28 Gain de fiabilité de la prévision du débit obtenu par post-traitement

météoro-logique. . . 67

3.29 Impact de la saison et de la gamme de débit sur le gain de fiabilité de la

prévision du débit obtenu par post-traitement météorologique. . . 68

3.30 Gain dans la performance permis par le post-traitement des prévisions

météo-rologiques.. . . 69

3.31 Gain dans la performance générale de la prévision du débit obtenu par

Remerciements

Je veux remercier Dieu pour chacune des bénédictions qu’il a placées dans ma vie. Ce furent des années de dur labeur, sans repos, loin de ma terre et de ma famille, mais à chaque instant, je voyais sa faveur sur moi. Sans sa volonté, rien de tout n’aurait été possible.

Le chemin parcouru jusqu’à ici, je le définis comme une fonction sinusoïdale. Je suis arrivée sans aucune connaissance préalable du domaine d’étude et avec la difficulté à communiquer en raison de la langue, mais grâce à l’aide de plusieurs personnes qui m’ont accueillies et guidés, j’ai pu réussir. Je profite de cet espace personnel pour les remercier.

Avant tout, je tiens à remercier mon directeur de recherche François Anctil qui m’a guidée pendant ces deux années de maîtrise. Merci d’être si patient avec moi, si généreux, de votre volonté de toujours m’aider et de me recevoir avec un sourire chaque fois que je suis allée vous consulter. Je me rappelle que j’entrais toujours à votre bureau très stressée et vos paroles et vos conseils me détendaient aussitôt. Je me rappellerai toujours ce que vous me disiez lorsqu’un problème se présentait : “écoute, ce n’est pas grave, il y a toujours une solution”. Vos étudiants et moi nous sentons heureux de vous avoir comme directeur, vous êtes une personne digne d’admiration. Merci beaucoup !

Dans nos vies arrivent des personnes qui marquent un avant et un après. Caine Poncelet est l’une d’elles. Au début je sentait une admiration professionnelle (tu es réellement excellente), mais à mesure que nous partageons j’ai pu observer ta valeur comme personne. Merci pour tous tes conseils, d’être toujours patiente avec moi, d’être intéressée de mon progrès, et prendre des heures de ton temps pour m’aider même si tu avais des choses plus importantes à faire. Tu m’as aussi formée pendant ces deux années. C’est incroyable comment tu savais si mon “je vais bien” c’était certain ou non et tirer bien que c’était 5 minutes de ton temps pour une “pause - café” et m’écouter. Je me souviendrai du “Mme Valdez”, en fait, je me souviendrai de tout ! Merci pour donner tant sans attendre rien en échange. Tu es incroyable !

Je tiens également à remercier Antoine Thiboult pour sa patience et ses explications concer-nant les prévisions. Pour toujours répondre à chacune de mes questions et le faire avec beau-coup de plaisir. Antoine, tu sais que je t’admire beaubeau-coup. Tu es très spécial pour moi.

Merci à M. Brian Morse et à M. Daniel Nadeau qui ont accepté gentilement d’évaluer mon travail. Brian, merci de partager vos connaissances et d’avoir rendu le cours d’hydraulique fluviale très intéressant et amusant (je n’oublierai jamais cet examen final !). Daniel, je vous remercie beaucoup de m’avoir permis de suivre des cours d’hydrologie même s’il y avait plus de 80 élèves en classe. Merci à vous deux pour votre aide durant ces deux années, je me sens vraiment privilégiée.

Mes remerciements vont aussi à tous ceux qui j’ai eu l’occasion de connaître et de partager à l’Université Laval et qui ont rendu mes journées plus agréables : Madiha, Gonzalo, Philippe, Achut, Stéphanie, Annie-Claude, Sisouvanh, Guillaume et Mabrouk.

Merci à l’Organisation des États américains (OEA) pour la généreuse bourse qui m’a permis de réaliser l’un de mes objectifs. Je tiens également à remercier Mme Paulina Savage de Laspau pour son suivi et ses soins durant la dernière année de mes études de maîtrise. No puedo dejar de agradecer el ser más importante en mi vida, mi padre. Gracias papi por siempre estar ahí para mí, por cuidarme, por sacrificarte para darnos lo mejor. Eres mi mayor orgullo y ejemplo de perseverancia y dedicación. Te amo.

También quiero agradecer a mis tías que han sido como madres para mí : Miladys, Laura, Lissandra, Juana y Nimia. Gracias por demostrame con hechos su amor.

Igual agradezco al resto de mi familia por todo el apoyo que me brindaron aún en la distancia, en especial a mis hermanos.

Gracias a la Ing. Lidibert González por compartir todos sus conocimientos e inspirarme a seguir sus pasos de estudiar ingeniería de aguas.

Merci à mon ami Enmanuel Rodríguez pour son soutien inconditionnel, pour ses paroles d’encouragement, pour m’avoir donné de la force et de la motivation quand j’ai pensé que tout allait de travers. Merci, de toujours prendre soin de moi.

Merci à ma meilleure amie Ana Celia pour tout son soutien, même à six heures d’intervalle. Merci pour ces longues vidéos appelées juste pour se faire mutuellement compagnie pendant que nous étudiions.

Introduction

1.1

Mise en contexte

1.1.1 Enjeux de la prévision des débits

Sur notre planète, près d’un milliard de personnes vivent dans des zones inondables (Di Bal-dassarre et al.,2013). Ces zones sont définies comme étant périodiquement touchées par les débordements latéraux des rivières lors d’une crue. L’établissement dans ces territoires à risques est hérité des anciennes générations, comme les Égyptiens qui profitaient des eaux du Nil pour mener leurs activités agricoles. En effet, ces zones offrent des conditions favo-rables pour plusieurs activités humaines importantes telles que le commerce, l’agriculture, l’eau potable, et le développement économique. Néanmoins, l’installation humaine modifie la dynamique des plaines inondables ainsi que la fréquence et l’intensité des inondations. Afin de minimiser ce risque et réduire la vulnérabilité aux événements extrêmes, les sociétés se sont toujours efforcées de prendre diverses mesures : des digues, des barrages de contrôle et des systèmes d’alerte précoce. Ces derniers permettent d’anticiper l’arrivée des événements de crues et d’inondations pour se préparer et faire face à leur sévérité. De cette façon, les pertes humaines et les dégâts matériels sont réduits. Par exemple, au Québec, l’année 1996 repré-sente la naissance du système de prévision des débits et niveaux d’eau qui opère actuellement, depuis les inondations exceptionnelles de plusieurs régions da la province.

Un système d’alerte précoce est généralement alimenté par un système de prévision hydro-logique (l’estimation des phénomènes hydrohydro-logiques futurs). Ces prévisions permettent non seulement l’atténuation des catastrophes naturelles (inondations et sécheresses), mais aussi d’avoir une meilleure gestion des ressources en eau, dans le domaine de l’agriculture, de la production d’énergie, de l’approvisionnement en eau, de la navigation, etc. Chacun de ces usages a besoin des prévisions à des échelles temporelles différentes. Par exemple, pour avoir le temps d’intervenir face un événements extrême, il faut utiliser des prévisions à moyen terme (3 -10 jours en avance), alors que pour mieux utiliser l’eau et anticiper les phénomènes de

sécheresse, une prévision à long terme (plus 10 jours) est idéale. Il faut donc avoir un système qui répond à trois caractéristiques : 1) des prévisions efficaces, 2) une correcte interprétation de ces prévisions et 3) une communication des alertes.

La prise en compte des incertitudes est fondamentale pour quantifier le risque associé à la prévision. Pour ce faire, il faut faire appel aux systèmes de prévision hydrologique d’ensemble qui produisent des prévisions sous forme probabiliste ou à scénarios multiples. Ce mémoire s’intéresse à ces prévisions. Plus de détails seront fournis dans les sections suivantes.

1.1.2 Bref aperçu historique des prévisions météorologiques et hydrologiques

La prévision météorologique remonte à l’Antiquité, comme le cas des Babyloniens qui prédi-saient le temps à court terme à partir de la présence de nuages et de phénomènes optiques tels que les halos (650 av. J.-C.). 350 années plus tard, Aristote écrivait sur le comportement de l’atmosphère et les phénomènes qui y sont liés. Compilé dans un traité de quatre volumes nommé Meteorologica, ce document a été l’autorité de la théorie de la météorologie pendant près 2000 ans, jusqu’à ce que certaines idées erronées du philosophe soient renversées. Avec la nouvelle conception de l’homme et du monde qui a surgi avec la Renaissance, les spécula-tions des philosophes étaient insuffisantes pour approfondir la compréhension de la nature de l’atmosphère. En fonction de ces besoins, différents instruments ont été créés pour mesurer les propriétés des gaz atmosphériques (hygromètre, thermomètre, baromètre).

Avec l’invention d’autres technologies observationnelles et du télégraphe, les individus à des endroits dispersés ont commencé à faire, enregistrer et partager des mesures atmosphériques. À partir de ces données, des cartes météorologiques brutes ont été établies et les régimes de vents de surface et les systèmes de tempêtes ont pu être identifiés et étudiés. Les stations d’observation météorologique sont devenues courantes un peu partout dans le monde, menant finalement à la naissance de la prévision météorologique synoptique dans les années 1860 et à la formation de réseaux d’observations météorologiques régionaux et mondiaux aux XIXe et XXe siècles. Une grande avancée s’est produite en 1920 avec l’invention de la radiosonde qui a permis le suivi de l’atmosphère jusqu’en haute altitude.

En parallèle à ces événements, les concepts de la prévision numérique ont été développés en résolvant des équations mathématiques. Le premier à formuler un ensemble d’équations décrivant l’évolution de l’atmosphère a été Vilhelm Bjerknes en 1904. Ces équations ont été implémentées par le mathématicien britannique Fry Richardson, qui malgré de laborieux mois de travail, n’a pu obtenir qu’une prévision de six heures très imprécise et incertaine. Après quelques années d’étude, en 1922 Richardson a conclu que c’était nécessaire d’avoir 64,000 personnes calculant des équations simultanément pour émettre une prévision, étant donné les

limitations informatiques de l’époque.

Avec l’apparition des premiers ordinateurs modernes à la fin de 1940, des progrès significatifs ont été réalisés en matière de prévisions météorologiques numériques. En 1950, avec de nou-veaux ordinateurs, des équations mathématiques modifiées et des mesures par satellite, des prévisions numériques ont été émises de manière régulière. Malgré les avancées technologiques, ces modèles restent cependant encore imparfaits1.

Quant à la prévision hydrologique, différentes techniques ont aidé les hydrologues à mieux comprendre le comportement des rivières, telles que l’analyse de fréquence des inondations, l’analyse de la durée de débits, des valeurs statistiques (moyenne, médiane, maximum, etc.) et l’analyse des séries (tendance, périodicité, etc.). Néanmoins, ces techniques ne constituent pas des outils de prévision en soi. La date exacte de la première prévision hydrologique n’est pas claire, mais nous savons que dès les années 1960, des chercheurs ont pu effectuer des prévisions mensuelles et saisonnières grâce aux grandes avancées informatiques réalisées à l’époque. La décennie des années 1970 a été une période de grands défis et d’expérimenta-tions pour l’hydrologie aux États-Unis, en raison de la grande sécheresse des années 1976-77 dans la partie occidentale du pays. Dans le but d’améliorer la gestion de l’eau pour les années suivantes, le service météorologique, des États-Unis a développé ce que nous connaissons au-jourd’hui comme le “Ensemble Streamflow Prediction” (ESP) (Day, 1985). Cette technique est largement utilisée de nos jours pour la prévision opérationnelle à long terme. Elle se base sur les observations passées pour ajuster le modèle jusqu’au moment de faire la prévision, afin de refléter les conditions actuelles, puis utiliser plusieurs scénarios de données météoro-logiques historiques ou prévisionnelles/ climatiques comme entrées dans le modèle et obtenir des scénarios possibles de débit. La figure 1.1illustre un exemple d’ESP2.

1.1.3 Prévision météorologique d’ensemble

Une prévision météorologique est une estimation de l’état futur de l’atmosphère à partir d’un modèle numérique et d’observations de son état actuel (initial). Pendant les années 1960-80, les systèmes de prévision météorologique opérationnels étaient de nature déterministe, i.e. le modèle numérique était lancé avec la meilleure estimation des conditions initiales possibles en générant un scénario unique du temps futur. Cependant, cette prévision n’est fiable que pour une échéance très courte et est parfois inexacte. Cette limitation de la prévisibilité découle de trois sources fondamentales :

1. Les conditions initiales ne sont pas assez précises à cause de la mauvaise couverture et des erreurs liées aux mesures. Jusqu’au présent, il n’est pas possible d’avoir une image

1. Pour plus de détails sur l’histoire de la prévision météorologique, visitez le site web de laNASA. 2. Pour plus de détails sur l’origine de la technique ESP et leurs concepts , visitez les sites webHEPEXet

Figure 1.1 – Illustration de la technique ESP. (Image modifiée de l’original publié par le

COMET MetEd, MOOC : An introduction to ensemble streamflow prediction).

complète et d’observer chaque détail de l’état actuel de l’atmosphère. De plus, il existe aussi un petit délai entre le moment de l’observation et le moment où la prévision est effectuée, ce qui peut être important sachant que l’atmosphère est en constante évolution.

2. Les modèles numériques utilisés ne décrivent que de façon approximative l’évolution de l’atmosphère. Le comportement de cette dernière est gouverné par un ensemble de lois physiques et de processus dynamiques qui n’ont pas tous des solutions analytiques. Des méthodes numériques sophistiquées et des ordinateurs puissants sont donc requis. 3. L’atmosphère présente un comportement chaotique ou une sensibilité élevée aux

condi-tions initiales (Lorenz,1982), c’est-à-dire que de très petites erreurs dans la définition de l’état initial d’une variable conduisent souvent à de grandes erreurs dans son évolution au fil du temps. (Figure 1.2).

Comme solution à ce problème, au début des années 1990, le Service National de Prévision des États-Unis (NCEP) et le Centre européen de prévision météorologique à moyen terme (ECMWF, en anglais) ont commencé à mettre en œuvre des systèmes de prévision météo-rologique d’ensemble (Buizza and Palmer, 1995; Molteni et al., 1996; Buizza et al., 2007). De nos jours, c’est une technique adoptée par tous les grands centres de prévision ( Houte-kamer et al., 1996; Bouttier, 2010). Elle consiste à exécuter plusieurs fois le même modèle numérique à partir des perturbations de la meilleure estimation de la condition de départ. En échantillonnant l’incertitude des conditions initiales, une approximation de l’incertitude de la prévision elle même est produite, de même qu’une indication des événements météorologiques possibles. L’union de toutes les prévisions générées par les différentes exécutions du modèle numérique est appelée ensemble, et les prévisions individuelles y figurent en tant que membres (Figure1.3).

Figure 1.2 – Illustration de la sensibilité de l’atmosphère aux conditions ninitiales. Deux membres qui sont très proches au début peuvent s’éloigner complètement au cours de la prévision. (Image modifiée de l’original publié par leMet Office, visité le 23 juin 2018).

Figure 1.3 – Prévision d’ensemble. (Image modifiée de l’original publié par le Met Office, visité le 26 juillet 2018).

L’une des étapes les plus difficiles de la prévision d’ensemble est d’estimer l’incertitude liée aux conditions initiales, soit d’obtenir le meilleur jeu de conditions initiales permettant de générer un ensemble avec la bonne dispersion. L’idéal serait qu’en moyenne, la dispersion de l’ensemble soit semblable à la dispersion des erreurs de la prévision, sur une certaine période appelée période d’optimisation. La Figure1.4illustre un exemple d’un système où la dispersion englobe l’erreur d’ensemble (a) et un système sous-dispersif (b). Il est important de préciser que ce n’est pas un grand nombre de membres qui déterminent une bonne dispersion, mais plutôt que l’ensemble utilisé capture la plus grande variance d’erreur de prévision. Il y a plusieurs

techniques pour générer un jeu de conditions initiales (perturbations). La mise en œuvre varie d’une agence à l’autre, mais tous visent à bien représenter les erreurs de ces conditions. La différence entre les systèmes de prévision d’ensemble n’est pas seulement centrée sur la façon de perturber les conditions initiales, mais aussi sur la technique d’assimilation des données, la structure des modèles numériques, le nombre de membres et l’horizon (nombre de jours de prévision) (Buizza et al.,2005). Néanmoins, la plupart des systèmes de prévision sont conçus de manière à ce que chaque membre ait la même probabilité d’occurrence (échangeables, équiprobables).

Figure 1.4 – (a) Ensemble fiable. (b) Un ensemble sous-dispersif qui ne fournit par une bonne estimation de l’erreur. 𝑚𝑖 est l’ième membre, ̄𝑚 est la moyenne de l’ensemble et X est la dispersion.

De même, il existe aussi des techniques pour considérer les incertitudes liées aux imperfec-tions des modèles. Certaines d’entre elles consistent en des perturbaimperfec-tions stochastiques de la meilleure estimation du paramétrage physique (Houtekamer and Lefaivre, 1997; Buizza et al., 1999) et d’autres en la combinaison des prévisions de différents systèmes. De cette façon, les incertitudes liées aux conditions initiales, à la paramétrisation, à la structure et à l’assimilation des données sont quantifiées. Un exemple de ceci est la base de données TIGGE (THORPEX Interactive Grand Global Ensemble ; en anglais), qui est constituée de prévisions provenant de différents centres météorologiques et dont l’objectif est d’améliorer la précision des prévisions météorologiques pour la prise de décision et, par conséquent, de réduire les conséquences sociales d’événements météorologiques violents (Park et al., 2008; Bougeault et al.,2010).

En conclusion, les prévisions d’ensemble donnent au prévisionniste une bien meilleure idée des phénomènes météorologiques qui pourraient survenir à un moment précis. En comparant les différents membres, le prévisionniste peut constater la probabilité d’occurrence d’un

événe-ment météorologique particulier. Si les membres sont très dispersés, le prévisionniste sait que l’incertitude est grande. Si les membres sont regroupés, c’est la confiance dans la prévision émise qui sera grande.

1.1.4 Prévision hydrologique d’ensemble

Semblable à la prévision météorologique, la prévision hydrologique d’ensemble est la com-binaison de différents scénarios de la valeur future possible du débit, afin de représenter dynamiquement l’incertitude associée à chaque prévision. L’application initialement considé-rée consistait en l’utilisation de prévisions météorologiques d’ensemble comme seul forçage d’un modèle hydrologique, en générant ainsi un scénario de débit pour chaque membre mé-téorologique. Ces prévisions à moyen terme tiennent leur origine du début des années 2000, avec la création d’organisations comme HEPEX (Hydrological Ensemble Prediction Expe-riment, 2004) et EFAS (European Flood Awareness System, 2003) dont l’objectif commun est de prévenir et d’atténuer les catastrophes causées par des événements hydrométéorologiques extrêmes (Schaake et al.,2006;Thielen et al.,2009;Thirel,2009). Un grand nombre de sys-tèmes de prévision hydrologique d’ensemble a depuis été mis en place (Pappenberger et al.,

2016).

Différentes techniques ont été développées qui permettent de propager les incertitudes liées à chaque étape du processus de prévision hydrologique. Un exemple de ceci est l’assimilation des données et l’approche multimodèle où plusieurs scénarios peuvent être générés à partir des perturbations des conditions initiales et de l’utilisation de plusieurs modèles hydrologiques respectivement (Thiboult et al.,2016).

Bien qu’il n’existe pas un système de prévision parfait, il est nécessaire que celui-ci soit apte à quantifier explicitement ou implicitement chacune des sources d’incertitude, puisque ces prévisions constituent généralement l’entrée d’un modèle décisionnel ou de gestion. Une approche ensembliste permet aux gestionnaires de prendre leurs propres décisions en fonction de leur expérience, ce qu’une valeur unique (prévision déterministe) ne permet pas de faire explicitement (Weerts et al.,2010). Pour cette raison, plusieurs aspects doivent être pris en compte au sein d’un système de prévision hydrométéorologique d’ensemble. La Figure 1.5

illustre une chaîne de modélisation qui inclut les principales sources d’erreurs. La meilleure façon de quantifier l’incertitude fait cependant toujours l’objet de discussions, et il est rare que toutes ces étapes soient incluses dans les systèmes opérationnels, en raison de la demande de temps de calculs et de la capacité de stockage. Il faut aussi considérer que pour chacune de ces étapes, il existe un nombre considérable de techniques et de combinaisons possibles. Tester chacune d’elles ne serait pas une tâche facile compte tenu de la variabilité des performances d’un bassin à l’autre. En pratique, il faut aussi prendre en compte la façon de communiquer ces incertitudes afin de répondre aux besoins des utilisateurs finaux (Ramos et al.,2010).

De nombreux travaux ont été réalisés ces dernières années qui confirment la valeur ajoutée de l’utilisation d’une prévision hydrologique d’ensemble au sein d’un système de prise de décisions (Pappenberger et al.,2008;Buizza,2008;Thirel et al.,2008;Marsigli et al.,2008;

Velázquez et al.,2009;Ramos et al.,2010;Verkade and Werner,2011;Boucher et al.,2012). Une prévision fiable et précise permet d’alerter les utilisateurs/décideurs des probabilités d’un aléa dans une zone à risque.

Figure 1.5 – Principaux éléments d’une chaîne de prévision hydrométéorologique. Figure adaptée de Zalachori (2013).

1.2

Définition de la problématique

Les sections précédentes démontrent que la prévision est intrinsèquement incertaine. Au fil des années, différentes techniques ont été développées et implémentées pour représenter dyna-miquement les erreurs et incertitudes qui se propagent tout au long de la chaîne de prévision hydrométéorologique. L’un de ces outils est la prévision météorologique d’ensemble qui quan-tifie l’incertitude associée à la condition future des forçages des modèles hydrologiques (Cloke and Pappenberger,2009;Brochero et al.,2011;Verkade et al.,2013;Thiboult et al.,2016). En outre, elles permettent d’étendre les horizons de prévision au-delà de la limite de prévisibilité des systèmes déterministes (à un scénario unique). Avoir un horizon plus lointain augmente le temps de préparation des utilisateurs face à l’occurrence éventuelle d’un événement extrême. Malgré les constantes améliorations des systèmes de prévision météorologique d’ensemble, leurs prévisions sont souvent entachées des biais et d’une sous- ou sur- dispersion de

l’en-semble, ce qui affecte la prise de décision. L’une des raisons est la compensation qui existe entre le nombre de membres et la résolution de la prévision (Buizza,2002). La prévision d’en-semble possède une résolution plus faible que la prévision déterministe, car il est impossible (jusqu’à maintenant) de générer une prévision d’ensemble météorologique à une résolution aussi élevée que sa contrepartie déterministe tout en respectant les délais opérationnels. De plus, les processus atmosphériques à grande échelle ne sont pas inclus dans les prévisions météorologiques d’ensemble et leur grande taille de grille ne permet pas de répercuter toutes les améliorations météorologiques au niveau de la prévision du débit.

Ces problèmes sont hérités par la prévision hydrologique en raison de la sensibilité de ces modèles aux forçages. Une solution à cette problématique consiste à faire un pré (avant la modélisation hydrologique) et un post-traitement statistique qui visent à améliorer la qualité des prévisions météorologiques et hydrologiques. Certains prévisionnistes considèrent qu’il est obligatoire de mettre en œuvre ces techniques de correction avant de fournir des prévisions aux utilisateurs. Néanmoins survient le doute sur la réalisation ou non d’un pré-traitement dans un système de prévision qui prend en compte les principales sources d’incertitude. L’in-quiétude survient du fait que faire une telle correction ajoute un coût au système et pourrait ne pas se traduire par une amélioration substantielle du résultat final. De l’autre côté, une quantification de “toutes” les incertitudes peut entraîner un ensemble de taille peu compatible avec les opérations. À partir de cela, un dilemme surgit : travailler avec un nombre limité de membres corrigés par un (pré)post-traitement ou considérer différents scénarios pour chaque type d’incertitude.

Plusieurs travaux ont étudié l’effet d’un post-traitement météorologique sur les prévisions de débit, mais destinés à une comparaison entre “pré- vs post-” traitement (Kang et al.,2010;

Zalachori et al.,2012;Verkade et al.,2013;Roulin and Vannitsem,2015;Abaza et al.,2017a). Jusqu’à présent, l’interaction entre une correction météorologique et la quantification totale des incertitudes n’a pas été prise en compte.

1.3

Objectif et questions de recherche

Le problème décrit précédemment évoque l’objectif principal de la présente étude, soit de

déterminer si une amélioration des prévisions météorologiques mène une prévision hydrologique plus fiable lorsqu’issue d’une chaîne de modélisation qui quantifie toutes les sources d’incertitudes.

De cet objectif découlent les questions suivantes :

1. Vaut-il la peine de faire une telle correction dans un système qui quantifie les principales sources d’incertitude ?

2. Toute amélioration des prévisions météorologiques se propage-t-elle nécessairement à la prévision de débit ?

3. Un post-traitement météorologique est-il suffisant pour atteindre une performance op-timale dans la prévision hydrologique ?

4. Dans quel cas est-il judicieux de réaliser un post-traitement ?

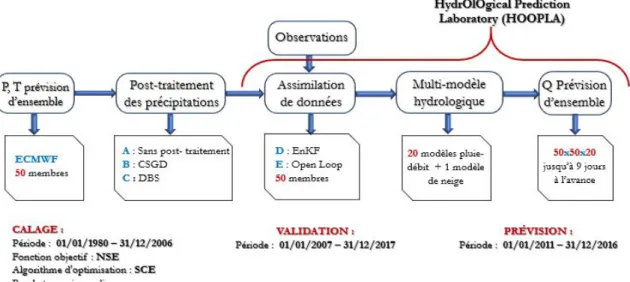

Pour répondre à ces questions et à l’objectif de ce travail, plusieurs scénarios ont été générés à partir d’une chaîne de prévision qui prend en compte les incertitudes associées aux forçages, aux conditions initiales et aux structures des modèles hydrologiques, de même que deux méthodologies de post-traitement météorologique de complexités différentes (Figure1.6). Ces scénarios seront détaillés à la section 2.

Figure 1.6 – Chaîne de prévision hydrométéorologique utilisée.

1.4

Plan du mémoire

Ce mémoire s’articule en quatre chapitres, incluant la présente introduction. Le chapitre 2 décrit les données, les modèles hydrologiques utilisés, les critères d’évaluation des prévisions, et les étapes méthodologiques spécifiques à ce projet de recherche. Le chapitre 3 est consacré à la présentation et la discussion des résultats. Finalement, une conclusion, qui reprend les objectifs et principaux résultats de ce travail et qui propose des perspectives de recherche, est présentée au chapitre 4.

Chapitre 2 : Aspects méthodologiques

et données

Ce chapitre décrit en détail chacune des étapes qui constituent la chaîne présentée à la figure

1.6, les bassins versants de l’étude et leurs séries de données. Les outils utilisés pour évaluer la qualité de la prévision et les approches pour la sélection des périodes de calage et validation, tant pour les modèles hydrologiques que pour l’obtention des paramètres des méthodes de correction, sont également fournis.

2.1

Bassins versants de l’étude

Dans le cadre de ce travail, l’analyse porte sur le bassin versant de la rivière Gatineau, au sud du Québec (figure 2.1). Cette rivière commence sa trajectoire dans le lac du Pain de Sucre (47∘ 52 54N, 75∘ 30 43W) et parcoure à peu près 400 km avant de finalement se jeter dans la rivière des Outaouais. Elle draine une vaste surface de 23, 838 km2. Les occupations des sols prédominantes correspondent à des bois mélangés, des conifères, des arbustes et des surfaces d’eau (figure 2.2), (Landscapes of Canada Working Group,2010).

Ce bassin appartient à la région hydrographique de l’Outaouais et Montréal dont le climat prédominant est de type continental humide (Dfb selon la classification de Köppen), soit des températures moyennes entre 22∘C et 10∘C pour le mois le plus chaud. En hiver, la zone est généralement humide, froide et couverte de neige, avec une température moyenne inférieure à -3 ∘C pour le mois le plus froid (Kottek et al. (2006)). Le régime hydrologique est dominé par des écoulements forts liés à la fonte de neige, avec un maximum de débit au printemps et au début de l’été, et une deuxième période propice aux crues à l’automne, liée à la pluie. Ce système hydrologique est fortement influencé par des activités anthropiques à cause de la présence d’un grand nombre de barrages de petite, moyenne ou forte contenance, dont les fonctions consistent en la production d’énergie, le contrôle des inondations, l’irrigation, la

Figure 2.1 – Localisation du bassin versant de la rivière Gatineau.

faune, la pisciculture et la récréation.

La zone d’étude a un rôle économique très important, car c’est un bassin avec un grand intérêt pour la production d’énergie électrique. Partant de ce fait, le bassin de la Gatineau a été divisé en cinq sous-basins dont les apports alimentent les réservoirs des barrages gérés par Hydro-Québec, comme illustré à la figure 2.3. Les caractéristiques physiques de ces bassins sont regroupées au tableau2.1. Nous nous intéressons spécifiquement aux prévisions des débits d’apport aux réservoirs, puisque celles-ci seront utilisées en tant qu’entrées dans un système de gestion des barrages (dans le cadre d’un projet mené par une autre étudiante). Dans le sous-bassin Maniwaki, il n’y a pas de centrale hydroélectrique, cependant, la zone est caractérisée par une histoire des événements extrêmes comme la crue de 1974, où le niveau d’eau augmentait de 3 à 6 pouces par heure1. La figure2.1fait ressortir ce qui précède, car il y a une concentration de barrages dans cette zone qui sont utilisés comme stratégie de contrôle des crues.

Le bassin versant de la Gatineau a déjà fait l’objet de plusieurs études. Boucher (2011) a

Figure 2.2 – Occupation des sols du bassin versant de la rivière Gatineau.

Table 2.1 – Caractéristiques physiques des sous-bassins versants étudiés.

Nom Bassin Surface Surface

réservoir Latitude Longitude

Altitude min. Altitude max. (km2) (km2) (degrés décimaux) (m) (m) Cabonga 2664.5 426.4 47.20931 -76.59722 351 610 Baskatong 13056.7 315.7 47.20985 -75.95149 204 771 Maniwaki 4145.4 0 46.52785 -76.25121 158 563 Paugan 2789.6 35.2 46.06846 -76.13251 133 505 Chelsea 1142.0 10.4 45.70477 -76.01448 93 478

déterminé la valeur des prévisions d’ensemble pour la gestion des ouvrages de production hydroélectrique, Movahedinia (2014) a quantifié l’impact des incertitudes hydrologiques et climatiques sur la production d’énergie et Pina et al. (2016) ont comparé des approches verticales et horizontales pour évaluer les impacts du changement climatique sur les ressources en eau.

2.2

Données observées

Les séries temporelles des observations s’étendent sur une période de 68 ans, entre le 01-jan-1950 et le 31-déc-2017. Ces observations comprennent des séries journalières des débits

Figure 2.3 – Sous-bassins, topographie, centrales hydroélectriques et régimes hydrométéorologiques du bassin de la rivière Gatineau.

d’apport aux réservoirs (𝑚3/𝑠), des températures minimales et maximales de l’air (∘C) et des précipitations liquides et solides (mm). Ces séries ont été fournies par Hydro-Québec et constituent la base de données opérationnelle de cette entreprise. Les valeurs des variables météorologiques ont été créées en appliquant le krigeage aux observations recueillies dans la zone d’étude, tandis que les apports sont des débits reconstitués à partir des mesures du niveau d’eau des réservoirs et d’une courbe de tarage. Cette méthodologie est typiquement assez imprécise pour de grands lacs, où de légères différences dans les mesures du niveau d’eau entraînent de grandes variations dans le débit estimé, sans compter les oscillations (seiches) occasionnées par le passage des systèmes météorologiques et par les fluctuations du vent qui augmentent le niveau d’eau près des berges. Dans de tels cas, la prévision est vérifiée par rapport à une valeur de référence entachée d’erreurs, avec des conséquences imprévisibles pour les résultats de la vérification.

Afin d’éviter des biais ou une variabilité accrue dans les résultats de la vérification, les 35 premières années des séries ont été éliminées en raison du grand nombre de valeurs manquantes du débit. Ainsi, la période utilisée pour l’étude est limitée à 33 ans. Les valeurs mensuelles illustrées à la figure 2.3 et détaillées au tableau 2.2 ont été calculées en s’appuyant de cette dernière période.

Conjointement avec la précipitation, l’évapotranspiration potentielle (ETP) alimente les mo-dèles hydrologiques. L’ETP est calculée à partir des données de température et du rayonne-ment extraterrestre en utilisant la formule d’Oudin et al. (2005).

Table 2.2 –Caractéristiques hydroclimatiques des bassins versants étudiés (1985 à 2017). Les débits ont été convertis en mm pour être en accord avec les unités que les modèles fonctionnent.

Nom Bassin Pt [solide] (mm) Q (mm) Tmax (∘C) Tmin (∘C)

Cabonga 977 [253] 1.35 8.7 -3.2

Baskatong 1031 [263] 1.49 8.3 -3.8

Maniwaki 961 [224] 1.24 9.9 -2.1

Paugan 972 [228] 1.29 10.4 -1.3

Chelsea 982 [223] 1.36 10.9 -0.5

2.3

Données des prévisions météorologiques

Les données de prévision météorologique (précipitation et témperature) d’ensemble du Centre Européen pour les Prévisions Météorologiques à Moyen Terme (ECMWF) ont été utlisées pour alimenter les modèles hydrologiques et générer les prévisions de débit. Elles ont été extraites de la base des données TIGGE et s’étendent sur la période 2011 à 2016.

La prévision d’ensemble du ECMWF est émise deux fois par jour (à 00h et à 12h UTC) en utilisant une grille gaussienne réduite transformée au système latitude-longitude lors de l’ex-traction TIGGE par interpolation bilinéaire. L’ensemble est constitué d’un membre “contrôle” obtenu de la condition initiale non perturbée et de 50 membres générés à partir des perturba-tions de cette condition initiale à l’aide de la méthode des vecteurs singuliers (Buizza et al.,

2005). La représentation d’erreurs liées au modèle numérique est faite en ajoutant 2 schémas d’incertitude : un qui simule l’incertitude due aux paramétrisations de sous-grille et l’autre pour paramétriser un processus manquant et incertain (Berner et al.,2009;Leutbecher et al.,

2015).

Dans cette étude, l’ensemble utilisé correspond à celui émis à 12h UTC, constitué des 50 membres provenant des perturbations jusqu’à un horizon de 10 jours (réduit à 9 jours après la conversion à l’heure locale du Québec). La résolution spatiale originale de ces données est de 0.5∘ lon x 0.5∘ lat (N160 grille Gaussienne). Elle a été réduite à 0.1∘ (résolution type des données observées sur grille au Québec) lors de l’extraction TIGGE . Pour l’utilisation dans la modélisation globale, ces prévisions ont été agrégées à l’échelle du bassin versant : une seule valeur de prévision résultant de la moyenne des points de la grille situés à l’intérieur des limites de la zone d’étude.

2.4

Modélisation et prévision hydrologique

Tout le processus compris entre le calage des modèles hydrologique jusqu’à obtenir le débit de prévision, est réalisé à l’aide du logiciel HOOPLA (HydrOlOgical Prediction Laboratory) (Thiboult et al.,2018). HOOPLA est déjà disponible au public surGitHub.

2.4.1 Modèles hydrologiques et module de neige

L’utilisation de plusieurs modèles hydrologiques permet de quantifier l’incertitude liée au processus de transformation pluie-débit (paramètres, structure du modèle, etc.), en considé-rant que ceux-ci ne simulent qu’une approximation des phénomènes qu’ils représentent. Pour cette étude, les 20 modèles globaux conceptuels disponibles dans HOOPLA ont été utilisés. Ayant comme critères la parcimonie et la diversité (différents contextes, objectifs et structure),

Seiller et al.(2012) ont sélectionné ces modèles à partir d’une première sélection faite par Per-rin (2000). Le tableau 2.3 résume leurs principales caractéristiques et les modèles originaux à partir desquels elles ont été modifiées. Ils sont forcés avec des valeurs d’évapotranspiration potentielle (ETP) et précipitation journalières (pas de temps opérationnel d’Hydro-Québec). Pour prendre en compte l’influence de la neige, le modèle empirique CemaNeige développé parValéry(2010) a été utilisé. Ce modèle à deux paramètres estime la quantité d’eau issue de la fonte de la neige basée sur une approche degré-jours. Le modèle repose sur une discrétisa-tion spatiale du bassin en cinq bandes d’altitudes égales, auxquelles correspond une certaine quantité de précipitation. À partir des données de précipitation totale, de température et d’élévation, CemaNeige sépare la fraction de précipitation solide de la fraction liquide et la stocke dans un réservoir conceptuel (manteau neigeux) et détermine la lame de fonte écoulée qui sera ajoutée au modèle hydrologique.

Calage et validation des modèles hydrologiques

Les modèles hydrologiques conceptuels reposent sur un ensemble de paramètres qui dictent le fonctionnement de la représentation mathématique des différentes composantes ou fonctions du cycle hydrologique qu’ils cherchent à simuler. Ces paramètres ne peuvent pas être mesurés directement. Il est donc nécessaire de les ajuster pour obtenir une performance optimale. Ceci est fait par un processus de calage qui consiste à trouver le jeu de paramètres qui optimise une fonction coût qui minimise la distance entre la valeur observée et la valeur simulée par les modèles.

Le calage est exploité uniquement pour identifier les paramètres, et nous ne pouvons pas cataloguer comme satisfaisant un modèle basé sur la performance obtenue lors de cette étape.

Table 2.3 – Principales caractéristiques des 20 modèles (Thiboult et al.,2018)

Nom du modèle Nombre des

paramètres libres

Nombre de

réservoirs Inspiré de

HydroMod1 6 3 BUCKET (Thornthwaite and Mather(1955)) HydroMod2 9 2 CEQUEAU (Girard et al.(1972)) HydroMod3 6 3 CREC (Cormary and Guilbot(1973))

HydroMod4 6 3 GARDENIA (Thiéry(1982))

HydroMod5 4 2 GR4J (Perrin et al.(2003) )

HydroMod6 9 3 HBV (Bergström and Forsman(1973))

HydroMod7 6 5 HYMOD (Wagener et al.(2001))

HydroMod8 7 3 IHACRES (Jakeman et al.(1990)) HydroMod9 7 4 MARTINE (Mazenc et al.(1984)) HydroMod10 7 2 MOHYSE (Fortin and Turcotte(2006))

HydroMod11 6 4 MORDOR (Garçon(1999))

HydroMod12 10 7 NAM (Nielsen and Hansen(1973)) HydroMod13 8 4 PDM (Moore and Clarke(1981)) HydroMod14 9 5 SACRAMENTO (Burnash et al.(1973))

HydroMod15 8 3 SIMHYD (Chiew et al.(2002))

HydroMod16 8 3 SMAR (O’connell et al.(1970))

HydroMod17 7 4 TANK (Sugawara(1979))

HydroMod18 7 3 TOPMODEL (Beven et al.(1984)) HydroMod19 8 3 WAGENINGEN (Warmerdam and Kole(1997)) HydroMod20 8 4 XINANJIANG (Zhao et al.(1980)) Il faut aussi vérifier les modèles pour une période différente de celle utilisée lors du calage : une étape nommée validation. Pour mener à bien ces deux processus, la méthodologie Test Split-Sample (SST) proposée par Klemeš(1986) a été suivie. Cela consiste à diviser les séries disponibles en deux segments différents : un destiné au calage et un autre à validation. Les séries des données observées sont donc séparées comme suit : 1988-2006 pour le calage des modèles et 2007-2017 pour la validation. Les trois années précédentes sont destinées à chauffe (spin-up) des modèles.

Une des raisons pour laquelle la validation a été effectuée sur les données plus récentes, dans les dernières années, est que les données utilisées pour la validation doivent représenter une situation similaire àcelle de l’utilisation principale du modèle (Klemeš, 1986), soit, dans ce cas, la période pour laquelle la prévision sera effectuée.

Le 20 modèles ont été calés et validés en utilisant le Nash-Sutcliffe Efficiency comme fonction objectif, (Nash and Sutcliffe, 1970). Le NSE détermine l’amplitude relative de la variance résiduelle par rapport à la variance des données observées. Ce critère donne plus de poids aux larges erreurs qui sont généralement associé aux débits de crue (Seiller,2013). Leurs valeurs varient entre -∞ et 1, étant 1 la valeur optimale (lorsque le débit simulée (𝑄𝑠𝑖𝑚) est exactement égale au débit observée( 𝑄𝑜𝑏𝑠)). Des valeurs comprises entre 0.5 et 1 sont considérées comme acceptables. Par contre, si le critère est négatif, la moyenne des observations (𝑄𝑜𝑏𝑠) est un meilleur prédicteur. Le NSE est calculé comme indiqué à l’équation 2.1:

𝑁 𝑆𝐸 = 1 − ∑ 𝑁 𝑖=1(𝑄 𝑠𝑖𝑚 𝑖 − 𝑄𝑜𝑏𝑠𝑖 )2 ∑𝑁𝑖=1(𝑄𝑜𝑏𝑠 𝑖 − 𝑄 𝑜𝑏𝑠 )2 (2.1)

Où 𝑁 est le nombre de pas de temps utilisés pour chaque période et 𝑖 est le ième valeur simulée et observée.

Pour sa part, le Shuffled Complex Evolution (Duan et al., 1993, 1994) a été utilisé comme algorithme d’optimisation automatique. C’est une méthode robuste et largement utilisée dans le domaine de l’hydrologie pour résoudre des problèmes d’optimisation globale. Le concept principal de cette approche est de trouver une solution globale à partir d’un processus d’évo-lution géométrique, dans lequel la population est divisée en plusieurs communautés appelées complexes qui évoluent indépendamment en partageant leurs informations puis en formant de nouvelles communautés. Ceci est réalisé à travers un processus itératif comme indiqué dans le schéma de la figure 2.4.

Figure 2.4 – Étapes de la méthode Shuffled Complex Evolution. Modifié à partir deDuan et al.

(1993)

2.4.2 Schémas d’initialisation des modèles

Le filtre de Kalman d’ensemble (EnKF) est utilisé pour quantifier les incertitudes liées aux conditions initiales des modèles hydrologiques. L’EnKF est une technique sophistiquée d’as-similation de données séquentielle et probabiliste. Basée sur l’approche Bayesienne, cette méthode estime la fonction de répartition des états du modèle conditionnée par la distribu-tion des observadistribu-tions. Les incertitudes liées aux forçages sont prises en compte en utilisant des

perturbations stochastiques identiques, en générant un ensemble de 50 membres. Les hyper-paramètres (décrivant l’incertitude des entrées et sorties) correspondent à ceux de Thiboult et al. (2016) et sont résumés au tableau 2.4.

Table 2.4 – Hyperparamètres utilisés dans l’assimilation de données. Les perturbations de la préci-pitation et du débit sont proportionnelles à leurs valeurs, et pour la température est une constante.

Hyperparamètre Loi statistique Incertitude

Précipitation Gamma 50%

Témperature Normale 2 ∘C

Débit Normale 10%

L’EnKF est implémenté en deux étapes principales :

1. Une étape de propagation : les 50 scénarios de forçages sont propagés à travers le modèle pour générer 50 jeux de variables d’état. À partir de cet ensemble de variables d’état, la matrice de covariance des erreurs du modèle est calculée et utilisée pour calculer le gain de Kalman.

2. Une étape de correction : une fois que les observations sont disponibles, les variables d’état sont mises à jour à partir de la connaissance a priori des états (générés par l’étape de propagation), le gain de Kalman et l’inovation, c’est-à-dire la différence entre le débit observé et simulé. Le gain de Kalman est calculé à partir de la matrice de covariance des erreurs en fonction d’un coefficient de pondération qui sert aussi à mettre à jour les états du modèle. C’est la raison pour laquelle les hyperparamètres de l’assimilation influencent la performance (Thiboult and Anctil, 2015). Pour plus de détails sur les équations et sur la démarche du EnKF, se référer à Abaza et al.(2017b).

L’objectif de l’assimilation est de fournir les conditions initiales qui produiront les meilleures prévisions possibles du modèle. Si nous ne pouvons pas bien observer une variable, nous ne pouvons pas la prédire non plus !

2.5

Post-traitement statistique des prévisions de

précipitation

2.5.1 Particularités de la précipitation

La précipitation est l’une des principales sources d’incertitude dans une chaîne de prévision hydrométéorologique. Contrairement à d’autres variables météorologiques, la précipitation est difficile à prédire et à corriger puisque les champs de précipitations ont souvent une structure multiéchelle mal représentée par les modèles, en particulier sur les petites échelles. La

représentation des évènements locaux est difficile lorsque les mesures satellitaires ou les radars ne sont pas disponibles. Cela peut mener à des mauvaises performances lors de l’évaluation de la prévision, puisqu’elle est vérifiée par rapport à autre chose que la vérité. D’autres particularités de la précipitation incluent : (1) une distribution mixte (discrète et continue à la fois) bornée à zéro à une extrémité et souvent fortement asymétrique, ce qui rend sa représentation statistique beaucoup plus ardue ; (2) les erreurs des prévisions ne sont pas homogènes ; et (3) il est nécessaire d’avoir une base des données très longue pour représenter les évènements extrêmes (Scheuerer,2014;Scheuerer and Hamill,2015).

2.5.2 Pré-requis du post-traitement statistique

Le post-traitement est une option généralement appropriée aux systèmes des prévisions d’en-semble. Sa mise en œuvre permet de corriger les biais systématiques, d’ajuster la dispersion de l’ensemble et de quantifier l’incertitude non représentée par les données brutes, ajoutant ainsi de la valeur aux prévisions (WMO,2012). Fondamentalement, il s’agit de modèles statistiques qui relient les observations aux informations contenues dans les sorties directes des modèles de prévision (figure 2.5).

Figure 2.5 –Flux post-traitement statistique (modifié deLi et al.(2017)). Les valeurs des prévisions et des observations historiques sont utilisées pour gérer leur distribution conjointe à partir d’un modèle statistique. Avec cette distribution conjointe 𝑝(𝑦, 𝑓) et des informations fournies par la prévision en temps réel (𝑝(𝑓)), on obtient la distribution de probabilité prédictive qui corrige les prévisions brutes.

Le but d’un post-traitement est d’estimer la distribution conditionnelle prédictive de l’obser-vation 𝑦, étant donné la simulation du modèle 𝑓. Dit d’un autre point de vue, il cherche à minimiser la distance entre les distributions des observations 𝐹 (𝑜) et la distribution prédictive

des prévisions 𝐹 (𝑓). Un système parfait serait celui qui vérifie :

𝐹 (𝑜) = 𝐹 (𝑓) (2.2)

Cependant, l’obtention d’un tel système est une utopie. D’une part parce que la distribution des observations est une hypothèse et d’autre part la distribution prédictive des prévisions est généralement une estimation d’une loi de probabilité et pour certaines variables il est difficile de trouver une loi qui correspond bien.

Pour mieux comprendre le principe sur lequel repose un post-traitement statistique, il est nécessaire de connaître le concept de distribution conjointe. Cette fonction de répartition définit le comportement simultané des variables aléatoires dans un espace de probabilité. Dans le cas d’un système de prévision, elle contient des informations sur les prévisions, l’observation et la relation entre elles, ce qui permet de déterminer et d’évaluer les différents attributs qui définissent la qualité des prévisions. D’après Murphy and Winkler (1987) ces informations peuvent être vues avec plus de détails si la distribution conjointe est factorisée dans une distribution conditionnelle et une distribution inconditionnelle (marginale). Pour ce faire, il existe deux options, selon les informations qu’elles fournissent :

1. Calibration-refinement factorization (en anglais).

𝑝(𝑦, 𝑓) = 𝑝(𝑦|𝑓)𝑝(𝑓) (2.3)

où 𝑝(𝑦|𝑓) est la distribution conditionnelle des observations étant données les prévisions. Cette distribution indique la fréquence avec laquelle chaque évènement possible 𝑦 s’est produit lorsqu’une prévision particulier (𝑓) est émise. Elle fournit des informations sur la fiabilité du système, ou à quel point il est calibré, puisque si le système est parfait 𝑝(𝑦 = 1|𝑓) = 𝑓 doit être satisfait.

D’ailleurs, 𝑃 (𝑓) est la distribution marginale des prévisions ou la fonction de densité expectée du prédicteur. Elle indique la fréquence d’utilisation de chacune des valeurs de prévision possible (𝑓), fournissant ainsi des informations sur la résolution.

2. Likelihood-base rate factorization

𝑝(𝑦, 𝑓) = 𝑝(𝑓|𝑦)𝑝(𝑦) (2.4)

où 𝑝(𝑓|𝑦) est la distribution conditionnelle des prévisions étant données les observations. Elle exprime la probabilité que chacune des valeurs prédites 𝑓 ait été émise avant l’évè-nement observé 𝑦. Ce concept peut révéler des informations utiles sur la nature de la performance de la prévision et sur la capacité du système à discriminer deux évènements différents. Elle est aussi connue comme la fonction de vraisemblance.

𝑝(𝑦) est la distribution marginale de l’observation communément appelée “climatolo-gie”. Elle indique combien de fois différentes valeurs de 𝑦 surviennent. Il faut souligner que 𝑃 (𝑦) est le seul terme qui n’implique pas la prévision. Elle est indépendante du prévisionniste et du système de prévision (Murphy and Winkler,1987).

Ces deux factorisations peuvent être liées et exprimées en termes du théorème de Bayes comme suit :

𝑝(𝑦|𝑓) = 𝑝(𝑓|𝑦)𝑝(𝑦)

𝑝(𝑓) (2.5)

Dans le théorème de Bayes, 𝑝(𝑦|𝑓) est connue comme la distribution a posteriori ou prédictive. Ce terme correspond à la première factorisation qui donne des informations sur la calibra-tion du système. 𝑝(𝑦) (distribucalibra-tion a priori) représente l’incertitude de l’observacalibra-tion avant la prévision et 𝑝(𝑓|𝑦) permet de vérifier cette information une fois la prévision 𝑝(𝑓) est émise. Donc, à chaque prévision, 𝑝(𝑦) est mise à jour pour l’information supplémentaire qui vient de 𝑝(𝑓). De cette manière la distribution prédictive capture l’observation et le prévisionniste obtient l’information de la probabilité d’occurrence de l’événement.

2.5.3 Approche Censored Shifted Gamma Distribution

Le Censored Shifted Gamma Distribution (CSGD) est une méthode de post-traitement sta-tistique de la précipitation développée par Scheuerer and Hamill (2015) qui génère des dis-tributions de probabilité prédictive basée sur des disdis-tributions Gamma censurées et décalées. C’est un modèle complexe, mais en revanche, il considère adéquatement les particularités de la précipitation. Grosso modo, l’approche consiste en trois étapes principales (figure 2.6) : (1) les prévisions sont corrigées (en termes des erreurs systématiques) et condensées en des statistiques ; (2) la fonction de probabilité empirique des observations est ajustée au modèle CSGD pour obtenir la distribution inconditionnelle (climatologie) ; (3) les paramètres du mo-dèle CSGD sont liés aux statistiques de l’ensemble en utilisant un momo-dèle de régression non homogène et non-linéaire d’où résulte une distribution conditionnelle des observations étant donné les prévisions. Nous considérons maintenant chaque étape plus en détail.

Étape 0 : Identification d’une distribution de probabilité appropiée

Il est important de sélectionner et appliquer une distribution appropriée, car l’utilisation d’un mauvais outil amènerait à des conclusions erronées tirées du modèle théorique choisi. Consé-quemment, ces erreurs entraîneront de mauvaises décisions. La distribution Gamma (Éq.2.6) est couramment utilisée pour décrire le comportement asymétrique de la précipitation grâce à ses paramètres de forme (𝛼) et d’échelle (𝛽). Cependant, cette distribution est strictement positive, de sorte qu’elle ne permet pas de modéliser l’occurrence et la non-occurrence de la

Figure 2.6 – Étapes de la méthode CSGD.

précipitation simultanément. Pour résoudre ce problème, Scheuerer and Hamill (2015) ont développé un modèle basé sur une distribution Gamma censurée et décalée (Éq. 2.7) en ajou-tant un troisième paramètre 𝛿 > 0 qui permet de contrôler la probabilité des précipitations nulles. 𝐹 (𝑦|𝛼, 𝛽) = 𝑦 𝛼−1𝑒𝑥𝑝(−𝑦 𝛽) 𝛽𝛼Γ(𝛼) , 𝑦, 𝛼, 𝛽 > 0 (2.6) ̃ 𝐹 (𝑦|𝛼, 𝛽, 𝛿) = ⎧ { ⎨ { ⎩ 𝐹𝛼(𝑦−𝛿𝛽 ) , 𝑦 ≥ 0 0, ∶ 𝑦 < 0 (2.7)

où 𝑦 est la valeur de précipitation, Γ(𝛼) est la fonction Gamma, 𝐹 désigne la CDF de la distribution Gamma et 𝐹 est la CDF du modèle CSGD. Les paramètres 𝛼 et 𝛽 peuvent êtrẽ liés à la moyenne de l’ensemble (𝜇) et l’écart-type (𝜎) via :

𝛼 = 𝜇 2

𝜎2; 𝛽 = 𝜎2

𝜇 (2.8)

Étape 1 : Quantile-Quantile et calcul des statistiques de l’ensemble

Dans cette étape les erreurs systématiques ou les biais inconditionnels sont corrigés. Ceci est réalisé en appliquant l’approche quantile-quantile qui consiste à faire correspondre les fonctions de densité de probabilité des précipitations prévues et observées (Wetterhall et al.,